تكوين حلقة تعلم Personalizer

هام

اعتبارا من 20 سبتمبر 2023، لن تتمكن من إنشاء موارد Personalizer جديدة. يتم إيقاف خدمة Personalizer في 1 أكتوبر 2026.

يتضمن تكوين الخدمة كيفية تعامل الخدمة مع المكافآت، وعدد مرات استكشاف الخدمة، وعدد مرات إعادة تدريب النموذج، ومقدار البيانات المخزنة.

تكوين حلقة التعلم في صفحة التكوين، في مدخل Microsoft Azure لمورد Personalizer هذا.

تغييرات تكوين التخطيط

نظرًا لأن بعض تغييرات التكوين تقوم بإعادة تعيين النموذج الخاص بك، يجب التخطيط لتغييرات التكوين الخاصة بك.

إذا كنت تخطط لاستخدام وضع المبتدئ، فتأكد من مراجعة تكوين Personalizer قبل التبديل إلى وضع المبتدئ.

الإعدادات التي تتضمن إعادة تعيين النموذج

تؤدي الإجراءات التالية إلى إعادة تدريب النموذج باستخدام البيانات المتوفرة حتى آخر يومين.

- مكافأة

- استكشاف

لأجل مسح جميع بياناتك، استخدم صفحة إعدادات النموذج والتعلم.

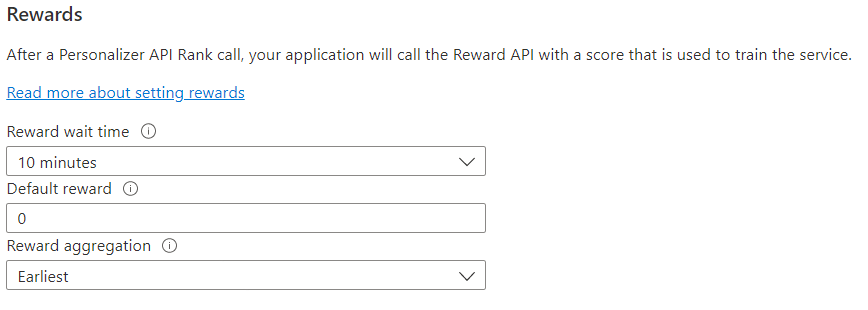

تكوين المكافآت لحلقة الملاحظات

تكوين الخدمة لاستخدام حلقة التعلم الخاصة بك للمكافآت. ستؤدي التغييرات التي أجريت على القيم التالية إلى إعادة تعيين نموذج Personalizer الحالي وإعادة تدريبه على آخر يومين من البيانات.

| القيمة | الغرض |

|---|---|

| وقت انتظار المكافأة | تعيين المدة الزمنية التي سيجمع خلالها Personalizer قيم المكافأة لاستدعاء Rank، بدءًا من لحظة حدوث استدعاء Rank. يتم تعيين هذه القيمة عن طريق السؤال: "كم من الوقت يجب أن ينتظر Personalizer استدعاءات المكافآت؟" سيتم تسجيل أي مكافأة تصل بعد هذه النافذة ولكن لن يتم استخدامها للتعلم. |

| المكافأة الافتراضية | إذا لم يتم تلقي أي استدعاء مكافأة من قبل Personalizer أثناء نافذة وقت انتظار المكافأة المقترنة باستدعاء Rank، فسيعين Personalizer المكافأة الافتراضية. بشكل افتراضي، وفي معظم السيناريوهات، تكون المكافأة الافتراضية صفر (0). |

| تجميع المكافأة | إذا تم تلقي مكافآت متعددة لنفس استدعاء واجهة برمجة تطبيقات Rank، يتم استخدام أسلوب التجميع هذا: المجموع أو الأقدم. يختار أقرب درجة تم تلقيها ويتجاهل الباقي. هذا مفيد إذا كنت تريد مكافأة فريدة بين المكالمات المكررة. |

بعد تغيير هذه القيم، تأكد من تحديد Save.

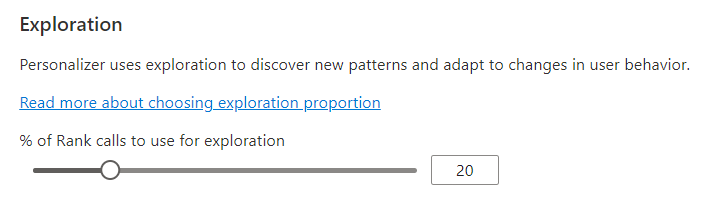

تكوين الاستكشاف للسماح لحلقة التعلم بالتكيف

التخصيص قادر على اكتشاف أنماط جديدة والتكيف مع تغييرات سلوك المستخدم بمرور الوقت من خلال استكشاف البدائل بدلاً من استخدام تنبؤ النموذج المدرب. تحدد قيمة الاستكشاف النسبة المئوية لاستدعاءات Rank التي يتم الرد عليها بالاستكشاف.

ستؤدي التغييرات التي تم إجراؤها على هذه القيمة إلى إعادة تعيين نموذج Personalizer الحالي وإعادة تدريبه في آخر يومين من البيانات.

بعد تغيير هذه القيمة، تأكد من تحديد Save.

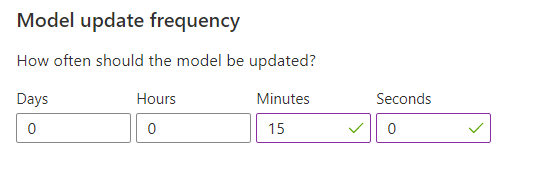

تكوين تكرار تحديث النموذج لتدريب النموذج

يحدد تكرار تحديث النموذج عدد مرات إعادة تدريب النموذج.

| إعداد التردد | الغرض |

|---|---|

| دقيقة واحدة | تكون تكرارات التحديث لمدة دقيقة واحدة مفيدة عند تصحيح أخطاء التعليمات البرمجية للتطبيق باستخدام Personalizer أو إجراء العروض التوضيحية أو اختبار جوانب التعلم الآلي بشكل تفاعلي. |

| 15 دقيقة | تعد ترددات تحديث النموذج العالية مفيدة للحالات التي تريد فيها تتبع التغييرات في سلوكيات المستخدم عن كثب. تتضمن الأمثلة المواقع التي تعمل على الأخبار المباشرة أو المحتوى الفيروسي أو عروض أسعار المنتجات المباشرة. يمكنك استخدام تردد 15 دقيقة في هذه السيناريوهات. |

| ساعة واحدة | بالنسبة لمعظم حالات الاستخدام، يكون تكرار التحديث الأقل فعالاً. |

بعد تغيير هذه القيمة، تأكد من تحديد Save.

الاحتفاظ بالبيانات

تحدد فترة استبقاء البيانات عدد الأيام التي يحتفظ فيها Personalizer بسجلات البيانات. سجلات البيانات السابقة مطلوبة لإجراء تقييمات دون اتصال، والتي تُستخدم لقياس فعالية Personalizer وتحسين نهج التعلم.

بعد تغيير هذه القيمة، تأكد من تحديد Save.