Aufzeichnen von Daten aus Event Hubs im Parquetformat

In diesem Artikel wird erläutert, wie Sie den No-Code-Editor zum automatischen Aufzeichnen von Streamingdaten in Event Hubs in einem Azure Data Lake Storage Gen2-Konto im Parquet-Format verwenden.

Voraussetzungen

Ein Azure Event Hubs-Namespace mit einem Event Hub und einem Azure Data Lake Storage Gen2-Konto mit einem Container zum Speichern der aufgezeichneten Daten. Diese Ressourcen müssen öffentlich zugänglich sein und dürfen sich nicht hinter einer Firewall befinden oder in einem virtuellen Azure-Netzwerk gesichert werden.

Wenn Sie keinen Event Hub haben, erstellen Sie einen, indem Sie die Anweisungen unter Schnellstart: Erstellen eines Event Hubs befolgen.

Wenn Sie kein Data Lake Storage Gen2-Konto haben, erstellen Sie ein Konto, indem Sie die Anweisungen unter Erstellen eines Speicherkontos befolgen.

Die Daten in Ihrer Event Hubs-Instanz müssen entweder im JSON-, CSV- oder Avro-Format serialisiert werden. Zu Testzwecken wählen Sie im linken Menü Daten generieren (Vorschau) aus. Aktivieren Sie das Dataset Bestandsdaten, und wählen Sie dann Senden aus.

Konfigurieren eines Auftrags zum Aufzeichnen von Daten

Verwenden Sie die folgenden Schritte, um einen Stream Analytics-Auftrag zum Aufzeichnen von Daten in Azure Data Lake Storage Gen2 zu konfigurieren.

Navigieren Sie im Azure-Portal zu Ihrem Event Hub.

Wählen Sie im linken Menü unter Featuresdie Option Daten verarbeiten aus. Wählen Sie anschließend auf der Kachel Daten im Parquet-Format in ADLS Gen2 erfassen die Option Start aus.

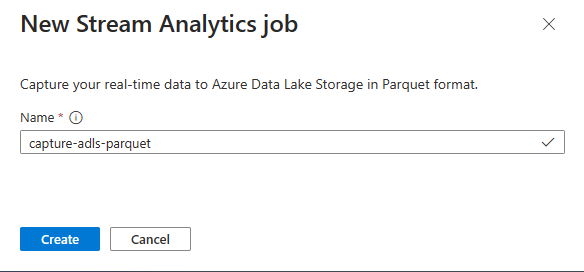

Geben Sie einen Namen für Ihren Stream Analytics-Auftrag ein, und wählen Sie dann Erstellen aus.

Geben Sie in Event Hubs den Serialisierungstyp Ihrer Daten sowie die Authentifizierungsmethode an, die der Auftrag zum Herstellen einer Verbindung mit Event Hubs verwenden soll. Wählen Sie dann Verbinden aus.

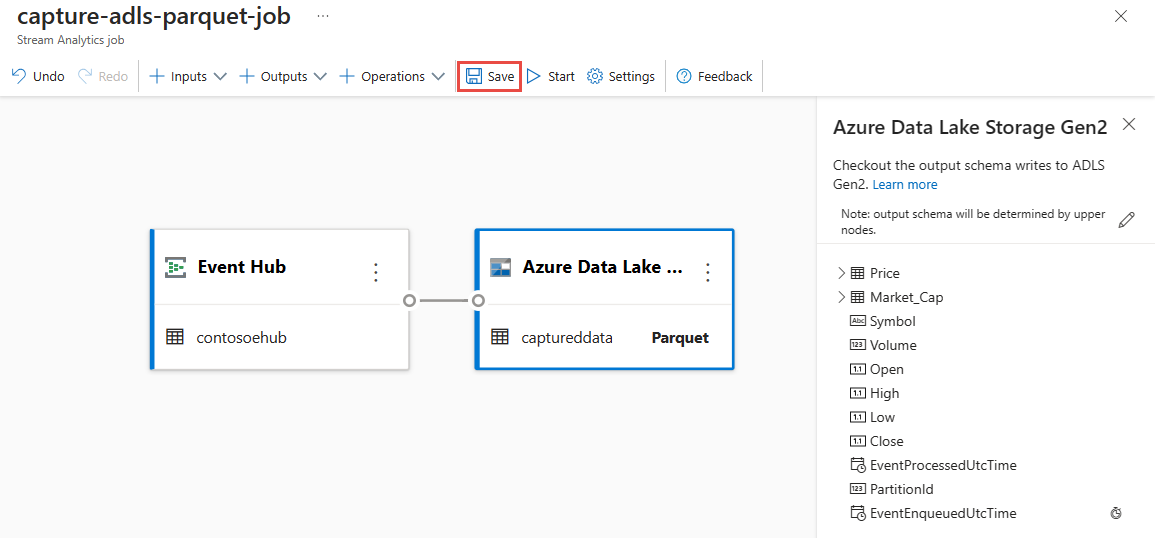

Wenn die Verbindung erfolgreich eingerichtet worden ist, wird Folgendes angezeigt:

Felder, die in den Eingabedaten vorhanden sind. Sie können Feld hinzufügen oder das Symbol mit den drei Punkten neben einem Feld auswählen, um den Namen optional zu entfernen oder zu ändern.

Ein Livebeispiel für eingehende Daten in der Tabelle Datenvorschau unter der Diagrammansicht. Es wird regelmäßig aktualisiert. Sie können Streamingvorschau anhalten auswählen, um eine statische Ansicht der Beispieleingabe anzuzeigen.

Wählen Sie die Kachel Azure Data Lake Storage Gen2 aus, um die Konfiguration zu bearbeiten.

Führen Sie auf der Seite für die Azure Data Lake Storage Gen2-Konfiguration die folgenden Schritte aus:

Wählen Sie das Abonnement, den Speicherkontonamen und den Container aus der Dropdownliste aus.

Wenn das Abonnement ausgewählt wurde, sollten Authentifizierungsmethode und Speicherkontoschlüssel automatisch ausgefüllt werden.

Wählen Sie Parquet als Serialisierungsformat aus.

Für Streamingblobs wird erwartet, dass das Verzeichnispfadmuster ein dynamischer Wert ist. Das Datum, auf das mit

{date}verwiesen wird, muss Teil des Dateipfads für das Blob sein. Informationen zu benutzerdefinierten Pfadmustern finden Sie in der benutzerdefinierten Blob-Ausgabepartitionierung von Azure Stream Analytics.Wählen Sie Verbinden aus.

Wenn die Verbindung hergestellt wurde, werden die Felder angezeigt, die in den Ausgabedaten vorhanden sind.

Wählen Sie auf der Befehlsleiste Speichern aus, um Ihre Konfiguration zu speichern.

Wählen Sie auf der Befehlsleiste Starten aus, um den Streamingdatenfluss zu starten und Daten zu erfassen. Gehen Sie dann im Aufgabenfenster „Stream Analytics-Auftrag starten“ folgendermaßen vor:

Wählen Sie die Startzeit der Ausgabe aus.

Wählen Sie den Tarif aus.

Wählen Sie die Anzahl der Streamingeinheiten (SU) aus, mit denen der Auftrag ausgeführt wird. Streamingeinheiten stellen die Computeressourcen dar, die zum Ausführen eines Stream Analytics-Auftrags zugeordnet werden. Weitere Informationen finden Sie unter Streamingeinheiten in Azure Stream Analytics.

Der Stream Analytics-Auftrag sollte auf der Registerkarte Stream Analytics-Auftrag der Seite Daten verarbeiten für Ihren Event Hub angezeigt werden.

Überprüfen der Ausgabe

Wählen Sie auf der Seite „Event Hubs-Instanz“ Ihres Event Hubs Daten generieren aus. Wählen Sie das Dataset Bestandsdaten und dann Senden aus, um einige Beispieldaten an den Event Hub zu senden.

Stellen Sie sicher, dass die PARQUET-Dateien im Azure Data Lake Storage-Container generiert werden.

Wählen Sie im linken MenüDaten verarbeiten aus. Wechseln Sie zur Registerkarte Stream Analytics-Aufträge. Wählen Sie Metriken öffnen aus, um sie zu überwachen.

Hier sehen Sie einen Beispielscreenshot von Metriken mit Eingabe- und Ausgabeereignissen.

Nächste Schritte

Jetzt wissen Sie, wie Sie den No-Code-Editor von Stream Analytics verwenden, um einen Auftrag zu erstellen, der Event Hubs-Daten in Azure Data Lake Storage Gen2 im Parquetformat aufzeichnet. Als Nächstes können Sie mehr über Azure Stream Analytics erfahren und wie Sie den von Ihnen erstellten Auftrag überwachen.