Diese Lösung speichert Sicherheitsprotokolle in Azure Data Explorer auf langfristiger Basis. Diese Lösung minimiert die Kosten und ermöglicht einen einfachen Zugriff, wenn Sie die Daten abfragen müssen.

Grafana und Jupyter Notebook sind Marken ihrer jeweiligen Unternehmen. Die Verwendung dieser Marken impliziert keine Empfehlung.

Aufbau

Laden Sie eine Visio-Datei dieser Architektur herunter.

Datenfluss

Für SIEM und SOAR verwendet ein Unternehmen Sentinel und Defender für Endpoint.

Defender für Endpoint verwendet native Funktionen zum Exportieren von Daten in Azure Event Hubs und Azure Data Lake. Sentinel erfasst Defender für Endpunkt-Daten zum Überwachen von Geräten.

Sentinel verwendet Log Analytics als Datenplattform zum Exportieren von Daten für Event Hubs und Azure Data Lake.

Azure Data Explorer verwendet Connectors für Event Hubs, Azure Blob Storage und Azure Data Lake Storage, um Daten mit geringer Wartezeit und hohem Durchsatz zu erfassen. Dieser Prozess verwendet Azure Event Grid, wodurch die Azure Data Explorer-Erfassungspipeline ausgelöst wird.

Bei Bedarf exportiert Azure Data Explorer kontinuierlich Sicherheitsprotokolle für Azure Storage. Diese Protokolle liegen im komprimierten, partitionierten Parquet-Format vor und können abgefragt werden.

Um die gesetzlichen Anforderungen zu erfüllen, exportiert Azure Data Explorer vorab aggregierte Daten zur Archivierung in Data Lake Storage.

Log Analytics und Sentinel unterstützen dienstübergreifende Abfragen mit Azure Data Explorer. SOC-Analysten nutzen diese Funktion, um umfassende Untersuchungen zu Sicherheitsdaten durchzuführen.

Azure Data Explorer bietet native Funktionen zum Verarbeiten, Aggregieren und Analysieren von Daten.

Verschiedene Tools bieten Analysedashboards in Quasi-Echtzeit, die schnell Erkenntnisse liefern:

Komponenten

Defender für Endpoint schützt Organisationen vor Bedrohungen für Geräte, Identitäten, Apps, E-Mails, Daten und Cloudworkloads.

Sentinel ist eine cloudnative SIEM- und SOAR-Lösung. Sie verwendet erweiterte KI- und Sicherheitsanalysen, um Bedrohungen unternehmensübergreifend zu erkennen, zu suchen, zu verhindern und darauf zu reagieren.

Monitor ist eine SaaS-Lösung (Software-as-a-Service), die Daten in Umgebungen und Azure-Ressourcen sammelt und analysiert. Diese Daten umfassen App-Telemetriedaten, z. B. Leistungsmetriken und Aktivitätsprotokolle. Monitor bietet auch Warnungsfunktionen.

Log Analytics ist ein Monitor-Dienst, den Sie zum Abfragen und Überprüfen von Monitor-Protokolldaten verwenden können. Darüber hinaus bietet Log Analytics Features zum Erstellen von Diagrammen sowie für statistische Analysen von Abfrageergebnissen.

Event Hubs ist ein vollständig verwalteter Echtzeitdienst zur Datenerfassung, der einfach und skalierbar ist.

Data Lake Storage ist ein skalierbares Repository zur Speicherung großer Datenmengen in ihrem nativen Rohformat. Dieser Data Lake basiert auf Blob Storage und bietet Funktionen zum Speichern und Verarbeiten von Daten.

Azure Data Explorer ist eine schnelle, vollständig verwaltete und hochgradig skalierbare Datenanalyseplattform. Sie können diesen Clouddienst für die Echtzeitanalyse großer Datenmengen nutzen. Azure Data Explorer ist für interaktive Ad-hoc-Abfragen optimiert. Es kann verschiedene Datenströme von Anwendungen, Websites, IoT-Geräten und anderen Quellen verarbeiten.

Azure Data Explorer-Dashboards importieren nativ Daten aus Abfragen der Azure Data Explorer-Webbenutzeroberfläche. Diese optimierten Dashboards bieten eine Möglichkeit, Abfrageergebnisse anzuzeigen und zu untersuchen.

Alternativen

Anstelle von Azure Data Explorer können Sie Storage für die langfristige Speicherung von Sicherheitsprotokollen verwenden. Dieser Ansatz vereinfacht die Architektur und kann dabei helfen, die Kosten zu kontrollieren. Ein Nachteil besteht darin, dass die Protokolle für Sicherheitsüberwachungen und interaktive Abfrageabfragen aktiviert werden müssen. Mit Azure Data Explorer können Sie Daten aus der kalten Partition in die heiße Partition verschieben, indem Sie eine Richtlinie ändern. Diese Funktion beschleunigt die Datenuntersuchung.

Eine weitere Möglichkeit bei dieser Lösung besteht darin, alle Daten unabhängig von ihrem Sicherheitswert gleichzeitig an Sentinel und Azure Data Explorer zu senden. Es ergibt sich eine gewisse Duplizierung, aber die Kosteneinsparungen können erheblich sein. Da Azure Data Explorer langfristige Speicherung bietet, können Sie mit diesem Ansatz Ihre Sentinel-Aufbewahrungskosten senken.

Log Analytics unterstützt derzeit nicht das Exportieren benutzerdefinierter Protokolltabellen. In diesem Szenario können Sie Azure Logic Apps verwenden, um Daten aus Log Analytics-Arbeitsbereichen zu exportieren. Weitere Informationen finden Sie unter Archivieren von Daten aus dem Log Analytics-Arbeitsbereich in Azure Storage mithilfe von Logic Apps.

Szenariodetails

Sicherheitsprotokolle sind nützlich, um Bedrohungen zu erkennen und unbefugte Versuche, auf Daten zuzugreifen, nachzuverfolgen. Sicherheitsangriffe können beginnen, lange bevor sie entdeckt werden. Daher ist es wichtig, Zugriff auf langfristige Sicherheitsprotokolle zu haben. Die Abfrage von Langzeitprotokollen ist von entscheidender Bedeutung, um die Auswirkungen von Bedrohungen zu erkennen und die Ausbreitung unerlaubter Zugriffsversuche zu untersuchen.

In diesem Artikel wird eine Lösung für die langfristige Aufbewahrung von Sicherheitsprotokollen vorgestellt. Der Kern der Architektur ist Azure Data Explorer. Dieser Dienst bietet Speicher für Sicherheitsdaten mit minimalen Kosten, speichert diese Daten jedoch in einem Format, das Sie abfragen können. Weitere Hauptkomponenten umfassen:

Microsoft Defender für Endpunkt und Microsoft Sentinel für folgende Funktionen:

- Umfassende Endpunktsicherheit

- SIEM-Lösung (Security Information and Event Management)

- Sicherheitsorchestrierung mit automatisierter Reaktion (Security Orchestration Automated Response, SOAR)

Log Analytics zur kurzfristigen Speicherung von Sentinel-Sicherheitsprotokollen

Mögliche Anwendungsfälle

Diese Lösung gilt für verschiedene Szenarien. Insbesondere SOC-Analysten (Security Operations Center) können diese Lösung für Folgendes verwenden:

- Umfassende Untersuchungen

- Forensische Analyse

- Bedrohungssuche

- Sicherheitsüberwachungen

Ein Kunde bezeugt die Nützlichkeit der Lösung: „Wir haben vor fast anderthalb Jahren einen Azure Data Explorer-Cluster bereitgestellt. Bei der letzten Solorigate-Datensicherheitsverletzung haben wir einen Azure Data Explorer-Cluster für die forensische Analyse verwendet. Ein Microsoft Dart-Team hat ebenfalls einen Azure Data Explorer-Cluster verwendet, um die Untersuchung abzuschließen. Die langfristige Aufbewahrung von Sicherheitsdaten ist für umfassende Datenuntersuchungen von entscheidender Bedeutung.“

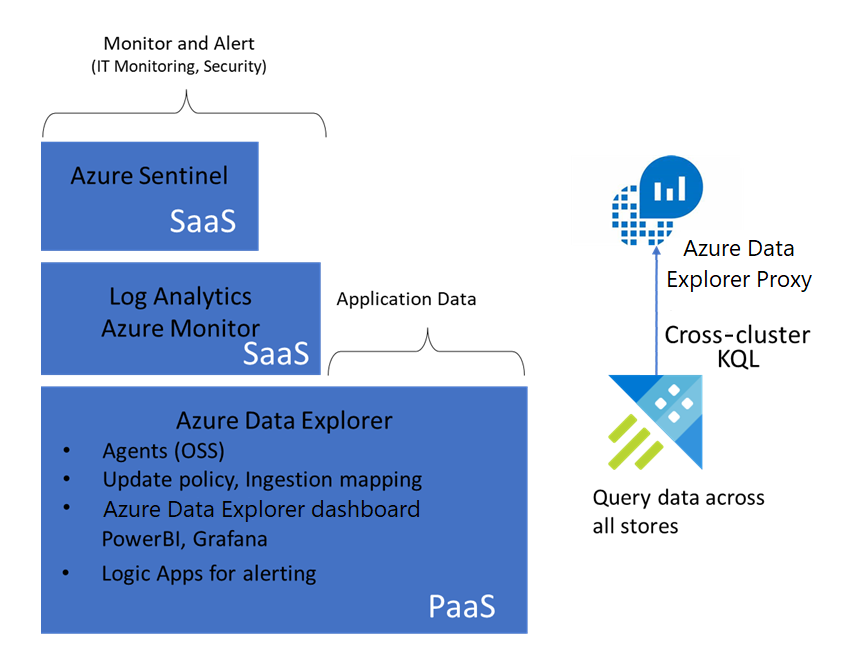

Überwachungsstapel

Das folgende Diagramm zeigt den Azure-Überwachungsstapel:

- Sentinel verwendet einen Log Analytics-Arbeitsbereich, um Sicherheitsprotokolle zu speichern und SIEM- und SOAR-Lösungen bereitzustellen.

- Monitor verfolgt den Status von IT-Ressourcen nach und sendet bei Bedarf Warnungen.

- Azure Data Explorer stellt eine zugrunde liegende Datenplattform bereit, die Sicherheitsprotokolle für Log Analytics-Arbeitsbereiche, Monitor und Sentinel speichert.

Wichtigste Features

Die Hauptfeatures der Lösung bieten viele Vorteile, wie in den folgenden Abschnitten erläutert.

Langfristig abfragbarer Datenspeicher

Azure Data Explorer indiziert Daten während des Speicherprozesses und stellt die Daten für Abfragen zur Verfügung. Wenn Sie sich auf die Ausführung von Überwachungen und Untersuchungen konzentrieren müssen, brauchen Sie die Daten nicht verarbeiten. Das Abfragen der Daten ist einfach.

Vollständige forensische Analyse

Azure Data Explorer, Log Analytics und Sentinel unterstützen dienstübergreifende Abfragen. Daher können Sie in einer einzelnen Abfrage auf Daten verweisen, die in einem dieser Dienste gespeichert sind. SOC-Analysten können die Kusto-Abfragesprache (KQL) verwenden, um umfassende Untersuchungen durchzuführen. Sie können auch Azure Data Explorer-Abfragen in Sentinel für das Hunting verwenden. Weitere Informationen finden Sie unter Neuigkeiten: Sentinel Hunting unterstützt ressourcenübergreifende ADX-Abfragen.

On-Demand-Datenzwischenspeicherung

Azure Data Explorer unterstützt fensterbasiertes heißes Zwischenspeichern. Diese Funktion ermöglicht es, Daten aus einem ausgewählten Zeitraum in den heißen Cache zu verschieben. Anschließend können Sie schnelle Abfragen für die Daten ausführen, um Untersuchungen effizienter zu gestalten. Zu diesem Zweck müssen Sie dem heißen Cache möglicherweise Computeknoten hinzufügen. Nach Abschluss der Untersuchung können Sie die Richtlinie für den heißen Cache ändern, um die Daten in die kalte Partition zu verschieben. Sie können den Cluster auch in seiner ursprünglichen Größe wiederherstellen.

Fortlaufender Export in Archivdaten

Um den gesetzlichen Anforderungen zu entsprechen, müssen einige Unternehmen Sicherheitsprotokolle für einen unbegrenzten Zeitraum speichern. Azure Data Explorer unterstützt den fortlaufenden Export von Daten. Sie können mithilfe dieser Funktion eine Archivierungsebene erstellen, indem Sie Sicherheitsprotokolle in Storage speichern.

Bewährte Abfragesprache

Die Kusto-Abfragesprache ist nativ in Azure Data Explorer enthalten. Diese Sprache ist auch in Log Analytics-Arbeitsbereichen und Sentinel-Umgebungen für die Bedrohungssuche verfügbar. Diese Verfügbarkeit reduziert die Lernkurve für SOC-Analysten erheblich. Abfragen, die Sie für Sentinel ausführen, funktionieren auch mit Daten, die Sie in Azure Data Explorer-Clustern speichern.

Überlegungen

Diese Überlegungen setzen die Säulen des Azure Well-Architected Framework um, das eine Reihe von Leitprinzipien enthält, die zur Verbesserung der Qualität eines Workloads verwendet werden können. Weitere Informationen finden Sie unter Microsoft Azure Well-Architected Framework.

Beachten Sie die folgenden Punkte, wenn Sie diese Lösung implementieren.

Skalierbarkeit

Berücksichtigen Sie folgende Probleme der Skalierbarkeit:

Datenexportmethode

Wenn Sie eine große Menge an Daten aus Log Analytics exportieren müssen, erreichen Sie möglicherweise die Kapazitätsgrenzen von Event Hubs. So vermeiden Sie diese Situation:

- Exportieren Sie Daten aus Log Analytics in Blob Storage.

- Verwenden Sie Azure Data Factory-Workloads, um die Daten in regelmäßigen Abständen in Azure Data Explorer zu exportieren.

Mithilfe dieser Methode können Sie Daten aus Data Factory nur dann kopieren, wenn sich die Daten der Aufbewahrungsfrist in Sentinel oder Log Analytics nähern. Dadurch vermeiden Sie eine Duplizierung der Daten. Weitere Informationen finden Sie unter Exportieren von Daten aus Log Analytics in Azure Data Explorer.

Abfrageverwendung und Überwachungsbereitschaft

Im Allgemeinen speichern Sie Daten im kalten Cache in Ihrem Azure Data Explorer-Cluster. Dieser Ansatz minimiert Ihre Clusterkosten und ist für die meisten Abfragen, die Daten aus den vergangenen Monaten umfassen, ausreichend. Wenn Sie jedoch große Datenbereiche abfragen, müssen Sie den Cluster möglicherweise aufskalieren und die Daten in den heißen Cache laden.

Zu diesem Zweck können Sie das Feature „Heißes Fenster“ (Hot Window) der Richtlinie „Heißer Cache“ (Hot Cache) verwenden. Sie können dieses Feature auch verwenden, wenn Sie langfristige Daten überwachen. Wenn Sie das heiße Fenster verwenden, müssen Sie Ihren Cluster möglicherweise hoch- oder aufskalieren, um Platz für weitere Daten im heißen Cache zu schaffen. Nachdem Sie die Abfrage des großen Datenbereichs abgeschlossen haben, ändern Sie die Richtlinie für den heißen Cache, um die Computekosten zu senken.

Wenn Sie das Feature für die optimierte Autoskalierung in Ihrem Azure Data Explorer-Cluster aktivieren, können Sie die Größe Ihres Clusters auf der Grundlage der Cachingrichtlinie optimieren. Weitere Informationen zum Abfragen von kalten Daten in Azure Data Explorer finden Sie unter Abfragen von kalten Daten mit heißen Fenstern.

Effiziente Leistung

Leistungseffizienz ist die Fähigkeit Ihrer Workload, auf effiziente Weise eine den Anforderungen der Benutzer entsprechende Skalierung auszuführen. Weitere Informationen finden Sie unter Übersicht über die Säule „Leistungseffizienz“.

Wenn Sie Sicherheitsdaten für einen langen oder unbegrenzten Zeitraum speichern müssen, exportieren Sie die Protokolle nach Storage. Azure Data Explorer unterstützt den fortlaufenden Export von Daten. Mithilfe dieser Funktion können Sie Daten im komprimierten, partitionierten Parquet-Format nach Storage exportieren. Anschließend können Sie diese Daten problemlos abfragen. Weitere Informationen finden Sie unter Übersicht über den kontinuierlichen Datenexport.

Kostenoptimierung

Bei der Kostenoptimierung geht es um die Suche nach Möglichkeiten, unnötige Ausgaben zu reduzieren und die Betriebseffizienz zu verbessern. Weitere Informationen finden Sie unter Übersicht über die Säule „Kostenoptimierung“.

Die Kosten des Azure Data Explorer-Clusters basieren in erster Linie auf der Computeleistung, die für die Speicherung von Daten im heißen Cache verwendet wird. Abfragen von Daten im heißen Cache bieten eine bessere Leistung als Abfragen von Daten im kalten Cache. Diese Lösung speichert die meisten Daten im kalten Cache, wodurch die Computingkosten minimiert werden.

Mithilfe des Azure-Preisrechners können Sie die Ausführungskosten dieser Lösung in Ihrer Umgebung untersuchen.

Bereitstellen dieses Szenarios

Verwenden Sie dieses PowerShell-Skript, um die Bereitstellung zu automatisieren. Dieses Skript erstellt die folgenden Komponenten:

- Zieltabelle

- Unformatierte Tabelle

- Die Tabellenzuordnung, die definiert, wie Event Hubs-Datensätze in der unformatierten Tabelle landen.

- Aufbewahrungs- und Aktualisierungsrichtlinien

- Event Hubs-Namespaces

- Datenexportregeln im Log Analytics-Arbeitsbereich

- Die Datenverbindung zwischen Event Hubs und der unformatierten Azure Data Explorer-Datentabelle.

Beitragende

Dieser Artikel wird von Microsoft gepflegt. Er wurde ursprünglich von folgenden Mitwirkenden geschrieben:

Hauptautor:

- Deepak Agrawal | Product Manager

Melden Sie sich bei LinkedIn an, um nicht öffentliche LinkedIn-Profile anzuzeigen.

Nächste Schritte

- Integrieren von Azure Data Explorer für die langfristige Protokollaufbewahrung

- Problemloses Verschieben Ihrer Microsoft Sentinel-Protokolle in langfristigen Speicher

- Ressourcenübergreifende Abfrage: Azure Data Explorer mithilfe von Azure Monitor

- Vorgehensweise: Konfigurieren des Microsoft Sentinel-Datenexports für die langfristige Speicherung

- Verwenden von Azure Data Explorer für die langfristige Aufbewahrung von Microsoft Sentinel-Protokollen

- Neuigkeiten: Microsoft Sentinel-Hunting unterstützt ressourcenübergreifende ADX-Abfragen

- Streamen von Microsoft Defender ATP-Hunting-Protokollen in Azure Data Explorer

- Blogreihe: Unbegrenztes erweitertes Hunting mit Azure Data Explorer (ADX)