Installieren von Apache Hadoop-Anwendungen von Drittanbietern in Azure HDInsight

Hier erfahren Sie, wie Sie Apache Hadoop-Anwendungen von Drittanbietern in Azure HDInsight installieren. Eine Anleitung zur Installation Ihrer eigenen Anwendung finden Sie unter Installieren benutzerdefinierter HDInsight-Anwendungen.

Eine HDInsight-Anwendung kann von Benutzern in einem HDInsight-Cluster installiert werden. Diese Anwendungen können von Microsoft oder von unabhängigen Softwareanbietern (Independent Software Vendors, ISVs) bezogen oder aber selbst entwickelt werden.

Die folgende Liste zeigt die veröffentlichten Anwendungen:

| Application | Clustertyp(en) | BESCHREIBUNG |

|---|---|---|

| AtScale Intelligence-Plattform | Hadoop | AtScale wandelt Ihren HDInsight-Cluster in einen OLAP-Server mit horizontaler Skalierung um, wodurch Sie vertraute Business Intelligence-Tools (von Microsoft Excel, Power BI und Tableau Software bis hin zu Qlikview), die Sie bereits besitzen und zu schätzen wissen, interaktiv zum Abfragen von Milliarden von Zeilen von Daten verwenden können. |

| Datameer | Hadoop | Die skalierbare Self-Service-Plattform von Datameer zum Vorbereiten, Untersuchen und Steuern Ihrer Daten für die Analyse, mit der Sie komplexe Daten aus mehreren Quellen schneller in wertvolle unternehmensrelevante Informationen verwandeln und schnell hilfreiche Erkenntnisse für das gesamte Unternehmen gewinnen können. |

| Dataiku DSS in HDInsight | Hadoop, Spark | Dataiku DSS ist eine Data Science-Plattform für Unternehmen, mit der Data Scientists und Data Analysts zusammenarbeiten können, um neue Datenprodukte und Dienste effizienter zu entwerfen und auszuführen, wodurch Rohdaten in aussagekräftig Vorhersagen konvertiert werden. |

| WANdisco Fusion HDI App | Hadoop, Spark, HBase, Kafka | Die Beibehaltung der Datenkonsistenz in einer verteilten Umgebung ist eine große Herausforderung für Datenvorgänge. WANdisco Fusion ist eine professionelle Softwareplattform, die dieses Problem löst, indem unstrukturierte Datenkonsistenz zwischen beliebigen Umgebungen ermöglicht wird. |

| H2O Sparkling Water for HDInsight | Spark | H2O Sparkling Water unterstützt die folgenden verteilten Algorithmen: GLM, Naïve Bayes, Distributed Random Forest, Gradient Boosting Machine, Deep Neural Networks, Deep Learning, k-Means, PCA, Generalized Low Rank Models, Anomalieerkennung und Autoencoder. |

| Striim für Echtzeitdatenintegration in HDInsight | Hadoop, HBase, Spark, Kafka | Striim (Aussprache: Stream) ist eine End-to-End-Integrations- und Intelligence-Plattform für Streamingdaten, die eine kontinuierliche Erfassung, Verarbeitung und Analyse unterschiedlicher Datenströme ermöglicht. |

| Jumbune – BigData-Analyse für Unternehmensbeschleunigung | Hadoop, Spark | Jumbune unterstützt Unternehmen im Allgemeinen wie folgt: 1. Beschleunigt die Workloadleistung von Tez, MapReduce & Spark-basiertes Hive, Java, und Scala. 2. Überwacht Hadoop-Cluster proaktiv. 3. Richtet Datenqualitätsverwaltung für verteilte Dateisysteme ein. |

| Kyligence Enterprise | Hadoop, HBase, Spark | Unterstützt von Apache Kylin ermöglicht Kyligence Enterprise BI für Big Data. Kyligence Enterprise ist eine professionelle OLAP-Engine für Hadoop, mit der Business Analysten Business Intelligence für Hadoop mit Data Warehouse- und BI-Methoden entwerfen können, die dem Industriestandard entsprechen. |

| StreamSets Data Collector für HDInsight Cloud | Hadoop, HBase, Spark, Kafka | StreamSets Data Collector ist eine einfache, leistungsstarke Engine, die Daten in Echtzeit übermittelt. Mit Data Collector können Sie Daten in Ihren Datenströmen weiterleiten und verarbeiten. Eine kostenlose 30-tägige Testlizenz steht zur Verfügung. |

| Trifacta Wrangler Enterprise | Hadoop, Spark, HBase | Trifacta Wrangler Enterprise für HDInsight unterstützt unternehmensweites Data Wrangling für Daten bei jeder Skalierung. Beim Ausführen von Trifacta in Azure entstehen die Kosten aus den Kosten für das Trifacta-Abonnement und den Kosten Azure-Infrastrukturkosten für die virtuellen Computer. |

| Unifi Data Platform | Hadoop, HBase, Spark | Unifi Data Platform ist eine nahtlos integrierte Suite von Self-Service-Datentools, mit der Unternehmensbenutzer/benutzerinnen datenbezogene Herausforderungen bewältigen können, um höhere Umsätze zu erzielen, Kosten zu senken oder die operative Komplexität zu verringern. |

Für die Anleitungen in diesem Artikel wird das Azure-Portal verwendet. Sie können die Azure Resource Manager-Vorlage auch aus dem Portal exportieren oder eine Kopie der Resource Manager-Vorlage von Anbietern erhalten und Azure PowerShell und die klassische Azure-Befehlszeilenschnittstelle zum Bereitstellen der Vorlage verwenden. Weitere Informationen finden Sie unter Erstellen von Apache Hadoop-Clustern in HDInsight mit Resource Manager-Vorlagen.

Voraussetzungen

Wenn Sie HDInsight-Anwendungen in einem vorhandenen HDInsight-Cluster installieren möchten, benötigen Sie einen HDInsight-Cluster. Informationen zum Erstellen eines solchen Clusters finden Sie unter Erstellen von Clustern. Im Zuge der HDInsight-Clustererstellung können Sie auch HDInsight-Anwendungen installieren.

Installieren von Anwendungen für vorhandene Cluster

Das folgende Verfahren veranschaulicht, wie Sie HDInsight-Anwendungen für einen vorhandenen HDInsight-Cluster installieren.

Installieren einer HDInsight-Anwendung

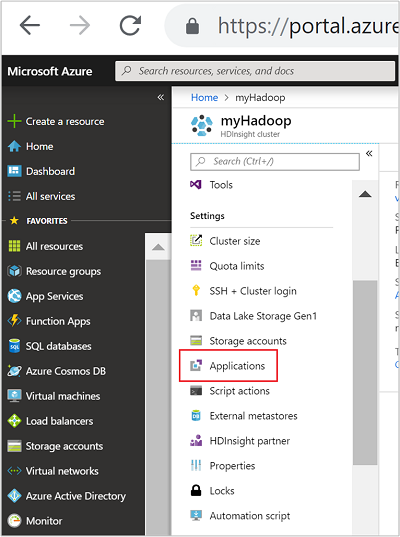

Melden Sie sich beim Azure-Portal an.

Navigieren Sie im linken Menü zu Alle Dienste>Analytics>HDInsight-Cluster.

Wählen Sie dann einen HDInsight-Cluster aus der Liste aus. Falls Sie noch keinen Cluster besitzen, müssen Sie zuerst einen erstellen. Weitere Informationen finden Sie unter Erstellen von Clustern.

Klicken Sie in der Kategorie Einstellungen auf Anwendungen. Im Hauptfenster wird eine Liste der installierten Anwendungen angezeigt.

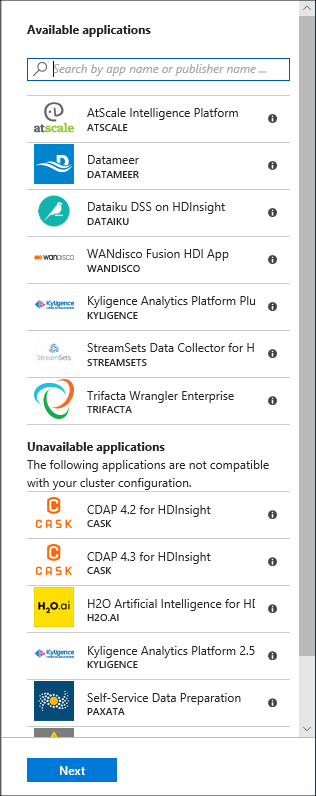

Klicken Sie im Menü auf + Hinzufügen. Ihnen wird eine Liste der verfügbaren Anwendungen angezeigt. Wenn + Hinzufügen ausgegraut ist, sind keine Anwendungen für diese Version des HDInsight-Clusters verfügbar.

Klicken Sie auf eine der verfügbaren Anwendungen, und folgen Sie dann den Anweisungen zum Akzeptieren der rechtlichen Bedingungen.

Sie können den Status der Installation über die Portalbenachrichtigungen verfolgen. (Klicken Sie hierzu oben im Portal auf das Glockensymbol). Nach der Installation wird die Anwendung in der Liste „Installierte Apps“ angezeigt.

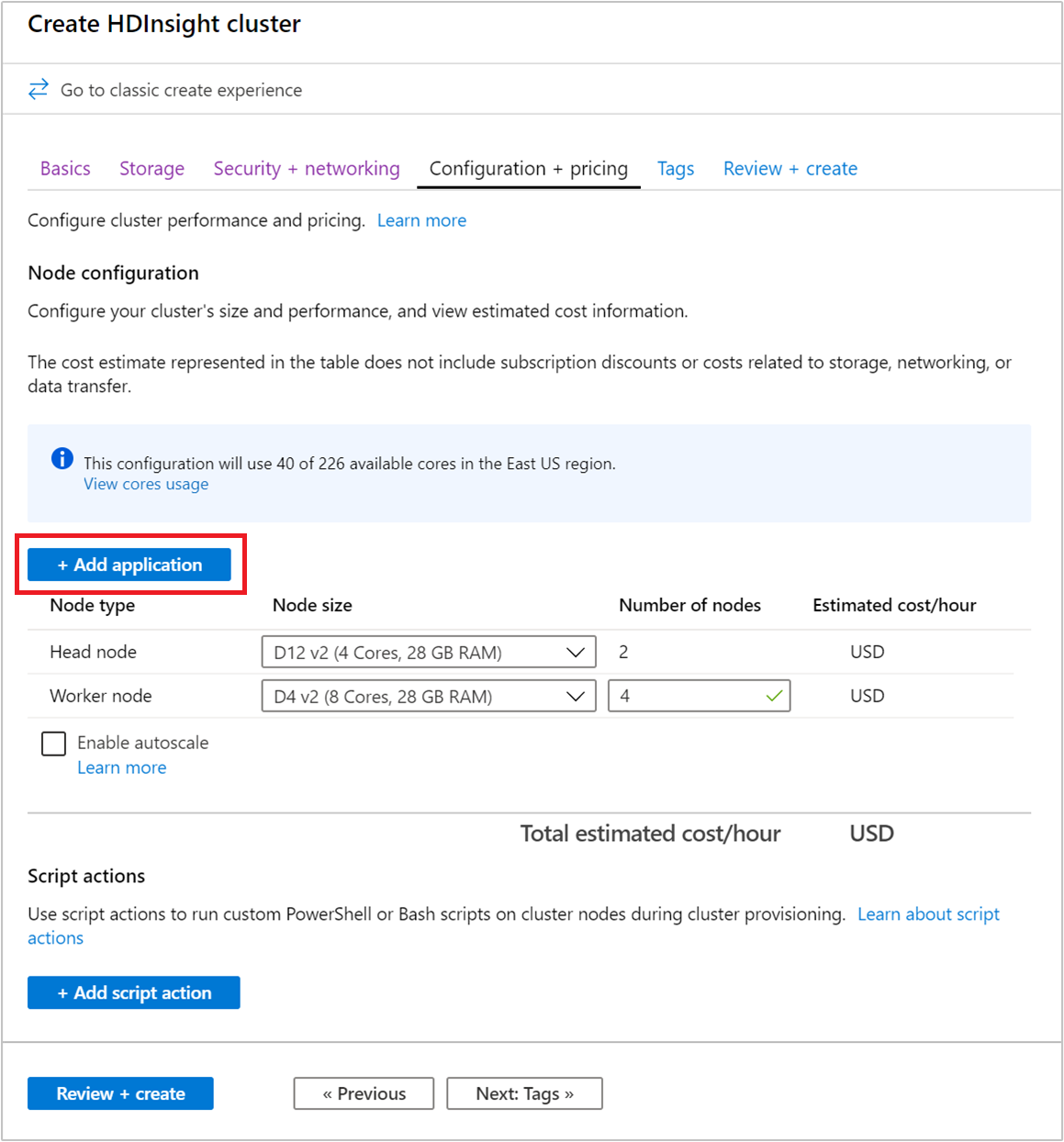

Installieren von Anwendungen während der Clustererstellung

Sie haben die Möglichkeit, die HDInsight-Anwendung beim Erstellen eines Clusters zu installieren. Während des Prozesses werden HDInsight-Anwendungen installiert, nachdem der Cluster erstellt wurde und sich im ausgeführten Zustand befindet. Wählen Sie in der Registerkarte Konfiguration + Preise+ Anwendung hinzufügen aus, um bei der Clustererstellung im Azure-Portal Anwendungen zu installieren.

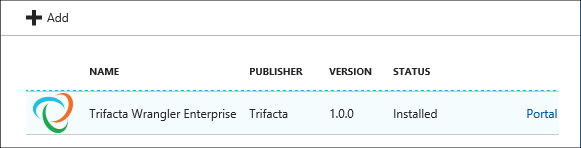

Auflisten der installierten HDInsight-Apps und Eigenschaften

Im Portal wird eine Liste mit den installierten HDInsight-Anwendungen für einen Cluster und den Eigenschaften der einzelnen installierten Anwendungen angezeigt.

Auflisten von HDInsight-Anwendungen und Eigenschaften

Melden Sie sich beim Azure-Portal an.

Navigieren Sie im linken Menü zu Alle Dienste>Analytics>HDInsight-Cluster.

Wählen Sie dann einen HDInsight-Cluster aus der Liste aus.

Klicken Sie in der Kategorie Einstellungen auf Anwendungen. Im Hauptfenster wird eine Liste der installierten Anwendungen angezeigt.

Wählen Sie eine der installierten Anwendungen aus, um die Eigenschaften anzuzeigen. Die Eigenschaft zeigt Folgendes:

Eigenschaft BESCHREIBUNG App-Name Der Anwendungsname. Status Anwendungsstatus Webseite Die URL der Webanwendung, die Sie auf dem Edgeknoten bereitgestellt haben. Die Anmeldeinformationen sind mit den HTTP-Benutzeranmeldeinformationen identisch, die Sie für den Cluster konfiguriert haben. SSH-Endpunkt Sie können über SSH eine Verbindung mit dem Edgeknoten herstellen. Die SSH-Anmeldeinformationen sind mit den SSH-Benutzeranmeldeinformationen identisch, die Sie für den Cluster konfiguriert haben. Informationen hierzu finden Sie unter Verwenden von SSH mit Linux-basiertem Hadoop in HDInsight unter Linux, Unix oder OS X. BESCHREIBUNG Anwendungsbeschreibung Klicken Sie zum Löschen einer Anwendung mit der rechten Maustaste darauf, und klicken Sie dann im Kontextmenü auf Löschen.

Herstellen einer Verbindung mit dem Edgeknoten

Sie können per HTTP und SSH eine Verbindung mit dem Edgeknoten herstellen. Sie finden die Endpunktinformationen im Portal. Informationen hierzu finden Sie unter Verwenden von SSH mit Linux-basiertem Hadoop in HDInsight unter Linux, Unix oder OS X.

Die Anmeldeinformationen für den HTTP-Endpunkt sind die im HDInsight-Cluster konfigurierten HTTP-Benutzeranmeldeinformationen. Die Anmeldeinformationen für den SSH-Endpunkt sind die im HDInsight-Cluster konfigurierten SSH-Anmeldeinformationen.

Problembehandlung

Weitere Informationen finden Sie unter Behandeln von Installationsproblemen.

Nächste Schritte

- Installieren benutzerdefinierter HDInsight-Anwendungen: Hier erfahren Sie, wie Sie eine nicht veröffentlichte HDInsight-Anwendung in HDInsight bereitstellen.

- Veröffentlichen von HDInsight-Anwendungen: Hier erfahren Sie, wie Sie benutzerdefinierte HDInsight-Anwendungen im Azure Marketplace veröffentlichen.

- MSDN: Installieren einer HDInsight-Anwendung: Hier erfahren Sie, wie Sie HDInsight-Anwendungen definieren.

- Anpassen Linux-basierter HDInsight-Cluster mithilfe von Skriptaktionen: Hier erfahren Sie, wie Sie mithilfe der Skriptaktion zusätzliche Anwendungen installieren.

- Erstellen von Linux-basierten Apache Hadoop-Clustern in HDInsight mit Resource Manager-Vorlagen: Hier erfahren Sie, wie Sie Resource Manager-Vorlagen für die Erstellung von HDInsight-Clustern aufrufen.

- Verwenden leerer Edgeknoten in HDInsight: Erfahren Sie, wie Sie einen leeren Edgeknoten zum Zugreifen auf HDInsight-Cluster, Testen von HDInsight-Anwendungen und Hosten von HDInsight-Anwendungen verwenden.