Schnellstart: Erstellen eines Apache Spark-Clusters in Azure HDInsight mithilfe einer ARM-Vorlage

In dieser Schnellstartanleitung verwenden Sie eine Azure Resource Manager-Vorlage (ARM-Vorlage), um einen Apache Spark-Cluster in Azure HDInsight zu erstellen. Anschließend erstellen Sie eine Jupyter Notebook-Datei und führen damit Spark SQL-Abfragen für Apache Hive-Tabellen aus. Azure HDInsight ist ein umfassender, verwalteter Open-Source-Analysedienst für Unternehmen. Das Apache Spark-Framework für HDInsight ermöglicht schnelle Datenanalysen und Clustercomputing mit In-Memory-Verarbeitung. Jupyter Notebook ermöglicht es Ihnen, mit Ihren Daten zu interagieren, Code mit Markdowntext zu kombinieren und einfache Visualisierungen durchzuführen.

Bei gemeinsamer Verwendung mehrerer Cluster empfiehlt sich die Erstellung eines virtuellen Netzwerks. Bei Verwendung eines Spark-Clusters sollten Sie den Hive Warehouse Connector verwenden. Weitere Informationen finden Sie unter Planen eines virtuellen Netzwerks für Azure HDInsight sowie unter Integrieren von Apache Spark und Apache Hive per Hive Warehouse Connector.

Eine Azure Resource Manager-Vorlage ist eine JSON (JavaScript Object Notation)-Datei, welche die Infrastruktur und die Konfiguration für Ihr Projekt definiert. Die Vorlage verwendet eine deklarative Syntax. Sie beschreiben Ihre geplante Bereitstellung, ohne die Abfolge der Programmierbefehle zum Erstellen der Bereitstellung zu schreiben.

Wenn Ihre Umgebung die Voraussetzungen erfüllt und Sie mit der Verwendung von ARM-Vorlagen vertraut sind, klicken Sie auf die Schaltfläche In Azure bereitstellen. Die Vorlage wird im Azure-Portal geöffnet.

Voraussetzungen

Wenn Sie kein Azure-Abonnement besitzen, können Sie ein kostenloses Konto erstellen, bevor Sie beginnen.

Überprüfen der Vorlage

Die in dieser Schnellstartanleitung verwendete Vorlage stammt von der Seite mit den Azure-Schnellstartvorlagen.

{

"$schema": "https://schema.management.azure.com/schemas/2019-04-01/deploymentTemplate.json#",

"contentVersion": "1.0.0.0",

"metadata": {

"_generator": {

"name": "bicep",

"version": "0.5.6.12127",

"templateHash": "4742950082151195489"

}

},

"parameters": {

"clusterName": {

"type": "string",

"metadata": {

"description": "The name of the HDInsight cluster to create."

}

},

"clusterLoginUserName": {

"type": "string",

"maxLength": 20,

"minLength": 2,

"metadata": {

"description": "These credentials can be used to submit jobs to the cluster and to log into cluster dashboards. The username must consist of digits, upper or lowercase letters, and/or the following special characters: (!#$%&'()-^_`{}~)."

}

},

"clusterLoginPassword": {

"type": "secureString",

"minLength": 10,

"metadata": {

"description": "The password must be at least 10 characters in length and must contain at least one digit, one upper case letter, one lower case letter, and one non-alphanumeric character except (single-quote, double-quote, backslash, right-bracket, full-stop). Also, the password must not contain 3 consecutive characters from the cluster username or SSH username."

}

},

"sshUserName": {

"type": "string",

"minLength": 2,

"metadata": {

"description": "These credentials can be used to remotely access the cluster. The sshUserName can only consit of digits, upper or lowercase letters, and/or the following special characters (%&'^_`{}~). Also, it cannot be the same as the cluster login username or a reserved word"

}

},

"sshPassword": {

"type": "secureString",

"maxLength": 72,

"minLength": 6,

"metadata": {

"description": "SSH password must be 6-72 characters long and must contain at least one digit, one upper case letter, and one lower case letter. It must not contain any 3 consecutive characters from the cluster login name"

}

},

"location": {

"type": "string",

"defaultValue": "[resourceGroup().location]",

"metadata": {

"description": "Location for all resources."

}

},

"headNodeVirtualMachineSize": {

"type": "string",

"defaultValue": "Standard_E8_v3",

"allowedValues": [

"Standard_A4_v2",

"Standard_A8_v2",

"Standard_E2_v3",

"Standard_E4_v3",

"Standard_E8_v3",

"Standard_E16_v3",

"Standard_E20_v3",

"Standard_E32_v3",

"Standard_E48_v3"

],

"metadata": {

"description": "This is the headnode Azure Virtual Machine size, and will affect the cost. If you don't know, just leave the default value."

}

},

"workerNodeVirtualMachineSize": {

"type": "string",

"defaultValue": "Standard_E8_v3",

"allowedValues": [

"Standard_A4_v2",

"Standard_A8_v2",

"Standard_E2_v3",

"Standard_E4_v3",

"Standard_E8_v3",

"Standard_E16_v3",

"Standard_E20_v3",

"Standard_E32_v3",

"Standard_E48_v3"

],

"metadata": {

"description": "This is the workernode Azure Virtual Machine size, and will affect the cost. If you don't know, just leave the default value."

}

}

},

"resources": [

{

"type": "Microsoft.Storage/storageAccounts",

"apiVersion": "2021-08-01",

"name": "[format('storage{0}', uniqueString(resourceGroup().id))]",

"location": "[parameters('location')]",

"sku": {

"name": "Standard_LRS"

},

"kind": "StorageV2"

},

{

"type": "Microsoft.HDInsight/clusters",

"apiVersion": "2021-06-01",

"name": "[parameters('clusterName')]",

"location": "[parameters('location')]",

"properties": {

"clusterVersion": "4.0",

"osType": "Linux",

"tier": "Standard",

"clusterDefinition": {

"kind": "spark",

"configurations": {

"gateway": {

"restAuthCredential.isEnabled": true,

"restAuthCredential.username": "[parameters('clusterLoginUserName')]",

"restAuthCredential.password": "[parameters('clusterLoginPassword')]"

}

}

},

"storageProfile": {

"storageaccounts": [

{

"name": "[replace(replace(reference(resourceId('Microsoft.Storage/storageAccounts', format('storage{0}', uniqueString(resourceGroup().id)))).primaryEndpoints.blob, 'https://', ''), '/', '')]",

"isDefault": true,

"container": "[parameters('clusterName')]",

"key": "[listKeys(resourceId('Microsoft.Storage/storageAccounts', format('storage{0}', uniqueString(resourceGroup().id))), '2021-08-01').keys[0].value]"

}

]

},

"computeProfile": {

"roles": [

{

"name": "headnode",

"targetInstanceCount": 2,

"hardwareProfile": {

"vmSize": "[parameters('headNodeVirtualMachineSize')]"

},

"osProfile": {

"linuxOperatingSystemProfile": {

"username": "[parameters('sshUserName')]",

"password": "[parameters('sshPassword')]"

}

}

},

{

"name": "workernode",

"targetInstanceCount": 2,

"hardwareProfile": {

"vmSize": "[parameters('workerNodeVirtualMachineSize')]"

},

"osProfile": {

"linuxOperatingSystemProfile": {

"username": "[parameters('sshUserName')]",

"password": "[parameters('sshPassword')]"

}

}

}

]

}

},

"dependsOn": [

"[resourceId('Microsoft.Storage/storageAccounts', format('storage{0}', uniqueString(resourceGroup().id)))]"

]

}

],

"outputs": {

"storage": {

"type": "object",

"value": "[reference(resourceId('Microsoft.Storage/storageAccounts', format('storage{0}', uniqueString(resourceGroup().id))))]"

},

"cluster": {

"type": "object",

"value": "[reference(resourceId('Microsoft.HDInsight/clusters', parameters('clusterName')))]"

}

}

}

Zwei Azure-Ressourcen sind in der Vorlage definiert:

- Microsoft.Storage/storageAccounts: Erstellen eines Azure Storage-Kontos

- Microsoft.HDInsight/cluster: Erstellen eines HDInsight-Clusters

Bereitstellen der Vorlage

Wählen Sie unten die Schaltfläche In Azure bereitstellen aus, um sich bei Azure anzumelden und die ARM-Vorlage zu öffnen.

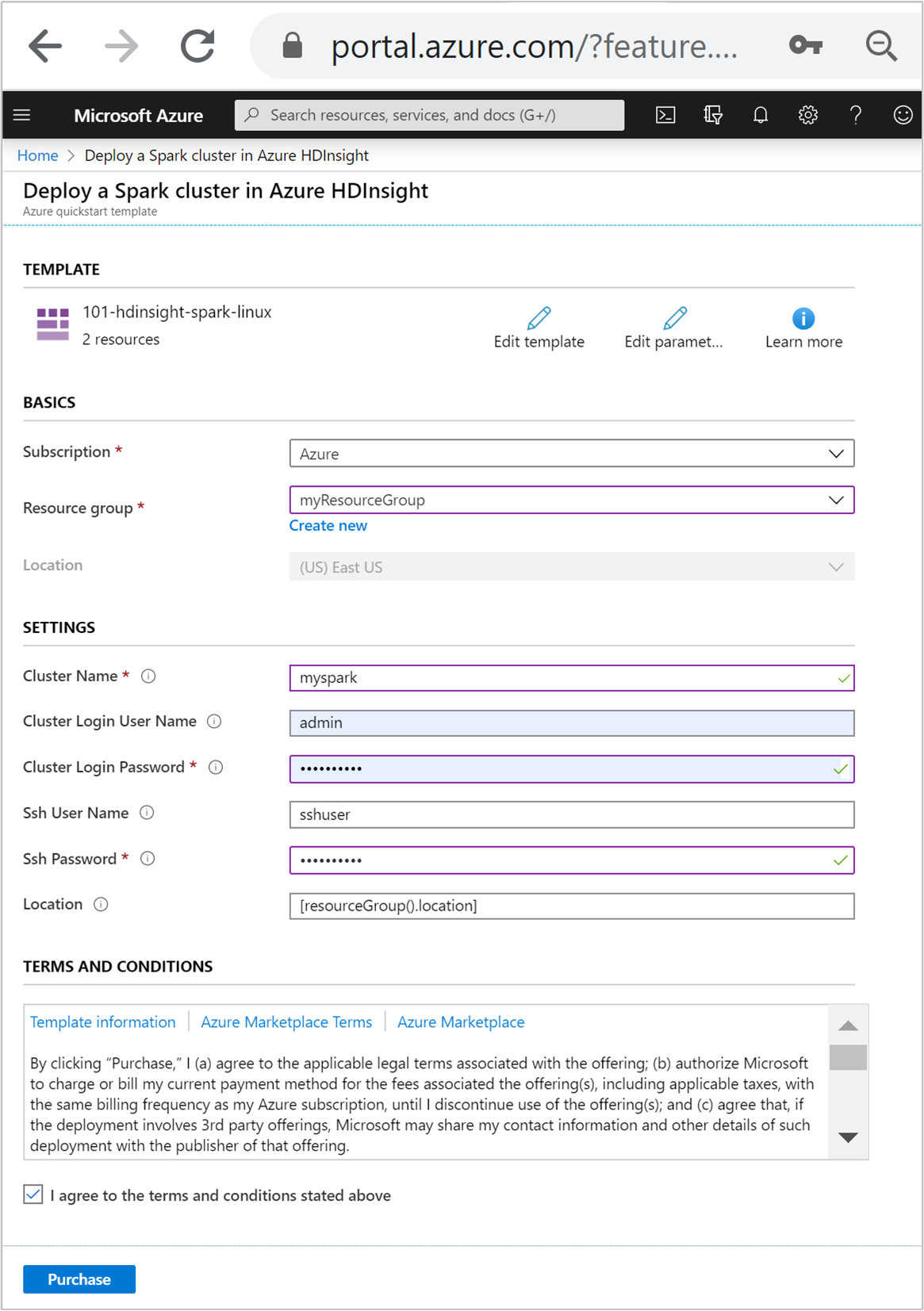

Geben Sie folgende Werte ein bzw. wählen diese aus:

Eigenschaft BESCHREIBUNG Subscription Wählen Sie in der Dropdownliste das Azure-Abonnement aus, das für den Cluster verwendet wird. Resource group Wählen Sie in der Dropdownliste Ihre vorhandene Ressourcengruppe oder die Option Neu erstellen aus. Standort Als Wert wird automatisch der Speicherort für die Ressourcengruppe eingefügt. Clustername Geben Sie einen global eindeutigen Namen ein. Verwenden Sie für diese Vorlage nur Kleinbuchstaben und Zahlen. Benutzername für Clusteranmeldung Geben Sie den Benutzernamen an, der Standardwert ist admin.Kennwort für Clusteranmeldung Geben Sie ein Kennwort an. Das Kennwort muss mindestens zehn Zeichen lang sein und mindestens eine Ziffer, einen Groß- und einen Kleinbuchstaben sowie ein nicht alphanumerisches Zeichen enthalten (mit Ausnahme folgender Zeichen: ' ` ").SSH-Benutzername Geben Sie den Benutzernamen an, der Standardwert ist sshuser.SSH-Kennwort Geben Sie das Kennwort an.

Sehen Sie sich die GESCHÄFTSBEDINGUNGEN an. Wählen Sie anschließend Ich stimme den oben genannten Geschäftsbedingungen zu und dann Kaufen aus. Sie erhalten eine Benachrichtigung, dass die Bereitstellung derzeit durchgeführt wird. Das Erstellen eines Clusters dauert ca. 20 Minuten.

Sollte bei der HDInsight-Clustererstellung ein Problem auftreten, verfügen Sie unter Umständen nicht über die erforderlichen Berechtigungen. Weitere Informationen finden Sie unter Voraussetzungen für die Zugriffssteuerung.

Überprüfen der bereitgestellten Ressourcen

Nachdem der Cluster erstellt wurde, erhalten Sie die Benachrichtigung Bereitstellung erfolgreich mit dem Link Zu Ressource wechseln. Auf der Seite „Ressourcengruppe“ sind der neue HDInsight-Cluster und der mit dem Cluster verbundene Standardspeicher aufgeführt. Jeder Cluster verfügt über eine Abhängigkeit von einer Azure Storage-, Azure Data Lake Storage Gen1- oder Azure Data Lake Storage Gen2-Instanz. Dieses wird als Standardspeicherkonto bezeichnet. Der HDInsight-Cluster und das dazugehörige Speicherkonto müssen sich in derselben Azure-Region befinden. Beim Löschen von Clustern wird die Speicherkontoabhängigkeit nicht gelöscht. Dieses wird als Standardspeicherkonto bezeichnet. Der HDInsight-Cluster und das zugehörige Speicherkonto müssen sich in derselben Azure-Region befinden. Beim Löschen von Clustern wird das Speicherkonto nicht gelöscht.

Erstellen einer Jupyter Notebook-Datei

Jupyter Notebook ist eine interaktive Notebook-Umgebung, die verschiedene Programmiersprachen unterstützt. Sie können eine Jupyter Notebook-Datei dazu verwenden, mit Ihren Daten zu interagieren, Code mit Markdowntext zu kombinieren und einfache Visualisierungen durchzuführen.

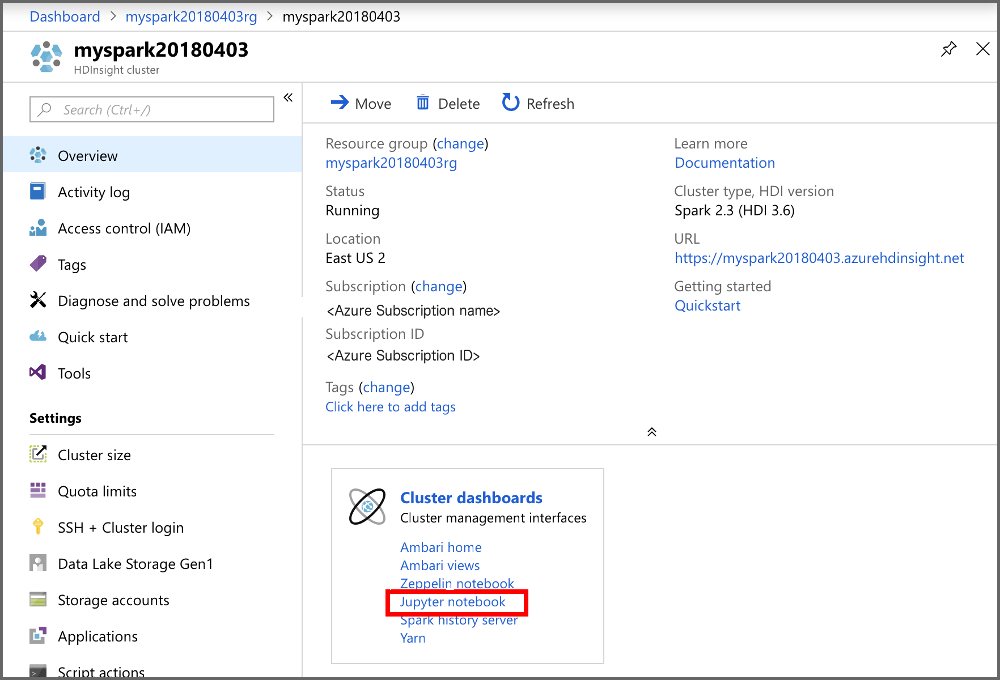

Öffnen Sie das Azure-Portal.

Wählen Sie HDInsight-Cluster und dann den von Ihnen erstellten Cluster aus.

Wählen Sie im Portal im Abschnitt Clusterdashboards die Option Jupyter Notebook aus. Geben Sie die Anmeldeinformationen für den Cluster ein, wenn Sie dazu aufgefordert werden.

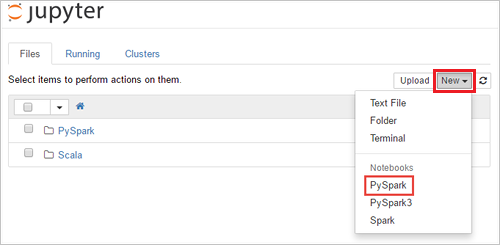

Wählen Sie Neu>PySpark aus, um ein Notebook zu erstellen.

Ein neues Notebook mit dem Namen „Untitled“ (Untitled.pynb) wird erstellt und geöffnet.

Ausführen von Apache Spark-SQL-Anweisungen

SQL (Structured Query Language) ist die gängigste und am häufigsten verwendete Sprache zum Abfragen und Transformieren von Daten. Spark SQL fungiert als Erweiterung von Apache Spark für die Verarbeitung strukturierter Daten mit der vertrauten SQL-Syntax.

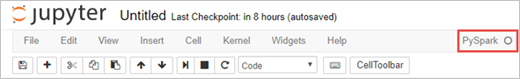

Überprüfen Sie, ob der Kernel bereit ist. Der Kernel ist bereit, wenn im Notebook neben dem Kernelnamen ein leerer Kreis angezeigt wird. Ein ausgefüllter Kreis gibt an, dass der Kernel ausgelastet ist.

alt-text="Kernel-Status." border="true":::

alt-text="Kernel-Status." border="true":::Wenn Sie das Notebook zum ersten Mal starten, führt der Kernel im Hintergrund einige Aufgaben durch. Warten Sie, bis der Kernel bereit ist.

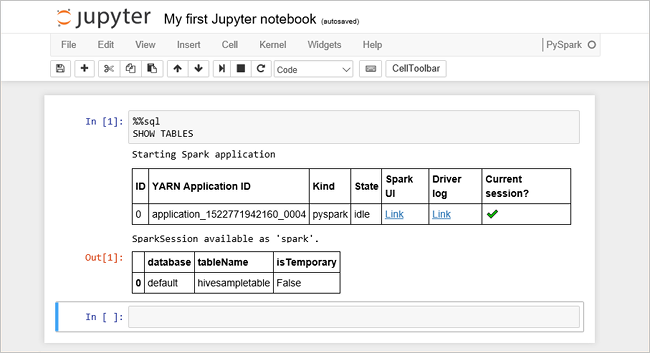

Fügen Sie den folgenden Code in eine leere Zelle ein, und drücken Sie UMSCHALT+EINGABE , um den Code auszuführen. Der Befehl listet die Hive-Tabellen im Cluster auf:

%%sql SHOW TABLESWenn Sie eine Jupyter Notebook-Datei mit Ihrem HDInsight-Cluster verwenden, erhalten Sie eine vordefinierte

spark-Sitzung, die Sie zum Ausführen von Hive-Abfragen mit Spark SQL verwenden können.%%sqlweist Jupyter Notebook an, die vordefiniertespark-Sitzung für die Ausführung der Hive-Abfrage zu verwenden. Die Abfrage ruft die ersten zehn Zeilen aus einer Hive-Tabelle (hivesampletable) ab, die standardmäßig in allen HDInsight-Clustern enthalten ist. Wenn Sie die Abfrage erstmals übermitteln, erstellt Jupyter eine Spark-Anwendung für das Notebook. Dieser Vorgang dauert ungefähr 30 Sekunden. Sobald die Spark-Anwendung bereit ist, wird die Abfrage innerhalb etwa einer Sekunde ausgeführt, und die Ergebnisse werden zurückgegeben. Die Ausgabe sieht wie folgt aus: y in HDInsight" border="true":::

y in HDInsight" border="true":::Bei jeder Ausführung einer Abfrage in Jupyter wird auf der Titelleiste Ihres Webbrowserfensters neben dem Notebooktitel der Status (Beschäftigt) angezeigt. Außerdem sehen Sie in der rechten oberen Ecke einen ausgefüllten Kreis neben dem Text PySpark.

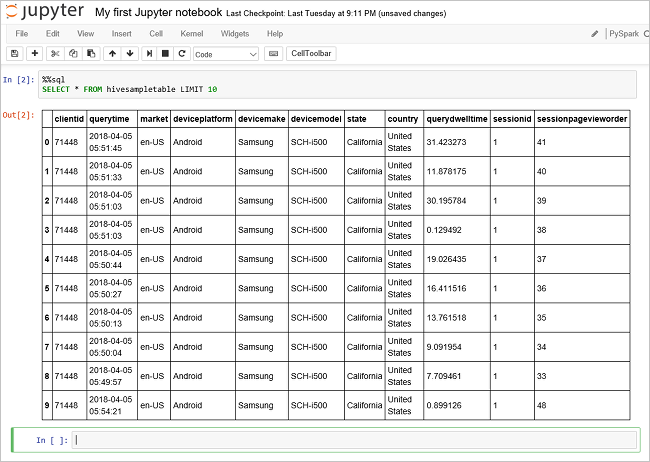

Führen Sie eine weitere Abfrage aus, um die Daten in

hivesampletableanzuzeigen.%%sql SELECT * FROM hivesampletable LIMIT 10Der Bildschirm wird aktualisiert, und die Ausgabe der Abfrage wird angezeigt.

Insight" border="true":::

Insight" border="true":::Wählen Sie im Menü Datei des Notebooks die Option Schließen und Anhalten aus. Durch Herunterfahren des Notebooks werden die Clusterressourcen freigegeben (einschließlich der Spark-Anwendung).

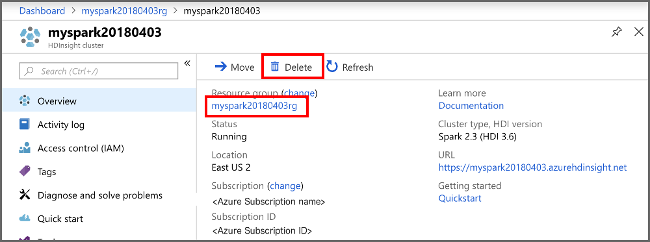

Bereinigen von Ressourcen

Nachdem Sie den Schnellstart abgeschlossen haben, können Sie den Cluster löschen. Mit HDInsight werden Ihre Daten in Azure Storage gespeichert, sodass Sie einen Cluster problemlos löschen können, wenn er nicht verwendet wird. Für einen HDInsight-Cluster fallen auch dann Gebühren an, wenn er nicht verwendet wird. Da die Gebühren für den Cluster erheblich höher sind als die Kosten für den Speicher, ist es sinnvoll, nicht verwendete Cluster zu löschen.

Navigieren Sie im Azure-Portal zu Ihrem Cluster, und wählen Sie Löschen aus.

sight cluster" border="true":::

sight cluster" border="true":::

Sie können auch den Namen der Ressourcengruppe auswählen, um die Seite für die Ressourcengruppe zu öffnen, und dann Ressourcengruppe löschen auswählen. Indem Sie die Ressourcengruppe löschen, löschen Sie sowohl den HDInsight-Cluster als auch das Standardspeicherkonto.

Nächste Schritte

In dieser Schnellstartanleitung haben Sie erfahren, wie Sie einen Apache Spark-Cluster in HDInsight erstellen und eine einfache Spark SQL-Abfrage ausführen. Im nächsten Tutorial erfahren Sie, wie Sie mithilfe eines HDInsight-Clusters interaktive Abfragen für Beispieldaten ausführen.