Übersicht über die Azure Synapse Data Explorer-Datenerfassung (Vorschau)

Die Datenerfassung ist der Prozess, mit dem Datensätze aus einer oder mehreren Quellen geladen werden, um Daten in eine Tabelle in einen Azure Synapse Data Explorer-Pool zu importieren. Nach der Erfassung sind die Daten für Abfragen verfügbar.

Der Datenverwaltungsdienst von Azure Synapse Data Explorer, der für die Datenerfassung zuständig ist, implementiert die folgenden Prozesse:

- Daten werden in Batches oder Datenströmen aus einer externen Quelle gepullt, und Anforderungen werden aus einer ausstehenden Azure-Warteschlange gelesen.

- Batchdaten, die an dieselbe Datenbank und Tabelle gesendet werden, sind für den Durchsatz der Datenerfassung optimiert.

- Anfängliche Daten werden überprüft, und das Format wird bei Bedarf konvertiert.

- Die weitere Datenbearbeitung umfasst den Schemaabgleich sowie die Organisation, Indizierung, Codierung und Komprimierung der Daten.

- Die Daten werden gemäß der festgelegten Aufbewahrungsrichtlinie im Speicher gespeichert.

- Für erfasste Daten erfolgt ein Commit in der Engine, wo sie dann für Abfragen zur Verfügung stehen.

Unterstützte Datenformate, Eigenschaften und Berechtigungen

Erfassungseigenschaften: Eigenschaften, die Einfluss auf die Datenerfassung haben (z. B. Tagging, Zuordnung, Erstellungszeit).

Berechtigungen: Zum Erfassen von Daten benötigt der Prozess Berechtigungen auf Ebene der Datenbankerfassung. Für andere Aktionen wie z. B. Abfragen sind möglicherweise die Berechtigungen „Datenbankadministrator“, „Datenbankbenutzer“ oder „Tabellenadministrator“ erforderlich.

Batcherfassung und Streamingerfassung

Bei der Batcherfassung werden die Daten in Batches zusammengefasst und für einen hohen Erfassungsdurchsatz optimiert. Diese Methode stellt die bevorzugte und leistungsfähigste Art der Erfassung dar. Die Daten werden gemäß den Erfassungseigenschaften in Batches zusammengefasst. Kleine Datenbatches werden zusammengeführt und für schnelle Abfrageergebnisse optimiert. Die Richtlinie für die Batcherfassung kann für Datenbanken oder Tabellen festgelegt werden. Standardmäßig beträgt der Maximalwert für Batches 5 Minuten, 1.000 Elemente oder eine Gesamtgröße von 1 GB. Das Datengröße für einen Batcherfassungsbefehl ist auf 4 GB beschränkt.

Die Streamingerfassung erfolgt durch eine fortlaufende Datenerfassung aus einer Streamingquelle. Durch die Streamingerfassung sinkt die Latenz bei kleinen Datensätzen pro Tabelle auf nahezu Echtzeit. Die Daten werden anfänglich im Zeilenspeicher erfasst und dann in Spaltenspeichererweiterungen verschoben.

Erfassungsmethoden und -tools

Azure Synapse Data Explorer unterstützt mehrere Erfassungsmethoden mit jeweils eigenen Zielszenarien. Diese Methoden umfassen Erfassungstools, Connectors und Plug-Ins für verschiedene Dienste, verwaltete Pipelines, die programmgesteuerte Erfassung mithilfe von SDKs und Direktzugriff auf die Erfassung.

Erfassung mit verwalteten Pipelines

Für Organisationen, die eine Verwaltung (Drosselung, Wiederholungen, Überwachungen, Warnungen usw.) über einen externen Dienst durchführen möchten, stellt die Verwendung eines Connectors wahrscheinlich die geeignetste Lösung dar. Die Erfassung in der Warteschlange eignet sich für große Datenmengen. Azure Synapse Data Explorer unterstützt die folgenden Azure Pipelines:

- Event Hub: Eine Pipeline, die Ereignisse von Diensten an Azure Synapse Data Explorer überträgt. Weitere Informationen finden Sie unter Event Hub-Datenverbindung (Vorschau).

- Synapse-Pipelines: Ein vollständig verwalteter Datenintegrationsdienst für Analyseworkloads in Synapse-Pipelines stellt eine Verbindung mit über 90 unterstützten Quellen her, um eine effiziente und resiliente Datenübertragung zu ermöglichen. Synapse-Pipelines führen die Vorbereitung, Transformation und Anreicherung der Daten durch, um Erkenntnisse zu erhalten, die auf unterschiedliche Art und Weise überwacht werden können. Dieser Dienst kann als einmalige Lösung verwendet, periodisch ausgeführt oder durch bestimmte Ereignisse ausgelöst werden.

Programmgesteuerte Erfassung mit SDKs

Azure Synapse Data Explorer bietet SDKs, die für Abfragen und die Datenerfassung verwendet werden können. Die programmgesteuerte Erfassung ist dafür optimiert, die Erfassungskosten (COGs) zu senken, indem Speichertransaktionen während und nach dem Erfassungsprozess minimiert werden.

Führen Sie zunächst die folgenden Schritte aus, um die Data Explorer-Poolendpunkte zum Konfigurieren der programmgesteuerten Erfassung abzurufen:

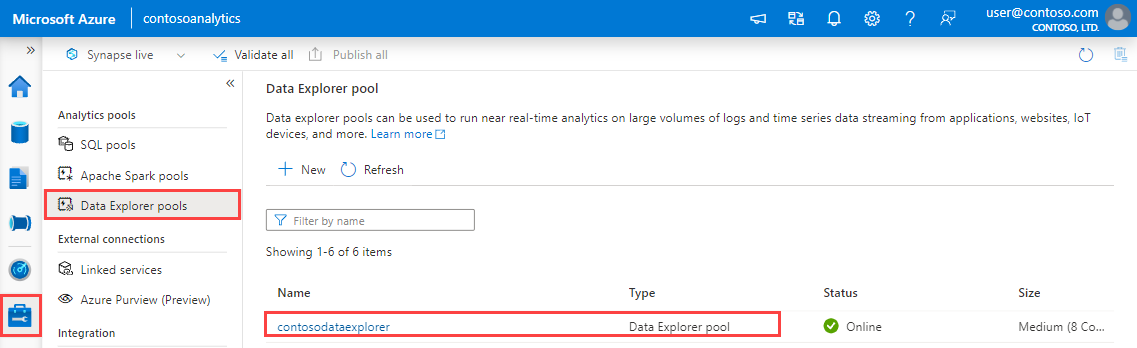

Wählen Sie in Synapse Studio im linken Bereich die Option Verwalten>Data Explorer-Pools aus.

Wählen Sie den Data Explorer-Pool aus, zu dem Sie Details anzeigen möchten.

Notieren Sie sich die Abfrage- und Datenerfassungsendpunkte. Verwenden Sie den Abfrageendpunkt als Cluster, wenn Sie Verbindungen mit Ihrem Data Explorer-Pool konfigurieren. Verwenden Sie beim Konfigurieren von SDKs für die Datenerfassung den Datenerfassungsendpunkt.

Verfügbare SDKs und Open-Source-Projekte

Tools

- 1-Klick-Erfassung: Ermöglicht das schnelle Erfassen von Daten durch Erstellen und Anpassen von Tabellen aus einer breiten Palette von Quelltypen. Bei der 1-Klick-Erfassung werden basierend auf der Datenquelle in Azure Synapse Data Explorer automatisch Tabellen und Zuordnungsstrukturen vorschlagen. Sie können die 1-Klick-Erfassung für die einmalige Erfassung verwenden oder zum Definieren einer kontinuierlichen Erfassung über Event Grid in dem Container, in dem die Daten erfasst wurden.

Befehle zur Steuerung der Erfassung in der Kusto-Abfragesprache

Es gibt eine Reihe von Methoden, mit denen Daten mithilfe von KQL-Befehlen (Kusto Query Language) direkt in der Engine erfasst werden können. Da diese Methode die Datenverwaltungsdienste umgeht, eignet sie sich nur für die Erkundung und Prototyperstellung. Verwenden Sie diese Methode nicht in Produktionsszenarien oder Szenarien mit hohem Volumen.

Inlineerfassung: An die Engine wird ein Steuerungsbefehl (.ingest inline) gesendet, und die zu erfassenden Daten werden direkt im Befehlstext angegeben. Diese Methode ist für improvisierte Testzwecke vorgesehen.

Erfassung aus einer Abfrage: An die Engine wird ein Steuerungsbefehl („.set“, „.append“, „.set-or-append“ oder „.set-or-replace“) gesendet, und die Daten werden indirekt als die Ergebnisse einer Abfrage oder eines Befehls angegeben.

Erfassung aus dem Speicher (Pull): An die Engine wird ein Steuerungsbefehl (.ingest into) gesendet, und die Daten sind in einem externen Speicher (beispielsweise in Azure Blob Storage) gespeichert, auf den die Engine zugreifen kann und auf den durch den Befehl verwiesen wird.

Ein Beispiel für die Verwendung von Erfassungssteuerungsbefehlen finden Sie unter Schnellstart: Analysieren mit Data Explorer (Vorschau).

Erfassungsprozess

Nachdem Sie die am besten geeignete Erfassungsmethode für Ihre Anforderungen ausgewählt haben, führen Sie die folgenden Schritte aus:

Festlegen der Aufbewahrungsrichtlinie

Für Daten, die in einer Tabelle in Azure Synapse Data Explorer erfasst werden, gilt die effektive Aufbewahrungsrichtlinie der Tabelle. Wurde für eine Tabelle nicht explizit eine effektive Aufbewahrungsrichtlinie festgelegt, wird sie von der Aufbewahrungsrichtlinie der Datenbank abgeleitet. Die heiße Speicherebene für die Aufbewahrung ist eine Funktion aus der Clustergröße und Ihrer Aufbewahrungsrichtlinie. Wenn Sie mehr Daten erfassen, als Speicherplatz verfügbar ist, werden die zuerst erfassten Daten in die kalte Aufbewahrung überführt.

Stellen Sie sicher, dass die Aufbewahrungsrichtlinie der Datenbank Ihren Anforderungen entspricht. Ist dies nicht der Fall, überschreiben Sie sie explizit auf Tabellenebene. Weitere Informationen finden Sie unter Aufbewahrungsrichtlinie.

Erstellen einer Tabelle

Um Daten zu erfassen, muss vorab eine Tabelle erstellt werden. Nutzen Sie eine der folgenden Optionen:

Erstellen einer Tabelle mit einem Befehl Ein Beispiel für die Verwendung des Befehls für die Tabellenerstellung finden Sie unter Schnellstart: Analysieren mit Data Explorer (Vorschau).

Erstellen Sie eine Tabelle mit der 1-Klick-Erfassung.

Hinweis

Wenn ein Datensatz unvollständig ist oder ein Feld nicht als erforderlicher Datentyp analysiert werden kann, werden die entsprechenden Tabellenspalten mit Nullwerten gefüllt.

Erstellen einer Schemazuordnung

Die Schemazuordnung hilft dabei, Quelldatenfelder an Spalten der Zieltabelle zu binden. Die Zuordnung ermöglicht Ihnen, Daten aus verschiedenen Quellen basierend auf den definierten Attributen in dieselbe Tabelle zu übernehmen. Es werden unterschiedliche Zuordnungstypen unterstützt – sowohl zeilenorientiert (CSV, JSON und Avro) als auch spaltenorientiert (Parquet). Bei den meisten Methoden können Zuordnungen auch vorab in der Tabelle erstellt und vom Erfassungsbefehlsparameter referenziert werden.

Einrichten einer Updaterichtlinie (optional)

Einige der Datenformatzuordnungen (Parquet, JSON und Avro) unterstützen einfache und nützliche Transformationen während der Erfassung. Wenn für das Szenario eine komplexere Verarbeitung zur Erfassungszeit erforderlich ist, verwenden Sie eine Updaterichtlinie, die eine einfache Verarbeitung mithilfe von Befehlen der Kusto-Abfragesprache ermöglicht. Die Updaterichtlinie führt automatisch Extraktionen und Transformationen der erfassten Daten in der ursprünglichen Tabelle aus und erfasst die resultierenden Daten in einer oder mehreren Zieltabellen. Legen Sie Ihre Updaterichtlinie fest.