Kapazitätsplanung für Active Directory Domain Services

Dieses Thema wurde ursprünglich von Ken Brumfield geschrieben, Program Manager bei Microsoft, und enthält Empfehlungen zur Kapazitätsplanung für Active Directory Domain Services (AD DS).

Ziele der Kapazitätsplanung

Kapazitätsplanung ist nicht identisch mit der Problembehandlung bei Leistungsvorfällen. Sie sind eng miteinander verbunden, aber sehr unterschiedlich. Die Ziele der Kapazitätsplanung sind:

- Ordnungsgemäßes Implementieren und Betreiben einer Umgebung

- Minimieren Sie den Zeitaufwand für die Behandlung von Leistungsproblemen.

Bei der Kapazitätsplanung kann eine Organisation ein Basisziel von 40 % Prozessorauslastung in Spitzenzeiten erzielen, um die Anforderungen an die Clientleistung zu erfüllen und die für das Upgrade der Hardware im Rechenzentrum erforderliche Zeit zu berücksichtigen. Zur Benachrichtigung bei ungewöhnlichen Leistungsvorfällen kann ein Überwachungswarnungs-Schwellenwert über ein Intervall von fünf Minuten auf 90 % festgelegt werden.

Der Unterschied ist: Bei ständiger Überschreitung eines Schwellenwerts für die Kapazitätsverwaltung (ein einmaliges Ereignis ist nicht von Belang) wäre das Hinzufügen von Kapazität (d. h. Hinzufügen weiterer oder schnellerer Prozessoren) oder die mehrere Server übergreifende Skalierung des Dienstes eine Lösung. Schwellenwerte für Leistungswarnungen geben an, dass die Clienterfahrung derzeit beeinträchtigt wird und sofortige Schritte erforderlich sind, um das Problem zu beheben.

Zur Veranschaulichung: Die Kapazitätsverwaltung entspricht den Maßnahmen, einen Autounfall zu verhindern (defensives Fahren, Sicherstellen, dass die Bremsen ordnungsgemäß funktionieren usw.), während die Leistungsproblembehandlung dem entspricht, was Polizei, Feuerwehr und Notfallmediziner nach einem Unfall leisten. Hier geht es um „defensives Fahren“, im Active Directory-Stil.

In den letzten Jahren hat sich die Kapazitätsplanungsanleitung für Hochskalierungssysteme erheblich verändert. Die folgenden Änderungen in Systemarchitekturen haben grundlegende Annahmen zum Entwerfen und Skalieren eines Diensts in Frage gestellt:

- 64-Bit-Serverplattformen

- Virtualisierung

- Kritischere Betrachtung des Stromverbrauchs

- SSD-Speicher

- Cloudszenarien

Darüber hinaus verschiebt sich der Ansatz von einer serverbasierten Kapazitätsplanungsübung zu einer dienstbasierten Kapazitätsplanungsübung. Active Directory Domain Services (AD DS), ein ausgereifter verteilter Dienst, den viele Microsoft- und Drittanbieterprodukte als Back-End verwenden, wird zu einem der wichtigsten Produkte für die richtige Planung, um die erforderliche Kapazität für die Ausführung anderer Anwendungen sicherzustellen.

Grundlegende Anforderungen für die Anleitung zur Kapazitätsplanung

In diesem Artikel gelten die folgenden grundlegenden Anforderungen:

- Die Leser haben die Richtlinien zur Leistungsoptimierung für Windows Server 2012 R2 gelesen und kennen sie.

- Die Windows Server-Plattform ist eine x64-basierte Architektur. Aber auch wenn Ihre Active Directory-Umgebung unter Windows Server 2003 x86 (jetzt über das Ende des Supportlebenszyklus hinaus) installiert ist und über eine Verzeichnisinformationsstruktur (Directory Information Tree, DIT) verfügt, die weniger als 1,5 GB groß ist und problemlos im Arbeitsspeicher gespeichert werden kann, gelten die Richtlinien aus diesem Artikel weiterhin.

- Die Kapazitätsplanung ist ein kontinuierlicher Prozess, und Sie sollten regelmäßig überprüfen, wie gut die Umgebung die Erwartungen erfüllt.

- Die Optimierung erfolgt über mehrere Hardwarelebenszyklen, da sich die Hardwarekosten ändern. Beispielsweise wird Arbeitsspeicher billiger, die Kosten pro Kern sinken, oder der Preis für verschiedene Speicheroptionen ändert sich.

- Planen Sie die Spitzenlastperiode des Tages. Sie sollten dies in Intervallen von 30 Minuten oder Stunden betrachten. Alles, was darüber liegt, kann die tatsächlichen Spitzen verbergen, und alles, was darunter liegt, kann durch „vorübergehende Spitzen“ verzerrt werden.

- Planen Sie das Wachstum im Laufe des Hardwarelebenszyklus für das Unternehmen. Dies kann eine Strategie des gestaffelten Aktualisierens oder Hinzufügens von Hardware oder eine vollständige Aktualisierung alle drei bis fünf Jahre beinhalten. Jedes erfordert eine „Schätzung“, wie stark die Last in Active Directory wächst. Bei dieser Bewertung helfen verlaufsbezogene Daten, wenn sie erfasst werden.

- Planen Sie Fehlertoleranz ein. Sobald eine Schätzung N abgeleitet wurde, planen Sie Szenarien ein, die N – 1, N – 2, N – x enthalten.

Fügen Sie zusätzliche Server entsprechend den Anforderungen der Organisation hinzu, um sicherzustellen, dass der Verlust eines einzelnen Servers oder mehrerer Server die maximalen Spitzenkapazitätsschätzungen nicht überschreitet.

Berücksichtigen Sie auch, dass der Wachstumsplan und der Fehlertoleranzplan integriert werden müssen. Wenn beispielsweise ein Domänencontroller erforderlich ist, um die Last zu unterstützen, die Last jedoch schätzungsweise im nächsten Jahr verdoppelt wird und insgesamt zwei Domänencontroller erforderlich werden, ist nicht genügend Kapazität vorhanden, um die Fehlertoleranz zu unterstützen. Die Lösung wäre, mit drei Domänencontrollern zu beginnen. Sie könnten auch planen, den dritten Domänencontroller nach 3 oder 6 Monaten hinzuzufügen, wenn die Budgets knapp sind.

Hinweis

Das Hinzufügen von Anwendungen mit Active Directory-Unterstützung kann spürbare Auswirkungen auf die Domänencontroller-Last haben, unabhängig davon, ob die Last von den Anwendungsservern oder Clients ausgeht.

Dreistufiger Prozess für den Kapazitätsplanungszyklus

Entscheiden Sie bei der Kapazitätsplanung zunächst, welche Dienstqualität benötigt wird. Ein Kernrechenzentrum unterstützt beispielsweise ein höheres Maß an Parallelität und erfordert eine konsistentere Erfahrung für Benutzer*innen und nutzende Anwendungen, was eine größere Aufmerksamkeit auf Redundanz und Minimierung von System- und Infrastrukturengpässen erfordert. Im Gegensatz dazu benötigt ein Satellitenstandort mit einer Handvoll Benutzer*innen nicht die gleiche Parallelitäts- oder Fehlertoleranz. Daher benötigt das Satellitenbüro möglicherweise nicht so viel Aufmerksamkeit für die Optimierung der zugrunde liegenden Hardware und Infrastruktur, was zu Kosteneinsparungen führen kann. Alle hier vorliegenden Empfehlungen und Anleitungen dienen der optimalen Leistung und können für Szenarien mit weniger anspruchsvollen Anforderungen selektiv gelockert werden.

Die nächste Frage lautet: virtualisiert oder physisch? Aus Kapazitätsplanungssicht gibt es keine richtige oder falsche Antwort; es gibt nur einen anderen Satz von Variablen, mit denen sie arbeiten. Virtualisierungsszenarien laufen auf eine von zwei Optionen hinaus:

- „Direkte Zuordnung“ mit einem Gast pro Host (wobei Virtualisierung nur vorhanden ist, um die physische Hardware vom Server abzustrahieren)

- „Freigegebener Host“

Test- und Produktionsszenarien zeigen, dass das Szenario „direkte Zuordnung“ wie ein physischer Host behandelt werden kann. „Freigegebener Host“ bringt jedoch eine Reihe von Überlegungen mit sich, die später ausführlicher beschrieben werden. Das Szenario „freigegebener Host“ bedeutet, dass AD DS auch um Ressourcen konkurriert, und dies ist mit Einschränkungen und Optimierungsüberlegungen verbunden.

Unter Berücksichtigung dieser Überlegungen ist der Kapazitätsplanungszyklus ein iterativer dreistufiger Prozess:

- Messen Sie die vorhandene Umgebung, ermitteln Sie, wo sich die Systemengpässe derzeit befinden, und ermitteln Sie Umgebungsgrundlagen, die zum Planen der benötigten Kapazität erforderlich sind.

- Ermitteln Sie die erforderliche Hardware gemäß den in Schritt 1 beschriebenen Kriterien.

- Überwachen und überprüfen Sie, ob die implementierte Infrastruktur gemäß den Spezifikationen funktioniert. Einige in diesem Schritt gesammelte Daten werden für den nächsten Zyklus der Kapazitätsplanung zur Baseline.

Anwenden des Prozesses

Stellen Sie zum Optimieren der Leistung sicher, dass diese Hauptkomponenten ordnungsgemäß ausgewählt und auf die Anwendungslasten abgestimmt sind:

- Arbeitsspeicher

- Netzwerk

- Storage

- Prozessor

- Netzwerkanmeldung

Die grundlegenden Speicheranforderungen von AD DS und das allgemeine Verhalten gut geschriebener Clientsoftware ermöglichen Umgebungen mit 10.000 bis 20.000 Benutzer*innen, auf hohe Investitionen in die Kapazitätsplanung in Bezug auf physische Hardware zu verzichten, da fast jedes moderne Serverklassensystem die Last bewältigen wird. In der folgenden Tabelle wird zusammengefasst, wie eine vorhandene Umgebung ausgewertet wird, um die richtige Hardware auszuwählen. Jede Komponente wird in den nachfolgenden Abschnitten ausführlich analysiert, um AD DS-Administrator*innen bei der Bewertung ihrer Infrastruktur mithilfe von Basisempfehlungen und umgebungsspezifischen Prinzipien zu unterstützen.

Im Allgemeinen:

- Jede auf aktuellen Daten basierende Größenanpassung ist nur für die aktuelle Umgebung korrekt.

- Bei Schätzungen sollte erwartet werden, dass die Nachfrage im Laufe des Lebenszyklus der Hardware steigt.

- Bestimmen Sie, ob Sie heute zu groß werden und in die größere Umgebung hineinwachsen oder im Laufe des Lebenszyklus die Kapazität erweitern möchten.

- Für die Virtualisierung gelten dieselben Prinzipien und Methoden für die Kapazitätsplanung, mit der Ausnahme, dass der Mehraufwand für die Virtualisierung allen domänenbezogenen Elementen hinzugefügt werden muss.

- Kapazitätsplanung ist wie jeder Versuch, Prognosen zu machen, KEINE genaue Wissenschaft. Erwarten Sie nicht, dass die Dinge perfekt und mit einer Genauigkeit von 100 % berechnet werden. Diese Anleitung hier ist die Minimalempfehlung; fügen Sie zusätzliche Kapazität für zusätzliche Sicherheit hinzu, und überprüfen Sie kontinuierlich, ob die Zielvorgabe für die Umgebung eingehalten wird.

Übersichtstabellen zur Datensammlung

Neue Umgebung

| Komponente | Schätzungen |

|---|---|

| Größe des Speichers/der Datenbank | 40 KB bis 60 KB für jeden Benutzer |

| RAM | Datenbankgröße Basisbetriebssystemempfehlungen Drittanbieteranwendungen |

| Netzwerk | 1 GB |

| CPU | 1.000 gleichzeitige Benutzer für jeden Kern |

Allgemeine Bewertungskriterien

| Komponente | Auswertungskriterien | Planungsaspekte |

|---|---|---|

| Größe des Speichers/der Datenbank | Der Abschnitt „So aktivieren Sie die Protokollierung durch Defragmentierung freigegeben Datenträgerspeicherplatzes“ unter Speichergrenzwerte | |

| Leistung des Speichers/der Datenbank |

|

|

| RAM |

|

|

| Netzwerk |

|

|

| CPU |

|

|

| Anmeldedienst |

|

|

Planung

Die Community hat lange für die Dimensionierung von AD DS empfohlen, „so viel RAM einzusetzen, wie es der Datenbankgröße entspricht“. In den meisten Fällen war diese Empfehlung alles, worüber sich die meisten Umgebungen Sorgen machen mussten. Aber das Ökosystem, das AD DS nutzt, ist seit seiner Einführung im Jahr 1999 viel größer geworden, ebenso wie die AD DS-Umgebungen selbst. Der Anstieg der Computeleistung und der Wechsel von x86-Architekturen zu x64-Architekturen hat zwar die subtileren Aspekte der Größenanpassung für die Leistung für eine größere Gruppe von Kund*innen, die AD DS auf physischer Hardware ausführen, irrelevant gemacht hat, aber die zunehmende Virtualisierung hat dazu geführt, dass die Optimierungsaspekte wieder für eine größere Zielgruppe als zuvor interessant geworden sind.

In der folgenden Anleitung geht es daher darum, die Anforderungen von Active Directory als Dienst unabhängig davon zu bestimmen und zu planen, ob es in einem physischen, einem gemischt virtuellen/physischen oder einem rein virtualisierten Szenario bereitgestellt wird. Daher werden wir die Auswertung auf jede der vier Hauptkomponenten aufteilen: Speicher, Arbeitsspeicher, Netzwerk und Prozessor. Kurz gesagt, um die Leistung auf AD DS zu maximieren, besteht das Ziel darin, so nahe wie möglich am Prozessor zu sein.

RAM

Ganz einfach: Je mehr im RAM zwischengespeichert werden kann, desto weniger ist es notwendig, auf den Datenträger zu wechseln. Um die Skalierbarkeit des Servers zu maximieren, sollte die minimale RAM-Menge der Summe der aktuellen Datenbankgröße, der SYSVOL-Gesamtgröße, der empfohlenen Menge des Betriebssystems und der Herstellerempfehlungen für die Agents (Antivirus, Überwachung, Sicherung usw.) entsprechen. Eine zusätzliche Menge sollte hinzugefügt werden, um das Wachstum über die Lebensdauer des Servers zu berücksichtigen. Dies wird auf der Grundlage von Schätzungen des Datenbankwachstums basierend auf Umgebungsveränderungen der Umgebung gemäß subjektiv sein.

Für Umgebungen (z. B. Satellitenstandorte), in denen die Maximierung der RAM-Menge nicht kosteneffizient oder nicht möglich ist (DIT ist zu groß), ziehen Sie den Abschnitt „Speicher“ zu Rate, um sicherzustellen, dass der Speicher ordnungsgemäß entworfen wird.

Eine logische Konsequenz, die im allgemeinen Kontext bei der Größenanpassung des Arbeitsspeichers auftritt, ist die Größenanpassung der Auslagerungsdatei. Im gleichen Kontext wie alles andere, was den Arbeitsspeicher betrifft, ist das Ziel, den Wechsel zum viel langsameren Datenträger zu minimieren. Daher sollte sich die Frage von „Wie sollte die Auslagerungsdatei dimensioniert sein?“ ändern in „Wie viel RAM ist erforderlich, um das Paging zu minimieren?“. Die Antwort auf die letztgenannte Frage wird im weiteren Verlauf dieses Abschnitts beschrieben. Dadurch bleibt der Großteil der Diskussion über die Dimensionierung der Auslagerungsdatei im Bereich der allgemeinen Betriebssystemempfehlungen und der Notwendigkeit, das System für Speicherabbilder zu konfigurieren, die nicht mit der AD DS-Leistung zusammenhängen.

Auswerten

Die Menge an RAM, die ein Domänencontroller (DC) benötigt, ist aus diesen Gründen eigentlich eine komplexe Übung:

- Der Versuch, ein vorhandenes System zu verwenden, um zu messen, wie viel RAM benötigt wird, birgt in sich ein hohes Fehlerpotenzial, da LSASS unter Speicherdruckbedingungen Kürzungen vornimmt, wodurch der Bedarf künstlich verringert wird.

- Die subjektive Tatsache ist, dass ein einzelner Domänencontroller nur zwischenspeichern muss, was für seine Clients „interessant“ ist. Dies bedeutet, dass die Daten, die auf einem Domänencontroller an einem Standort mit nur einem Exchange-Server zwischengespeichert werden müssen, sich stark von den Daten unterscheiden, die auf einem Domänencontroller zwischengespeichert werden müssen, der nur Benutzer authentifiziert.

- Die Arbeit zum Auswerten des RAM für jeden Domänencontroller von Fall zu Fall ist kostenintensiv und ändert sich, wenn sich die Umgebung ändert.

- Die Kriterien hinter der Empfehlung unterstützen das Treffen fundierter Entscheidungen:

- Je mehr im RAM zwischengespeichert werden kann, desto weniger ist es notwendig, auf den Datenträger zu wechseln.

- Speicher ist bei weitem die langsamste Komponente eines Computers. Der Datenzugriff auf spindelbasierten und SSD-Speichermedien ist etwa 1.000.000-mal langsamer als der Zugriff auf Daten im RAM.

Um die Skalierbarkeit des Servers zu maximieren, ist darum die minimale RAM-Menge die Summe der aktuellen Datenbankgröße, der SYSVOL-Gesamtgröße, der empfohlenen Menge des Betriebssystems und der Herstellerempfehlungen für die Agents (Antivirus, Überwachung, Sicherung usw.). Fügen Sie zusätzliche Mengen hinzu, um das Wachstum über die Lebensdauer des Servers zu berücksichtigen. Dies wird auf der Grundlage von Schätzungen des Datenbankwachstums der Umgebung gemäß subjektiv sein. Für Satellitenstandorte mit einer kleinen Gruppe von Endbenutzer*innen können diese Anforderungen jedoch gelockert werden, da diese Standorte nicht so viel zwischenspeichern müssen, um die meisten Anforderungen zu erfüllen.

Für Umgebungen, in denen die Maximierung der RAM-Menge nicht kosteneffizient (z. B. Satellitenstandorte) oder nicht möglich ist (DIT ist zu groß), ziehen Sie den Abschnitt „Speicher“ zu Rate, um sicherzustellen, dass der Speicher ordnungsgemäß dimensioniert ist.

Hinweis

Eine logische Konsequenz bei der Größenanpassung des Arbeitsspeichers ist die Größenanpassung der Auslagerungsdatei. Da das Ziel darin besteht, den Zugriff auf den viel langsameren Datenträger zu minimieren, ändert sich die Frage von „Wie sollte die Auslagerungsdatei dimensioniert sein?“ in „Wie viel RAM ist erforderlich, um das Paging zu minimieren?“. Die Antwort auf die letztgenannte Frage wird im weiteren Verlauf dieses Abschnitts beschrieben. Dadurch bleibt der Großteil der Diskussion über die Dimensionierung der Auslagerungsdatei im Bereich der allgemeinen Betriebssystemempfehlungen und der Notwendigkeit, das System für Speicherabbilder zu konfigurieren, die nicht mit der AD DS-Leistung zusammenhängen.

Virtualisierungsüberlegungen zum RAM

Vermeiden Sie übermäßige Arbeitsspeicherbelegung auf dem Host. Das grundlegende Ziel bei der Optimierung der RAM-Menge ist, den Zeitaufwand für den Zugriff auf den Datenträger zu minimieren. In Virtualisierungsszenarien besteht das Konzept der übermäßigen Arbeitsspeicherbelegung darin, den Gästen mehr RAM zuzuweisen, als auf dem physischen Computer vorhanden ist. Dies ist an und für sich kein Problem. Es wird zu einem Problem, wenn der gesamte von allen Gästen aktiv genutzte Arbeitsspeicher die RAM-Menge auf dem Host überschreitet, und der zugrunde liegende Host mit der Auslagerung beginnt. Die Leistung wird datenträgergebunden, wenn der Domänencontroller zu „NTDS.dit“ wechselt, um Daten abzurufen, oder zur Auslagerungsdatei wechselt, um Daten abzurufen, oder der Host zum Datenträger wechselt, um Daten abzurufen, von denen der Gast annimmt, dass sie sich im RAM befinden.

Beispiel für die Berechnungszusammenfassung

| Komponente | Geschätzter Arbeitsspeicher (Beispiel) |

|---|---|

| Empfohlener RAM des Basisbetriebssystems (Windows Server 2008) | 2 GB |

| Interne LSASS-Aufgaben | 200 MB |

| Überwachungs-Agent | 100 MB |

| Virenschutz | 100 MB |

| Datenbank (Globaler Katalog) | 8,5 GB |

| Polster für die Ausführung der Sicherung, Administrator*innen können sich ohne Auswirkungen anmelden | 1 GB |

| Gesamt | 12 GB |

Empfohlen: 16 GB

Es kann davon ausgegangen werden, dass im Laufe der Zeit der Datenbank weitere Daten hinzugefügt werden und der Server wahrscheinlich 3 bis 5 Jahre in Produktion sein wird. Basierend auf einer Schätzung des Wachstums von 33 % wären 16 GB eine angemessene Menge an RAM für einen physischen Server. Angesichts der Leichtigkeit, mit der Einstellungen geändert werden können und RAM der VM hinzugefügt werden kann, ist es angemessen, auf einem virtuellen Computer ab 12 GB mit dem Plan für die zukünftige Überwachung und das Upgrade zu beginnen.

Netzwerk

Auswerten

In diesem Abschnitt geht es weniger um die Bewertung der Anforderungen an den Replikationsdatenverkehr, der sich auf den Datenverkehr durch das WAN konzentriert und gründlich in Active Directory-Replikationsdatenverkehr behandelt wird, als um die Bewertung der insgesamt benötigten Bandbreite und Netzwerkkapazität, einschließlich Clientabfragen, Gruppenrichtlinieanwendungen usw. Für vorhandene Umgebungen kann dies mithilfe der Leistungsindikatoren „Netzwerkschnittstelle(*)\Empfangene Bytes/s“ und „Netzwerkschnittstelle(*)\Gesendete Bytes/s“erfasst werden. Beispielintervalle für Netzwerkschnittstellen-Leistungsindikatoren sind 15, 30 oder 60 Minuten. Alles darunter ist in der Regel zu flüchtig für gute Messungen; alles darüber glättet die täglichen Spitzen übermäßig.

Hinweis

Im Allgemeinen ist der Großteil des Netzwerkdatenverkehrs auf einem Domänencontroller ausgehend, da der Domänencontroller auf Clientabfragen antwortet. Dies ist der Grund für den Fokus auf ausgehenden Datenverkehr, obwohl jede Umgebung auch auf eingehenden Datenverkehr ausgewertet werden sollte. Dieselben Ansätze können verwendet werden, um die Anforderungen an eingehenden Netzwerkdatenverkehr zu berücksichtigen und zu überprüfen. Weitere Informationen finden Sie im Knowledge Base-Artikel 929851: Der dynamische Portbereich für TCP/IP hat sich in Windows Vista und Windows Server 2008 geändert.

Bandbreitenbedarf

Die Planung der Netzwerkskalierbarkeit umfasst zwei verschiedene Kategorien: die Menge des Datenverkehrs und die CPU-Last des Netzwerkdatenverkehrs. Jedes dieser Szenarien ist im Vergleich zu einigen anderen Themen in diesem Artikel einfach.

Zur Bewertung, wie viel Datenverkehr unterstützt werden muss, gibt es zwei eindeutige Kategorien der Kapazitätsplanung für AD DS in Bezug auf den Netzwerkdatenverkehr. Die erste ist der Replikationsdatenverkehr, der zwischen Domänencontrollern durchläuft und in der Referenz Active Directory-Replikationsdatenverkehr gründlich behandelt wird und für die aktuellen Versionen von AD DS weiterhin relevant ist. Die zweite ist der standortinterne Client-zu-Server-Datenverkehr. Eines der einfacheren Szenarien für die Planung: Der interne Datenverkehr empfängt hauptsächlich kleine Anforderungen von Clients im Verhältnis zu den großen Datenmengen, die an die Clients zurückgesendet werden. 100 MB sind in Umgebungen mit bis zu 5.000 Benutzer*innen pro Server an einem Standort in der Regel ausreichend. Die Verwendung eines Netzwerkadapters mit 1 GB und der Unterstützung für die RSS-Skalierung (Receive Side Scaling) wird für alle Anwendungen über 5.000 Benutzer*innen empfohlen. Um dieses Szenario zu überprüfen, insbesondere im Fall von Serverkonsolidierungsszenarien, sehen Sie sich „Netzwerkschnittstelle(*)\Bytes/s“ für alle Domänencontroller an einem Standort an, addieren Sie sie, und dividieren Sie sie durch die Zielanzahl von Domänencontrollern, um sicherzustellen, dass ausreichende Kapazität vorhanden ist. Die einfachste Möglichkeit hierfür ist die Verwendung der Ansicht „Gestapelte Fläche“ in Windows Reliability und Systemmonitor (früher bekannt als Perfmon), um sicherzustellen, dass alle Leistungsindikatoren gleich skaliert sind.

Betrachten Sie das folgende Beispiel (auch bekannt als eine wirklich komplexe Methode, um zu überprüfen, ob die allgemeine Regel auf eine bestimmte Umgebung anwendbar ist). Die folgenden Annahmen werden getroffen:

- Ziel ist es, den Speicherbedarf auf so wenige Server wie möglich zu reduzieren. Im Idealfall trägt ein Server die Last, und ein zusätzlicher Server wird zur Redundanz bereitgestellt („N + 1“-Szenario).

- In diesem Szenario unterstützt der aktuelle Netzwerkadapter nur 100 MB und befindet sich in einer Switch-Umgebung. Die maximale Auslastung der Zielnetzwerkbandbreite beträgt in einem N-Szenario 60 % (Verlust eines Domänencontrollers).

- Mit jedem Server sind etwa 10.000 Clients verbunden.

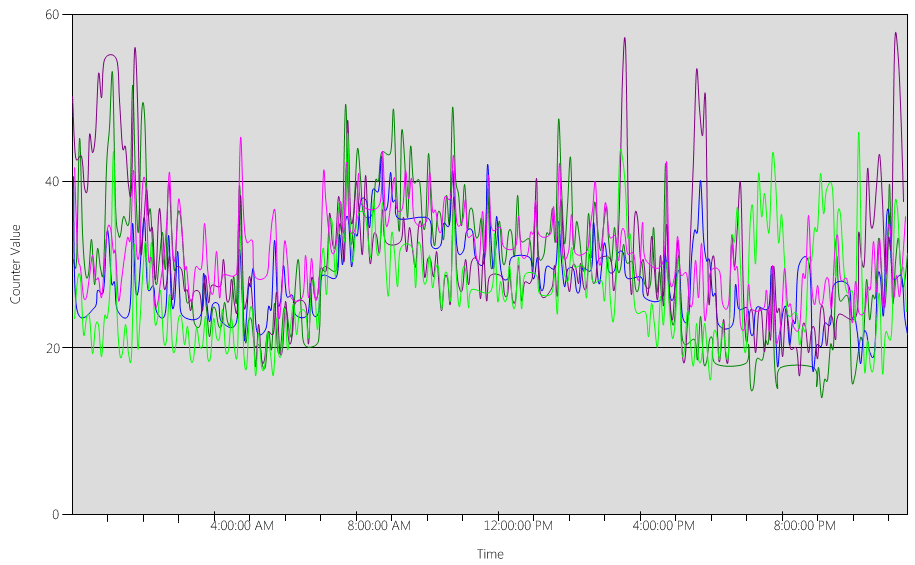

Erkenntnisse aus den Daten im Diagramm (Netzwerkschnittstelle(*)\Gesendete Bytes/s):

- Der Geschäftstag beginnt um 5:30 Uhr und geht um 19:00 Uhr zu Ende.

- Der Zeitraum der stärksten Nutzung ist von 8:00 Uhr bis 8:15 Uhr, wobei mehr als 25 Bytes pro Sekunde auf dem am meisten genutzten Domänencontroller gesendet werden.

Hinweis

Alle Leistungsdaten sind Verlaufsdaten. So gibt der Spitzendatenpunkt um 8:15 Uhr die Last von 8:00 bis 8:15 Uhr an.

- Es gibt Spitzen vor 4:00 Uhr mit mehr als 20 gesendeten Bytes/s auf dem am meisten genutzten Domänencontroller, was entweder auf die Auslastung aus verschiedenen Zeitzonen oder auf Infrastrukturaktivitäten im Hintergrund wie Sicherungen hinweisen kann. Da der Höchstwert um 8:00 Uhr diese Aktivität überschreitet, ist er nicht relevant.

- Es gibt fünf Domänencontroller an diesem Standort.

- Die maximale Auslastung beträgt etwa 5,5 MB/s pro Domänencontroller, was 44 % der 100 MB-Verbindung entspricht. Anhand dieser Daten kann geschätzt werden, dass die zwischen 8:00 Uhr und 8:15 Uhr benötigte Gesamtbandbreite 28 MB/s beträgt.

Hinweis

Achten Sie darauf, dass die Sende-/Empfangszähler der Netzwerkschnittstelle in Bytes angegeben werden, während die Netzwerkbandbreite in Bits gemessen wird. 100 MB ÷ 8 = 12,5 MB, 1 GB ÷ 8 = 128 MB.

Schlussfolgerungen:

- Diese aktuelle Umgebung erfüllt die Fehlertoleranzstufe N+1 bei einer Zielauslastung von 60 %. Wenn ein System offline geschaltet wird, wird die Bandbreite pro Server von etwa 5,5 MB/s (44 %) auf etwa 7 MB/s (56 %) verschoben.

- Basierend auf dem zuvor genannten Ziel der Konsolidierung auf einen Server überschreitet dies sowohl die maximale Zielauslastung als auch theoretisch die mögliche Auslastung einer 100-MB-Verbindung.

- Bei einer Verbindung mit 1 GB entspricht dies 22 % der Gesamtkapazität.

- Unter normalen Betriebsbedingungen im Szenario N +1 ist die Clientlast mit etwa 14 MB/s pro Server oder 11 % der Gesamtkapazität relativ gleichmäßig verteilt.

- Um sicherzustellen, dass die Kapazität während der Nichtverfügbarkeit eines Domänencontrollers ausreicht, würden die normalen Betriebsziele pro Server etwa 30 % Netzwerkauslastung oder 38 MB/s pro Server betragen. Failoverziele wären 60 % Netzwerkauslastung oder 72 MB/s pro Server.

Kurz gesagt, die endgültige Bereitstellung von Systemen muss über einen 1-GB-Netzwerkadapter verfügen und mit einer Netzwerkinfrastruktur verbunden sein, die diese Last unterstützt. Ein weiterer Hinweis: Angesichts der Menge des generierten Netzwerkdatenverkehrs kann die CPU-Last von der Netzwerkkommunikation erhebliche Auswirkungen haben und die maximale Skalierbarkeit von AD DS einschränken kann. Derselbe Prozess kann verwendet werden, um die Menge der eingehenden Kommunikation des Domänencontrollers abzuschätzen. Angesichts der Dominanz des ausgehenden Datenverkehrs im Verhältnis zum eingehenden Datenverkehr ist dies jedoch für die meisten Umgebungen eine akademische Übung. Die Hardwareunterstützung für RSS sicherzustellen ist in Umgebungen mit mehr als 5.000 Benutzer*innen pro Server wichtig. In Szenarien mit hohem Netzwerkdatenverkehr kann der Ausgleich der Interruptlast ein Engpass sein. Dies kann daran erkannt werden, dass „Prozessor(*)% Interruptzeit“ ungleichmäßig auf CPUs verteilt ist. Netzwerkadapter mit RSS-Unterstützung können diese Einschränkung verringern und die Skalierbarkeit erhöhen.

Hinweis

Ein ähnlicher Ansatz kann verwendet werden, um die zusätzliche Kapazität zu schätzen, die beim Konsolidieren von Rechenzentren erforderlich ist, oder wenn ein Domänencontroller an einem Satellitenstandort eingestellt wird. Erfassen Sie einfach den ausgehenden und eingehenden Datenverkehr mit Clients, und das ist die Datenverkehrsmenge, die jetzt auf den WAN-Links vorhanden ist.

In einigen Fällen tritt möglicherweise mehr Datenverkehr als erwartet auf, da der Datenverkehr langsamer ist, z. B. wenn die Zertifikatüberprüfung keinen aggressiven Timeouts im WAN gerecht wird. Aus diesem Grund sollten die WAN-Größenanpassung und -nutzung ein iterativer, fortlaufender Prozess sein.

Überlegungen zur Virtualisierung für die Netzwerkbandbreite

Es ist einfach, Empfehlungen für einen physischen Server zu geben: 1 GB für Server, die mehr als 5.000 Benutzer*innen unterstützen. Sobald mehrere Gäste beginnen, eine zugrunde liegende virtuelle Switchinfrastruktur gemeinsam zu nutzen, ist zusätzliche Aufmerksamkeit erforderlich, um sicherzustellen, dass der Host über eine angemessene Netzwerkbandbreite verfügt, um alle Gäste im System zu unterstützen, und daher die zusätzliche Stringenz erfordert. Dies ist nichts anderes als eine Erweiterung der Sicherung der Netzwerkinfrastruktur auf dem Hostcomputer. Dies ist unabhängig davon, ob das Netzwerk den Domänencontroller einbezieht, der als Gast eines virtuellen Computers auf einem Host ausgeführt wird, und der Netzwerkdatenverkehr über einen virtuellen Switch erfolgt, oder ob eine direkte Verbindung mit einem physischen Switch besteht. Der virtuelle Switch ist nur eine weitere Komponente, bei der der Uplink die übertragene Datenmenge unterstützen muss. Daher sollte der mit dem Switch verbundene physische Host-Netzwerkadapter in der Lage sein, die Domänencontroller-Last sowie alle anderen Gäste zu unterstützen, die den virtuellen Switch, der mit dem physischen Netzwerkadapter verbunden ist, gemeinsam nutzen.

Beispiel für die Berechnungszusammenfassung

| System | Spitzenbandbreite |

|---|---|

| DC 1 | 6,5 MB/s |

| DC 2 | 6,25 MB/s |

| DC 3 | 6,25 MB/s |

| DC 4 | 5,75 MB/s |

| DC 5 | 4,75 MB/s |

| Gesamt | 28,5 MB/s |

Empfohlen: 72 MB/s (28,5 MB/s geteilt durch 40 %)

| Anzahl der Zielsysteme | Gesamtbandbreite (von oben) |

|---|---|

| 2 | 28,5 MB/s |

| Resultierendes normales Verhalten | 28,5 ÷ 2 = 14,25 MB/s |

Wie immer kann im Laufe der Zeit davon ausgegangen werden, dass die Clientlast zunehmen wird und dieses Wachstum so gut wie möglich geplant werden sollte. Die für die Planung empfohlene Menge würde ein geschätztes Wachstum des Netzwerkdatenverkehrs von 50 % ermöglichen.

Storage

Die Planung von Speicher besteht aus zwei Komponenten:

- Kapazität oder Speichergröße

- Leistung

Für die Planung der Kapazität wird viel Zeit und Dokumentation aufgewendet, sodass die Leistung oft völlig übersehen wird. Unter Berücksichtigung der derzeitigen Hardwarekosten sind die meisten Umgebungen nicht so groß, dass dies wirklich ein Problem darstellt, und die Empfehlung, dass "der Arbeitsspeicher der Datenbankgröße entsprechen soll", deckt in der Regel den Rest ab, auch wenn dies für Satellitenstandorte in größeren Umgebungen übertrieben sein kann.

Festlegen der Größe

Bewertung für Speicher

Verglichen mit der Einführung von Active Directory vor 13 Jahren, als 4-GB- und 9-GB-Laufwerke die gängigsten Laufwerksgrößen waren, ist die Dimensionierung für Active Directory heute nur noch in den größten Umgebungen ein Thema. Mit den kleinsten verfügbaren Festplattengrößen im Bereich von 180 GB können das gesamte Betriebssystem, SYSVOL und NTDS.dit problemlos auf ein Laufwerk passen. Daher können hohe Investitionen in diesem Bereich als veraltet betrachtet werden.

Als einzige Empfehlung sollte berücksichtigt werden, sicherzustellen, dass 110 % der NTDS.dit-Größe verfügbar sind, um die Defragmentierung zu ermöglichen. Darüber hinaus sollten Anpassungen für das Wachstum während der Lebensdauer der Hardware vorgenommen werden.

Der erste und wichtigste Aspekt ist die Bewertung der Größe von NTDS.dit und SYSVOL. Diese Messungen führen zur Größenanpassung sowohl für feste Datenträger als auch für die RAM-Zuordnung. Aufgrund der (relativ) niedrigen Kosten dieser Komponenten muss die Berechnung nicht streng und präzise sein. Wie dies sowohl für vorhandene als auch neue Umgebungen bewertet werden kann, erfahren Sie in der Datenspeicher-Artikelreihe. Weitere Informationen finden Sie in den folgenden Artikeln:

Für vorhandene Umgebungen: Der Abschnitt „So aktivieren Sie die Protokollierung von Speicherplatz, der durch Defragmentierung freigegeben wird“ im Artikel Speichergrenzwerte.

Für neue Umgebungen: Der Artikel mit dem Titel Wachstumsschätzungen für Active Directory-Benutzer und Organisationseinheiten.

Hinweis

Die Artikel basieren auf Datengrößenschätzungen, die zum Zeitpunkt der Veröffentlichung von Active Directory in Windows 2000 vorgenommen wurden. Verwenden Sie Objektgrößen, die die tatsächliche Größe von Objekten in Ihrer Umgebung widerspiegeln.

Beim Überprüfen vorhandener Umgebungen mit mehreren Domänen kann es zu Abweichungen bei den Datenbankgrößen kommen. Wenn dies der Fall ist, verwenden Sie die kleinsten globalen Kataloggrößen (GC) und Nicht-GC-Größen.

Die Datenbankgröße kann je nach Betriebssystemversion variieren. Domänencontroller, auf denen frühere Betriebssysteme wie Windows Server 2003 ausgeführt werden, haben eine geringere Datenbankgröße als ein Domänencontroller, auf dem ein späteres Betriebssystem wie Windows Server 2008 R2 ausgeführt wird, insbesondere wenn Features wie Active Directory-Papierkorb oder Roaming für Anmeldeinformationen aktiviert sind.

Hinweis

- Beachten Sie für neue Umgebungen, dass den Schätzungen unter „Wachstumsschätzungen für Active Directory-Benutzer und Organisationseinheiten“ zufolge 100.000 Benutzer (in derselben Domäne) etwa 450 MB Speicherplatz verbrauchen. Beachten Sie, dass die aufgefüllten Attribute einen großen Einfluss auf die Gesamtmenge haben können. Attribute werden für viele Objekte von Drittanbieter- und Microsoft-Produkten aufgefüllt, einschließlich Microsoft Exchange Server und Lync. Eine Bewertung auf der Grundlage des Produktportfolios in der Umgebung ist zu bevorzugen, aber der Aufwand für die detaillierte Berechnung und das Testen für präzise Schätzungen ist für alle Umgebungen mit Ausnahme der größten möglicherweise nicht die Zeit und Mühe wert.

- Stellen Sie sicher, dass 110 % der NTDS.dit-Größe als freier Speicherplatz verfügbar sind, um die Offlinedefragmentierung zu ermöglichen, und planen Sie das Wachstum über eine Hardwarelebensdauer von drei bis fünf Jahren. Angesichts des günstigen Speichers ist die Schätzung von Speicher auf 300 % der DIT-Größe als Speicherbelegung sicher, um das Wachstum und den potenziellen Bedarf an Offlinedefragmentierung zu berücksichtigen.

Virtualisierungsüberlegungen zum Speicher

In einem Szenario, in dem mehrere VHD-Dateien (Virtual Hard Disk) einem einzelnen Volume zugeordnet werden, verwenden Sie einen Datenträger mit fester Größe von mindestens 210 % (100 % des DIT + 110 % freien Speicherplatz), um sicherzustellen, dass ausreichend Speicherplatz reserviert ist.

Beispiel für die Berechnungszusammenfassung

| In der Auswertungsphase gesammelte Daten | Size |

|---|---|

| NTDS.dit-Größe | 35 GB |

| Modifizierer, um die Offlinedefragmentierung zuzulassen | 2,1 GB |

| Benötigter Gesamtspeicher | 73,5 GB |

Hinweis

Dieser erforderliche Speicher wird zusätzlich zum Speicher benötigt, der für SYSVOL, Betriebssystem, Auslagerungsdatei, temporäre Dateien, lokale zwischengespeicherte Daten (z. B. Installationsdateien) und Anwendungen erforderlich ist.

Speicherleistung

Auswerten der Speicherleistung

Als langsamste Komponente auf jedem Computer kann der Speicher die größten negativen Auswirkungen auf die Clienterfahrung haben. In Umgebungen, die so groß sind, dass die Empfehlungen für die Größe des Arbeitsspeichers nicht realisierbar sind, kann es verheerende Folgen haben, wenn die Speicherplanung nicht auf die Leistung abgestimmt ist. Auch die Komplexität und Vielfalt der Speichertechnologie erhöht das Ausfallrisiko, da die langjährige bewährte Praxis „Betriebssystem, Protokolle und Datenbank“ auf getrennten physischen Festplatten unterzubringen, nur noch bedingt sinnvoll ist. Dies liegt daran, dass die seit langem bewährte Methode auf der Annahme basiert, dass ein „Datenträger“ eine dedizierte Spindel ist und dies eine E/A-Isolation ermöglicht. Diese Annahmen, die dies begründen, sind nicht mehr relevant mit der Einführung von Folgendem:

- RAID

- Neue Speichertypen und virtualisierte und freigegebene Speicherszenarien

- Freigegebene Spindeln in einem Storage Area Network (SAN)

- VHD-Datei in einem SAN-Speicher oder Network Attached Storage

- Solid-State-Laufwerke

- Mehrstufige Speicherarchitekturen (d. h. SSD-Speicherebenen-Zwischenspeicherung größerer spindelbasierter Speicher)

Insbesondere kann freigegebener Speicher (RAID, SAN, NAS, JBOD (d. h. Speicherplätze), VHD) von anderen Arbeitslasten, die im Back-End-Speicher platziert werden, überschrieben/überlastet werden. Dazu kommt auch die Herausforderung, dass SAN-/Netzwerk-/Treiberprobleme (alles zwischen dem physischen Datenträger und der AD-Anwendung) zu Drosselungen und/oder Verzögerungen führen können. Zur Klarstellung: Dies sind keine „schlechten“ Konfigurationen, es handelt sich um komplexere Konfigurationen, die erfordern, dass jede Komponente ordnungsgemäß funktioniert, sodass zusätzliche Aufmerksamkeit erforderlich ist, um sicherzustellen, dass die Leistung akzeptabel ist. Ausführlichere Erläuterungen finden Sie unter Anhang C, Unterabschnitt „Einführung in SANs“, und Anhang D weiter unten in diesem Dokument. Auch haben Solid State Drives zwar nicht die Einschränkung rotierender Platten (Festplatten), dass nur jeweils ein E/A-Vorgang verarbeitet werden kann, aber sie haben immer noch E/A-Einschränkungen, und eine Überlastung von SSDs ist möglich. Kurz gesagt, das Endziel aller Speicherleistungsbemühungen besteht unabhängig von der zugrunde liegenden Speicherarchitektur und dem Entwurf darin, sicherzustellen, dass die erforderliche Menge an Eingabe-/Ausgabevorgängen pro Sekunde (IOPS) verfügbar ist, und diese IOPS innerhalb eines akzeptablen Zeitrahmens erfolgen (wie an anderer Stelle in diesem Dokument ausgeführt). Für Szenarien mit lokal angefügtem Speicher finden Sie in Anhang C die Grundlagen zum Entwerfen herkömmlicher lokaler Speicherszenarien. Diese Prinzipien gelten in der Regel für komplexere Speicherebenen und helfen auch beim Dialog mit den Herstellern, die Back-End-Speicherlösungen unterstützen.

- Angesichts der großen Bandbreite verfügbarer Speicheroptionen empfiehlt es sich, das Fachwissen von Hardwaresupportteams oder -anbietern zu nutzen, um sicherzustellen, dass die spezifische Lösung die Anforderungen von AD DS erfüllt. Die folgenden Zahlen sind die Informationen, die den Speicherspezialisten zur Verfügung gestellt würden.

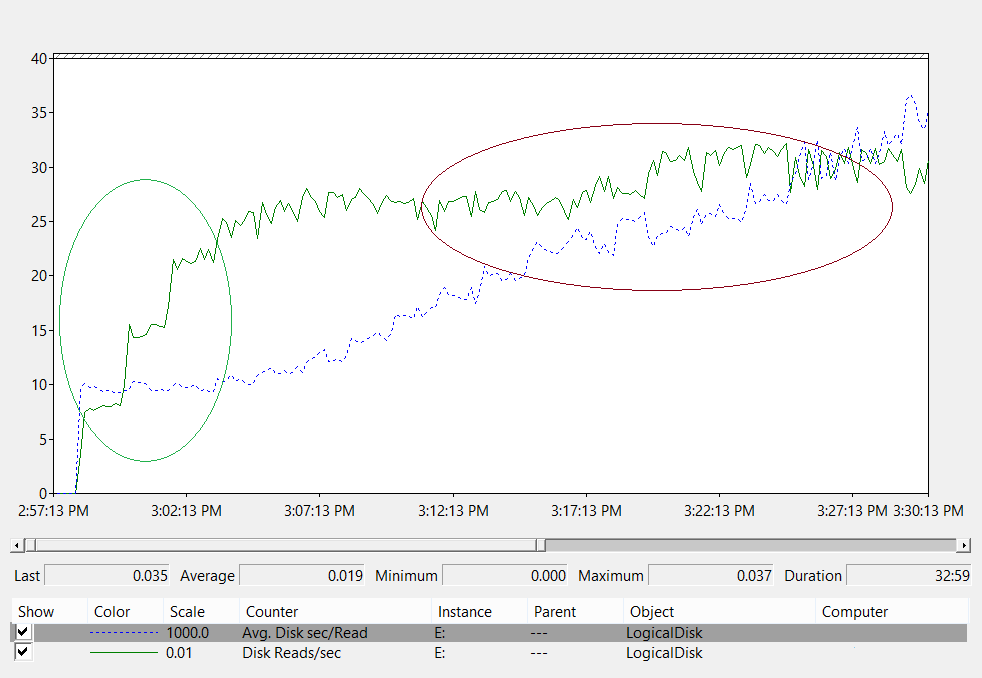

Bestimmen Sie für Umgebungen, in denen die Datenbank zu groß ist, um im RAM gespeichert zu werden, anhand der Leistungsindikatoren, wie viel E/A unterstützt werden muss:

- Logischer Datenträger(*)\Mittlere Sek./Lesevorgänge (Wenn z. B. „NTDS.dit“ auf Laufwerk D:/ gespeichert ist, wäre der vollständige Pfad „Logischer Datenträger(D:)\Mittlere Sek./Lesevorgänge)

- Logischer Datenträger(*)\Mittlere Sek./Schreibvorgänge

- Logischer Datenträger(*)\Mittlere Sek./Übertragung

- Logischer Datenträger(*)\Lesevorgänge/s

- Logischer Datenträger(*)\Schreibvorgänge/s

- Logischer Datenträger(*)\Übertragungen/s

Diese sollten in Intervallen von 15/30/60 Minuten erfasst werden, um einen Vergleichstest der Anforderungen der aktuellen Umgebung durchzuführen.

Auswerten der Ergebnisse

Hinweis

Der Fokus liegt auf Lesevorgängen aus der Datenbank, da dies in der Regel die anspruchsvollste Komponente ist. Dieselbe Logik kann auf Schreibvorgänge in die Protokolldatei angewendet werden, indem „Logischer Datenträger(<NTDS-Protokoll>)\Mittlere Sek./Schreibvorgänge“ und „Logischer Datenträger(<NTDS-Protokoll>)\Schreibvorgänge/s“ ersetzt werden:

- „Logischer Datenträger(<NTDS>)\Mittlere Sek./Lesevorgänge“ gibt an, ob der aktuelle Speicher angemessen dimensioniert ist. Wenn die Ergebnisse ungefähr gleich der Datenträgerzugriffszeit für den Datenträgertyp sind, ist „Logischer Datenträger(<NTDS>)\Lesevorgänge/s“ ein gültiges Maß. Überprüfen Sie die Herstellerspezifikationen für den Speicher im Back-End, aber gute Bereiche für „Logischer Datenträger(<NTDS>)\Mittlere Sek./Lesevorgänge“ wären ungefähr:

- 7.200 – 9 bis 12,5 Millisekunden (ms)

- 10.000 – 6 bis 10 ms

- 15.000 – 4 bis 6 ms

- SSD – 1 bis 3 ms

-

Hinweis

Empfehlungen zufolge wird die Speicherleistung (abhängig von der Quelle) um 15 ms bis 20 ms beeinträchtigt. Der Unterschied zwischen den oben genannten Werten und der anderen Anleitung besteht darin, dass die oben genannten Werte der normale Betriebsbereich sind. Die anderen Empfehlungen sind Anleitungen zur Problembehandlung, um zu ermitteln, wann sich die Clienterfahrung erheblich und spürbar verschlechtert. Ausführlichere Erläuterungen finden Sie in Anhang C.

- „Logischer Datenträger(<NTDS>)\Lesevorgänge/s“ ist die ausgeführte E/A-Menge.

- Wenn „Logischer Datenträger(<NTDS>)\Mittlere Sek./Lesevorgänge“ innerhalb des optimalen Bereichs für den Back-End-Speicher liegt, kann „Logischer Datenträger(<NTDS>)\Lesevorgänge/s“ direkt zur Dimensionierung des Speichers verwendet werden.

- Wenn „Logischer Datenträger(<NTDS>)\Mittlere Sek./Lesevorgänge“ nicht innerhalb des optimalen Bereichs für den Back-End-Speicher liegt, ist zusätzliche E/A gemäß der folgenden Formel erforderlich: (Logischer Datenträger(<NTDS>)\Mittlere Sek./Lesevorgänge) ÷ (Datenträgerzugriffszeit für physische Medien) × (Logischer Datenträger(<NTDS>)\Mittlere Sek./Lesevorgänge)

Überlegungen:

- Beachten Sie, dass diese Werte zu Planungszwecken zu ungenau sind, wenn der Server mit einer suboptimalen RAM-Menge konfiguriert ist. Sie werden fälschlicherweise auf der hohen Seite liegen und können weiterhin als Worst-Case-Szenario verwendet werden.

- Durch das spezielle Hinzufügen/Optimieren von RAM wird die Menge an Lese-E/A-Vorgängen (Logischer Datenträger(<NTDS>)\Lesevorgänge/s) verringert. Dies bedeutet, dass die Speicherlösung möglicherweise nicht so robust sein muss, wie ursprünglich berechnet. Leider ist alles, was genauer als diese allgemeine Aussage ist, umgebungsspezifisch von der Clientlast abhängig, und es kann keine allgemeine Anleitung gegeben werden. Die beste Option ist, die Speicherdimensionierung nach der RAM-Optimierung vorzunehmen.

Virtualisierungsüberlegungen zur Leistung

Ähnlich wie bei allen vorherigen Virtualisierungsdiskussionen liegt der Schlüssel hier darin, sicherzustellen, dass die zugrunde liegende freigegebene Infrastruktur die Domänencontrollerauslastung sowie die anderen Ressourcen unterstützen kann, die die zugrunde liegenden freigegebenen Medien und alle Pfade dazu verwenden. Dies gilt unabhängig davon, ob ein physischer Domänencontroller die gleichen zugrunde liegenden Medien auf einer SAN-, NAS- oder iSCSI-Infrastruktur wie andere Server oder Anwendungen nutzt, unabhängig davon, ob es sich um einen Gast mit Passthrough-Zugriff auf eine SAN-, NAS- oder iSCSI-Infrastruktur handelt, die die zugrunde liegenden Medien verwendet, oder ob der Gast eine VHD-Datei verwendet, die sich lokal auf freigegebenen Medien oder in einer SAN-, NAS- oder iSCSI-Infrastruktur befindet. Bei der Planungsübung geht es darum, sicherzustellen, dass die zugrunde liegenden Medien die Gesamtlast aller Consumer unterstützen können.

Da zusätzliche Codepfade durchlaufen werden müssen, wirkt sich dies aus Sicht des Gastes auch auf die Leistung aus, da der Zugriff auf den Speicher über einen Host erfolgen muss. Es überrascht nicht, dass die Speicherleistungstests zeigen, dass die Virtualisierung einen Einfluss auf den Durchsatz hat, der subjektiv von der Prozessorauslastung des Hostsystems abhängt (siehe Anhang A: Kriterien der CPU-Dimensionierung), die natürlich von den Ressourcen des Hosts beeinflusst wird, die der Gast benötigt. Dies trägt zu den Virtualisierungsüberlegungen hinsichtlich der Verarbeitungsanforderungen in einem virtualisierten Szenario bei (siehe Überlegungen zur Virtualisierung für die Verarbeitung).

Erschwerend kommt hinzu, dass es eine Vielzahl verschiedener Speicheroptionen gibt, die alle unterschiedliche Auswirkungen auf die Leistung haben. Verwenden Sie als sichere Schätzung bei der Migration von physisch zu virtuell einen Multiplikator von 1,10 zur Anpassung an verschiedene Speicheroptionen für virtualisierte Gäste in Hyper-V, z. B. Passthroughspeicher, SCSI-Adapter oder IDE. Die Anpassungen, die bei der Übertragung zwischen den verschiedenen Speicherszenarien vorgenommen werden müssen, sind unabhängig davon, ob es sich um lokalen, SAN-, NAS- oder iSCSI-Speicher handelt.

Beispiel für die Berechnungszusammenfassung

Bestimmen der E/A-Menge, die für ein fehlerfreies System unter normalen Betriebsbedingungen erforderlich ist:

- „Logischer Datenträger(<NTDS-Datenbanklaufwerk>)\Übertragungen/s“ während des Spitzenzeitraums von 15 Minuten

- So ermitteln Sie den E/A-Bedarf für den Speicher, wenn die Kapazität des zugrunde liegenden Speichers überschritten wird:

Erforderliche IOPS = (Logischer Datenträger(<NTDS-Datenbanklaufwerk>)\Mittlere Sek./Lesevorgänge ÷ <Ziel Mittlere Sek./Lesevorgänge>) × Logischer Datenträger(<NTDS-Datenbanklaufwerk>)\Lesevorgänge/s

| Leistungsindikator | Wert |

|---|---|

| Tatsächlicher logischer Datenträger(<NTDS-Datenbanklaufwerk>)\Mittlere Sek./Übertragung | 0,02 Sekunden (20 Millisekunden) |

| Logischer Zieldatenträger(<NTDS-Datenbanklaufwerk>)\Mittlere Sek./Übertragung | 0,01 Sekunden |

| Multiplikator für Änderungen in verfügbarer E/A | 0,02 ÷ 0,01 = 2 |

| Wertname | Wert |

|---|---|

| Logischer Datenträger(<NTDS-Datenbanklaufwerk>)\Übertragungen/s | 400 |

| Multiplikator für Änderungen in verfügbarer E/A | 2 |

| Gesamter IOPS-Bedarf während der Spitzenzeit | 800 |

So bestimmen Sie die Rate, mit der der Cache aufgewärmt werden soll:

- Bestimmen Sie die maximal zulässige Zeit zum Aufwärmen des Caches. Es ist entweder die Zeit, die zum Laden der gesamten Datenbank vom Datenträger benötigt werden sollte, oder in Szenarien, in denen nicht die gesamte Datenbank in den RAM geladen werden kann, wäre dies die maximale Zeit, den RAM zu füllen.

- Bestimmen Sie die Größe der Datenbank, ohne Leerzeichen. Weitere Informationen finden Sie unter Auswerten des Speichers.

- Dividieren Sie die Datenbankgröße durch 8 KB. Dies ist die Gesamtanzahl der E/A-Vorgänge, die zum Laden der Datenbank erforderlich sind.

- Dividieren Sie die Gesamtanzahl der E/A-Vorgänge durch die Anzahl der Sekunden im definierten Zeitrahmen.

Beachten Sie, dass die berechnete Rate zwar präzise ist, aber nicht exakt, da zuvor geladene Seiten verdrängt werden, wenn ESE nicht für eine feste Cachegröße konfiguriert ist, und AD DS standardmäßig eine variable Cachegröße verwendet.

| Zu erfassende Datenpunkte | Werte |

|---|---|

| Maximal zulässige Aufwärmzeit | 10 Minuten (600 Sekunden) |

| Datenbankgröße | 2 GB |

| Berechnungsschritt | Formel | Ergebnis |

|---|---|---|

| Berechnung der Größe der Datenbank in Seiten | (2 GB × 1024 × 1024) = Größe der Datenbank in KB | 2.097.152 KB |

| Berechnung der Anzahl der Seiten in der Datenbank | 2.097.152 KB ÷ 8 KB = Anzahl der Seiten | 262.144 Seiten |

| Berechnung von IOPS, die zum vollständigen Aufwärmen des Caches erforderlich sind | 262.144 Seiten ÷ 600 Sekunden = erforderliche IOPS | 437 IOPS |

Verarbeitung

Auswerten der Active Directory-Prozessornutzung

In den meisten Umgebungen ist die Verwaltung der Verarbeitungskapazität die Komponente, die die meiste Aufmerksamkeit verdient, nachdem Speicher, RAM und Netzwerk wie im Abschnitt „Planung“ beschrieben richtig eingestellt wurden. Bei der Bewertung der benötigten CPU-Kapazität gibt es zwei Herausforderungen:

Ob sich die Anwendungen in der Umgebung in einer Infrastruktur mit gemeinsamen Diensten gut verhalten oder nicht, wird im Abschnitt „Tracking Expensive and Inefficient Searches“ (Nachverfolgen teurer und ineffizienter Suchvorgänge) des Artikels „Creating More Efficient Microsoft Active Directory-Enabled Applications or migrating away from down-level SAM calls to LDAP calls“ (Erstellen effizienterer Anwendungen mit Microsoft Active Directory-Unterstützung oder Migrieren von Downlevel-SAM-Aufrufen zu LDAP-Aufrufen) behandelt.

In größeren Umgebungen ist dies wichtig, da schlecht codierte Anwendungen die Flüchtigkeit der CPU-Auslastung fördern, eine ungeheure Menge an CPU-Zeit von anderen Anwendungen „stehlen“, Kapazitätsanforderungen künstlich erhöhen und die Last ungleichmäßig auf die Domänencontroller verteilen können.

Da AD DS eine verteilte Umgebung mit einer Vielzahl potenzieller Kunden ist, ist die Schätzung der Kosten eines „einzelnen Kunden“ aufgrund von Nutzungsmustern und der Art oder Menge von Anwendungen, die AD DS nutzen, umgebungsspezifisch. Kurz gesagt, ähnlich wie im Netzwerkabschnitt, ist es für eine breite Anwendbarkeit besser, dies aus der Perspektive der Bewertung der gesamten in der Umgebung benötigten Kapazität zu betrachten.

Da die Dimensionierung des Speichers bereits zuvor erörtert wurde, wird bei bestehenden Umgebungen davon ausgegangen, dass der Speicher jetzt richtig dimensioniert ist und die Daten zur Prozessorlast somit gültig sind. Um es noch einmal zu wiederholen, es ist wichtig, sicherzustellen, dass der Engpass im System nicht die Leistung des Speichers ist. Wenn ein Engpass besteht und der Prozessor wartet, gibt es Leerlaufzustände, die verschwinden, sobald der Engpass entfernt wurde. Wenn die Prozessorwartestatus beseitigt werden, steigt die CPU-Auslastung per Definition, da die CPU nicht mehr auf die Daten warten muss. Erfassen Sie daher die Leistungsindikatoren „Logischer Datenträger(<NTDS-Datenbanklaufwerk>)\Mittlere Sek./Lesevorgänge“ und „Prozess(lsass)\% Prozessorzeit“. Die Daten in „Prozess(lsass)\% Prozessorzeit“ sind künstlich niedrig, wenn „Logischer Datenträger(<NTDS-Datenbanklaufwerk>)\Mittlere Sek./Lesevorgänge“ 10 bis 15 ms überschreitet. Dies ist ein allgemeiner Schwellenwert, den der Microsoft-Support zur Behandlung speicherbezogener Leistungsprobleme verwendet. Wie zuvor sollten die Stichprobenintervalle entweder 15, 30 oder 60 Minuten betragen. Alles darunter ist in der Regel zu flüchtig für gute Messungen; alles darüber glättet die täglichen Spitzen übermäßig.

Einführung

Bei der Kapazitätsplanung für Domänencontroller erfordert die Verarbeitungsleistung die meiste Aufmerksamkeit und das meiste Verständnis. Bei der Größenanpassung von Systemen, um eine maximale Leistung sicherzustellen, gibt es immer eine Komponente, die den Engpass darstellt, und in einem ordnungsgemäß dimensionierten Domänencontroller ist dies der Prozessor.

Ähnlich wie im Netzwerkabschnitt, in dem der Bedarf der Umgebung Standort für Standort überprüft wird, muss dies auch für die erforderliche Computekapazität erfolgen. Im Gegensatz zum Netzwerkabschnitt, in dem die verfügbaren Netzwerktechnologien den normalen Bedarf bei weitem übersteigen, sollten Sie mehr auf die Dimensionierung der CPU-Kapazität achten. Wie in jeder Umgebung von auch nur mäßiger Größe kann alles, was über ein paar Tausend gleichzeitige Benutzer hinausgeht, eine erhebliche Belastung für die CPU darstellen.

Aufgrund der enormen Variabilität von Clientanwendungen, die AD nutzen, ist eine allgemeine Schätzung der Benutzer pro CPU für alle Umgebungen leider nicht anwendbar. Insbesondere die Computeanforderungen unterliegen dem Benutzerverhalten und Anwendungsprofil. Daher muss jede Umgebung individuell dimensioniert werden.

Verhaltensprofil des Zielstandorts

Wie bereits erwähnt, verfolgt die Planung der Kapazität für einen gesamten Standort einen Kapazitätsentwurf von N + 1 als Ziel, sodass ein Ausfall eines Systems während der Spitzenzeit die Fortsetzung des Betriebs mit einem angemessenen Qualitätsniveau ermöglicht. Dies bedeutet, dass in einem „N“-Szenario die Auslastung aller Einheiten während der Spitzenzeiten weniger als 100 % (besser noch, weniger als 80 %) betragen sollte.

Wenn die Anwendungen und Clients am Standort bewährte Methoden zum Auffinden von Domänencontrollern verwenden (d. h. mithilfe der DsGetDcName-Funktion), sollten die Clients außerdem relativ gleichmäßig verteilt werden, wobei geringfügige vorübergehende Spitzen aufgrund einer Reihe von Faktoren auftreten.

Im nächsten Beispiel werden die folgenden Annahmen getroffen:

- Jeder der fünf Domänencontroller am Standort verfügt über vier CPUs.

- Die CPU-Zielauslastung während der Geschäftszeiten beträgt unter normalen Betriebsbedingungen 40 % („N + 1“) und andernfalls 60 % („N“). Außerhalb der Geschäftszeiten beträgt die CPU-Zielauslastung 80 %, da von Sicherungssoftware und anderen Wartungsvorgängen erwartet wird, dass sie alle verfügbaren Ressourcen beanspruchen.

Analysieren der Daten im Diagramm (Processor Information(_Total)\% Processor Utility) für die einzelnen Domänencontroller:

In den meisten Fällen ist die Last relativ gleichmäßig verteilt, was erwartet wird, wenn Clients den Domänencontroller-Locator verwenden und über gut geschriebene Suchvorgänge verfügen.

Es gibt eine Anzahl von fünfminütigen Spitzen von 10 %, von denen einige bis zu 20 % betragen. Im Allgemeinen lohnt es sich nicht, sie zu untersuchen, es sei denn, sie führen zu einer Überschreitung des Kapazitätsplanziels.

Die Spitzenzeit für alle Systeme liegt zwischen ca. 8:00 Uhr und 9:15 Uhr. Mit dem reibungslosen Übergang von ca. 5:00 Uhr bis ca. 17:00 Uhr ist dies in der Regel ein Hinweis auf den Geschäftszyklus. Die mehr zufälligen Spitzen der CPU-Auslastung in einem Box-by-Box-Szenario zwischen 17:00 Uhr und 4:00 Uhr lägen außerhalb der Kapazitätsplanungsaspekte.

Hinweis

Auf einem gut verwalteten System könnten diese Spitzen vielleicht auf ausgeführte Sicherungssoftware, Virenscans des gesamten Systems, Hardware- oder Softwareinventur, Software- oder Patchbereitstellung usw. zurückzuführen sein. Da sie außerhalb des Spitzengeschäftszyklus liegen, werden die Ziele nicht überschritten.

Da jedes System bei 40 % liegt und alle Systeme über die gleiche Anzahl von CPUs verfügen, würden die verbleibenden Systeme bei Ausfall oder Abschaltung eines Systems mit geschätzten 53 % ausgeführt werden (die 40 %-Last von System D wird gleichmäßig aufgeteilt und der vorhandenen 40 %-Last von System A und System C hinzugefügt). Aus einer Reihe von Gründen ist diese lineare Annahme NICHT ganz genau, aber genau genug zum Messen.

Alternatives Szenario: Zwei Domänencontroller, die mit 40 % ausgeführt werden: Ein Domänencontroller fällt aus, die CPU auf dem verbleibenden Domänencontroller wird schätzungsweise mit 80 % ausgeführt. Dies überschreitet die oben für den Kapazitätsplan beschriebenen Schwellenwerte bei weitem und beginnt auch, den Umfang des Spielraums für die 10 % bis 20 % im obigen Auslastungsprofil stark einzuschränken, was bedeutet, dass die Spitzen den Domänencontroller während des „N“-Szenarios auf 90 % bis 100 % treiben und die Reaktionsfähigkeit definitiv beeinträchtigen würden.

Berechnen von CPU-Anforderungen

Der Leistungsindikator „Prozess\% Prozessorzeit“ summiert die Gesamtzeit, für die alle Threads einer Anwendung die CPU beanspruchen, und dividiert sie durch die gesamte verstrichene Systemzeit. Dies hat zur Folge, dass eine Multithreadanwendung auf einem Multi-CPU-System 100 % CPU-Zeit überschreiten kann und SEHR anders interpretiert wird als „Prozessorinformationen\% Prozessor-Hilfsprogramm“. In der Praxis kann „Prozess(lsass)\% Prozessorzeit“ als die Anzahl der zu 100 % ausgeführten CPUs angesehen werden, die zur Unterstützung der Anforderungen des Prozesses erforderlich sind. Ein Wert von 200 % bedeutet, dass 2 CPUs mit jeweils 100 % erforderlich sind, um die vollständige AD DS-Auslastung zu unterstützen. Eine CPU, die mit einer Kapazität von 100 % ausgeführt wird, ist unter dem Gesichtspunkt der Ausgaben für CPUs sowie des Stromverbrauchs zwar am kostengünstigsten, aber ein Multithreadsystem weist aus einer Reihe von Gründen, die in Anhang A beschrieben sind, eine bessere Reaktionsfähigkeit auf, wenn das System nicht zu 100 % ausgeführt wird.

Um vorübergehende Spitzen der Clientlast zu bewältigen, sollte eine CPU-Spitzenzeit von 40 % bis 60 % der Systemkapazität angestrebt werden. Im obigen Beispiel würde dies bedeuten, dass zwischen 3,33 (Ziel 60 %) und 5 (Ziel 40 %) CPUs für die AD DS-Last (lsass-Prozess) benötigt würden. Zusätzliche Kapazität sollte entsprechend den Anforderungen des Basisbetriebssystems und anderer erforderlicher Agents (z. B. Virenschutz, Sicherung, Überwachung usw.) hinzugefügt werden. Obwohl die Auswirkungen von Agents der Umgebung entsprechend ausgewertet werden müssen, ist eine Schätzung zwischen 5 % und 10 % einer einzelnen CPU möglich. Im aktuellen Beispiel würde dies darauf hindeuten, dass in Spitzenzeiten zwischen 3,43 CPUs (Ziel 60 %) und 5,1 (Ziel 40 %) erforderlich sind.

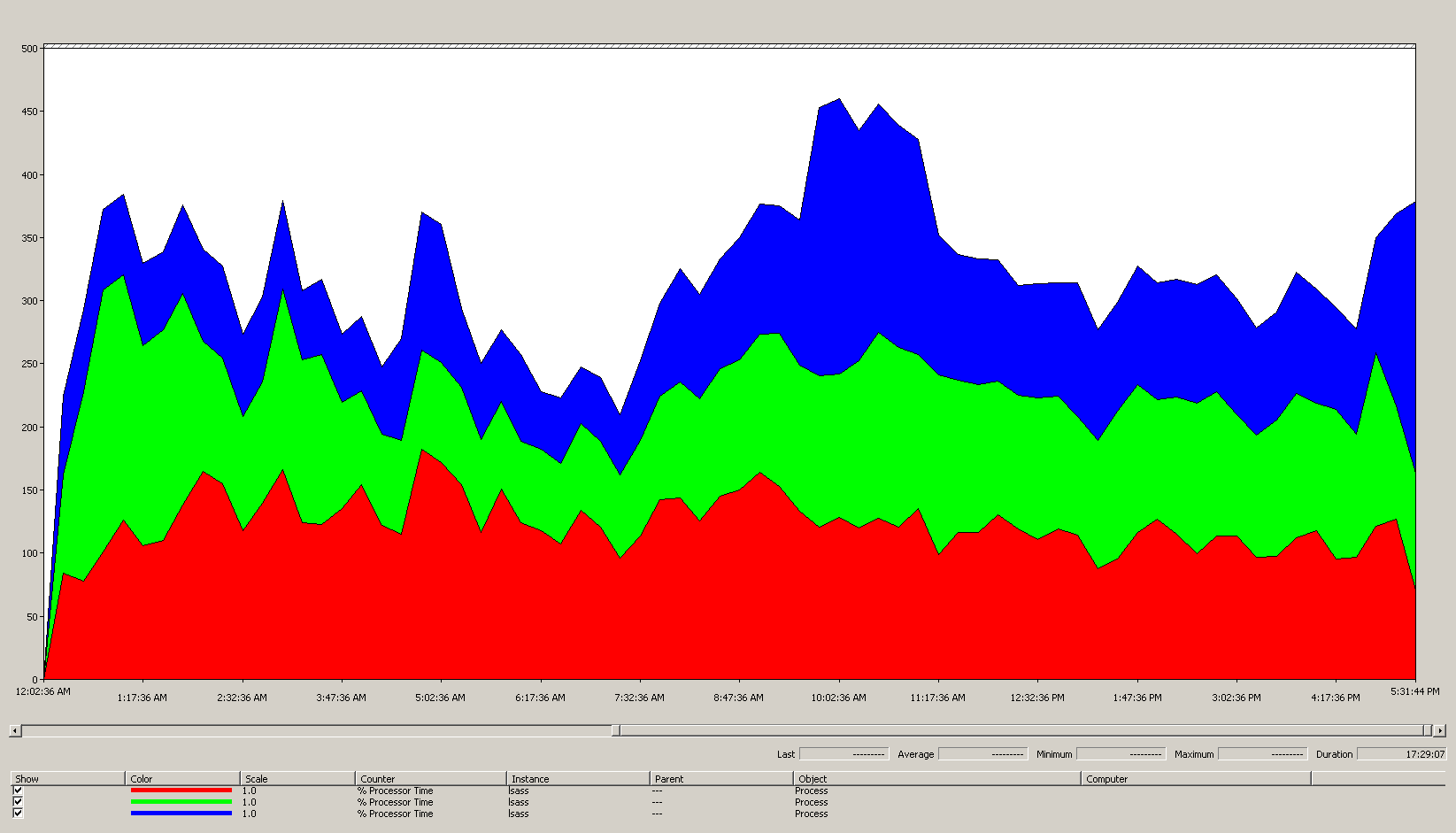

Die einfachste Möglichkeit hierfür ist die Verwendung der Ansicht „Gestapelte Fläche“ in Windows Reliability und Systemmonitor, um sicherzustellen, dass alle Leistungsindikatoren gleich skaliert sind.

Voraussetzungen:

- Ziel ist es, den Speicherbedarf auf so wenige Server wie möglich zu reduzieren. Im Idealfall trägt ein Server die Last, und ein zusätzlicher Server wird zur Redundanz hinzugefügt („N + 1“-Szenario).

Erkenntnisse aus den Daten im Diagramm (Prozess(lsass)\% Prozessorzeit):

- Der Geschäftstag beginnt um 7:00 Uhr und geht um 17:00 Uhr zu Ende.

- Der Zeitraum der stärksten Nutzung ist von 9:30 Uhr bis 11:00 Uhr.

Hinweis

Alle Leistungsdaten sind Verlaufsdaten. Der Spitzendatenpunkt um 9:15 Uhr gibt die Last von 9:00 bis 9:15 Uhr an.

- Es gibt Spitzen vor 7:00 Uhr, was entweder auf die Auslastung aus verschiedenen Zeitzonen oder auf Infrastrukturaktivitäten im Hintergrund wie Sicherungen hinweisen kann. Da der Höchstwert um 9:30 Uhr diese Aktivität überschreitet, ist er nicht relevant.

- Es gibt drei Domänencontroller an diesem Standort.

Bei maximaler Auslastung verbraucht lsass etwa 485 % einer CPU oder 4,85 CPUs, die zu 100 % ausgeführt werden. Gemäß der obigen Berechnung bedeutet dies, dass der Standort etwa 12,25 CPUs für AD DS benötigt. Fügen Sie die obigen Vorschläge von 5 % bis 10 % für Hintergrundprozesse hinzu. Dies bedeutet, dass für einen Austausch des Servers heute ungefähr 12,30 bis 12,35 CPUs nötig wären, um die gleiche Last zu unterstützen. Eine Umgebunsschätzung für das Wachstum muss nun einbezogen werden.

Wann eine Optimierung der LDAP-Gewichtung erforderlich ist

Es gibt mehrere Szenarien, in denen die Optimierung von LdapSrvWeight in Betracht gezogen werden sollte. Im Rahmen der Kapazitätsplanung erfolgt dies, wenn die Anwendungs- oder Benutzerlasten nicht gleichmäßig ausbalanciert sind oder die zugrunde liegenden Systeme hinsichtlich ihrer Leistungsfähigkeit nicht gleichmäßig ausbalanciert sind. Gründe, die über die Kapazitätsplanung hinausgehen, liegen außerhalb des Rahmens dieses Artikels.

Es gibt zwei häufige Gründe für die Optimierung von LDAP-Gewichtungen:

- Der PDC-Emulator ist ein Beispiel, das jede Umgebung betrifft, in der das Benutzer- oder Anwendungslastverhalten nicht gleichmäßig verteilt ist. Da bestimmte Tools und Aktionen auf den PDC-Emulator abzielen, z. B. die Gruppenrichtlinien-Verwaltungstools, zweite Versuche bei Authentifizierungsfehlern, Vertrauensstellung usw., sind CPU-Ressourcen im PDC-Emulator möglicherweise stärker gefragt als an anderer Stelle des Standorts.

- Es ist nur sinnvoll, dies zu optimieren, wenn es einen spürbaren Unterschied in der CPU-Auslastung gibt, um die Last des PDC-Emulators zu reduzieren, und durch Erhöhen der Last auf anderen Domänencontrollern wird eine gleichmäßigere Lastverteilung ermöglicht.

- Legen Sie in diesem Fall LDAPSrvWeight für den PDC-Emulator zwischen 50 und 75 fest.

- Server mit unterschiedlicher Anzahl von CPUs (und Geschwindigkeiten) an einem Standort. Angenommen, es gibt zwei Server mit acht Kernen und einen Server mit vier Kernen. Der letzte Server verfügt über die Hälfte der Prozessoren der anderen beiden Server. Dies bedeutet, dass eine gut verteilte Clientlast die durchschnittliche CPU-Auslastung der Einheit mit vier Kernen auf etwa das Doppelte der Einheiten mit acht Kernen erhöht.

- Beispielsweise würden die beiden Einheiten mit acht Kernen zu 40 % und die Einheit mit vier Kernen zu 80 % ausgeführt werden.

- Berücksichtigen Sie auch die Auswirkungen des Verlusts eines Feldes mit acht Kernen in diesem Szenario, insbesondere die Tatsache, dass das Feld mit vier Kernen jetzt überlastet wäre.

Beispiel 1: PDC

| System | Auslastung mit Standardwerten | Neues LdapSrvWeight | Geschätzte neue Auslastung |

|---|---|---|---|

| DC1 (PDC-Emulator) | 53 % | 57 | 40% |

| DC 2 | 33 % | 100 | 40% |

| DC 3 | 33 % | 100 | 40% |

Der Haken dabei ist: Wenn die PDC-Emulatorrolle übertragen oder übernommen wird, insbesondere auf einen anderen Domänencontroller am Standort, wird der neue PDC-Emulator drastisch erhöht.

Anhand des Beispiels aus dem Abschnitt Verhaltensprofil des Zielstandorts wurde davon ausgegangen, dass alle drei Domänencontroller am Standort über vier CPUs verfügen. Was sollte unter normalen Bedingungen passieren, wenn einer der Domänencontroller über acht CPUs verfügt? Es würde zwei Domänencontroller mit einer Auslastung von 40 % und einen mit einer Auslastung von 20 % geben. Dies ist zwar nicht schlecht, aber es gibt eine Möglichkeit, die Last ein wenig besser auszugleichen. Nutzen Sie dazu LDAP-Gewichtungen. Ein Beispielszenario wäre:

Beispiel 2: Unterschiedliche CPU-Anzahl

| System | Prozessorinformationen\ % Prozessor-Hilfsprogramm(_Gesamt) Auslastung mit Standardwerten |

Neues LdapSrvWeight | Geschätzte neue Auslastung |

|---|---|---|---|

| 4-CPU DC 1 | 40 | 100 | 30 % |

| 4-CPU DC 2 | 40 | 100 | 30 % |

| 8-CPU DC 3 | 20 | 200 | 30 % |

Seien Sie bei diesen Szenarien jedoch sehr vorsichtig. Auf dem Papier sieht die Berechnung wirklich gut aus. In diesem Artikel ist die Planung eines „N + 1“-Szenarios jedoch von größter Bedeutung. Die Auswirkungen eines offline geschalteten Domänencontrollers müssen für jedes Szenario berechnet werden. In dem unmittelbar vorangegangenen Szenario, in dem die Last gleichmäßig auf alle Server verteilt ist, um eine 60 %ige Last in einem „N“-Szenario zu gewährleisten, wird die Verteilung in Ordnung sein, da die Verhältnisse gleich bleiben. Bei Betrachtung des Szenarios zur Optimierung des PDC-Emulators und im Allgemeinen jedes Szenarios, in dem die Benutzer- oder Anwendungslast nicht ausgeglichen ist, ist die Auswirkung sehr unterschiedlich:

| System | Optimierte Auslastung | Neues LdapSrvWeight | Geschätzte neue Auslastung |

|---|---|---|---|

| DC1 (PDC-Emulator) | 40% | 85 | 47 % |

| DC 2 | 40% | 100 | 53 % |

| DC 3 | 40% | 100 | 53 % |

Überlegungen zur Virtualisierung für die Verarbeitung

Es gibt zwei Ebenen der Kapazitätsplanung, die in einer virtualisierten Umgebung berücksichtigt werden müssen. Auf Hostebene müssen ähnlich wie bei dem zuvor für die Domänencontrollerverarbeitung beschriebenen Geschäftszyklus Schwellenwerte während der Spitzenzeit identifiziert werden. Da die zugrunde liegenden Prinzipien für einen Hostcomputer, der Gastthreads auf der CPU plant, und für das Abrufen von AD DS-Threads auf der CPU identisch sind, wird dasselbe Ziel von 40 % bis 60 % auf dem zugrunde liegenden Host empfohlen. Auf der nächsten Ebene, der Gastebene, liegt das Ziel innerhalb des Gasts im Bereich von 40 % bis 60 %, da sich die Prinzipien der Threadplanung nicht geändert haben.

In einem direkt zugeordneten Szenario, einem Gast pro Host, muss die gesamte Kapazitätsplanung bis zu diesem Punkt den Anforderungen (RAM, Datenträger, Netzwerk) des zugrunde liegenden Hostbetriebssystems hinzugefügt werden. In einem Szenario mit gemeinsam genutztem Host zeigen Tests an, dass sich die Effizienz der zugrunde liegenden Prozessoren zu 10 % auswirkt. Das bedeutet, wenn ein Standort 10 CPUs bei einem Ziel von 40 % benötigt, ist die empfohlene Anzahl virtueller CPUs, die allen „N“-Gästen zugeordnet werden sollen, 11. An einem Standort mit einer gemischten Verteilung aus physischen und virtuellen Servern gilt der Modifizierer nur für die VMs. Wenn ein Standort beispielsweise das Szenario „N + 1“ aufweist, entspricht ein physischer oder direkt zugeordneter Server mit 10 CPUs ungefähr einem Gast mit 11 CPUs auf einem Host, wobei 11 CPUs für den Domänencontroller reserviert sind.

Bei der Analyse und Berechnung der CPU-Mengen, die zur Unterstützung der AD DS-Last erforderlich sind, kann die Anzahl der CPUs im Sinne physischer Hardware nicht unbedingt eindeutig bestimmt werden. Bei der Virtualisierung entfällt die Notwendigkeit, aufzurunden. Virtualisierung verringert den erforderlichen Aufwand, einem Standort Computekapazität hinzuzufügen, wenn man bedenkt, wie leicht eine CPU einem virtuellen Computer hinzugefügt werden kann. Dennoch muss die erforderliche Computeleistung genau bewertet werden, damit die zugrunde liegende Hardware verfügbar ist, wenn den Gästen zusätzliche CPUs hinzugefügt werden müssen. Denken Sie wie immer daran, das Wachstum der Nachfrage zu planen und zu überwachen.

Beispiel für die Berechnungszusammenfassung

| System | Höchstwert für CPU |

|---|---|

| DC 1 | 120 % |

| DC 2 | 147 % |

| DC 3 | 218 % |

| Gesamte CPU-Nutzung | 485 % |

| Anzahl der Zielsysteme | Gesamtbandbreite (von oben) |

|---|---|

| Bei einem Ziel von 40 % erforderliche CPUs | 4,85 ÷ 0,4 = 12,25 |

Zur Wiederholung, weil dieser Punkt so wichtig ist: Denken Sie daran, das Wachstum zu planen. Bei einem angenommenen Wachstum von 50 % in den nächsten drei Jahren wird diese Umgebung 18,375 CPUs (12,25 × 1,5) an der Dreijahresmarke benötigen. Ein alternativer Plan wäre, nach dem ersten Jahr eine Überprüfung durchzuführen und bei Bedarf zusätzliche Kapazität hinzuzufügen.

Vertrauenswürdige Clientauthentifizierungslast für NTLM

Auswerten der Last der vertrauenswürdigen Clientauthentifizierung

Viele Umgebungen verfügen möglicherweise über eine oder mehrere Domänen, die durch eine Vertrauensstellung verbunden sind. Eine Authentifizierungsanforderung für eine Identität in einer anderen Domäne, die keine Kerberos-Authentifizierung verwendet, muss eine Vertrauensstellung über den sicheren Kanal des Domänencontrollers zu einem anderen Domänencontroller durchlaufen, entweder in der Zieldomäne oder in der nächsten Domäne im Pfad zur Zieldomäne. Die Anzahl gleichzeitiger Aufrufe über den sicheren Kanal, die ein Domänencontroller an einen Domänencontroller in einer vertrauenswürdigen Domäne richten kann, wird durch die Einstellung MaxConcurrentAPI gesteuert. Für Domänencontroller wird durch einen von zwei Ansätzen sichergestellt, dass der sichere Kanal die Lastmenge verarbeiten kann: Optimierung von MaxConcurrentAPI oder, innerhalb einer Gesamtstruktur, das Erstellen von Vertrauensstellungsabkürzungen. Informationen zum Messen des Datenverkehrsvolumens einer einzelnen Vertrauensstellung finden Sie unter Leistungsoptimierung für NTLM-Authentifizierung mithilfe der Einstellung MaxConcurrentApi.

Während der Datensammlung muss dies, wie bei allen anderen Szenarien, während der Spitzenzeiten des Tages erfasst werden, damit die Daten nützlich sind.

Hinweis

Gesamstrukturinterne und die Gesamtstruktur übergreifende Szenarien können dazu führen, dass die Authentifizierung mehrere Vertrauensstellungen durchläuft, und jede Phase muss optimiert werden.

Planung

Es gibt eine Reihe von Anwendungen, die die NTLM-Authentifizierung standardmäßig oder in einem bestimmten Konfigurationsszenario verwenden. Anwendungsserver nehmen an Kapazität zu und bedienen immer mehr aktive Clients. Es gibt auch den Trend, dass Clients Sitzungen für eine begrenzte Zeit geöffnet lassen und eher regelmäßig erneut eine Verbindung herstellen (z. B. E-Mail-Pullsynchronisierung). Ein weiteres häufiges Beispiel für hohe NTLM-Auslastung sind Webproxyserver, die eine Authentifizierung für den Internetzugriff erfordern.

Diese Anwendungen können eine erhebliche Last für die NTLM-Authentifizierung verursachen, was die Domänencontroller erheblich belasten kann, insbesondere wenn sich Benutzer*innen und Ressourcen in verschiedenen Domänen befinden.

Es gibt mehrere Ansätze für die Verwaltung von vertrauenswürdiger Last, die in der Praxis in Verbindung und nicht in einem exklusiven „Entweder-oder“-Szenario verwendet werden. Folgende Optionen sind möglich:

- Reduzieren Sie die vertrauenswürdige Clientauthentifizierung, indem Sie die Dienste suchen, die Benutzer*innen in derselben Domäne nutzen, in der sie sich befinden.

- Erhöhen Sie die Anzahl der verfügbaren sicheren Kanäle. Dies ist für den gesamstrukturinternen und die Gesamtstruktur übergreifenden Datenverkehr relevant und wird als „Vertrauensstellungsabkürzungen“ bezeichnet.

- Optimieren Sie die Standardeinstellungen für MaxConcurrentAPI.

Für die Optimierung von MaxConcurrentAPI auf einem vorhandenen Server lautet die Gleichung:

Neue_MaxConcurrentApi-Einstellung ≥ (Semaphor_erwirbt + Semaphortimeouts) × Durchschnittliche_Semaphorenhaltezeit ÷ Dauer_der_Zeiterfassung

Weitere Informationen hierzu finden Sie unter KB-Artikel 2688798: Leistungsoptimierung für NTLM-Authentifizierung mithilfe der Einstellung MaxConcurrentApi.

Virtualisierung: Überlegungen

Keine, dies ist eine Einstellung zur Betriebssystemoptimierung.

Beispiel für die Berechnungszusammenfassung

| Datentyp | Wert |

|---|---|

| Semaphor erwirbt (Minimum) | 6.161 |

| Semaphor erwirbt (Maximum) | 6.762 |

| Semaphortimeouts | 0 |

| Durchschnittliche Semaphorenhaltezeit | 0,012 |

| Sammlungsdauer (Sekunden) | 1:11 Minuten (71 Sekunden) |

| Formel (von KB 2688798) | ((6762 – 6161) + 0) × 0,012 / |

| Mindestwert für MaxConcurrentAPI | ((6762 – 6161) + 0) × 0,012 ÷ 71 = 0,101 |

Für dieses System und diesen Zeitraum sind die Standardwerte akzeptabel.

Überwachung der Einhaltung der Ziele für die Kapazitätsplanung

In diesem Artikel wurde erläutert, dass Planung und Skalierung sich an den Nutzungszielen orientieren. Im Folgenden finden Sie ein zusammenfassendes Diagramm der empfohlenen Schwellenwerte, die überwacht werden müssen, um sicherzustellen, dass die Systeme innerhalb angemessener Kapazitätsschwellenwerte arbeiten. Beachten Sie, dass es sich dabei nicht um Leistungsschwellenwerte handelt, sondern um Schwellenwerte für die Kapazitätsplanung. Ein Server, der diese Schwellenwerte überschreitet, funktioniert, aber dann sollte überprüft werden, ob sich alle Anwendungen gut verhalten. Wenn sich diese Anwendungen gut verhalten, sollte mit der Auswertung von Hardwareupgrades oder anderen Konfigurationsänderungen begonnen werden.

| Category | Leistungsindikator | Intervall/Stichprobenentnahme | Ziel | Warnung |

|---|---|---|---|---|

| Prozessor | Prozessorinformationen(_Gesamt)\% Prozessor-Hilfsprogramm | 60 Min. | 40% | 60% |

| RAM (Windows Server 2008 R2 oder früher) | Arbeitsspeicher\Verfügbare MB | < 100 MB | – | < 100 MB |

| RAM (Windows Server 2012) | Arbeitsspeicher\Langfristige durchschnittliche Lebensdauer im Standbycache | 30 Min. | Muss getestet werden | Muss getestet werden |

| Netzwerk | Netzwerkschnittstelle(*)\Gesendete Bytes/s Netzwerkschnittstelle(*)\Empfangene Bytes/s |

30 Min. | 40% | 60% |

| Storage | Logischer Datenträger(<NTDS-Datenbanklaufwerk>)\Mittlere Sek./Lesevorgänge Logischer Datenträger(<NTDS-Datenbanklaufwerk>)\Mittlere Sek./Schreibvorgänge |

60 Min. | 10 ms | 15 ms |

| AD-Dienste | Netlogon(*)\Durchschnittliche Semaphorenhaltezeit | 60 Min. | 0 | 1 Sekunde |

Anhang A: Kriterien der CPU-Dimensionierung

Definitionen

Prozessor (Mikroprozessor): eine Komponente, die Programmanweisungen liest und ausführt

CPU: Zentralprozessor

Mehrkernprozessor: mehrere CPUs auf demselben IC

Multi-CPU: mehrere CPUs, nicht auf demselben IC

Logischer Prozessor: eine logische Computing-Engine aus Sicht des Betriebssystems

Dies umfasst Hyperthreading, einen Kern eines Mehrkernprozessors oder einen Prozessor mit einem einzelnen Kern.

Da die heutigen Serversysteme über mehrere Prozessoren, mehrere Mehrkernprozessoren und Hyperthreading verfügen, sind diese Informationen verallgemeinert, um beide Szenarien abzudecken. Daher wird der Begriff „logischer Prozessor“ verwendet, da er die Betriebssystem- und Anwendungsperspektive der verfügbaren Computing-Engines darstellt.

Parallelität auf Threadebene

Jeder Thread ist ein unabhängiger Task, da jeder Thread über einen eigenen Stapel und eigene Anweisungen verfügt. Da AD DS Multithreading einsetzt und die Anzahl der verfügbaren Threads mithilfe von Anzeigen und Festlegen einer LDAP-Richtlinie in Active Directory mithilfe von Ntdsutil.exe optimiert werden kann, ist eine mehrere logische Prozessoren übergreifende Skalierung gut machbar.

Parallelität auf Datenebene

Dies umfasst die mehrere Threads übergreifende gemeinsame Nutzung von Daten innerhalb eines Prozesses (im Fall des AD DS-Prozesses allein) und mehrere Threads in mehreren Prozessen übergreifend (im Allgemeinen). Um den Fall nicht zu sehr zu vereinfachen: Dies bedeutet, dass alle Änderungen an Daten in allen ausgeführten Threads in allen verschiedenen Cacheebenen (L1, L2, L3) alle Kerne übergreifend, die diese Threads ausführen, sowie im Aktualisieren des freigegebenen Arbeitsspeichers widergespiegelt werden. Die Leistung kann während Schreibvorgängen beeinträchtigt werden, während alle verschiedenen Arbeitsspeicherorte konsistent sind, bevor die Verarbeitung der Anweisungen fortgesetzt werden kann.

Überlegungen zur CPU-Geschwindigkeit in Verbindung mit mehreren Kernen

Die allgemeine Faustregel ist, dass schnellere logische Prozessoren die zum Verarbeiten einer Reihe von Anweisungen benötigte Zeit reduzieren, während mehr logische Prozessoren bedeuten, dass mehr Aufgaben gleichzeitig ausgeführt werden können. Diese Faustregeln versagen, wenn die Szenarien von Natur aus komplexer werden, wobei Überlegungen zum Abrufen von Daten aus freigegebenem Arbeitsspeicher, zum Warten auf Parallelität auf Datenebene und zum Mehraufwand für die Verwaltung mehrerer Threads erforderlich sind. Dies ist auch der Grund, warum Skalierbarkeit in Systemen mit mehreren Kernen nicht linear ist.

Betrachten Sie die folgenden Analogien in diesen Überlegungen: Stellen Sie sich eine Autobahn vor, wobei jeder Thread ein einzelnes Auto ist, jede Spur ein Kern und das Tempolimit die Taktgeschwindigkeit.

- Wenn nur ein Auto auf der Autobahn ist, spielt es keine Rolle, ob zwei oder 12 Spuren verfügbar sind. Dieses Auto wird nur so schnell fahren, wie es das Tempolimit zulässt.

- Angenommen, die vom Thread benötigten Daten sind nicht sofort verfügbar. Die Analogie wäre, dass ein Straßenabschnitt gesperrt ist. Wenn nur ein Auto auf der Autobahn ist, spielt es keine Rolle, wie hoch die Geschwindigkeitsbegrenzung ist, bis die Spur wieder geöffnet wird (Daten werden aus dem Speicher abgerufen).

- Wenn die Anzahl der Autos steigt, steigt der Mehraufwand für die Verwaltung der Anzahl der Autos. Vergleichen Sie die Erfahrung des Fahrens und die erforderliche Aufmerksamkeit, wenn die Straße praktisch leer ist (z. B. am späten Abend) mit dem starken Verkehr (z. B. nachmittags, aber nicht zur Hauptverkehrszeit). Berücksichtigen Sie auch die erforderliche Aufmerksamkeit, wenn Sie auf einer zweispurigen Autobahn fahren, wo nur auf einer anderen Spur die Aktionen der Fahrer*innen beachtet werden müssen, im Gegensatz zu einer sechsspurigen Autobahn, wo viele andere Fahrer*innen Aufmerksamkeit erfordern.

Hinweis

Die Analogie zum Hauptverkehrszeitszenario wird im nächsten Abschnitt erweitert: Antwortzeit/Wie sich die Systemlast auf die Leistung auswirkt.

Infolgedessen sind Angaben über mehr oder schnellere Prozessoren in hohem Maße vom Anwendungsverhalten abhängig, das im Falle von AD DS sehr umgebungsspezifisch ist und sogar innerhalb einer Umgebung von Server zu Server variiert. Aus diesem Grund wird bei den Verweisen weiter oben im Artikel nicht beharrlich auf übermäßige Präzision gepocht, und eine Sicherheitsmarge wird in die Berechnungen einbezogen. Bei budgetorientierten Kaufentscheidungen sollte die Nutzung der Prozessoren zunächst auf 40 % (oder die für die Umgebung gewünschte Anzahl) optimiert werden, bevor der Kauf schnellerer Prozessoren erwogen wird. Die höhere mehrere Prozessoren übergreifende Synchronisierung verringert den wahren Nutzen von mehr Prozessoren durch die lineare Progression (die doppelte Anzahl Prozessoren bietet weniger als die doppelte verfügbare Computeleistung).

Hinweis

Amdahl-Gesetz und Gustafson-Gesetz sind hier die relevanten Konzepte.

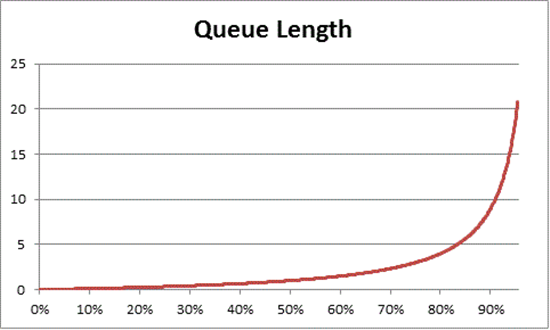

Antwortzeit/Wie sich die Systemlast auf die Leistung auswirkt

Die Warteschlangentheorie ist die mathematische Untersuchung von Wartelinien (Warteschlangen). In der Warteschlangentheorie wird das Nutzungsgesetz durch diese Gleichung dargestellt:

U k = B ÷ T

Dabei ist U k der Auslastungsprozentsatz, B die benötigte Zeit und T die Gesamtzeit, für die das System beobachtet wurde. In den Kontext von Windows übersetzt bedeutet dies die Anzahl der 100-Nanosekunden-Intervallthreads (ns), die sich im Ausführungszustand befinden, dividiert durch die Anzahl von 100-ns-Intervallen, die in einem bestimmten Zeitintervall verfügbar waren. Dies ist genau die Formel für die Berechnung von „% Prozessor-Hilfsprogramm“ (Referenz Prozessorobjekt und PERF_100NSEC_TIMER_INV).

Die Warteschlangentheorie bietet auch die Formel: N = U k ÷ (1 – U k), um die Anzahl der wartenden Elemente basierend auf der Auslastung zu schätzen ( N ist die Länge der Warteschlange). Die Diagrammerstellung für alle Auslastungsintervalle liefert die folgenden Schätzungen, wie lange die Warteschlange für den Prozessorzugriff bei einer bestimmten CPU-Auslastung ist.

Es ist zu beobachten, dass nach 50 % CPU-Auslastung im Durchschnitt immer mit einem spürbaren schnellen Anstieg nach etwa 70 % CPU-Auslastung auf ein anderes Element in der Warteschlange gewartet wird.

Wir kehren nun zur weiter oben in diesem Abschnitt verwendeten Fahranalogie zurück:

- Die geschäftigen Zeiten des „Nachmittags“ würden hypothetisch irgendwo in den Bereich von 40 % bis 70 % fallen. Das Verkehrsaufkommen ist so, dass die Fähigkeit, eine Spur zu wählen, nicht wesentlich eingeschränkt ist, und die Wahrscheinlichkeit, dass ein anderer Fahrer im Weg ist, zwar hoch ist, jedoch nicht den Aufwand erfordert, eine sichere Lücke zwischen anderen Autos auf der Straße finden zu müssen.

- Wenn die Hauptverkehrszeit näher rückt, ist festzustellen, dass die Auslastung des Straßennetzes sich der 100 %-Marke nähert. Der Wechsel von Fahrspuren kann sehr schwierig werden, weil Autos so nah beieinander sind, dass erhöhte Vorsicht geboten ist.

Aus diesem Grund bieten die langfristigen Durchschnittswerte für die Kapazität, die konservativ auf 40 % geschätzt werden, einen Spielraum für anormale Lastspitzen, unabhängig davon, ob es sich um vorübergehende Spitzen handelt (z. B. schlecht codierte Abfragen, die einige Minuten lang laufen), oder um anormale Bursts in der allgemeinen Last (der Morgen des ersten Tages nach einem langen Wochenende).

In der obigen Aussage wird die Berechnung der prozentualen Prozessorzeit zur Vereinfachung für die Leser*innen mit dem Nutzungsgesetz gleichgesetzt. Für die mathematisch eher Hartgesottenen:

- Übersetzen von PERF_100NSEC_TIMER_INV