Integration von „Software und Hardware (SH)“-Features und -Technologien

Gilt für: Windows Server 2022, Windows Server 2019, Azure Stack HCI, Versionen 21H2 und 20H2

Diese Features verfügen über Software- und Hardwarekomponenten. Die Software ist eng mit Hardwarefunktionen verbunden, die erforderlich sind, damit das Feature funktioniert. Beispiele hierfür sind VMMQ, VMQ, IPv4-Prüfsummenauslagerung auf Senderseite und RSS. Weitere Informationen finden Sie unter Anforderungen an das Hostnetzwerk für die Azure Stack HCI.

Tipp

SH- und HO-Features sind verfügbar, wenn die installierte NIC dies unterstützt. In den folgenden Funktionsbeschreibungen erfahren Sie, wie Sie feststellen können, ob Ihre NIC das Feature unterstützt.

Konvergente NIC

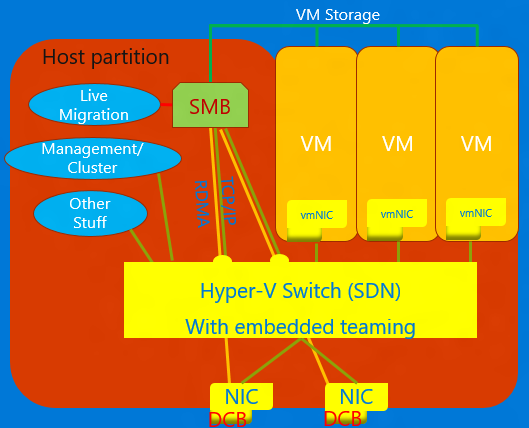

Die konvergente NIC ist eine Technologie, die es virtuellen NICs auf dem Hyper-V-Host ermöglicht, RDMA-Dienste für Hostprozesse verfügbar zu machen. Windows Server 2016 erfordert keine separaten NICs mehr für RDMA. Das Feature „Konvergente NIC“ ermöglicht es den virtuellen NICs in der Hostpartition (vNICs), RDMA für die Hostpartition verfügbar zu machen und die Bandbreite der NICs zwischen dem RDMA-Datenverkehr und der VM und anderen TCP/UDP-Datenverkehr auf faire und verwaltbare Weise gemeinsam zu verwenden.

Sie können konvergente NIC-Vorgänge über VMM oder Windows PowerShell verwalten. Die PowerShell-Cmdlets sind die gleichen Cmdlets, die für RDMA verwendet werden (siehe unten).

So verwenden Sie die Funktion „konvergente NIC“:

Stellen Sie sicher, dass Sie den Host für DCB einrichten.

Stellen Sie sicher, dass Sie RDMA für die NIC aktivieren, oder im Fall eines SET-Teams, dass die NICs an den Hyper-V-Switch gebunden sind.

Stellen Sie sicher, dass Sie RDMA für die vNICs aktivieren, die für RDMA auf dem Host bestimmt sind.

Ausführliche Informationen zu RDMA und SET finden Sie unter Remotezugriff auf den direkten Speicher (RDMA) und Switch Embedded Teaming (SET).

Data Center Bridging (DCB)

DCB besteht aus einer Reihe von IEEE-Standards (Institute of Electrical and Electronics Engineers), die konvergente Fabrics in Rechenzentren ermöglichen. DCB bietet auf Hardwarewarteschlangen basierende Bandbreitenverwaltung in einem Host mit Zusammenarbeit vom angrenzenden Switch. Der gesamte Datenverkehr für Speicher, Datennetzwerke, Kommunikation zwischen Prozessen (IPC) der Cluster und Verwaltung nutzen dieselbe Ethernet-Netzwerkinfrastruktur. In Windows Server 2016 kann DCB auf jede einzelne NIC einzeln sowie auf NICs angewendet werden, die an den Hyper-V-Switch gebunden sind.

Für DCB verwendet Windows Server prioritätsbasierte Flusssteuerung (PFC), die in IEEE 802.1Qbb standardisiert ist. PFC erstellt ein (fast) verlustfreies Netzwerk-Fabric, indem ein Überlauf innerhalb von Datenverkehrsklassen verhindert wird. Windows Server verwendet außerdem die in IEEE 802.1Qaz standardisierte erweiterte Übertragungsauswahl (Enhanced Transmission Selection, ETS). ETS ermöglicht die Aufteilung der Bandbreite in reservierte Teile für bis zu acht Datenverkehrsklassen. Jede Datenverkehrsklasse verfügt über eine eigene Übertragungswarteschlange und kann durch die Verwendung von PFC die Übertragung innerhalb einer Klasse starten und beenden.

Hyper-V-Netzwerkvirtualisierung

| Version | BESCHREIBUNG |

|---|---|

| v1 (HNVv1) | Hyper-V-Netzwerkvirtualisierung (HNV) wurde in Windows Server 2012 eingeführt und ermöglicht die Virtualisierung von Kundennetzwerken auf der Basis einer gemeinsam genutzten physischen Netzwerkinfrastruktur. Mit nur minimalen Änderungen an der physischen Netzwerkstruktur bietet HNV Dienstanbietern die Flexibilität, Mandantenworkloads überall in den drei Clouds bereitzustellen und zu migrieren: in der Cloud des Dienstanbieters, in der privaten Cloud oder in der öffentlichen Microsoft Azure-Cloud. |

| v2 NVGRE (HNVv2 NVGRE) | In Windows Server 2016 und System Center Virtual Machine Manager bietet Microsoft eine End-to-End-Netzwerkvirtualisierungslösung, die ein RAS-Gateway, Softwarelastenausgleich, einen Netzwerkcontroller und vieles mehr umfasst. Weitere Informationen finden Sie unter Hyper-V-Netzwerkvirtualisierung in Windows Server 2016: Übersicht. |

| v2 VxLAN (HNVv2 VxLAN) | Ist in Windows Server 2016 Teil der SDN-Erweiterung, die Sie über den Netzwerkcontroller verwalten. |

IPsec-Aufgabenauslagerung (IPsecTO)

IPsec-Aufgabenauslagerung ist eine NIC-Funktion, mit der das Betriebssystem den Prozessor in der NIC für IPsec-Verschlüsselungsaufgaben verwenden kann.

Wichtig

IPsec-Aufgabenauslagerung ist eine Legacytechnologie, die von den meisten Netzwerkadaptern nicht unterstützt wird. Wenn dies doch der Fall ist, ist sie standardmäßig deaktiviert.

Privates virtuelles lokales Netzwerk (Private Local Area Network, PVLAN).

PVLANs ermöglichen nur die Kommunikation zwischen VMs auf demselben Virtualisierungsserver. Ein privates virtuelles Netzwerk ist nicht mit einem physischen Netzwerkadapter gebunden. Ein privates virtuelles Netzwerk ist vom gesamten externen Netzwerkdatenverkehr auf dem Virtualisierungsserver sowie vom gesamten Netzwerkdatenverkehr zwischen dem Verwaltungsbetriebssystem und dem externen Netzwerk isoliert. Dieser Netzwerktyp ist nützlich, wenn Sie eine isolierten Netzwerkumgebung erstellen müssen, wie z. B. eine isolierte Testdomäne. Die Hyper-V- und SDN-Stapel unterstützen nur den PVLAN-Modus für isolierte Ports.

Ausführliche Informationen zur PVLAN-Isolierung finden Sie unter Engineering-Blog zu System Center: Virtual Machine Manager.

Remotezugriff auf den direkten Speicher (RDMA)

RDMA ist eine Netzwerktechnologie, die Kommunikation mit hohem Durchsatz und geringer Latenz bietet und die CPU-Auslastung minimiert. RDMA unterstützt Netzwerke ohne Kopiervorgänge, indem es dem Netzwerkadapter ermöglicht wird, Daten direkt in den oder aus dem Anwendungsspeicher zu übertragen. „RDMA-fähig“ bedeutet, dass die NIC (physisch oder virtuell) RDMA für einen RDMA-Client verfügbar machen kann. „RDMA-fähig“ bedeutet hingegen, dass eine RDMA-fähige NIC die RDMA-Schnittstelle im Stapel verfügbar macht.

Ausführliche Informationen zu RDMA finden Sie unter Remotezugriff auf den direkten Speicher (RDMA) und Switch Embedded Teaming (SET).

Empfangsseitige Skalierung (RSS)

RSS ist ein NIC-Feature, das verschiedene Datenströme trennt und sie zur Verarbeitung an verschiedene Prozessoren übermittelt. RSS parallelisiert die Netzwerkverarbeitung, sodass ein Host auf sehr hohe Datenraten skaliert werden kann.

Weitere Einzelheiten finden Sie unter Empfangsseitige Skalierung (Receive Side Scaling, RSS).

E/A-Virtualisierung mit Einzelstamm (SR-IOV)

SR-IOV ermöglicht es VM-Datenverkehr, direkt von der NIC zur VM zu gelangen, ohne den Hyper-V-Host zu durchlaufen. SR-IOV ist eine unglaubliche Leistungsverbesserung für eine VM, aber es fehlt die Möglichkeit für den Host, diese Pipe zu verwalten. Verwenden Sie SR-IOV nur, wenn die Workload ordnungsgemäß und vertrauenswürdig und im Allgemeinen die einzige VM auf dem Host ist.

Datenverkehr, der SR-IOV verwendet, umgeht den Hyper-V-Switch. Dies bedeutet, dass Richtlinien (z. B. ACLs) oder Bandbreitenverwaltung nicht angewendet werden. SR-IOV-Datenverkehr kann auch nicht über eine Netzwerkvirtualisierungsfunktion übergeben werden, sodass NV-GRE- oder VxLAN-Kapselung nicht angewendet werden kann. Verwenden Sie SR-IOV nur für vertrauenswürdige Workloads unter bestimmten Umständen. Darüber hinaus können Sie Hostrichtlinien, Bandbreitenverwaltung und Virtualisierungstechnologien nicht verwenden.

In Zukunft könnten zwei Technologien SR-IOV ermöglichen: Generic Flow Tables (GFT) und Hardware QoS Offload (Bandbreitenverwaltung in der NIC) – sobald die NICs in unserem Ökosystem dies unterstützen. Die Kombination dieser beiden Technologien würde SR-IOV für alle VMs nutzbar machen, die Anwendung von Richtlinien, Virtualisierungs- und Bandbreitenverwaltungsregeln ermöglichen und könnte zu großen Fortschritten bei der allgemeinen Anwendung von SR-IOV führen.

Weitere Informationen finden Sie unter Übersicht über E/A-Virtualisierung mit Einzelstamm (SR-IOV).

TCP Chimney Offload

TCP Chimney Offload, auch als TCP Engine Offload (TOE) bezeichnet, ist eine Technologie, mit der der Host die gesamte TCP-Verarbeitung an die NIC auslagern kann. Da der Windows Server-TCP-Stapel fast immer effizienter als die TOE-Engine ist, wird die Verwendung von TCP Chimney Offload nicht empfohlen.

Wichtig

TCP Chimney Offload ist eine veraltete Technologie. Es wird empfohlen, TCP Chimney Offload nicht zu verwenden, da Microsoft die Unterstützung in Zukunft möglicherweise einstellt.

Virtuelles lokales Netzwerk (Virtual Local Area Network, VLAN)

VLAN ist eine Erweiterung des Ethernet-Frameheaders, um die Partitionierung eines LAN in mehrere VLANs zu ermöglichen, die jeweils einen eigenen Adressraum verwenden. In Windows Server 2016 werden VLANs für Ports des Hyper-V-Switches festgelegt oder durch Festlegen von Teamschnittstellen in NIC-Teamingteams.

Warteschlange für virtuelle Computer (Virtual Machine Queue, VMQ)

VMQs ist eine NIC-Funktion, die jeder VM eine Warteschlange zuweist. Wenn Sie Hyper-V aktiviert haben, müssen Sie immer auch VMQ aktivieren. In Windows Server 2016 verwenden VMQs NIC-Switch-vPorts mit einer einzelnen Warteschlange, die dem vPort zugewiesen ist, um dieselbe Funktionalität bereitzustellen.

Mehrere VM-Warteschlangen (Virtual Machine Multi-Queue, VMMQ)

VMMQ ist ein NIC-Feature, mit dem der Datenverkehr für eine VM auf mehrere Warteschlangen verteilt werden kann, die jeweils von einem anderen physischen Prozessor verarbeitet werden. Der Datenverkehr wird dann wie in vRSS an mehrere LPs auf der VM übergeben, wodurch eine erhebliche Netzwerkbandbreite für die VM bereitgestellt werden kann.