Evaluate Model (Evaluar modelo)

Importante

El soporte técnico de Machine Learning Studio (clásico) finalizará el 31 de agosto de 2024. Se recomienda realizar la transición a Azure Machine Learning antes de esa fecha.

A partir del 1 de diciembre de 2021 no se podrán crear recursos de Machine Learning Studio (clásico). Hasta el 31 de agosto de 2024, puede seguir usando los recursos de Machine Learning Studio (clásico) existentes.

- Consulte la información acerca de traslado de proyectos de aprendizaje automático de ML Studio (clásico) a Azure Machine Learning.

- Más información sobre Azure Machine Learning.

La documentación de ML Studio (clásico) se está retirando y es posible que no se actualice en el futuro.

Evalúa los resultados de un modelo de clasificación o regresión con métricas estándar.

Categoría: Machine Learning/Evaluar

Nota

Se aplica a: solo Machine Learning Studio (clásico)

Hay módulos para arrastrar y colocar similares en el diseñador de Azure Machine Learning.

Información general sobre el módulo

En este artículo se describe cómo usar el módulo Evaluar modelo en Machine Learning Studio (clásico) para medir la precisión de un modelo entrenado. Hay que proporcionar un conjunto de datos que contenga las puntuaciones generadas a partir de un modelo y el módulo Evaluate Model calculará un conjunto de métricas de evaluación estándar del sector.

Las métricas devueltas por Evaluate Model dependen del tipo de modelo que va a evaluar:

Para los modelos de recomendación, use el módulo Evaluar recomendador .

Sugerencia

Si no está familiarizado con la evaluación del modelo, se recomiendan estos ejemplos en la Galería de Azure AI, que crean un modelo y, a continuación, explican cómo usar las métricas relacionadas:

- Comparación de modelos de regresión

- Comparación de clasificadores binarios

- Comparación de clasificadores multiclase

También recomendamos la serie de vídeos del Dr. Stephen Elston, como parte del curso de aprendizaje automático de EdX.

Cómo usar Evaluar modelo

Hay tres formas de usar el módulo Evaluate Model:

- Generar puntuaciones sobre los datos de entrenamiento y evaluar el modelo según estas puntuaciones.

- Generar puntuaciones en el modelo, pero compararlas con las de un conjunto de pruebas reservado.

- Comparar las puntuaciones de dos modelos diferentes pero relacionados, usando el mismo conjunto de datos.

Usar datos de aprendizaje

Para evaluar un modelo, debe conectar un conjunto de datos que contenga un conjunto de puntuaciones y columnas de entrada. Si no hay otros datos disponibles, puede usar el conjunto de datos original.

- Conectar la salida de datset puntuada del score model a la entrada de Evaluate Model.

- Haga clic en el módulo Evaluate Model y luego en Ejecutar seleccionado para generar las puntuaciones de la evaluación.

Usar datos de prueba

Un escenario común en el aprendizaje automático consiste en separar el conjunto de datos original en conjuntos de datos de entrenamiento y prueba, mediante el módulo Split (Dividir) o el módulo Partition and Sample (Partición y ejemplo).

- Conecte la salida de Scored dataset (Conjunto de datos puntuados) de Score Model (Puntuar modelo) a la entrada de Evaluate Model.

- Conecte la salida del módulo Split Data (Dividir datos) que contenga los datos de prueba con la entrada de la derecha de Evaluate Model.

- Haga clic en el módulo Evaluate Model y luego en Ejecutar seleccionado para generar las puntuaciones de la evaluación.

Comparar las puntuaciones de dos modelos

También puede conectar un segundo conjunto de puntuaciones a Evaluate Model. Las puntuaciones podrían ser un conjunto de evaluación compartido con resultados conocidos o un conjunto de resultados de un modelo diferente para los mismos datos.

Esta característica es útil porque permite comparar fácilmente los resultados de dos modelos distintos con los mismos datos. O bien, puede comparar las puntuaciones de las dos ejecuciones diferentes con los mismos datos con parámetros diferentes.

- Conectar la salida de datset puntuada del score model a la entrada de Evaluate Model.

- Conecte la salida del módulo Score Model (Puntuar modelo) para el segundo modelo a la entrada derecha de Evaluate Model.

- Haga clic con el botón derecho en Evaluate Model y luego en Ejecutar seleccionado para generar las puntuaciones de la evaluación.

Results

Después de ejecutar Evaluate Model, haga clic con el botón derecho en el módulo y seleccione Resultados de evaluación para ver los resultados. Puede:

- Guardar los resultados como un conjunto de datos, para facilitar el análisis con otras herramientas.

- Generación de una visualización en la interfaz de Studio (clásico)

Si conecta los conjuntos de datos a las dos entradas de Evaluate Model, los resultados contendrán las métricas para ambos conjuntos de datos, o ambos modelos. El modelo o los datos adjuntos al puerto izquierdo se presentan primero en el informe, seguido de las métricas del conjunto de datos o el modelo adjunto en el puerto derecho.

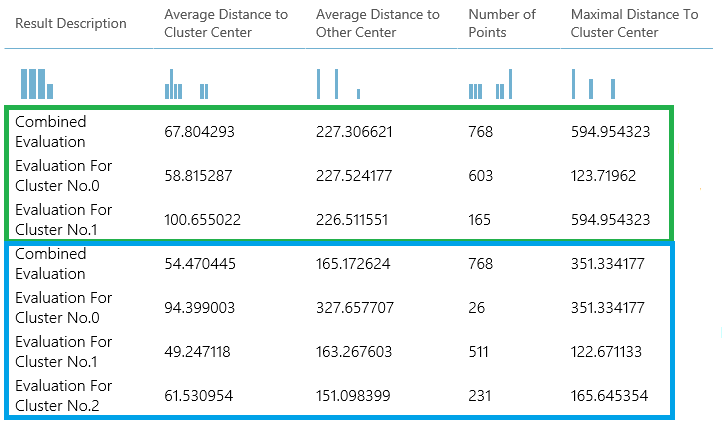

Por ejemplo, la imagen siguiente representa una comparación de los resultados de dos modelos de agrupación en clústeres que se crearon con los mismos datos, pero con distintos parámetros.

Debido a que se trata de un modelo de agrupación en clústeres, los resultados de evaluación son diferentes de si compara las puntuaciones de dos modelos de regresión o si compara dos modelos de clasificación. Pero la presentación general es la misma.

Métricas

Esta sección describe las métricas devueltas para los tipos específicos de los modelos admitidos para su uso con Evaluate Model:

Métricas para modelos de clasificación

Las siguientes métricas se notifican al evaluar los modelos de clasificación. Si compara los modelos, se clasifican según la métrica que seleccionó para la evaluación.

Precisión (Accuracy) mide la calidad de un modelo de clasificación como la proporción de resultados verdaderos en el total de casos.

Precisión es la proporción de resultados verdaderos de todos los resultados positivos.

Recuperación es una fracción de todos los resultados correctos devueltos por el modelo.

Puntuación F se calcula como el promedio ponderado de precisión y recuperación entre 0 y 1, donde el valor ideal de puntuación F es 1.

AUC mide el área bajo la curva trazada con los verdaderos positivos en el eje y los falsos positivos en el eje x. Esta métrica es útil porque proporciona un número único que le permite comparar los modelos de diferentes tipos.

Promedio de pérdida logarítmica es una puntuación única que se usa para expresar la penalización de los resultados incorrectos. Se calcula como la diferencia entre dos distribuciones de probabilidad: la verdadera y la que aparece en el modelo.

Pérdida logarítmica de entrenamiento es una puntuación única que representa la ventaja del clasificador sobre una predicción aleatoria. La pérdida de registro mide la incertidumbre del modelo comparando las probabilidades que envía a los valores conocidos (datos verdaderos) en las etiquetas. Quiere minimizar la pérdida de registro para el modelo en conjunto.

Métricas para los modelos de regresión

Las métricas devueltas para los modelos de regresión están diseñadas generalmente para estimar la cantidad de errores. Se considera que un modelo se ajusta a los datos correctamente si la diferencia entre los valores observados y los previstos es pequeña. Pero el patrón de los valores residuales (la diferencia entre un punto previsto y su valor real correspondiente) puede indicarle mucho sobre el sesgo potencial en el modelo.

Las siguientes métricas se notifican para evaluar los modelos de regresión. Al comparar los modelos, estos se clasifican según la métrica que seleccionó para la evaluación.

La probabilidad de registro negativa mide la función de pérdida, una puntuación más baja es mejor. Tenga en cuenta que esta métrica solo se calcula para la regresión lineal bayesiana y la regresión del bosque de decisión; para otros algoritmos, el valor es

Infinitylo que significa para nada.Error medio absoluto (MAE) : mide la proximidad de las predicciones con respecto a los resultados reales; por lo tanto, cuanto menor es la puntuación, mejor.

Error cuadrático medio (RMSE) : crea un valor único que resume el error en el modelo. Al elevar al cuadrado la diferencia, la métrica no tiene en cuenta la diferencia entre un exceso o un defecto de predicción.

Error absoluto relativo (RAE) : es la diferencia absoluta relativa entre los valores esperados y los reales; es relativa porque la diferencia media se divide por la media aritmética.

Error cuadrático relativo (RSE) : del mismo modo, normaliza el error cuadrático medio total de los valores previstos dividiendo entre el total de errores al cuadrado de los valores reales.

Error medio cero-uno (MZOE): indica si la predicción era correcta o no. En otras palabras:

ZeroOneLoss(x,y) = 1cuandox!=y; de lo contrario0.Coeficiente de determinación: a menudo conocido como R2, representa la eficacia predictiva del modelo como un valor entre 0 y 1. Cero significa que el modelo es aleatorio (no explica nada); 1 significa que hay un ajuste perfecto. Sin embargo, hay que tener precaución al interpretar los valores de R2, ya que los valores bajos pueden ser completamente normales y los valores altos pueden ser sospechosos.

Métricas para modelos de agrupación en clústeres

Dado que los modelos de agrupación en clústeres se diferencian considerablemente de los modelos de clasificación y regresión en muchos aspectos, Evaluar modelo también devuelve un conjunto distinto de estadísticas para los modelos de agrupación en clústeres.

Las estadísticas devueltas para un modelo de agrupación en clústeres describen el número de puntos de datos que se han asignado a cada clúster, la cantidad de separación entre clústeres y cómo de estrechamente están agrupados los puntos de datos dentro de cada clúster.

El promedio de las estadísticas del modelo de agrupación en clústeres se realiza en todo el conjunto de datos, con filas adicionales que contienen las estadísticas por clúster.

Por ejemplo, los siguientes resultados muestran una parte de los resultados de un experimento de ejemplo que agrupa los datos en el conjunto de datos de clasificación binaria de diabetes india PIMA, que está disponible en Machine Learning Studio (clásico).

| Descripción del resultado | Distancia media al centro de clústeres | Distancia media a otro centro | Número de puntos | Distancia máxima al centro de clústeres |

|---|---|---|---|---|

| Evaluación combinada | 55.915068 | 169.897505 | 538 | 303.545166 |

| Evaluación del clúster No.0 | 0 | 1 | 570 | 0 |

| Evaluación del clúster No.1 | 0 | 1 | 178 | 0 |

| Evaluación del clúster No.2 | 0 | 1 | 178 | 0 |

A partir de estos resultados, obtendrá la siguiente información:

El módulo De agrupación en clústeres de barrido crea varios modelos de agrupación en clústeres, enumerados en orden de precisión. Por motivos de simplicidad, aquí solo hemos mostrado el modelo mejor clasificado. Los modelos se miden con todas las métricas posibles, pero los modelos se clasifican mediante la métrica que especificó. Si ha cambiado la métrica, es posible que un modelo diferente se clasifique más alto.

La puntuación evaluación combinada en la parte superior de cada sección de resultados muestra las puntuaciones medias de los clústeres creados en ese modelo en particular.

Este modelo de clasificación superior se produjo para crear tres clústeres; Otros modelos pueden crear dos clústeres o cuatro clústeres. Por lo tanto, esta puntuación de evaluación combinada le ayuda a comparar modelos con un número diferente de clústeres.

Las puntuaciones de la columna Average Distance to Cluster Center (Distancia media al centro del clúster) representan la cercanía de todos los puntos del clúster al centroide de ese clúster.

Las puntuaciones de la columna Average Distance to Other Center (Distancia media a otro centro) representan la cercanía, como media, de cada punto del clúster a los centroides de todos los demás clústeres.

Puede elegir cualquiera de las cuatro métricas para medir esta distancia, pero todas las medidas deben usar la misma métrica.

La columna Number of Points (Número de puntos) muestra cuántos puntos de datos se han asignado a cada clúster, junto con el número total de puntos de datos en cualquier clúster.

Si el número de puntos de datos asignado a los clústeres es menor que el número total de puntos de datos disponibles, significa que no se han podido asignar los puntos de datos a un clúster.

Las puntuaciones de la columna Maximal Distance to Cluster Center (Distancia máxima al centro del clúster) representan la suma de las distancias entre cada punto y el centroide del clúster de ese punto.

Si este número es alto, puede significar que el clúster está muy disperso. Debe revisar esta estadística junto con Average Distance to Cluster Center (Distancia media al centro del clúster) para determinar la dispersión del clúster.

Ejemplos

Para obtener ejemplos de cómo generar, visualizar e interpretar métricas de evaluación, consulte estos experimentos de ejemplo en la Galería de Azure AI. Estos experimentos muestran cómo crear varios modelos y usar Evaluar modelo para determinar qué modelo es el mejor.

Comparar clasificadores binarios: explica cómo comparar el rendimiento de diferentes clasificadores que se crearon con los mismos datos.

Comparar clasificadores de varias clases: muestra cómo comparar la precisión de los diferentes modelos de clasificación que se crearon en el conjunto de datos de reconocimiento de letras.

Comparar regresores: le guía por el proceso de evaluación de diferentes modelos de regresión.

Estimación de demanda: aprenda a combinar métricas de evaluación de varios modelos.

Predicción de relaciones con el cliente: muestra cómo evaluar varios modelos relacionados.

Entradas esperadas

| Nombre | Tipo | Descripción |

|---|---|---|

| Conjunto de datos puntuado | Tabla de datos | Conjunto de datos puntuado |

| Conjunto de datos puntuado para comparar | Tabla de datos | Conjunto de datos puntuado para comparar (opcional) |

Salidas

| Nombre | Tipo | Descripción |

|---|---|---|

| Evaluation results | Tabla de datos | Resultado de la evaluación de datos |

Excepciones

| Excepción | Descripción |

|---|---|

| Error 0003 | Se produce una excepción si una o varias de las entradas son NULL o están vacías. |

| Error 0013 | Se produce una excepción si se pasa un aprendiz de módulo con un tipo no válido. |

| Error 0020 | Se produce una excepción si en algunos de los conjuntos de datos que se pasan al módulo el número de columnas es demasiado pequeño. |

| Error 0021 | Se produce una excepción si el número de filas en algunos de los conjuntos de datos que se pasan al módulo es demasiado pequeño. |

| Error 0024 | Se produce una excepción si el conjunto de datos no contiene una columna de etiqueta. |

| Error 0025 | Se produce una excepción si el conjunto de datos no contiene una columna de puntuación. |

Consulte también

Modelo de validación cruzada

Evaluate Recommender (Evaluar recomendador)

Evaluate

Score Model (puntuar modelo)