Ejemplos de código de Azure Blob Storage mediante bibliotecas cliente de .NET versión 11.x

En este artículo, se muestran ejemplos de código que usan la versión 11.x de la biblioteca cliente de Azure Blob Storage para .NET.

El 31 de marzo de 2023, se retiró el soporte técnico para las bibliotecas del SDK de Azure que no cumplen las directrices actuales del SDK de Azure. Las nuevas bibliotecas del SDK de Azure se actualizan periódicamente para impulsar experiencias coherentes y reforzar la posición de seguridad. Se recomienda realizar la transición a las nuevas bibliotecas del SDK de Azure para aprovechar las nuevas funcionalidades y las actualizaciones de seguridad críticas.

Aunque las bibliotecas anteriores todavía se pueden usar más allá del 31 de marzo de 2023, ya no recibirán soporte técnico oficial ni actualizaciones de Microsoft. Para obtener más información, consulte el anuncio de retirada de soporte técnico.

Crear una instantánea

Artículo relacionado: Creación y administración de una instantánea de blob en .NET

Para crear una instantánea de un blob en bloques con la versión 11.x de la biblioteca de cliente de Azure Storage para .NET, use uno de los métodos siguientes:

En el ejemplo de código siguiente se muestra cómo crear una instantánea con la versión 11.x. En este ejemplo se especifican metadatos adicionales para la instantánea cuando se crea.

private static async Task CreateBlockBlobSnapshot(CloudBlobContainer container)

{

// Create a new block blob in the container.

CloudBlockBlob baseBlob = container.GetBlockBlobReference("sample-base-blob.txt");

// Add blob metadata.

baseBlob.Metadata.Add("ApproxBlobCreatedDate", DateTime.UtcNow.ToString());

try

{

// Upload the blob to create it, with its metadata.

await baseBlob.UploadTextAsync(string.Format("Base blob: {0}", baseBlob.Uri.ToString()));

// Sleep 5 seconds.

System.Threading.Thread.Sleep(5000);

// Create a snapshot of the base blob.

// You can specify metadata at the time that the snapshot is created.

// If no metadata is specified, then the blob's metadata is copied to the snapshot.

Dictionary<string, string> metadata = new Dictionary<string, string>();

metadata.Add("ApproxSnapshotCreatedDate", DateTime.UtcNow.ToString());

await baseBlob.CreateSnapshotAsync(metadata, null, null, null);

Console.WriteLine(snapshot.SnapshotQualifiedStorageUri.PrimaryUri);

}

catch (StorageException e)

{

Console.WriteLine(e.Message);

Console.ReadLine();

throw;

}

}

Eliminar instantáneas

Artículo relacionado: Creación y administración de una instantánea de blob en .NET

Para eliminar un blob y sus instantáneas con la versión 11.x de la biblioteca de cliente de Azure Storage para .NET, use uno de los métodos de eliminación de blobs siguientes e incluya la enumeración DeleteSnapshotsOption:

En el ejemplo de código siguiente se muestra cómo eliminar un blob y sus instantáneas en. NET, donde blockBlob es un objeto del tipo [CloudBlockBlob][dotnet_CloudBlockBlob]:

await blockBlob.DeleteIfExistsAsync(DeleteSnapshotsOption.IncludeSnapshots, null, null, null);

Crear una directiva de acceso almacenada

Artículo relacionado: Creación de una directiva de acceso almacenada con .NET

Para crear una directiva de acceso almacenada en un contenedor con la versión 11.x de la biblioteca cliente de .NET para Azure Storage, llame a uno de los métodos siguientes:

En el ejemplo siguiente se crea una directiva de acceso almacenada que está en vigor durante un día y que concede permisos de lectura, escritura y enumeración:

private static async Task CreateStoredAccessPolicyAsync(CloudBlobContainer container, string policyName)

{

// Create a new stored access policy and define its constraints.

// The access policy provides create, write, read, list, and delete permissions.

SharedAccessBlobPolicy sharedPolicy = new SharedAccessBlobPolicy()

{

// When the start time for the SAS is omitted, the start time is assumed to be the time when Azure Storage receives the request.

SharedAccessExpiryTime = DateTime.UtcNow.AddHours(24),

Permissions = SharedAccessBlobPermissions.Read | SharedAccessBlobPermissions.List |

SharedAccessBlobPermissions.Write

};

// Get the container's existing permissions.

BlobContainerPermissions permissions = await container.GetPermissionsAsync();

// Add the new policy to the container's permissions, and set the container's permissions.

permissions.SharedAccessPolicies.Add(policyName, sharedPolicy);

await container.SetPermissionsAsync(permissions);

}

Creación de una SAS de servicio para un contenedor de blob

Creación de una SAS de servicio para un contenedor o blob con .NET

Para crear una SAS de servicio para un contenedor, llame al método CloudBlobContainer.GetSharedAccessSignature.

private static string GetContainerSasUri(CloudBlobContainer container,

string storedPolicyName = null)

{

string sasContainerToken;

// If no stored policy is specified, create a new access policy and define its constraints.

if (storedPolicyName == null)

{

// Note that the SharedAccessBlobPolicy class is used both to define

// the parameters of an ad hoc SAS, and to construct a shared access policy

// that is saved to the container's shared access policies.

SharedAccessBlobPolicy adHocPolicy = new SharedAccessBlobPolicy()

{

// When the start time for the SAS is omitted, the start time is assumed

// to be the time when the storage service receives the request. Omitting

// the start time for a SAS that is effective immediately helps to avoid clock skew.

SharedAccessExpiryTime = DateTime.UtcNow.AddHours(24),

Permissions = SharedAccessBlobPermissions.Write | SharedAccessBlobPermissions.List

};

// Generate the shared access signature on the container,

// setting the constraints directly on the signature.

sasContainerToken = container.GetSharedAccessSignature(adHocPolicy, null);

Console.WriteLine("SAS for blob container (ad hoc): {0}", sasContainerToken);

Console.WriteLine();

}

else

{

// Generate the shared access signature on the container. In this case,

// all of the constraints for the shared access signature are specified

// on the stored access policy, which is provided by name. It is also possible

// to specify some constraints on an ad hoc SAS and others on the stored access policy.

sasContainerToken = container.GetSharedAccessSignature(null, storedPolicyName);

Console.WriteLine("SAS for container (stored access policy): {0}", sasContainerToken);

Console.WriteLine();

}

// Return the URI string for the container, including the SAS token.

return container.Uri + sasContainerToken;

}

Creación de una SAS de servicio para un blob

Creación de una SAS de servicio para un contenedor o blob con .NET

Para crear una SAS de servicio para un blob, llame al método CloudBlob.GetSharedAccessSignature.

private static string GetBlobSasUri(CloudBlobContainer container,

string blobName,

string policyName = null)

{

string sasBlobToken;

// Get a reference to a blob within the container.

// Note that the blob may not exist yet, but a SAS can still be created for it.

CloudBlockBlob blob = container.GetBlockBlobReference(blobName);

if (policyName == null)

{

// Create a new access policy and define its constraints.

// Note that the SharedAccessBlobPolicy class is used both to define the parameters

// of an ad hoc SAS, and to construct a shared access policy that is saved to

// the container's shared access policies.

SharedAccessBlobPolicy adHocSAS = new SharedAccessBlobPolicy()

{

// When the start time for the SAS is omitted, the start time is assumed to be

// the time when the storage service receives the request. Omitting the start time

// for a SAS that is effective immediately helps to avoid clock skew.

SharedAccessExpiryTime = DateTime.UtcNow.AddHours(24),

Permissions = SharedAccessBlobPermissions.Read |

SharedAccessBlobPermissions.Write |

SharedAccessBlobPermissions.Create

};

// Generate the shared access signature on the blob,

// setting the constraints directly on the signature.

sasBlobToken = blob.GetSharedAccessSignature(adHocSAS);

Console.WriteLine("SAS for blob (ad hoc): {0}", sasBlobToken);

Console.WriteLine();

}

else

{

// Generate the shared access signature on the blob. In this case, all of the constraints

// for the SAS are specified on the container's stored access policy.

sasBlobToken = blob.GetSharedAccessSignature(null, policyName);

Console.WriteLine("SAS for blob (stored access policy): {0}", sasBlobToken);

Console.WriteLine();

}

// Return the URI string for the container, including the SAS token.

return blob.Uri + sasBlobToken;

}

Creación de una SAS de cuenta

Artículo relacionado: Creación de una SAS de cuenta con .NET

Para crear una SAS de cuenta para un contenedor, llame al método CloudStorageAccount.GetSharedAccessSignature.

En el ejemplo de código siguiente se crea una SAS de cuenta que es válida para los servicios Blob y Archivo y da al cliente permisos de lectura, escritura y lista para acceder a las API de nivel de servicio. La SAS de cuenta restringe el protocolo a HTTPS, por lo que la solicitud se debe realizar con HTTPS. No olvide reemplazar los valores del marcador de posición entre corchetes angulares por sus propios valores:

static string GetAccountSASToken()

{

// To create the account SAS, you need to use Shared Key credentials. Modify for your account.

const string ConnectionString = "DefaultEndpointsProtocol=https;AccountName=<storage-account>;AccountKey=<account-key>";

CloudStorageAccount storageAccount = CloudStorageAccount.Parse(ConnectionString);

// Create a new access policy for the account.

SharedAccessAccountPolicy policy = new SharedAccessAccountPolicy()

{

Permissions = SharedAccessAccountPermissions.Read |

SharedAccessAccountPermissions.Write |

SharedAccessAccountPermissions.List,

Services = SharedAccessAccountServices.Blob | SharedAccessAccountServices.File,

ResourceTypes = SharedAccessAccountResourceTypes.Service,

SharedAccessExpiryTime = DateTime.UtcNow.AddHours(24),

Protocols = SharedAccessProtocol.HttpsOnly

};

// Return the SAS token.

return storageAccount.GetSharedAccessSignature(policy);

}

Uso de una SAS de cuenta desde un cliente

Artículo relacionado: Creación de una SAS de cuenta con .NET

En este fragmento de código, reemplace el marcador de posición <storage-account> por el nombre de la cuenta de almacenamiento.

static void UseAccountSAS(string sasToken)

{

// Create new storage credentials using the SAS token.

StorageCredentials accountSAS = new StorageCredentials(sasToken);

// Use these credentials and the account name to create a Blob service client.

CloudStorageAccount accountWithSAS = new CloudStorageAccount(accountSAS, "<storage-account>", endpointSuffix: null, useHttps: true);

CloudBlobClient blobClientWithSAS = accountWithSAS.CreateCloudBlobClient();

// Now set the service properties for the Blob client created with the SAS.

blobClientWithSAS.SetServiceProperties(new ServiceProperties()

{

HourMetrics = new MetricsProperties()

{

MetricsLevel = MetricsLevel.ServiceAndApi,

RetentionDays = 7,

Version = "1.0"

},

MinuteMetrics = new MetricsProperties()

{

MetricsLevel = MetricsLevel.ServiceAndApi,

RetentionDays = 7,

Version = "1.0"

},

Logging = new LoggingProperties()

{

LoggingOperations = LoggingOperations.All,

RetentionDays = 14,

Version = "1.0"

}

});

// The permissions granted by the account SAS also permit you to retrieve service properties.

ServiceProperties serviceProperties = blobClientWithSAS.GetServiceProperties();

Console.WriteLine(serviceProperties.HourMetrics.MetricsLevel);

Console.WriteLine(serviceProperties.HourMetrics.RetentionDays);

Console.WriteLine(serviceProperties.HourMetrics.Version);

}

Simultaneidad optimista para blobs

Artículo relacionado: Administración de la simultaneidad en Blob Storage

public void DemonstrateOptimisticConcurrencyBlob(string containerName, string blobName)

{

Console.WriteLine("Demonstrate optimistic concurrency");

// Parse connection string and create container.

CloudStorageAccount storageAccount = CloudStorageAccount.Parse(ConnectionString);

CloudBlobClient blobClient = storageAccount.CreateCloudBlobClient();

CloudBlobContainer container = blobClient.GetContainerReference(containerName);

container.CreateIfNotExists();

// Create test blob. The default strategy is last writer wins, so

// write operation will overwrite existing blob if present.

CloudBlockBlob blockBlob = container.GetBlockBlobReference(blobName);

blockBlob.UploadText("Hello World!");

// Retrieve the ETag from the newly created blob.

string originalETag = blockBlob.Properties.ETag;

Console.WriteLine("Blob added. Original ETag = {0}", originalETag);

/// This code simulates an update by another client.

string helloText = "Blob updated by another client.";

// No ETag was provided, so original blob is overwritten and ETag updated.

blockBlob.UploadText(helloText);

Console.WriteLine("Blob updated. Updated ETag = {0}", blockBlob.Properties.ETag);

// Now try to update the blob using the original ETag value.

try

{

Console.WriteLine(@"Attempt to update blob using original ETag

to generate if-match access condition");

blockBlob.UploadText(helloText, accessCondition: AccessCondition.GenerateIfMatchCondition(originalETag));

}

catch (StorageException ex)

{

if (ex.RequestInformation.HttpStatusCode == (int)HttpStatusCode.PreconditionFailed)

{

Console.WriteLine(@"Precondition failure as expected.

Blob's ETag does not match.");

}

else

{

throw;

}

}

Console.WriteLine();

}

Simultaneidad pesimista para blobs

Artículo relacionado: Administración de la simultaneidad en Blob Storage

public void DemonstratePessimisticConcurrencyBlob(string containerName, string blobName)

{

Console.WriteLine("Demonstrate pessimistic concurrency");

// Parse connection string and create container.

CloudStorageAccount storageAccount = CloudStorageAccount.Parse(ConnectionString);

CloudBlobClient blobClient = storageAccount.CreateCloudBlobClient();

CloudBlobContainer container = blobClient.GetContainerReference(containerName);

container.CreateIfNotExists();

CloudBlockBlob blockBlob = container.GetBlockBlobReference(blobName);

blockBlob.UploadText("Hello World!");

Console.WriteLine("Blob added.");

// Acquire lease for 15 seconds.

string lease = blockBlob.AcquireLease(TimeSpan.FromSeconds(15), null);

Console.WriteLine("Blob lease acquired. Lease = {0}", lease);

// Update blob using lease. This operation should succeed.

const string helloText = "Blob updated";

var accessCondition = AccessCondition.GenerateLeaseCondition(lease);

blockBlob.UploadText(helloText, accessCondition: accessCondition);

Console.WriteLine("Blob updated using an exclusive lease");

// Simulate another client attempting to update to blob without providing lease.

try

{

// Operation will fail as no valid lease was provided.

Console.WriteLine("Now try to update blob without valid lease.");

blockBlob.UploadText("Update operation will fail without lease.");

}

catch (StorageException ex)

{

if (ex.RequestInformation.HttpStatusCode == (int)HttpStatusCode.PreconditionFailed)

{

Console.WriteLine(@"Precondition failure error as expected.

Blob lease not provided.");

}

else

{

throw;

}

}

// Release lease proactively.

blockBlob.ReleaseLease(accessCondition);

Console.WriteLine();

}

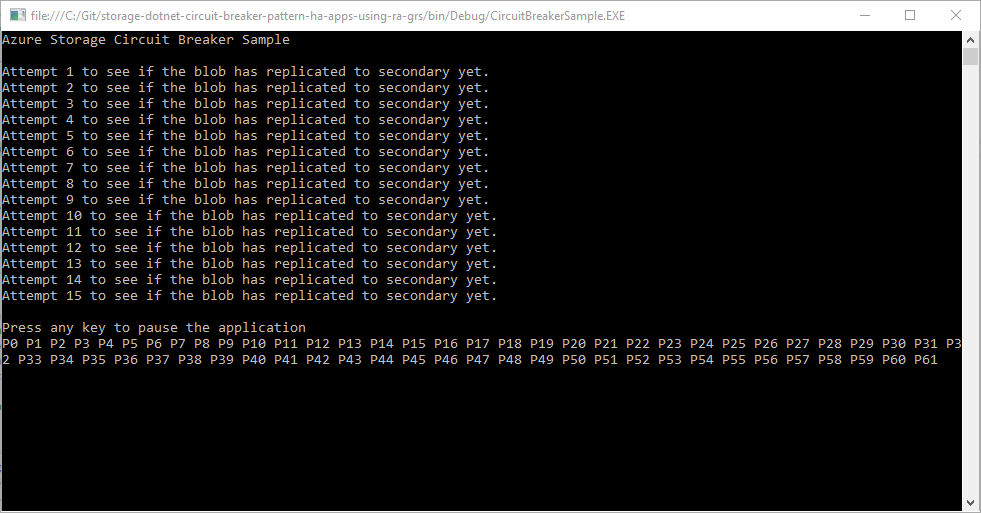

Creación de una aplicación de alta disponibilidad con Blob Storage

Artículo relacionado: Tutorial: Creación de una aplicación de alta disponibilidad con Blob Storage.

Descarga del ejemplo

Descargue el proyecto de ejemplo, extraiga (descomprima) el archivo storage-dotnet-circuit-breaker-pattern-ha-apps-using-ra-grs.zip y vaya a la carpeta v11 para buscar los archivos del proyecto.

También puede usar git para descargar una copia de la aplicación en el entorno de desarrollo. El proyecto de ejemplo de la carpeta v11 contiene una aplicación de consola.

git clone https://github.com/Azure-Samples/storage-dotnet-circuit-breaker-pattern-ha-apps-using-ra-grs.git

Configuración del ejemplo

En la aplicación, debe proporcionar la cadena de conexión para la cuenta de almacenamiento. Esta cadena de conexión se puede almacenar en una variable de entorno de la máquina local que ejecuta la aplicación. Siga uno de los estos ejemplos dependiendo de su sistema operativo para crear la variable de entorno.

En Azure Portal, vaya a la cuenta de almacenamiento. Seleccione Claves de acceso en Configuración, en su cuenta de almacenamiento. Copie la cadena de conexión de la clave principal o secundaria. Reemplace <yourconnectionstring> por la cadena de conexión real para ejecutar uno de los siguientes comandos en función de su sistema operativo. Este comando guarda una variable de entorno en la máquina local. En Windows, la variable de entorno no está disponible hasta que vuelve a cargar el símbolo del sistema o el shell que usa.

Ejecución de la aplicación de consola

En Visual Studio, presione F5 o seleccione Iniciar para iniciar la depuración de la aplicación. Visual Studio restaura automáticamente los paquetes NuGet que falten si se ha configurado la restauración de paquetes. Consulte Instalación y reinstalación de paquetes con la restauración de paquetes para más información.

Se inicia una ventana en la consola y la aplicación comienza a ejecutarse. La aplicación carga la imagen HelloWorld.png de la solución en la cuenta de almacenamiento. La aplicación hace comprobaciones para garantizar que la imagen se haya replicado en el punto de conexión secundario con RA-GZRS. A continuación, comienza la descarga de la imagen hasta 999 veces. Cada lectura se representa con una P o una S. Donde P representa el punto de conexión principal y S, el secundario.

En el código de ejemplo, la tarea RunCircuitBreakerAsync del archivo Program.cs se usa para descargar una imagen de la cuenta de almacenamiento con el método DownloadToFileAsync. Antes de la descarga, se define OperationContext. El contexto de operación define los controladores de eventos, que se activan cuando una descarga se completa correctamente o si se produce un error de descarga y se vuelve a intentar.

Descripción del código de ejemplo

Controlador de eventos de reintento

El controlador de eventos OperationContextRetrying se llama cuando se produce un error de descarga de la imagen y se ha establecido el reintento. Si se alcanza el máximo de reintentos definido en la aplicación, el valor LocationMode de la solicitud cambia a SecondaryOnly. Esta opción obliga a la aplicación a intentar la descarga de la imagen desde el punto de conexión secundario. Esta configuración reduce el tiempo necesario para solicitar la imagen, ya que no se reintenta siempre con el punto de conexión principal.

private static void OperationContextRetrying(object sender, RequestEventArgs e)

{

retryCount++;

Console.WriteLine("Retrying event because of failure reading the primary. RetryCount = " + retryCount);

// Check if we have had more than n retries in which case switch to secondary.

if (retryCount >= retryThreshold)

{

// Check to see if we can fail over to secondary.

if (blobClient.DefaultRequestOptions.LocationMode != LocationMode.SecondaryOnly)

{

blobClient.DefaultRequestOptions.LocationMode = LocationMode.SecondaryOnly;

retryCount = 0;

}

else

{

throw new ApplicationException("Both primary and secondary are unreachable. Check your application's network connection. ");

}

}

}

Controlador de eventos de solicitud completada

El controlador de eventos OperationContextRequestCompleted se llama cuando la descarga de la imagen es correcta. Si la aplicación utiliza el punto de conexión secundario, continuará usándolo hasta 20 veces. Después de 20 veces, la aplicación establece LocationMode en PrimaryThenSecondary de nuevo y vuelve a probar con el punto de conexión principal. Si la solicitud se realiza correctamente, la aplicación continúa leyendo desde el punto de conexión principal.

private static void OperationContextRequestCompleted(object sender, RequestEventArgs e)

{

if (blobClient.DefaultRequestOptions.LocationMode == LocationMode.SecondaryOnly)

{

// You're reading the secondary. Let it read the secondary [secondaryThreshold] times,

// then switch back to the primary and see if it's available now.

secondaryReadCount++;

if (secondaryReadCount >= secondaryThreshold)

{

blobClient.DefaultRequestOptions.LocationMode = LocationMode.PrimaryThenSecondary;

secondaryReadCount = 0;

}

}

}

Descarga de grandes cantidades de datos aleatorios desde Azure Storage

Artículo relacionado: Carga de grandes cantidades de datos aleatorios en paralelo en Azure Storage

Los números mínimo y máximo de subprocesos se establecen en 100 para garantizar que se permite un gran número de conexiones simultáneas.

private static async Task UploadFilesAsync()

{

// Create five randomly named containers to store the uploaded files.

CloudBlobContainer[] containers = await GetRandomContainersAsync();

var currentdir = System.IO.Directory.GetCurrentDirectory();

// Path to the directory to upload

string uploadPath = currentdir + "\\upload";

// Start a timer to measure how long it takes to upload all the files.

Stopwatch time = Stopwatch.StartNew();

try

{

Console.WriteLine("Iterating in directory: {0}", uploadPath);

int count = 0;

int max_outstanding = 100;

int completed_count = 0;

// Define the BlobRequestOptions on the upload.

// This includes defining an exponential retry policy to ensure that failed connections

// are retried with a back off policy. As multiple large files are being uploaded using

// large block sizes, this can cause an issue if an exponential retry policy is not defined.

// Additionally, parallel operations are enabled with a thread count of 8.

// This should be a multiple of the number of processor cores in the machine.

// Lastly, MD5 hash validation is disabled for this example, improving the upload speed.

BlobRequestOptions options = new BlobRequestOptions

{

ParallelOperationThreadCount = 8,

DisableContentMD5Validation = true,

StoreBlobContentMD5 = false

};

// Create a new instance of the SemaphoreSlim class to

// define the number of threads to use in the application.

SemaphoreSlim sem = new SemaphoreSlim(max_outstanding, max_outstanding);

List<Task> tasks = new List<Task>();

Console.WriteLine("Found {0} file(s)", Directory.GetFiles(uploadPath).Count());

// Iterate through the files

foreach (string path in Directory.GetFiles(uploadPath))

{

var container = containers[count % 5];

string fileName = Path.GetFileName(path);

Console.WriteLine("Uploading {0} to container {1}", path, container.Name);

CloudBlockBlob blockBlob = container.GetBlockBlobReference(fileName);

// Set the block size to 100MB.

blockBlob.StreamWriteSizeInBytes = 100 * 1024 * 1024;

await sem.WaitAsync();

// Create a task for each file to upload. The tasks are

// added to a collection and all run asynchronously.

tasks.Add(blockBlob.UploadFromFileAsync(path, null, options, null).ContinueWith((t) =>

{

sem.Release();

Interlocked.Increment(ref completed_count);

}));

count++;

}

// Run all the tasks asynchronously.

await Task.WhenAll(tasks);

time.Stop();

Console.WriteLine("Upload has been completed in {0} seconds. Press any key to continue", time.Elapsed.TotalSeconds.ToString());

Console.ReadLine();

}

catch (DirectoryNotFoundException ex)

{

Console.WriteLine("Error parsing files in the directory: {0}", ex.Message);

}

catch (Exception ex)

{

Console.WriteLine(ex.Message);

}

}

Además de establecer la configuración del límite de subprocesos y de conexiones, la clase BlobRequestOptions del método UploadFromStreamAsync está configurada para usar el paralelismo y deshabilitar la validación de hash MD5. Los archivos se cargan en bloques de 100 MB. Esta configuración proporciona un mejor rendimiento, pero puede aumentar el costo si se usa una red con un rendimiento deficiente, ya que si se produce un error, se reintenta todo el bloque de 100 MB.

| Propiedad | Value | Descripción |

|---|---|---|

| ParallelOperationThreadCount | 8 | La configuración divide el blob en bloques al realizar la carga. Para conseguir el máximo rendimiento, este valor debe ser 8 veces el número de núcleos. |

| DisableContentMD5Validation | true | Esta propiedad deshabilita la función de comprobación del hash MD5 del contenido cargado. Al deshabilitar la validación de MD5, se agiliza la transferencia. Aún así, hay que tener en cuenta que no se puede confirmar la validez o integridad de los archivos que se transfieren. |

| StoreBlobContentMD5 | false | Esta propiedad determina si se calcula y almacena un hash MD5 con el archivo. |

| RetryPolicy | Retroceso de 2 segundos con 10 reintentos como máximo | Determina la directiva de reintentos de las solicitudes. Los errores de conexión se reintentan y, en este ejemplo, una directiva ExponentialRetry está configurada con un retroceso de 2 segundos y un número máximo de reintentos de 10. Esta configuración es importante cuando la aplicación se acerca a los objetivos de escalabilidad y rendimiento de Blob Storage. Para más información, consulte Objetivos de escalabilidad y rendimiento de Blob Storage. |

Descargar grandes cantidades de datos aleatorios desde Azure Storage

Artículo relacionado: Descarga de grandes cantidades de datos aleatorios desde Azure Storage

La aplicación lee los contenedores que se encuentran en la cuenta de almacenamiento especificada en storageconnectionstring. Recorre en iteración 10 blobs cada vez mediante el método ListBlobsSegmentedAsync de los contenedores y los descarga en la máquina local mediante el método DownloadToFileAsync.

En la siguiente tabla se muestran la clases BlobRequestOptions definidas para cada blob al descargarse.

| Propiedad | Value | Descripción |

|---|---|---|

| DisableContentMD5Validation | true | Esta propiedad deshabilita la función de comprobación del hash MD5 del contenido cargado. Al deshabilitar la validación de MD5, se agiliza la transferencia. Aún así, hay que tener en cuenta que no se puede confirmar la validez o integridad de los archivos que se transfieren. |

| StoreBlobContentMD5 | false | Esta propiedad determina si se calcula y almacena un hash MD5. |

private static async Task DownloadFilesAsync()

{

CloudBlobClient blobClient = GetCloudBlobClient();

// Define the BlobRequestOptions on the download, including disabling MD5

// hash validation for this example, this improves the download speed.

BlobRequestOptions options = new BlobRequestOptions

{

DisableContentMD5Validation = true,

StoreBlobContentMD5 = false

};

// Retrieve the list of containers in the storage account.

// Create a directory and configure variables for use later.

BlobContinuationToken continuationToken = null;

List<CloudBlobContainer> containers = new List<CloudBlobContainer>();

do

{

var listingResult = await blobClient.ListContainersSegmentedAsync(continuationToken);

continuationToken = listingResult.ContinuationToken;

containers.AddRange(listingResult.Results);

}

while (continuationToken != null);

var directory = Directory.CreateDirectory("download");

BlobResultSegment resultSegment = null;

Stopwatch time = Stopwatch.StartNew();

// Download the blobs

try

{

List<Task> tasks = new List<Task>();

int max_outstanding = 100;

int completed_count = 0;

// Create a new instance of the SemaphoreSlim class to

// define the number of threads to use in the application.

SemaphoreSlim sem = new SemaphoreSlim(max_outstanding, max_outstanding);

// Iterate through the containers

foreach (CloudBlobContainer container in containers)

{

do

{

// Return the blobs from the container, 10 at a time.

resultSegment = await container.ListBlobsSegmentedAsync(null, true, BlobListingDetails.All, 10, continuationToken, null, null);

continuationToken = resultSegment.ContinuationToken;

{

foreach (var blobItem in resultSegment.Results)

{

if (((CloudBlob)blobItem).Properties.BlobType == BlobType.BlockBlob)

{

// Get the blob and add a task to download the blob asynchronously from the storage account.

CloudBlockBlob blockBlob = container.GetBlockBlobReference(((CloudBlockBlob)blobItem).Name);

Console.WriteLine("Downloading {0} from container {1}", blockBlob.Name, container.Name);

await sem.WaitAsync();

tasks.Add(blockBlob.DownloadToFileAsync(directory.FullName + "\\" + blockBlob.Name, FileMode.Create, null, options, null).ContinueWith((t) =>

{

sem.Release();

Interlocked.Increment(ref completed_count);

}));

}

}

}

}

while (continuationToken != null);

}

// Creates an asynchronous task that completes when all the downloads complete.

await Task.WhenAll(tasks);

}

catch (Exception e)

{

Console.WriteLine("\nError encountered during transfer: {0}", e.Message);

}

time.Stop();

Console.WriteLine("Download has been completed in {0} seconds. Press any key to continue", time.Elapsed.TotalSeconds.ToString());

Console.ReadLine();

}

Habilitar los registros de Azure Storage Analytics (clásico)

Artículo relacionado: Habilitación y administración de los registros de Azure Storage Analytics (clásico)

var storageAccount = CloudStorageAccount.Parse(connStr);

var queueClient = storageAccount.CreateCloudQueueClient();

var serviceProperties = queueClient.GetServiceProperties();

serviceProperties.Logging.LoggingOperations = LoggingOperations.All;

serviceProperties.Logging.RetentionDays = 2;

queueClient.SetServiceProperties(serviceProperties);

Modificación del período de retención de los datos de registro

Artículo relacionado: Habilitación y administración de los registros de Azure Storage Analytics (clásico)

En el ejemplo siguiente, se imprime en la consola el período de retención para los servicios de almacenamiento de blobs y colas.

var storageAccount = CloudStorageAccount.Parse(connectionString);

var blobClient = storageAccount.CreateCloudBlobClient();

var queueClient = storageAccount.CreateCloudQueueClient();

var blobserviceProperties = blobClient.GetServiceProperties();

var queueserviceProperties = queueClient.GetServiceProperties();

Console.WriteLine("Retention period for logs from the blob service is: " +

blobserviceProperties.Logging.RetentionDays.ToString());

Console.WriteLine("Retention period for logs from the queue service is: " +

queueserviceProperties.Logging.RetentionDays.ToString());

En el ejemplo siguiente, se cambia el período de retención de los registros para los servicios de almacenamiento de blobs y colas a 4 días.

blobserviceProperties.Logging.RetentionDays = 4;

queueserviceProperties.Logging.RetentionDays = 4;

blobClient.SetServiceProperties(blobserviceProperties);

queueClient.SetServiceProperties(queueserviceProperties);

Habilitar las métricas de Azure Storage Analytics (clásico)

Artículo relacionado: Habilitación y administración de las métricas de Azure Storage Analytics (clásico)

var storageAccount = CloudStorageAccount.Parse(connStr);

var queueClient = storageAccount.CreateCloudQueueClient();

var serviceProperties = queueClient.GetServiceProperties();

serviceProperties.HourMetrics.MetricsLevel = MetricsLevel.Service;

serviceProperties.HourMetrics.RetentionDays = 10;

queueClient.SetServiceProperties(serviceProperties);

Configuración de Seguridad de la capa de transporte (TLS) para una aplicación cliente

Artículo relacionado: Configuración de Seguridad de la capa de transporte (TLS) para una aplicación cliente

En el ejemplo siguiente, se muestra cómo habilitar TLS 1.2 en un cliente .NET con la versión 11.x de la biblioteca cliente de Azure Storage:

static void EnableTls12()

{

// Enable TLS 1.2 before connecting to Azure Storage

System.Net.ServicePointManager.SecurityProtocol = System.Net.SecurityProtocolType.Tls12;

// Add your connection string here.

string connectionString = "";

// Connect to Azure Storage and create a new container.

CloudStorageAccount storageAccount = CloudStorageAccount.Parse(connectionString);

CloudBlobClient blobClient = storageAccount.CreateCloudBlobClient();

CloudBlobContainer container = blobClient.GetContainerReference("sample-container");

container.CreateIfNotExists();

}

Supervisión, diagnóstico y solución de problemas de Microsoft Azure Storage (clásicos)

Artículo relacionado: Supervisión, diagnóstico y solución de problemas de Microsoft Azure Storage (clásico)

Si la biblioteca de cliente de Almacenamiento inicia una StorageException en el cliente, la propiedad RequestInformation contendrá un objeto RequestResult que incluirá una propiedad ServiceRequestID. También puede acceder a los objetos RequestResult desde una instancia de OperationContext.

El ejemplo de código siguiente muestra cómo establecer un valor de ClientRequestId personalizado adjuntando un objeto OperationContext a la solicitud que se realiza al servicio de almacenamiento. También muestra cómo recuperar el valor de ServerRequestId a partir del mensaje de respuesta.

//Parse the connection string for the storage account.

const string ConnectionString = "DefaultEndpointsProtocol=https;AccountName=account-name;AccountKey=account-key";

CloudStorageAccount storageAccount = CloudStorageAccount.Parse(ConnectionString);

CloudBlobClient blobClient = storageAccount.CreateCloudBlobClient();

// Create an Operation Context that includes custom ClientRequestId string based on constants defined within the application along with a Guid.

OperationContext oc = new OperationContext();

oc.ClientRequestID = String.Format("{0} {1} {2} {3}", HOSTNAME, APPNAME, USERID, Guid.NewGuid().ToString());

try

{

CloudBlobContainer container = blobClient.GetContainerReference("democontainer");

ICloudBlob blob = container.GetBlobReferenceFromServer("testImage.jpg", null, null, oc);

var downloadToPath = string.Format("./{0}", blob.Name);

using (var fs = File.OpenWrite(downloadToPath))

{

blob.DownloadToStream(fs, null, null, oc);

Console.WriteLine("\t Blob downloaded to file: {0}", downloadToPath);

}

}

catch (StorageException storageException)

{

Console.WriteLine("Storage exception {0} occurred", storageException.Message);

// Multiple results may exist due to client side retry logic - each retried operation will have a unique ServiceRequestId

foreach (var result in oc.RequestResults)

{

Console.WriteLine("HttpStatus: {0}, ServiceRequestId {1}", result.HttpStatusCode, result.ServiceRequestID);

}

}

Investigación de problemas de rendimiento del cliente: deshabilite el algoritmo de Nagle

Artículo relacionado: Supervisión, diagnóstico y solución de problemas de Microsoft Azure Storage (clásico)

var storageAccount = CloudStorageAccount.Parse(connStr);

ServicePoint queueServicePoint = ServicePointManager.FindServicePoint(storageAccount.QueueEndpoint);

queueServicePoint.UseNagleAlgorithm = false;

Investigación de problemas de latencia de red: configuración del uso compartido de recursos entre orígenes (CORS)

Artículo relacionado: Supervisión, diagnóstico y solución de problemas de Microsoft Azure Storage (clásico)

CloudBlobClient client = new CloudBlobClient(blobEndpoint, new StorageCredentials(accountName, accountKey));

// Set the service properties.

ServiceProperties sp = client.GetServiceProperties();

sp.DefaultServiceVersion = "2013-08-15";

CorsRule cr = new CorsRule();

cr.AllowedHeaders.Add("*");

cr.AllowedMethods = CorsHttpMethods.Get | CorsHttpMethods.Put;

cr.AllowedOrigins.Add("http://www.contoso.com");

cr.ExposedHeaders.Add("x-ms-*");

cr.MaxAgeInSeconds = 5;

sp.Cors.CorsRules.Clear();

sp.Cors.CorsRules.Add(cr);

client.SetServiceProperties(sp);

Creación de un blob en páginas vacío de tamaño específico

Artículo relacionado: Introducción a blobs en páginas de Azure

Para crear un blob en páginas, primero debe crear un objeto CloudBlobClient, con el URI base para acceder al almacenamiento de blobs de la cuenta de almacenamiento (pbaccount en la figura 1) junto con el objeto StorageCredentialsAccountAndKey, tal y como se muestra en el ejemplo siguiente. El ejemplo muestra cómo crear una referencia a un objeto CloudBlobContainer y, a continuación, cómo crear el contenedor (testvhds) si aún no existe. A continuación, con el objeto CloudBlobContainer, cree una referencia a un objeto CloudPageBlob especificando el nombre de blob en página (os4.vhd) al que se quiere acceder. Para crear el blob en páginas, llame a CloudPageBlob.Create pasando el tamaño máximo del blob que se va a crear. blobSize debe ser un múltiplo de 512 bytes.

using Microsoft.Azure;

using Microsoft.Azure.Storage;

using Microsoft.Azure.Storage.Blob;

long OneGigabyteAsBytes = 1024 * 1024 * 1024;

// Retrieve storage account from connection string.

CloudStorageAccount storageAccount = CloudStorageAccount.Parse(

CloudConfigurationManager.GetSetting("StorageConnectionString"));

// Create the blob client.

CloudBlobClient blobClient = storageAccount.CreateCloudBlobClient();

// Retrieve a reference to a container.

CloudBlobContainer container = blobClient.GetContainerReference("testvhds");

// Create the container if it doesn't already exist.

container.CreateIfNotExists();

CloudPageBlob pageBlob = container.GetPageBlobReference("os4.vhd");

pageBlob.Create(16 * OneGigabyteAsBytes);

Cambio del tamaño de un blob en páginas

Artículo relacionado: Introducción a blobs en páginas de Azure

Para cambiar el tamaño de un blob en páginas después de crearlo, use el método Resize. El tamaño solicitado debe ser un múltiplo de 512 bytes.

pageBlob.Resize(32 * OneGigabyteAsBytes);

Escritura de páginas en un blob en páginas

Artículo relacionado: Introducción a blobs en páginas de Azure

Para escribir páginas, use el método CloudPageBlob.WritePages.

pageBlob.WritePages(dataStream, startingOffset);

Lectura de páginas de un blob en páginas

Artículo relacionado: Introducción a blobs en páginas de Azure

Para leer las páginas, use el método CloudPageBlob.DownloadRangeToByteArray para leer un intervalo de bytes desde el blob en páginas.

byte[] buffer = new byte[rangeSize];

pageBlob.DownloadRangeToByteArray(buffer, bufferOffset, pageBlobOffset, rangeSize);

Para determinar qué páginas están respaldadas por datos, use CloudPageBlob.GetPageRanges. A continuación, puede enumerar los intervalos devueltos y descargar los datos de cada intervalo.

IEnumerable<PageRange> pageRanges = pageBlob.GetPageRanges();

foreach (PageRange range in pageRanges)

{

// Calculate the range size

int rangeSize = (int)(range.EndOffset + 1 - range.StartOffset);

byte[] buffer = new byte[rangeSize];

// Read from the correct starting offset in the page blob and

// place the data in the bufferOffset of the buffer byte array

pageBlob.DownloadRangeToByteArray(buffer, bufferOffset, range.StartOffset, rangeSize);

// Then use the buffer for the page range just read

}