Mirada y confirmación

La mirada y la confirmación son un modelo de entrada fundamental que está estrechamente relacionado con la forma en que estamos interactuando con nuestros equipos mediante el mouse: puntero & clic. En esta página, presentamos dos tipos de entrada de mirada (cabeza y mirada) y diferentes tipos de acciones de confirmación. La mirada y la confirmación se consideran un modelo de entrada lejano con manipulación indirecta. Se usa mejor para interactuar con contenido holográfico que está fuera de alcance.

Los auriculares de realidad mixta pueden usar la posición y la orientación de la cabeza del usuario para determinar su vector de dirección de la cabeza. Piense en la mirada como un láser que apunta directamente desde los ojos del usuario. Esto es una aproximación bastante general de dónde mira el usuario. La aplicación puede intersecr este rayo con objetos virtuales o reales y dibujar un cursor en esa ubicación para que el usuario sepa lo que tiene como destino.

Además de la mirada con la cabeza, algunos cascos de realidad mixta, como HoloLens 2, incluyen sistemas de seguimiento ocular que producen un vector de mirada ocular. Esto proporciona una medida específica de adónde mira el usuario. En ambos casos, la mirada representa una señal importante para la intención del usuario. Cuanto mejor pueda interpretar y predecir las acciones previstas del usuario, más satisfacción y rendimiento mejorará el usuario.

A continuación se muestran algunos ejemplos de cómo usted como desarrollador de realidad mixta puede beneficiarse de la mirada con la cabeza o los ojos:

- La aplicación puede intersectar la mirada con los hologramas de la escena para determinar dónde está la atención del usuario (más precisa con la mirada con los ojos).

- La aplicación puede canalizar gestos y presionar el controlador en función de la mirada del usuario, lo que permite al usuario seleccionar, activar, agarrar, desplazarse o interactuar de otro modo con sus hologramas.

- La aplicación puede permitir que el usuario coloque hologramas en superficies reales mediante la intersección de sus rayos de mirada con la malla de asignación espacial.

- La aplicación puede saber cuándo el usuario no está buscando en la dirección de un objeto importante, lo que puede llevar a la aplicación a dar indicaciones visuales y de audio para girar hacia ese objeto.

Compatibilidad con dispositivos

| Modelo de entrada | HoloLens (1.ª generación) | HoloLens 2 | Cascos envolventes |

| Mirada con la cabeza y confirmación | ✔️ Recomendado | ✔️ Recomendado (tercera opción: Ver las demás opciones) | ➕ Opción alternativa |

| Mirada con los ojos y confirmación | ❌ No disponible | ✔️ Recomendado (tercera opción: Ver las demás opciones) | ❌ No disponible |

Demostración de los conceptos de diseño de seguimiento de la cabeza y los ojos

Si quiere ver en acción los conceptos de diseño de seguimiento de cabeza y manos, consulte nuestra demostración de vídeo Diseño de hologramas: Seguimiento de cabeza y seguimiento de manos a continuación. Cuando haya terminado, continúe para profundizar más en detalle en temas específicos.

Este vídeo se tomó de la aplicación HoloLens 2 "Diseño de hologramas". Descargue y disfrute de la experiencia completa aquí.

Mirar

¿Mirada con los ojos o la cabeza?

Hay varias consideraciones al enfrentarse a la pregunta de si debe usar el modelo de entrada "mirada con los ojos y confirmación" o "mirada con la cabeza y confirmación". Si está desarrollando para un casco envolvente o para HoloLens (1.ª generación), la elección es sencilla: mirada con la cabeza y confirmación. Si está desarrollando para HoloLens 2, la elección se vuelve un poco más difícil. Es importante comprender las ventajas y los desafíos que vienen con cada uno de ellos. Hemos compilado algunas ventajas generales y desventajas en la tabla siguiente para contrastar el objetivo de la mirada con los ojos frente a la cabeza. Esto está lejos de completarse y sugerimos obtener más información sobre el objetivo de mirada ocular en realidad mixta aquí:

- Seguimiento ocular en HoloLens 2: introducción general de nuestra nueva funcionalidad de seguimiento ocular en HoloLens 2 incluyendo algunas instrucciones para desarrolladores.

- Interacción con la mirada ocular: consideraciones de diseño y recomendaciones al planear el uso del seguimiento ocular como entrada.

| Objetivo de mirada con ojos | Establecer el destino de la mirada con la cabeza |

| ¡Rápido! | Más lento |

| Bajo esfuerzo (apenas se necesitan movimientos corporales) | Puede ser fatiguante - Posible molestia (por ejemplo, tensión del cuello) |

| No requiere un cursor, pero se recomiendan comentarios sutiles. | Requiere mostrar un cursor |

| Sin movimientos oculares suaves: por ejemplo, no es bueno para dibujar | Más controlado y explícito |

| Difícil para destinos pequeños (por ejemplo, pequeños botones o vínculos web) | ¡Fidedigno! ¡Gran reserva! |

| ... | ... |

Tanto si usa la mirada con la cabeza como la mirada con los ojos para el modelo de entrada de mirada y confirmación, cada uno incluye diferentes conjuntos de restricciones de diseño. Estos se tratan por separado en los artículos de mirada y confirmación y confirmación de la mirada y la cabeza .

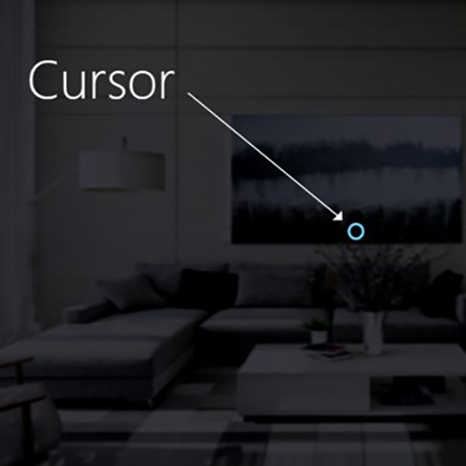

Cursor

Para la mirada con la cabeza, la mayoría de las aplicaciones deben usar un cursor u otra indicación auditiva o visual para dar al usuario confianza en lo que está a punto de interactuar.

Normalmente, colocas este cursor en el mundo donde su rayo de mirada con la cabeza cruza primero un objeto, que puede ser un holograma o una superficie real.

Para la mirada con los ojos, generalmente se recomienda no mostrar un cursor, ya que esto puede volverse distraído y molesto para el usuario.

En su lugar, resalte los destinos visuales o use un cursor de ojo débil para proporcionar confianza sobre lo que el usuario está a punto de interactuar. Para obtener más información, consulte nuestra guía de diseño para obtener una entrada basada en los ojos en HoloLens 2.

Imagen: un cursor visual de ejemplo para mostrar la mirada

Commit

Después de hablar de diferentes maneras de mirar a un objetivo, hablemos un poco más sobre la parte de confirmación en la mirada y confirmación. Después de seleccionar como destino un objeto o un elemento de interfaz de usuario, el usuario puede interactuar o hacer clic en él mediante una entrada secundaria. Esto se conoce como el paso de confirmación del modelo de entrada.

Se admiten los siguientes métodos de confirmación:

- Gesto de pulsar la mano en el aire (es decir, levantar la mano delante de usted y reunir el dedo índice y el pulgar)

- Diga "select" o uno de los comandos de voz de destino.

- Presionar un solo botón en un clicker de HoloLens

- Pulse el botón "A" en un controlador para juegos de Xbox.

- Pulse el botón "A" en un controlador adaptable de Xbox.

Gesto de mirada y pulsación en el aire

Pulsar en el aire es hacer el gesto de pulsar con la mano vertical. Para usar una pulsación de aire, levante el dedo índice hasta la posición lista, luego pellizque con el pulgar y levante el dedo índice hacia arriba para liberarlo. En HoloLens (1ª generación), la pulsación de aire es la entrada secundaria más común.

Dedo en la posición lista

Presione el dedo hacia abajo para pulsar o hacer clic en

La pulsación de aire también está disponible en HoloLens 2. Se ha relajado de la versión original. Casi todos los tipos de pellizcos ahora se admiten siempre y cuando la mano esté vertical y sujetando todavía. Esto facilita mucho a los usuarios aprender y usar el gesto. Esta nueva pulsación aérea reemplaza la antigua a través de la misma API, por lo que las aplicaciones existentes tendrán el nuevo comportamiento automáticamente después de volver a compilar para HoloLens 2.

Comando de voz "Seleccionar" y mirada

El comando de voz es uno de los métodos de interacción principales en la realidad mixta. Proporciona un potente mecanismo manos libres para controlar el sistema. Hay diferentes tipos de modelos de interacción de voz:

- Comando genérico "Select" que usa una acción de clic o confirmación como entrada secundaria.

- Los comandos object (por ejemplo, "Close" o "Make it bigger") realizan y confirman en una acción como entrada secundaria.

- Los comandos globales (por ejemplo, "Ir a inicio") no requieren un destino.

- Las interfaces de usuario de conversación o entidades como Cortana tienen una funcionalidad de lenguaje natural de IA.

- Comandos de voz personalizados

Para obtener más información sobre los detalles y una lista completa de los comandos de voz disponibles y cómo usarlos, consulte nuestra guía de comandos de voz .

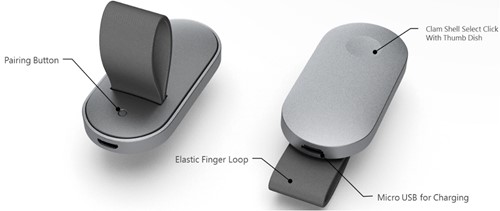

Mirada y clicker de HoloLens

HoloLens Clicker es el primer dispositivo periférico creado específicamente para HoloLens. Se incluye con HoloLens (1.ª generación) Development Edition. El Clicker de HoloLens permite al usuario hacer clic con un movimiento de mano mínimo y confirmar como entrada secundaria. El Clicker de HoloLens se conecta a HoloLens (1.ª generación) o HoloLens 2 mediante Bluetooth low energy (BTLE).

Más información e instrucciones para emparejar el dispositivo

Imagen: Clicker de HoloLens

Mirada y Control inalámbrico Xbox

El Control inalámbrico Xbox realiza una acción de clic como entrada secundaria mediante el botón "A". El dispositivo se asigna a un conjunto predeterminado de acciones que ayudan a navegar y controlar el sistema. Si quieres personalizar el controlador, usa la aplicación Accesorios de Xbox para configurar tu Control inalámbrico Xbox.

Cómo emparejar un mando de Xbox con tu PC

Imagen: Control inalámbrico Xbox

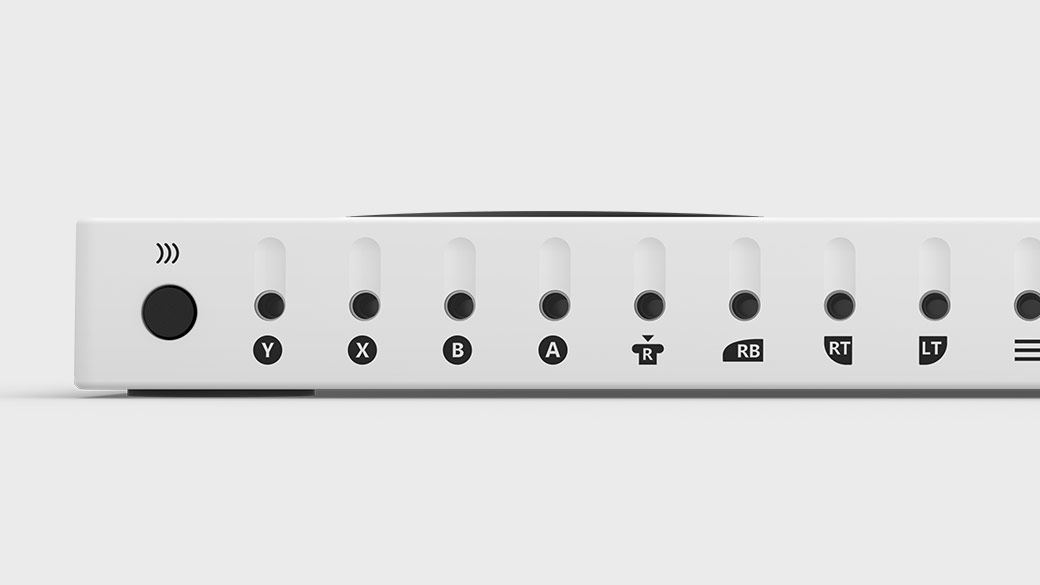

Mirada y controlador adaptable de Xbox

Diseñado principalmente para satisfacer las necesidades de los jugadores con movilidad limitada, el controlador adaptable de Xbox es un centro unificado para dispositivos que ayuda a que la realidad mixta sea más accesible.

El controlador adaptable de Xbox realiza una acción de clic como entrada secundaria mediante el botón "A". El dispositivo se asigna a un conjunto predeterminado de acciones que ayudan a navegar y controlar el sistema. Si quieres personalizar el controlador, usa la aplicación Accesorios de Xbox para configurar el controlador adaptable de Xbox.

Xbox Adaptive Controller

Conecte dispositivos externos, como conmutadores, botones, montajes y joysticks para crear una experiencia de controlador personalizada que sea única. Las entradas de botón, stick analógico y desencadenador se controlan con dispositivos de asistencia conectados a través de conectores de 3,5 mm y puertos USB.

Puertos del Xbox Adaptive Controller

Instrucciones para emparejar el dispositivo

Más información disponible en el sitio de Xbox

Gestos compuestos

Pulsar en el aire

El gesto de pulsación de aire (y los demás gestos a continuación) solo reacciona a una pulsación específica. Para detectar otras pulsaciones, como Menú o Agarre, la aplicación debe usar directamente las interacciones de nivel inferior descritas en la sección anterior de dos gestos de componente clave.

Mantener pulsado

Mantener pulsado simplemente consiste en mantener la posición del dedo hacia abajo al pulsar en el aire. La combinación de pulsación y suspensión del aire permite varias interacciones más complejas de "clic y arrastrar" cuando se combina con el movimiento del brazo, como la selección de un objeto en lugar de activarlo o las interacciones secundarias de mousedown, como mostrar un menú contextual. Sin embargo, se debe tener precaución al diseñar este gesto, ya que los usuarios pueden ser propensos a relajar sus posturas de la mano durante cualquier gesto extendido.

Manipulación

Los gestos de manipulación se pueden usar para mover, cambiar el tamaño o girar un holograma cuando quieras que el holograma reaccione 1:1 a los movimientos de la mano del usuario. Uno de los usos de estos movimientos 1:1 es permitir al usuario dibujar o pintar en el mundo. El destino inicial de un gesto de manipulación debe establecerse con la mirada o apuntando. Una vez que se inicia la pulsación y la suspensión, cualquier manipulación de objetos se controla mediante movimientos de mano, lo que libera al usuario de mirar alrededor mientras manipula.

Navegación

Los gestos de navegación funcionan como un joystick virtual y se pueden usar para navegar por los widgets de la interfaz de usuario, como los menús circulares. Se mantiene pulsado para iniciar el gesto y, después, se mueve la mano dentro de un cubo 3D normalizado centrado alrededor de la pulsación inicial. Puede mover la mano a lo largo del eje X, Y o Z de un valor de -1 a 1, siendo 0 el punto inicial. La navegación se puede utilizar para crear gestos de zoom o desplazamiento continuo basado en la velocidad, similares al desplazamiento en una interfaz de usuario 2D cuando se hace clic con el botón central del ratón para después mover el ratón hacia arriba y abajo.

La navegación con raíles hace referencia a la capacidad de reconocer los movimientos en determinados ejes hasta que se alcanza un umbral determinado en ese eje. Esto solo es útil cuando el desarrollador habilita el movimiento en más de un eje en una aplicación, por ejemplo, si una aplicación está configurada para reconocer gestos de navegación a través de X, eje Y, pero también eje X especificado con raíles. En este caso, el sistema reconocerá los movimientos de mano a través del eje X siempre y cuando permanezcan dentro de un riel imaginario (guía) en el eje X, si el movimiento de la mano también se produce en el eje Y.

En las aplicaciones 2D, los usuarios pueden usar gestos de navegación vertical para desplazarse, hacer zoom o arrastrar dentro de la aplicación. Esto inserta entradas táctiles virtuales en la aplicación para simular gestos táctiles del mismo tipo. Los usuarios pueden seleccionar qué acciones se llevan a cabo alternando entre las herramientas de la barra situada encima de la aplicación, ya sea seleccionando el botón o diciendo "<Scroll/Drag/Zoom> Tool".

Más información sobre los gestos compuestos

Reconocedores de gestos

Una ventaja de usar el reconocimiento de gestos es que puede configurar un reconocedor de gestos solo para los gestos que el holograma de destino actualmente puede aceptar. La plataforma solo elimina la ambigüedad según sea necesario para distinguir esos gestos admitidos en particular. De este modo, un holograma que solo admite pulsación de aire puede aceptar cualquier período de tiempo entre la prensa y la liberación, mientras que un holograma que admite pulsación y suspensión puede promover la pulsación a una suspensión después del umbral de tiempo de suspensión.

Reconocimiento de la mano

HoloLens reconoce los gestos de la mano mediante el seguimiento de la posición de una o ambas manos si son visibles para el dispositivo. HoloLens ve las manos cuando están en el estado preparado (parte posterior de la mano hacia ti con el dedo índice arriba) o el estado presionado (parte posterior de la mano hacia ti con el dedo índice hacia abajo). Cuando las manos están en otras posturas, HoloLens las omite. Para cada mano que HoloLens detecta, puede acceder a su posición sin orientación y su estado presionado. A medida que la mano se acerca al borde del marco gestual, obtendrás un vector de dirección que puedes mostrar al usuario para que sepa cómo mover la mano para volver a ponerla donde HoloLens pueda verla.

Marco gestual

Para los gestos en HoloLens, la mano debe estar dentro de un marco de gesto, en un rango que las cámaras de detección de gestos pueden ver correctamente, desde la nariz a la cintura y entre los hombros. Los usuarios deben estar capacitados en esta área de reconocimiento tanto para el éxito de la acción como para su propia comodidad. Muchos usuarios asumen inicialmente que el marco de gesto debe estar dentro de su vista a través de HoloLens y mantener los brazos en los brazos infortablemente para interactuar. Al usar el clicker de HoloLens, no es necesario que las manos estén dentro del marco de gesto.

En el caso de los gestos continuos en particular, existe el riesgo de que los usuarios muevan sus manos fuera del marco del gesto mientras se encuentran en el medio al mover un objeto holográfico, por ejemplo, y perder su resultado previsto.

Hay tres cosas que hay que tener en cuenta:

Educación del usuario en la existencia del marco de gestos y límites aproximados. Esto se enseña durante la configuración de HoloLens.

Notificar a los usuarios cuando sus gestos están cerca o rompiendo los límites del marco de gesto dentro de una aplicación hasta el punto en que un gesto perdido conduce a resultados no deseados. La investigación ha demostrado las cualidades clave de este sistema de notificación. El shell de HoloLens proporciona un buen ejemplo de este tipo de notificación- objeto visual, en el cursor central, que indica la dirección en la que se está llevando a cabo el cruce de límites.

Se deben minimizar las consecuencias de traspasar los límites del marco gestual. En general, esto significa que el resultado de un gesto se debe detener en el límite y no invertirlo. Por ejemplo, si un usuario mueve algún objeto holográfico a través de una sala, el movimiento debe detenerse cuando se infringe el marco de gesto y no se devuelve al punto inicial. El usuario puede experimentar cierta frustración, pero podría comprender más rápidamente los límites y no tener que reiniciar sus acciones previstas completas cada vez.