Introducción a los ejemplos de seguimiento ocular: MRTK2

En este tema se describe cómo empezar a trabajar rápidamente con el seguimiento ocular en MRTK basándose en ejemplos de seguimiento ocular de MRTK (Assets/MRTK/Examples/Demos/EyeTracking). Estos ejemplos le permiten experimentar una de nuestras nuevas capacidades de entrada mágicas: Seguimiento ocular! La demostración incluye varios casos de uso, que van desde activaciones implícitas basadas en los ojos hasta cómo combinar sin problemas información sobre lo que está examinando con la entrada de voz y mano . Esto permite a los usuarios seleccionar y mover contenido holográfico rápidamente y sin esfuerzo a través de su vista simplemente mirando un destino y diciendo "Seleccionar" o realizar un gesto de mano. Las demostraciones también incluyen un ejemplo para el desplazamiento dirigido por los ojos, el movimiento panorámico y el zoom de texto e imágenes en una pizarra. Por último, se proporciona un ejemplo para grabar y visualizar la atención visual del usuario en una pizarra 2D. En la siguiente sección, encontrará más detalles sobre lo que incluye cada una de las diferentes muestras del paquete de ejemplo de seguimiento ocular de MRTK (Assets/MRTK/Examples/Demos/EyeTracking):

![]()

La siguiente sección es una visión general rápida de lo que tratan las escenas de demostración de seguimiento ocular individuales. Las escenas de demostración de seguimiento ocular de MRTK se cargan aditivamente, que explicaremos a continuación cómo configurar.

Introducción a los ejemplos de demostración de seguimiento ocular

Selección de destino compatible con los ojos

En este tutorial se muestra la facilidad de acceso a los datos de mirada ocular para seleccionar destinos. Incluye un ejemplo de comentarios sutiles pero eficaces para proporcionar al usuario la confianza de que un destino está centrado sin ser abrumador. Además, hay un ejemplo sencillo de notificaciones inteligentes que desaparece automáticamente después de leerse.

Resumen: selecciones de destino rápidas y sin esfuerzo mediante una combinación de ojos, voz y entrada manual.

Navegación compatible con los ojos

Imagine que está leyendo información sobre una pantalla lejana o su lector electrónico y cuando llega al final del texto mostrado, el texto se desplaza automáticamente para mostrar más contenido. ¿O cómo acercarse mágicamente hacia dónde estabas mirando? Estos son algunos de los ejemplos que se muestran en este tutorial con respecto a la navegación con los ojos admitidos. Además, hay un ejemplo para la rotación sin manos de hologramas 3D haciendo que se giren automáticamente en función del foco actual.

Resumen: Desplazamiento, movimiento panorámico, zoom, rotación 3D mediante una combinación de ojos, voz y entrada manual.

Posicionamiento compatible con los ojos

En este tutorial se muestra un escenario de entrada llamado Put-That-There que data de la investigación del MIT Media Lab a principios de 1980 con entrada de ojo, mano y voz. La idea es sencilla: beneficiarse de los ojos para una selección y posicionamiento rápidos de destino. Solo tienes que mirar un holograma y decir 'poner esto', ver dónde quieres colocarlo y decir 'ahí!'. Para colocar con más precisión el holograma, puede usar la entrada adicional de las manos, la voz o los controladores.

Resumen: Colocación de hologramas mediante ojos, voz y entrada de mano (arrastrar y colocar). Controles deslizantes compatibles con los ojos mediante los ojos y las manos.

Visualización de la atención visual

Los datos basados en dónde ven los usuarios hacen una herramienta inmensamente eficaz para evaluar la facilidad de uso de un diseño e identificar problemas en flujos de trabajo eficientes. En este tutorial se describen diferentes visualizaciones de seguimiento ocular y cómo se ajustan a diferentes necesidades. Proporcionamos ejemplos básicos para registrar y cargar datos de seguimiento ocular y ejemplos de cómo visualizarlos.

Resumen: mapa de atención bidimensional (mapas térmicos) en pizarras. Grabar & reproducir datos de seguimiento ocular.

Configuración de los ejemplos de seguimiento ocular de MRTK

Requisitos previos

Tenga en cuenta que el uso de los ejemplos de seguimiento ocular en el dispositivo requiere un HoloLens 2 y un paquete de aplicación de ejemplo que se compila con la funcionalidad "Entrada de mirada" en appXManifest del paquete.

Para usar estos ejemplos de seguimiento ocular en el dispositivo, asegúrese de seguir estos pasos antes de compilar la aplicación en Visual Studio.

1. Cargar EyeTrackingDemo-00-RootScene.unity

EyeTrackingDemo-00-RootScene es la escena base (raíz) que tiene incluidos todos los componentes principales de MRTK. Esta es la escena que necesita cargar primero y desde la que ejecutará las demostraciones de seguimiento ocular. Cuenta con un menú gráfico de escenas que le permite cambiar fácilmente entre las diferentes muestras de seguimiento ocular que se cargarán aditivamente.

![]()

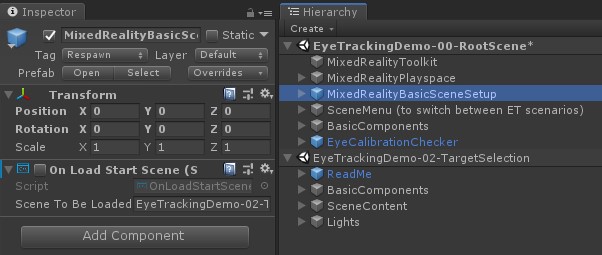

La escena raíz incluye algunos componentes principales que se conservarán en las escenas cargadas aditivamente, como los perfiles configurados de MRTK y la cámara de escena. MixedRealityBasicSceneSetup (consulte la captura de pantalla siguiente) incluye un script que cargará automáticamente la escena a la que se hace referencia en el inicio. De forma predeterminada, se trata de EyeTrackingDemo-02-TargetSelection.

![]()

2. Agregar escenas al menú de compilación

Para cargar escenas de adición durante el tiempo de ejecución, primero debe agregar estas escenas a la configuración de compilación:> escenas en el menú Compilar . Es importante que la escena raíz se muestre como la primera escena de la lista:

![]()

3. Reproducir las muestras de seguimiento ocular en el editor de Unity

Después de agregar las escenas de seguimiento ocular a la configuración de compilación y cargar eyeTrackingDemo-00-RootScene, hay una última cosa que puede comprobar: ¿Está habilitado el script "OnLoadStartScene" que está asociado al gameObject MixedRealityBasicSceneSetup ? Esto es para permitir que la escena raíz sepa qué escena de demostración se va a cargar primero.

![]()

¡Vamos a rodar! ¡Toca "Play"! Debería ver que aparecen varias gemas y el menú de escena en la parte superior.

![]()

También debes observar un pequeño círculo semitransparente en el centro de la vista del juego. Esto actúa como indicador (cursor) de la mirada de los ojos simulados: simplemente presione el botón derecho del mouse y mueva el mouse para cambiar su posición. Cuando el cursor mantenga el puntero sobre las gemas, observará que se ajustará al centro de la gema vista actualmente. Esta es una excelente manera de probar si los eventos se desencadenan según lo previsto cuando se "examinan" un destino. Tenga en cuenta que la mirada de los ojos simulada a través del control del mouse es un suplemento bastante deficiente para nuestros movimientos oculares rápidos e involuntarias. Sin embargo, es ideal para probar la funcionalidad básica antes de iterar en el diseño mediante la implementación en el dispositivo HoloLens 2. Volver a nuestra escena de muestra de seguimiento ocular: la gema gira mientras se examina y se puede destruir "mirando" en ella y ...

- Presionar Entrar (que simula que dice "seleccionar")

- Decir "seleccionar" en el micrófono

- Al presionar Espacio para mostrar la entrada de mano simulada, haga clic en el botón izquierdo del mouse para realizar una pulsación simulada.

Describimos con más detalle cómo puede lograr estas interacciones en nuestro tutorial Selección de destino compatible con los ojos.

Al mover el cursor hacia arriba hasta la barra de menús superior de la escena, observará que el elemento que se mantiene activo se resaltará de forma secundaria. Puede seleccionar el elemento resaltado actualmente mediante uno de los métodos de confirmación descritos anteriormente (por ejemplo, presionar Entrar). De este modo, puede cambiar entre las diferentes escenas de ejemplo de seguimiento ocular.

4. Cómo probar subcadenas específicas

Al trabajar en un escenario específico, es posible que no quiera pasar por el menú de la escena cada vez. En su lugar, puede que quiera empezar directamente desde la escena en la que está trabajando actualmente al presionar el botón Reproducir . No se preocupe. Esto es lo que puede hacer:

Cargar la escena raíz

En la escena raíz, deshabilite el script "OnLoadStartScene".

Arrastre y coloque una de las escenas de prueba de seguimiento ocular que se describen a continuación (o cualquier otra escena) en la vista Jerarquía , como se muestra en la captura de pantalla siguiente.

Presione Reproducir

Tenga en cuenta que cargar la subcadena como esta no es persistente: esto significa que si implementa la aplicación en el dispositivo HoloLens 2, solo cargará la escena raíz (suponiendo que aparezca en la parte superior de la configuración de compilación). Además, al compartir el proyecto con otros usuarios, las subcadenas no se cargan automáticamente.

Ahora que sabe cómo hacer que funcionen las escenas de ejemplo de seguimiento ocular de MRTK, vamos a continuar profundizando en cómo seleccionar hologramas con los ojos: selección de destino compatible con los ojos.