Mengambil data dari Azure Event Hubs dalam format Parquet

Artikel ini menjelaskan cara menggunakan editor tanpa kode untuk mengambil data streaming secara otomatis di Azure Event Hubs dalam akun Azure Data Lake Storage Gen2 dalam format Parquet.

Prasyarat

Namespace Azure Event Hubs dengan pusat aktivitas dan akun Azure Data Lake Storage Gen2 dengan kontainer untuk menyimpan data yang diambil. Sumber daya ini harus dapat diakses publik dan tidak dapat berada di belakang firewall atau diamankan di jaringan virtual Azure.

Jika Anda tidak memiliki pusat aktivitas, buat hub peristiwa dengan mengikuti instruksi dari Mulai Cepat: Membuat pusat aktivitas.

Jika Anda tidak memiliki akun Data Lake Storage Gen2, buat akun dengan mengikuti instruksi dari Membuat akun penyimpanan

Data di Azure Event Hubs Anda harus diserialisasikan dalam format JSON, CSV, atau Avro. Untuk tujuan pengujian, pilih Buat data (pratinjau) di menu sebelah kiri, pilih Data stok untuk himpunan data, lalu pilih Kirim.

Mengonfigurasi pekerjaan untuk mengambil data

Gunakan langkah-langkah berikut untuk mengonfigurasi pekerjaan Analisis Aliran untuk mengambil data di Azure Data Lake Storage Gen2.

Di portal Microsoft Azure, pergi ke pusat aktivitas Anda.

Di menu sebelah kiri, pilih Proses Data di bawah Fitur. Kemudian, pilih Mulai pada kartu format Ambil data ke ADLS Gen2 di Parquet .

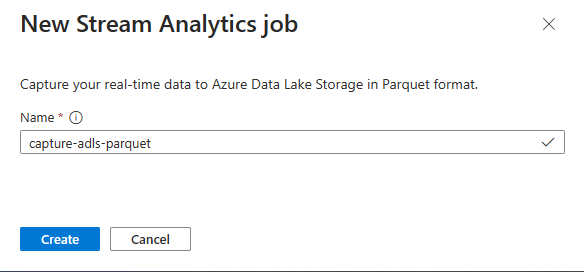

Masukkan nama untuk pekerjaan Azure Stream Analytics Anda, lalu pilih Buat.

Tentukan jenis Serialisasi data Anda di Azure Event Hubs dan metode Autentikasi yang digunakan pekerjaan untuk menyambungkan ke Azure Event Hubs. Kemudian pilih Sambungkan.

Saat koneksi berhasil dibuat, Anda akan melihat:

Bidang yang ada dalam data input. Anda dapat memilih Tambahkan bidang atau Anda dapat memilih simbol tiga titik di samping bidang untuk menghapus, mengganti nama, atau mengubah namanya secara opsional.

Sampel langsung data masuk dalam tabel Pratinjau data di bawah tampilan diagram. Ini di-refresh secara berkala. Anda dapat memilih Jeda pratinjau streaming untuk melihat tampilan statis input sampel.

Pilih petak peta Azure Data Lake Storage Gen2 untuk mengedit konfigurasi.

Pada halaman konfigurasi Azure Data Lake Storage Gen2, ikuti langkah-langkah berikut:

Pilih langganan, nama akun penyimpanan, dan kontainer dari menu drop-down.

Setelah langganan dipilih, metode autentikasi dan kunci akun penyimpanan harus diisi secara otomatis.

Pilih Parquet untuk Format serialisasi .

Untuk blob streaming, pola jalur direktori diharapkan menjadi nilai dinamis. Diperlukan tanggal untuk menjadi bagian dari jalur file untuk blob - dirujuk sebagai

{date}. Untuk mempelajari tentang pola jalur kustom, lihat pemartisian output blob kustom Azure Stream Analytics.Pilih Sambungkan

Saat koneksi dibuat, Anda akan melihat bidang yang ada dalam data output.

Pilih Simpan pada bilah perintah untuk menyimpan konfigurasi Anda.

Pilih Mulai untuk memulai alur streaming untuk mengambil data. Kemudian di jendela pekerjaan Mulai Analisis Aliran:

Pilih waktu mulai keluaran.

Pilih paket harga.

Pilih jumlah Unit Streaming (SU) yang dijalankan pekerjaan. SU mewakili sumber daya komputasi yang dialokasikan untuk menjalankan tugas Analisis Aliran. Untuk informasi selengkapnya, lihat Unit Streaming di Azure Stream Analytics.

Anda akan melihat pekerjaan Stream Analytic di tab pekerjaan Azure Stream Analytics di halaman Memproses data untuk hub peristiwa Anda.

Verifikasi output

Pada halaman instans Azure Event Hubs untuk pusat aktivitas Anda, pilih Hasilkan data, pilih Data stok untuk himpunan data, lalu pilih Kirim untuk mengirim beberapa data sampel ke pusat aktivitas.

Verifikasi bahwa file Parquet dihasilkan dalam kontainer Azure Data Lake Storage.

Pilih Proses data di menu sebelah kiri. Beralih ke tab pekerjaan Azure Stream Analytics . Pilih Buka metrik untuk memantaunya.

Berikut adalah contoh cuplikan layar metrik yang menunjukkan peristiwa input dan output.

Langkah berikutnya

Sekarang Anda tahu cara menggunakan editor tanpa kode Analisis Aliran untuk membuat pekerjaan yang menangkap data Azure Event Hubs untuk Azure Data Lake Storage Gen2 dalam format Parquet. Selanjutnya, Anda dapat mempelajari selengkapnya tentang Azure Stream Analytics dan cara memantau pekerjaan yang Anda buat.