Panduan Mulai Cepat: Buatlah kumpulan Apache Spark nirserver di Azure Synapse Analytics dengan menggunakan alat web

Dalam panduan mulai cepat ini, Anda mempelajari cara membuat kumpulan Apache Spark nirserver di Azure Synapse dengan menggunakan alat web. Anda kemudian belajar membuat sambungan ke kumpulan Apache Spark dan menjalankan kueri Spark SQL pada file dan tabel. Apache Spark memfasilitasi analitik data yang cepat dan komputasi kluster dengan menggunakan pemrosesan dalam memori. Untuk informasi tentang Spark di Azure Synapse, lihat Ikhtisar: Apache Spark di Azure Synapse.

Penting

Penagihan untuk instans Spark diprorata per menit, baik Anda menggunakannya atau tidak. Pastikan Anda mematikan instans Spark setelah selesai menggunakannya, atau atur waktu jangka pendek. Untuk informasi selengkapnya, lihat bagian Membersihkan sumber daya di artikel ini.

Jika Anda tidak memiliki langganan Azure, buat akun gratis sebelum memulai.

Prasyarat

- Anda akan memerlukan langganan Azure. Jika diperlukan, buat akun Azure gratis

- Ruang kerja Synapse Analytics

- Kumpulan Apache Spark nirserver

Masuk ke portal Microsoft Azure

Masuk ke portal Microsoft Azure.

Jika Anda tidak memiliki langganan Azure, buat akun Azure gratissebelum Anda memulai.

Membuat notebook

Notebook adalah lingkungan interaktif yang mendukung berbagai bahasa pemrogram. Notebook tersebut memungkinkan Anda untuk berinteraksi dengan data, menggabungkan kode dengan markdown, teks, dan melakukan visualisasi sederhana.

Dari tampilan portal Microsoft Azure untuk ruang kerja Azure Synapse yang ingin Anda gunakan, pilih Luncurkan Synapse Studio.

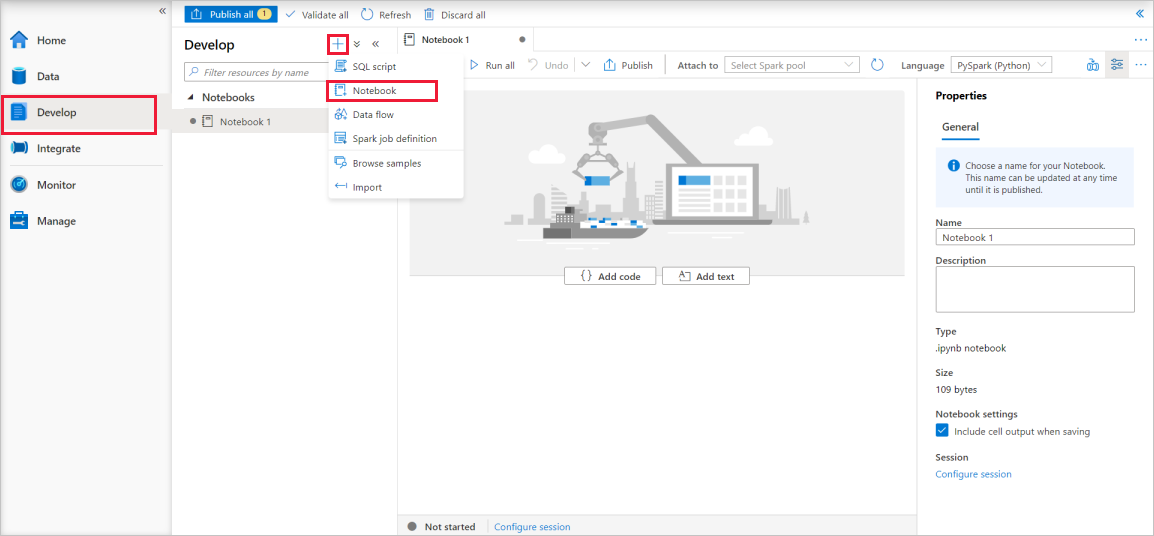

Setelah Synapse Studio terbuka, pilih Kembangkan. Lalu, pilih ikon " + " untuk menambahkan sumber daya baru.

Dari sana, pilih Notebook. Notebook baru dibuat dan dibuka dengan nama yang dibuat secara otomatis.

Di jendela Properti, berikan nama untuk notebook.

Pada bar alat, klik Terbitkan.

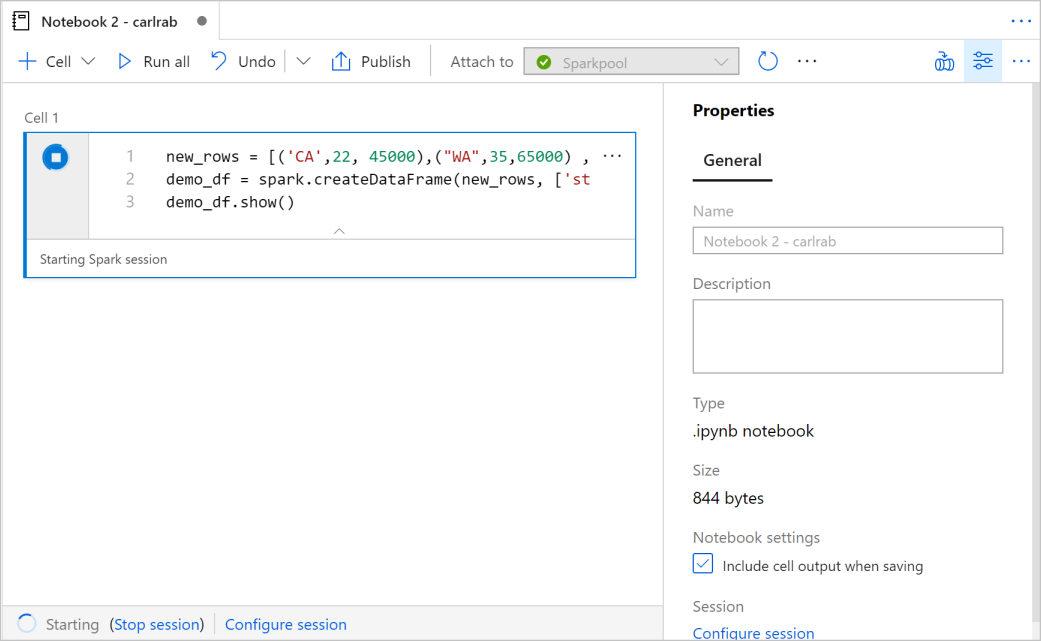

Jika hanya ada satu kumpulan Apache Spark di ruang kerja Anda, maka kumpulan tersebut dipilih secara default. Gunakan menu drop-down untuk memilih kumpulan Apache Spark yang benar jika tidak ada yang dipilih.

Klik Tambahkan kode. Bahasa defaultnya adalah

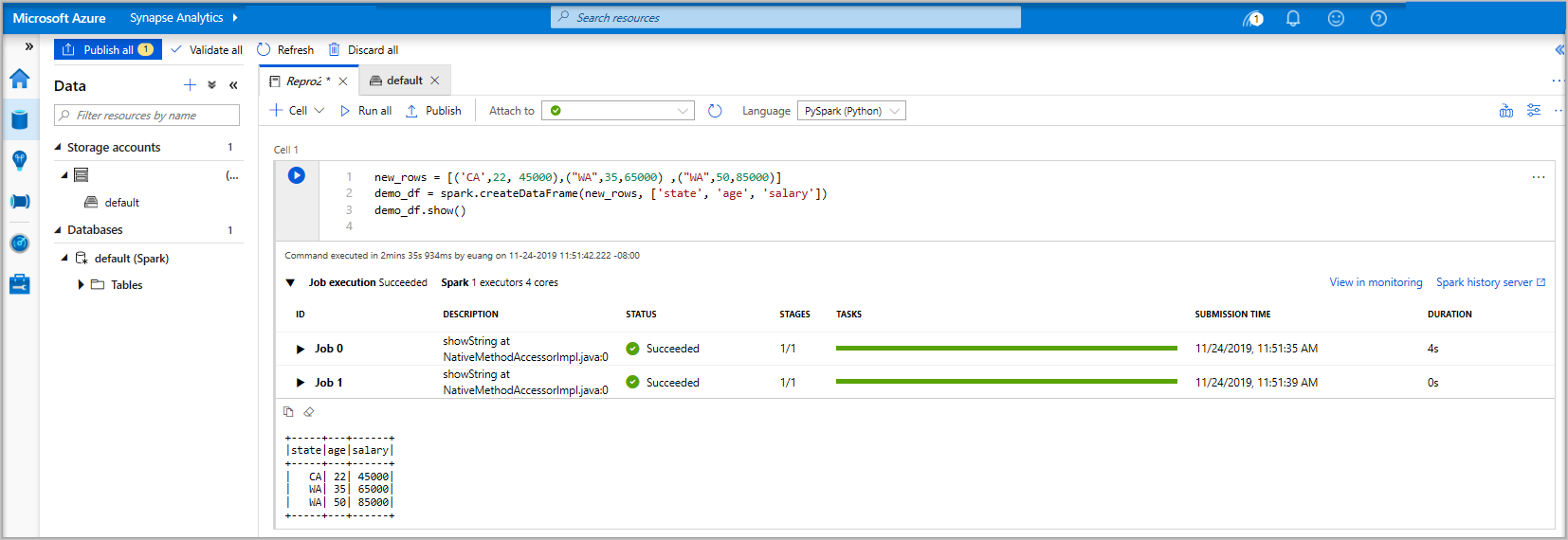

Pyspark. Anda akan menggunakan campuran Pyspark dan Spark SQL, jadi pengaturan defaultnya boleh dipilih. Bahasa lain yang didukung adalah Scala dan .NET untuk Spark.Selanjutnya Anda membuat objek Spark DataFrame sederhana untuk dimanipulasi. Dalam hal ini, Anda membuatnya dari kode. Terdapat tiga baris dan tiga kolom:

new_rows = [('CA',22, 45000),("WA",35,65000) ,("WA",50,85000)] demo_df = spark.createDataFrame(new_rows, ['state', 'age', 'salary']) demo_df.show()Sekarang jalankan sel dengan menggunakan salah satu metode berikut:

Tekan SHIFT + ENTER.

Pilih ikon putar biru di sebelah kiri sel.

Pilih tombol Jalankan semua pada bar alat.

Jika instans kumpulan Apache Spark belum berjalan, prosesnya akan dimulai secara otomatis. Anda dapat melihat status instans kumpulan Apache Spark di bawah sel yang Anda jalankan dan juga pada panel status di bagian bawah notebook. Tergantung pada ukuran kumpulan, proses awal umumnya berlangsung selama 2-5 menit. Setelah kode selesai dijalankan, informasi di bawah tampilan sel menunjukkan lamanya waktu yang dijalankan dan eksekusinya. Di sel output, Anda melihat output.

Data sekarang berada di DataFrame dan dari sana Anda dapat menggunakan data dengan berbagai cara. Anda akan membutuhkannya dalam format yang berbeda untuk panduan mulai cepat lainnya.

Masukkan kode di bawah ini di sel lain dan jalankan, maka tabel Spark, CSV, dan file Parket akan muncul dengan salinan data:

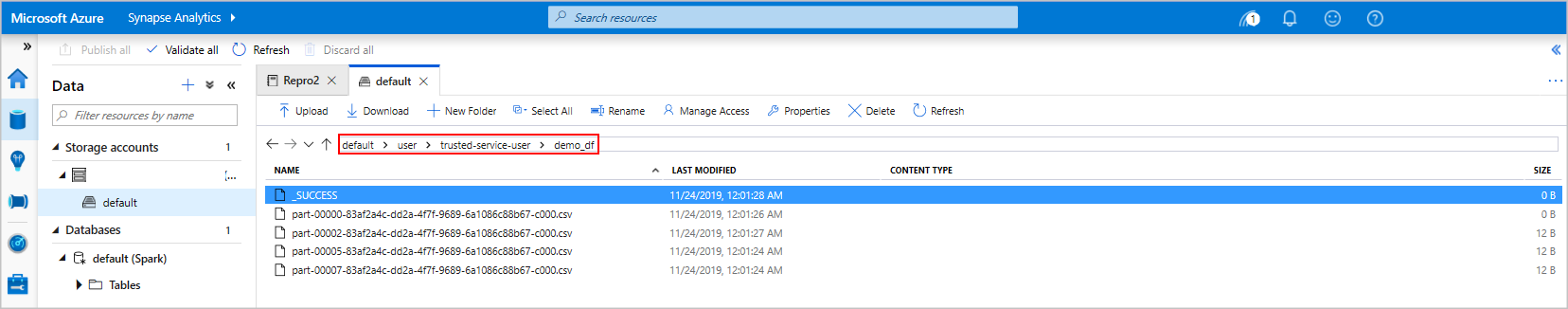

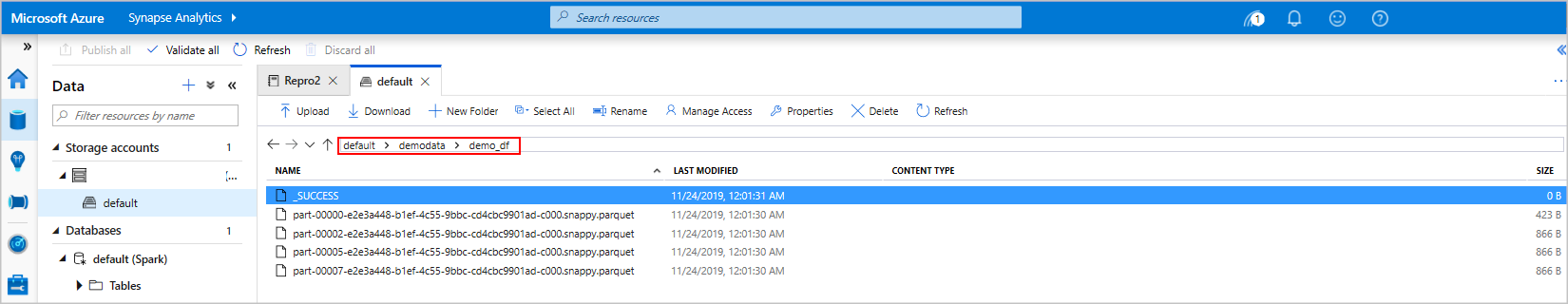

demo_df.createOrReplaceTempView('demo_df') demo_df.write.csv('demo_df', mode='overwrite') demo_df.write.parquet('abfss://<<TheNameOfAStorageAccountFileSystem>>@<<TheNameOfAStorageAccount>>.dfs.core.windows.net/demodata/demo_df', mode='overwrite')Jika menggunakan penjelajah penyimpanan, Anda dapat melihat dampak dari dua cara penulisan file berbeda yang digunakan di atas. Jika tidak ada sistem file yang ditentukan maka default digunakan, dalam hal ini

default>user>trusted-service-user>demo_df. Data disimpan ke lokasi sistem file yang ditentukan.Perhatikan bahwa dalam format "csv" dan "parquet", operasi penulisan pada sebuah direktori dibuat dengan banyak file partisi.

Jalankan pernyataan Spark SQL

Structured Query Language (SQL) adalah bahasa yang paling umum dan banyak digunakan untuk membuat kueri dan mendefinisikan data. Spark SQL berfungsi sebagai ekstensi untuk Apache Spark guna memproses data terstruktur, menggunakan sintaksis SQL yang sudah diketahui.

Tempel kode berikut di sel kosong, lalu jalankan kode. Perintah mencantumkan tabel di kumpulan.

%%sql SHOW TABLESSaat Anda menggunakan Notebook dengan kumpulan Azure Synapse Apache Spark, Anda mendapatkan prasetel

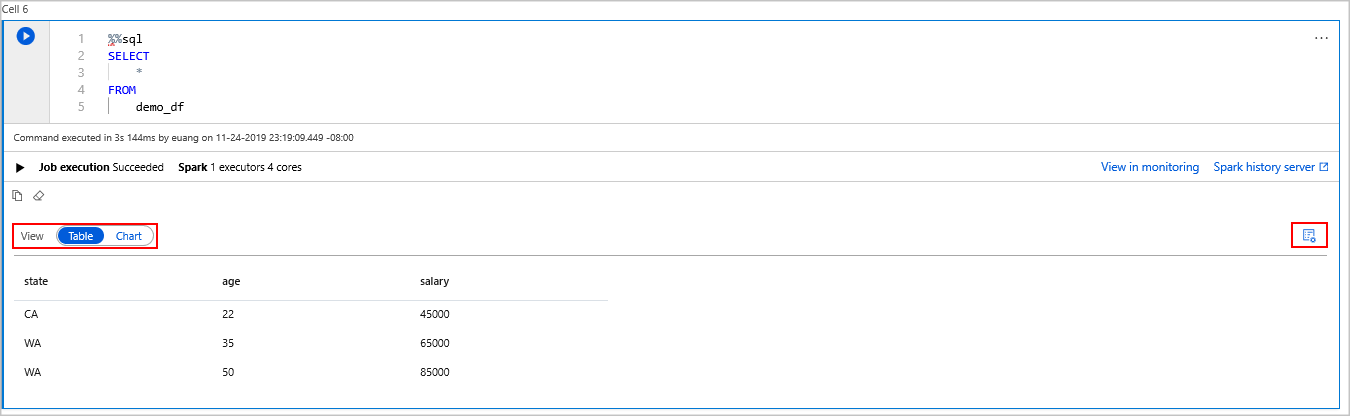

sqlContextyang dapat Anda gunakan untuk menjalankan kueri dengan menggunakan Spark SQL.%%sqlmemberi tahu notebook untuk menggunakan prasetelsqlContextuntuk menjalankan kueri. Kueri mengambil 10 baris teratas dari tabel sistem yang disertakan dengan semua kumpulan Azure Synapse Apache Spark secara default.Jalankan kueri lain untuk melihat data dalam

demo_df.%%sql SELECT * FROM demo_dfKode menghasilkan dua sel output, yang satu berisi hasil data yang lain, yang menunjukkan tampilan pekerjaan.

Secara default, tampilan hasil menunjukkan suatu kisi. Namun, ada pengalih tampilan di bawah kisi yang memungkinkan tampilan untuk beralih di antara tampilan kisi dan grafik.

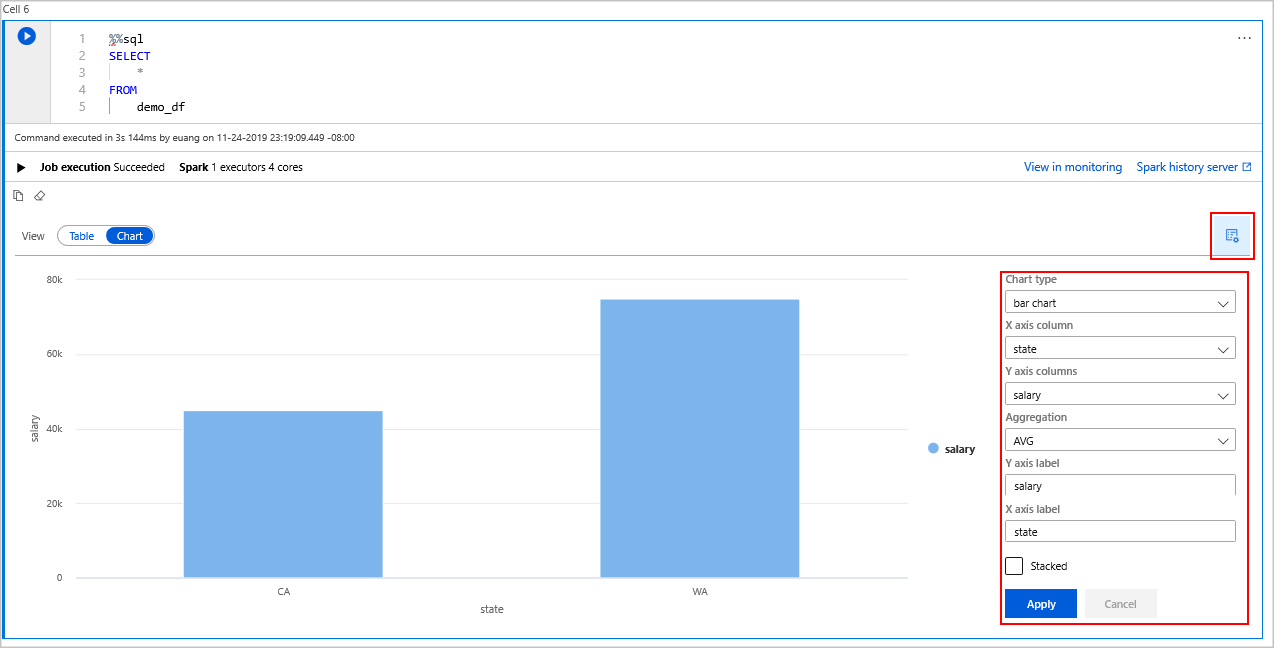

Di pengalih Tampilan, pilih Bagan.

Pilih ikon Opsi tampilan dari sisi paling kanan.

Di bidang Jenis bagan, pilih "bagan batang".

Di bidang kolom sumbu X, pilih "status".

Di bidang kolom sumbu Y, pilih "gaji".

Di bidang Agregasi, pilih "AVG".

Pilih Terapkan.

Pengalaman yang sama saat menjalankan SQL dapat diperoleh, namun Anda tidak perlu berganti bahasa. Anda dapat melakukannya dengan mengganti sel SQL di atas dengan sel PySpark ini, pengalaman outputnya sama karena perintah tampilan digunakan:

display(spark.sql('SELECT * FROM demo_df'))Setiap sel yang sebelumnya dieksekusi memiliki opsi untuk membuka Server Riwayat dan Pemantauan. Dengan mengeklik tautan, Anda akan dibawa ke berbagai bagian Pengalaman Pengguna.

Catatan

Beberapa Dokumentasi resmi Apache Spark mengandalkan penggunaan konsol Spark, yang tidak tersedia di Synapse Spark. Gunakan pengalaman notebook atau IntelliJ sebagai gantinya.

Bersihkan sumber daya

Azure Synapse menyimpan data Anda di Azure Data Lake Storage. Anda dapat dengan aman membiarkan instans Spark dimatikan saat tidak digunakan. Anda dikenai biaya untuk kumpulan Apache Spark nirserver selama instans berjalan, bahkan saat tidak digunakan.

Karena biaya untuk kumpulan jauh lebih banyak daripada biaya untuk penyimpanan, untuk penghematan instans Spark sebaiknya dimatikan saat tidak digunakan.

Untuk memastikan instans Spark dimatikan, akhiri semua sesi yang tersambung (notebook). Kumpulan dimatikan ketika waktu siaga yang ditentukan di kumpulan Apache Spark tercapai. Anda juga dapat memilih akhiri sesi dari bar status di bagian bawah notebook.

Langkah berikutnya

Dalam panduan mulai cepat ini, Anda mempelajari cara membuat kumpulan Apache Spark nirserver dan menjalankan kueri Spark SQL dasar.