Penyiapan ketersediaan yang tinggi di SUSE menggunakan perangkat pagar

Di dalam artikel ini, kita akan membahas langkah-langkah untuk menyiapkan ketersediaan tinggi (HA) di Instans Besar HANA pada sistem operasi SUSE menggunakan perangkat pagar.

Catatan

Panduan ini berasal dari pengujian penyiapan yang berhasil di lingkungan Instans Large HANA Microsoft. Tim Manajemen Layanan Microsoft untuk Instans Large HANA tidak mendukung sistem operasi. Untuk pemecahan masalah atau klarifikasi pada lapisan sistem operasi, hubungi SUSE.

Tim Manajemen Layanan Microsoft menyiapkan dan mendukung penuh perangkat pagar. Ini dapat membantu memecahkan masalah perangkat pagar.

Prasyarat

Untuk menyiapkan ketersediaan tinggi menggunakan pengklusteran SUSE, Anda harus:

- Menyediakan Instans Large HANA.

- Menginstal dan mendaftarkan sistem operasi dengan patch terbaru.

- Menghubungkan server Instans Large HANA ke server SMT untuk mendapatkan patch dan paket.

- Menyiapkan Protokol Waktu Jaringan (server waktu NTP)

- Membaca dan memahami versi terbaru dokumentasi SUSE tentang penyiapan HA.

Detail penyetelan

Panduan ini menggunakan pengaturan berikut:

- Sistem operasi: SLES 12 SP1 untuk SAP

- Instans Large HANA: 2xS192 (empat soket, 2 TB)

- Versi HANA: HANA 2.0 SP1

- Nama server: sapprdhdb95 (node1) dan sapprdhdb96 (node2)

- Perangkat pagar: berbasis iSCSI

- NTP di salah satu node Instans Large HANA

Saat menyiapkan Instans Besar HANA dengan replikasi sistem HANA, Anda dapat meminta tim Manajemen Layanan Microsoft untuk menyiapkan perangkat pagar. Lakukan ini pada saat penyediaan.

Jika sudah menjadi pelanggan dengan Instans Besar HANA yang sudah disediakan, Anda masih dapat menyiapkan perangkat pagar. Berikan informasi berikut ini kepada tim Manajemen Layanan Microsoft dalam formulir permintaan layanan (SRF). Anda bisa mendapatkan SRF melalui Manajer Akun Teknis atau kontak Microsoft Anda untuk onboarding Instans Large HANA.

- Nama server dan alamat IP server (misalnya, myhanaserver1 dan 10.35.0.1)

- Lokasi (misalnya, US Timur)

- Nama Pelanggan (misalnya, Microsoft)

- Pengidentifikasi sistem HANA (SID) (misalnya, H11)

Setelah perangkat pagar dikonfigurasi, tim Manajemen Layanan Microsoft akan memberi Anda nama SBD dan alamat IP penyimpanan iSCSI. Anda dapat menggunakan informasi ini untuk mengonfigurasi penyiapan pagar.

Ikuti langkah-langkah di bagian berikut untuk menyiapkan HA menggunakan perangkat pagar.

Identifikasi perangkat SBD

Catatan

Bagian ini hanya berlaku untuk pelanggan yang sudah ada. Jika Anda adalah pelanggan baru, tim Manajemen Layanan Microsoft akan memberi Anda nama perangkat SBD, jadi lompati bagian ini.

Ubah /etc/iscsi/initiatorname.isci ke:

iqn.1996-04.de.suse:01:<Tenant><Location><SID><NodeNumber>Manajemen layanan Microsoft menyediakan untai (karakter) ini. Ubah file pada kedua simpul. Tetapi, nomor node berbeda pada setiap node.

Memodifikasi /etc/iscsi/iscsid.conf dengan mengatur

node.session.timeo.replacement_timeout=5dannode.startup = automatic. Ubah file pada kedua simpul.Jalankan perintah penemuan berikut di kedua node.

iscsiadm -m discovery -t st -p <IP address provided by Service Management>:3260Hasilnya menampilkan empat sesi.

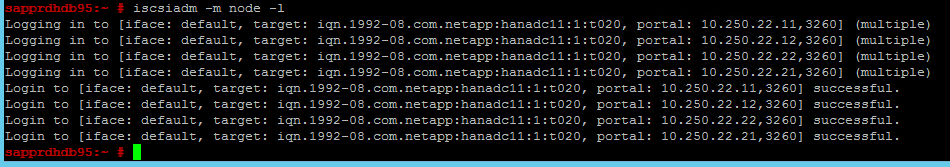

Jalankan perintah berikut di kedua node untuk masuk ke perangkat iSCSI.

iscsiadm -m node -lHasilnya menampilkan empat sesi.

Gunakan perintah berikut untuk menjalankan skrip pemindaian ulang rescan-scsi-bus.sh. Skrip ini menampilkan disk baru yang dibuat untuk Anda. Jalankan di kedua simpul.

rescan-scsi-bus.shHasilnya akan menampilkan angka LUN yang lebih besar dari nol (misalnya: 1, 2, dan sebagainya.).

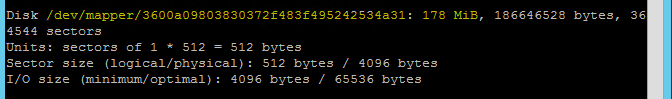

Untuk mendapatkan nama perangkat, jalankan perintah berikut di kedua node.

fdisk –lDi dalam hasil, pilih perangkat dengan ukuran 178 MiB.

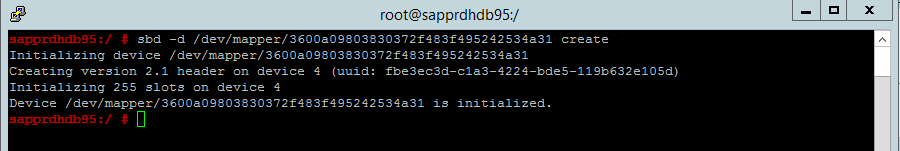

Inisialisasi perangkat SBD

Gunakan perintah berikut untuk menginisialisasi perangkat SBD di kedua node.

sbd -d <SBD Device Name> create

Gunakan perintah berikut di kedua node untuk memeriksa hal yang telah ditulis ke perangkat.

sbd -d <SBD Device Name> dump

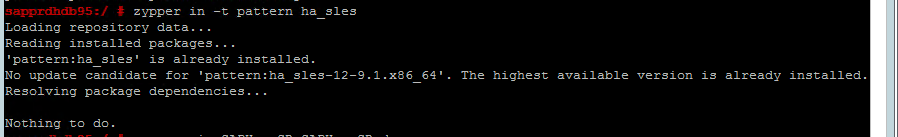

Mengonfigurasi kluster HA SUSE

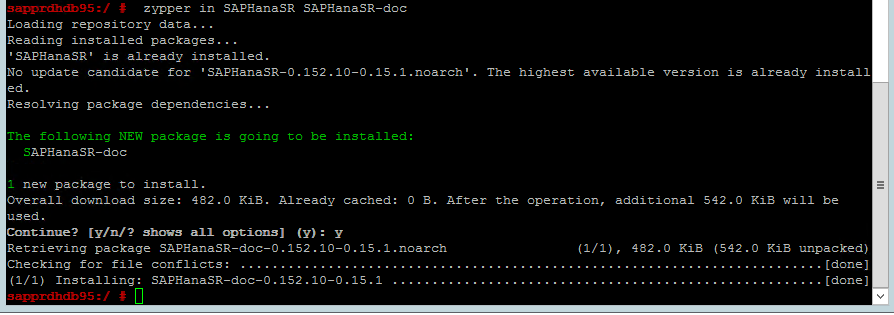

Gunakan perintah berikut untuk memeriksa apakah pola ha_sles dan SAPHanaSR-doc diinstal di kedua node. Jika belum diinstal, instal kedua pola tersebut.

zypper in -t pattern ha_sles zypper in SAPHanaSR SAPHanaSR-doc

Menyiapkan kluster menggunakan perintah

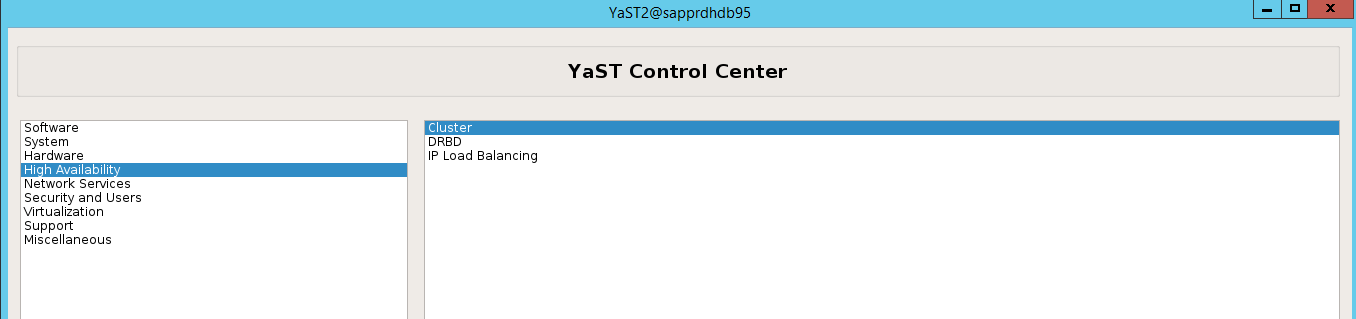

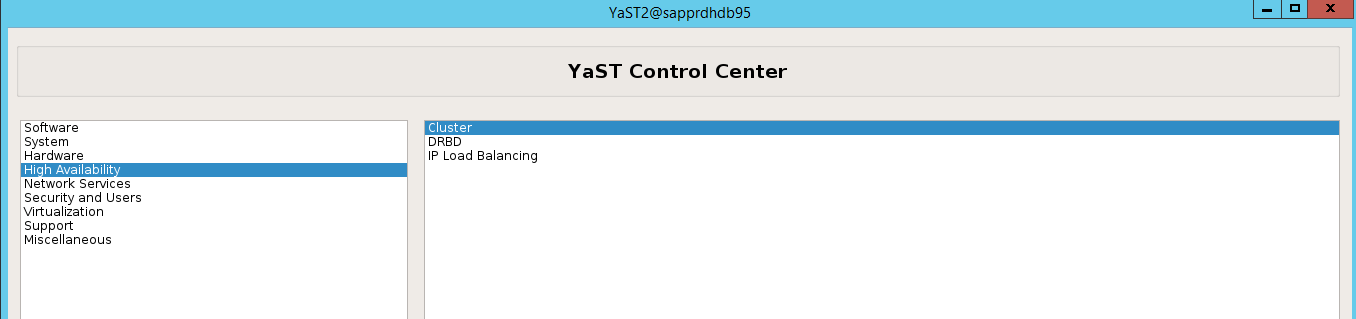

ha-cluster-initatau wizard yast2. Dalam contoh ini, kita menggunakan wizard yast2. Lakukan langkah ini hanya pada node utama.Buka yast2>Ketersediaan Tinggi>Kluster.

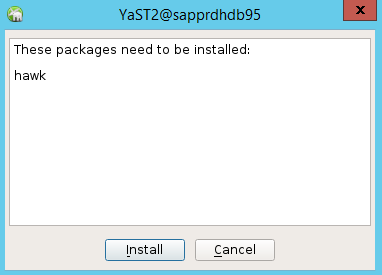

Dalam dialog yang muncul tentang penginstalan paket hawk, pilih Batalkan karena paket halk2 sudah terinstal.

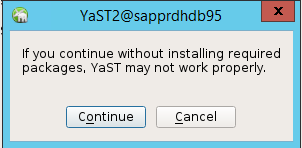

Dalam dialog yang muncul tentang melanjutkan, pilih Lanjutkan.

Nilai yang diharapkan adalah jumlah node yang disebarkan (dalam hal ini, 2). Pilih Selanjutnya.

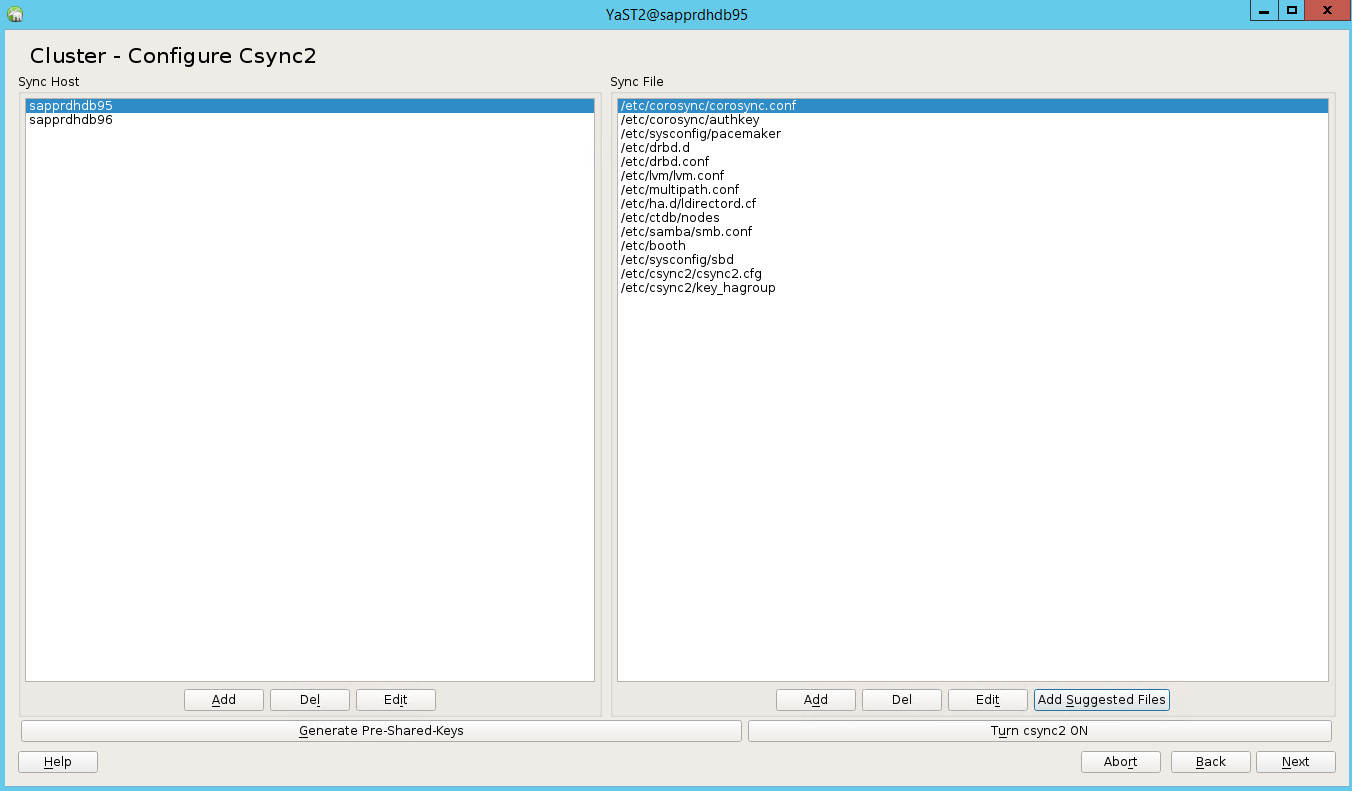

Tambahkan nama node, lalu pilih Tambahkan file yang disarankan.

Pilih Aktifkan csync2.

Pilih Hasilkan Kunci yang Dibagikan Sebelumnya.

Di pesan pop-up yang muncul, pilih OKE.

Autentikasi dilakukan menggunakan alamat IP dan kunci yang dibagikan sebelumnya di Csync2. File kunci dibagikan dengan

csync2 -k /etc/csync2/key_hagroup.Salin secara manual file key_hagroup ke semua anggota kluster setelah dibuat. Pastikan untuk menyalin file dari node1 ke node2. Lalu pilih Berikutnya.

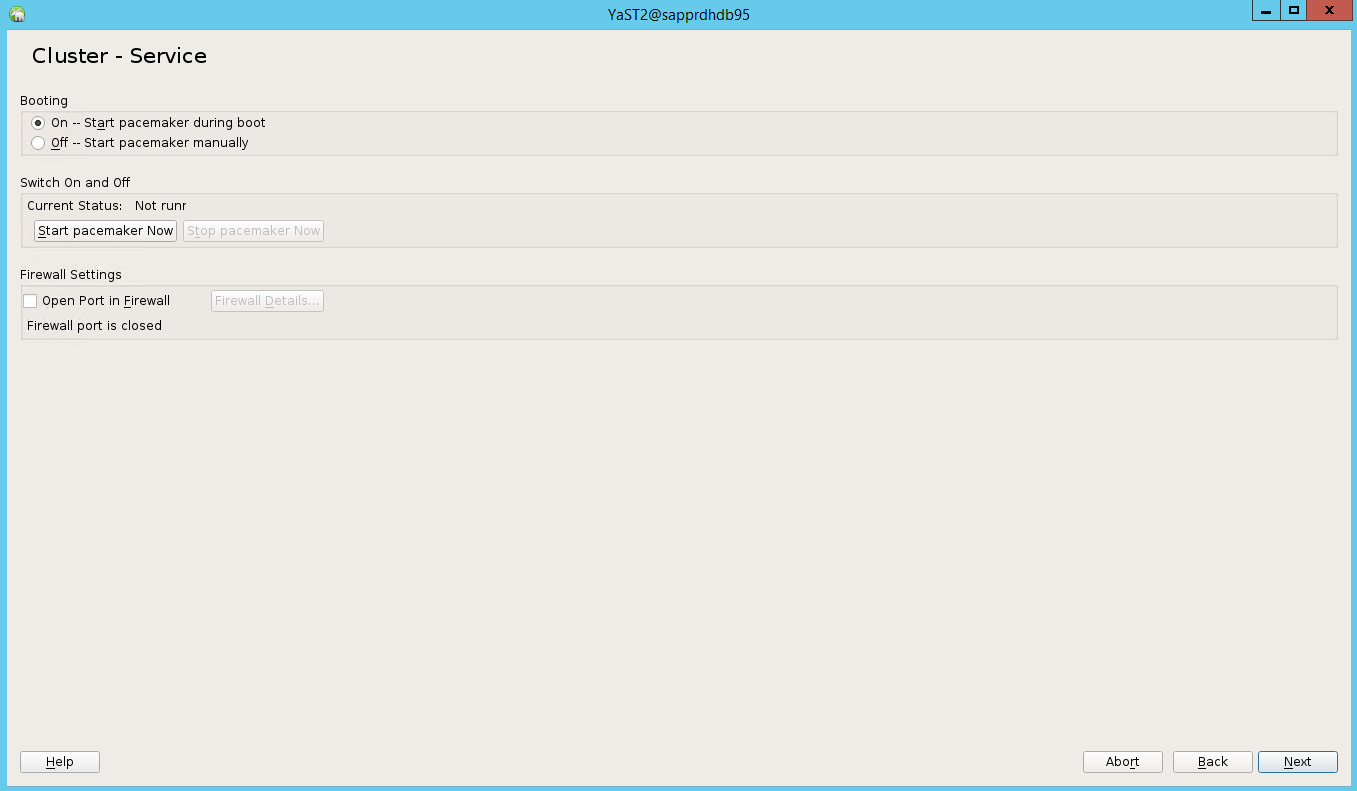

Opsi default Booting adalah Nonaktif. Ubah ke Aktif agar alat pacemaker akan dimulai saat booting. Anda dapat membuat pilihan berdasarkan persyaratan penyetelan Anda.

Pilih Berikutnya, dan konfigurasi kluster selesai.

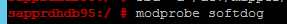

Siapkan pengawas softdog

Tambahkan baris berikut ke /etc/init.d/boot.local di kedua node.

modprobe softdog

Gunakan perintah berikut untuk memperbarui file /etc/sysconfig/sbd di kedua node.

SBD_DEVICE="<SBD Device Name>"

Muat modul kernel di kedua node dengan menjalankan perintah berikut.

modprobe softdog

Gunakan perinth berikut untuk memastikan bahwa softdog berjalan di kedua node.

lsmod | grep dog

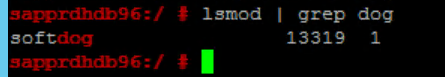

Gunakan perintah berikut untuk memulai perangkat SBD di kedua node.

/usr/share/sbd/sbd.sh start

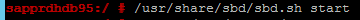

Gunakan perintah berikut untuk menguji daemon SBD di kedua node.

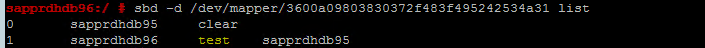

sbd -d <SBD Device Name> listHasilnya menampilkan dua entri setelah konfigurasi di kedua node.

Kirim pesan pengujian berikut ke salah satu node.

sbd -d <SBD Device Name> message <node2> <message>Pada node kedua (node2), gunakan perintah berikut untuk memeriksa status pesan.

sbd -d <SBD Device Name> list

Untuk mengadopsi konfigurasi SBD, perbarui file /etc/sysconfig/sbd seperti berikut di kedua node.

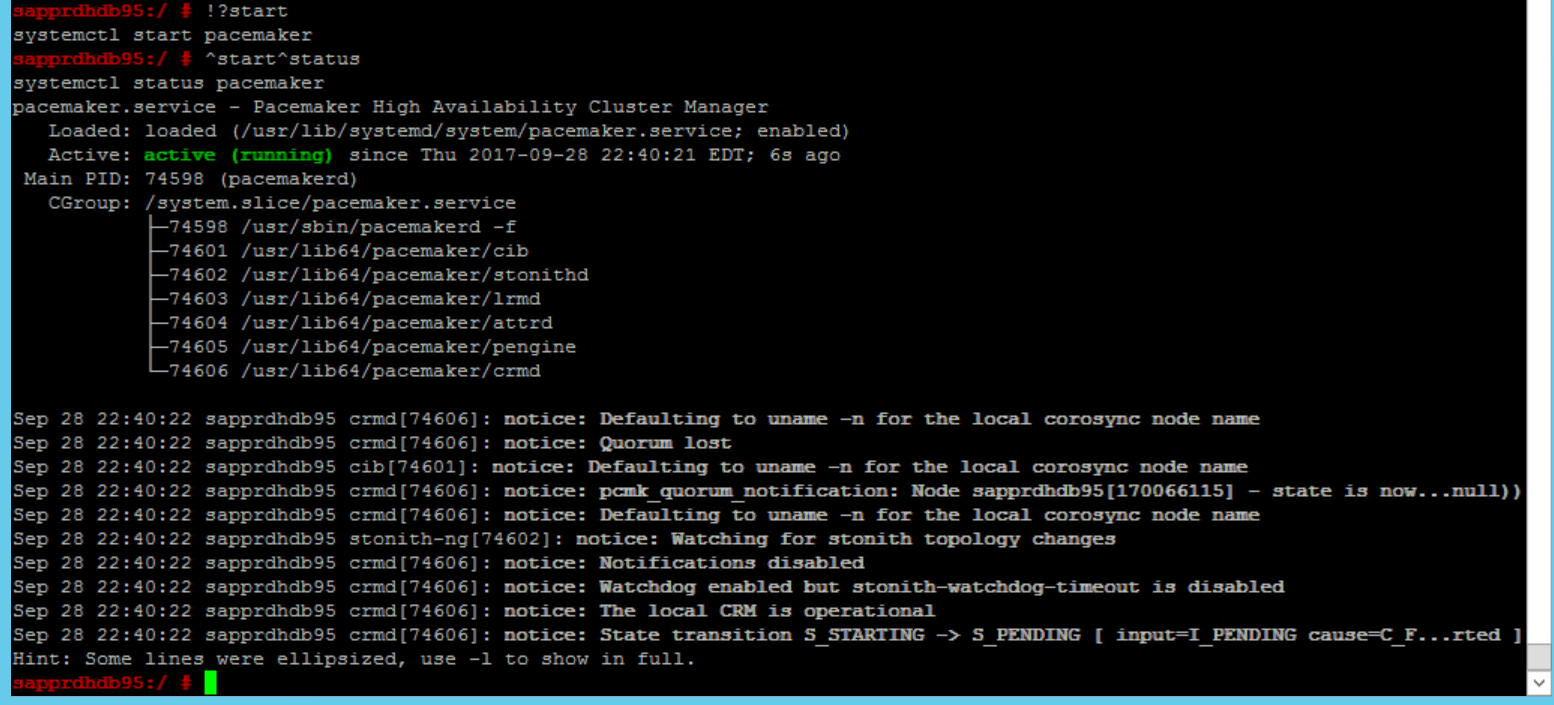

SBD_DEVICE=" <SBD Device Name>" SBD_WATCHDOG="yes" SBD_PACEMAKER="yes" SBD_STARTMODE="clean" SBD_OPTS=""Gunakan perintah berikut untuk memulai layanan pacemaker di node utama (node1).

systemctl start pacemaker

Jika layanan pacemaker gagal, lihat bagian Skenario 5: Layanan Pacemaker gagal nanti di artikel ini.

Menggabungkan node ke kluster

Jalankan perintah berikut di node2 untuk membuat node tersebut bergabung dengan kluster.

ha-cluster-join

Jika Anda menerima kesalahan saat bergabung dengan kluster, lihat bagian Skenario 6: Node2 tidak dapat bergabung dengan kluster nanti di artikel ini.

Memvalidasi kluster

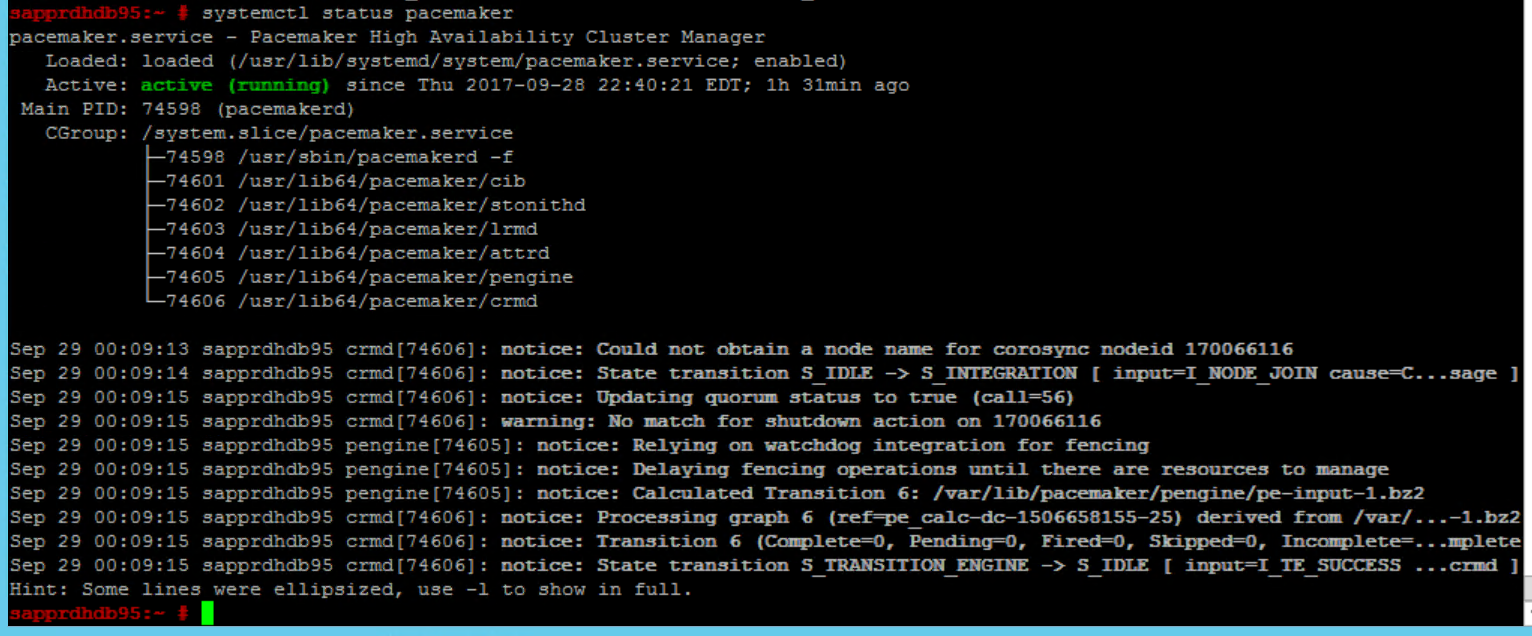

Gunakan perintah berikut untuk memeriksa dan secara opsional memulai kluster untuk pertama kali di kedua node.

systemctl status pacemaker systemctl start pacemaker

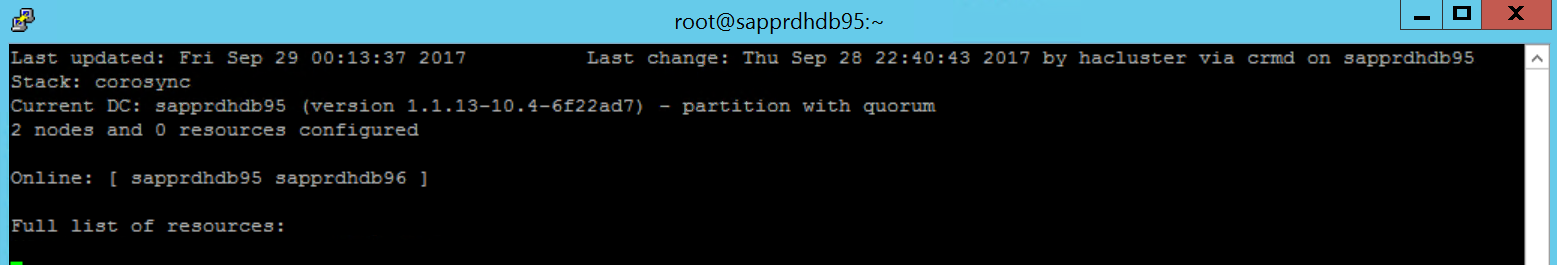

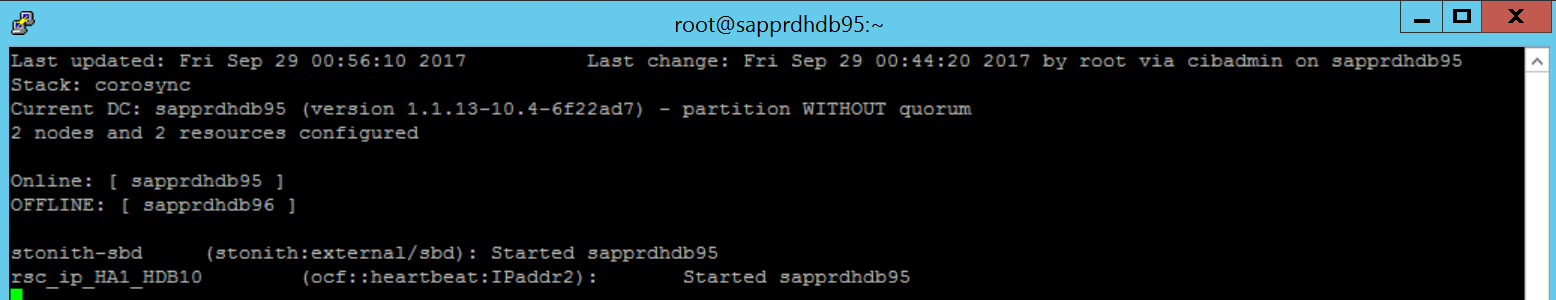

Jalankan perintah berikut untuk memastikan bahwa kedua node sedang online. Anda dapat menjalankannya di salah satu simpul kluster.

crm_mon

Anda juga dapat masuk ke hawk untuk memeriksa status kluster:

https://\<node IP>:7630. Pengguna default adalah hacluster dan kata sandinya adalah linux. Jika perlu, Anda dapat mengubah kata sandi menggunakan perintahpasswd.

Konfigurasikan properti dan sumber daya kluster

Bagian ini menjelaskan langkah-langkah untuk mengonfigurasi sumber daya kluster. Pada contoh ini, Anda menyiapkan sumber daya berikut. Anda dapat mengonfigurasi sisanya (jika diperlukan) dengan merujuk panduan HA SUSE.

- Bootstrap kluster

- Perangkat pagar

- Alamat IP Virtual

Lakukan konfigurasi di node utama saja.

Buat file bootstrap kluster dan konfigurasikan dengan menambahkan teks berikut.

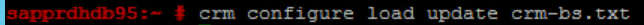

sapprdhdb95:~ # vi crm-bs.txt # enter the following to crm-bs.txt property $id="cib-bootstrap-options" \ no-quorum-policy="ignore" \ stonith-enabled="true" \ stonith-action="reboot" \ stonith-timeout="150s" rsc_defaults $id="rsc-options" \ resource-stickiness="1000" \ migration-threshold="5000" op_defaults $id="op-options" \ timeout="600"Gunakan perintah berikut untuk menambahkan konfigurasi ke kluster.

crm configure load update crm-bs.txt

Konfigurasikan perangkat pagar dengan menambahkan sumber daya, membuat file, dan menambahkan teks sebagai berikut.

# vi crm-sbd.txt # enter the following to crm-sbd.txt primitive stonith-sbd stonith:external/sbd \ params pcmk_delay_max="15"Gunakan perintah berikut untuk menambahkan konfigurasi ke kluster.

crm configure load update crm-sbd.txtTambahkan alamat IP virtual untuk sumber daya dengan membuat file dan menambahkan teks berikut.

# vi crm-vip.txt primitive rsc_ip_HA1_HDB10 ocf:heartbeat:IPaddr2 \ operations $id="rsc_ip_HA1_HDB10-operations" \ op monitor interval="10s" timeout="20s" \ params ip="10.35.0.197"Gunakan perintah berikut untuk menambahkan konfigurasi ke kluster.

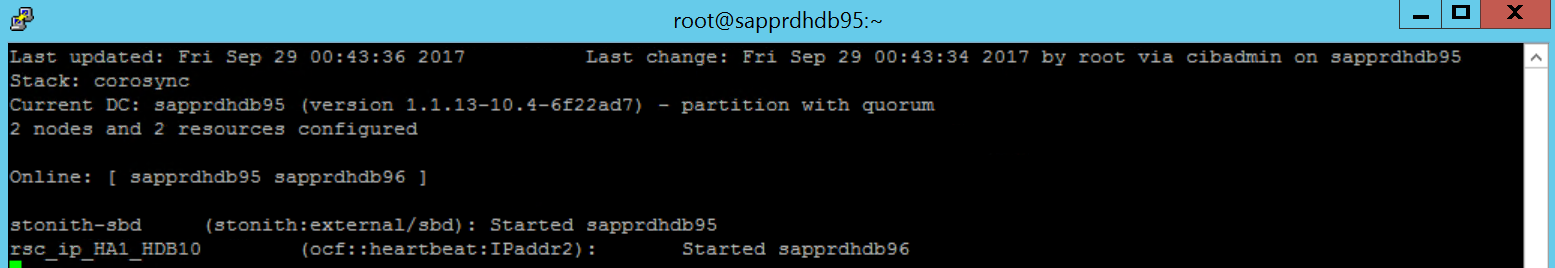

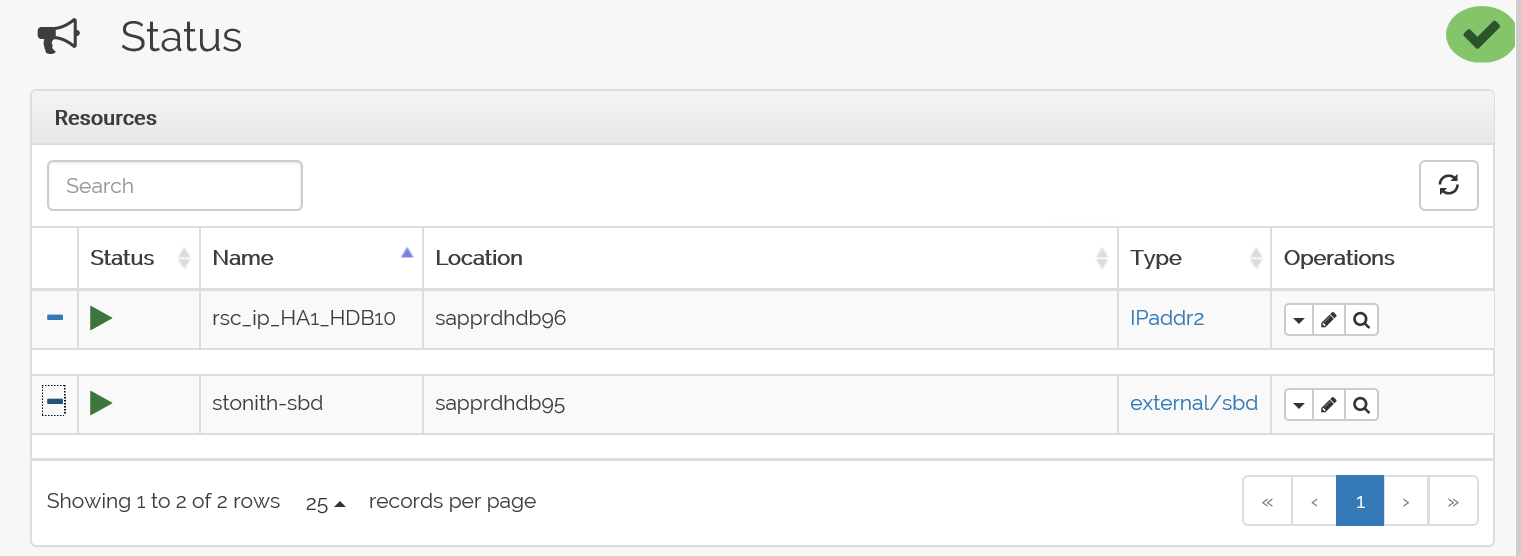

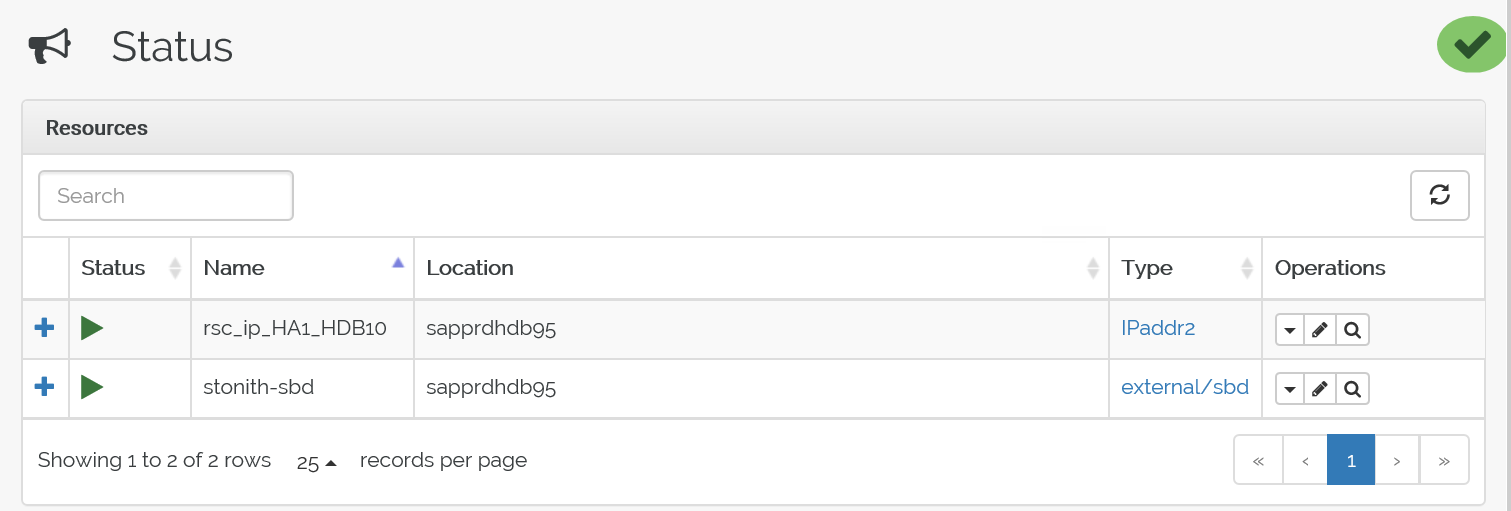

crm configure load update crm-vip.txtGunakan perintah

crm_monuntuk memvalidasi sumber daya.Hasilnya menampilkan dua sumber daya.

Anda juga dapat memeriksa statusnya di https://<alamat IP node>:7630/cib/live/state.

Uji proses kegagalan

Untuk menguji proses failover, gunakan perintah berikut untuk menghentikan layanan pacemaker di node1.

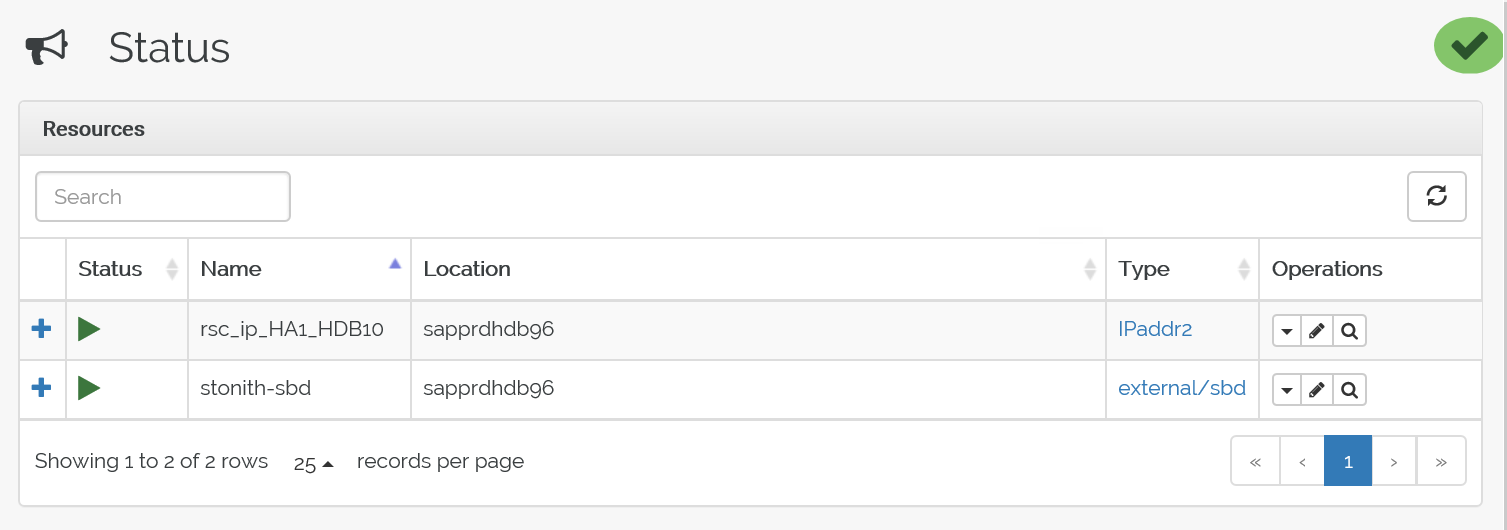

Service pacemaker stopSumber daya failover ke node2.

Hentikan layanan pacemaker di node2 dan lakukan failover sumber daya ke node1.

Berikut adalah status sebelum failover:

Berikut adalah status setelah failover:

Pemecahan Masalah

Bagian ini menjelaskan skenario kegagalan yang mungkin Anda temui selama penyiapan.

Skenario 1: Node kluster tidak online

Jika salah satu node tidak menampilkan status online di Manajer Kluster, Anda dapat mencoba prosedur berikut untuk membuatnya online.

Gunakan perintah berikut untuk memulai layanan iSCSI.

service iscsid startGunakan perintah berikut untuk masuk ke node iSCSI tersebut.

iscsiadm -m node -lOutput yang diharapkan terlihat seperti:

sapprdhdb45:~ # iscsiadm -m node -l Logging in to [iface: default, target: iqn.1992-08.com.netapp:hanadc11:1:t020, portal: 10.250.22.11,3260] (multiple) Logging in to [iface: default, target: iqn.1992-08.com.netapp:hanadc11:1:t020, portal: 10.250.22.12,3260] (multiple) Logging in to [iface: default, target: iqn.1992-08.com.netapp:hanadc11:1:t020, portal: 10.250.22.22,3260] (multiple) Logging in to [iface: default, target: iqn.1992-08.com.netapp:hanadc11:1:t020, portal: 10.250.22.21,3260] (multiple) Login to [iface: default, target: iqn.1992-08.com.netapp:hanadc11:1:t020, portal: 10.250.22.11,3260] successful. Login to [iface: default, target: iqn.1992-08.com.netapp:hanadc11:1:t020, portal: 10.250.22.12,3260] successful. Login to [iface: default, target: iqn.1992-08.com.netapp:hanadc11:1:t020, portal: 10.250.22.22,3260] successful. Login to [iface: default, target: iqn.1992-08.com.netapp:hanadc11:1:t020, portal: 10.250.22.21,3260] successful.

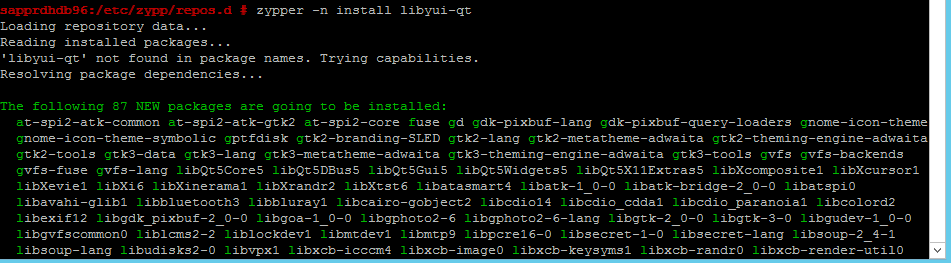

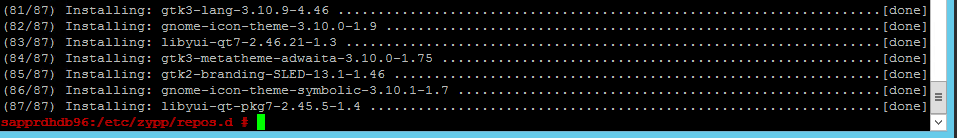

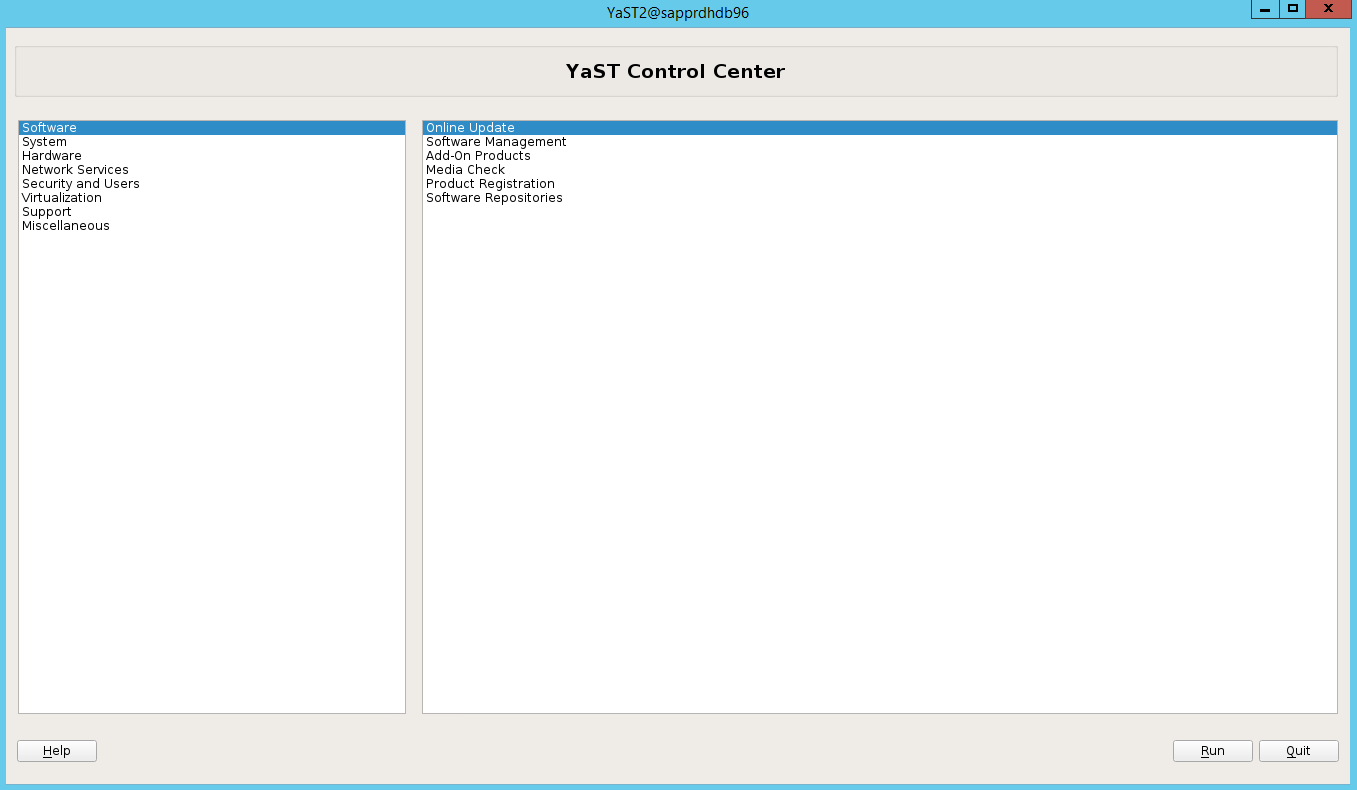

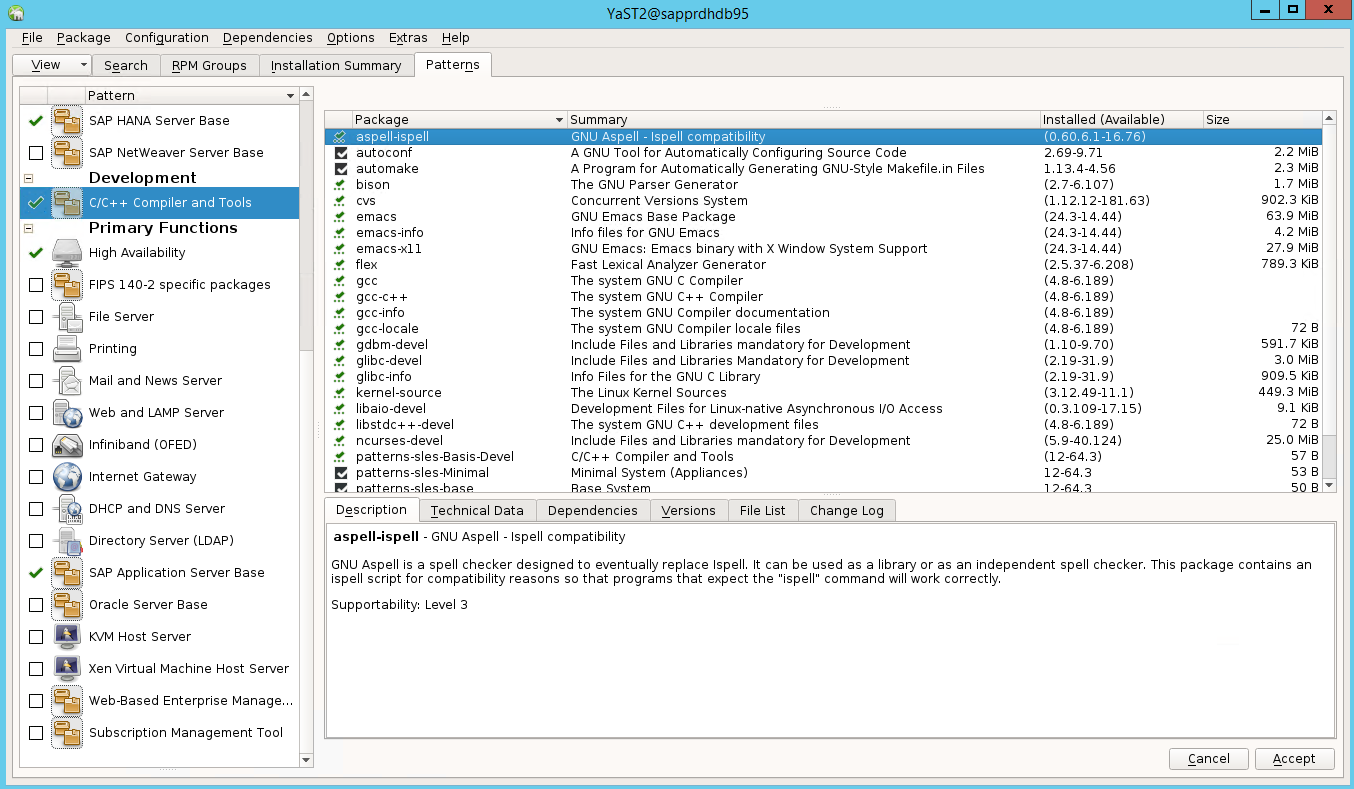

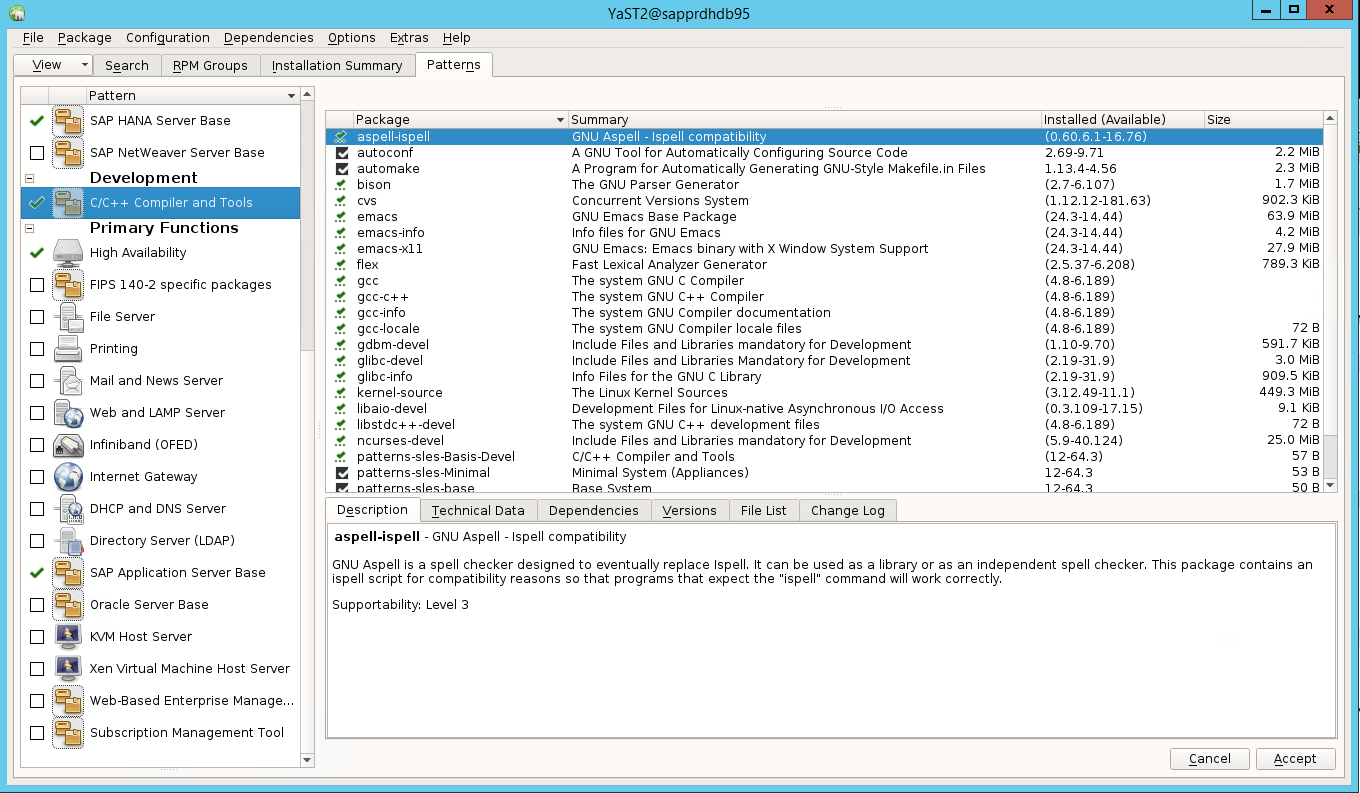

Skenario 2: Yast2 tidak menampilkan tampilan grafis

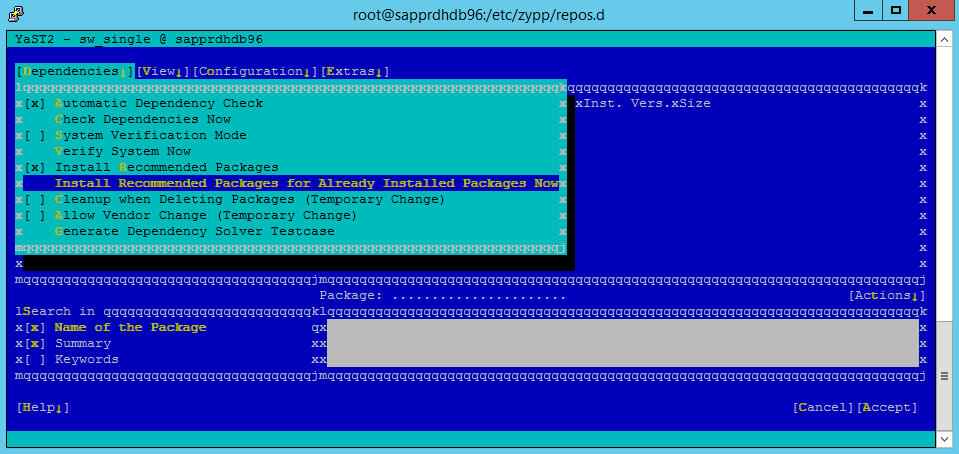

Layar grafis yast2 digunakan untuk menyiapkan kluster ketersediaan tinggi dalam artikel ini. Jika yast2 tidak terbuka dengan jendela grafis seperti yang ditampilkan dan memunculkan kesalahan Qt, lakukan langkah-langkah berikut untuk menginstal paket yang diperlukan. Jika yast2 terbuka dengan jendela grafis, Anda dapat melewati langkah-langkah ini.

Berikut adalah contoh kesalahan Qt:

Berikut adalah contoh output yang diharapkan:

Pastikan Anda masuk sebagai pengguna "root" dan menyiapkan SMT untuk mengunduh dan menginstal paket.

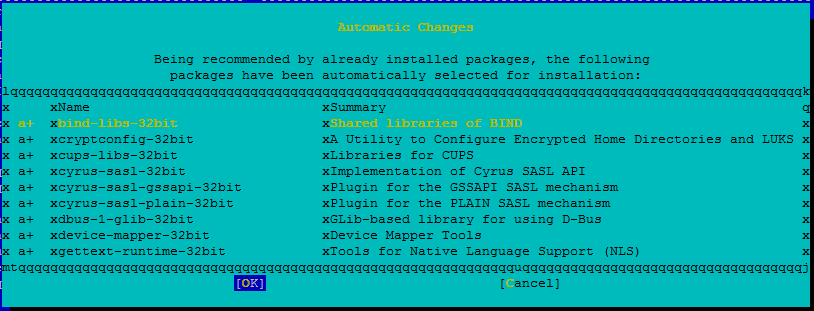

Buka Yast>Perangkat Lunak>Manajemen Perangkat Lunak>Dependensi, lalu pilih Instal paket yang direkomendasikan.

Catatan

Lakukan langkah-langkah tersebut di kedua node, sehingga Anda dapat mengakses tampilan grafis yast2 dari kedua node.

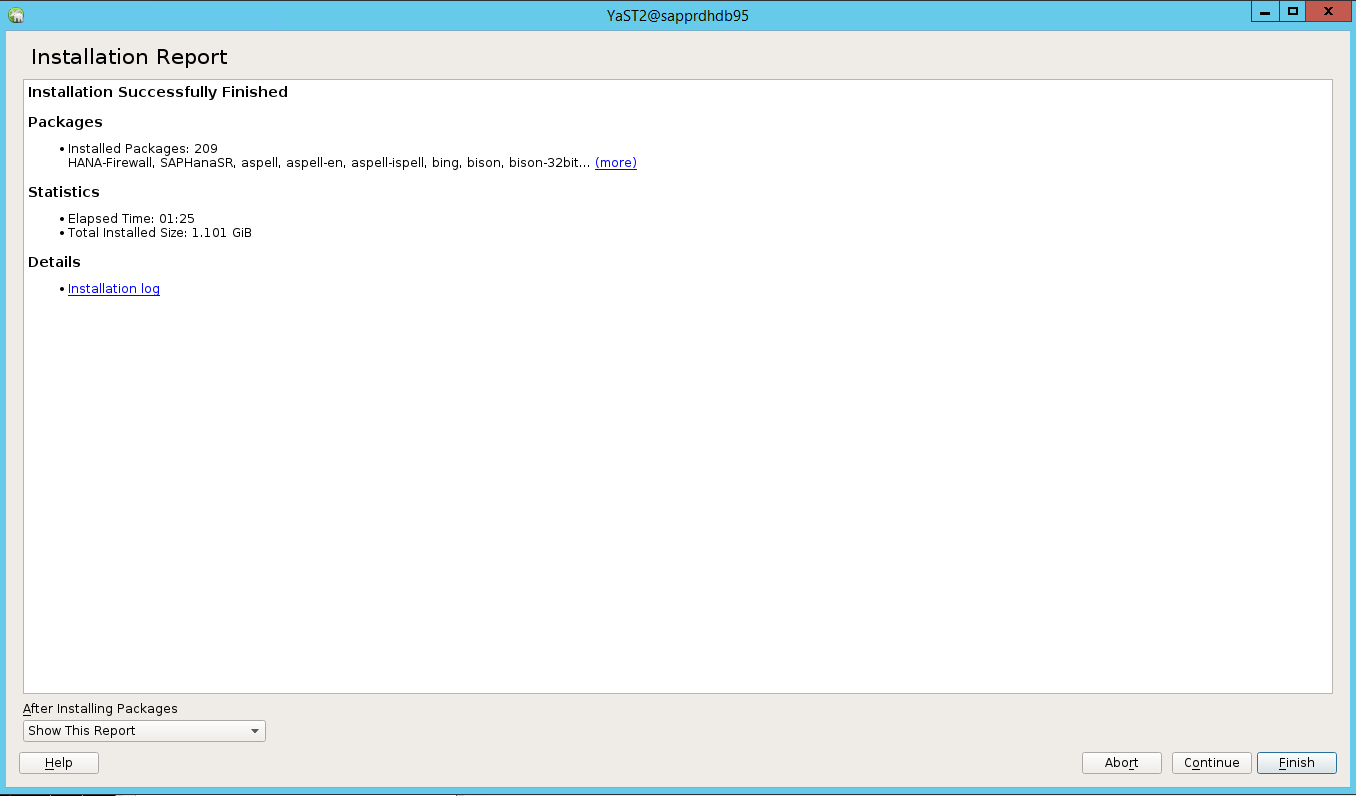

Cuplikan layar berikut menampilkan layar diharapkan.

Di bawah Dependensi, pilih Instal Paket yang Direkomendasikan.

Tinjau perubahan dan pilih OK.

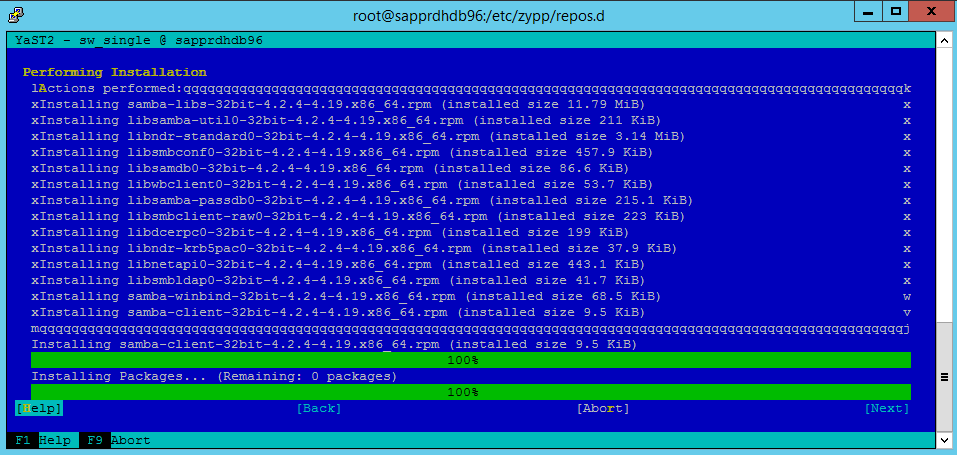

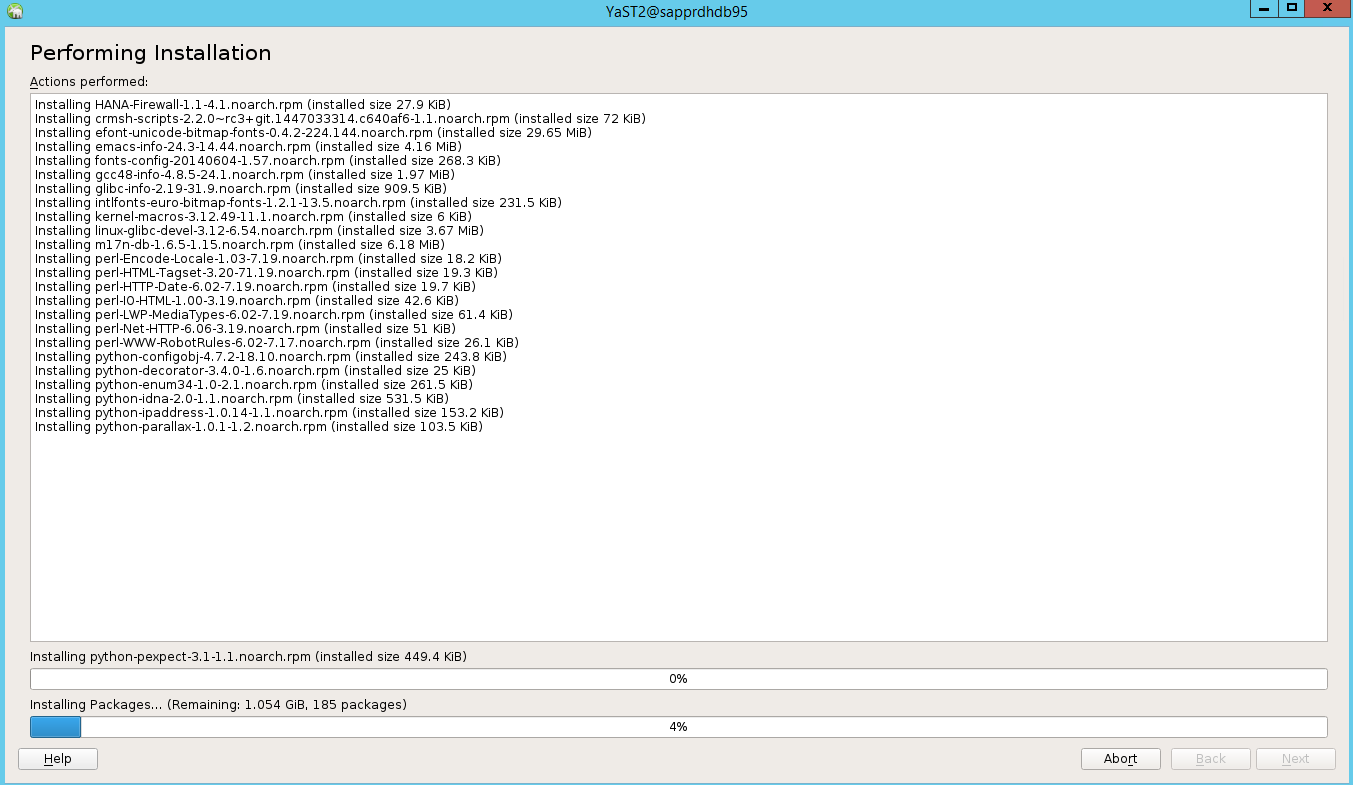

Penginstalan paket berlangsung.

Pilih Selanjutnya.

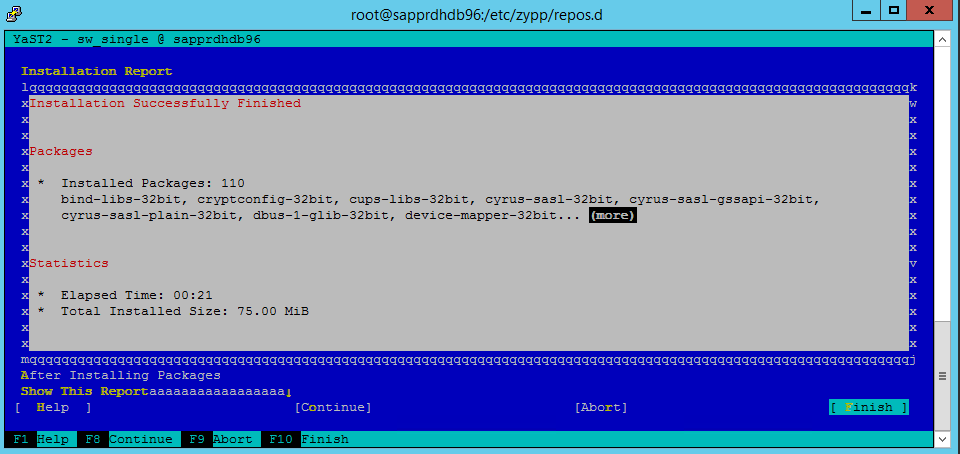

Ketika layar Penginstalan Berhasil muncul, pilih Selesai.

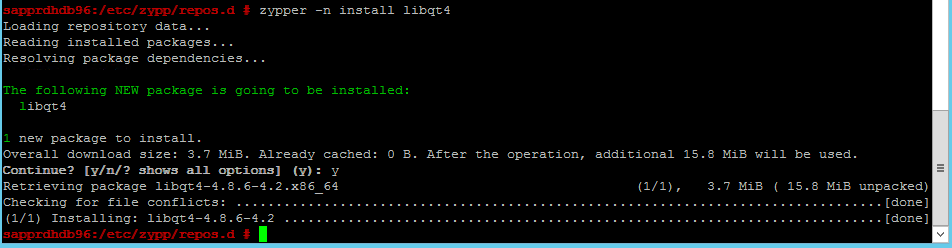

Jalankan perintah berikut untuk menginstal paket libqt4 dan libyui-qt.

zypper -n install libqt4

zypper -n install libyui-qt

Yast2 kini dapat membuka tampilan grafis.

Skenario 3: Yast2 tidak menampilkan opsi ketersediaan tinggi

Agar opsi ketersediaan tinggi terlihat di pusat kontrol yast2, Anda perlu menginstal paket lainnya.

Buka Yast2>Perangkat Lunak>Manajemen Perangkat Lunak. Kemudian pilih Perangkat Lunak>Pembaruan Online.

Pilih pola untuk item berikut. Lalu pilih Terima.

- Basis server SAP HANA

- Pengompilasi dan alat C/C++

- Ketersediaan tinggi

- Basis server aplikasi SAP

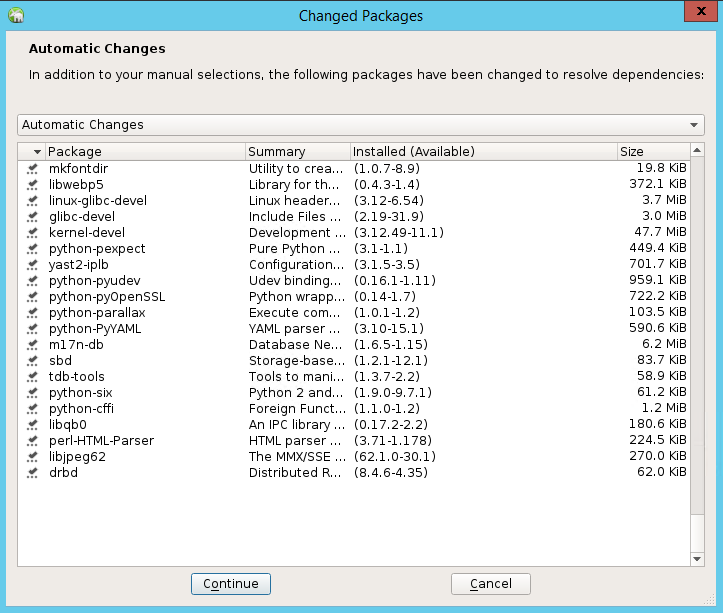

Dalam daftar paket yang telah diubah untuk menyelesaikan dependensi, pilih Lanjutkan.

Di halaman status Melakukan Penginstalan, pilih Berikutnya.

Ketika penginstalan selesai, laporan penginstalan muncul. Pilih Selesai.

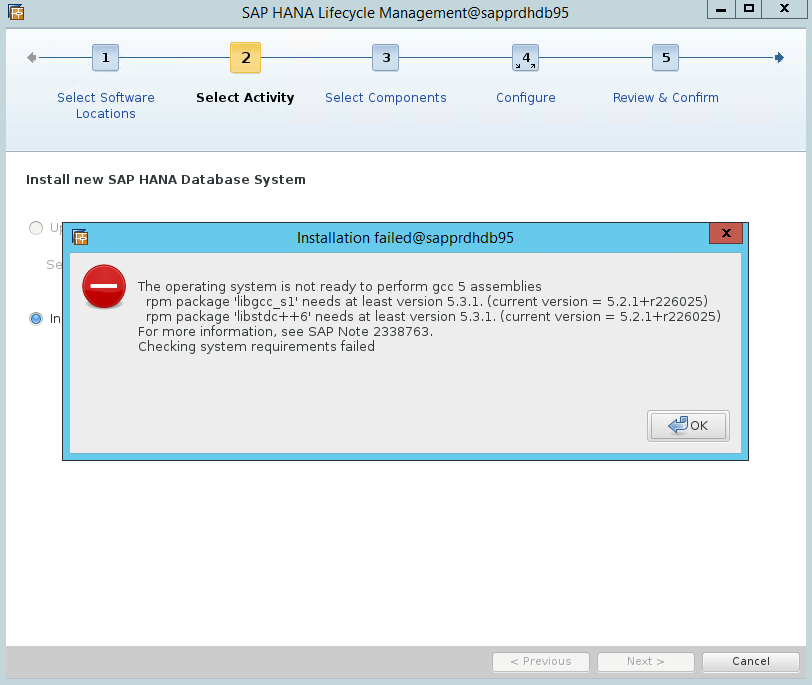

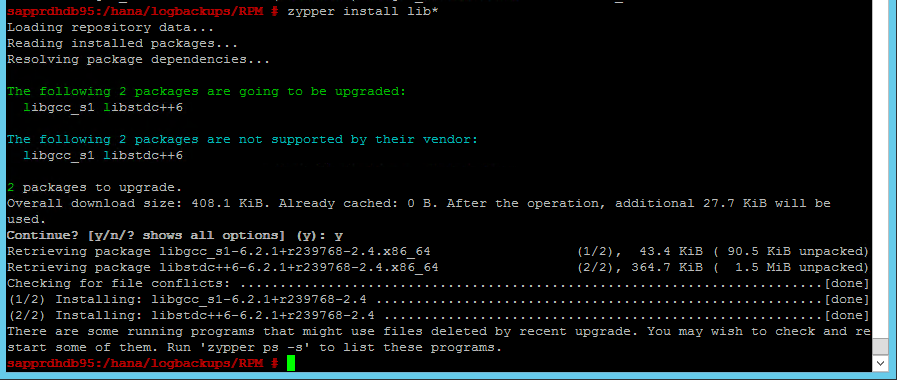

Skenario 4: Penginstalan HANA gagal dengan kesalahan rakitan gcc

Jika penginstalan HANA gagal, Anda mungkin mendapatkan kesalahan berikut.

Untuk memperbaiki masalah, instal pustaka libgcc_sl dan libstdc++6 seperti yang ditampilkan pada cuplikan layar berikut.

Skenario 5: Layanan pacemaker gagal

Informasi berikut muncul jika layanan apacemaker tidak dapat dimulai.

sapprdhdb95:/ # systemctl start pacemaker

A dependency job for pacemaker.service failed. See 'journalctl -xn' for details.

sapprdhdb95:/ # journalctl -xn

-- Logs begin at Thu 2017-09-28 09:28:14 EDT, end at Thu 2017-09-28 21:48:27 EDT. --

Sep 28 21:48:27 sapprdhdb95 corosync[68812]: [SERV ] Service engine unloaded: corosync configuration map

Sep 28 21:48:27 sapprdhdb95 corosync[68812]: [QB ] withdrawing server sockets

Sep 28 21:48:27 sapprdhdb95 corosync[68812]: [SERV ] Service engine unloaded: corosync configuration ser

Sep 28 21:48:27 sapprdhdb95 corosync[68812]: [QB ] withdrawing server sockets

Sep 28 21:48:27 sapprdhdb95 corosync[68812]: [SERV ] Service engine unloaded: corosync cluster closed pr

Sep 28 21:48:27 sapprdhdb95 corosync[68812]: [QB ] withdrawing server sockets

Sep 28 21:48:27 sapprdhdb95 corosync[68812]: [SERV ] Service engine unloaded: corosync cluster quorum se

Sep 28 21:48:27 sapprdhdb95 corosync[68812]: [SERV ] Service engine unloaded: corosync profile loading s

Sep 28 21:48:27 sapprdhdb95 corosync[68812]: [MAIN ] Corosync Cluster Engine exiting normally

Sep 28 21:48:27 sapprdhdb95 systemd[1]: Dependency failed for Pacemaker High Availability Cluster Manager

-- Subject: Unit pacemaker.service has failed

-- Defined-By: systemd

-- Support: https://lists.freedesktop.org/mailman/listinfo/systemd-devel

--

-- Unit pacemaker.service has failed.

--

-- The result is dependency.

sapprdhdb95:/ # tail -f /var/log/messages

2017-09-28T18:44:29.675814-04:00 sapprdhdb95 corosync[57600]: [QB ] withdrawing server sockets

2017-09-28T18:44:29.676023-04:00 sapprdhdb95 corosync[57600]: [SERV ] Service engine unloaded: corosync cluster closed process group service v1.01

2017-09-28T18:44:29.725885-04:00 sapprdhdb95 corosync[57600]: [QB ] withdrawing server sockets

2017-09-28T18:44:29.726069-04:00 sapprdhdb95 corosync[57600]: [SERV ] Service engine unloaded: corosync cluster quorum service v0.1

2017-09-28T18:44:29.726164-04:00 sapprdhdb95 corosync[57600]: [SERV ] Service engine unloaded: corosync profile loading service

2017-09-28T18:44:29.776349-04:00 sapprdhdb95 corosync[57600]: [MAIN ] Corosync Cluster Engine exiting normally

2017-09-28T18:44:29.778177-04:00 sapprdhdb95 systemd[1]: Dependency failed for Pacemaker High Availability Cluster Manager.

2017-09-28T18:44:40.141030-04:00 sapprdhdb95 systemd[1]: [/usr/lib/systemd/system/fstrim.timer:8] Unknown lvalue 'Persistent' in section 'Timer'

2017-09-28T18:45:01.275038-04:00 sapprdhdb95 cron[57995]: pam_unix(crond:session): session opened for user root by (uid=0)

2017-09-28T18:45:01.308066-04:00 sapprdhdb95 CRON[57995]: pam_unix(crond:session): session closed for user root

Untuk memperbaikinya, hapus baris berikut dari file /usr/lib/systemd/system/fstrim.timer:

Persistent=true

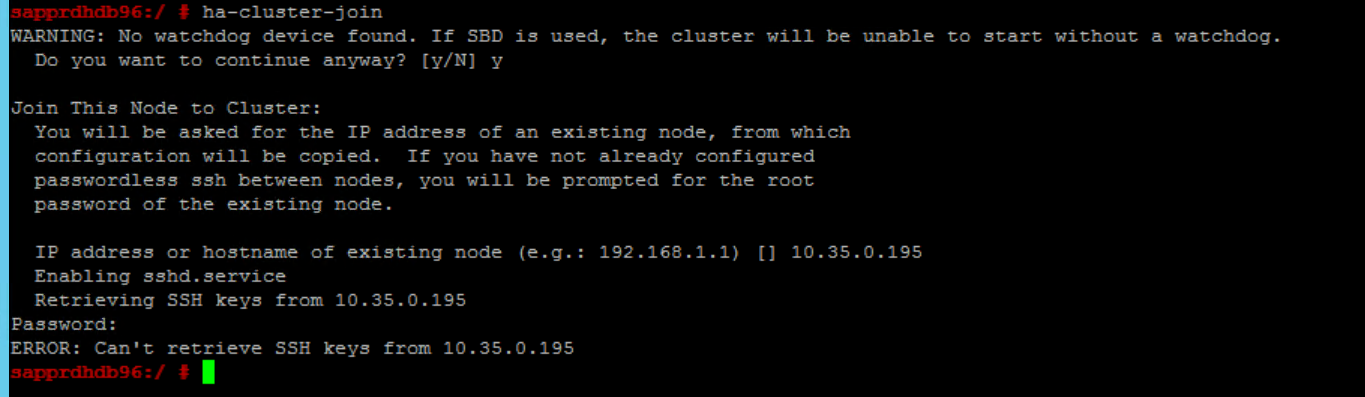

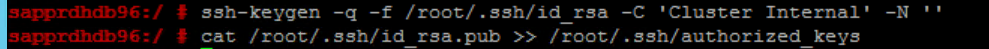

Skenario 6: Node2 tidak dapat bergabung dengan kluster

Kesalahan berikut muncul jika ada masalah saat menggabungkan node2 ke kluster yang ada melalui perintah ha-cluster-join.

ERROR: Can’t retrieve SSH keys from <Primary Node>

Cara memperbaikinya:

Jalankan perintah berikut di kedua node.

ssh-keygen -q -f /root/.ssh/id_rsa -C 'Cluster Internal' -N '' cat /root/.ssh/id_rsa.pub >> /root/.ssh/authorized_keys

Konfirmasikan bahwa node2 ditambahkan ke kluster.

Langkah berikutnya

Anda dapat menemukan informasi selengkapnya tentang penyetelan SUSE HA di artikel berikut:

- Skenario Performa SAP HANA SR yang Dioptimalkan (situs web SUSE)

- Perangkat pagar dan pagar (situs web SUSE)

- Bersiaplah untuk Menggunakan Kluster Pacemaker untuk SAP HANA – Bagian 1: Dasar-dasar (blog SAP)

- Bersiaplah untuk Menggunakan Kluster Pacemaker untuk SAP HANA – Bagian 2: Kegagalan di Kedua Node (blog SAP)

- Pencadangan dan pemulihan OS