Menyebarkan sistem peluasan skala SAP Hana dengan simpul siaga di VM Azure menggunakan Azure NetApp Files di Linux Red Hat Enterprise

Artikel ini menjelaskan cara menyebarkan sistem SAP Hana dengan ketersediaan tinggi dalam konfigurasi peluasan skala dengan siaga di mesin virtual (VM) Azure Red Hat Enterprise Linux, dengan menggunakan Azure NetApp Files untuk volume penyimpanan bersama.

Dalam contoh konfigurasi, perintah penginstalan, dan sebagainya, instans HANA adalah 03 dan ID sistem HANA adalah HN1. Contohnya didasarkan pada Hana 2.0 SP4 dan Red Hat Enterprise Linux untuk SAP 7.6.

Catatan

Artikel ini berisi referensi ke istilah yang tidak lagi digunakan Microsoft. Saat istilah ini dihapus dari perangkat lunak, kami akan menghapusnya dari artikel ini.

Sebelum Anda mulai, lihat catatan dan makalah SAP berikut:

- Dokumentasi Azure NetApp Files

- Catatan SAP 1928533 meliputi:

- Daftar ukuran Azure VM yang didukung untuk penyebaran perangkat lunak SAP

- Informasi kapasitas penting untuk ukuran Azure komputer virtual

- Perangkat lunak SAP yang didukung, sistem operasi (OS), dan kombinasi database

- Versi kernel SAP yang diperlukan untuk Windows dan Linux di Microsoft Azure

- Catatan SAP2015553: Memuat prasyarat untuk penyebaran perangkat lunak SAP yang didukung SAP di Azure

- Catatan SAP [2002167] merekomendasikan pengaturan OS untuk Red Hat Enterprise Linux

- Catatan SAP 2009879 memiliki Panduan SAP Hana untuk Red Hat Enterprise Linux

- Catatan SAP 3108302 memiliki Panduan SAP Hana untuk Red Hat Enterprise Linux 9.x

- Catatan SAP 2178632: Berisi informasi rinci tentang semua metrik pemantauan yang dilaporkan untuk SAP di Azure

- Catatan SAP 2191498: Berisi versi Agen Host SAP yang diperlukan untuk Linux di Azure

- Catatan SAP 2243692: Berisi informasi tentang lisensi SAP pada Linux di Azure

- Catatan SAP 1999351: Berisi informasi pemecahan masalah tambahan atas Azure Enhanced Monitoring Extension untuk SAP

- Catatan SAP 1900823: Berisi informasi tentang persyaratan penyimpanan SAP HANA

- Wiki Komunitas SAP: Berisi semua catatan SAP yang diperlukan untuk Linux

- Microsoft Azure Virtual Machines perencanaan dan penerapan untuk SAP di Linux

- Azure Virtual Machines penyebaran untuk SAP pada Linux

- Penyebaran Azure Virtual Machines DBMS untuk SAP pada Linux

- Dokumentasi RHEL umum

- Dokumentasi RHEL khusus Azure:

- Volume NFS v4.1 di Azure NetApp Files untuk SAP Hana

Gambaran Umum

Salah satu metode untuk mencapai ketersediaan tinggi HANA adalah dengan mengonfigurasi kegagalan otomatis host. Untuk mengonfigurasi kegagalan otomatis host, Anda menambahkan satu atau beberapa komputer virtual ke sistem HANA dan mengonfigurasinya sebagai simpul siaga. Ketika simpul aktif gagal, simpul siaga secara otomatis mengambil alih. Dalam konfigurasi yang disajikan dengan komputer virtual Azure, Anda mencapai kegagalan otomatis dengan menggunakan NFS di Azure NetApp Files.

Catatan

Simpul siaga membutuhkan akses ke semua volume database. Volume HANA harus dipasang sebagai volume NFSv4. Mekanisme penguncian berbasis sewa file yang ditingkatkan dalam protokol NFSv4 digunakan untuk I/O pagar.

Penting

Untuk membangun konfigurasi yang didukung, Anda harus menyebarkan data HANA dan volume log sebagai volume NFSv4.1 dan memasangnya dengan menggunakan protokol NFSv4.1. Konfigurasi kegagalan otomatis host HANA dengan simpul siaga tidak didukung dengan NFSv3.

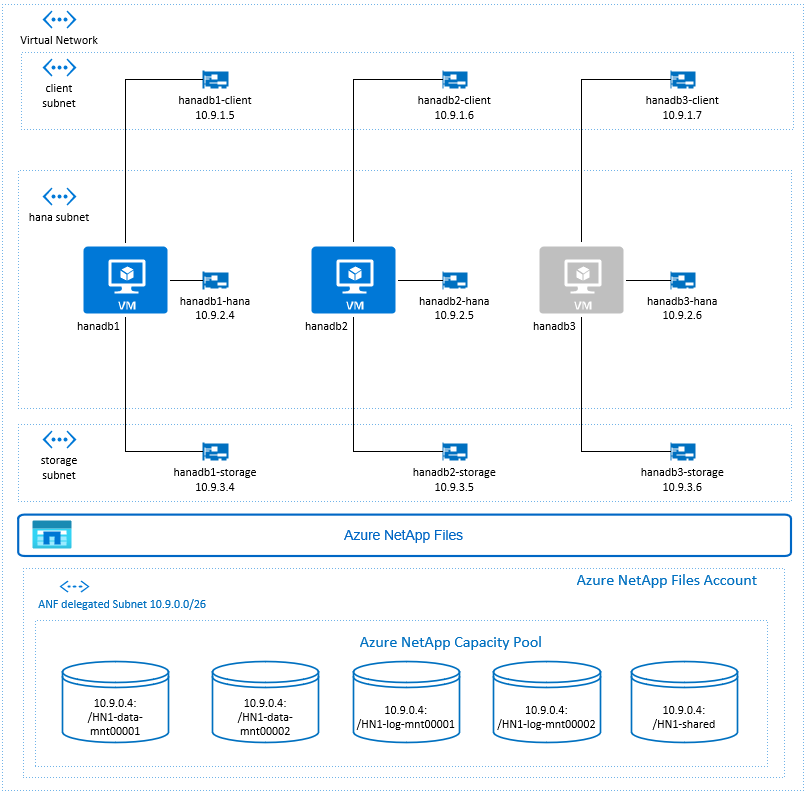

Dalam diagram sebelumnya, yang mengikuti rekomendasi jaringan SAP Hana, tiga subnet diwakili dalam satu jaringan virtual Azure:

- Untuk komunikasi klien

- Untuk komunikasi dengan sistem penyimpanan

- Untuk komunikasi antar-simpul HANA internal

Volume Azure NetApp berada dalam subnet terpisah, ditujukan ke Azure NetApp Files.

Untuk contoh konfigurasi ini, subnet adalah:

client10.9.1.0/26storage10.9.3.0/26hana10.9.2.0/26anf10.9.0.0/26 (subnet yang diserahkan ke Azure NetApp Files)

Menyiapkan infrastruktur Azure NetApp Files

Sebelum Anda melanjutkan penyiapan untuk infrastruktur Azure NetApp Files, biasakan diri Anda dengan dokumentasi Azure NetApp Files.

Azure NetApp Files tersedia di beberapa wilayah Azure. Periksa untuk melihat apakah wilayah Azure yang Anda pilih menawarkan Azure NetApp Files.

Untuk informasi tentang ketersediaan Azure NetApp Files menurut Azure region, lihat Ketersediaan Azure NetApp Files berdasarkan Azure Region.

Pertimbangan penting

Saat Anda membuat volume Azure NetApp Files untuk peluasan skala SAP Hana dengan skenario simpul siaga, ketahui pertimbangan penting yang didokumentasikan dalam volume NFS v4.1 di Azure NetApp Files untuk SAP Hana.

Ukuran untuk database HANA di Azure NetApp Files

Throughput volume Azure NetApp Files adalah fungsi dari ukuran volume dan tingkat layanan, seperti yang didokumentasikan dalam Tingkat layanan untuk Azure NetApp Files.

Saat merancang infrastruktur untuk SAP Hana di Azure dengan Azure NetApp Files, ketahui rekomendasi dalam volume NFS v4.1 di Azure NetApp Files untuk SAP Hana.

Konfigurasi dalam artikel ini disajikan dengan Volume Azure NetApp Files sederhana.

Penting

Untuk sistem produksi, di mana performa adalah kunci, sebaiknya evaluasi dan pertimbangkan untuk menggunakan grup volume aplikasi Azure NetApp Files untuk SAP Hana.

Sebarkan sumber daya Azure NetApp Files

Instruksi berikut mengasumsikan bahwa Anda telah menyebarkan jaringan virtual Azure Anda. Sumber daya dan VM Azure NetApp Files, di mana sumber daya Azure NetApp Files akan dipasang, harus disebarkan di jaringan virtual Azure yang sama atau di jaringan virtual Azure yang diserekan.

Buat akun NetApp di wilayah Azure pilihan Anda dengan mengikuti instruksi di Buat akun NetApp.

Siapkan kumpulan kapasitas Azure NetApp Files dengan mengikuti instruksi pada Menyiapkan kumpulan kapasitas Azure NetApp Files.

Arsitektur HANA yang disajikan dalam artikel ini menggunakan kumpulan kapasitas Azure NetApp Files tunggal di tingkat Layanan Ultra. Untuk beban kerja HANA di Azure, sebaiknya gunakan tingkat layanan Azure NetApp Files Ultra atau Premium.

Delegasikan subnet ke Azure NetApp Files, seperti yang dijelaskan dalam instruksi di Mendelegasikan subnet ke Azure NetApp Files.

Sebarkan volume Azure NetApp Files dengan mengikuti instruksi pada Membuat volume NFS untuk Azure NetApp Files.

Saat Anda menyebarkan volume, pastikan untuk memilih versi NFSv4.1. Sebarkan volume di subnet Azure NetApp Files yang ditunjuk. Alamat IP volume Azure NetApp ditetapkan secara otomatis.

Perlu diingat bahwa sumber daya Azure NetApp Files dan VM Azure harus berada di jaringan virtual Azure yang sama atau di jaringan virtual Azure yang diserekan. Misalnya, HN1-data-mnt00001, HN1-log-mnt00001, dan sebagainya, adalah nama volume dan nfs://10.9.0.4/HN1-data-mnt00001, nfs://10.9.0.4/HN1-log-mnt00001, dan sebagainya, adalah jalur file untuk volume Azure NetApp Files.

- volume HN1-data-mnt00001 (nfs://10.9.0.4/HN1-data-mnt00001)

- volume HN1-data-mnt00002 (nfs://10.9.0.4/HN1-data-mnt00002)

- volume HN1-log-mnt00001 (nfs://10.9.0.4/HN1-log-mnt00001)

- volume HN1-log-mnt00002 (nfs://10.9.0.4/HN1-log-mnt00002)

- volume HN1-shared (nfs://10.9.0.4/HN1-shared)

Dalam contoh ini, kami menggunakan volume Azure NetApp Files terpisah untuk setiap data HANA dan volume log. Untuk konfigurasi yang lebih hemat biaya pada sistem yang lebih kecil atau tidak produktif, Anda dapat menempatkan semua data dipasang pada satu volume dan semua log dipasang pada volume tunggal yang berbeda.

Sebarkan komputer virtual Linux melalui portal Microsoft Azure

Pertama, Anda perlu membuat volume Azure NetApp Files. Kemudian lakukan langkah-langkah berikut:

Buat subnet jaringan virtual Azure di jaringan virtual Azure Anda.

Menyebarkan komputer virtual.

Buat antarmuka jaringan tambahan, dan lampirkan antarmuka jaringan ke VM yang sesuai.

Setiap komputer virtual memiliki tiga antarmuka jaringan, yang sesuai dengan tiga subnet jaringan virtual Azure (

client,storagedanhana).Untuk informasi lebih lanjut, lihat Membuat komputer virtual Linux di Azure dengan beberapa kartu antarmuka jaringan.

Penting

Untuk beban kerja SAP Hana, latensi rendah sangat penting. Untuk mencapai latensi rendah, bekerjalah dengan perwakilan Microsoft Anda untuk memastikan bahwa komputer virtual dan volume Azure NetApp Files disebarkan dalam jarak dekat. Saat Anda melakukan onboarding sistem SAP Hana baru yang menggunakan Azure NetApp Files SAP Hana, kirimkan informasi yang diperlukan.

Instruksi berikutnya mengasumsikan bahwa Anda telah membuat grup sumber daya, jaringan virtual Azure, dan tiga subnet jaringan virtual Azure: client, storage dan hana. Saat Anda menerapkan VM, pilih subnet klien, sehingga antarmuka jaringan klien adalah antarmuka utama pada VM. Anda juga perlu mengonfigurasi rute eksplisit ke subnet yang ditujukan Azure NetApp Files melalui gateway subnet penyimpanan.

Penting

Pastikan OS yang Anda pilih bersertifikat SAP untuk SAP Hana pada jenis VM tertentu yang Anda gunakan. Untuk daftar jenis VM bersertifikat SAP Hana dan rilis OS untuk jenis tersebut, buka situsplatform IaaS bersertifikat SAP Hana. Klik detail jenis VM yang tercantum untuk mendapatkan daftar lengkap rilis OS yang didukung SAP Hana untuk jenis tersebut.

Buat ketersediaan yang ditetapkan untuk SAP Hana. Pastikan untuk mengatur domain pembaruan maksimum.

Buat tiga komputer virtual (hanadb1, hanadb2, hanadb3) dengan melakukan langkah-langkah berikut:

a. Gunakan gambar Red Hat Enterprise Linux di galeri Azure yang didukung untuk SAP Hana. Kami menggunakan gambar RHEL-SAP-HA 7.6 dalam contoh ini.

b. Pilih kumpulan ketersediaan yang Anda buat sebelumnya untuk SAP Hana.

c. Pilih subnet jaringan virtual Azure klien. Pilih Jaringan yang Dipercepat.

Ketika Anda menyebarkan mesin virtual, nama antarmuka jaringan secara otomatis akan dihasilkan. Dalam petunjuk ini untuk kesederhanaan, kami akan merujuk ke antarmuka jaringan yang dibuat secara otomatis, yang dilampirkan ke subnet jaringan virtual Azure klien, sebagai hanadb1-client, hanadb2-client, dan hanadb3-client.

Buat tiga antarmuka jaringan, satu untuk setiap komputer virtual, untuk subnet jaringan virtual

storage(dalam contoh ini, hanadb1-storage, hanadb2-storage, dan hanadb3-storage).Buat tiga antarmuka jaringan, satu untuk setiap komputer virtual, untuk subnet jaringan virtual

hana(dalam contoh ini, hanadb1-hana, hanadb2-hana, dan hanadb3-hana).Lampirkan antarmuka jaringan virtual yang baru dibuat ke mesin virtual yang sesuai dengan melakukan langkah-langkah berikut:

a. Buka komputer virtual Anda di portal Azure.

b. Pada panel kiri, pilih Komputer Virtual. Filter pada nama komputer virtual (misalnya, hanadb1), lalu pilih komputer virtual.

c. Di panel Gambaran Umum, pilih Hentikan untuk membatalkan alokasi komputer virtual.

d. Pilih Penjaringan, lalu lampirkan antarmuka jaringan. Dalam daftar drop-downLampirkan antarmuka jaringan, pilih antarmuka jaringan yang sudah dibuat untuk subnet

storagedanhana.e. Pilih Simpan.

f. Ulangi langkah b sampai e untuk komputer virtual yang tersisa (dalam contoh kami, hanadb2 dan hanadb3).

g. Biarkan komputer virtual dalam keadaan berhenti untuk saat ini. Selanjutnya, kami akan mengaktifkan jaringan yang dipercepat untuk semua antarmuka jaringan yang baru dilampirkan.

Aktifkan jaringan yang dipercepat untuk antarmuka jaringan tambahan untuk subnet

storagedanhanadengan melakukan langkah-langkah berikut:a. Buka Azure Cloud Shell di portal Azure.

b. Jalankan perintah berikut untuk mengaktifkan jaringan yang dipercepat untuk antarmuka jaringan tambahan, yang dilampirkan ke subnet

storagedanhana.az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb1-storage --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb2-storage --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb3-storage --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb1-hana --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb2-hana --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb3-hana --accelerated-networking trueMulai mesin komputer dengan melakukan langkah-langkah berikut:

a. Pada panel kiri, pilih Komputer Virtual. Filter nama komputer virtual (misalnya, hanadb1), lalu pilih.

b. Di panel Gambaran Umum, pilih Mulai.

Mengonfigurasi dan persiapan sistem operasi

Petunjuk di bagian berikutnya diawali dengan salah satu dari berikut ini:

- [A]: Berlaku untuk semua simpul

- [1]: Hanya berlaku untuk simpul 1

- [2]: Hanya berlaku untuk node 2

- [3]: Hanya berlaku untuk simpul 3

Konfigurasikan dan siapkan OS Anda dengan melakukan langkah-langkah berikut:

[A] Pertahankan file host pada komputer virtual. Sertakan entri untuk semua subnet. Entri berikut ini ditambahkan ke

/etc/hostsuntuk contoh ini.# Storage 10.9.3.4 hanadb1-storage 10.9.3.5 hanadb2-storage 10.9.3.6 hanadb3-storage # Client 10.9.1.5 hanadb1 10.9.1.6 hanadb2 10.9.1.7 hanadb3 # Hana 10.9.2.4 hanadb1-hana 10.9.2.5 hanadb2-hana 10.9.2.6 hanadb3-hana[A] Tambahkan rute jaringan, sehingga komunikasi ke Azure NetApp Files melalui antarmuka jaringan penyimpanan.

Dalam contoh ini akan digunakan

Networkmanageruntuk mengonfigurasi rute jaringan tambahan. Instruksi berikut mengasumsikan bahwa antarmuka jaringan penyimpanan adalaheth1.

Pertama, tentukan nama koneksi untuketh1perangkat. Dalam contoh ini nama koneksi untuk perangkateth1adalahWired connection 1.# Execute as root nmcli connection # Result #NAME UUID TYPE DEVICE #System eth0 5fb06bd0-0bb0-7ffb-45f1-d6edd65f3e03 ethernet eth0 #Wired connection 1 4b0789d1-6146-32eb-83a1-94d61f8d60a7 ethernet eth1Kemudian konfigurasikan rute tambahan ke jaringan yang ditujukan Azure NetApp Files melalui

eth1.# Add the following route # ANFDelegatedSubnet/cidr via StorageSubnetGW dev StorageNetworkInterfaceDevice nmcli connection modify "Wired connection 1" +ipv4.routes "10.9.0.0/26 10.9.3.1"Boot ulang VM untuk mengaktifkan perubahan.

[A] Pasang paket klien NFS.

yum install nfs-utils[A] Siapkan OS untuk menjalankan SAP Hana di Azure NetApp dengan NFS, seperti yang dijelaskan dalam catatan SAP 3024346 - Pengaturan Linux Kernel untuk NetApp NFS. Buat file konfigurasi /etc/sysctl.d/91-NetApp-HANA.conf untuk pengaturan konfigurasi NetApp.

vi /etc/sysctl.d/91-NetApp-HANA.conf # Add the following entries in the configuration file net.core.rmem_max = 16777216 net.core.wmem_max = 16777216 net.ipv4.tcp_rmem = 4096 131072 16777216 net.ipv4.tcp_wmem = 4096 16384 16777216 net.core.netdev_max_backlog = 300000 net.ipv4.tcp_slow_start_after_idle=0 net.ipv4.tcp_no_metrics_save = 1 net.ipv4.tcp_moderate_rcvbuf = 1 net.ipv4.tcp_window_scaling = 1 net.ipv4.tcp_timestamps = 1 net.ipv4.tcp_sack = 1[A] Buat file konfigurasi /etc/sysctl.d/ms-az.conf dengan pengaturan pengoptimalan tambahan.

vi /etc/sysctl.d/ms-az.conf # Add the following entries in the configuration file net.ipv6.conf.all.disable_ipv6 = 1 net.ipv4.tcp_max_syn_backlog = 16348 net.ipv4.conf.all.rp_filter = 0 sunrpc.tcp_slot_table_entries = 128 vm.swappiness=10

Tip

Hindari pengaturan net.ipv4.ip_local_port_range dan net.ipv4.ip_local_reserved_ports secara eksplisit dalam file konfigurasi sysctl untuk memungkinkan Agen Host SAP mengelola rentang port. Untuk detail lebih lanjut, lihat catatan SAP 2382421.

[A] Sesuaikan pengaturan sunrpc, seperti yang disarankan dalam catatan SAP 3024346 - Pengaturan Linux Kernel untuk NetApp NFS.

vi /etc/modprobe.d/sunrpc.conf # Insert the following line options sunrpc tcp_max_slot_table_entries=128[A] Konfigurasi Red Hat untuk HANA.

Konfigurasikan RHEL seperti yang dijelaskan dalam Catatan SAP 2292690, 2455582, 2593824, dan catatan Red Hat 2447641.

Catatan

Jika memasang Hana 2.0 SP04, Anda akan diminta untuk menginstal paket

compat-sap-c++-7seperti yang dijelaskan dalam catatan SAP 2593824, sebelum Anda dapat memasang SAP Hana.

Pasang volume Azure NetApp Files

[A] Buat titik pemasangan untuk volume database HANA.

mkdir -p /hana/data/HN1/mnt00001 mkdir -p /hana/data/HN1/mnt00002 mkdir -p /hana/log/HN1/mnt00001 mkdir -p /hana/log/HN1/mnt00002 mkdir -p /hana/shared mkdir -p /usr/sap/HN1[1] Buat direktori khusus simpul untuk /usr/sap di HN1-dibagikan.

# Create a temporary directory to mount HN1-shared mkdir /mnt/tmp # if using NFSv3 for this volume, mount with the following command mount 10.9.0.4:/HN1-shared /mnt/tmp # if using NFSv4.1 for this volume, mount with the following command mount -t nfs -o sec=sys,nfsvers=4.1 10.9.0.4:/HN1-shared /mnt/tmp cd /mnt/tmp mkdir shared usr-sap-hanadb1 usr-sap-hanadb2 usr-sap-hanadb3 # unmount /hana/shared cd umount /mnt/tmp[A] Verifikasi pengaturan domain NFS. Pastikan bahwa domain dikonfigurasi sebagai domain Azure NetApp Files default, yaitu

defaultv4iddomain.comdan pemetaan diatur ke tidak ada.Penting

Pastikan untuk menyetel domain NFS di

/etc/idmapd.confpada VM agar sesuai dengan konfigurasi domain default di Azure NetApp Files:defaultv4iddomain.com. Jika ada ketidakcocokan antara konfigurasi domain pada klien NFS (yaitu VM) dan server NFS, yaitu konfigurasi Azure NetApp, maka izin untuk file pada volume Azure NetApp yang dipasang pada VM akan ditampilkan sebagainobody.sudo cat /etc/idmapd.conf # Example [General] Domain = defaultv4iddomain.com [Mapping] Nobody-User = nobody Nobody-Group = nobody[A] Verifikasi

nfs4_disable_idmapping. Pengaturan harus diatur ke Y. Untuk membuat struktur direktori tempatnfs4_disable_idmappingberada, jalankan perintah pemasangan. Anda tidak akan dapat membuat direktori secara manual di bawah /sys/modules, karena akses dicadangkan untuk kernel/driver.# Check nfs4_disable_idmapping cat /sys/module/nfs/parameters/nfs4_disable_idmapping # If you need to set nfs4_disable_idmapping to Y mkdir /mnt/tmp mount 10.9.0.4:/HN1-shared /mnt/tmp umount /mnt/tmp echo "Y" > /sys/module/nfs/parameters/nfs4_disable_idmapping # Make the configuration permanent echo "options nfs nfs4_disable_idmapping=Y" >> /etc/modprobe.d/nfs.confUntuk detail lebih lanjut tentang cara mengubah parameter

nfs4_disable_idmappinglihat https://access.redhat.com/solutions/1749883.[A] Pasang volume Azure NetApp Files bersama.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-data-mnt00001 /hana/data/HN1/mnt00001 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-data-mnt00002 /hana/data/HN1/mnt00002 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-log-mnt00001 /hana/log/HN1/mnt00001 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-log-mnt00002 /hana/log/HN1/mnt00002 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-shared/shared /hana/shared nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount all volumes sudo mount -aUntuk beban kerja, yang memerlukan throughput yang lebih tinggi, pertimbangkan untuk menggunakan

nconnectopsi pemasangan, seperti yang dijelaskan dalam volume NFS v4.1 pada Azure NetApp Files untuk SAP Hana.nconnectPeriksa apakah didukung oleh Azure NetApp Files pada rilis Linux Anda.[1] Pasang volume spesifik simpul pada hanadb1.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-shared/usr-sap-hanadb1 /usr/sap/HN1 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount the volume sudo mount -a[2] Pasang volume spesifik simpul pada hanadb2.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-shared/usr-sap-hanadb2 /usr/sap/HN1 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount the volume sudo mount -a[3] Pasang volume spesifik simpul pada hanadb3.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-shared/usr-sap-hanadb3 /usr/sap/HN1 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount the volume sudo mount -a[A] Verifikasi bahwa semua volume HANA dipasang dengan versi protokol NFS NFSv4.

sudo nfsstat -m # Verify that flag vers is set to 4.1 # Example from hanadb1 /hana/data/HN1/mnt00001 from 10.9.0.4:/HN1-data-mnt00001 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/log/HN1/mnt00002 from 10.9.0.4:/HN1-log-mnt00002 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/data/HN1/mnt00002 from 10.9.0.4:/HN1-data-mnt00002 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/log/HN1/mnt00001 from 10.9.0.4:/HN1-log-mnt00001 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /usr/sap/HN1 from 10.9.0.4:/HN1-shared/usr-sap-hanadb1 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/shared from 10.9.0.4:/HN1-shared/shared Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4

Penginstalan

Dalam contoh ini untuk menerapkan SAP Hana dalam konfigurasi peluasan skala dengan simpul siaga dengan Azure, kami telah menggunakan Hana 2.0 SP4.

Bersiap untuk penginstalan Hana

[A] Sebelum penginstalan HANA, atur kata sandi akar. Anda dapat menonaktifkan kata sandi akar setelah penginstalan selesai. Jalankan sebagai

rootperintahpasswd.[1] Verifikasi bahwa Anda dapat masuk melalui SSH ke hanadb2 dan hanadb3, tanpa dimintai kata sandi.

ssh root@hanadb2 ssh root@hanadb3[A] Pasang paket tambahan, yang diperlukan untuk HANA 2.0 SP4. Untuk informasi selengkapnya, lihat Catatan SAP 2593824.

yum install libgcc_s1 libstdc++6 compat-sap-c++-7 libatomic1[2], [3] Ubah kepemilikan SAP Hana

datadan direktorilogmenjadi hn1adm.# Execute as root sudo chown hn1adm:sapsys /hana/data/HN1 sudo chown hn1adm:sapsys /hana/log/HN1[A] Nonaktifkan firewall untuk sementara, sehingga tidak mengganggu penginstalan Hana. Anda dapat mengaktifkannya kembali, setelah penginstalan HANA selesai.

# Execute as root systemctl stop firewalld systemctl disable firewalld

Penginstalan Hana

[1] Pasang SAP Hana dengan mengikuti instruksi pada panduan Penginstalan dan Pembaruan SAP Hana 2.0. Dalam contoh ini, kami memasang SAP Hana peluasan skala dengan master, satu pekerja, dan satu simpul siaga.

a. Mulai program hdblcm dari direktori perangkat lunak penginstalan HANA. Gunakan parameter

internal_networkdan berikan ruang alamat untuk subnet, yang digunakan untuk komunikasi antar-simpul HANA internal../hdblcm --internal_network=10.9.2.0/26b. Saat diminta, masukkan nilai berikut:

- Untuk Memilih tindakan: masukkan 1 (untuk penginstalan)

- Untuk Komponen tambahan untuk penginstalan: masukkan 2, 3

- Untuk jalur penginstalan: tekan Enter (default ke /hana/shared)

- Untuk Nama Host Lokal: tekan Enter untuk menerima default

- Pada Apakah Anda ingin menambahkan host ke sistem?: masukkan y

- Untuk nama host yang dipisahkan koma untuk ditambahkan: masukkan hanadb2, hanadb3

- Untuk Nama Pengguna Akar [akar]: tekan Enter untuk menerima default

- Untuk peran host hanadb2: masukkan 1 (untuk pekerja)

- Untuk Grup Kegagalan Host untuk host hanadb2 [default]: tekan Enter untuk menerima default

- Untuk Nomor Partisi Penyimpanan untuk host hanadb2 [<<tetapkan secara otomatis>>]: tekan Enter untuk menerima default

- Untuk Grup Pekerja untuk host hanadb2 [default]: tekan Enter untuk menerima default

- Untuk Memilih peran untuk host hanadb3: masukkan 2 (untuk siaga)

- Untuk Grup Kegagalan Host untuk host hanadb3 [default]: tekan Enter untuk menerima default

- Untuk Grup Pekerja untuk host hanadb3 [default]: tekan Enter untuk menerima default

- Untuk ID Sistem SAP Hana: masukkan HN1

- Untuk Nomor Instans [00]: masukkan 03

- Untuk Grup Pekerja Host Lokal [default]: tekan Enter untuk menerima default

- Untuk Memilih Penggunaan Sistem / Masukkan indeks [4]: masukkan 4 (untuk kustom)

- Untuk Lokasi Volume Data [/hana/data/HN1]: tekan Enter untuk menerima default

- Untuk Lokasi Volume Log [/hana/log/HN1]: tekan Enter untuk menerima default

- Untuk Membatasi alokasi memori maksimum? [n]: masukkan n

- Untuk Sertifikat Nama Host Untuk Host hanadb1 [hanadb1]: tekan Enter untuk menerima default

- Untuk Sertifikat Nama Host Untuk Host hanadb2 [hanadb2]: tekan Enter untuk menerima default

- Untuk Sertifikat Nama Host Untuk Host hanadb3 [hanadb3]: tekan Enter untuk menerima default

- Untuk Kata Sandi Administrator Sistem (hn1adm): masukkan kata sandi

- Untuk Kata Sandi Pengguna Database Sistem (sistem): masukkan kata sandi sistem

- Untuk Konfirmasi Kata Sandi Pengguna (sistem) Database Sistem: masukkan kata sandi sistem

- Untuk Memulai ulang sistem setelah reboot komputer? [n]: masukkan n

- Untuk Apakah Anda ingin melanjutkan (y/n): validasi ringkasan dan jika semuanya terlihat bagus, masukkan y

[1] Verifikasi global.ini

Tampilkan global.ini, dan pastikan konfigurasi untuk komunikasi antar-simpul SAP HANA internal diberlakukan. Verifikasi bagian komunikasi. Bagian ini harus memiliki ruang alamat untuk

hanasubnet, danlisteninterfaceharus diatur ke.internal. Verifikasi bagian internal_hostname_resolution. Bagian ini harus memiliki alamat IP untuk mesin virtual HANA milik subnethana.sudo cat /usr/sap/HN1/SYS/global/hdb/custom/config/global.ini # Example #global.ini last modified 2019-09-10 00:12:45.192808 by hdbnameserve [communication] internal_network = 10.9.2.0/26 listeninterface = .internal [internal_hostname_resolution] 10.9.2.4 = hanadb1 10.9.2.5 = hanadb2 10.9.2.6 = hanadb3[1] Tambahkan pemetaan host untuk memastikan bahwa alamat IP klien digunakan untuk komunikasi klien. Tambahkan bagian

public_host_resolution, dan tambahkan alamat IP yang sesuai dari subnet klien.sudo vi /usr/sap/HN1/SYS/global/hdb/custom/config/global.ini #Add the section [public_hostname_resolution] map_hanadb1 = 10.9.1.5 map_hanadb2 = 10.9.1.6 map_hanadb3 = 10.9.1.7[1] Mulai ulang SAP Hana untuk mengaktifkan perubahan.

sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StopSystem HDB sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StartSystem HDB[1] Verifikasi bahwa antarmuka klien akan menggunakan alamat IP dari subnet

clientuntuk komunikasi.# Execute as hn1adm /usr/sap/HN1/HDB03/exe/hdbsql -u SYSTEM -p "password" -i 03 -d SYSTEMDB 'select * from SYS.M_HOST_INFORMATION'|grep net_publicname # Expected result "hanadb3","net_publicname","10.9.1.7" "hanadb2","net_publicname","10.9.1.6" "hanadb1","net_publicname","10.9.1.5"Untuk informasi tentang cara memverifikasi konfigurasi, lihat Catatan SAP 2183363 - Konfigurasi jaringan internal SAP Hana.

[A] Aktifkan kembali firewall.

Hentikan HANA

sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StopSystem HDBAktifkan kembali firewall

# Execute as root systemctl start firewalld systemctl enable firewalldBuka port firewall yang diperlukan

Penting

Buat aturan firewall untuk memungkinkan komunikasi antar simpul HANA dan lalu lintas klien. Port yang diperlukan tercantum pada Port TCP/IP dari Semua Produk SAP. Perintah berikut hanyalah contoh. Dalam skenario ini dengan sistem yang digunakan nomor 03.

# Execute as root sudo firewall-cmd --zone=public --add-port={30301,30303,30306,30307,30313,30315,30317,30340,30341,30342,1128,1129,40302,40301,40307,40303,40340,50313,50314,30310,30302}/tcp --permanent sudo firewall-cmd --zone=public --add-port={30301,30303,30306,30307,30313,30315,30317,30340,30341,30342,1128,1129,40302,40301,40307,40303,40340,50313,50314,30310,30302}/tcpMulai HANA

sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StartSystem HDB

Untuk mengoptimalkan SAP Hana untuk penyimpanan Azure NetApp Files yang mendasarinya, atur parameter SAP Hana berikut:

max_parallel_io_requests128async_read_submitpadaasync_write_submit_activepadaasync_write_submit_blocksall

Untuk informasi selengkapnya, lihat Konfigurasi tumpukan I/O untuk SAP Hana.

Dimulai dengan sistem SAP Hana 2.0, Anda dapat mengatur parameter di

global.ini. Untuk informasi selengkapnya, lihat Catatan SAP 1999930.Untuk sistem SAP Hana 1.0 versi SPS12 dan yang lebih lama, parameter ini dapat diatur selama penginstalan, seperti yang dijelaskan dalam Catatan SAP 2267798.

Penyimpanan yang digunakan oleh Azure NetApp Files memiliki batasan ukuran file 16 terabyte (TB). SAP Hana tidak secara implisit mengetahui batasan penyimpanan, dan tidak akan secara otomatis membuat file data baru ketika batas ukuran file 16 TB tercapai. Ketika SAP Hana mencoba untuk mengembangkan file di luar 16 TB, upaya itu akan mengakibatkan kesalahan dan, akhirnya, dalam crash server indeks.

Penting

Untuk mencegah SAP Hana mencoba mengembangkan file data di luar batas 16 TB subsistem penyimpanan, setel parameter berikut di

global.ini.

Uji kegagalan SAP Hana

Simulasikan crash simpul pada simpul pekerja SAP Hana. Lakukan:

a. Sebelum Anda menyimulasikan crash simpul, jalankan perintah berikut sebagai hn1adm untuk menangkap status lingkungan:

# Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - | # Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREENb. Untuk mensimulasikan crash simpul, jalankan perintah berikut sebagai akar pada simpul pekerja, yaitu hanadb2 dalam hal ini:

echo b > /proc/sysrq-triggerc. Pantau sistem untuk penyelesaian kegagalan. Ketika kegagalan telah selesai, tangkap statusnya, yang akan terlihat seperti berikut:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GRAY hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | no | info | | | 2 | 0 | default | default | master 2 | slave | worker | standby | worker | standby | default | - | | hanadb3 | yes | info | | | 0 | 2 | default | default | master 3 | slave | standby | slave | standby | worker | default | default |Penting

Ketika simpul mengalami kepanikan kernel, hindari penundaan dengan kegagalan SAP Hana dengan mengatur

kernel.panicke 20 detik pada semua komputer virtual HANA. Konfigurasi dilakukan dalam/etc/sysctl. Boot ulang komputer virtual untuk mengaktifkan perubahan. Jika perubahan ini tidak dilakukan, kegagalan dapat memakan waktu 10 menit atau lebih ketika simpul mengalami kepanikan kernel.Matikan server nama dengan melakukan hal berikut:

a. Sebelum pengujian, periksa status lingkungan dengan menjalankan perintah berikut sebagai hn1adm:

#Landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - | # Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREENb. Jalankan perintah berikut sebagai hn1adm pada simpul master aktif, yaitu hanadb1 dalam hal ini:

hn1adm@hanadb1:/usr/sap/HN1/HDB03> HDB killSimpul siaga hanadb3 akan mengambil alih sebagai simpul master. Berikut adalah status sumber daya setelah pengujian kegagalan selesai:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GRAY # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | no | info | | | 1 | 0 | default | default | master 1 | slave | worker | standby | worker | standby | default | - | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | info | | | 0 | 1 | default | default | master 3 | master | standby | master | standby | worker | default | default |c. Mulai ulang instans HANA pada hanadb1 (artinya, pada komputer virtual yang sama, di mana server nama dimatikan). Simpul hanadb1 akan bergabung kembali dengan lingkungan dan akan mempertahankan peran siaganya.

hn1adm@hanadb1:/usr/sap/HN1/HDB03> HDB startSetelah SAP Hana dimulai pada hanadb1, harapkan status berikut:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | no | info | | | 1 | 0 | default | default | master 1 | slave | worker | standby | worker | standby | default | - | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | info | | | 0 | 1 | default | default | master 3 | master | standby | master | standby | worker | default | default |d. Sekali lagi, matikan server nama pada simpul master yang sedang aktif (yaitu, pada simpul hanadb3).

hn1adm@hanadb3:/usr/sap/HN1/HDB03> HDB killSimpul hanadb1 akan melanjutkan peran simpul master. Setelah pengujian kegagalan selesai, status akan terlihat seperti ini:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GRAY hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | no | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - |e. Mulai SAP Hana pada hanadb3, yang akan siap berfungsi sebagai simpul siaga.

hn1adm@hanadb3:/usr/sap/HN1/HDB03> HDB startSetelah SAP Hana dimulai pada hanadb3, statusnya terlihat seperti berikut:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList & python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | no | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - |

Langkah berikutnya

- Perencanaan dan implementasi Azure Virtual Machine untuk SAP

- Penerapan Azure Virtual Machine untuk SAP

- Penyebaran Microsoft Azure Virtual Machines DBMS untuk SAP

- Volume NFS v4.1 di Azure NetApp Files untuk SAP Hana

- Untuk mempelajari cara menetapkan ketersediaan tinggi dan merencanakan pemulihan bencana SAP Hana di VM Azure, lihat Ketersediaan Tinggi SAP Hana di Azure Virtual Machines (VM).