Che cos'è Azure Content Moderator?

Importante

Azure Content Moderator è deprecato a febbraio 2024 e verrà ritirato entro febbraio 2027. Viene sostituito da Contenuto di intelligenza artificiale di Azure Cassaforte ty, che offre funzionalità avanzate di intelligenza artificiale e prestazioni migliorate.

Azure AI Content Cassaforte ty è una soluzione completa progettata per rilevare contenuti dannosi generati dall'utente e generati dall'intelligenza artificiale in applicazioni e servizi. Azure AI Content Cassaforte ty è adatto per molti scenari, ad esempio marketplace online, aziende di giochi, piattaforme di messaggistica sociale, aziende di contenuti multimediali aziendali e provider di soluzioni di formazione K-12. Ecco una panoramica delle relative funzionalità e funzionalità:

- API rilevamento di testo e immagini: analizza testo e immagini per contenuti sessuali, violenza, odio e autolesionismo con più livelli di gravità.

- Content Cassaforte ty Studio: uno strumento online progettato per gestire contenuti potenzialmente offensivi, rischiosi o indesiderati usando i modelli di Machine Learning con modalità tenda ration più recenti. Fornisce modelli e flussi di lavoro personalizzati che consentono agli utenti di creare sistemi di con modalità tenda ration personalizzati.

- Supporto per la lingua: Azure AI Content Cassaforte ty supporta più di 100 lingue ed è in particolare sottoposto a training su inglese, tedesco, giapponese, spagnolo, francese, italiano, portoghese e cinese.

Azure AI Content Cassaforte ty offre una soluzione affidabile e flessibile per le esigenze di con modalità tenda ration. Passando da Content Moderator a Contenuto di Azure per intelligenza artificiale Cassaforte ty, è possibile sfruttare gli strumenti e le tecnologie più recenti per assicurarsi che il contenuto sia sempre moderato in base alle specifiche esatte.

Altre informazioni sul contenuto di Intelligenza artificiale di Azure Cassaforte ty e su come può elevare la strategia di con modalità tenda ration.

Azure Content Moderator è un servizio di intelligenza artificiale che consente di gestire i contenuti potenzialmente offensivi, rischiosi o in altro modo indesiderati. Include il servizio di con modalità tenda ration basato su intelligenza artificiale che analizza testo, immagine e video e applica automaticamente i flag di contenuto.

È possibile integrare un software di filtro dei contenuti nell'app per garantire la conformità con le normative o mantenere l'ambiente previsto per gli utenti.

Questa documentazione contiene i tipi di articolo seguenti:

- Le guide introduttive sono istruzioni introduttive che consentono di eseguire richieste al servizio.

- Le guide pratiche contengono istruzioni per l'uso del servizio in modi più specifici o personalizzati.

- I concetti forniscono spiegazioni approfondite delle funzionalità e delle funzionalità del servizio.

Per un approccio più strutturato, seguire un modulo di training per Content Moderator.

Dove è utilizzato

Ecco alcuni scenari in cui uno sviluppatore di software o un team potrebbe aver bisogno di un servizio di moderazione del contenuto:

- Marketplace online che sottopongono a moderazione i cataloghi prodotti e altro contenuto generato dagli utenti.

- Aziende produttrici di giochi che sottopongono a moderazione gli artefatti di gioco generati dagli utenti e le chat room.

- Piattaforme di messaggistica di social networking che sottopongono a moderazione le immagini, il testo e i video aggiunti dagli utenti.

- Grandi aziende nel settore dei media che implementano la moderazione centralizzata del contenuto.

- Provider di soluzioni didattiche per scuola primaria e secondaria che filtrano il contenuto non appropriato per studenti e docenti.

Importante

Non è possibile usare Content Moderator per filtrare immagini correlate allo sfruttamento illegale di minori. Tuttavia, le organizzazioni idonee possono usare il servizio cloud PhotoDNA per filtrare questo tipo di contenuto.

Cosa include

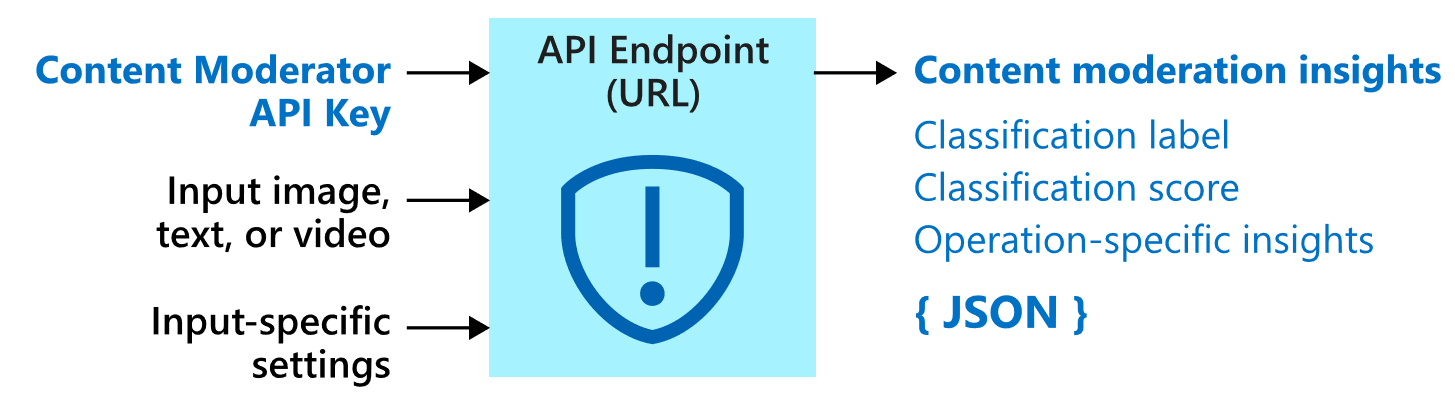

Il servizio Content Moderator è costituito da diverse API di servizi Web disponibili tramite chiamate REST e un .NET SDK.

API per la moderazione

Il servizio Content Moderator include le API per la moderazione, che verificano se nel contenuto è presente materiale potenzialmente inappropriato o sgradevole.

La tabella seguente descrive i diversi tipi di API per la moderazione.

| Gruppo di API | Descrizione |

|---|---|

| Moderazione testo | Analizza il testo per individuare contenuto offensivo, sessualmente esplicito o allusivo, oltre a contenuto volgare e informazioni personali. |

| Elenchi di termini personalizzati | Consente di analizzare il testo in base a un elenco personalizzato di termini unitamente ai termini predefiniti. Usare gli elenchi personalizzati per bloccare o consentire il contenuto in base a criteri specifici per il contenuto. |

| Moderazione immagini | Analizza le immagini per individuare eventuale contenuto per adulti o spinto, rileva il testo presente nelle immagini tramite OCR (Optical Character Recognition) e rileva i visi. |

| Elenchi di immagini personalizzati | Analizza le immagini in base a un elenco personalizzato di immagini. Usare gli elenchi di immagini personalizzati per filtrare le istanze di contenuti ricorrenti che non si vuole classificare nuovamente. |

| Moderazione video | Analizza i video per individuare contenuto per adulti o spinto e restituisce i marcatori temporali per tale contenuto. |

Privacy e sicurezza dei dati

Come per tutti i servizi di intelligenza artificiale di Azure, gli sviluppatori che usano il servizio Content Moderator devono essere consapevoli dei criteri di Microsoft sui dati dei clienti. Per altre informazioni, vedere la pagina dei servizi di intelligenza artificiale di Azure nel Centro protezione Microsoft.

Passaggi successivi

- Completare una guida introduttiva alla libreria client o all'API REST per implementare gli scenari di base nel codice.