Custom Speech とは?

Custom Speech を使用すると、アプリケーションや製品の音声認識の正確性を評価して改善できます。 カスタム音声モデルは、リアルタイムの音声テキスト変換、音声翻訳、バッチ文字起こしに使用できます。

音声認識では、Microsoft が所有するデータを使用してトレーニングされ、一般的に使用される音声言語を反映する基本モデルとしてユニバーサル言語モデルが活用されます。面倒な設定はありません。 この基本モデルは、さまざまな一般的なドメインを表す言語と発音を使用して事前にトレーニングされています。 音声認識要求を行うと、既定では、サポートされている各言語の最新の基本モデルが使用されます。 この基本モデルは、ほとんどの音声認識シナリオで適切に動作します。

カスタム モデルを使用すると、モデルをトレーニングするテキスト データを提供することによって、ベース モデルを拡張し、アプリケーションに特有のドメイン固有のボキャブラリの認識を向上させることができます。 また、参照文字起こしを含むオーディオ データを提供することで、アプリケーションの特定のオーディオ条件に基づいた認識を改善する際にも使用できます。

また、データがパターンに従う場合に構造化テキストを使用してモデルをトレーニングし、カスタムの発音を指定したり、カスタムの逆テキスト正規化、カスタムの書き換え、カスタムの不適切表現のフィルター処理を使用して表示テキストのフォーマットをカスタマイズしたりすることができます。

それはどのように機能するのでしょうか。

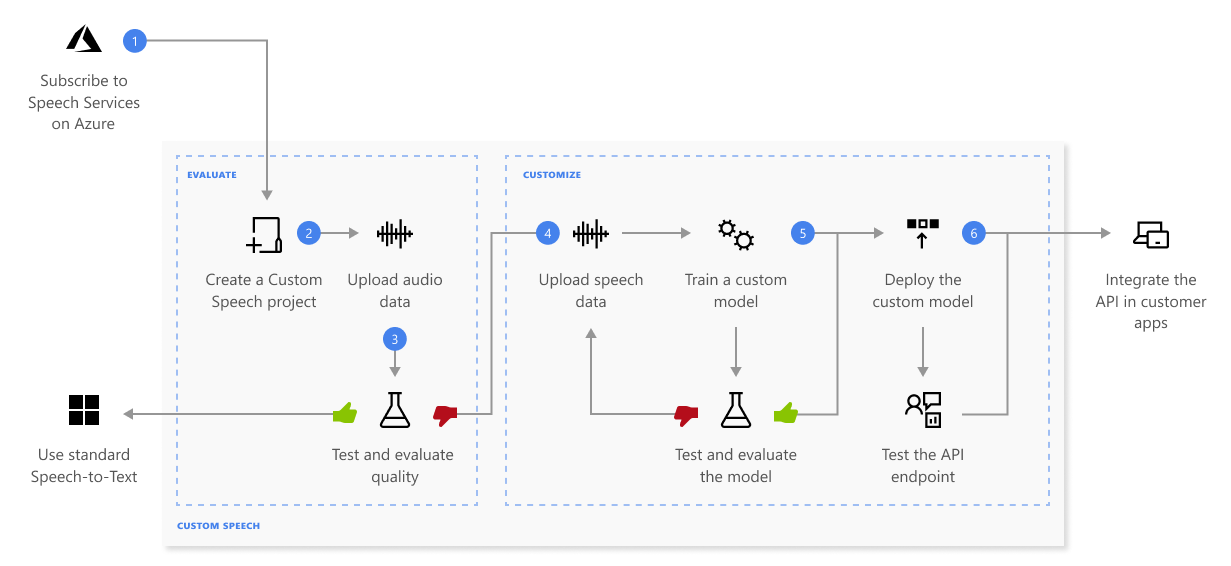

Custom Speech を使用すると、独自データのアップロード、カスタム モデルのテストとトレーニング、モデル間での正確性の比較、カスタム エンドポイントへのモデルのデプロイを行うことができます。

ここでは、上の図に示されている一連の手順について詳しく説明します。

- プロジェクトを作成し、モデルを選択します。 Azure portal で作成する Speech リソースを使用します。 オーディオ データを使用してカスタム モデルをトレーニングする場合は、オーディオ データのトレーニングに使用する専用ハードウェアがある Speech リソース リージョンを選択します。 詳細については、リージョン テーブルの脚注を参照してください。

- テスト データをアップロードする。 テスト データをアップロードして、ご利用のアプリケーション、ツール、製品に使用する音声テキスト変換プランを評価します。

- 認識品質をテストする。 Speech Studio を使用して、アップロードした音声を再生し、テスト データの音声認識品質を調査します。

- モデルを定量的にテストする。 音声テキスト変換モデルの正確性を評価して改善します。 Speech サービスには、さらにトレーニングが必要かどうかを判定するために使用できる定量的なワード エラー率 (WER) が用意されています。

- モデルをトレーニングします。 書き込まれたトランスクリプトと関連するテキストを、対応するオーディオ データとともに提供します。 トレーニング前後のモデルのテストは省略可能ですが、推奨されます。

Note

Custom Speech モデルの使用とエンドポイント ホスティングには料金が発生します。 基本モデルが 2023 年 10 月 1 日以降に作成された場合、Custom Speech モデルのトレーニングに対しても課金が行われます。 基本モデルが 2023 年 10 月より前に作成された場合、トレーニングに対して課金は行われません。 詳細については、「Azure AI 音声の価格」と音声テキスト変換 3.2 への移行ガイドの「適応の料金」セクションを参照してください。

- モデルをデプロイします。 テスト結果に問題がなければ、モデルをカスタム エンドポイントにデプロイします。 バッチ文字起こしを除き、Custom Speech モデルを使用するには、カスタム エンドポイントをデプロイする必要があります。

ヒント

バッチ文字起こし API で Custom Speech を使用するには、ホストされたデプロイ エンドポイントは必要ありません。 Custom Speech モデルがバッチ文字起こしにのみ使用される場合は、リソースを節約できます。 詳細については、「Speech Services の価格」を参照してください。

責任ある AI

AI システムには、テクノロジだけでなく、それを使用する人、それによって影響を受ける人、それがデプロイされる環境も含まれます。 「透過性のためのメモ」を読み、システムでの責任ある AI の使用とデプロイについて確認してください。