責任ある AI とは?

適用対象: Azure CLI ml extension v2 (現行)

Azure CLI ml extension v2 (現行) Python SDK azure-ai-ml v2 (現行)

Python SDK azure-ai-ml v2 (現行)

責任ある人工知能 (責任ある AI) とは、安全で信頼できる倫理的な方法で AI システムを開発、評価、デプロイするためのアプローチです。 AI システムは、それらを開発してデプロイするユーザーによる多くの決定に基づいて構築されます。 システムの目的から AI システムとの対話方法まで、責任ある AI は、より有益で公平な結果に向けて、これらの決定を積極的に導くために役立ちます。 つまり、人とその目標をシステム設計の決定の中心に保ち、公平性、信頼性、透明性などの永続的な価値を尊重することを意味します。

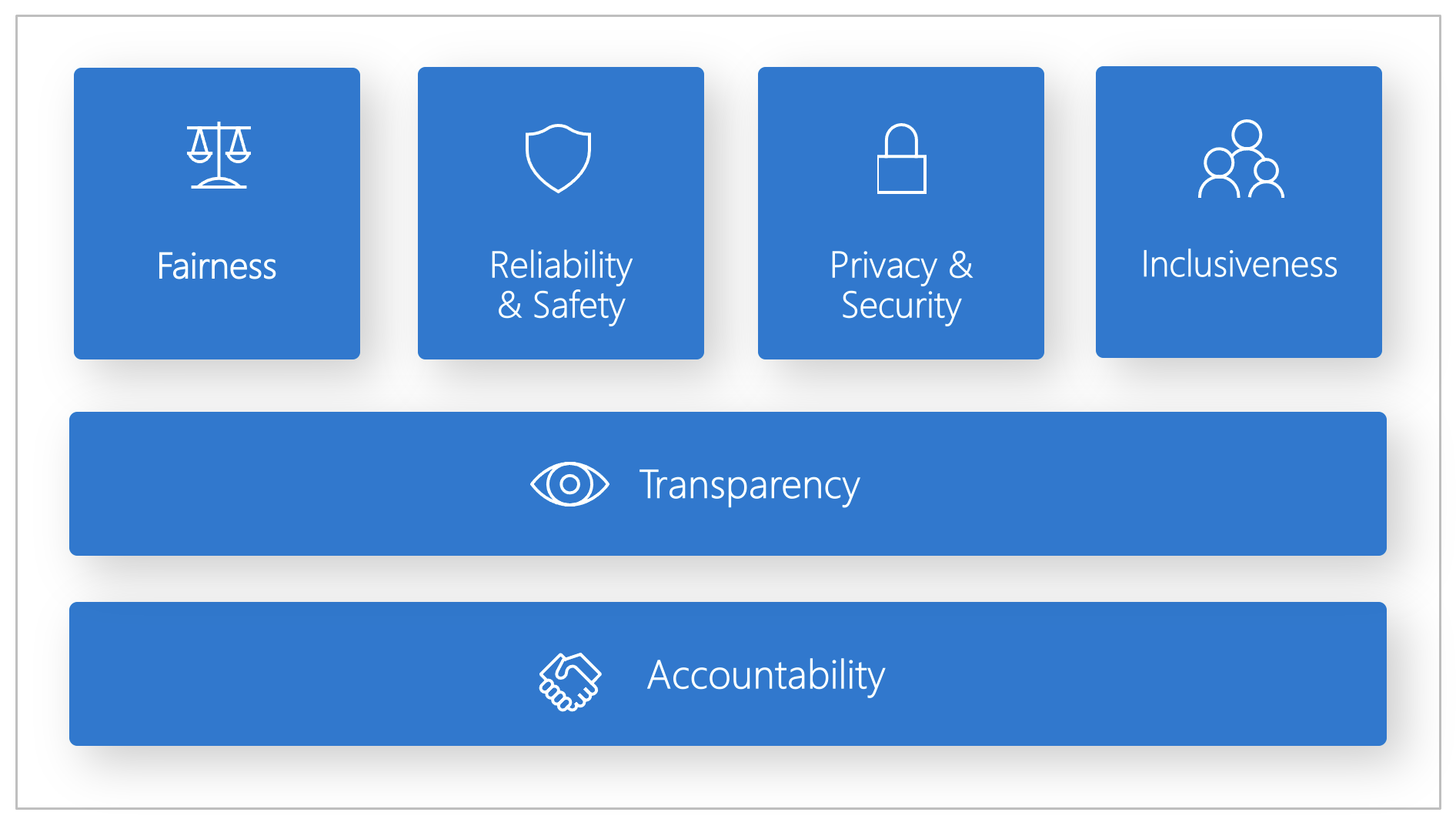

Microsoft では、責任ある AI の標準を開発しました。 これは、公平性、信頼性と安全性、プライバシーとセキュリティ、包括性、透明性、説明責任の 6 つの原則に従って AI システムを構築するためのフレームワークです。 Microsoft にとって、特に、毎日使用する製品やサービスでインテリジェント テクノロジがさらに普及していくにつれ、これらの原則は、AI への責任あるかつ信頼できるアプローチの基礎となります。

この記事では、開発者とデータ サイエンティストが 6 つの原則を実装して、実際に運用できるようにするためのツールを Azure Machine Learning がどのようにサポートしているかを示します。

公平性と包摂性

AI システムは、すべての人を公平に扱い、同じ状況に置かれた人たちのグループが異なる方法で影響を受けることを回避する必要があります。 たとえば、AI システムが治療、ローンの申し込み、または雇用に関するガイダンスを提供する場合は、同様の症状、財務状況、または専門的な資格を持つすべての人に対して同じ推奨を行う必要があります。

Azure Machine Learning での公平性と包括性: の責任ある AI ダッシュボードの公平性評価コンポーネントを使うと、データ サイエンティストと開発者は、性別、民族性、年齢などの観点から定義された機密グループ全体でモデルの公平性を評価できるようになります。

信頼性と安全性

信頼を構築するには、AI システムが、確実かつ安全に、一貫して動作することが重要です。 これらのシステムは、当初の設計どおりに動作し、予期しない状態に安全に対応し、さらに有害な操作を排除できる必要があります。 これらのシステムがどのように動作するか、また処理できる条件の多様性には、開発者が設計およびテスト中に予測している状況や状態の範囲が反映されます。

Azure Machine Learning における信頼性と安全性: 責任ある AI ダッシュボードのエラー分析コンポーネントにより、データ サイエンティストと開発者は次のことが可能になります。

- モデルに対するエラーの分散について詳しく理解する。

- 全体的なベンチマークよりもエラー率が高いデータのコーホート (サブセット) を特定する。

このような不一致は、トレーニング データ内の特定の人口統計グループや頻繁に観察されない入力条件に対してシステムまたはモデルの成績が良くない場合に発生する可能性があります。

Transparency

AI システムが、人びとの生活に多大な影響を及ぼす決定を通知するために使用される場合、これらの決定がどのように行われたかを人びとが理解することが重要です。 たとえば、銀行が AI システムを使用して、ある人物が信用できるかどうかを判定することがあります。 会社で AI システムを使用して、採用する最も適格な候補者を決定する場合があります。

透明性の重要な部分は、"解釈可能性"、つまり AI システムとそのコンポーネントの動作の有効な説明です。 解釈可能性を向上させるには、利害関係者が AI システムが機能する方法と理由を理解することが必要です。 その後、利害関係者は、潜在的なパフォーマンスの問題、公平性の問題、排他的な処理、または意図しない結果を特定できます。

Azure Machine Learning における透明性: 責任ある AI ダッシュボードの モデルの解釈可能性と反事実条件 What-If の各コンポーネントを使い、データ サイエンティストと開発者は、モデルの予測について人間が理解できる説明を生成できます。

モデルの解釈可能性コンポーネントは、モデルの動作に対する複数のビューを提供します。

- "グローバルな説明"。 たとえば、ローン配賦モデルの全体的な動作に影響する特徴は何ですか?

- "局所的な説明"。 たとえば、顧客のローン申請が承認または却下されたのはなぜですか?

- "選択したコーホートまたはデータ ポイントに対するモデルの説明"。 たとえば、低所得の申請者に対するローン配賦モデルの全体的な動作に影響する特徴は何ですか?

反事実条件 What-If コンポーネントを使うと、特徴の変更や摂動にどのように反応するかという観点から、機械学習モデルを理解し、デバッグすることができます。

Azure Machine Learning では、責任ある AI のスコアカードもサポートされています。 このスコアカードはカスタマイズ可能な PDF レポートであり、開発者が簡単に構成し、作成し、ダウンロードして、技術者と非技術者の利害関係者と共有し、データセットとモデルの正常性について教育し、コンプライアンスを達成し、信頼を構築することができます。 このスコアカードは、監査レビューで使用して、機械学習モデルの特性を明らかにすることもできます。

プライバシーとセキュリティ

AI がさらに普及していくにつれ、プライバシーの保護や個人およびビジネス情報のセキュリティ保護はますます重要かつ複雑になっています。 AI では、AI システムが人びとに関する正確で、情報に基づいた予測や決定を行うにはデータへのアクセスが不可欠であるため、プライバシーやデータ セキュリティには細心の注意が必要です。 AI システムは、次のプライバシー法を遵守する必要があります。

- データの収集、使用、および保存に関する透明性を義務付ける。

- 利用者に自分のデータの使用方法を選択するための適切な制御を持たせることを義務付ける。

Azure Machine Learning におけるプライバシーとセキュリティ: Azure Machine Learning では、管理者と開発者が、会社のポリシーに準拠したセキュリティで保護された構成を作成できます。 Azure Machine Learning と Azure プラットフォームを使用すると、次のことができます。

- ユーザー アカウントまたはグループでリソースと操作へのアクセスを制限する。

- 受信および送信のネットワーク通信を制限する。

- 転送中および保存中のデータを暗号化する。

- 脆弱性をスキャンする。

- 構成ポリシーを適用および監査する。

Microsoft では、プライバシーとセキュリティの原則の実装を深めることができる 2 つのオープンソース パッケージも作成しました。

SmartNoise: 差分プライバシーは、個人のデータを安全かつプライベートに保つうえで役立つ、一連のシステムとプラクティスです。 機械学習ソリューションでは、規制遵守のために差分プライバシーが必要になる場合があります。 SmartNoise は、グローバルな差分プライバシー システムを構築するためのコンポーネントを含んだ、(Microsoft が共同開発している) オープンソース プロジェクトです。

Counterfit: Counterfit は、コマンドライン ツールと汎用自動化レイヤーで構成された、オープンソース プロジェクトであり、開発者は AI システムに対するサイバー攻撃をシミュレートできます。 誰でもこのツールをダウンロードし、Azure Cloud Shell を使用して Azure クラウドにデプロイし、ブラウザー内で実行するか、Anaconda Python 環境にローカルにデプロイできます。 さまざまなクラウド環境、オンプレミス、またはエッジにホストされている AI モデルを評価できます。 このツールは AI モデルにとらわれず、テキスト、画像、一般的な入力など、さまざまなデータ型をサポートします。

アカウンタビリティ

AI システムを設計してデプロイする人たちは、そのシステムがどのように動作するかについて説明責任があります。 組織は、業界標準に基づいて説明責任の基準を策定する必要があります。 これらの基準により、人びとの生活に影響を与える決定について、AI システムが最終権限ではないことが保証されます。 また、高度に自律的な AI システムに対して人間が意味のある制御を維持することも可能にします。

Azure Machine Learning における説明責任: Machine Learning Operations (MLOps) は、 AI ワークフローの効率を高める DevOps の原則とプラクティスに基づいています。 Azure Machine Learning には、AI システムの説明責任を高める次の MLOps 機能が用意されています。

- どこからでもモデルの登録、パッケージ化、デプロイを行う。 モデルの使用に必要な関連メタデータを追跡することもできます。

- エンドツーエンドの機械学習ライフサイクルのためのガバナンス データを取得します。 ログに記録される系列情報には、モデルを公開しているユーザー、変更が行われた理由、モデルが運用環境にいつデプロイされたか、または使用されたかを含めることができます。

- 機械学習ライフサイクルにおけるイベントについて通知とアラートを行います。 例として、実験の完了、モデルの登録、モデル デプロイ、データ ドリフト検知などがあります。

- 運用上の問題や機械学習に関連する問題についてアプリケーションを監視します。 トレーニングと推論の間でのモデル入力の比較、モデル固有のメトリックの調査、および機械学習インフラストラクチャに対する監視とアラートの提供を行います。

MLOps 機能に加えて、Azure Machine Learning の責任ある AI スコアカードにより、利害関係者間のコミュニケーションを可能にすることで説明責任を生み出します。 このスコアカードにより、AI データとモデルの正常性について、開発者がモデルの正常性に関する分析情報を簡単に構成し、ダウンロードして、技術者と非技術者の利害関係者と共有できるため、さらに説明責任を生み出すことができます。 これらの分析情報を共有することは、信頼の構築に役立ちます。

機械学習プラットフォームでは、さらに、次の方法でビジネス上の意思決定を通知することで意思決定が可能になります。

- 利害関係者が結果に対する因果関係処理効果を理解するのに役立つ、履歴データのみを使用したデータ駆動型分析情報。 たとえば、"薬は患者の血圧にどのように影響するか"。これらの分析情報は、責任ある AI ダッシュボードの因果関係推論コンポーネントを通じて提供されます。

- "次に AI から異なる結果を得るためにどうすればよいのか?" などのユーザーの質問に回答し、対応できるようにするためのモデル駆動型分析情報。 このような分析情報は、責任ある AI ダッシュボードの反事実条件 What-If コンポーネントを介してデータ サイエンティストに提供されます。

次の手順

- Azure Machine Learning で責任ある AI を実装する方法の詳細については、責任ある AI ダッシュボードに関する記事を参照してください。

- CLI と SDK または Azure Machine Learning スタジオ UI を使用して責任ある AI ダッシュボードを生成する方法について学習します。

- 責任ある AI ダッシュボードで観察された分析情報に基づいて責任ある AI スコアカードを生成する方法について学習します。

- 6 つの主要な原則に従って AI システムを構築するための責任ある AI 標準について確認します。