Azure Stack HCI 및 Windows Server 클러스터용 드라이브 선택

적용 대상: Azure Stack HCI, 버전 22H2 및 21H2; Windows Server 2022, Windows Server 2019

이 문서에서는 성능 및 용량 요구 사항을 충족하기 위해 드라이브를 선택하는 방법에 대한 지침을 제공합니다.

드라이브 종류

저장소 공간 다이렉트 Azure Stack HCI 및 Windows Server의 기본 스토리지 가상화 기술은 현재 네 가지 유형의 드라이브에서 작동합니다.

| 드라이브 유형 | 설명 |

|---|---|

|

PMem 은 대기 시간이 짧은 고성능 스토리지의 새로운 유형인 영구 메모리를 나타냅니다. |

|

NVMe (비휘발성 메모리 Express)는 PCIe 버스에 직접 있는 반도체 드라이브를 나타냅니다. 일반적인 폼 팩터는 2.5" U.2, PCIe AIC(추가 기능 카드) 및 M.2입니다. NVMe는 PMem을 제외한 현재 지원되는 다른 유형의 드라이브보다 대기 시간이 짧은 더 높은 IOPS 및 IO 처리량을 제공합니다. |

|

SSD 는 기존 SATA 또는 SAS를 통해 연결하는 반도체 드라이브를 나타냅니다. |

|

HDD 는 방대한 스토리지 용량을 제공하는 회전, 자기 하드 디스크 드라이브를 나타냅니다. |

참고

이 문서에서는 NVMe, SSD 및 HDD를 사용하여 드라이브 구성을 선택하는 방법에 대해 설명합니다. PMem에 대한 자세한 내용은 영구 메모리 이해 및 배포를 참조하세요.

참고

SBL(Storage Bus Layer) 캐시는 단일 서버 구성에서 지원되지 않습니다. 모든 플랫 단일 스토리지 유형 구성(예: all-NVMe 또는 all-SSD)은 단일 서버에 대해 지원되는 유일한 스토리지 유형입니다.

기본 제공 캐시

저장소 공간 다이렉트 기본 제공 서버 쪽 캐시를 제공합니다. 이 캐시는 크고 영구적이며 실시간 읽기 및 쓰기 캐시입니다. 여러 유형의 드라이브가 있는 배포에서는 "가장 빠른" 유형의 모든 드라이브를 사용하도록 자동으로 구성됩니다. 나머지 드라이브는 용량에 사용됩니다.

자세한 내용은 스토리지 풀 캐시 이해를 검사.

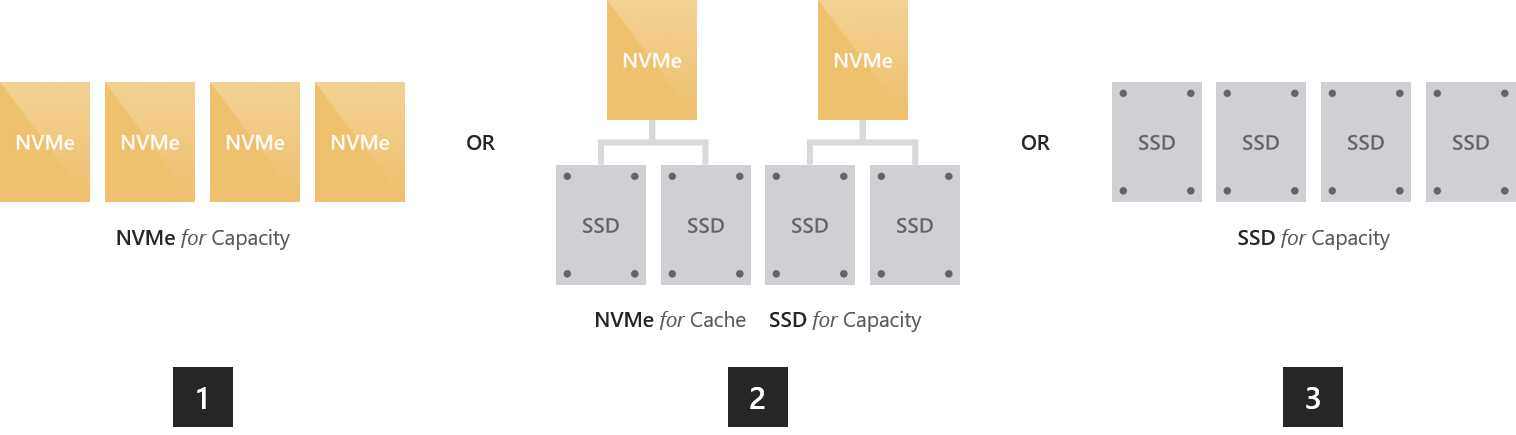

옵션 1 – 성능 최대화

임의 읽기 및 쓰기에서 예측 가능하고 균일한 하위 밀리초 대기 시간을 달성하거나 매우 높은 IOPS( 1,300만 개 이상 수행했습니다!) 또는 IO 처리량(500GB/초 읽기를 완료함)을 달성하려면 "모든 플래시"로 이동해야 합니다.

이렇게 하는 방법에는 여러 가지가 있습니다.

모든 NVMe. 모든 NVMe를 사용하면 가장 예측 가능한 짧은 대기 시간을 포함하여 타의 추종을 불허하는 성능을 제공합니다. 모든 드라이브가 동일한 모델인 경우 캐시가 없습니다. 더 높은 내구성과 낮은 내구성의 NVMe 모델을 혼합하고 후자의 쓰기를 캐시하도록 전자를 구성할 수도 있습니다(설정 필요).

NVMe + SSD. NVMe를 SSD와 함께 사용하면 NVMe가 SSD에 쓰기를 자동으로 캐시합니다. 이렇게 하면 쓰기가 캐시에 병합되고 필요에 따라 스테이징 해제되어 SSD의 마모를 줄일 수 있습니다. 이렇게 하면 NVMe와 유사한 쓰기 특성을 제공하지만 읽기는 빠른 SSD에서 직접 제공됩니다.

모든 SSD. All-NVMe와 마찬가지로 모든 드라이브가 동일한 모델인 경우 캐시가 없습니다. 내구성이 높고 내구성이 낮은 모델을 혼합하는 경우 후자의 쓰기를 캐시하도록 전자를 구성할 수 있습니다(설정 필요).

참고

캐시 없이 all-NVMe 또는 all-SSD를 사용하는 장점은 모든 드라이브에서 사용 가능한 스토리지 용량을 얻을 수 있다는 것입니다. 캐싱에 "소요"되는 용량은 없으며, 이는 더 작은 규모로 매력적일 수 있습니다.

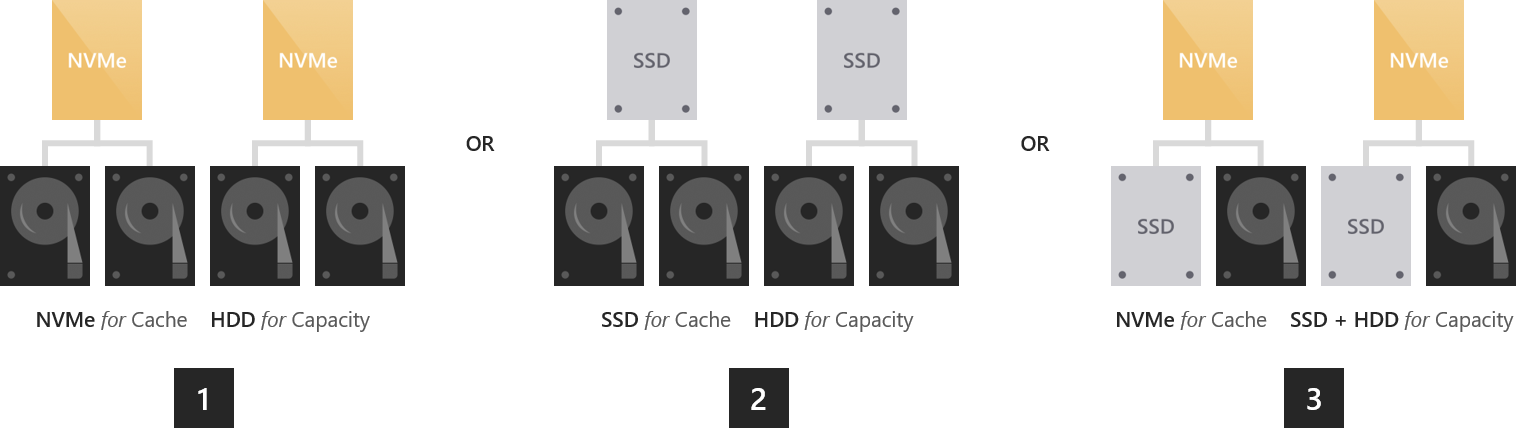

옵션 2 – 성능 및 용량 분산

다양한 애플리케이션 및 워크로드가 있는 환경, 엄격한 성능 요구 사항이 있는 환경 및 상당한 스토리지 용량이 필요한 환경의 경우 더 큰 HDD용 NVMe 또는 SSD 캐싱을 사용하여 "하이브리드"로 이동해야 합니다.

NVMe + HDD. NVMe 드라이브는 둘 다 캐싱하여 읽기 및 쓰기를 가속화합니다. 읽기를 캐싱하면 HDD가 쓰기에 집중할 수 있습니다. 캐싱 쓰기는 버스트를 흡수하고 쓰기를 사용하여 HDD IOPS 및 IO 처리량을 최대화하는 인위적으로 직렬화된 방식으로 필요에 따라 병합하고 스테이징 해제할 수 있습니다. NVMe와 유사한 쓰기 특성을 제공하며, 자주 또는 최근에 읽는 데이터의 경우 NVMe와 유사한 읽기 특성도 제공합니다.

SSD + HDD. 위와 마찬가지로 SSD는 둘 다 캐싱하여 읽기 및 쓰기를 가속화합니다. 이렇게 하면 자주 또는 최근에 읽은 데이터에 대한 SSD와 유사한 쓰기 특성 및 SSD와 유사한 읽기 특성이 제공됩니다.

세 가지 유형의 드라이브를 모두 사용하는 한 가지 추가적인 이국적인 옵션이 있습니다.

NVMe + SSD + HDD. 세 가지 유형의 드라이브를 모두 사용하는 NVMe는 SSD와 HDD 모두에 대한 캐시를 구동합니다. 매력은 SSD에 볼륨을 만들 수 있고 HDD의 볼륨은 NVMe에서 모두 가속화된 동일한 클러스터에서 나란히 만들 수 있다는 것입니다. 전자는 "올 플래시" 배포와 정확히 동일하며, 후자는 위에서 설명한 "하이브리드" 배포와 정확히 같습니다. 이는 개념적으로 크게 독립적인 용량 관리, 실패 및 복구 주기 등을 갖춘 두 개의 풀을 갖는 것과 같습니다.

중요

SSD 계층을 사용하여 성능에 가장 중요한 워크로드를 올 플래시에 배치하는 것이 좋습니다.

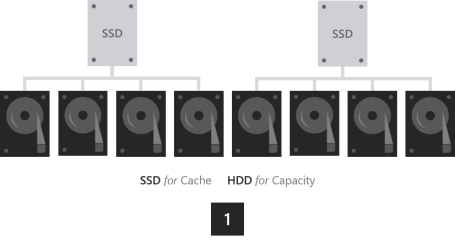

옵션 3 – 용량 최대화

보관, 백업 대상, 데이터 웨어하우스 또는 "콜드" 스토리지와 같이 대용량 용량이 필요하고 자주 쓰지 않는 워크로드의 경우 캐싱을 위한 몇 가지 SSD를 용량에 대한 많은 더 큰 HDD와 결합해야 합니다.

- SSD + HDD. SSD는 읽기 및 쓰기를 캐시하여 버스트를 흡수하고 나중에 HDD에 최적화된 디 스테이징을 통해 SSD와 유사한 쓰기 성능을 제공합니다.

중요

HDD만 포함된 구성은 지원되지 않습니다. 내구성이 높은 SSD를 내구성이 낮은 SSD에 캐싱하는 것은 권장되지 않습니다.

크기 조정 고려 사항

캐시

모든 서버에는 2개 이상의 캐시 드라이브가 있어야 합니다(중복성에 필요한 최소). 용량 드라이브의 수를 캐시 드라이브 수의 배수로 만드는 것이 좋습니다. 예를 들어 4개의 캐시 드라이브가 있는 경우 7 또는 9보다 8개의 용량 드라이브(1:2 비율)에서 더 일관된 성능을 경험할 수 있습니다.

캐시는 애플리케이션 및 워크로드의 작업 집합, 즉 지정된 시간에 적극적으로 읽고 쓰는 모든 데이터를 수용할 수 있도록 크기가 조정되어야 합니다. 그 외에는 캐시 크기 요구 사항이 없습니다. HDD를 사용하는 배포의 경우 공정한 시작 위치는 용량의 10%입니다. 예를 들어 각 서버에 4 x 4TB HDD = 16TB의 용량이 있는 경우 2 x 800GB SSD = 서버당 1.6TB의 캐시가 있습니다. 모든 플래시 배포의 경우, 특히 내구성이 매우 높은 SSD의 경우 용량의 5%에 가깝게 시작하는 것이 공평할 수 있습니다. 예를 들어 각 서버에 24 x 1.2TB SSD = 28.8TB의 용량이 있는 경우 서버당 2 x 750GB NVMe = 1.5TB의 캐시가 있습니다. 캐시 드라이브는 추후 언제든지 추가하거나 제거해서 조정할 수 있습니다.

일반

서버당 총 스토리지 용량을 약 400TB(테라바이트)로 제한하는 것이 좋습니다. 서버당 스토리지 용량이 많을수록 소프트웨어 업데이트를 적용할 때 가동 중지 시간 또는 다시 부팅 후 데이터를 다시 동기화하는 데 필요한 시간이 길어집니다. 스토리지 풀당 현재 최대 크기는 4페타바이트(PB)(4,000TB)(Windows Server 2016 1PB)입니다.

다음 단계

자세한 내용은 다음 항목을 참조하십시오.

피드백

출시 예정: 2024년 내내 콘텐츠에 대한 피드백 메커니즘으로 GitHub 문제를 단계적으로 폐지하고 이를 새로운 피드백 시스템으로 바꿀 예정입니다. 자세한 내용은 다음을 참조하세요. https://aka.ms/ContentUserFeedback

다음에 대한 사용자 의견 제출 및 보기