자습서: NFS를 통해 Azure Data Box에 데이터 복사

Important

이제 Azure Data Box는 Blob 수준에서 액세스 계층 할당을 지원합니다. 이 자습서에 포함된 단계는 업데이트된 데이터 복사 프로세스를 반영하며 블록 Blob와 관련된 내용입니다.

블록 Blob 데이터에 대한 적절한 액세스 계층을 결정하는 데 도움이 필요한 경우 블록 Blob에 대한 적절한 액세스 계층 확인 섹션을 참조하세요. Data Box에 데이터 복사 섹션에 포함된 단계에 따라 데이터를 적절한 액세스 계층에 복사합니다.

이 섹션에 포함된 정보는 2024년 4월 1일 이후에 주문한 주문에 적용됩니다.

이 자습서에서는 로컬 웹 UI를 사용하여 호스트 컴퓨터에서 연결하고 데이터를 복사하는 방법을 설명합니다.

이 자습서에서는 다음을 하는 방법을 알아볼 수 있습니다.

- 필수 조건

- Data Box에 연결

- Data Box에 데이터 복사

필수 조건

시작하기 전에 다음 사항을 확인합니다.

- 자습서: Azure Data Box 설정을 완료했습니다.

- Data Box를 받았고 포털의 주문 상태가 배달됨입니다.

- Data Box에 복사할 데이터가 포함된 호스트 컴퓨터가 있습니다. 호스트 컴퓨터는 다음 사항이 필수입니다.

- 지원되는 운영 체제를 실행합니다.

- 고속 네트워크에 연결되어 있어야 합니다. 10GbE 연결이 하나 이상 있는 것이 좋습니다. 10GbE 연결을 사용할 수 없는 경우 1GbE 데이터 링크를 사용할 수 있지만 복사 속도에 영향을 미칩니다.

Data Box에 연결

선택한 스토리지 계정에 따라 Data Box에서 만드는 항목은 다음과 같습니다.

- GPv1 및 GPv2에서 연결된 각 스토리지에 대한 공유 3개.

- Premium Storage에 대한 공유 1개

- 네 개의 액세스 계층마다 하나의 폴더를 포함하는 Blob Storage 계정에 대한 하나의 공유입니다.

다음 테이블에는 연결할 수 있는 Data Box 공유의 이름과 대상 스토리지 계정에 업로드되는 데이터 형식을 식별합니다. 또한 원본 데이터를 복사할 공유 및 디렉터리의 계층 구조를 식별합니다.

| 스토리지 유형 | 공유 이름 | 첫 번째 수준 엔터티 | 두 번째 수준 엔터티 | 세 번째 수준 엔터티 |

|---|---|---|---|---|

| 블록 Blob | <storageAccountName>_BlockBlob | <\accessTier> | <\containerName> | <\blockBlob> |

| 페이지 Blob | <\storageAccountName>_PageBlob | <\containerName> | <\pageBlob> | |

| File Storage | <\storageAccountName>_AzFile | <\fileShareName> | <\file> |

Data Box 공유의 루트 폴더에 직접 파일을 복사할 수 없습니다. 대신 사용 사례에 따라 Data Box 공유 내에 폴더를 만드세요.

블록 Blob는 파일 수준에서 액세스 계층 할당을 지원합니다. 블록 Blob 공유에 파일을 복사하기 전 권장되는 모범 사례는 적절한 액세스 계층 내에 새 하위 폴더를 추가하는 것입니다. 새 하위 폴더를 만든 후 각 하위 폴더에 적절하게 파일을 계속 추가합니다.

블록 Blob 공유의 루트에 있는 폴더에 대해 새 컨테이너가 만들어집니다. 해당 폴더 내의 모든 파일은 스토리지 계정의 기본 액세스 계층에 블록 Blob으로 복사됩니다.

Blob 액세스 계층에 대한 자세한 내용은 Blob 데이터에 대한 액세스 계층을 참조하세요. 액세스 계층 모범 사례에 대한 자세한 내용은 Blob 액세스 계층 사용에 대한 모범 사례를 참조하세요.

다음 테이블은 Data Box에 있는 공유의 UNC 경로와 데이터가 업로드되는 해당 Azure Storage 경로 URL을 보여 줍니다. 최종 Azure Storage 경로 URL은 UNC 공유 경로에서 파생될 수 있습니다.

| Azure Storage 유형 | Data Box 공유 |

|---|---|

| Azure 블록 Blob | \\<DeviceIPAddress>\<storageaccountname_BlockBlob>\<accessTier>\<ContainerName>\myBlob.txthttps://<storageaccountname>.blob.core.windows.net/<ContainerName>/myBlob.txt |

| Azure 페이지 Blob | \\<DeviceIPAddress>\<storageaccountname_PageBlob>\<ContainerName>\myBlob.vhdhttps://<storageaccountname>.blob.core.windows.net/<ContainerName>/myBlob.vhd |

| Azure 파일 | \\<DeviceIPAddress>\<storageaccountname_AzFile>\<ShareName>\myFile.txthttps://<storageaccountname>.file.core.windows.net/<ShareName>/myFile.txt |

Linux 호스트 컴퓨터를 사용하는 경우 다음 단계에 따라 NFS 클라이언트에 대한 액세스를 허용하도록 Data Box를 구성합니다.

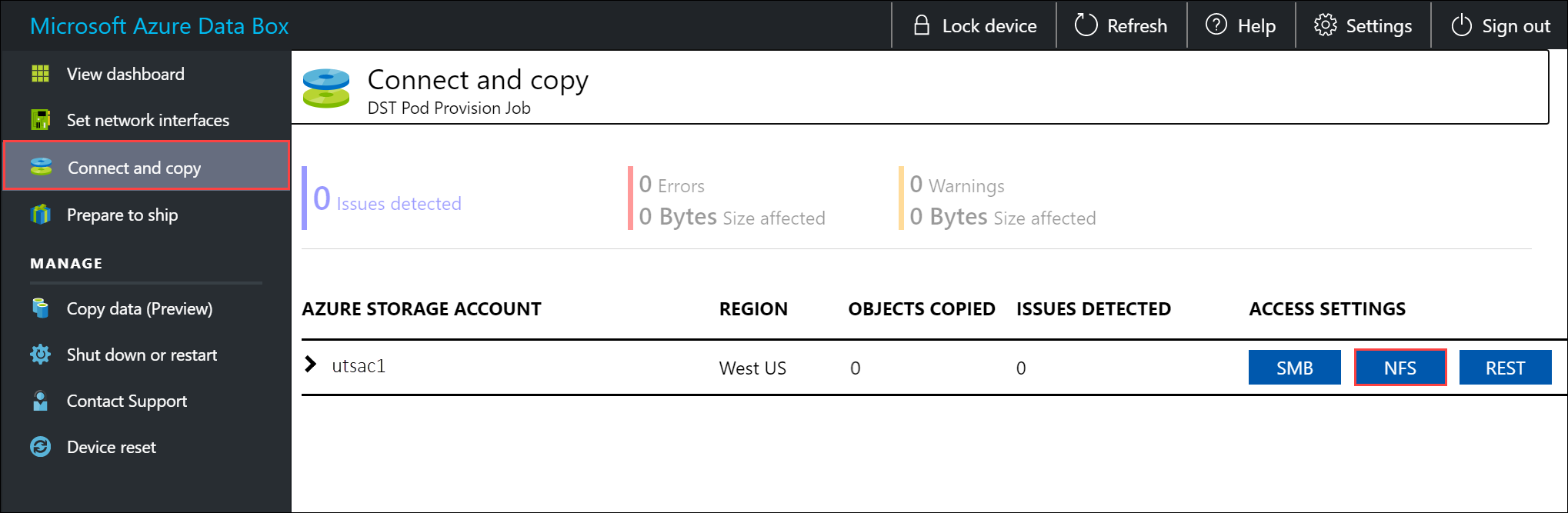

공유에 액세스할 수 있도록 허용된 클라이언트의 IP 주소를 입력합니다. 로컬 웹 UI에서 연결 및 복사 페이지로 이동합니다. NFS 설정에서 NFS 클라이언트 액세스를 선택합니다.

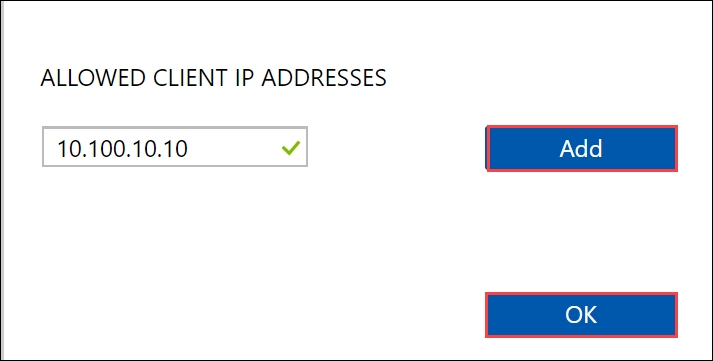

NFS 클라이언트의 IP 주소를 입력하고 추가를 선택합니다. 이 단계를 반복하여 여러 NFS 클라이언트에 대한 액세스를 구성할 수 있습니다. 확인을 선택합니다.

Linux 호스트 컴퓨터에 지원되는 버전의 NFS 클라이언트를 설치합니다. 해당 Linux 배포판에 맞는 버전을 사용하세요.

NFS 클라이언트가 설치되면 다음 명령을 사용하여 Data Box 디바이스에 NFS 공유를 탑재합니다.

sudo mount <Data Box device IP>:/<NFS share on Data Box device> <Path to the folder on local Linux computer>다음 예제를 사용하여 NFS를 사용하여 Data Box 공유에 연결합니다. 이 예제에서 Data Box 디바이스 IP는

10.161.23.130입니다. 공유Mystoracct_Blob은(는) ubuntuVM에 마운트되고 마운트 지점은/home/databoxubuntuhost/databox입니다.sudo mount -t nfs 10.161.23.130:/Mystoracct_Blob /home/databoxubuntuhost/databoxMac 클라이언트의 경우 다음과 같이 추가 옵션을 추가해야 합니다.

sudo mount -t nfs -o sec=sys,resvport 10.161.23.130:/Mystoracct_Blob /home/databoxubuntuhost/databoxImportant

스토리지 계정의 루트 폴더에 직접 파일을 복사할 수 없습니다. 블록 Blob Storage 계정의 루트 폴더 내에서 사용 가능한 각 액세스 계층에 해당하는 폴더를 찾을 수 있습니다.

Azure Data Box에 데이터를 복사하려면 먼저 액세스 계층 중 하나에 해당하는 폴더를 선택해야 합니다. 다음으로 해당 계층의 폴더 내에 하위 폴더를 만들어 데이터를 저장합니다. 마지막으로 데이터를 새로 만든 하위 폴더에 복사합니다. 새 하위 폴더는 수집 중에 스토리지 계정 내에서 만든 컨테이너를 나타냅니다. 데이터는 이 컨테이너에 Blob으로 업로드됩니다.

블록 Blob에 대한 적절한 액세스 계층 확인

Important

이 섹션에 포함된 정보는 2024년 4월 1일이후에 주문한 주문에 적용됩니다.

Azure Storage를 사용하면 블록 Blob 데이터를 동일한 스토리지 계정 내의 여러 액세스 계층에 저장할 수 있습니다. 이 기능을 사용하면 액세스 빈도에 따라 데이터를 보다 효율적으로 구성하고 저장할 수 있습니다. 다음 표에는 Azure Storage 액세스 계층에 대한 정보와 권장 사항이 포함되어 있습니다.

| 계층 | 추천 | 모범 사례 |

|---|---|---|

| 핫 | 자주 액세스하거나 수정하는 온라인 데이터에 유용합니다. 이 계층은 스토리지 비용이 가장 높지만 액세스 비용은 가장 낮습니다. | 이 계층의 데이터는 일반 및 활성 상태여야 합니다. |

| 쿨 | 자주 액세스하거나 수정하지 않는 온라인 데이터에 유용합니다. 이 계층은 핫 계층보다 스토리지 비용이 낮고 액세스 비용이 더 높습니다. | 이 계층의 데이터는 30일 이상 저장해야 합니다. |

| 관심 낮음 | 드물게 액세스하거나 수정하지만 여전히 빠른 검색이 필요한 온라인 데이터에 유용합니다. 이 계층은 쿨 계층보다 스토리지 비용이 낮고 액세스 비용이 더 높습니다. | 이 계층의 데이터는 최소 90일 동안 저장해야 합니다. |

| 보관 | 오프라인 데이터에 거의 액세스하지 않고 대기 시간 요구 사항이 낮은 경우에 유용합니다. | 이 계층의 데이터는 최소 180일 동안 저장해야 합니다. 180일 이내에 보관 계층에서 제거된 데이터는 조기 삭제 요금이 부과됩니다. |

Blob 액세스 계층에 대한 자세한 내용은 Blob 데이터에 대한 액세스 계층을 참조하세요. 모범 사례에 대한 자세한 내용은 Blob 액세스 계층 사용에 대한 모범 사례를 참조하세요.

블록 Blob 데이터를 Data Box 내의 해당 폴더에 복사하여 적절한 액세스 계층으로 전송할 수 있습니다. 이 프로세스는 Azure Data Box에 데이터 복사 섹션에서 자세히 설명합니다.

Data Box에 데이터 복사

하나 이상의 Data Box 공유에 연결한 후 다음 단계는 데이터를 복사하는 것입니다. 데이터 복사를 시작하기 전에 다음 제한 사항을 고려합니다.

- 필수 데이터 형식에 해당하는 공유에 데이터를 복사해 놓아야 합니다. 예를 들어 블록 Blob에 대한 공유에 블록 Blob 데이터를 복사합니다. 페이지 Blob 공유에 VHD를 복사합니다. 데이터 형식이 적절한 공유 유형과 일치하지 않으면 이후 단계에서 Azure에 대한 데이터 업로드가 실패합니다.

- AzFile 또는 PageBlob 공유에 데이터를 복사할 때는 먼저 공유의 루트에 폴더를 만든 다음 해당 폴더에 파일을 복사합니다.

- BlockBlob 공유에 데이터를 복사하는 경우 원하는 액세스 계층 내에 하위 폴더를 만든 다음, 새로 만든 하위 폴더에 데이터를 복사합니다. 하위 폴더는 데이터가 Blob으로 업로드되는 컨테이너를 나타냅니다. 공유의 루트 폴더에 직접 파일을 복사할 수 없습니다.

- 데이터를 복사하는 동안 데이터 크기가 Azure 스토리지 계정 크기 제한에 설명된 크기 제한을 준수하는지 확인합니다.

- Data Box 및 다른 비 Data Box 애플리케이션에서 동시에 업로드하면 업로드 작업 실패 및 데이터 손상이 발생할 수 있습니다.

- SMB 및 NFS 프로토콜을 모두 데이터 복사에 사용하는 경우 다음을 수행하는 것이 좋습니다.

- 서로 다른 스토리지 계정을 SMB 및 NFS에 사용합니다.

- SMB와 NFS를 모두 사용하여 Azure에서 동일한 데이터를 동일한 최종 대상에 복사하지 않습니다. 이 경우 최종 결과를 확인할 수 없습니다.

- SMB와 NFS 모두를 통해 동시에 복사할 수 있지만 사용자 오류가 발생하기 쉬우므로 권장하지 않습니다. SMB 데이터 복사가 완료될 때까지 기다린 후에 NFS 데이터 복사를 시작합니다.

- 블록 Blob 공유에 데이터를 복사하는 경우 원하는 액세스 계층 내에 하위 폴더를 만든 다음, 새로 만든 하위 폴더에 데이터를 복사합니다. 하위 폴더는 데이터가 Blob으로 업로드되는 컨테이너를 나타냅니다. 스토리지 계정 내 루트 폴더에는 파일을 직접 복사할 수 없습니다.

- NFS 공유에서 Data Box의 NFS까지 대/소문자 구분 디렉터리 및 파일 이름을 수집하는 경우:

이름의 대/소문자가 유지됩니다.

파일은 대/소문자를 구분하지 않습니다.

예를 들어

SampleFile.txt및Samplefile.Txt을(를) 복사하는 경우 Data Box에 복사할 때 이름에 대/소문자를 유지합니다. 그러나 동일한 파일로 간주되므로 업로드된 마지막 파일은 첫 번째 파일을 덮어씁니다.

Important

데이터가 Azure Storage에 복사되었는지 확인할 때까지 원본 데이터의 복사본을 유지 관리해야 합니다.

Linux 호스트 컴퓨터를 사용하는 경우 Robocopy와 비슷한 복사 유틸리티를 사용합니다. Linux에서 사용할 수 있는 대안 중 일부는 rsync, FreeFileSync, Unison 또는 Ultracopier입니다.

cp 명령은 디렉터리를 복사하는 최고의 옵션 중 하나입니다. 사용 방법에 대한 자세한 내용은 cp 기본 페이지를 참조하세요.

다중 스레드 복사에 rsync 옵션을 사용하는 경우 다음 지침을 따르세요.

Linux 클라이언트에서 사용하는 파일 시스템에 따라 CIFS 유틸리티 또는 NFS 유틸리티 패키지를 설치합니다.

sudo apt-get install cifs-utilssudo apt-get install nfs-utilsrsync및 병렬을 설치합니다(Linux 배포 버전에 따라 다름).sudo apt-get install rsyncsudo apt-get install parallel탑재 지점을 만듭니다.

sudo mkdir /mnt/databox볼륨을 탑재합니다.

sudo mount -t NFS4 //Databox IP Address/share_name /mnt/databox폴더 디렉터리 구조를 미러링합니다.

rsync -za --include='*/' --exclude='*' /local_path/ /mnt/databox파일을 복사합니다.

cd /local_path/; find -L . -type f | parallel -j X rsync -za {} /mnt/databox/{}여기서 j는 병렬 처리의 수를 지정하고, X는 병렬 복사본의 수

병렬 복사본 16개로 시작하여 가용 리소스에 따라 스레드 수를 늘리는 것이 좋습니다.

Important

Linux 파일 형식인 기호 링크, 문자 파일, 블록 파일, 소켓 및 파이프는 지원되지 않습니다. 이러한 파일 형식을 사용하면 배송 준비 단계 동안 오류가 발생합니다.

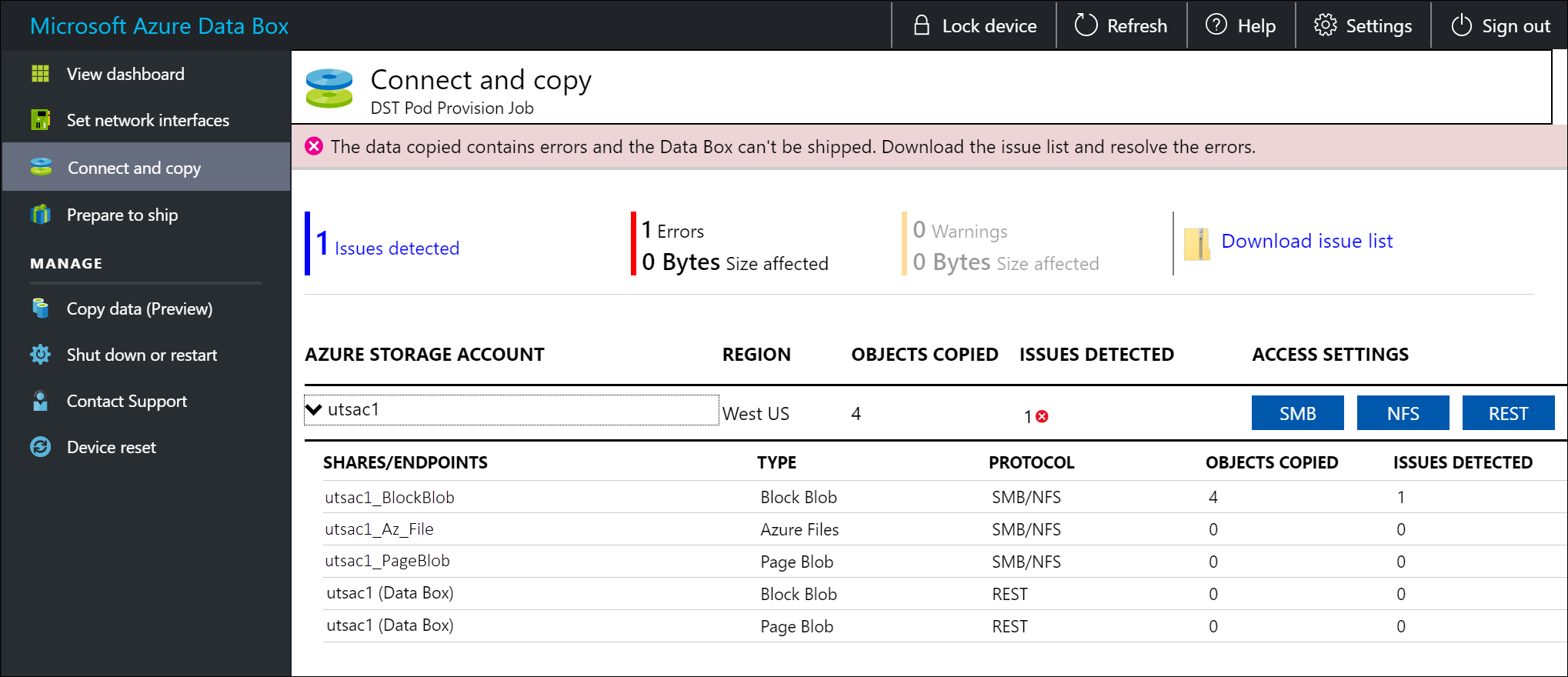

복사하는 동안 오류를 식별할 수 있도록 알림이 표시됩니다.

문제 목록 다운로드를 선택합니다.

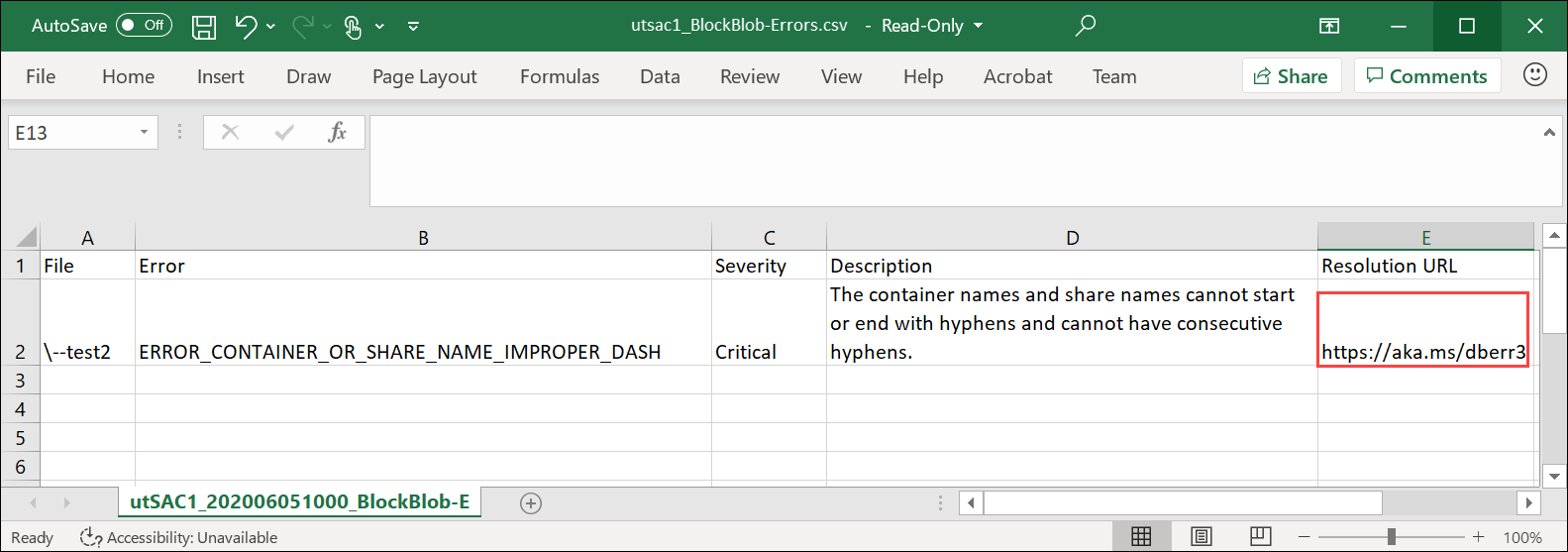

목록을 열어 오류의 세부 정보를 보고 해결 URL을 선택하여 권장 해결 방법을 확인합니다.

자세한 내용은 Data Box로 데이터를 복사하는 동안 오류 로그 보기를 참조하세요. 데이터를 복사하는 동안 발생하는 오류에 대한 자세한 목록을 보려면 Data Box 문제 해결을 참조하세요.

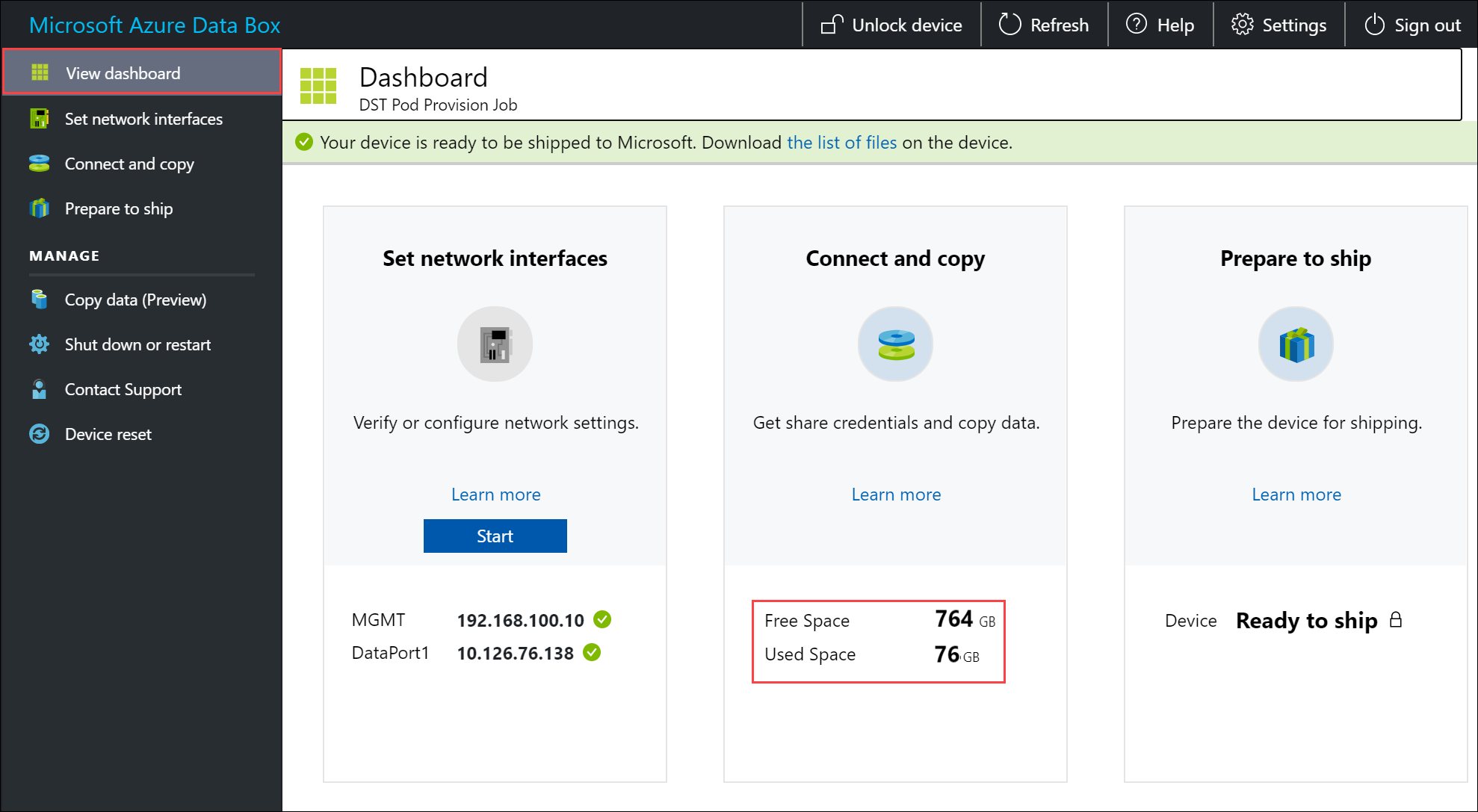

데이터 무결성을 보장하기 위해, 데이터가 복사될 때 체크섬이 인라인으로 계산됩니다. 복사가 완료되면 디바이스에서 사용 중인 공간과 여유 공간을 확인합니다.

다음 단계

이 자습서에서는 Azure Data Box 항목에 대해 다음과 같은 내용을 알아보았습니다.

- Data Box 데이터 복사 사전 요구 사항

- Data Box에 연결

- 블록 Blob에 대한 적절한 액세스 계층 확인

- Data Box에 데이터 복사

Data Box를 Microsoft로 다시 배송하는 방법을 알아보려면 다음 자습서로 계속 진행하세요.