SUSE Linux Enterprise Server의 Azure VM에 있는 NFS의 고가용성

참고 항목

Azure 자사 NFS 서비스 중 하나인 Azure Files 의 NFS 또는 고가용성 SAP 시스템에 공유 데이터를 저장하기 위한 NFS ANF 볼륨 중 하나를 배포하는 것이 좋습니다. NFS 클러스터를 활용하여 SAP 참조 아키텍처를 강조하지 않습니다.

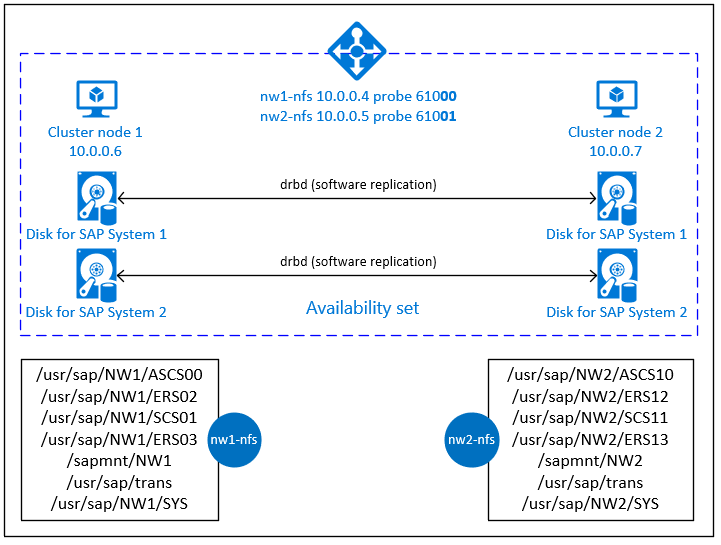

이 문서에서는 가상 머신을 배포하고, 가상 머신을 구성하고, 클러스터 프레임워크를 설치하고, 고가용성 SAP 시스템의 공유 데이터를 저장하는 데 사용할 수 있는 고가용성 NFS 서버를 설치하는 방법을 설명합니다. 이 가이드에서는 두 SAP 시스템 NW1 및 NW2에서 사용되는 고가용성 NFS 서버를 설정하는 방법을 설명합니다. 예제에 포함된 리소스(예: 가상 머신, 가상 네트워크) 이름은 SAP 파일 서버 템플릿을 리소스 접두사인 prod와 함께 사용한 것으로 가정합니다.

참고 항목

이 문서에는 Microsoft에서 더 이상 사용하지 않는 용어에 대한 참조가 포함되어 있습니다. 소프트웨어에서 용어가 제거되면 이 문서에서 해당 용어를 제거합니다.

먼저 다음 SAP 노트 및 논문을 읽어 보세요.

SAP Note 1928533 다음과 같습니다.

- SAP 소프트웨어 배포에 지원되는 Azure VM 크기 목록

- Azure VM 크기에 대한 중요한 용량 정보

- 지원되는 SAP 소프트웨어, OS(운영 체제) 및 데이터베이스 조합

- Microsoft Azure에서 Windows 및 Linux에 필요한 SAP 커널 버전

SAP Note 2015553 Azure에서 SAP 지원 SAP 소프트웨어 배포를 위한 필수 구성 요소를 나열합니다.

SAP Note 2205917에는 SAP 애플리케이션용 SUSE Linux Enterprise Server에 권장되는 OS 설정이 나와 있습니다.

SAP Note 1944799 SAP 애플리케이션용 SUSE Linux Enterprise Server에 대한 SAP HANA 지침이 있습니다.

SAP Note 2178632는 Azure에서 SAP에 대해 보고된 모든 모니터링 메트릭에 대한 자세한 정보를 포함하고 있습니다.

SAP Note 2191498 Azure의 Linux에 필요한 SAP 호스트 에이전트 버전이 있습니다.

SAP Note 2243692 Azure의 Linux에서 SAP 라이선스에 대한 정보를 포함하고 있습니다.

SAP Note 1984787 SUSE Linux Enterprise Server 12에 대한 일반적인 정보가 있습니다.

SAP Note 1999351 SAP용 Azure 고급 모니터링 확장에 대한 추가 문제 해결 정보가 있습니다.

SAP Community WIKI는 Linux에 필요한 모든 SAP Note를 포함하고 있습니다.

SUSE Linux Enterprise 고가용성 확장 12 SP3 모범 사례 가이드

- DRBD 및 Pacemaker를 사용하는 고가용성 NFS 스토리지

개요

고가용성을 달성하려면 SAP NetWeaver에 NFS 서버가 필요합니다. NFS 서버는 별도의 클러스터에서 구성되며, 여러 SAP 시스템에서 사용할 수 있습니다.

이 NFS 서버를 사용하는 모든 SAP 시스템에 대해 전용 가상 호스트 이름과 가상 IP 주소가 사용됩니다. Azure에서는 가상 IP 주소를 사용하려면 부하 분산 장치가 필요합니다. 제시된 구성은 다음이 포함된 부하 분산 장치를 보여 줍니다.

- NW1용 프런트 엔드 IP 주소 10.0.0.4

- NW2용 프런트 엔드 IP 주소 10.0.0.5

- NW1용 프로브 포트 61000

- NW2용 프로브 포트 61001

고가용성 NFS 서버 설정

Azure Portal을 통해 수동으로 Linux 배포

이 문서에서는 리소스 그룹, Azure Virtual Network 및 서브넷을 이미 배포했다고 가정합니다.

NFS 서버에 두 개의 가상 머신을 배포합니다. SAP 시스템에서 지원되는 적합한 SLES 이미지를 선택합니다. 확장 집합, 가용성 영역 또는 가용성 집합과 같은 가용성 옵션 중 하나에서 VM을 배포할 수 있습니다.

Azure 부하 분산 장치 구성

부하 분산 장치 만들기 가이드에 따라 NFS 서버 고가용성을 위한 표준 부하 분산 장치를 구성합니다. 부하 분산 장치를 구성하는 동안 다음 사항을 고려합니다.

- 프런트 엔드 IP 구성: 두 개의 프런트 엔드 IP를 만듭니다. NFS 서버와 동일한 가상 네트워크 및 서브넷을 선택합니다.

- 백 엔드 풀: 백 엔드 풀을 만들고 NFS 서버 VM을 추가합니다.

- 인바운드 규칙: NW1용과 NW2용으로 두 개의 부하 분산 규칙을 만듭니다. 두 부하 분산 규칙에 대해 동일한 단계를 수행합니다.

- 프런트 엔드 IP 주소: 프런트 엔드 IP 선택

- 백 엔드 풀: 백 엔드 풀 선택

- "고가용성 포트" 확인

- 프로토콜: TCP

- 상태 프로브: 아래 세부 정보를 사용하여 상태 프로브 만들기(NW1 및 NW2 모두에 적용됨)

- 프로토콜: TCP

- 포트: [예: NW1의 경우 61000, NW2의 경우 61001]

- 간격: 5

- 프로브 임계값: 2

- 유휴 시간 제한(분): 30

- "부동 IP 사용" 확인

참고 항목

상태 프로브 구성 속성 numberOfProbes(포털에서 “비정상 임계값”으로 알려짐)는 적용되지 않습니다. 따라서 성공 또는 실패한 연속 프로브 수를 제어하려면 속성 "probeThreshold"를 2로 설정합니다. 현재 Azure Portal을 사용하여 이 속성을 설정할 수 없으므로 Azure CLI 또는 PowerShell 명령을 사용합니다.

Important

부동 IP는 부하 분산 시나리오의 NIC 보조 IP 구성에서 지원되지 않습니다. 자세한 내용은 Azure Load Balancer 제한 사항을 참조 하세요. VM에 대한 추가 IP 주소가 필요한 경우 두 번째 NIC를 배포합니다.

참고 항목

공용 IP 주소가 없는 VM이 내부(공용 IP 주소 없음) 표준 Azure 부하 분산 장치의 백 엔드 풀에 배치되는 경우 공용 엔드포인트로 라우팅을 허용하기 위해 추가 구성을 수행하지 않는 한 아웃바운드 인터넷 연결이 없습니다. 아웃바운드 연결을 설정하는 방법에 대한 자세한 내용은 SAP 고가용성 시나리오에서 Azure 표준 Load Balancer를 사용하는 Virtual Machines에 대한 퍼블릭 엔드포인트 연결을 참조하세요.

Important

- Azure Load Balancer 뒤에 배치되는 Azure VM에서 TCP 타임스탬프를 사용하도록 설정하면 안 됩니다. TCP 타임스탬프를 사용하도록 설정하면 상태 프로브에 오류가 발생합니다.

net.ipv4.tcp_timestamps매개 변수를0로 설정합니다. 자세한 내용은 Load Balancer 상태 프로브를 참조하세요. - saptune이 수동으로 설정된

net.ipv4.tcp_timestamps값을0다시1변경하지 않도록 하려면 saptune 버전을 3.1.1 이상으로 업데이트해야 합니다. 자세한 내용은 saptune 3.1.1 – 업데이트해야 하나요?를 참조하세요.

Pacemaker 클러스터 만들기

Azure의 SUSE Linux Enterprise Server에서 Pacemaker를 설정하는 단계에 따라 이 NFS 서버에 대한 기본 Pacemaker 클러스터를 만듭니다.

NFS 서버 구성

다음 항목에는 노드 1 또는 [2]에만 적용되는 모든 노드에 적용할 수 있는 [A] 접두사로 노드 2에만 적용됩니다.

[A] 호스트 이름 확인 설정

DNS 서버를 사용하거나 모든 노드에서 /etc/hosts를 수정할 수 있습니다. 이 예에서는 /etc/hosts 파일 사용 방법을 보여줍니다. 다음 명령에서 IP 주소와 호스트 이름 바꾸기

sudo vi /etc/hosts다음 줄을 /etc/hosts에 삽입합니다. 환경에 맞게 IP 주소와 호스트 이름 변경

# IP address of the load balancer frontend configuration for NFS 10.0.0.4 nw1-nfs 10.0.0.5 nw2-nfs[A] NFS 서버 사용

루트 NFS 내보내기 항목 만들기

sudo sh -c 'echo /srv/nfs/ *\(rw,no_root_squash,fsid=0\)>/etc/exports' sudo mkdir /srv/nfs/[A] drbd 구성 요소 설치

sudo zypper install drbd drbd-kmp-default drbd-utils[A] drbd 디바이스에 대한 파티션 만들기

사용 가능한 모든 데이터 디스크 나열

sudo ls /dev/disk/azure/scsi1/ # Example output # lun0 lun1모든 데이터 디스크에 대한 파티션 만들기

sudo sh -c 'echo -e "n\n\n\n\n\nw\n" | fdisk /dev/disk/azure/scsi1/lun0' sudo sh -c 'echo -e "n\n\n\n\n\nw\n" | fdisk /dev/disk/azure/scsi1/lun1'[A] LVM 구성 만들기

사용 가능한 모든 파티션 나열

ls /dev/disk/azure/scsi1/lun*-part* # Example output # /dev/disk/azure/scsi1/lun0-part1 /dev/disk/azure/scsi1/lun1-part1모든 파티션에 대한 LVM 볼륨 만들기

sudo pvcreate /dev/disk/azure/scsi1/lun0-part1 sudo vgcreate vg-NW1-NFS /dev/disk/azure/scsi1/lun0-part1 sudo lvcreate -l 100%FREE -n NW1 vg-NW1-NFS sudo pvcreate /dev/disk/azure/scsi1/lun1-part1 sudo vgcreate vg-NW2-NFS /dev/disk/azure/scsi1/lun1-part1 sudo lvcreate -l 100%FREE -n NW2 vg-NW2-NFS[A] drbd 구성

sudo vi /etc/drbd.confdrbd.conf 파일에 다음 두 줄이 포함되어 있는지 확인합니다.

include "drbd.d/global_common.conf"; include "drbd.d/*.res";전역 drbd 구성 변경

sudo vi /etc/drbd.d/global_common.conf처리기 및 net 섹션에 다음 항목을 추가합니다.

global { usage-count no; } common { handlers { fence-peer "/usr/lib/drbd/crm-fence-peer.9.sh"; after-resync-target "/usr/lib/drbd/crm-unfence-peer.9.sh"; split-brain "/usr/lib/drbd/notify-split-brain.sh root"; pri-lost-after-sb "/usr/lib/drbd/notify-pri-lost-after-sb.sh; /usr/lib/drbd/notify-emergency-reboot.sh; echo b > /proc/sysrq-trigger ; reboot -f"; } startup { wfc-timeout 0; } options { } disk { md-flushes yes; disk-flushes yes; c-plan-ahead 1; c-min-rate 100M; c-fill-target 20M; c-max-rate 4G; } net { after-sb-0pri discard-younger-primary; after-sb-1pri discard-secondary; after-sb-2pri call-pri-lost-after-sb; protocol C; tcp-cork yes; max-buffers 20000; max-epoch-size 20000; sndbuf-size 0; rcvbuf-size 0; } }[A] NFS drbd 디바이스 만들기

sudo vi /etc/drbd.d/NW1-nfs.res새 drbd 디바이스에 대한 구성을 삽입하고 종료합니다.

resource NW1-nfs { protocol C; disk { on-io-error detach; } net { fencing resource-and-stonith; } on prod-nfs-0 { address 10.0.0.6:7790; device /dev/drbd0; disk /dev/vg-NW1-NFS/NW1; meta-disk internal; } on prod-nfs-1 { address 10.0.0.7:7790; device /dev/drbd0; disk /dev/vg-NW1-NFS/NW1; meta-disk internal; } }sudo vi /etc/drbd.d/NW2-nfs.res새 drbd 디바이스에 대한 구성을 삽입하고 종료합니다.

resource NW2-nfs { protocol C; disk { on-io-error detach; } net { fencing resource-and-stonith; } on prod-nfs-0 { address 10.0.0.6:7791; device /dev/drbd1; disk /dev/vg-NW2-NFS/NW2; meta-disk internal; } on prod-nfs-1 { address 10.0.0.7:7791; device /dev/drbd1; disk /dev/vg-NW2-NFS/NW2; meta-disk internal; } }drbd 디바이스를 만들고 시작합니다.

sudo drbdadm create-md NW1-nfs sudo drbdadm create-md NW2-nfs sudo drbdadm up NW1-nfs sudo drbdadm up NW2-nfs[1] 초기 동기화 건너뛰기

sudo drbdadm new-current-uuid --clear-bitmap NW1-nfs sudo drbdadm new-current-uuid --clear-bitmap NW2-nfs[1] 주 노드 설정

sudo drbdadm primary --force NW1-nfs sudo drbdadm primary --force NW2-nfs[1] 새 drbd 디바이스가 동기화될 때까지 기다립니다.

sudo drbdsetup wait-sync-resource NW1-nfs sudo drbdsetup wait-sync-resource NW2-nfs[1] drbd 디바이스에서 파일 시스템 만들기

sudo mkfs.xfs /dev/drbd0 sudo mkdir /srv/nfs/NW1 sudo chattr +i /srv/nfs/NW1 sudo mount -t xfs /dev/drbd0 /srv/nfs/NW1 sudo mkdir /srv/nfs/NW1/sidsys sudo mkdir /srv/nfs/NW1/sapmntsid sudo mkdir /srv/nfs/NW1/trans sudo mkdir /srv/nfs/NW1/ASCS sudo mkdir /srv/nfs/NW1/ASCSERS sudo mkdir /srv/nfs/NW1/SCS sudo mkdir /srv/nfs/NW1/SCSERS sudo umount /srv/nfs/NW1 sudo mkfs.xfs /dev/drbd1 sudo mkdir /srv/nfs/NW2 sudo chattr +i /srv/nfs/NW2 sudo mount -t xfs /dev/drbd1 /srv/nfs/NW2 sudo mkdir /srv/nfs/NW2/sidsys sudo mkdir /srv/nfs/NW2/sapmntsid sudo mkdir /srv/nfs/NW2/trans sudo mkdir /srv/nfs/NW2/ASCS sudo mkdir /srv/nfs/NW2/ASCSERS sudo mkdir /srv/nfs/NW2/SCS sudo mkdir /srv/nfs/NW2/SCSERS sudo umount /srv/nfs/NW2[A] drbd split-brain 검색 설정

drbd를 사용하여 한 호스트에서 다른 호스트로 데이터를 동기화하는 경우 소위 분할 브레인이 발생할 수 있습니다. 분할 브레인은 두 클러스터 노드가 drbd 디바이스를 기본 디바이스로 승격하고 동기화되지 않는 시나리오입니다. 그것은 드문 상황이 될 수 있습니다 하지만 당신은 여전히 처리 하 고 가능한 한 빨리 분할 두뇌를 해결 하 고 싶어. 따라서 분할된 뇌가 발생했을 때 알림을 받도록 하는 것이 중요합니다.

분할 브레인 알림을 설정하는 방법에 대한 공식 drbd 설명서를 읽어보세요.

분할 브레인(split-brain) 시나리오에서 자동으로 복구할 수도 있습니다. 자세한 내용은 자동 분할 브레인 복구 정책을 참조 하세요.

클러스터 프레임워크 구성

[1] 클러스터 구성에 SAP 시스템 NW1용 NFS drbd 디바이스 추가

Important

최근 테스트 결과, 백로그와 하나의 연결만 처리하는 제한으로 인해 netcat이 요청에 응답하지 않는 것으로 확인되었습니다. netcat 리소스는 Azure Load Balancer 요청 수신을 중지하고 부동 IP를 사용할 수 없게 됩니다.

기존 Pacemaker 클러스터의 경우 과거에 netcat을 socat으로 바꾸는 것이 좋습니다. 현재 다음 패키지 버전 요구 사항을 사용하여 패키지 리소스 에이전트의 일부인 azure-lb 리소스 에이전트를 사용하는 것이 좋습니다.- SLES 12 SP4/SP5의 경우 버전은 resource-agents-4.3.018.a7fb5035-3.30.1 이상이어야 합니다.

- SLES 15/15 SP1의 경우 버전은 resource-agents-4.3.0184.6ee15eb2-4.13.1 이상이어야 합니다.

변경에는 짧은 가동 중지 시간이 필요합니다.

기존 Pacemaker 클러스터의 경우 Azure Load-Balancer 감지 강화의 설명에 따라 socat을 사용하도록 구성을 이미 변경한 경우 즉시 azure-lb 리소스 에이전트로 전환할 필요가 없습니다.sudo crm configure rsc_defaults resource-stickiness="200" # Enable maintenance mode sudo crm configure property maintenance-mode=true sudo crm configure primitive drbd_NW1_nfs \ ocf:linbit:drbd \ params drbd_resource="NW1-nfs" \ op monitor interval="15" role="Master" \ op monitor interval="30" role="Slave" sudo crm configure ms ms-drbd_NW1_nfs drbd_NW1_nfs \ meta master-max="1" master-node-max="1" clone-max="2" \ clone-node-max="1" notify="true" interleave="true" sudo crm configure primitive fs_NW1_sapmnt \ ocf:heartbeat:Filesystem \ params device=/dev/drbd0 \ directory=/srv/nfs/NW1 \ fstype=xfs \ op monitor interval="10s" sudo crm configure primitive nfsserver systemd:nfs-server \ op monitor interval="30s" sudo crm configure clone cl-nfsserver nfsserver sudo crm configure primitive exportfs_NW1 \ ocf:heartbeat:exportfs \ params directory="/srv/nfs/NW1" \ options="rw,no_root_squash,crossmnt" clientspec="*" fsid=1 wait_for_leasetime_on_stop=true op monitor interval="30s" sudo crm configure primitive vip_NW1_nfs IPaddr2 \ params ip=10.0.0.4 op monitor interval=10 timeout=20 sudo crm configure primitive nc_NW1_nfs azure-lb port=61000 \ op monitor timeout=20s interval=10 sudo crm configure group g-NW1_nfs \ fs_NW1_sapmnt exportfs_NW1 nc_NW1_nfs vip_NW1_nfs sudo crm configure order o-NW1_drbd_before_nfs inf: \ ms-drbd_NW1_nfs:promote g-NW1_nfs:start sudo crm configure colocation col-NW1_nfs_on_drbd inf: \ g-NW1_nfs ms-drbd_NW1_nfs:Master[1] 클러스터 구성에 SAP 시스템 NW2용 NFS drbd 디바이스 추가

# Enable maintenance mode sudo crm configure property maintenance-mode=true sudo crm configure primitive drbd_NW2_nfs \ ocf:linbit:drbd \ params drbd_resource="NW2-nfs" \ op monitor interval="15" role="Master" \ op monitor interval="30" role="Slave" sudo crm configure ms ms-drbd_NW2_nfs drbd_NW2_nfs \ meta master-max="1" master-node-max="1" clone-max="2" \ clone-node-max="1" notify="true" interleave="true" sudo crm configure primitive fs_NW2_sapmnt \ ocf:heartbeat:Filesystem \ params device=/dev/drbd1 \ directory=/srv/nfs/NW2 \ fstype=xfs \ op monitor interval="10s" sudo crm configure primitive exportfs_NW2 \ ocf:heartbeat:exportfs \ params directory="/srv/nfs/NW2" \ options="rw,no_root_squash,crossmnt" clientspec="*" fsid=2 wait_for_leasetime_on_stop=true op monitor interval="30s" sudo crm configure primitive vip_NW2_nfs IPaddr2 \ params ip=10.0.0.5 op monitor interval=10 timeout=20 sudo crm configure primitive nc_NW2_nfs azure-lb port=61001 \ op monitor timeout=20s interval=10 sudo crm configure group g-NW2_nfs \ fs_NW2_sapmnt exportfs_NW2 nc_NW2_nfs vip_NW2_nfs sudo crm configure order o-NW2_drbd_before_nfs inf: \ ms-drbd_NW2_nfs:promote g-NW2_nfs:start sudo crm configure colocation col-NW2_nfs_on_drbd inf: \ g-NW2_nfs ms-drbd_NW2_nfs:Masterexportfs클러스터 리소스의crossmnt옵션은 이전 SLES 버전과의 호환성을 위해 설명서에 나와 있습니다.[1] 기본 테넌트 모드 사용 안 함

sudo crm configure property maintenance-mode=false

다음 단계

- SAP ASCS 및 데이터베이스 설치

- SAP용 Azure Virtual Machines 계획 및 구현

- SAP용 Azure Virtual Machines 배포

- SAP용 Azure Virtual Machines DBMS 배포

- Azure VM에서 SAP HANA의 재해 복구를 계획하고 고가용성을 설정하는 방법을 알아보려면 Azure VM(Virtual Machines)의 SAP HANA 고가용성을 참조하세요.