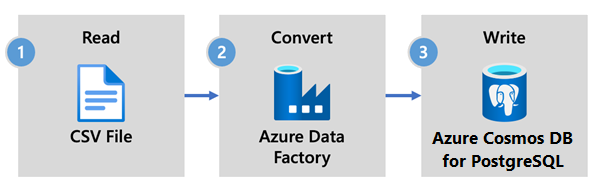

Gegevens opnemen met behulp van Azure Data Factory in Azure Cosmos DB for PostgreSQL

VAN TOEPASSING OP: Azure Cosmos DB for PostgreSQL (mogelijk gemaakt door de Citus-database-extensie naar PostgreSQL)

Azure Data Factory is een cloudgebaseerde ETL - en gegevensintegratieservice. Hiermee kunt u gegevensgestuurde werkstromen maken om gegevens op schaal te verplaatsen en transformeren.

Met Data Factory kunt u gegevensgestuurde werkstromen (pijplijnen genoemd) maken en plannen die gegevens uit verschillende gegevensarchieven opnemen. Pijplijnen kunnen on-premises, in Azure of in andere cloudproviders worden uitgevoerd voor analyse en rapportage.

Data Factory heeft een gegevenssink voor Azure Cosmos DB for PostgreSQL. Met de gegevenssink kunt u uw gegevens (relationele, NoSQL-, data lake-bestanden) overbrengen naar Azure Cosmos DB for PostgreSQL-tabellen voor opslag, verwerking en rapportage.

Belangrijk

Data Factory biedt momenteel geen ondersteuning voor privé-eindpunten voor Azure Cosmos DB voor PostgreSQL.

Data Factory voor realtime opname

Hier volgen de belangrijkste redenen om Azure Data Factory te kiezen voor het opnemen van gegevens in Azure Cosmos DB for PostgreSQL:

- Eenvoudig te gebruiken : biedt een codevrije visuele omgeving voor het organiseren en automatiseren van gegevensverplaatsing.

- Krachtig : maakt gebruik van de volledige capaciteit van de onderliggende netwerkbandbreedte, tot 5 GiB/s-doorvoer.

- Ingebouwde connectors : integreert al uw gegevensbronnen, met meer dan 90 ingebouwde connectors.

- Rendabel: biedt ondersteuning voor een volledig beheerde, volledig beheerde serverloze cloudservice die op aanvraag wordt geschaald.

Stappen voor het gebruik van Data Factory

In dit artikel maakt u een gegevenspijplijn met behulp van de Gebruikersinterface (UI) van Data Factory. De pijplijn in deze data factory kopieert gegevens van Azure Blob Storage naar een database. Zie de tabel Ondersteunde gegevensarchieven voor een lijst met gegevensarchieven die worden ondersteund als bron en als sink.

In Data Factory kunt u de kopieeractiviteit gebruiken om gegevens te kopiëren tussen gegevensarchieven die zich on-premises en in de cloud bevinden naar Azure Cosmos DB for PostgreSQL. Als u geen kennis hebt met Data Factory, vindt u hier een beknopte handleiding voor het aan de slag gaan:

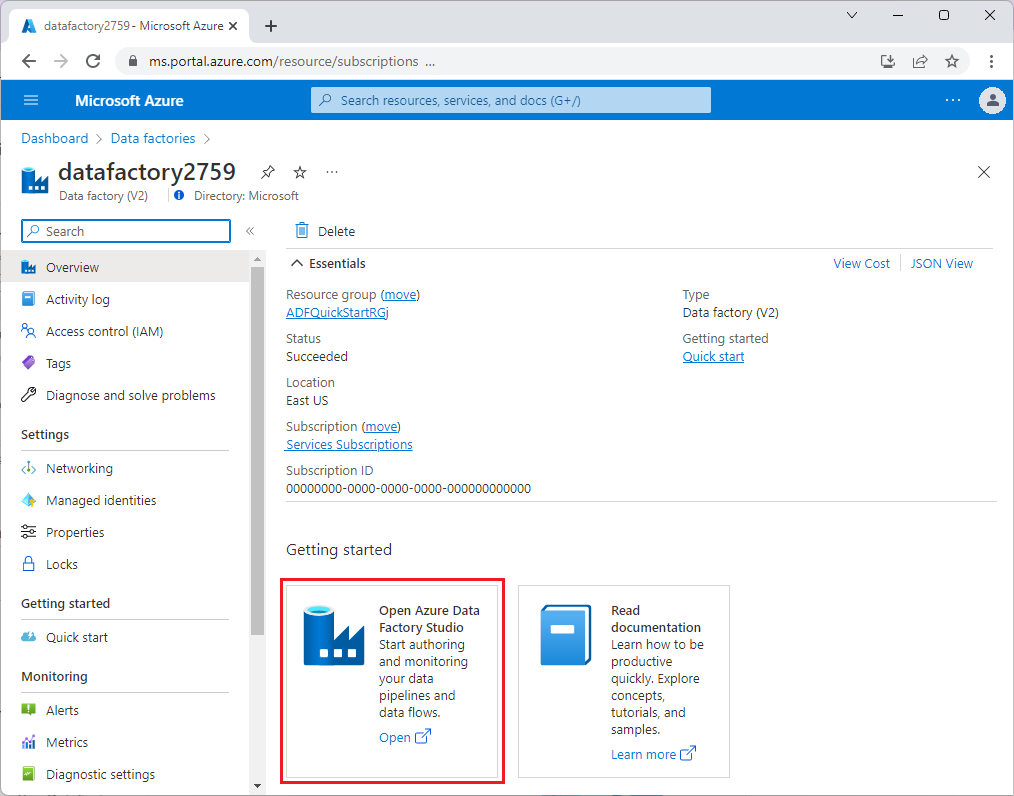

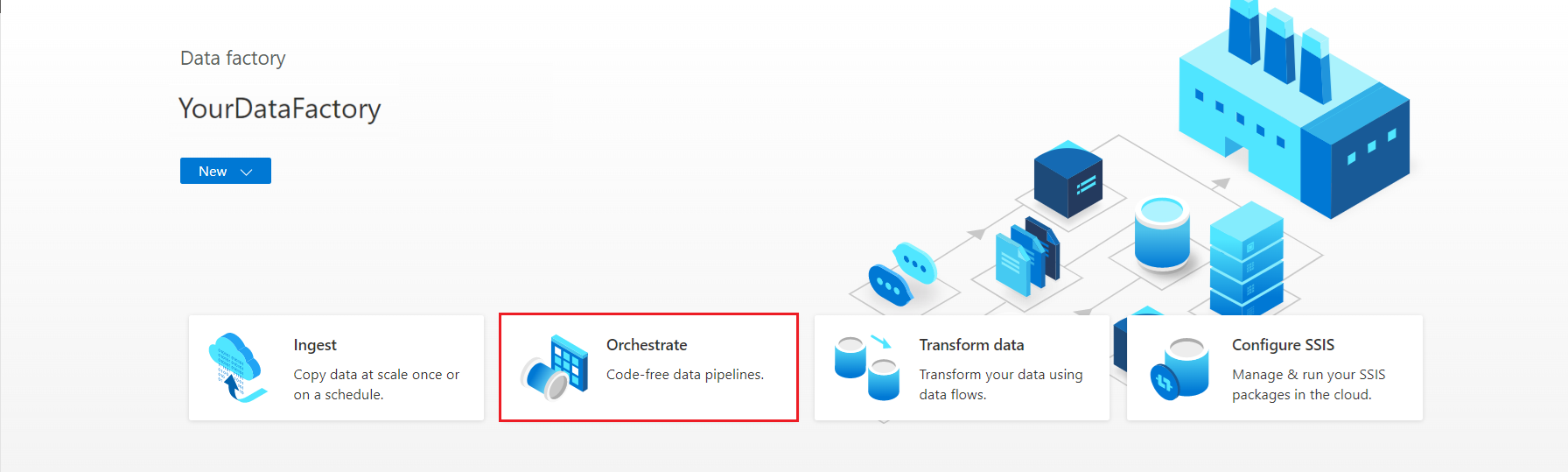

Zodra Data Factory is ingericht, gaat u naar uw data factory en start u Azure Data Factory Studio. U ziet de startpagina van Data Factory, zoals wordt weergegeven in de volgende afbeelding:

Selecteer Orchestrate op de startpagina van Azure Data Factory Studio.

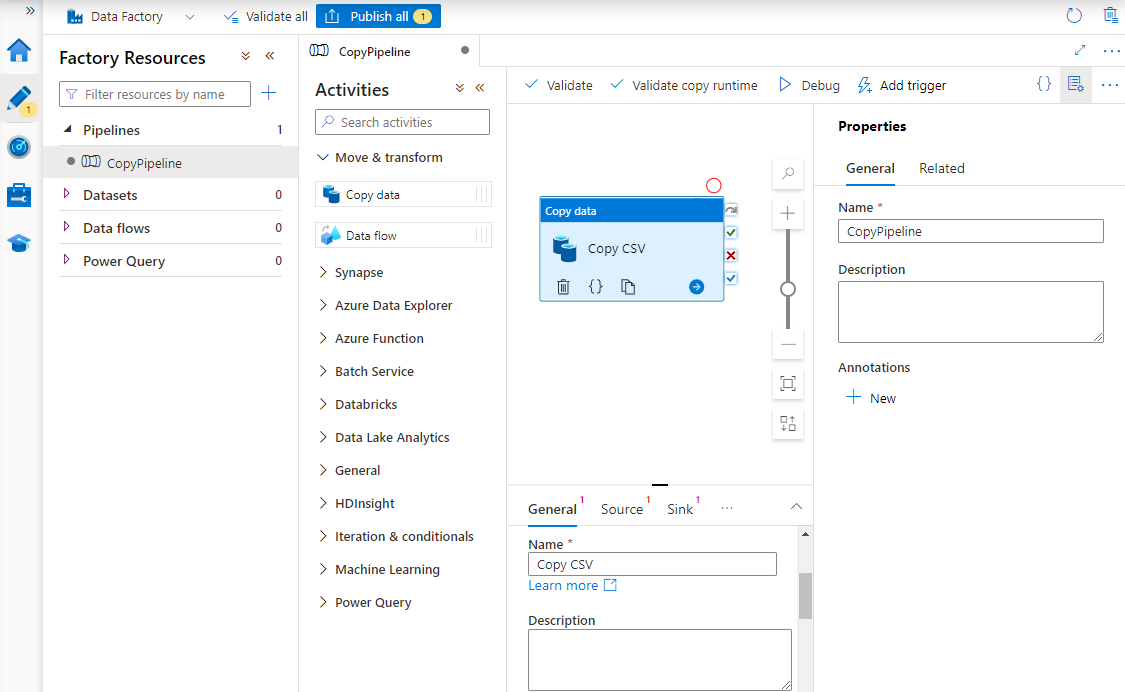

Voer onder Eigenschappen een naam in voor de pijplijn.

Vouw in de werkset Activiteiten de categorie Verplaatsen en transformeren uit en sleep de kopieergegevensactiviteit naar het ontwerpoppervlak voor pijplijnen. Voer onder in het ontwerpvenster op het tabblad Algemeen een naam in voor de kopieeractiviteit.

Bron configureren.

Selecteer op de pagina Activiteiten het tabblad Bron . Selecteer Nieuw om een brongegevensset te maken.

Selecteer in het dialoogvenster Nieuwe gegevensset de optie Azure Blob Storage en selecteer vervolgens Doorgaan.

Kies het indelingstype van uw gegevens en selecteer Vervolgens Doorgaan.

Selecteer Nieuw op de pagina Eigenschappen instellen onder Gekoppelde service.

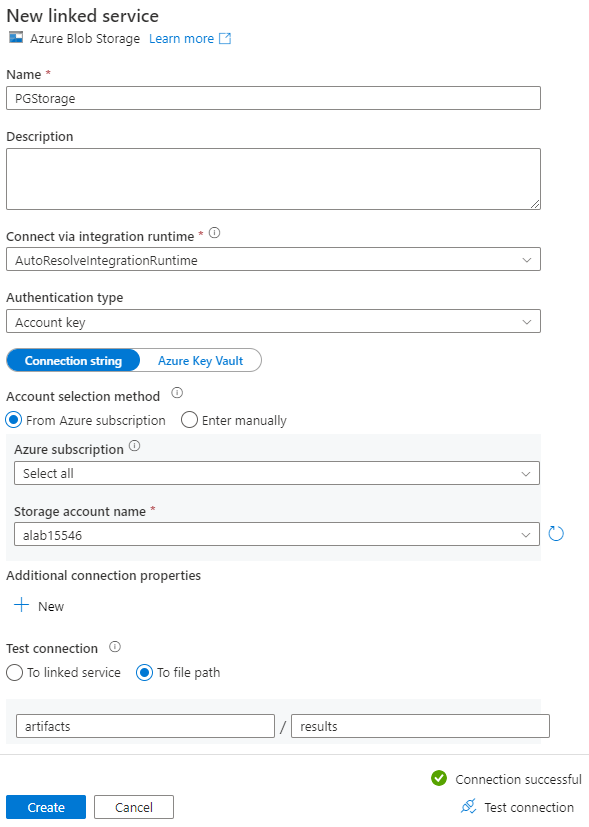

Voer op de pagina Nieuwe gekoppelde service een naam in voor de gekoppelde service en selecteer uw opslagaccount in de lijst met naam van het opslagaccount.

Selecteer onder Verbinding testen het bestandspad, voer de container en map in waarmee u verbinding wilt maken en selecteer vervolgens Verbinding testen.

Selecteer Maken om de configuratie op te slaan.

Selecteer OK in het scherm Eigenschappen instellen.

Sink configureren.

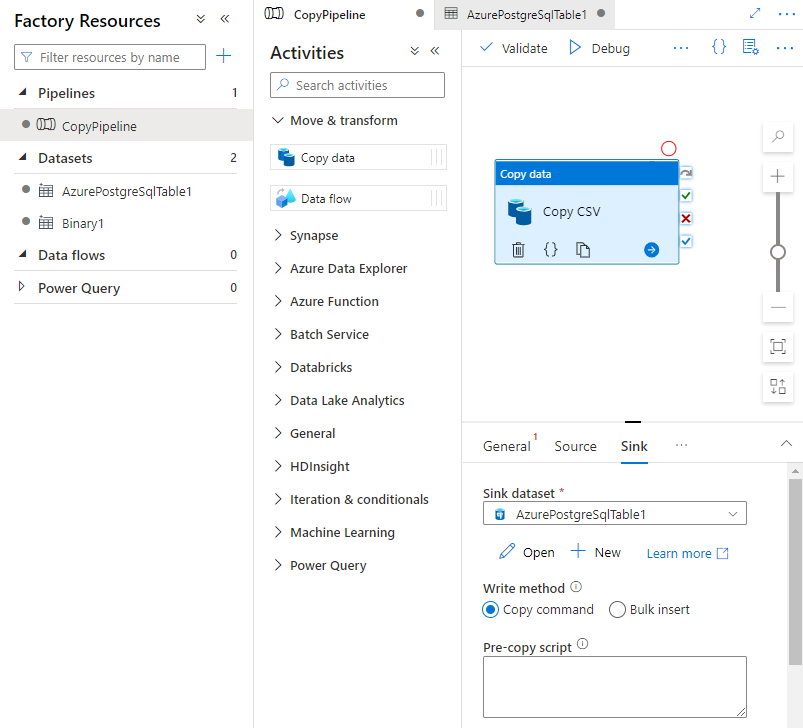

Selecteer op de pagina Activiteiten het tabblad Sink . Selecteer Nieuw om een sinkgegevensset te maken.

Selecteer Azure Database for PostgreSQL in het dialoogvenster Nieuwe gegevensset en selecteer vervolgens Doorgaan.

Selecteer Nieuw op de pagina Eigenschappen instellen onder Gekoppelde service.

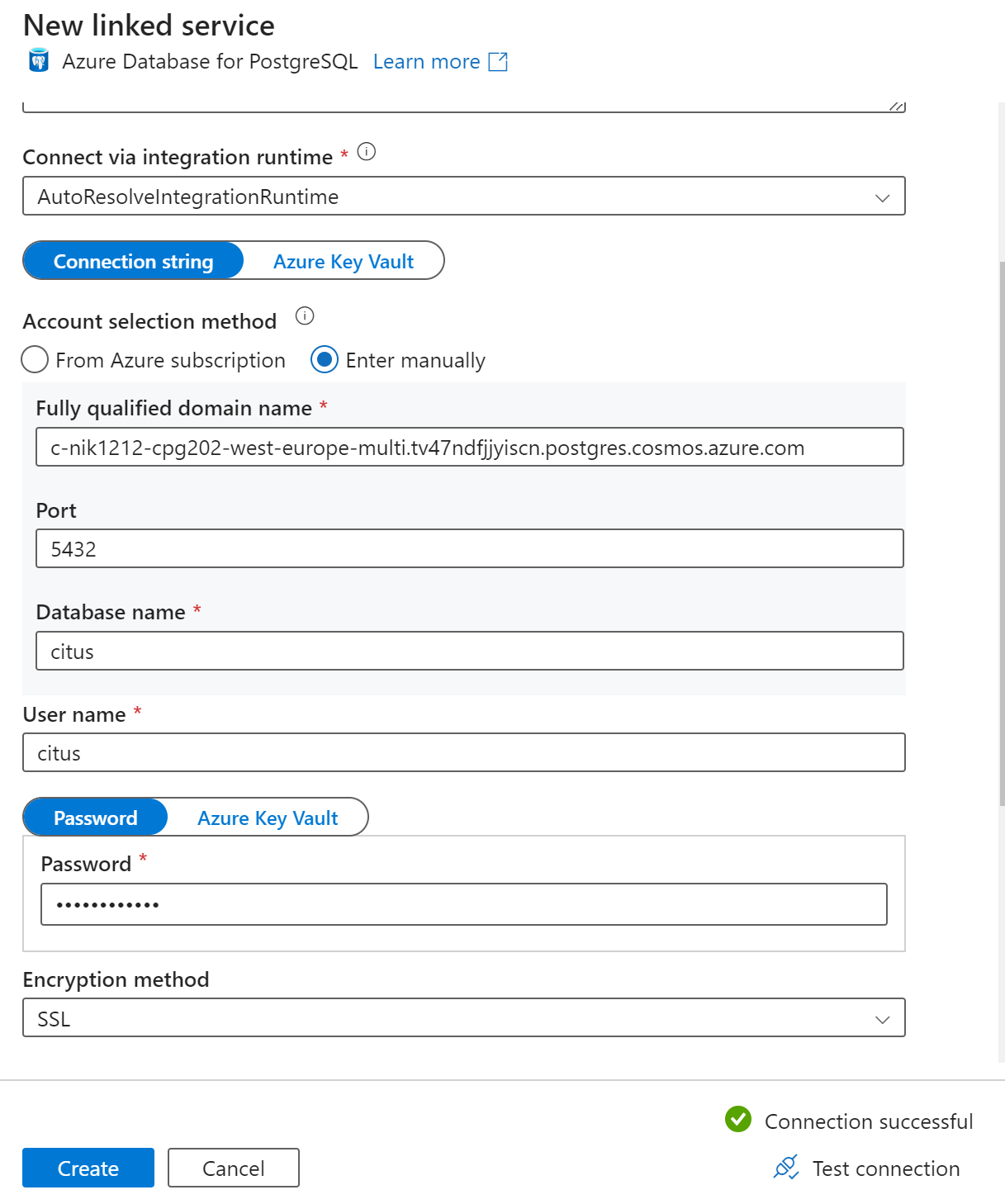

Voer op de pagina Nieuwe gekoppelde service een naam in voor de gekoppelde service en selecteer Handmatig invoeren in de selectiemethode Account.

Voer de coördinatornaam van uw cluster in het veld Fully Qualified Domain Name in. U kunt de naam van de coördinator kopiëren op de overzichtspagina van uw Azure Cosmos DB for PostgreSQL-cluster.

Laat standaardpoort 5432 in het veld Poort staan voor directe verbinding met de coördinator of vervang deze door poort 6432 om verbinding te maken met de beheerde PgBouncer-poort .

Voer de databasenaam in uw cluster in en geef referenties op om er verbinding mee te maken.

Selecteer SSL in de vervolgkeuzelijst Versleutelingsmethode .

Selecteer Verbinding testen onderaan het deelvenster om de sinkconfiguratie te valideren.

Selecteer Maken om de configuratie op te slaan.

Selecteer OK in het scherm Eigenschappen instellen.

Selecteer op het tabblad Sink op de pagina Activiteiten de optie Openen naast de vervolgkeuzelijst Sink-gegevensset en selecteer de tabelnaam in het doelcluster waar u de gegevens wilt opnemen.

Selecteer de opdracht Kopiëren onder Schrijfmethode.

Selecteer Valideren om de pijplijninstellingen te valideren in de werkbalk boven het canvas. Los eventuele fouten op, valideer opnieuw en zorg ervoor dat de pijplijn is gevalideerd.

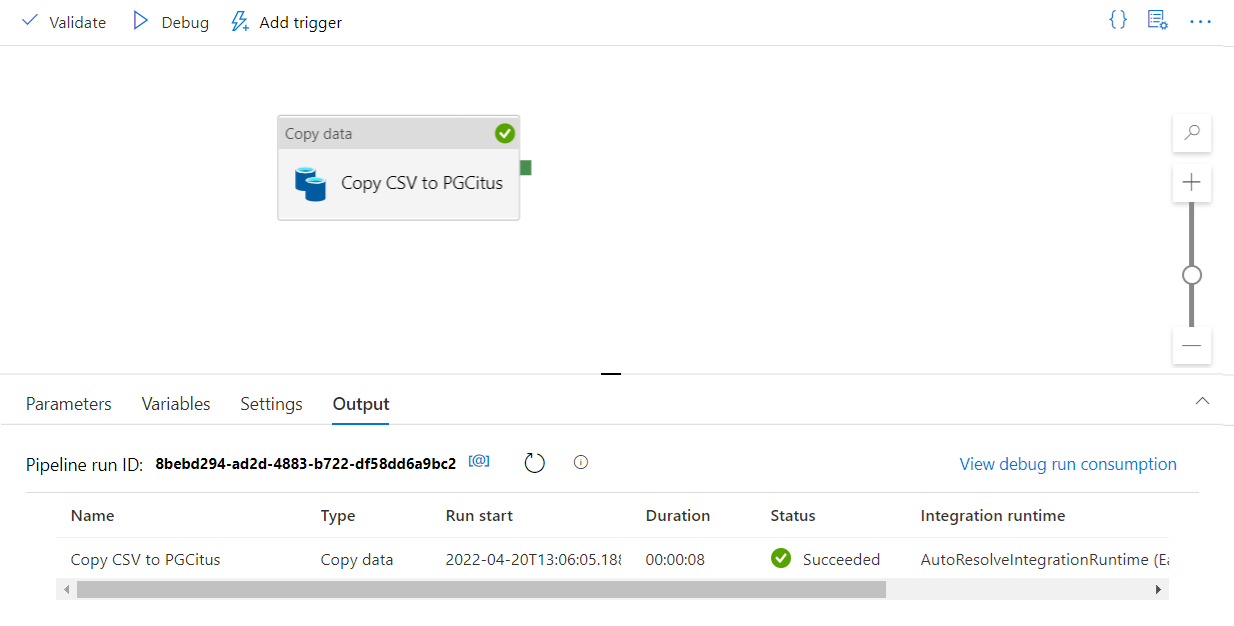

Selecteer Fouten opsporen in de werkbalk om de pijplijn uit te voeren.

Zodra de pijplijn kan worden uitgevoerd, selecteert u Alles publiceren in de bovenste werkbalk. Met deze actie publiceert u entiteiten (gegevenssets en pijplijnen) die u in Data Factory hebt gemaakt.

Een opgeslagen procedure aanroepen in Data Factory

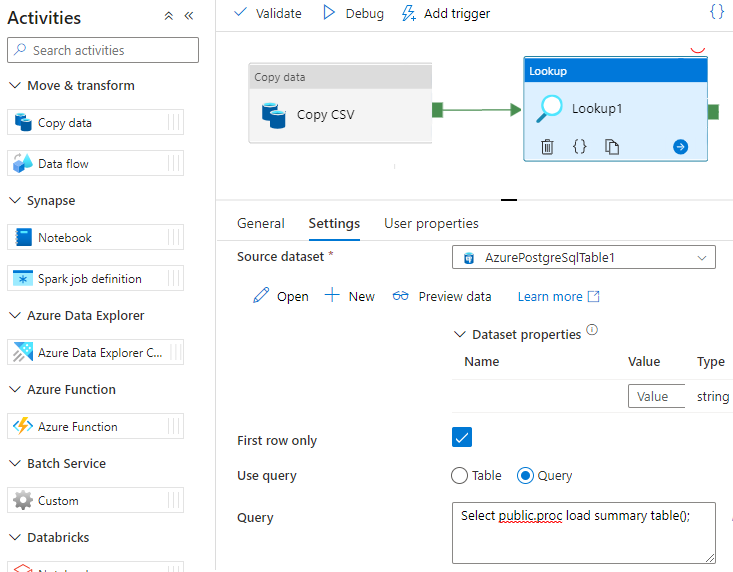

In sommige specifieke scenario's kunt u een opgeslagen procedure/functie aanroepen om geaggregeerde gegevens uit de faseringstabel naar de overzichtstabel te pushen. Data Factory biedt geen opgeslagen procedureactiviteit voor Azure Cosmos DB for PostgreSQL, maar als tijdelijke oplossing kunt u de opzoekactiviteit met een query gebruiken om een opgeslagen procedure aan te roepen, zoals hieronder wordt weergegeven:

Volgende stappen

- Meer informatie over het maken van een realtime dashboard met Azure Cosmos DB voor PostgreSQL.

- Meer informatie over het verplaatsen van uw workload naar Azure Cosmos DB for PostgreSQL