Wat is Responsible AI?

VAN TOEPASSING OP: Azure CLI ml extension v2 (current)

Azure CLI ml extension v2 (current) Python SDK azure-ai-ml v2 (current)

Python SDK azure-ai-ml v2 (current)

Verantwoorde kunstmatige intelligentie (verantwoordelijke AI) is een benadering voor het ontwikkelen, beoordelen en implementeren van AI-systemen op een veilige, betrouwbare en ethische manier. AI-systemen zijn het product van veel beslissingen die worden genomen door degenen die ze ontwikkelen en implementeren. Van systeemdoel tot hoe mensen communiceren met AI-systemen, verantwoorde AI kan helpen deze beslissingen proactief te leiden naar gunstigere en billijkere resultaten. Dat betekent dat mensen en hun doelstellingen centraal blijven in beslissingen over systeemontwerp en dat ze de duurzame waarden respecteren, zoals billijkheid, betrouwbaarheid en transparantie.

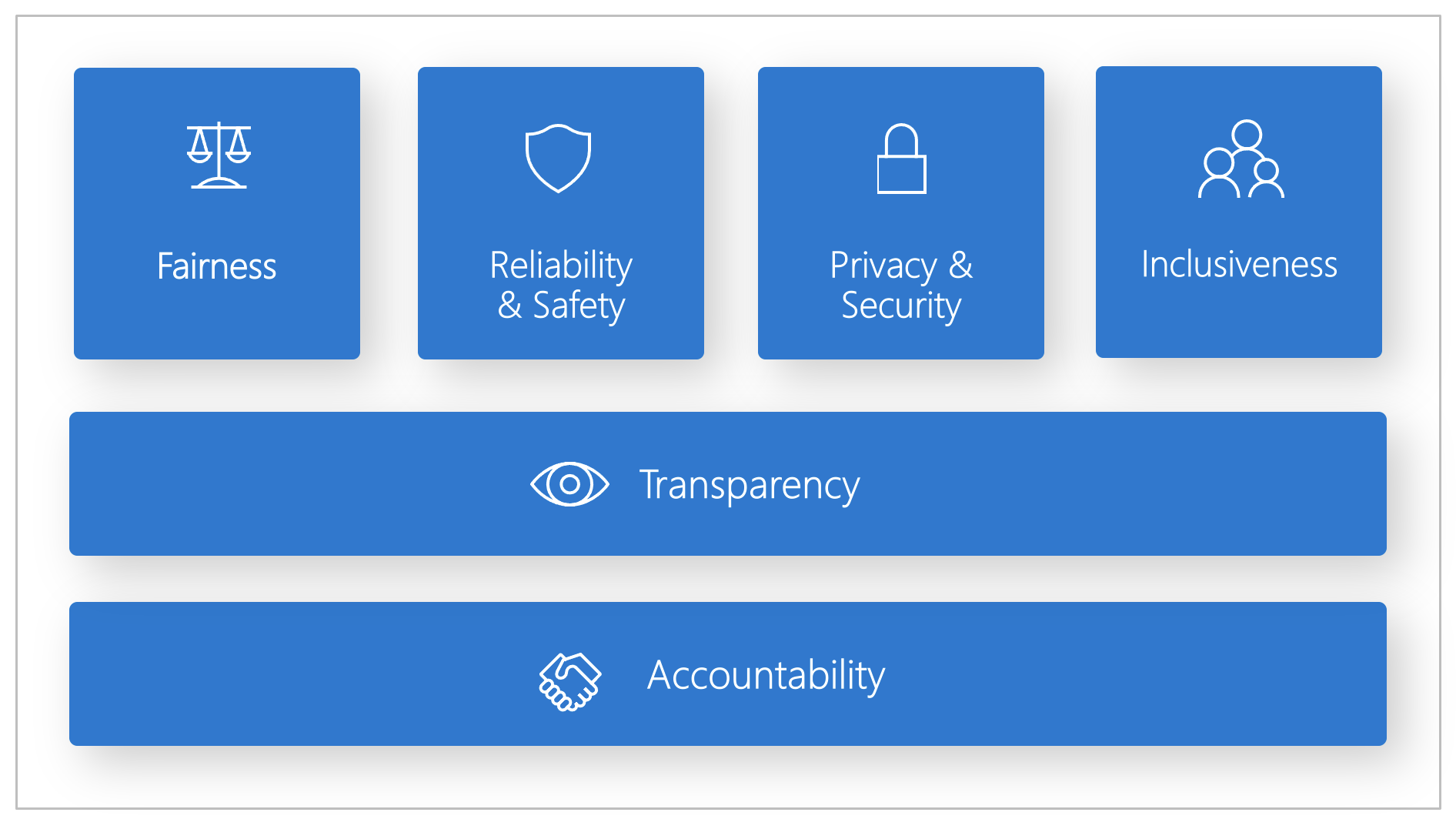

Microsoft heeft een Responsible AI Standard ontwikkeld. Het is een framework voor het bouwen van AI-systemen volgens zes principes: billijkheid, betrouwbaarheid en veiligheid, privacy en beveiliging, inclusiefheid, transparantie en verantwoordelijkheid. Voor Microsoft vormen deze principes de hoeksteen van een verantwoorde en betrouwbare benadering van AI, met name omdat intelligente technologie steeds vaker voorkomt in producten en services die mensen dagelijks gebruiken.

In dit artikel wordt gedemonstreerde hoe Azure Machine Learning hulpprogramma's ondersteunt voor het implementeren en operationeel maken van de zes principes voor ontwikkelaars en gegevenswetenschappers.

Billijkheid en inclusiefheid

AI-systemen moeten iedereen eerlijk behandelen en voorkomen dat dit van invloed is op vergelijkbare groepen mensen op verschillende manieren. Wanneer AI-systemen bijvoorbeeld richtlijnen bieden voor medische behandeling, leningsaanvragen of werkgelegenheid, moeten ze dezelfde aanbevelingen doen aan iedereen met vergelijkbare symptomen, financiële omstandigheden of beroepskwalificaties.

Fairness and inclusiveness in Azure Machine Learning: Met het onderdeel fairness assessment van het Responsible AI-dashboard kunnen gegevenswetenschappers en ontwikkelaars modelgetrouwheid beoordelen in gevoelige groepen die zijn gedefinieerd in termen van geslacht, etniciteit, leeftijd en andere kenmerken.

Betrouwbaarheid en veiligheid

Om vertrouwen te bouwen, is het essentieel dat AI-systemen betrouwbaar, veilig en consistent werken. Deze systemen moeten kunnen functioneren wanneer ze oorspronkelijk zijn ontworpen, veilig reageren op onverwachte omstandigheden en schadelijke manipulatie weerstaan. Hoe ze zich gedragen en de verscheidenheid aan voorwaarden die ze kunnen verwerken, weerspiegelen het bereik van situaties en omstandigheden die ontwikkelaars verwachten tijdens het ontwerpen en testen.

Betrouwbaarheid en veiligheid in Azure Machine Learning: Met het onderdeel foutanalyse van het dashboard verantwoorde AI kunnen gegevenswetenschappers en ontwikkelaars:

- Krijg een goed beeld van de verdeling van fouten voor een model.

- Identificeer cohorten (subsets) van gegevens met een hoger foutpercentage dan de algehele benchmark.

Deze verschillen kunnen optreden wanneer het systeem of model minder goed presteert voor specifieke demografische groepen of voor onregelmatig waargenomen invoervoorwaarden in de trainingsgegevens.

Transparency

Wanneer AI-systemen helpen beslissingen te informeren die enorme gevolgen hebben voor het leven van mensen, is het essentieel dat mensen begrijpen hoe deze beslissingen zijn genomen. Een bank kan bijvoorbeeld een AI-systeem gebruiken om te bepalen of een persoon kredietwaardig is. Een bedrijf kan een AI-systeem gebruiken om de meest gekwalificeerde kandidaten te bepalen die moeten worden aangenomen.

Een cruciaal onderdeel van transparantie is interpreteerbaarheid: de nuttige uitleg van het gedrag van AI-systemen en hun onderdelen. Het verbeteren van de interpreteerbaarheid vereist dat belanghebbenden begrijpen hoe en waarom AI-systemen werken zoals ze dat doen. De belanghebbenden kunnen vervolgens potentiële prestatieproblemen, billijkheidsproblemen, uitsluitingspraktijken of onbedoelde resultaten identificeren.

Transparantie in Azure Machine Learning: met de modelinterpretabiliteit en contrafactuele wat-als-onderdelen van het verantwoordelijke AI-dashboard kunnen gegevenswetenschappers en ontwikkelaars begrijpelijke beschrijvingen genereren van de voorspellingen van een model.

Het model interpreteerbaarheidsonderdeel biedt meerdere weergaven in het gedrag van een model:

- Globale uitleg. Welke functies zijn bijvoorbeeld van invloed op het algehele gedrag van een leningtoewijzingsmodel?

- Lokale uitleg. Waarom is de leningsaanvraag van een klant bijvoorbeeld goedgekeurd of afgewezen?

- Modeluitleg voor een geselecteerd cohort van gegevenspunten. Welke functies zijn bijvoorbeeld van invloed op het algehele gedrag van een leningtoewijzingsmodel voor aanvragers met een laag inkomen?

Het contrafactuele wat-als-onderdeel maakt het mogelijk om een machine learning-model te begrijpen en fouten op te sporen in termen van hoe het reageert op functiewijzigingen en -verstoringen.

Azure Machine Learning biedt ook ondersteuning voor een verantwoordelijke AI-scorecard. De scorecard is een aanpasbaar PDF-rapport dat ontwikkelaars eenvoudig kunnen configureren, genereren, downloaden en delen met hun technische en niet-technische belanghebbenden om hen te informeren over hun gegevenssets en modelstatus, naleving te bereiken en vertrouwen te bouwen. Deze scorecard kan ook worden gebruikt in controlebeoordelingen om de kenmerken van machine learning-modellen te ontdekken.

Privacy en beveiliging

Naarmate AI steeds vaker voorkomt, wordt het beschermen van privacy en het beveiligen van persoonlijke en zakelijke gegevens belangrijker en complexer. Voor AI, privacy en gegevensbeveiliging is veel aandacht vereist, omdat de toegang tot gegevens essentieel is voor AI-systemen om nauwkeurige en geïnformeerde voorspellingen en beslissingen over mensen te nemen. AI-systemen moeten voldoen aan privacywetten die:

- Transparantie vereisen over het verzamelen, gebruiken en opslaan van gegevens.

- Verplicht stellen dat consumenten de juiste controles hebben om te kiezen hoe hun gegevens worden gebruikt.

Privacy en beveiliging in Azure Machine Learning: Met Azure Machine Learning kunnen beheerders en ontwikkelaars een veilige configuratie maken die voldoet aan het beleid van hun bedrijf. Met Azure Machine Learning en het Azure-platform kunnen gebruikers het volgende doen:

- Beperk de toegang tot resources en bewerkingen per gebruikersaccount of groep.

- Binnenkomende en uitgaande netwerkcommunicatie beperken.

- Versleutel gegevens die worden verzonden en at-rest.

- Scannen op beveiligingsproblemen.

- Configuratiebeleid toepassen en controleren.

Microsoft heeft ook twee opensource-pakketten gemaakt die verdere implementatie van privacy- en beveiligingsprincipes mogelijk maken:

SmartNoise: Differentiële privacy is een set systemen en procedures die helpen de gegevens van personen veilig en privé te houden. In machine learning-oplossingen kan differentiële privacy vereist zijn voor naleving van regelgeving. SmartNoise is een opensource-project (mede ontwikkeld door Microsoft) dat onderdelen bevat voor het bouwen van differentiële privésystemen die wereldwijd zijn.

Counterfit: Counterfit is een opensource-project dat bestaat uit een opdrachtregelprogramma en een algemene automatiseringslaag, zodat ontwikkelaars cyberaanvallen kunnen simuleren op AI-systemen. Iedereen kan het hulpprogramma downloaden en implementeren via Azure Cloud Shell om in een browser uit te voeren of lokaal te implementeren in een Anaconda Python-omgeving. Het kan AI-modellen evalueren die worden gehost in verschillende cloudomgevingen, on-premises of in de rand. Het hulpprogramma is agnostisch voor AI-modellen en ondersteunt verschillende gegevenstypen, waaronder tekst, afbeeldingen of algemene invoer.

Verantwoordelijkheid

De personen die AI-systemen ontwerpen en implementeren, moeten verantwoordelijk zijn voor de werking van hun systemen. Organisaties moeten gebruikmaken van industriestandaarden om verantwoordingsnormen te ontwikkelen. Deze normen kunnen ervoor zorgen dat AI-systemen niet de uiteindelijke autoriteit zijn voor beslissingen die van invloed zijn op het leven van mensen. Ze kunnen er ook voor zorgen dat mensen zinvolle controle houden over anderszins zeer autonome AI-systemen.

Verantwoordelijkheid in Azure Machine Learning: Machine Learning-bewerkingen (MLOps) is gebaseerd op DevOps-principes en -procedures die de efficiëntie van AI-werkstromen verhogen. Azure Machine Learning biedt de volgende MLOps-mogelijkheden voor betere verantwoordelijkheid van uw AI-systemen:

- Registreer, verpakt en implementeer modellen vanaf elke locatie. U kunt ook de gekoppelde metagegevens bijhouden die vereist zijn voor het gebruik van het model.

- Leg de governancegegevens vast voor de end-to-end levenscyclus van machine learning. De vastgelegde herkomstgegevens kunnen omvatten wie modellen publiceert, waarom er wijzigingen zijn aangebracht en wanneer modellen in productie zijn geïmplementeerd of gebruikt.

- Informeer en waarschuw gebeurtenissen in de levenscyclus van Machine Learning. Voorbeelden hiervan zijn voltooiing van experimenten, modelregistratie, modelimplementatie en detectie van gegevensdrift.

- Bewaak toepassingen voor operationele problemen en problemen met betrekking tot machine learning. Vergelijk modelinvoer tussen training en deductie, verken modelspecifieke metrische gegevens en geef bewaking en waarschuwingen op uw machine learning-infrastructuur.

Naast de MLOps-mogelijkheden creëert de verantwoordelijke AI-scorecard in Azure Machine Learning verantwoording door communicatie tussen belanghebbenden mogelijk te maken. De scorecard creëert ook verantwoordelijkheid door ontwikkelaars in staat te stellen hun modelstatusinzichten te configureren, te downloaden en te delen met hun technische en niet-technische belanghebbenden over AI-gegevens en modelstatus. Het delen van deze inzichten kan helpen bij het opbouwen van vertrouwen.

Het Machine Learning-platform maakt besluitvorming ook mogelijk door zakelijke beslissingen te informeren via:

- Gegevensgestuurde inzichten om belanghebbenden te helpen bij het begrijpen van causale behandelingseffecten op een resultaat door alleen historische gegevens te gebruiken. Bijvoorbeeld: "Hoe zou een geneesmiddel de bloeddruk van een patiënt beïnvloeden?" Deze inzichten worden geboden via het causale deductieonderdeel van het Dashboard verantwoorde AI.

- Modelgestuurde inzichten om vragen van gebruikers te beantwoorden (zoals 'Wat kan ik doen om een ander resultaat te krijgen van uw AI volgende keer?') zodat ze actie kunnen ondernemen. Dergelijke inzichten worden gegeven aan gegevenswetenschappers via het contrafactuele wat-als-onderdeel van het verantwoordelijke AI-dashboard.

Volgende stappen

- Zie het Dashboard voor verantwoorde AI voor meer informatie over het implementeren van verantwoorde AI in Azure Machine Learning.

- Meer informatie over het genereren van het verantwoordelijke AI-dashboard via CLI en SDK of Azure Machine Learning-studio ui.

- Meer informatie over het genereren van een verantwoordelijke AI-scorecard op basis van de inzichten die zijn waargenomen in uw Dashboard voor verantwoorde AI.

- Meer informatie over de Responsible AI Standard voor het bouwen van AI-systemen volgens zes belangrijke principes.