Het Team Datawetenschap Process (TDSP) is een flexibele, iteratieve data science-methodologie die u kunt gebruiken om predictive analytics-oplossingen en AI-toepassingen efficiënt te leveren. De TDSP helpt bij het verbeteren van teamsamenwerking en leren door aan te geven hoe teamrollen het beste samenwerken. De TDSP bevat best practices en structuren van Microsoft en andere toonaangevende bedrijven om uw team te helpen bij het implementeren van data science-initiatieven en het volledig realiseren van de voordelen van uw analyseprogramma.

Dit artikel bevat een overzicht van TDSP en de belangrijkste onderdelen hiervan. Het bevat richtlijnen over het implementeren van de TDSP met behulp van Microsoft-hulpprogramma's en -infrastructuur. In het artikel vindt u meer gedetailleerde informatiebronnen.

Belangrijke onderdelen van de TDSP

De TDSP heeft de volgende belangrijke onderdelen:

- Een definitie van de data science-levenscyclus

- Een gestandaardiseerde projectstructuur

- Aanbevolen infrastructuur en bronnen voor data science-projecten

- Aanbevolen hulpprogramma's voor het uitvoeren van projecten

Data science-levenscyclus

De TDSP biedt een levenscyclus die u kunt gebruiken om de ontwikkeling van uw data science-projecten te structuren. De levenscyclus geeft een overzicht van de volledige stappen die voor succesvolle projecten moeten worden gevolgd.

U kunt de op taken gebaseerde TDSP combineren met andere levenscycluss van data science, zoals het standaardproces voor gegevensanalyse (CRISP-DM), het kennisdetectieproces in databases (KDD) of een ander aangepast proces. Deze verschillende methodologieën hebben in de basis veel gemeen.

U moet deze levenscyclus gebruiken als u een data science-project hebt dat deel uitmaakt van een intelligente toepassing. Intelligente toepassingen implementeren machine learning- of AI-modellen voor predictive analytics. U kunt dit proces ook gebruiken voor experimentele data science-projecten en geïmproviseerde analyseprojecten.

De TDSP-levenscyclus bestaat uit vijf belangrijke fasen die uw team iteratief uitvoert. Deze fasen zijn onder andere:

Hier volgt een visuele weergave van de TDSP-levenscyclus:

Zie de levenscyclus van het team Datawetenschap proces voor informatie over de doelen, taken en documentatieartefacten voor elke fase.

Deze taken en artefacten zijn gekoppeld aan projectrollen, bijvoorbeeld:

- Oplossingsarchitect.

- Projectmanager.

- Data engineer.

- Gegevenswetenschapper.

- Toepassingsontwikkelaar.

- Projectleider.

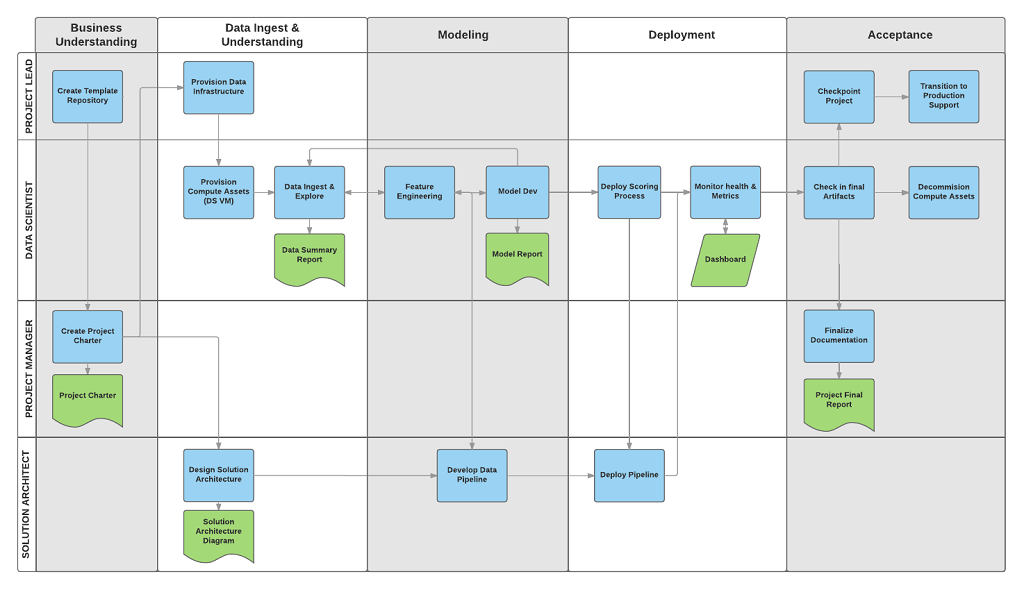

In het volgende diagram ziet u de taken (blauw) en artefacten (groen) die zijn gekoppeld aan elke fase van de levenscyclus (op de horizontale as) voor deze rollen (op de verticale as).

Gestandaardiseerde projectstructuur

Uw team kan de Azure-infrastructuur gebruiken om uw data science-assets te organiseren.

Azure Machine Learning ondersteunt de opensource-MLflow. U wordt aangeraden MLflow te gebruiken voor gegevenswetenschap en AI-projectbeheer. MLflow is ontworpen voor het beheren van de volledige levenscyclus van machine learning. Het traint en bedient modellen op verschillende platforms, zodat u een consistente set hulpprogramma's kunt gebruiken, ongeacht waar uw experimenten worden uitgevoerd. U kunt MLflow lokaal gebruiken op uw computer, op een extern rekendoel, op een virtuele machine of op een Machine Learning-rekenproces.

MLflow bestaat uit verschillende belangrijke functies:

Experimenten bijhouden: Met MLflow kunt u experimenten bijhouden, waaronder parameters, codeversies, metrische gegevens en uitvoerbestanden. Met deze functie kunt u verschillende uitvoeringen vergelijken en het experimenteerproces efficiënt beheren.

Pakketcode: Het biedt een gestandaardiseerde indeling voor het verpakken van machine learning-code, waaronder afhankelijkheden en configuraties. Deze verpakking maakt het eenvoudiger om uitvoeringen te reproduceren en code met anderen te delen.

Modellen beheren: MLflow biedt functionaliteiten voor het beheren en versiebeheer van modellen. Het ondersteunt verschillende machine learning-frameworks, zodat u modellen kunt opslaan, versien en bedienen.

Modellen leveren en implementeren: MLflow integreert modelfuncties en implementatiemogelijkheden, zodat u eenvoudig modellen in diverse omgevingen kunt implementeren.

Modellen registreren: U kunt de levenscyclus van een model beheren, inclusief versiebeheer, faseovergangen en aantekeningen. MLflow is handig voor het onderhouden van een gecentraliseerd modelarchief in een samenwerkingsomgeving.

Een API en gebruikersinterface gebruiken: In Azure wordt MLflow gebundeld in machine learning-API versie 2, zodat u programmatisch met het systeem kunt werken. U kunt Azure Portal gebruiken om te communiceren met een gebruikersinterface.

MLflow is erop gericht het proces van machine learning-ontwikkeling te vereenvoudigen en te standaardiseren, van experimenten tot implementatie.

Machine Learning kan worden geïntegreerd met Git-opslagplaatsen, zodat u git-compatibele services kunt gebruiken: GitHub, GitLab, Bitbucket, Azure DevOps of een andere git-compatibele service. Naast de assets die al in Machine Learning zijn bijgehouden, kan uw team hun eigen taxonomie ontwikkelen binnen hun met Git compatibele service om andere projectgegevens op te slaan, zoals:

- Documentatie

- Project, bijvoorbeeld het uiteindelijke projectrapport

- Gegevensrapport, bijvoorbeeld de gegevenswoordenlijst of rapporten over gegevenskwaliteit

- Model, bijvoorbeeld modelrapporten

- Code

- Gegevensvoorbereiding

- Modelontwikkeling

- Operationalisatie, inclusief beveiliging en naleving

Infrastructuur en resources

De TDSP biedt aanbevelingen voor het beheren van gedeelde analyses en opslaginfrastructuur, zoals:

- Cloudbestandssystemen voor het opslaan van gegevenssets

- Databases

- Big data-clusters, bijvoorbeeld SQL of Spark

- Machine learning-services

U kunt de analyse- en opslaginfrastructuur, waar onbewerkte en verwerkte gegevenssets worden opgeslagen, in de cloud of on-premises plaatsen. Met deze infrastructuur zijn reproduceerbare analyses mogelijk. Het voorkomt ook duplicatie, wat kan leiden tot inconsistenties en onnodige infrastructuurkosten. De infrastructuur heeft hulpprogramma's om de gedeelde resources in te richten, ze bij te houden en elk teamlid in staat te stellen om veilig verbinding te maken met deze resources. Het is ook een goede gewoonte om projectleden een consistente rekenomgeving te laten maken. Verschillende teamleden kunnen vervolgens experimenten repliceren en valideren.

Hier volgt een voorbeeld van een team dat aan meerdere projecten werkt en verschillende onderdelen van de cloudanalyseinfrastructuur deelt:

Hulpprogramma's

In de meeste organisaties is het lastig om processen te introduceren. De infrastructuur biedt hulpprogramma's voor het implementeren van de TDSP en levenscyclus om de obstakels te verlagen en de consistentie van hun acceptatie te vergroten.

Met Machine Learning kunnen gegevenswetenschappers opensource-hulpprogramma's toepassen als onderdeel van de data science-pijplijn of -werkstroom. Binnen Machine Learning bevordert Microsoft verantwoorde AI-hulpprogramma's, waarmee de verantwoordelijke AI-standaard van Microsoft wordt bereikt.

Door peer beoordeeld bronvermeldingen

TDSP is een gevestigde methodologie die wordt gebruikt in Microsoft-afspraken en is daarom gedocumenteerd en bestudeerd in literatuur die door peers is beoordeeld. Deze bronvermeldingen bieden de mogelijkheid om TDSP-functies en -toepassingen te onderzoeken. Zie de overzichtspagina van de levenscyclus voor een lijst met bronvermeldingen.