Overzicht van oogtraceringsvoorbeelden — MRTK2

In dit onderwerp wordt beschreven hoe u snel aan de slag kunt met oogtracering in MRTK door voort te bouwen op MRTK-voorbeelden voor oogtracering (Assets/MRTK/Examples/Demos/EyeTracking). Met deze voorbeelden kunt u een van onze nieuwe magische invoermogelijkheden ervaren: Oogtracering! De demo bevat verschillende use cases, variërend van impliciete ooggebaseerde activeringen tot het naadloos combineren van informatie over wat u bekijkt met spraak en handinvoer . Hierdoor kunnen gebruikers snel en moeiteloos holografische inhoud selecteren en verplaatsen in hun weergave door simpelweg naar een doel te kijken en 'Selecteren' te zeggen of een handgebaar uit te voeren. De demo's bevatten ook een voorbeeld voor het schuiven, pannen en zoomen van tekst en afbeeldingen op een lei. Ten slotte wordt een voorbeeld gegeven voor het opnemen en visualiseren van de visuele aandacht van de gebruiker op een 2D-lei. In de volgende sectie vindt u meer informatie over wat elk van de verschillende voorbeelden in het MRTK-voorbeeldpakket voor oogtracering (Assets/MRTK/Examples/Demos/EyeTracking) bevat:

![]()

In de volgende sectie vindt u een kort overzicht van waar de afzonderlijke oogtraceringsdemoscènes over gaan. De MRTK oogtraceringsdemoscènes zijn additief geladen. Hieronder wordt uitgelegd hoe u dit instelt.

Overzicht van de voorbeelddemo's voor oogtracering

Door het oog ondersteunde doelselectie

Deze zelfstudie laat zien hoe eenvoudig u toegang hebt tot oog-blikgegevens om doelen te selecteren. Het bevat een voorbeeld van subtiele maar krachtige feedback om de gebruiker het vertrouwen te geven dat een doel is gericht zonder overweldigend te zijn. Daarnaast is er een eenvoudig voorbeeld van slimme meldingen die automatisch verdwijnen nadat ze zijn gelezen.

Samenvatting: Snelle en moeiteloze doelselecties met behulp van een combinatie van ogen, stem en handinvoer.

Door ogen ondersteunde navigatie

Stel dat u bepaalde informatie leest op een beeldscherm op afstand of uw e-reader en wanneer u het einde van de weergegeven tekst bereikt, schuift de tekst automatisch omhoog om meer inhoud weer te geven. Of wat dacht je van magisch zoomen naar waar je naar keek? Dit zijn enkele voorbeelden die in deze zelfstudie worden getoond met betrekking tot navigatie met oog-ondersteuning. Daarnaast is er een voorbeeld voor handsfree draaien van 3D-hologrammen door ze automatisch te laten draaien op basis van uw huidige focus.

Samenvatting: Schuiven, pannen, zoomen, 3D-draaiing met behulp van een combinatie van ogen, stem en handinvoer.

Door het oog ondersteunde plaatsing

Deze zelfstudie toont een invoerscenario met de naam Put-That-There dat teruggaat tot onderzoek van het MIT Media Lab in de vroege jaren 1980 met oog-, hand- en spraakinvoer. Het idee is eenvoudig: profiteer van uw ogen voor snelle doelselectie en plaatsing. Kijk gewoon naar een hologram en zeg 'zet dit op', kijk waar u het wilt plaatsen en zeg 'daar!'. Voor een preciezere plaatsing van uw hologram kunt u extra invoer van uw handen, stem of controllers gebruiken.

Samenvatting: Plaats hologrammen met behulp van ogen, stem en handinvoer (slepen en neerzetten). Ogen ondersteunde schuifregelaars met ogen en handen.

Visualisatie van visuele aandacht

Gegevens op basis van waar gebruikers naar kijken, zijn een enorm krachtig hulpmiddel om de bruikbaarheid van een ontwerp te beoordelen en problemen in efficiënte werkstromen te identificeren. In deze zelfstudie worden verschillende oogtraceringsvisualisaties besproken en wordt uitgelegd hoe deze in verschillende behoeften passen. We bieden basisvoorbeelden voor logboekregistratie en het laden van oogtraceringsgegevens en voorbeelden voor het visualiseren ervan.

Samenvatting: Tweedimensionale aandachtskaart (heatmaps) op leien. Het opnemen & het opnieuw afspelen van oogtraceringsgegevens.

De MRTK-voorbeelden voor oogtracering instellen

Vereisten

Houd er rekening mee dat het gebruik van de oogtraceringsvoorbeelden op het apparaat een HoloLens 2 en een voorbeeld-app-pakket vereist dat is gebouwd met de mogelijkheid 'Gaze Input' op de AppXManifest van het pakket.

Als u deze voorbeelden voor oogtracering op het apparaat wilt gebruiken, moet u deze stappen volgen voordat u de app in Visual Studio bouwt.

1. Laad EyeTrackingDemo-00-RootScene.unity

De EyeTrackingDemo-00-RootScene is de basisscène (root) waarin alle MRTK-kernonderdelen zijn opgenomen. Dit is de scène die u eerst moet laden en van waaruit u de oogtraceringsdemo's gaat uitvoeren. Het beschikt over een grafisch scènemenu waarmee u eenvoudig kunt schakelen tussen de verschillende oogtraceringsvoorbeelden die additief worden geladen.

![]()

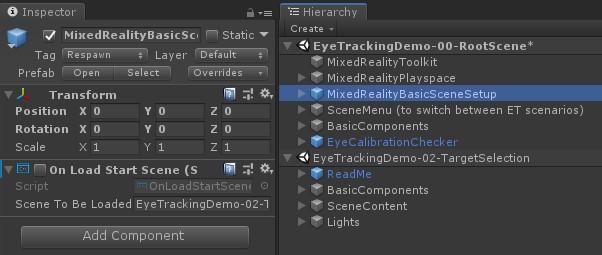

De hoofdscène bevat enkele kernonderdelen die behouden blijven voor de extra geladen scènes, zoals de mrtk geconfigureerde profielen en scènecamera. MixedRealityBasicSceneSetup (zie de onderstaande schermopname) bevat een script waarmee de scène waarnaar wordt verwezen, automatisch wordt geladen bij het opstarten. Standaard is dit EyeTrackingDemo-02-TargetSelection.

![]()

2. Scènes toevoegen aan het buildmenu

Als u additieve scènes tijdens runtime wilt laden, moet u deze scènes eerst toevoegen aan uw Build-instellingen -> Scènes in het menu Bouwen . Het is belangrijk dat de hoofdscène wordt weergegeven als de eerste scène in de lijst:

![]()

3. De oogtraceringsvoorbeelden afspelen in de Unity-editor

Nadat u de oogtraceringscènes hebt toegevoegd aan de build-instellingen en de EyeTrackingDemo-00-RootScene hebt geladen, is er nog één ding dat u mogelijk wilt controleren: is het script 'OnLoadStartScene' dat is gekoppeld aan het MixedRealityBasicSceneSetup GameObject ingeschakeld? Dit is om de hoofdscène te laten weten welke demoscène het eerst moet worden geladen.

![]()

Laten we rollen! Druk op 'Afspelen'. U ziet verschillende edelstenen verschijnen en het scènemenu bovenaan.

![]()

U ziet ook een kleine semitransparante cirkel in het midden van de gameweergave. Dit fungeert als een indicator (cursor) van uw gesimuleerde oog staren: druk gewoon op de rechtermuisknop en beweeg de muis om de positie te wijzigen. Wanneer de cursor boven de edelstenen beweegt, ziet u dat deze wordt uitgelijnd naar het midden van de momenteel bekeken edelsteen. Dit is een uitstekende manier om te testen of gebeurtenissen worden geactiveerd zoals verwacht bij het 'kijken' naar een doel. Houd er rekening mee dat de gesimuleerde ogen kijken via muisbesturing een nogal slechte aanvulling is op onze snelle en onbedoelde oogbewegingen. Het is echter ideaal voor het testen van de basisfunctionaliteit voordat u het ontwerp door het te implementeren op het HoloLens 2 apparaat. Terugkerend naar onze voorbeeldscène voor oogtracering: Het juweeltje draait zolang er naar wordt gekeken en kan worden vernietigd door er "naar te kijken" en ...

- Op Enter drukken (dit simuleert het zeggen van 'selecteren')

- 'selecteren' zeggen in uw microfoon

- Terwijl u op de spatiebalk drukt om de gesimuleerde handinvoer weer te geven, klikt u op de linkermuisknop om een gesimuleerde knijpbewerking uit te voeren

We beschrijven in meer detail hoe u deze interacties kunt bereiken in onze zelfstudie Over het oog ondersteunde doelselectie .

Wanneer u de cursor naar de bovenste menubalk in de scène verplaatst, ziet u dat het item dat momenteel wordt aangehouden, subtiel wordt gemarkeerd. U kunt het momenteel gemarkeerde item selecteren met behulp van een van de hierboven beschreven doorvoermethoden (bijvoorbeeld door op Enter te drukken). Op deze manier kunt u schakelen tussen de verschillende voorbeeldscènes voor ogentracering.

4. Specifieke subscènes testen

Wanneer u aan een specifiek scenario werkt, wilt u mogelijk niet elke keer het scènemenu doorlopen. In plaats daarvan kunt u rechtstreeks beginnen vanuit de scène waaraan u momenteel werkt wanneer u op de knop Afspelen drukt. Geen probleem! U kunt het volgende doen:

De hoofdscène laden

Schakel in de hoofdscène het script 'OnLoadStartScene' uit

Sleep een van de testscènes voor oogtracering die hieronder worden beschreven (of een andere scène) naar de weergave Hiërarchie , zoals wordt weergegeven in de onderstaande schermafbeelding.

Druk op Afspelen

Houd er rekening mee dat het laden van de subscène zoals deze niet permanent is: dit betekent dat als u uw app implementeert op het HoloLens 2-apparaat, alleen de hoofdscène wordt geladen (ervan uitgaande dat deze boven aan uw build-instellingen wordt weergegeven). Wanneer u uw project met anderen deelt, worden de subscènes ook niet automatisch geladen.

Nu u weet hoe u de MRTK-voorbeeldscènes voor oogtracering kunt laten werken, gaan we dieper in op het selecteren van hologrammen met uw ogen: Door het oog ondersteunde doelselectie.