Informacje o wersji CNTK w wersji 2.7

Szanowna społeczność,

Dzięki ciągłym współtworzeniu środowiska ONNX i środowiska uruchomieniowego ONNX ułatwiliśmy współdziałanie w ekosystemie platformy sztucznej inteligencji oraz uzyskiwanie dostępu do wysokiej wydajności, możliwości wnioskowania międzyplatformowego zarówno dla tradycyjnych modeli uczenia maszynowego, jak i głębokich sieci neuronowych. W ciągu ostatnich kilku lat mieliśmy zaszczyt opracowywać takie kluczowe projekty uczenia maszynowego typu open source, w tym Microsoft Cognitive Toolkit, które umożliwiły swoim użytkownikom wykorzystanie w całej branży postępów w uczeniu głębokim na dużą skalę.

Dzisiejsza wersja 2.7 będzie ostatnią główną wersją CNTK. Możemy mieć kilka kolejnych wersji pomocniczych poprawek błędów, ale zostaną one ocenione na podstawie przypadku. W tej wersji nie ma planów dotyczących tworzenia nowych funkcji.

Wersja CNTK 2.7 ma pełną obsługę środowiska ONNX 1.4.1 i zachęcamy tych, którzy starają się zoperacjonalizować swoje modele CNTK, aby skorzystać ze środowiska ONNX i środowiska uruchomieniowego ONNX. W przyszłości użytkownicy mogą nadal korzystać ze zmieniających się innowacji ONNX za pośrednictwem liczby struktur, które je obsługują. Na przykład użytkownicy mogą natywnie eksportować modele ONNX z biblioteki PyTorch lub konwertować modele TensorFlow na ONNX za pomocą konwertera TensorFlow-ONNX.

Jesteśmy niesamowicie wdzięczni za wszystkie wsparcie, które otrzymaliśmy od współautorów i użytkowników przez lata od początkowej wersji open source CNTK. CnTK umożliwiło zespołom firmy Microsoft i użytkownikom zewnętrznym wykonywanie złożonych i dużych obciążeń we wszystkich aplikacjach uczenia głębokiego, takich jak historyczne przełomy w rozpoznawaniu mowy osiągnięte przez badaczy usługi Microsoft Speech, twórców platformy.

Ponieważ ONNX jest coraz częściej wykorzystywany w obsłudze modeli używanych w produktach firmy Microsoft, takich jak Bing i Office, jesteśmy oddani do synchronizowania innowacji z badań z rygorystycznymi wymaganiami produkcji, aby rozwijać ekosystem.

Przede wszystkim naszym celem jest wprowadzenie innowacji w uczeniu głębokim w obrębie stosów oprogramowania i sprzętu tak otwartych i dostępnych, jak to możliwe. Będziemy ciężko pracować, aby zapewnić zarówno istniejące mocne strony CNTK, jak i nowe najnowocześniejsze badania nad innymi projektami typu open source, aby naprawdę poszerzyć zasięg takich technologii.

Z wdzięcznością,

-- Zespół CNTK

Najważniejsze funkcje w tej wersji

- Przeniesiono do interfejsu CUDA 10 dla systemów Windows i Linux.

- Obsługa zaawansowanej pętli RNN w eksporcie ONNX.

- Eksportuj modele większe niż 2 GB w formacie ONNX.

- Obsługa akcji trenowania fp16 w skrypcie mózgu.

Obsługa cnTK dla CUDA 10

CnTK obsługuje teraz cuda 10. Wymaga to aktualizacji środowiska kompilacji do programu Visual Studio 2017 w wersji 15.9 dla systemu Windows.

Aby skonfigurować środowisko kompilacji i środowiska uruchomieniowego w systemie Windows:

- Zainstaluj program Visual Studio 2017. Uwaga: w przyszłości dla cudA 10 i nowszych nie jest już wymagane zainstalowanie i uruchomienie przy użyciu określonych narzędzi VC Tools w wersji 14.11.

- Instalowanie narzędzia Nvidia CUDA 10

- W programie PowerShell uruchom polecenie: DevInstall.ps1

- Uruchom program Visual Studio 2017 i otwórz plik CNTK.sln.

Aby skonfigurować środowisko kompilacji i środowiska uruchomieniowego w systemie Linux przy użyciu platformy Docker, utwórz tutaj obraz platformy Docker Unbuntu 16.04 przy użyciu plików Dockerfile. W przypadku innych systemów Linux zapoznaj się z plikami Dockerfile, aby skonfigurować biblioteki zależne dla pliku CNTK.

Obsługa zaawansowanej pętli RNN w eksporcie ONNX

Modele CNTK z pętlami rekursywnymi można eksportować do modeli ONNX przy użyciu operacji skanowania.

Eksportowanie większych niż 2 GB modeli w formacie ONNX

Aby wyeksportować modele o rozmiarze większym niż 2 GB w formacie ONNX, użyj pliku cntk. Interfejs API funkcji: save(self, nazwa pliku, format=ModelFormat.CNTKv2, use_external_files_to_store_parameters=False) z wartością "format" ustawioną na ModelFormat.ONNX i use_external_files_to_store_parameters ustawioną na true. W takim przypadku parametry modelu są zapisywane w plikach zewnętrznych. Wyeksportowane modele są używane z zewnętrznymi plikami parametrów podczas oceny modelu przy użyciu polecenia onnxruntime.

2018-11-26.

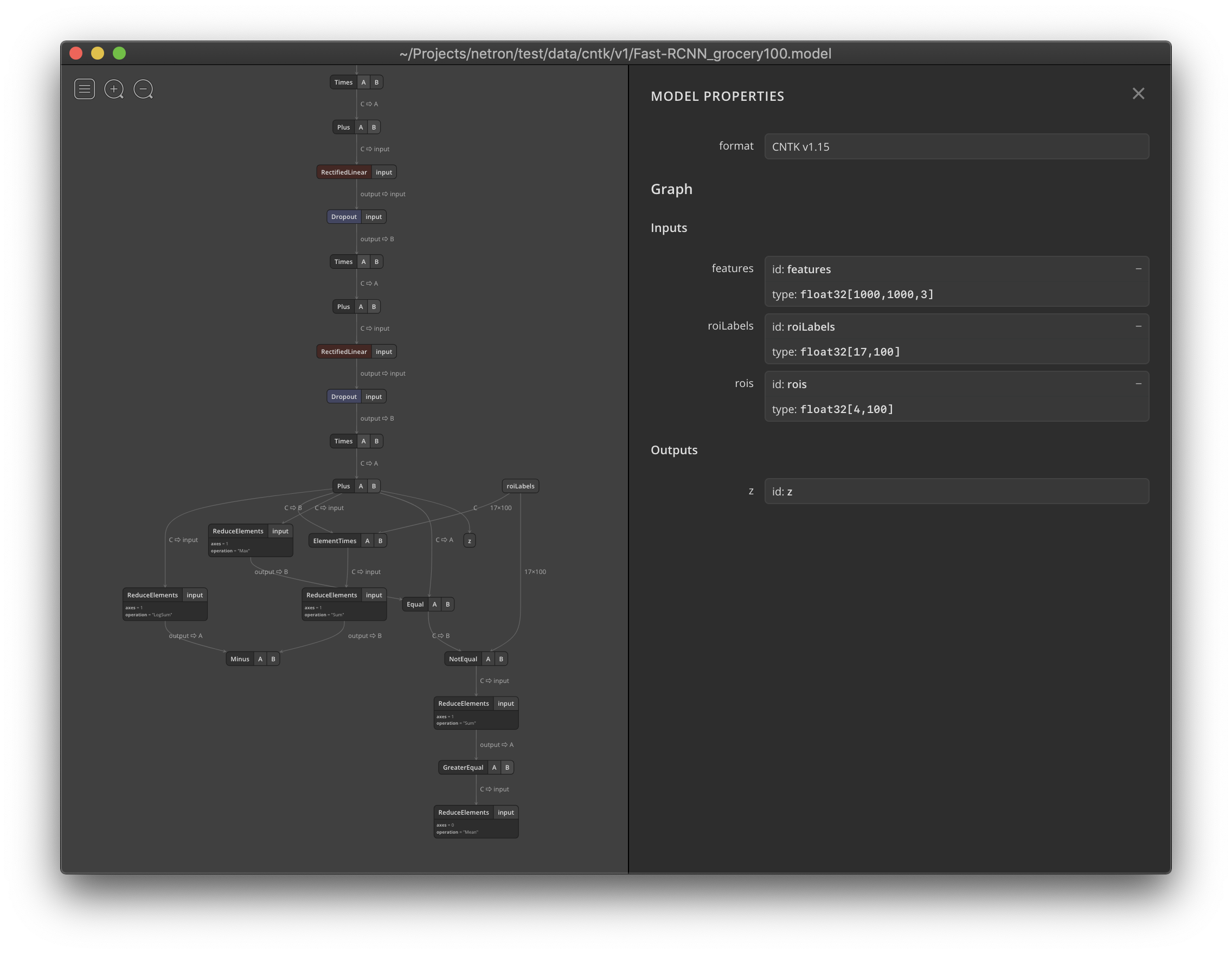

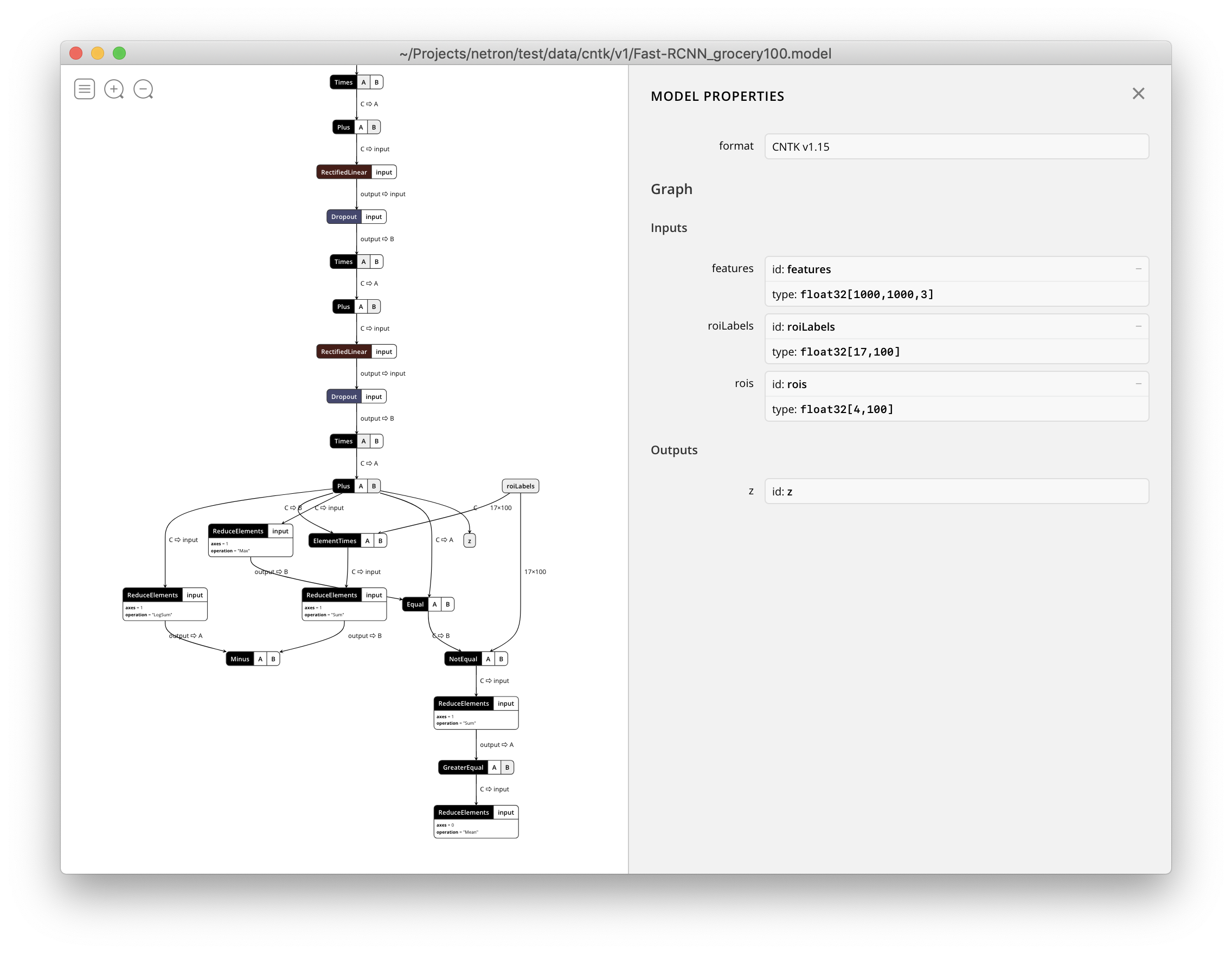

Platforma Netron obsługuje teraz wizualizowanie plików CNTK v1 i CNTK v2 .model .