Processar dados na borda com pipelines da Versão Prévia do Processador de Dados da Internet das Coisas do Azure

Importante

O recurso Pré-visualização de Operações do Azure IoT — habilitado pelo Azure Arc — está atualmente em VERSÃO PRÉVIA. Você não deve usar esse software em versão prévia em ambientes de produção.

Veja os Termos de Uso Complementares para Versões Prévias do Microsoft Azure para obter termos legais que se aplicam aos recursos do Azure que estão em versão beta, versão prévia ou que, de outra forma, ainda não foram lançados em disponibilidade geral.

Os ativos industriais geram dados em vários formatos diferentes e usam vários protocolos de comunicação. Essa diversidade de fontes de dados, aliada à variação de esquemas e medidas de unidades, dificulta o uso e a análise efetiva de dados industriais brutos. Além disso, por motivos de conformidade, segurança e desempenho, você não pode carregar todos os conjuntos de dados para a nuvem.

O processamento desses dados tradicionalmente requer uma engenharia de dados cara, complexa e demorada. O Processador de Dados da Internet das Coisas do Azure (versão prévia) é um serviço de processamento de dados configurável que pode gerenciar as complexidades e a diversidade dos dados industriais. Use o Processador de Dados para tornar os dados de fontes diferentes mais compreensíveis, utilizáveis e valiosos.

Versão prévia da Versão Prévia do Processador de Dados da Internet das Coisas do Azure

O Processador de Dados da Internet das Coisas do Azure (versão prévia) é um componente da Versão Prévia das Operações do Azure IoT. O Processador de Dados permite agregar, enriquecer, normalizar e filtrar os dados de seus dispositivos. O Processador de Dados é um mecanismo de processamento de dados baseado em pipeline que permite processar dados na borda antes de enviá-los a outros serviços, seja na borda ou na nuvem:

O Processador de Dados ingere dados de streaming em tempo real de fontes como servidores OPC UA, historiadores e outros sistemas industriais. Ele normaliza esses dados convertendo vários formatos de dados em um formato padronizado e estruturado, o que facilita a consulta e a análise. O processador de dados também pode contextualizar os dados, enriquecendo-os com dados de referência ou LKV (últimos valores conhecidos) para fornecer uma visão abrangente de suas operações industriais.

O resultado do Processador de Dados são dados limpos, enriquecidos e padronizados, prontos para aplicativos downstream, como ferramentas de análise e insights em tempo real. O processador de dados reduz significativamente o tempo necessário para transformar dados brutos em insights acionáveis.

Os principais recursos do Processador de Dados incluem:

Normalização flexível de dados para converter vários formatos de dados em uma estrutura padronizada.

Enriquecimento de fluxos de dados com dados de referência ou LKV para aprimorar o contexto e permitir melhores insights.

Integração com o Microsoft Fabric para simplificar a análise de dados limpos.

Capacidade de processar dados de várias fontes e publicar os dados em vários destinos.

Como uma plataforma de processamento de dados independente de dados, o Processador de Dados pode ingerir dados em qualquer formato, processar os dados e gravá-los em um destino. Para dar suporte a esses recursos, o Processador de Dados pode desserializar e serializar vários formatos. Por exemplo, ele pode serializar para parquet a fim de gravar arquivos no Microsoft Fabric.

Políticas de repetição automáticas e configuráveis para lidar com erros transitórios ao enviar dados para os destinos de nuvem.

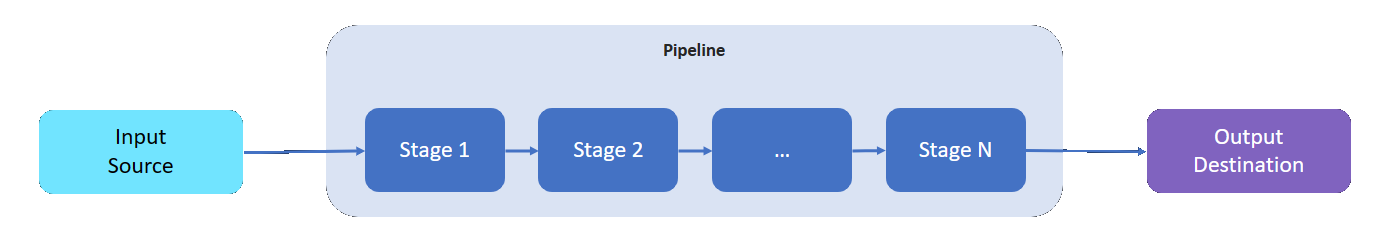

O que é um pipeline?

Um pipeline do Processador de Dados tem uma fonte de entrada de onde lê os dados, um destino onde grava os dados processados e um número variável de fases intermediárias para processar os dados.

As fases intermediárias representam os diferentes recursos de processamento de dados disponíveis:

- Você pode adicionar quantas fases intermediárias forem necessárias a um pipeline.

- Você pode ordenar as fases intermediárias de um pipeline conforme sua necessidade. Você pode reordenar as fases depois de criar um pipeline.

- Cada fase adere a uma interface de implementação definida e a um contrato de esquema de entrada/saída.

- Cada fase é independente das outras fases no pipeline.

- Todos as fases operam dentro do escopo de uma partição. Os dados não são compartilhados entre partições diferentes.

- Os dados fluem apenas de uma fase para a outra.

Os pipelines do processador de dados podem usar as seguintes fases:

| Estágio | Descrição |

|---|---|

| Fonte – MQ | Recupera dados de um agente MQTT. |

| Fonte – Ponto de extremidade HTTP | Recupera dados de um ponto de extremidade HTTP. |

| Fonte – SQL | Recupera dados de um banco de dados do Microsoft SQL Server. |

| Origem - InfluxDB | Recupera dados de um banco de dados InfluxDB. |

| Filter | Filtra os dados que passam pela fase. Por exemplo, filtre qualquer mensagem com temperatura fora do intervalo de 50F-150F. |

| Transformar | Normaliza a estrutura dos dados. Por exemplo, altere a estrutura de {"Name": "Temp", "value": 50} para {"temp": 50}. |

| LKV | Armazena valores de métrica selecionados em um repositório LKV. Por exemplo, armazene apenas medições de temperatura e umidade no LKV e ignore o restante. Uma fase seguinte pode enriquecer uma mensagem com os dados LKV armazenados. |

| Enriquecimento | Enriquece as mensagens com dados do armazenamento de dados de referência. Por exemplo, adicione um nome de operador e um número de lote do conjunto de dados de operações. |

| Agregação | Agrega valores que passam pela fase. Por exemplo, quando os valores de temperatura são enviados a cada 100 milissegundos, emita uma métrica de temperatura média a cada 30 segundos. |

| Chamada | Faz uma chamada para um serviço HTTP ou gRPC externo. Por exemplo, chame uma Função do Azure para converter de um formato de mensagem personalizado para JSON. |

| Destino – MQ | Grava seus dados processados, limpos e contextualizados em um tópico MQTT. |

| Destino – Referência | Grava seus dados processados no armazenamento de referência integrado. Outros pipelines podem usar o armazenamento de referência para enriquecer suas mensagens. |

| Destino – gRPC | Envia seus dados processados, limpos e contextualizados para um ponto de extremidade gRPC. |

| Destino - HTTP | Envia seus dados processados, limpos e contextualizados para um ponto de extremidade HTTP. |

| Destino – Fabric Lakehouse | Envia seus dados processados, limpos e contextualizados para um lakehouse do Microsoft Fabric na nuvem. |

| Destino – Azure Data Explorer | Envia seus dados processados, limpos e contextualizados para um ponto de extremidade do Azure Data Explorer na nuvem. |

| Destino - Armazenamento de Blobs do Azure | Envia seus dados processados, limpos e contextualizados para um ponto de extremidade do Armazenamento de Blobs do Azure na nuvem. |

Próxima etapa

Para experimentar os pipelines do Processador de Dados, confira Inícios rápidos das Operações do Azure IoT.

Para saber mais sobre o Processador de dados, confira: