O que é o designer (v1) do Azure Machine Learning?

O designer de Azure Machine Learning é uma interface do tipo "arrastar e soltar" usada para treinar e implantar modelos no Azure Machine Learning. Este artigo descreve as tarefas que você pode fazer no designer.

Observação

O Designer tem suporte para dois tipos de componentes, componentes predefinidos clássicos(v1) e componentes personalizados(v2). Esses dois tipos de componentes NÃO são compatíveis.

Os componentes predefinidos clássicos fornecem componentes predefinidos principalmente para processamento de dados e tarefas tradicionais de aprendizado de máquina, como regressão e classificação. Esse tipo de componente continua com suporte, mas não terá componentes novos adicionados.

Componentes personalizados permitem que você envolva seu próprio código como um componente. Ele tem suporte para o compartilhamento de componentes entre espaços de trabalho e à criação contínua nas interfaces Studio, CLI v2 e SDK v2.

Para novos projetos, sugerimos que você use o componente personalizado, que é compatível com o AzureML V2 e continuará recebendo novas atualizações.

Este artigo se aplica a componentes predefinidos clássicos e não são compatíveis com a CLI v2 e o SDK v2.

- Para começar a usar o designer, confira Tutorial: treinar um modelo de regressão sem código.

- Para saber mais sobre os componentes disponíveis no designer, confira o Algoritmo e a referência de componente.

O designer usa o espaço de trabalho do Azure Machine Learning para organizar recursos compartilhados, como:

- Pipelines

- Dados

- Recursos de computação

- Modelos registrados

- Pipelines publicados

- Pontos de extremidade em tempo real

Treinamento e implantação de modelo

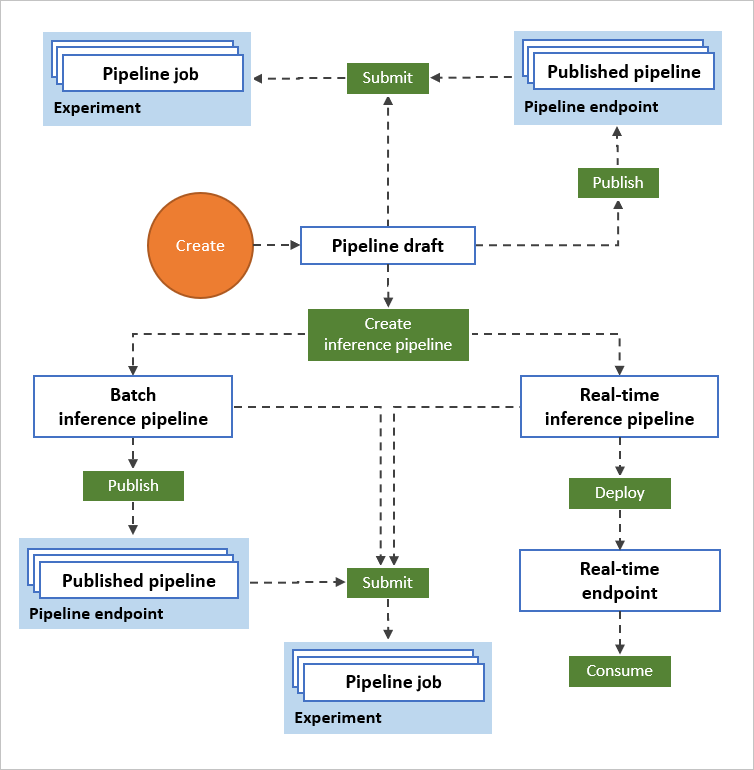

Use uma tela visual para compilar um fluxo de trabalho de aprendizado de máquina de ponta a ponta. Treine, teste e implante modelos no designer:

- Arrastar e soltar conjuntos de dados e componentes na tela.

- Conectar os componentes para criar um rascunho de pipeline.

- Enviar uma execução de pipeline usando os recursos de computação no workspace do Azure Machine Learning.

- Converter os pipelines de treinamento em pipelines de inferência.

- Publicar os pipelines em um ponto de extremidade de pipeline do REST para enviar um novo pipeline que é executado com diferentes parâmetros e ativos de dados.

- Publicar um pipeline de treinamento para reutilizar um único pipeline para treinar vários modelos, enquanto altera os parâmetros e ativos de dados.

- Publicar um pipeline de inferência de lote para fazer previsões sobre novos dados usando um modelo treinado anteriormente.

- Implantar um pipeline de inferência em tempo real em um ponto de extremidade online real para fazer previsões sobre novos dados em tempo real.

Pipeline

Um pipeline consiste em ativos de dados e componentes analíticos que você conecta. Os pipelines têm muitas utilidades: você pode criar um pipeline que treina um único modelo ou um que treina vários modelos. É possível criar um pipeline que faça previsões em tempo real ou em lote, ou então criar um pipeline que apenas limpa os dados. Os pipelines permitem reutilizar o trabalho e organizar os projetos.

Rascunho de pipeline

À medida que você edita um pipeline no designer, seu progresso é salvo como um rascunho de pipeline. Você pode editar um rascunho de pipeline a qualquer momento adicionando ou removendo componentes, configurando destinos de computação, criando parâmetros e assim por diante.

Um pipeline válido tem estas características:

- Os ativos de dados só podem ser conectados a componentes.

- Os componentes só podem ser conectados a ativos de dados ou outros componentes.

- Todas as portas de entrada dos componentes devem ter uma conexão com o fluxo de dados.

- Todos os parâmetros necessários para cada componente devem estar configurados.

Quando você estiver pronto para executar o rascunho de pipeline, envie um trabalho de pipeline.

Trabalho de pipeline

Cada vez que você executa um pipeline, a configuração do pipeline e seus resultados são armazenados no espaço de trabalho como um trabalho de pipeline. Você pode voltar a qualquer trabalho de pipeline para inspecioná-lo quanto a solução de problemas ou auditoria. Clone um trabalho de pipeline para criar um novo rascunho de pipeline para edição.

Os trabalhos de pipeline são agrupados em experimentos para organizar o histórico de trabalhos. Você pode definir o experimento para cada trabalho de pipeline.

Dados

Um ativo de dados do aprendizado de máquina facilita o acesso aos dados e o trabalho com eles. Vários ativos de dados de amostra são incluídos no designer para que você possa fazer experimentos. Você pode registrar mais ativos de dados conforme necessário.

Componente

Um componente é um algoritmo que você pode executar em seus dados. O designer tem vários componentes que variam de funções de entrada de dados a processos de treinamento, pontuação e validação.

Um componente pode ter um conjunto de parâmetros que você pode usar para configurar os algoritmos internos do componente. Ao selecionar um componente nas telas, os parâmetros do componente são exibidos no painel Propriedades à direita das telas. Você pode modificar os parâmetros nesse painel para ajustar seu modelo. Você pode definir os recursos de computação para componentes individuais no designer.

Para obter ajuda para navegar pela biblioteca de algoritmos disponíveis do aprendizado de máquina, confira Visão geral do algoritmo e da referência de componente. Para obter ajuda para escolher um algoritmo, confira a Página de dicas úteis do algoritmo do Azure Machine Learning.

Recursos de computação

Use recursos de computação de seu workspace para executar o pipeline e hospedar modelos implantados como pontos de extremidade online ou pontos de extremidade do pipeline (para inferência em lote). Os destinos de computação com suporte são:

| Destino de computação | Treinamento | Implantação |

|---|---|---|

| Computação do Azure Machine Learning | ✓ | |

| Serviço de Kubernetes do Azure | ✓ |

Os destinos de computação são anexados ao workspace do Azure Machine Learning. Você gerencia os destinos de computação no espaço de trabalho do Azure Machine Learning Studio.

Implantar

Para realizar a inferência em tempo real, você precisa implantar um pipeline como um ponto de extremidade online. O ponto de extremidade online cria uma interface entre um aplicativo externo e o modelo de pontuação. Uma chamada para um ponto de extremidade online retorna resultados de previsão para o aplicativo em tempo real. Para fazer uma chamada para um ponto de extremidade online, você passa a chave de API criada quando você implantou o ponto de extremidade. O ponto de extremidade baseia-se em REST, uma opção popular de arquitetura para projetos de programação da Web.

Os pontos de extremidade online devem ser implantados em um cluster do Serviço de Kubernetes do Azure.

Para saber como implantar o modelo, confira Tutorial: Implantar um modelo de machine learning com o designer.

Publicar

Você também pode publicar um pipeline para um ponto de extremidade do pipeline. Semelhante a um ponto de extremidade online, um ponto de extremidade do pipeline permite enviar novos trabalhos de pipeline de aplicativos externos usando chamadas REST. No entanto, não é possível enviar ou receber dados em tempo real usando um ponto de extremidade do pipeline.

Os pipelines publicados são flexíveis, podem ser usados para treinar ou retreinar modelos, realizar inferências de lote, processar novos dados e muito mais. Você pode publicar vários pipelines em um único ponto de extremidade do pipeline e especificar qual versão de pipeline deve ser executada.

Um pipeline publicado é executado nos recursos de computação que você define no rascunho de pipeline para cada componente.

O designer cria o mesmo objeto PublishedPipeline que o SDK.

Próximas etapas

- Conheça os conceitos fundamentais da análise preditiva e do machine learning com o Tutorial: Prever preço de automóvel com o designer

- Saiba como modificar as amostras existentes do designer para adaptá-las às suas necessidades.