Este artigo fornece uma visão geral das soluções de banco de dados do Azure descritas no Centro de Arquitetura do Azure.

Apache®, Apache Cassandra® e o logotipo Hadoop são marcas registradas ou marcas comerciais da Apache Software Foundation nos Estados Unidos e/ou em outros países. Nenhum endosso da Apache Software Foundation está implícito no uso dessas marcas.

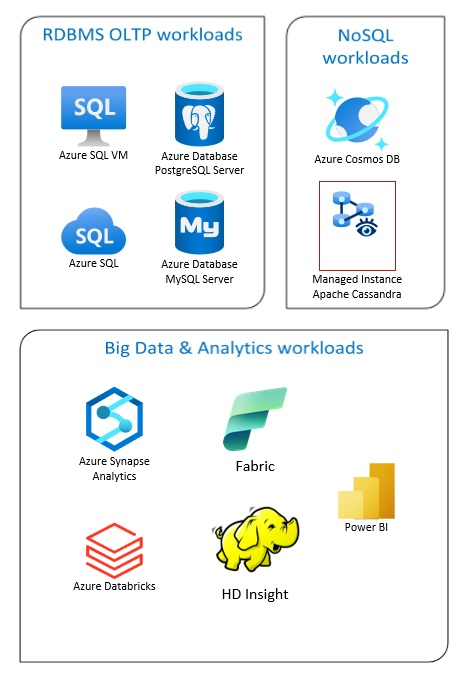

As soluções de Banco de Dados do Azure incluem sistemas tradicionais de gerenciamento de banco de dados relacional (RDBMS e OLTP), cargas de trabalho de big data e análise (incluindo OLAP) e cargas de trabalho NoSQL.

As cargas de trabalho RDBMS incluem processamento de transações online (OLTP) e processamento analítico online (OLAP). Os dados de várias fontes na organização podem ser consolidados em um data warehouse. Você pode usar um processo de extração, transformação e carregamento (ETL) ou extrair, carregar e transformar (ELT) para mover e transformar os dados de origem. Para obter mais informações sobre bancos de dados RDBMS, consulte Explorar bancos de dados relacionais no Azure.

Uma arquitetura de big data é projetada para lidar com a ingestão, processamento e análise de dados grandes ou complexos. As soluções de Big Data normalmente envolvem uma grande quantidade de dados relacionais e não relacionais, que os sistemas RDBMS tradicionais não são adequados para armazenar. Estes normalmente envolvem soluções como Data Lakes, Delta Lakes e lakehouses. Veja mais informações em Analytics Architecture Design.

Os bancos de dados NoSQL são chamados intercambiavelmente de DBs não relacionais, NoSQL ou não-SQL para destacar o fato de que eles podem lidar com grandes volumes de dados não estruturados que mudam rapidamente. Eles não armazenam dados em tabelas, linhas e colunas, como bancos de dados (SQL). Para obter mais informações sobre No SQL DBs Databases, consulte Dados NoSQL e O que são bancos de dados NoSQL?.

Este artigo fornece recursos para saber mais sobre os bancos de dados do Azure. Ele descreve caminhos para implementar as arquiteturas que atendem às suas necessidades e as melhores práticas a ter em mente ao projetar suas soluções.

Há muitas arquiteturas para você desenhar para atender às suas necessidades de banco de dados. Também fornecemos ideias de soluções para você desenvolver, que incluem links para todos os componentes de que você precisa.

Saiba mais sobre bancos de dados no Azure

À medida que você começa a pensar em possíveis arquiteturas para sua solução, é vital que você escolha o armazenamento de dados correto. Se você é novo em bancos de dados no Azure, o melhor lugar para começar é o Microsoft Learn. Esta plataforma online gratuita oferece vídeos e tutoriais para aprendizagem prática. O Microsoft Learn oferece caminhos de aprendizagem baseados na sua função, como desenvolvedor ou analista de dados.

Você pode começar com uma descrição geral dos diferentes bancos de dados no Azure e seu uso. Você também pode navegar pelos módulos de dados do Azure e escolher uma abordagem de armazenamento de dados no Azure. Estes artigos ajudam-no a compreender as suas escolhas nas soluções de dados do Azure e a saber porque é que algumas soluções são recomendadas em cenários específicos.

Aqui estão alguns módulos do Learn que você pode achar úteis:

- Projetar sua migração para o Azure

- Implantar o Banco de Dados SQL do Azure

- Explore o banco de dados e os serviços de análise do Azure

- Proteja seu Banco de Dados SQL do Azure

- BD do Cosmos para o Azure

- Base de Dados do Azure para PostgreSQL

- Base de Dados do Azure para MySQL

- SQL Server em VMs do Azure

Caminho para a produção

Para encontrar opções úteis para lidar com dados relacionais, considere estes recursos:

- Para saber mais sobre recursos para coletar dados de várias fontes e como aplicar transformações de dados nos pipelines de dados, consulte Analytics no Azure.

- Para saber mais sobre o OLAP, que organiza grandes bancos de dados de negócios e oferece suporte a análises complexas, consulte Processamento analítico on-line.

- Para saber mais sobre os sistemas OLTP registram as interações comerciais à medida que ocorrem, consulte Processamento de transações on-line.

Um banco de dados não relacional não usa o esquema tabular de linhas e colunas. Para obter mais informações, consulte Dados não relacionais e NoSQL.

Para saber mais sobre data lakes, que contêm uma grande quantidade de dados em seu formato nativo bruto, consulte Data lakes.

Uma arquitetura de big data pode lidar com ingestão, processamento e análise de dados que são muito grandes ou complexos para sistemas de banco de dados tradicionais. Para obter mais informações, consulte Arquiteturas de Big Data e Análises.

Uma nuvem híbrida é um ambiente de TI que combina nuvem pública e datacenters locais. Para obter mais informações, consulte Estender soluções de dados locais para a nuvem ou considerar o Azure Arc combinado com bancos de dados do Azure.

O Azure Cosmos DB é um serviço de base de dados NoSQL totalmente gerido para o desenvolvimento de aplicações modernas. Para obter mais informações, consulte Modelo de recursos do Azure Cosmos DB.

Para saber mais sobre as opções de transferência de dados de e para o Azure, consulte Transferir dados de e para o Azure.

Melhores práticas

Analise essas práticas recomendadas ao projetar suas soluções.

| Melhores práticas | Description |

|---|---|

| Padrões de gerenciamento de dados | A gestão de dados é o elemento-chave das aplicações na nuvem. Influencia a maioria dos atributos de qualidade. |

| Padrão de caixa de saída transacional com o Azure Cosmos DB | Saiba como usar o padrão de caixa de saída transacional para mensagens confiáveis e entrega garantida de eventos. |

| Distribuir dados globalmente com o Azure Cosmos DB | Para obter baixa latência e alta disponibilidade, alguns aplicativos precisam ser implantados em datacenters próximos de seus usuários. |

| Segurança no Azure Cosmos DB | As práticas recomendadas de segurança ajudam a prevenir, detetar e responder a violações de banco de dados. |

| Backup contínuo com restauração point-in-time no Azure Cosmos DB | Saiba mais sobre o recurso de restauração point-in-time do Azure Cosmos DB. |

| Obtenha alta disponibilidade com o Azure Cosmos DB | O Azure Cosmos DB fornece vários recursos e opções de configuração para obter alta disponibilidade. |

| Alta disponibilidade para o Banco de Dados SQL do Azure e a Instância Gerenciada SQL | O banco de dados não deve ser um único ponto de falha em sua arquitetura. |

Opções de tecnologia

Há muitas opções de tecnologias para usar com os Bancos de Dados do Azure. Estes artigos ajudam-no a escolher as melhores tecnologias para as suas necessidades.

- Escolha um armazenamento de dados

- Escolher um armazenamento de dados analíticos no Azure

- Escolher uma tecnologia de análise de dados no Azure

- Escolher uma tecnologia de processamento em lote no Azure

- Escolha uma tecnologia de armazenamento de big data no Azure

- Escolher uma tecnologia de orquestração de pipeline de dados no Azure

- Escolher um armazenamento de dados de pesquisa no Azure

- Escolher uma tecnologia de processamento de fluxo no Azure

Mantenha-se atualizado com os bancos de dados

Consulte as atualizações do Azure para se manter atualizado com a tecnologia de Bancos de Dados do Azure.

Recursos relacionados

- Cenário da Adatum Corporation para gerenciamento e análise de dados no Azure

- Cenário do Lamna Healthcare para gerenciamento e análise de dados no Azure

- Otimizar a administração de instâncias do SQL Server

- Cenário Relecloud para gerenciamento e análise de dados no Azure

Exemplos de soluções

Essas ideias de solução são alguns dos exemplos de abordagens que você pode adaptar às suas necessidades.

- Cache de dados

- Armazém de dados empresariais

- Mensagens

- Aplicativos sem servidor usando o Azure Cosmos DB

Produtos de base de dados semelhantes

Se você estiver familiarizado com a Amazon Web Services (AWS) ou o Google Cloud, consulte as seguintes comparações: