Implementar e gerir clusters do Azure Stack HCI no VMM

Este artigo fornece informações sobre como configurar um cluster do Azure Stack HCI no System Center – Virtual Machine Manager (VMM). Pode implementar um cluster do Azure Stack HCI ao aprovisionar a partir de servidores bare-metal ou ao adicionar anfitriões existentes. Saiba mais sobre o novo Azure Stack HCI.

O VMM 2019 Update Rollup 3 (UR3) suporta o Azure Stack HCI, versão 20H2. O produto atual é o Azure Stack HCI, versão 21H2. A partir do System Center 2022, o VMM suporta o Azure Stack HCI, versão 20H2; Azure Stack HCI, versão 21H2; e Azure Stack HCI, versão 22H2 (suportada a partir do VMM 2022 UR1).

Importante

Os clusters do Azure Stack HCI geridos pelo Virtual Machine Manager ainda não devem aderir ao canal de pré-visualização . O System Center (incluindo o Virtual Machine Manager, o Operations Manager e outros componentes) não suporta atualmente versões de pré-visualização do Azure Stack. Para obter as atualizações mais recentes, consulte o blogue do System Center.

Antes de começar

Certifique-se de que está a executar o VMM 2019 UR3 ou posterior.

O que é suportado?

Adição, criação e gestão de clusters do Azure Stack HCI. Veja os passos detalhados para criar e gerir clusters do HCI.

Capacidade de aprovisionar & implementar VMs nos clusters do Azure Stack HCI e executar operações de ciclo de vida da VM. As VMs podem ser aprovisionadas com ficheiros VHD(x), modelos ou a partir de uma VM existente. Saiba mais.

Configurar a rede baseada em VLAN em clusters do Azure Stack HCI.

Implementação e gestão do controlador de rede SDN em clusters do Azure Stack HCI.

Gestão das definições do agrupamento de armazenamento, criação de discos virtuais, criação de volumes partilhados de cluster (CSVs) e aplicação de definições de QoS.

Mover VMs entre clusters do Windows Server e do Azure Stack HCI funciona através da Migração de Rede e da migração de uma VM offline (encerrada). Neste cenário, o VMM exporta e importa sob os bastidores, apesar de ser executado como uma única operação.

Os cmdlets do PowerShell utilizados para gerir clusters do Windows Server também podem ser utilizados para gerir clusters do Azure Stack HCI.

Registar e anular o registo de clusters do Azure Stack HCI

Com o VMM 2022, estamos a introduzir cmdlets do PowerShell do VMM para registar e anular o registo de clusters do Azure Stack HCI.

Utilize os seguintes cmdlets para registar um cluster do HCI:

Register-SCAzStackHCI -VMHostCluster <HostCluster> -SubscriptionID <string>

Utilize o seguinte comando para anular o registo de um cluster:

Unregister-SCAzStackHCI -VMHostCluster <HostCluster> -SubscriptionID <string>

Para obter informações detalhadas sobre o parâmetro suportado, veja Register-SCAzStackHCI e Unregister-SCAzStackHCI.

O que não é suportado?

A gestão de clusters dispersos do Azure Stack HCI não é atualmente suportada no VMM.

O Azure Stack HCI destina-se a um anfitrião de virtualização onde executa todas as cargas de trabalho em máquinas virtuais. Os termos do Azure Stack HCI permitem-lhe executar apenas o que é necessário para alojar máquinas virtuais. Os clusters do Azure Stack HCI não devem ser utilizados para outros fins, como servidores WSUS, servidores WDS ou servidores de bibliotecas. Veja Casos de utilização do Azure Stack HCI, Quando utilizar o Azure Stack HCI e Funções que pode executar sem virtualizar.

A migração em direto entre qualquer versão dos clusters do Windows Server e do Azure Stack HCI não é suportada.

Nota

A migração em direto entre clusters do Azure Stack HCI funciona, bem como entre clusters do Windows Server.

- O único tipo de armazenamento disponível para o Azure Stack HCI é Espaços de Armazenamento Direto (S2D). A criação ou gestão de clusters não S2D com nós do Azure Stack HCI não é suportada. Se precisar de utilizar qualquer outro tipo de armazenamento, por exemplo SANs, utilize o Windows Server como anfitrião de virtualização.

Nota

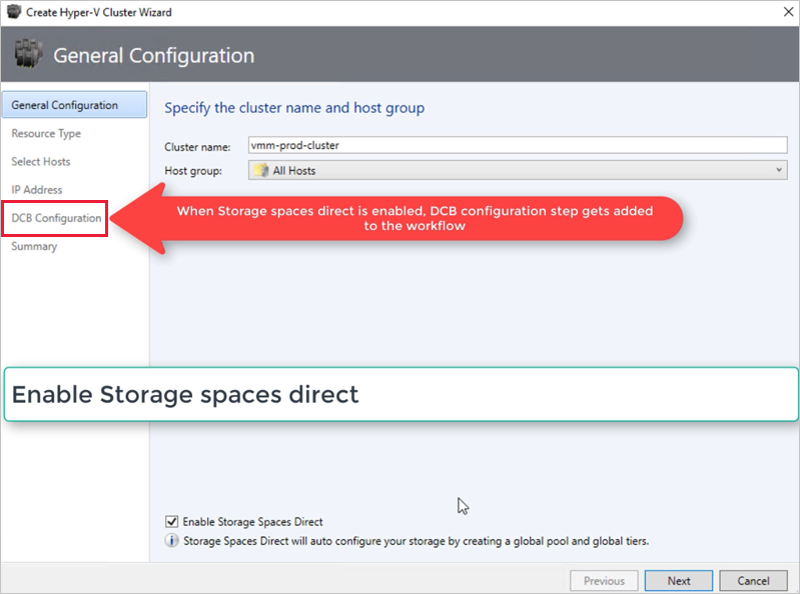

Tem de ativar o S2D ao criar um cluster do Azure Stack HCI. Para ativar o S2D, no assistente de criação de clusters, aceda a Configuração Geral. Em Especificar o nome do cluster e o grupo de anfitriões, selecione Ativar Espaços de Armazenamento Direto conforme mostrado abaixo:

Depois de ativar um cluster com S2D, o VMM faz o seguinte:

- A funcionalidade Clustering de Ativação Pós-falha está ativada.

- A réplica de armazenamento e a eliminação de dados duplicados estão ativadas.

- Opcionalmente, o cluster é validado e criado.

- O S2D está ativado e é criado um objeto de matriz de armazenamento no VMM com o mesmo nome que forneceu no assistente.

Quando utiliza o VMM para criar um cluster hiperconvergido, o conjunto e as camadas de armazenamento são criados automaticamente ao executar Enable-ClusterStorageSpacesDirect -Autoconfig $True.

Após estes pré-requisitos estarem implementados, aprovisiona um cluster e configura os recursos de armazenamento no mesmo. Em seguida, pode implementar VMs no cluster.

Siga estes passos:

Passo 1: Aprovisionar o cluster

Pode aprovisionar um cluster por anfitriões Hyper-V e máquinas bare-metal:

Aprovisionar um cluster a partir de anfitriões Hyper-V

Se precisar de adicionar os anfitriões do Azure Stack HCI aos recursos de infraestrutura do VMM, siga estes passos. Se já estiverem nos recursos de infraestrutura do VMM, avance para o passo seguinte.

Nota

- Quando configurar o cluster, selecione a opção Ativar Espaços de Armazenamento Direto na página Configuração Geral do assistente Criar Cluster Hyper-V.

- Em Tipo de Recurso, selecione Servidores existentes a executar um sistema operativo Windows Server e selecione os anfitriões Hyper-V a adicionar ao cluster.

- Todos os anfitriões selecionados devem ter o Azure Stack HCI instalado.

- Uma vez que o S2D está ativado, o cluster tem de ser validado.

Aprovisionar um cluster a partir de máquinas bare-metal

Nota

Normalmente, o nó S2D requer definições RDMA, QoS e SET. Para configurar estas definições para um nó com computadores bare-metal, pode utilizar a capacidade de script pós-implementação no PCP. Eis o script de pós-implementação do PCP de exemplo. Também pode utilizar este script para configurar RDMA, QoS e SET ao adicionar um novo nó a uma implementação S2D existente a partir de computadores bare-metal.

- Leia os pré-requisitos para a implementação de clusters bare-metal.

Nota

- O VHD ou VHDX generalizado na biblioteca do VMM deve estar a executar o Azure Stack HCI com as atualizações mais recentes. Os valores do sistema operativo e da plataforma de Virtualização para o disco rígido devem ser definidos.

- Para a implementação bare-metal, tem de adicionar um servidor de ambiente de execução de pré-arranque (PXE) aos recursos de infraestrutura do VMM. O servidor PXE é fornecido através dos Serviços de Implementação do Windows. O VMM utiliza a sua própria imagem WinPE e tem de garantir que é a mais recente. Para tal, selecioneInfraestrutura> de Recursos> de InfraestruturaAtualizar imagem winPE e certifique-se de que a tarefa é concluída.

- Siga as instruções para aprovisionar um cluster a partir de computadores bare-metal.

Passo 2: Configurar a rede para o cluster

Depois de o cluster ser aprovisionado e gerido nos recursos de infraestrutura do VMM, tem de configurar a rede para nós de cluster.

- Comece por criar uma rede lógica para espelhar a sua rede de gestão física.

- Tem de configurar um comutador lógico com o Agrupamento Incorporado do Comutador (SET) ativado para que o comutador esteja ciente da virtualização. Este comutador está ligado à rede lógica de gestão e tem todos os adaptadores virtuais anfitriões, que são necessários para fornecer acesso à rede de gestão ou configurar a rede de armazenamento. O S2D depende de uma rede para comunicar entre anfitriões. São recomendados adaptadores compatíveis com RDMA.

- Criar redes VM.

Passo 3: Configurar as definições do DCB no cluster do Azure Stack HCI

Nota

A configuração das definições do DCB é um passo opcional para alcançar um elevado desempenho durante o fluxo de trabalho de criação do cluster S2D. Avance para o passo 4 se não pretender configurar as definições do DCB.

Recomendações

Se tiver vNICs implementados, para um desempenho ideal, recomendamos que mapeie todos os seus vNICs com os pNICs correspondentes. As afinidades entre a vNIC e a pNIC são definidas aleatoriamente pelo sistema operativo e podem existir cenários em que vários vNICs são mapeados para a mesma pNIC. Para evitar tais cenários, recomendamos que defina manualmente a afinidade entre vNIC e pNIC ao seguir os passos listados aqui.

Quando cria um perfil de porta de placa de rede, recomendamos que permita a prioridade IEEE. Saiba mais.

Também pode definir a Prioridade IEEE com os seguintes comandos do PowerShell:

Set-VMNetworkAdapterVlan -VMNetworkAdapterName 'SMB2' -VlanId '101' -Access -ManagementOS Set-VMNetworkAdapter -ManagementOS -Name 'SMB2' -IeeePriorityTag on

Utilize os seguintes passos para configurar as definições do DCB:

Crie um novo cluster Hyper-V e selecione Ativar Espaços de Armazenamento Direto. A opção Configuração do DCB é adicionada ao fluxo de trabalho de criação do cluster Hyper-V.

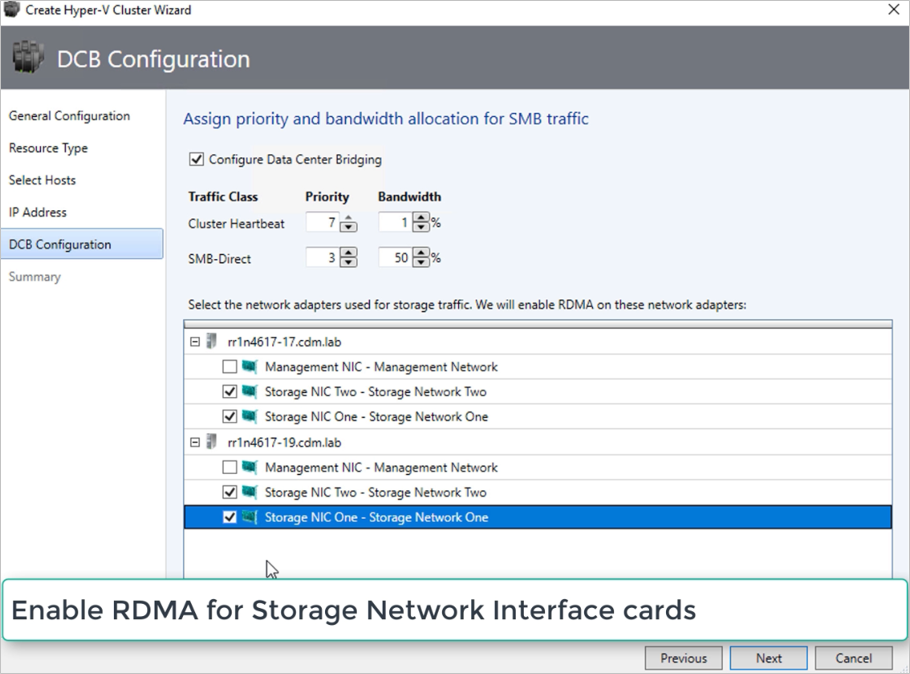

Na configuração do DCB, selecione Configurar Data Center Bridging.

Forneça valores de Prioridade e Largura de Banda para SMB-Direct e Tráfego de Heartbeat de Cluster.

Nota

Os valores predefinidos são atribuídos a Prioridade e Largura de Banda. Personalize estes valores com base nas necessidades de ambiente da sua organização.

Valores predefinidos:

| Classe de Tráfego | Prioridade | Largura de banda (%) |

|---|---|---|

| Cluster Heartbeat | 7 | 1 |

| SMB-Direct | 3 | 50 |

Selecione os adaptadores de rede utilizados para o tráfego de armazenamento. O RDMA está ativado nestes adaptadores de rede.

Nota

Num cenário nic convergido, selecione os vNICs de armazenamento. Os pNICs subjacentes devem ser compatíveis com RDMA para que os vNICs sejam apresentados e disponíveis para seleção.

Reveja o resumo e selecione Concluir.

Será criado um cluster do Azure Stack HCI e os parâmetros do DCB são configurados em todos os nós S2D.

Nota

- As definições do DCB podem ser configuradas nos clusters S2D do Hyper-V existentes visitando a página Propriedades do Cluster e navegando para a página de configuração do DCB .

- Quaisquer alterações fora de banda às definições do DCB em qualquer um dos nós farão com que o cluster S2D não esteja em conformidade no VMM. Será fornecida uma opção Remediar na página de configuração do DCB das propriedades do cluster, que pode utilizar para impor as definições do DCB configuradas no VMM nos nós de cluster.

Passo 4: Registar o cluster do Azure Stack HCI no Azure

Depois de criar um cluster do Azure Stack HCI, este tem de ser registado no Azure no prazo de 30 dias após a instalação de acordo com os termos do Serviço Online do Azure. Se estiver a utilizar o System Center 2022, utilize Register-SCAzStackHCI o cmdlet no VMM para registar o cluster do Azure Stack HCI no Azure. Em alternativa, siga estes passos para registar o cluster do Azure Stack HCI no Azure.

O estado de registo será refletido no VMM após uma atualização bem-sucedida do cluster.

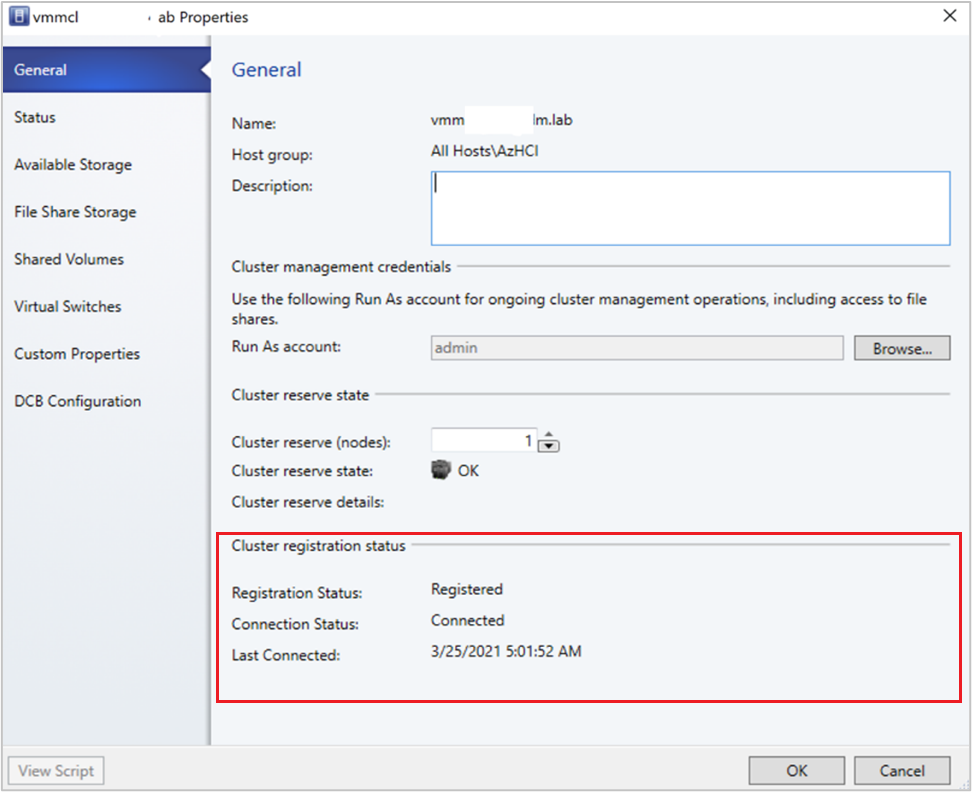

Passo 5: ver o estado de registo dos clusters do Azure Stack HCI

Na consola do VMM, pode ver o estado do registo e a última data ligada dos clusters do Azure Stack HCI.

Selecione Recursos de Infraestrutura, clique com o botão direito do rato no cluster do Azure Stack HCI e selecione Propriedades.

Em alternativa, execute

Get-SCVMHoste observe as propriedades do objeto devolvido para verificar o estado do registo.

Passo 6: Gerir o conjunto e criar CSVs

Agora, pode modificar as definições do agrupamento de armazenamento e criar discos virtuais e CSVs.

> SelecioneMatrizesde Armazenamentode Recursos de > Infraestrutura.

Clique com o botão direito do rato no cluster >Gerir Conjunto e selecione o agrupamento de armazenamento que foi criado por predefinição. Pode alterar o nome predefinido e adicionar uma classificação.

Para criar um CSV, clique com o botão direito do rato no cluster >Volumes Partilhados de Propriedades>.

No Assistente para CriarTipo de Armazenamento de Volumes>, especifique o nome do volume e selecione o agrupamento de armazenamento.

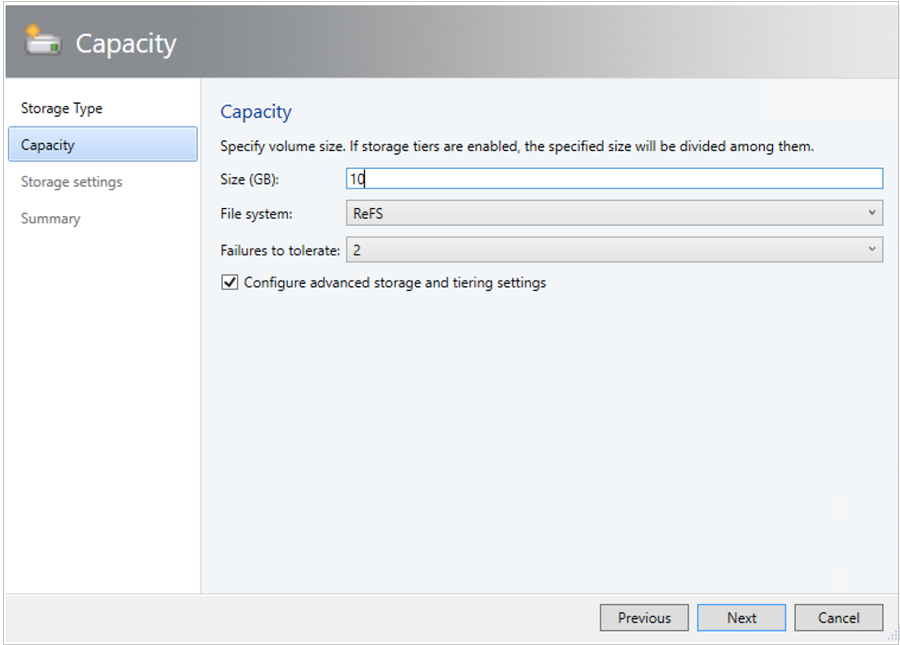

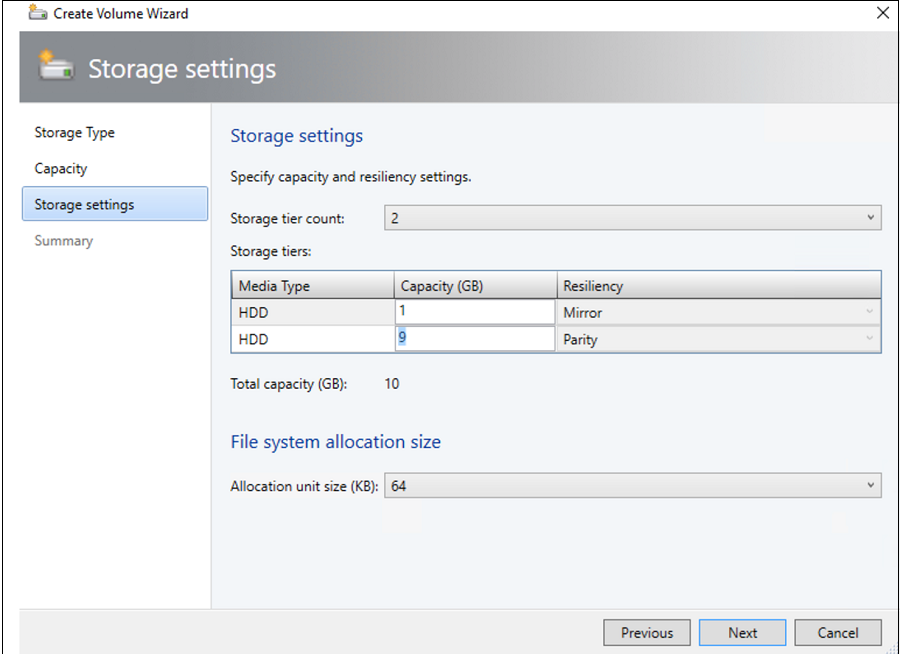

Em Capacidade, pode especificar o tamanho do volume, o sistema de ficheiros e as definições de resiliência (Falhas a tolerar).

Selecione Configurar definições avançadas de armazenamento e camadas para configurar estas opções.

Em Resumo, verifique as definições e conclua o assistente. Quando criar o volume, será criado automaticamente um disco virtual.

Passo 7: Implementar VMs no cluster

Numa topologia hiperconvergida, as VMs podem ser implementadas diretamente no cluster. Os respetivos discos rígidos virtuais são colocados nos volumes que criou com o S2D. Pode criar e implementar estas VMs tal como criaria qualquer outra VM.

Importante

Se o cluster do Azure Stack HCI não estiver registado no Azure ou não estiver ligado ao Azure durante mais de 30 dias após o registo, a criação da máquina virtual (HAVM) de elevada disponibilidade será bloqueada no cluster. Veja o passo 4 & 5 para o registo do cluster.

Passo 8: Migrar VMs do Windows Server para o cluster do Azure Stack HCI

Utilize a Funcionalidade de migração de rede no VMM para migrar cargas de trabalho do Hyper-V (Windows Server 2019 & posterior) para o Azure Stack HCI.

Nota

A migração em direto entre o Windows Server e o Azure Stack HCI não é suportada. A migração de rede do Azure Stack HCI para o Windows Server não é suportada.

- Desative temporariamente a migração em direto no anfitrião do Azure Stack HCI de destino.

- Selecione VMs e Serviços > Todos os Anfitriões e, em seguida, selecione o anfitrião Hyper-V de origem a partir do qual pretende migrar.

- Selecione a VM que pretende migrar. A VM tem de estar num estado desativado.

- Selecione Migrar Máquina Virtual.

- Em Selecionar Anfitrião, reveja e selecione o anfitrião do Azure Stack HCI de destino.

- Selecione Seguinte para iniciar a migração de rede. O VMM realizará importações e exportações no back-end.

- Para verificar se a máquina virtual foi migrada com êxito, verifique a lista de VMs no anfitrião de destino. Ative a VM e volte a ativar a migração em direto no anfitrião do Azure Stack HCI.

Passo 9: Migrar cargas de trabalho do VMware para o cluster do Azure Stack HCI com o SCVMM

O VMM oferece uma experiência simples baseada no assistente para conversão V2V (Virtual para Virtual). Pode utilizar a ferramenta de conversão para migrar cargas de trabalho em escala da infraestrutura do VMware para a infraestrutura hyper-V. Para obter a lista de servidores VMware suportados, veja Requisitos de sistema.

Para obter os pré-requisitos e limitações da conversão, veja Converter uma VM VMware em Hyper-V nos recursos de infraestrutura do VMM.

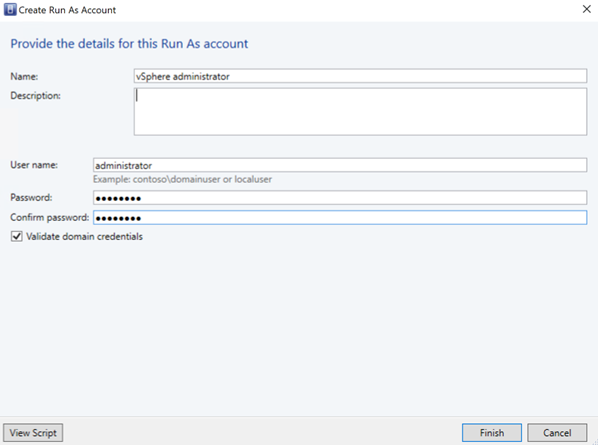

Crie uma conta Run As para a função de Administrador do vCenter Server no VMM. Estas credenciais de administrador são utilizadas para gerir o vCenter Server e os anfitriões ESXi.

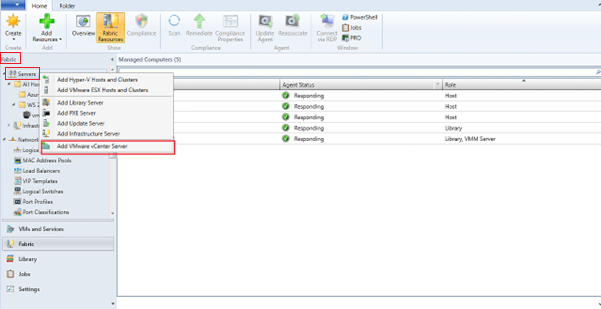

Na consola do VMM, em Recursos de Infraestrutura, selecione Servidores>Adicionar VMware vCenter Server.

Na página Adicionar VMware vCenter Server , faça o seguinte:

- Nome do computador: especifique o nome do servidor vCenter.

- Conta Run As: selecione a conta Run As criada para administrador do vSphere.

Selecione Concluir.

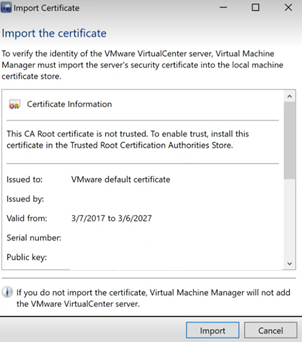

Na página Importar Certificado , selecione Importar.

Após a adição bem-sucedida do vCenter Server, todos os anfitriões ESXi no vCenter são migrados para o VMM.

Adicionar Anfitriões

- Na consola do VMM, em Recursos de Infraestrutura, selecione Servidores>Adicionar Anfitriões e Clusters VMware ESX.

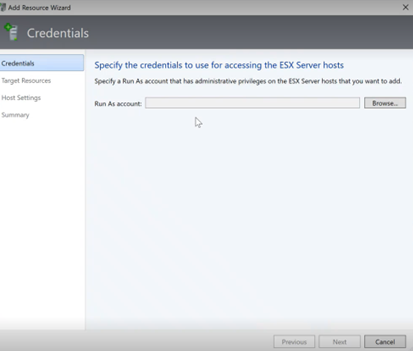

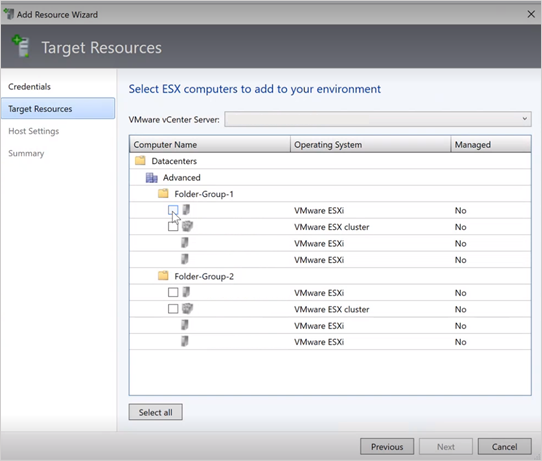

- No Assistente para Adicionar Recursos,

Em Credenciais, selecione a conta Run as que é utilizada para a porta e selecione Seguinte.

Em Recursos de Destino, selecione todos os clusters ESX que precisam de ser adicionados ao VMM e selecione Seguinte.

Em Definições do Anfitrião, selecione a localização onde pretende adicionar as VMs e selecione Seguinte.

Em Resumo, reveja as definições e selecione Concluir. Juntamente com os anfitriões, as VMs associadas também serão adicionadas.

Verificar o estado do anfitrião ESXi

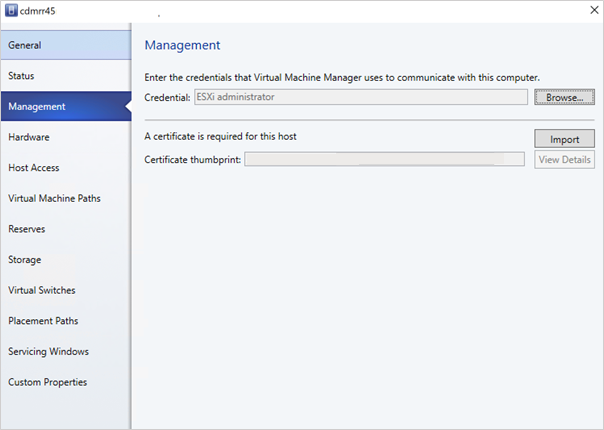

- Se o estado do anfitrião ESXi refletir como OK (Limitado), clique com o botão direito do rato emGestão de Propriedades>, selecione Executar como conta utilizada para a porta e importe os certificados para o anfitrião.

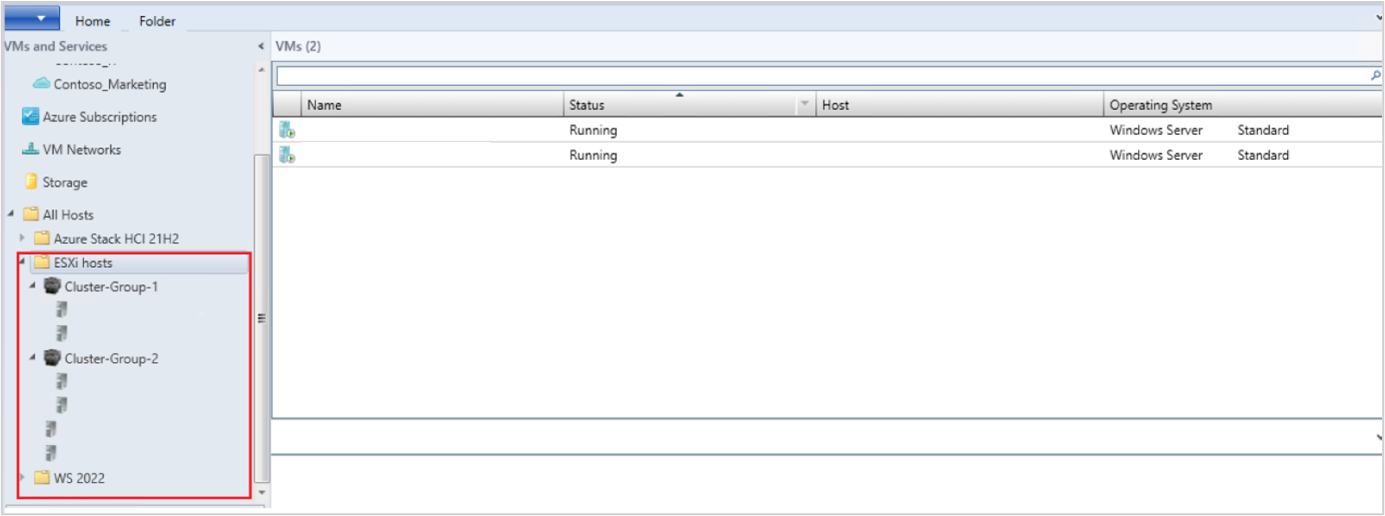

Repita o mesmo processo para todos os anfitriões ESXi. Depois de adicionar os clusters ESXi, todas as máquinas virtuais em execução nos clusters ESXi são detetadas automaticamente no VMM.

Depois de adicionar os clusters ESXi, todas as máquinas virtuais em execução nos clusters ESXi são detetadas automaticamente no VMM.

Ver VMs

Aceda a VMs e Serviços para ver as máquinas virtuais. Também pode gerir as operações de ciclo de vida principal destas máquinas virtuais a partir do VMM.

Clique com o botão direito do rato na VM e selecione Desligar (as migrações online não são suportadas) que precisam de ser migradas e desinstalar ferramentas VMware do sistema operativo convidado.

> SelecioneHome Create Máquinas Virtuais>Converter Máquina Virtual.

No Assistente de Conversão de Máquinas Virtuais,

- Em Selecionar Origem, selecione a VM em execução no servidor ESXi e selecione Seguinte.

- Em Especificar Identidade da Máquina Virtual, introduza o novo nome da máquina virtual, se quiser e selecione Seguinte.

- Em Selecionar Origem, selecione a VM em execução no servidor ESXi e selecione Seguinte.

Em Selecionar Anfitrião, selecione o nó Azure Stack HCI de destino e especifique a localização no anfitrião para ficheiros de armazenamento de VM e selecione Seguinte.

Selecione uma rede virtual para a máquina virtual e selecione Criar para concluir a migração.

A máquina virtual em execução no cluster ESXi foi migrada com êxito para o cluster do Azure Stack HCI. Para automatização, utilize comandos do PowerShell para conversão.

Passos seguintes

Comentários

Brevemente: Ao longo de 2024, vamos descontinuar progressivamente o GitHub Issues como mecanismo de feedback para conteúdos e substituí-lo por um novo sistema de feedback. Para obter mais informações, veja: https://aka.ms/ContentUserFeedback.

Submeter e ver comentários