Настройка цикла обучения Персонализатора

Важно!

Начиная с 20 сентября 2023 г. вы не сможете создавать новые ресурсы Персонализатора. Служба Персонализатора отменяется 1 октября 2026 года.

Конфигурация сервиса включает в себя то, как сервис рассматривает результаты, как часто он исследует, как часто переобучается модель и сколько данных хранится.

Настройте цикл обучения на странице Конфигурации на портале Azure для этого ресурса Персонализатора.

Планирование изменений конфигурации

Поскольку некоторые изменения конфигурации сбрасывают вашу модель, вам следует спланировать изменения конфигурации.

Если вы планируете использовать Режим ученика, обязательно проверьте конфигурацию Персонализатора перед переключением в режим ученика.

Настройки, включающие сброс модели

Следующие действия запускают повторное обучение модели с использованием данных, доступных за последние 2 дня.

- Награда

- и исследование

Чтобы очистить все данные, используйте страницу параметров модели и обучения.

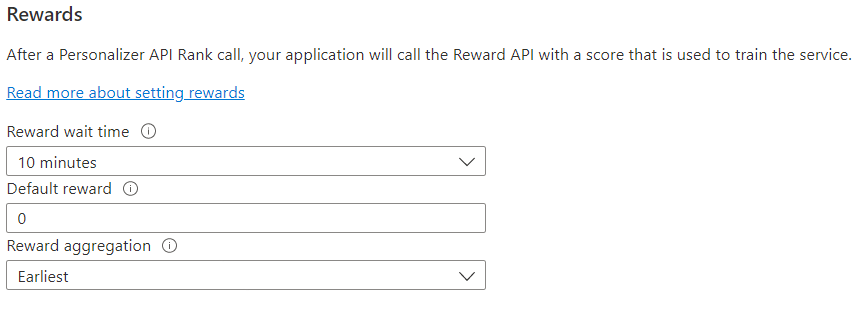

Настройте награды для цикла обратной связи

Настройте службу для использования вознаграждений в вашем цикле обучения. Изменение следующих значений приведет к сбросу текущей модели Персонализатора и ее повторному обучению с использованием данных за последние 2 дня.

| Значение | Назначение |

|---|---|

| Время ожидания результата | Задает продолжительность времени, во время которого Персонализатор будет собирать результаты значений для вызова ранжирования, начиная с момента, когда вызов ранжирования происходит. Это значение устанавливается с помощью вопроса: "Как долго Персонализатор должен ждать результативных звонков?" Любой результат, полученный после этого окна, будет зарегистрирован, но не будет использоваться для обучения. |

| Вознаграждение по умолчанию | Если в течение времени ожидания результата, связанного с вызовом ранжирования, Персонализатор не получит результативный вызов, Персонализатор назначит результат по умолчанию. По умолчанию и в большинстве сценариев вознаграждение по умолчанию равно нулю (0). |

| Агрегация вознаграждения | Если за один и тот же вызов API ранжирования получено несколько результатов, используется следующий метод агрегации: сумма или самое раннее. Самое раннее выбирает самую раннюю полученную оценку и отклоняет остальные. Это полезно, если вы хотите получить уникальное вознаграждение среди возможных повторяющихся звонков. |

После изменения этих значений не забудьте выбрать Сохранить.

Настройте исследование, чтобы позволить адаптировать цикл обучения

Персонализация может обнаруживать новые закономерности и адаптироваться к изменениям поведения пользователя с течением времени, исследуя альтернативы вместо использования прогнозов обученной модели. Значение Исследования определяет, на какой процент запросов ранга отвечает исследование.

Изменение этого значения приведет к сбросу текущей модели Персонализатора и ее повторному обучению с использованием данных за последние 2 дня.

После изменения этого значения не забудьте выбрать Сохранить.

Настроить частоту обновления модели для обучения модели

Частота обновления модели устанавливает, как часто модель обучается.

| Параметр частоты | Назначение |

|---|---|

| 1 минута | Частота обновления в одну минуту полезна при отладке кода приложения с помощью Персонализатора, выполнении демонстраций или интерактивном тестировании аспектов машинного обучения. |

| 15 минут | Высокая частота обновления модели полезна в ситуациях, когда вы хотите внимательно отслеживать изменения в поведении пользователей. Это могут быть сайты с новостями, вирусным содержимым или торговлей в режиме реального времени. В таких сценариях модель можно обновлять каждые 15 минут. |

| 1 ч | В большинстве других случаев целесообразно задать меньшую частоту обновления. |

После изменения этого значения не забудьте выбрать Сохранить.

Хранение данных

Период хранения данных устанавливает, сколько дней Персонализатор хранит журналы данных. Журналы прошлых данных необходимы для выполнения автономных вычислений, которые используются для измерения эффективности Персонализатора и оптимизации политики обучения.

После изменения этого значения не забудьте выбрать Сохранить.