Краткое руководство. Развертывание кластера Служба Azure Kubernetes (AKS) с помощью шаблона ARM

Служба Azure Kubernetes (AKS) — это управляемая служба Kubernetes, которая позволяет быстро развертывать кластеры и управлять ими. В этом кратком руководстве вы:

- Развертывание кластера AKS с использованием шаблона Azure Resource Manager.

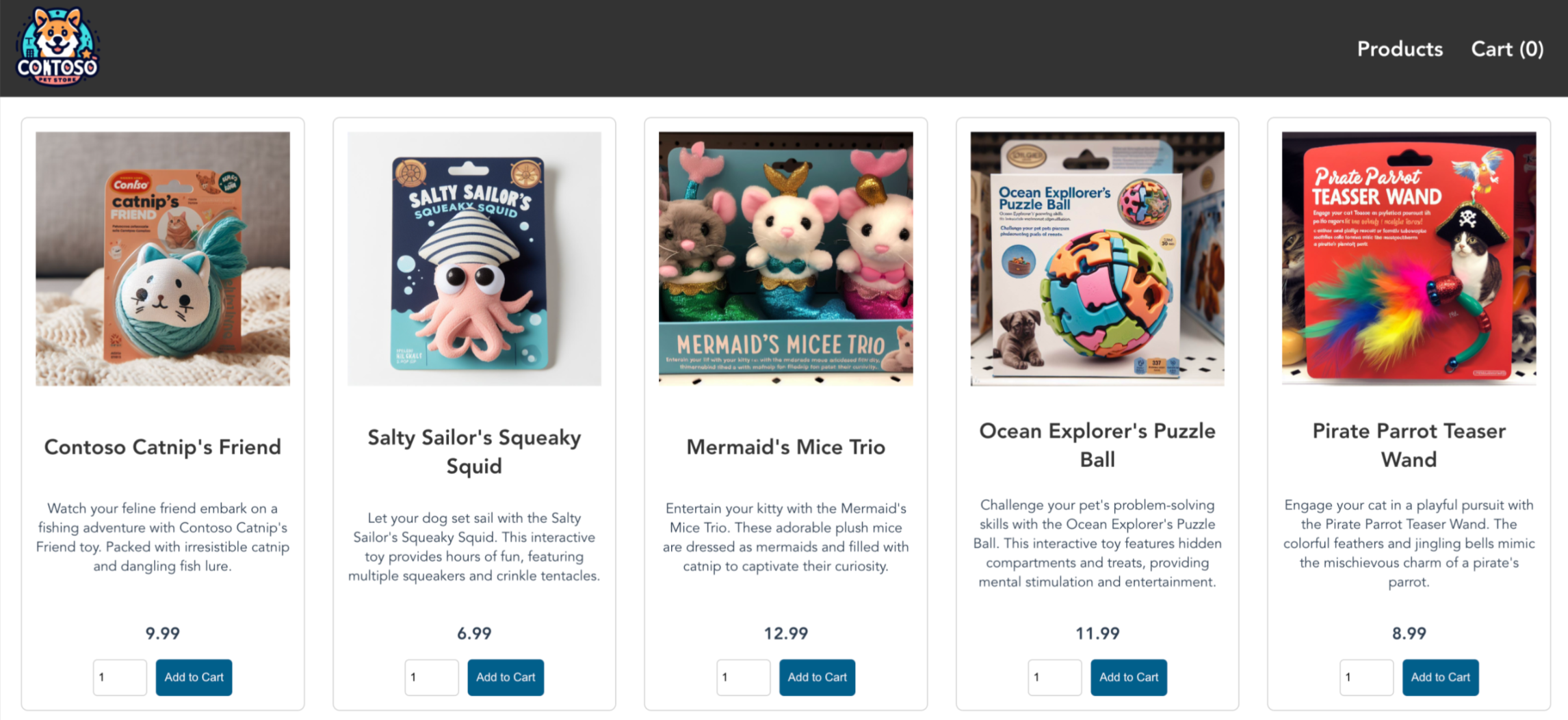

- Запустите пример мультиконтейнерного приложения с группой микрослужб и веб-интерфейсов с имитацией сценария розничной торговли.

Шаблон Azure Resource Manager — это файл нотации объектов JavaScript (JSON), который определяет инфраструктуру и конфигурацию проекта. В шаблоне используется декларативный синтаксис. Вы описываете предполагаемое развертывание без написания последовательности команд программирования для создания развертывания.

Примечание.

Чтобы приступить к быстрой подготовке кластера AKS, в этой статье содержатся действия по развертыванию кластера с параметрами по умолчанию только для оценки. Прежде чем развертывать готовый к работе кластер, рекомендуется ознакомиться с базовой эталонной архитектурой , чтобы понять, как она соответствует вашим бизнес-требованиям.

Подготовка к работе

В этой статье предполагается базовое понимание концепций Kubernetes. Дополнительные сведения см. в статье Ключевые концепции Kubernetes для службы Azure Kubernetes (AKS).

-

Если у вас еще нет подписки Azure, создайте бесплатную учетную запись Azure, прежде чем начинать работу.

Убедитесь, что удостоверение, используемое для создания кластера, имеет соответствующие минимальные разрешения. Дополнительные сведения о доступе и удостоверении для AKS см. в статье Возможности контроля доступа и идентификации в Службе Azure Kubernetes (AKS).

Чтобы развернуть шаблон ARM, необходимо написать доступ к ресурсам, которые вы развертываете и обращаетесь ко всем операциям с типом

Microsoft.Resources/deploymentsресурса. Например, для развертывания виртуальной машины необходимы разрешенияMicrosoft.Compute/virtualMachines/writeиMicrosoft.Resources/deployments/*. Список ролей и разрешений см. в статье Встроенные роли Azure.

После развертывания кластера из шаблона можно использовать Azure CLI или Azure PowerShell для подключения к кластеру и развертывания примера приложения.

Используйте среду Bash в Azure Cloud Shell. Дополнительные сведения см . в кратком руководстве по Bash в Azure Cloud Shell.

Если вы предпочитаете выполнять справочные команды CLI локально, установите Azure CLI. Если вы работаете в Windows или macOS, Azure CLI можно запустить в контейнере Docker. Дополнительные сведения см. в статье Как запустить Azure CLI в контейнере Docker.

Если вы используете локальную установку, выполните вход в Azure CLI с помощью команды az login. Чтобы выполнить аутентификацию, следуйте инструкциям в окне терминала. Сведения о других возможностях, доступных при входе, см. в статье Вход с помощью Azure CLI.

Установите расширение Azure CLI при первом использовании, когда появится соответствующий запрос. Дополнительные сведения о расширениях см. в статье Использование расширений с Azure CLI.

Выполните команду az version, чтобы узнать установленную версию и зависимые библиотеки. Чтобы обновиться до последней версии, выполните команду az upgrade.

Для этой статьи требуется Azure CLI версии 2.0.64 или более поздней. Если вы используете Azure Cloud Shell, последняя версия уже установлена там.

Создание пары ключей SSH

Чтобы создать кластер AKS с помощью шаблона ARM, укажите открытый ключ SSH. Если вам нужен этот ресурс, выполните действия, описанные в этом разделе. В противном случае перейдите к разделу "Просмотр шаблона ".

Чтобы получить доступ к узлам AKS, подключитесь с помощью пары ключей SSH (общедоступная и частная). Чтобы создать пару ключей SSH, сделайте следующее:

Перейдите по адресу https://shell.azure.com, чтобы открыть Cloud Shell в браузере.

Создайте пару ключей SSH с помощью команды az sshkey create или

ssh-keygenкоманды.# Create an SSH key pair using Azure CLI az sshkey create --name "mySSHKey" --resource-group "myResourceGroup" # or # Create an SSH key pair using ssh-keygen ssh-keygen -t rsa -b 4096Чтобы развернуть шаблон, необходимо указать открытый ключ из пары SSH. Чтобы получить открытый ключ, вызовите az sshkey show:

az sshkey show --name "mySSHKey" --resource-group "myResourceGroup" --query "publicKey"

По умолчанию файлы ключей SSH создаются в каталоге ~/.ssh . При выполнении az sshkey createssh-keygen команды перезаписывается любая существующая пара ключей SSH с тем же именем.

Дополнительные сведения о создании ключей SSH см. в статье Detailed steps: Create and manage SSH keys for authentication to a Linux VM in Azure (Подробные инструкции. Создание ключей SSH для проверки подлинности на виртуальной машине Linux в Azure и управление этими ключами).

Изучение шаблона

Шаблон, используемый в этом кратком руководстве, взят из шаблонов быстрого запуска Azure.

{

"$schema": "https://schema.management.azure.com/schemas/2019-04-01/deploymentTemplate.json#",

"contentVersion": "1.0.0.0",

"metadata": {

"_generator": {

"name": "bicep",

"version": "0.26.170.59819",

"templateHash": "14823542069333410776"

}

},

"parameters": {

"clusterName": {

"type": "string",

"defaultValue": "aks101cluster",

"metadata": {

"description": "The name of the Managed Cluster resource."

}

},

"location": {

"type": "string",

"defaultValue": "[resourceGroup().location]",

"metadata": {

"description": "The location of the Managed Cluster resource."

}

},

"dnsPrefix": {

"type": "string",

"metadata": {

"description": "Optional DNS prefix to use with hosted Kubernetes API server FQDN."

}

},

"osDiskSizeGB": {

"type": "int",

"defaultValue": 0,

"minValue": 0,

"maxValue": 1023,

"metadata": {

"description": "Disk size (in GB) to provision for each of the agent pool nodes. This value ranges from 0 to 1023. Specifying 0 will apply the default disk size for that agentVMSize."

}

},

"agentCount": {

"type": "int",

"defaultValue": 3,

"minValue": 1,

"maxValue": 50,

"metadata": {

"description": "The number of nodes for the cluster."

}

},

"agentVMSize": {

"type": "string",

"defaultValue": "standard_d2s_v3",

"metadata": {

"description": "The size of the Virtual Machine."

}

},

"linuxAdminUsername": {

"type": "string",

"metadata": {

"description": "User name for the Linux Virtual Machines."

}

},

"sshRSAPublicKey": {

"type": "string",

"metadata": {

"description": "Configure all linux machines with the SSH RSA public key string. Your key should include three parts, for example 'ssh-rsa AAAAB...snip...UcyupgH azureuser@linuxvm'"

}

}

},

"resources": [

{

"type": "Microsoft.ContainerService/managedClusters",

"apiVersion": "2024-02-01",

"name": "[parameters('clusterName')]",

"location": "[parameters('location')]",

"identity": {

"type": "SystemAssigned"

},

"properties": {

"dnsPrefix": "[parameters('dnsPrefix')]",

"agentPoolProfiles": [

{

"name": "agentpool",

"osDiskSizeGB": "[parameters('osDiskSizeGB')]",

"count": "[parameters('agentCount')]",

"vmSize": "[parameters('agentVMSize')]",

"osType": "Linux",

"mode": "System"

}

],

"linuxProfile": {

"adminUsername": "[parameters('linuxAdminUsername')]",

"ssh": {

"publicKeys": [

{

"keyData": "[parameters('sshRSAPublicKey')]"

}

]

}

}

}

}

],

"outputs": {

"controlPlaneFQDN": {

"type": "string",

"value": "[reference(resourceId('Microsoft.ContainerService/managedClusters', parameters('clusterName')), '2024-02-01').fqdn]"

}

}

}

Тип ресурса, определенный в шаблоне ARM, — Microsoft.ContainerService/managedClusters.

Дополнительные примеры AKS см. на странице Шаблоны быстрого запуска Azure.

Развертывание шаблона

Выберите "Развернуть в Azure ", чтобы войти и открыть шаблон.

На странице "Основные сведения" оставьте значения по умолчанию для размера диска ОС, количества агентов, размера виртуальной машины агента и типа ОС и настройте следующие параметры шаблона:

- Подписка— выберите подписку Azure.

- Группа ресурсов: выберите "Создать". Введите уникальное имя группы ресурсов, например myResourceGroup, а затем нажмите кнопку ОК.

- Расположение: выберите расположение, например восточную часть США.

- Имя кластера: введите уникальное имя кластера AKS, например myAKSCluster.

- Префикс DNS: введите уникальный префикс DNS для кластера, например myakscluster.

- Имя пользователя в Linux Администратор: введите имя пользователя для подключения с помощью SSH, например azureuser.

- Источник открытого ключа SSH: выберите " Использовать существующий открытый ключ".

- Имя пары ключей: скопируйте и вставьте общедоступную часть пары ключей SSH (по умолчанию содержимое ~/.ssh/id_rsa.pub).

Выберите Просмотреть и создать>Создать.

Создание кластера AKS займет несколько минут. Дождитесь успешного развертывания кластера, прежде чем перейти к следующему шагу.

Подключение к кластеру

Кластером Kubernetes можно управлять при помощи kubectl клиента командной строки Kubernetes.

Если вы используете Azure Cloud Shell, kubectl уже установлен. Чтобы установить и запустить kubectl локально, вызовите команду az aks install-cli .

Настройте в

kubectlподключение к кластеру Kubernetes, выполнив команду az aks get-credentials. Эта команда скачивает учетные данные и настраивает интерфейс командной строки Kubernetes для их использования.az aks get-credentials --resource-group myResourceGroup --name myAKSClusterПроверьте подключение к кластеру, выполнив команду kubectl get. Эта команда возвращает список узлов кластера.

kubectl get nodesВ следующем примере выходных данных показаны три узла, созданные на предыдущих шагах. Убедитесь, что состояние узла готово.

NAME STATUS ROLES AGE VERSION aks-agentpool-27442051-vmss000000 Ready agent 10m v1.27.7 aks-agentpool-27442051-vmss000001 Ready agent 10m v1.27.7 aks-agentpool-27442051-vmss000002 Ready agent 11m v1.27.7

Развертывание приложения

Чтобы развернуть приложение, используйте файл манифеста для создания всех объектов, необходимых для запуска приложения AKS Store. Файл манифеста Kubernetes используется для определения требуемого состояния кластера, например выполняемых в нем образов контейнеров. Манифест включает следующие развертывания и службы Kubernetes:

- Интерфейс магазина: веб-приложение для пользователей для просмотра продуктов и размещения заказов.

- Служба продуктов: отображает сведения о продукте.

- Служба заказов: помещает заказы.

- Rabbit MQ: очередь сообщений для очереди заказов.

Примечание.

Не рекомендуется запускать контейнеры с отслеживанием состояния, такие как Rabbit MQ, без постоянного хранения для рабочей среды. Они используются здесь для простоты, но мы рекомендуем использовать управляемые службы, такие как Azure CosmosDB или Служебная шина Azure.

Создайте файл с именем

aks-store-quickstart.yamlи скопируйте его в следующем манифесте:apiVersion: apps/v1 kind: Deployment metadata: name: rabbitmq spec: replicas: 1 selector: matchLabels: app: rabbitmq template: metadata: labels: app: rabbitmq spec: nodeSelector: "kubernetes.io/os": linux containers: - name: rabbitmq image: mcr.microsoft.com/mirror/docker/library/rabbitmq:3.10-management-alpine ports: - containerPort: 5672 name: rabbitmq-amqp - containerPort: 15672 name: rabbitmq-http env: - name: RABBITMQ_DEFAULT_USER value: "username" - name: RABBITMQ_DEFAULT_PASS value: "password" resources: requests: cpu: 10m memory: 128Mi limits: cpu: 250m memory: 256Mi volumeMounts: - name: rabbitmq-enabled-plugins mountPath: /etc/rabbitmq/enabled_plugins subPath: enabled_plugins volumes: - name: rabbitmq-enabled-plugins configMap: name: rabbitmq-enabled-plugins items: - key: rabbitmq_enabled_plugins path: enabled_plugins --- apiVersion: v1 data: rabbitmq_enabled_plugins: | [rabbitmq_management,rabbitmq_prometheus,rabbitmq_amqp1_0]. kind: ConfigMap metadata: name: rabbitmq-enabled-plugins --- apiVersion: v1 kind: Service metadata: name: rabbitmq spec: selector: app: rabbitmq ports: - name: rabbitmq-amqp port: 5672 targetPort: 5672 - name: rabbitmq-http port: 15672 targetPort: 15672 type: ClusterIP --- apiVersion: apps/v1 kind: Deployment metadata: name: order-service spec: replicas: 1 selector: matchLabels: app: order-service template: metadata: labels: app: order-service spec: nodeSelector: "kubernetes.io/os": linux containers: - name: order-service image: ghcr.io/azure-samples/aks-store-demo/order-service:latest ports: - containerPort: 3000 env: - name: ORDER_QUEUE_HOSTNAME value: "rabbitmq" - name: ORDER_QUEUE_PORT value: "5672" - name: ORDER_QUEUE_USERNAME value: "username" - name: ORDER_QUEUE_PASSWORD value: "password" - name: ORDER_QUEUE_NAME value: "orders" - name: FASTIFY_ADDRESS value: "0.0.0.0" resources: requests: cpu: 1m memory: 50Mi limits: cpu: 75m memory: 128Mi initContainers: - name: wait-for-rabbitmq image: busybox command: ['sh', '-c', 'until nc -zv rabbitmq 5672; do echo waiting for rabbitmq; sleep 2; done;'] resources: requests: cpu: 1m memory: 50Mi limits: cpu: 75m memory: 128Mi --- apiVersion: v1 kind: Service metadata: name: order-service spec: type: ClusterIP ports: - name: http port: 3000 targetPort: 3000 selector: app: order-service --- apiVersion: apps/v1 kind: Deployment metadata: name: product-service spec: replicas: 1 selector: matchLabels: app: product-service template: metadata: labels: app: product-service spec: nodeSelector: "kubernetes.io/os": linux containers: - name: product-service image: ghcr.io/azure-samples/aks-store-demo/product-service:latest ports: - containerPort: 3002 resources: requests: cpu: 1m memory: 1Mi limits: cpu: 1m memory: 7Mi --- apiVersion: v1 kind: Service metadata: name: product-service spec: type: ClusterIP ports: - name: http port: 3002 targetPort: 3002 selector: app: product-service --- apiVersion: apps/v1 kind: Deployment metadata: name: store-front spec: replicas: 1 selector: matchLabels: app: store-front template: metadata: labels: app: store-front spec: nodeSelector: "kubernetes.io/os": linux containers: - name: store-front image: ghcr.io/azure-samples/aks-store-demo/store-front:latest ports: - containerPort: 8080 name: store-front env: - name: VUE_APP_ORDER_SERVICE_URL value: "http://order-service:3000/" - name: VUE_APP_PRODUCT_SERVICE_URL value: "http://product-service:3002/" resources: requests: cpu: 1m memory: 200Mi limits: cpu: 1000m memory: 512Mi --- apiVersion: v1 kind: Service metadata: name: store-front spec: ports: - port: 80 targetPort: 8080 selector: app: store-front type: LoadBalancerСведения о разбивке файлов манифеста YAML см. в разделе "Развертывания" и "Манифесты YAML".

Если вы создаете и сохраняете файл YAML локально, вы можете отправить файл манифеста в каталог по умолчанию в CloudShell, нажав кнопку "Отправить и скачать файлы " и выбрав файл из локальной файловой системы.

Разверните приложение с помощью команды kubectl apply и укажите имя манифеста YAML.

kubectl apply -f aks-store-quickstart.yamlВ следующем примере выходных данных показаны развертывания и службы:

deployment.apps/rabbitmq created service/rabbitmq created deployment.apps/order-service created service/order-service created deployment.apps/product-service created service/product-service created deployment.apps/store-front created service/store-front created

Тестирование приложения

Проверьте состояние развернутых модулей pod с помощью команды kubectl get pods . Прежде чем продолжить, сделайте все модули pod

Running.kubectl get podsПроверьте общедоступный IP-адрес для приложения store-front. Ход выполнения можно отслеживать с помощью команды kubectl get service с аргументом

--watch.kubectl get service store-front --watchВыходные данные EXTERNAL-IP для

store-frontслужбы изначально отображаются как ожидающие:NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE store-front LoadBalancer 10.0.100.10 <pending> 80:30025/TCP 4h4mКогда параметр EXTERNAL-IP вместо pending примет значение общедоступного IP-адреса, выполните команду

CTRL-C, чтобы остановить процесс отслеживанияkubectl.В следующем примере выходных данных показан общедоступный IP-адрес, присвоенный службе.

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE store-front LoadBalancer 10.0.100.10 20.62.159.19 80:30025/TCP 4h5mОткройте веб-браузер на внешний IP-адрес службы, чтобы увидеть приложение Магазина Azure в действии.

Удаление кластера

Если вы не планируете использовать учебник AKS, очистите ненужные ресурсы, чтобы избежать расходов Azure.

Удалите группу ресурсов, службу контейнеров и все связанные ресурсы, вызвав команду az group delete .

az group delete --name myResourceGroup --yes --no-wait

Примечание.

Кластер AKS был создан с управляемым удостоверением, назначенным системой, который является параметром удостоверения по умолчанию, используемым в этом кратком руководстве. Платформа управляет этим удостоверением, чтобы удалить его вручную не нужно.

Следующие шаги

С помощью этого краткого руководства вы развернули кластер Kubernetes и простое многоконтейнерное приложение в нем. Этот пример приложения предназначен только для демонстрационных целей и не представляет все рекомендации для приложений Kubernetes. Рекомендации по созданию полных решений с помощью AKS для рабочей среды см . в руководстве по решению AKS.

Чтобы узнать больше об AKS и ознакомиться с полным примером кода к развертыванию, перейдите к руководству по кластеру Kubernetes.