Потоковая передача данных в Базу данных SQL Azure с помощью интеграции Azure Stream Analytics (предварительная версия)

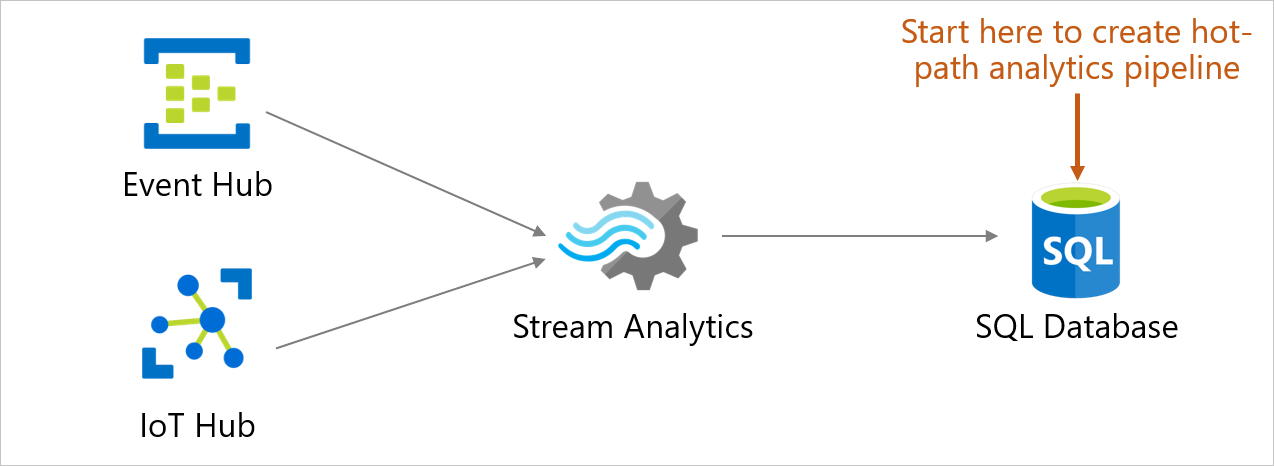

Теперь пользователи могут принимать, обрабатывать, просматривать и анализировать данные потоковой передачи в режиме реального времени в таблицу непосредственно из базы данных в Базе данных SQL Azure. Это доступно на портале Azure благодаря Azure Stream Analytics. Этот интерфейс обеспечивает широкий спектр сценариев, таких как подключенный автомобиль, удаленный мониторинг, обнаружение мошенничества и многое другое. На портале Azure можно выбрать источник событий (концентратор событий или центр Интернета вещей), просмотреть входящие события в реальном времени и выбрать таблицу для хранения событий. Можно также писать запросы на языке запросов Azure Stream Analytics на портале, чтобы преобразовать входящие события и сохранить их в выбранной таблице. Эта новая точка входа дополняет возможности создания и конфигурации, уже имеющиеся в Stream Analytics. Интерфейс начинается с контекста базы данных и позволяет быстро настроить задание Stream Analytics, а также легко перемещаться между базой данных в Базе данных SQL Azure и Stream Analytics.

Ключевые преимущества

- Минимальное переключение контекста. Вы можете начать с базы данных в Базе данных SQL Azure на портале и принимать данные в режиме реального времени в таблицу, не переключаясь на другую службу.

- Уменьшенное количество шагов. Контекст базы данных и таблицы используется для предварительной настройки Stream Analytics задания.

- Простота в использовании данных для предварительного просмотра. Вы можете просматривать входящие данные из источника событий (концентратора событий или центра Интернета вещей) в контексте выбранной таблицы.

Важно!

Задание Azure Stream Analytics может выводить данные в базу данных SQL Azure, Управляемый экземпляр SQL Azure или Azure Synapse Analytic. Дополнительные сведения: Выходные данные.

Необходимые компоненты

Чтобы выполнить действия, описанные в этой статье, необходимы следующие ресурсы:

- Подписка Azure. Если у вас еще нет подписки Azure, создайте бесплатную учетную запись.

- База данных в службе "База данных SQL Azure". Дополнительные сведения см. в разделе Создание отдельной базы данных в Базе данных SQL Azure.

- Правило брандмауэра, разрешающее компьютеру подключаться к серверу. Дополнительные сведения см. в разделе Создание правила брандмауэра на уровне сервера.

Настройка интеграции со Stream Analytics

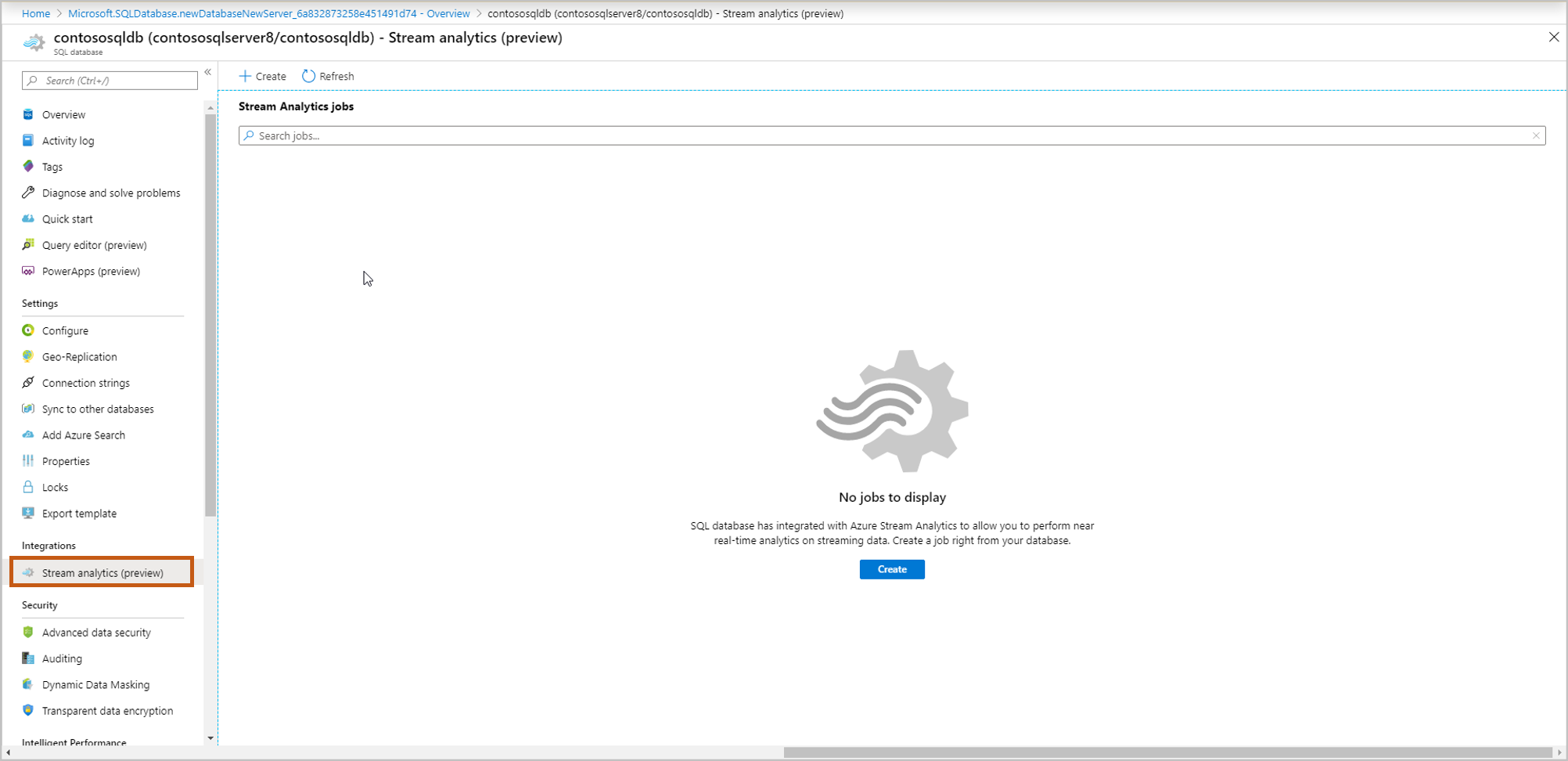

Войдите на портал Azure.

Перейдите к базе данных, в которой необходимо получить данные потоковой передачи. Выберите Stream Analytics (preview).

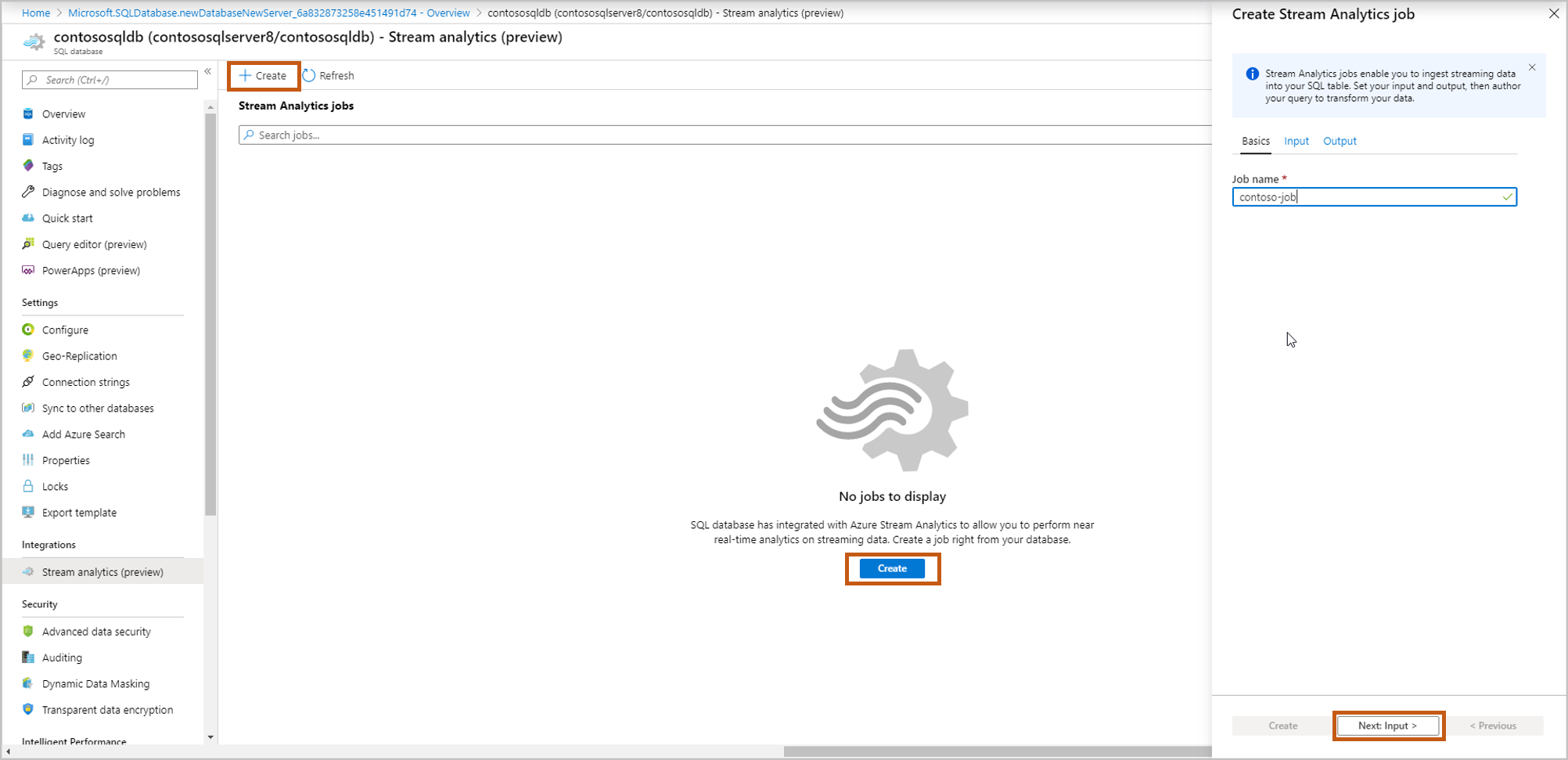

Чтобы начать потоковую передачу в эту базу данных, выберите Create (Создать) и укажите имя для задания потоковой передачи, а затем нажмите кнопку Next: Input (Далее: вход).

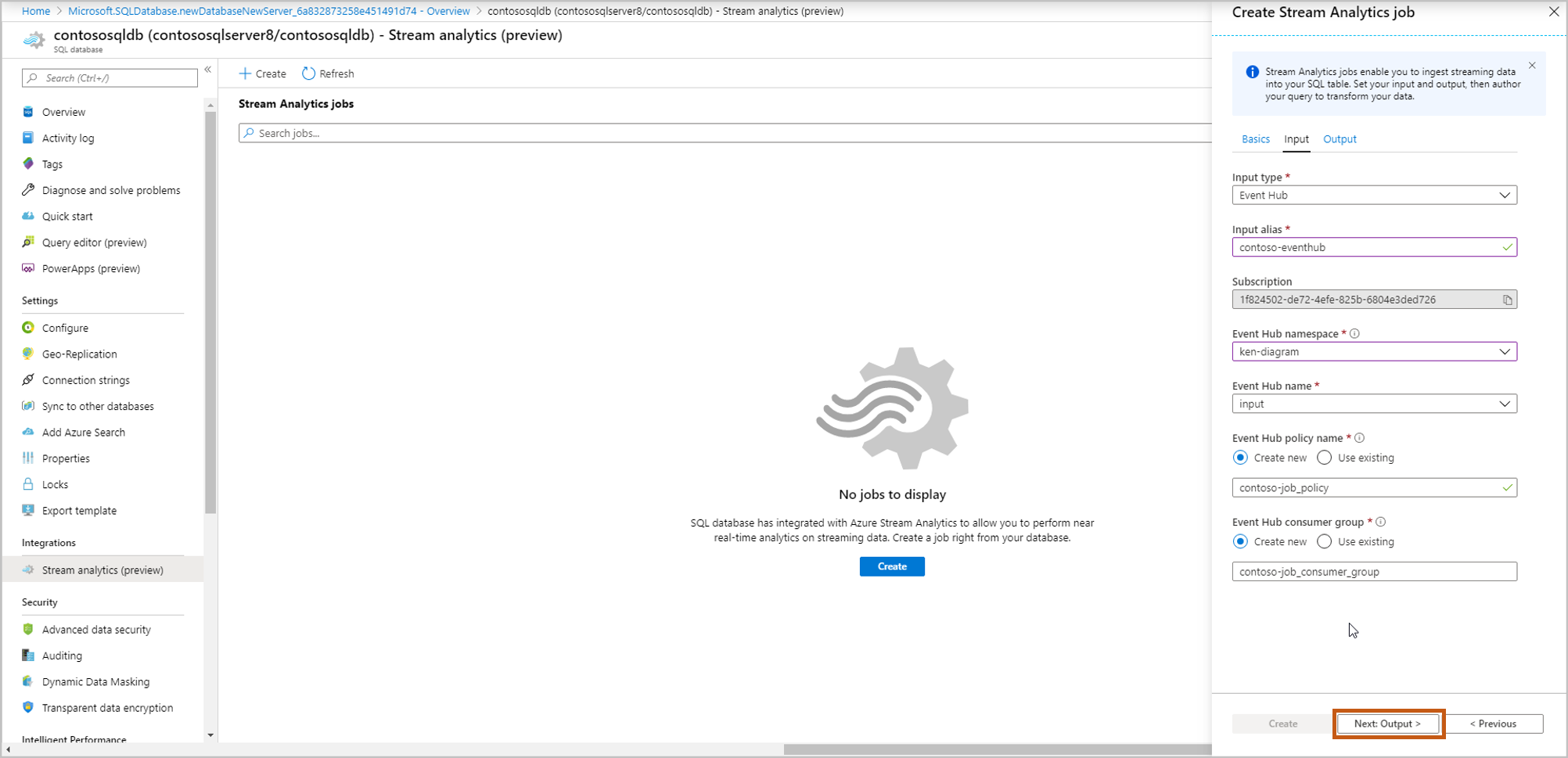

Введите сведения об источнике событий, а затем нажмите кнопку Next: Output (Далее: выходные данные).

Input type (Тип входных данных): концентратор событий или центр Интернета вещей

Input alias (Псевдоним входных данных): введите имя, чтобы указать источник события

Subscription (Подписка): то же значение, что и для подписки на Базу данных SQL Azure

Event Hub namespace (Пространство имен концентратора событий): имя пространства имен

Event Hub name (имя концентратора событий): имя концентратора событий в пространстве имен

Event Hub policy name (Имя политики концентратора событий), по умолчанию новое: назовите политику

Event Hub consumer group (Группа потребителей концентратора событий), по умолчанию новое: назовите группу потребителей

Рекомендуется создавать группу потребителей и политику для каждого нового задания Azure Stream Analytics, которое вы будете создавать. Группы потребителей допускают только пять одновременных средств чтения, поэтому для каждого задания выделяется выделенная группа потребителей, что позволяет избежать ошибок, которые могут возникнуть из-за превышения этого ограничения. Выделенная политика позволяет поворачивать ключ или отзывать разрешения без влияния на другие ресурсы.

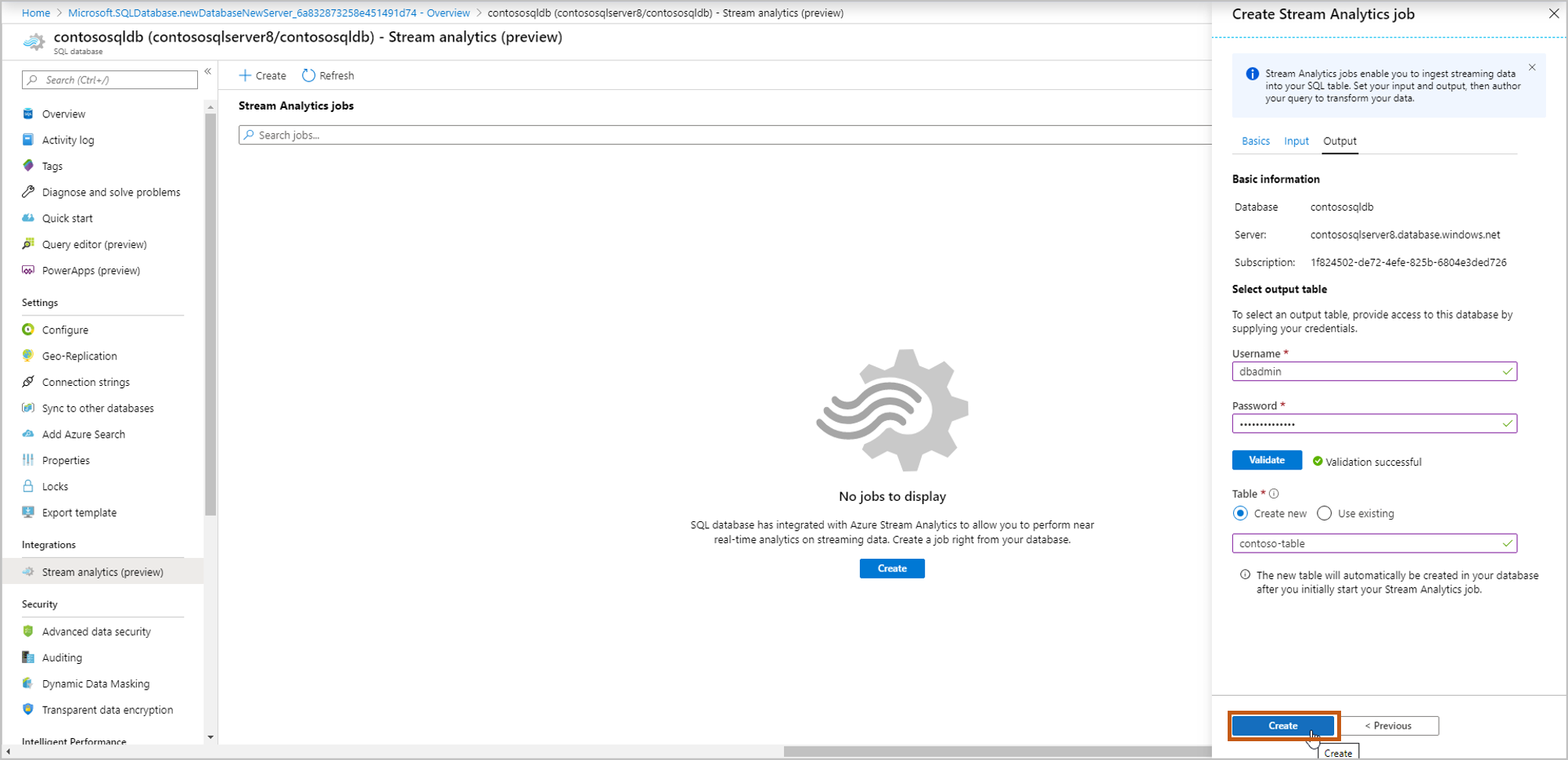

Выберите таблицу, в которую необходимо передавать данные потоковой передачи. По завершении выберите Create (Создать).

Username, Password: введите учетные данные для проверки подлинности сервера SQL. Выберите Проверить.

Table (Таблица): выберите Create new (Создать) либо Use existing (Использовать существующую). В этом потоке выберите "Создать". При запуске задания Stream Analytics будет создана таблица.

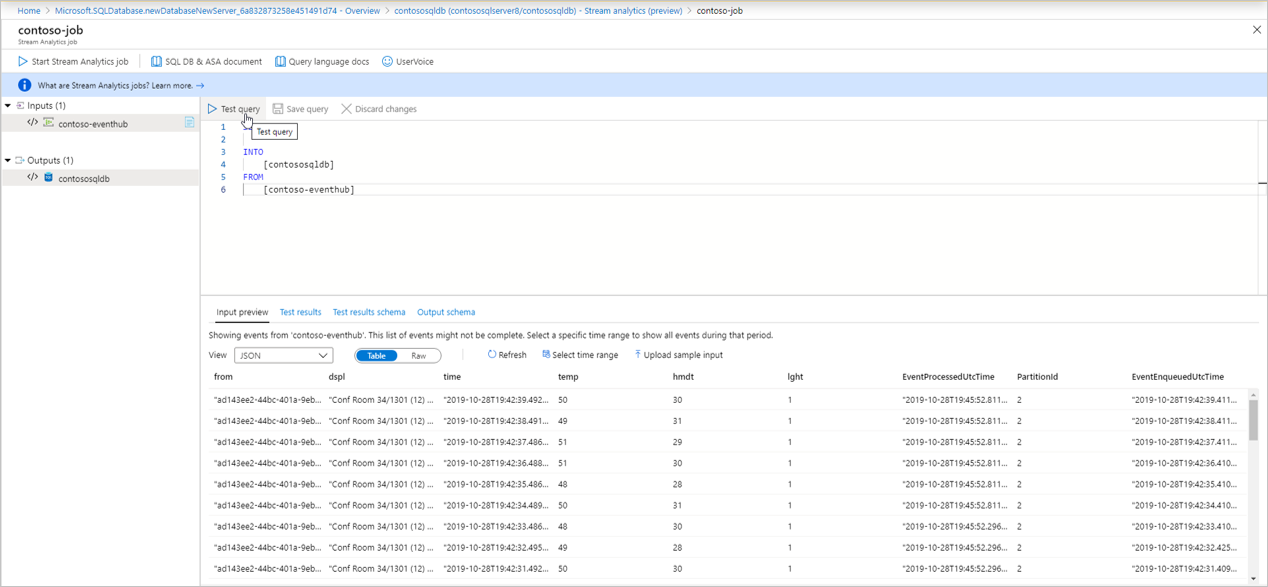

Откроется страница запроса со следующими сведениями:

Ваши входные данные (источник входных событий), из которого будут приниматься данные

Ваши выходные данные (таблица выходных данных), в которых будут содержаться преобразованные данные

Пример запроса SAQL с оператором SELECT.

Input preview (Предварительный просмотр ввода): показывает моментальный снимок последних входящих данных из источника входных событий.

- Тип сериализации в данных определяется автоматически (JSON/CSV). Вы можете вручную изменить его на JSON/CSV/AVRO.

- Вы можете просмотреть входящие данные в формате таблицы или необработанном формате.

- Если данные не актуальны, выберите Refresh (Обновить), чтобы просмотреть последние события.

- Нажмите Select time range (Выбрать диапазон времени), чтобы проверить запрос по определенному диапазону входящих событий.

- Выберите Upload sample input (Отправить пример входных данных), чтобы протестировать запрос, отправив пример файла JSON/CSV. Дополнительные сведения о тестировании запроса SAQL см. в разделе Тестирование задания Azure Stream Analytics с помощью демонстрационных данных.

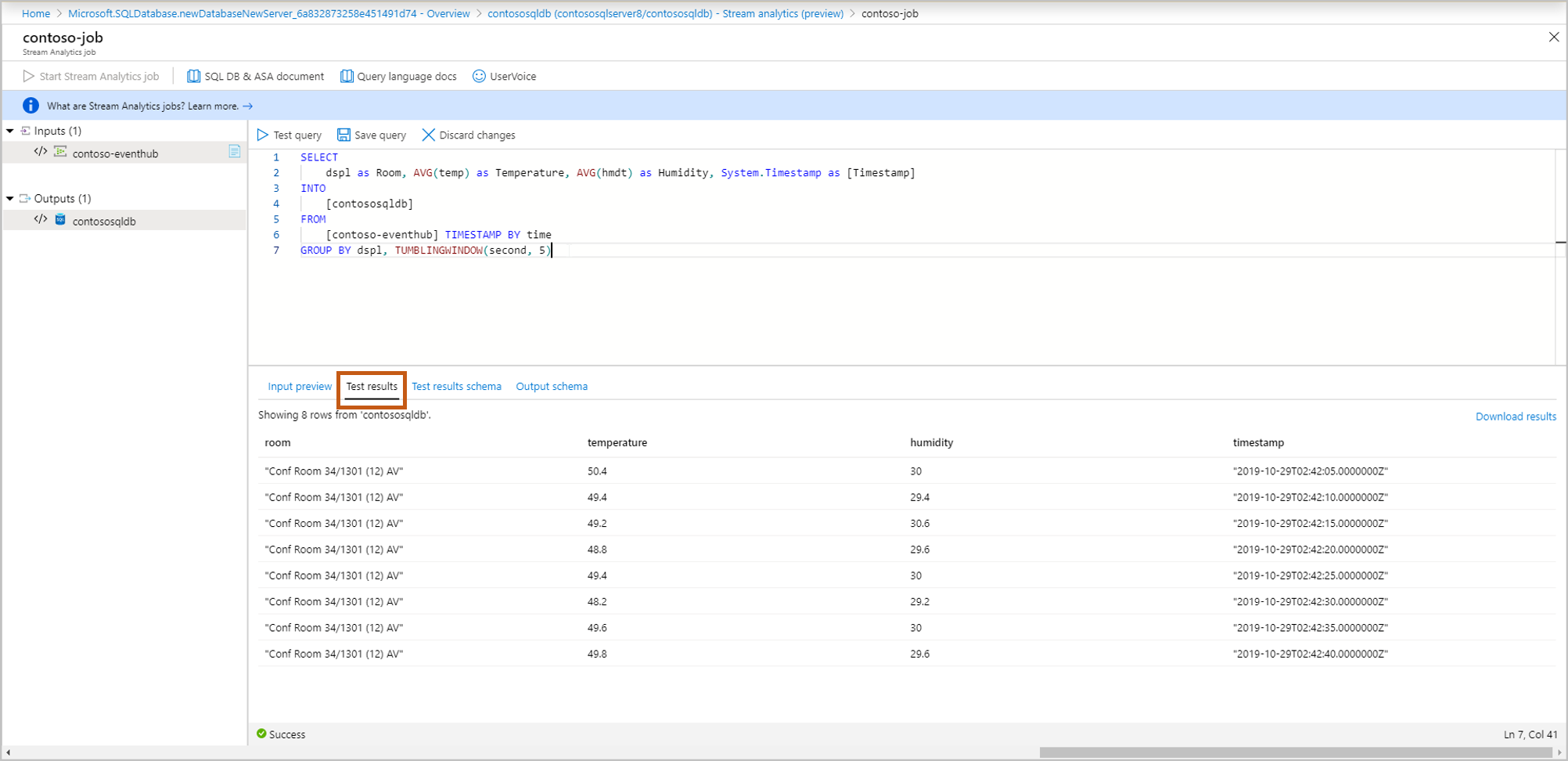

Test results (Результаты теста): нажмите Test query (Тестовый запрос), чтобы увидеть результаты запроса потоковой передачи.

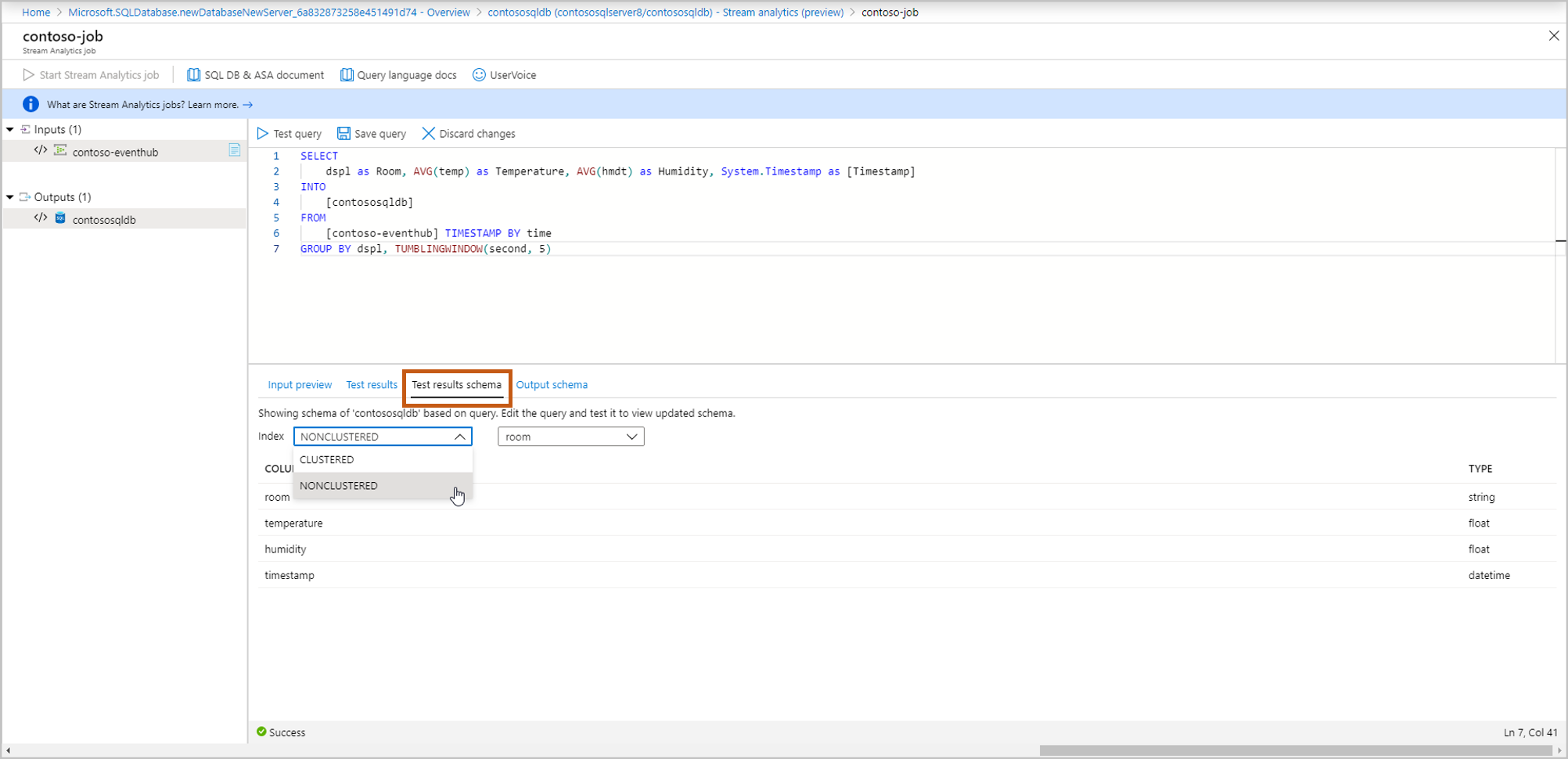

Test results schema (Схема результатов теста): отображает схему с результатами теста запроса потоковой передачи. Проверьте, что схема результатов теста соответствует выходной схеме.

Output schema (Выходная схема): содержит схему таблицы, выбранной на шаге 5 (новую или существующую).

- Создайте новое: если этот параметр выбран на шаге 5, схема еще не будет отображаться, пока не начнется задание потоковой передачи. При создании новой таблицы выберите соответствующий индекс таблицы. Дополнительные сведения об индексации таблицы см. в разделе Описания кластеризованных и некластеризованных индексов.

- "Использовать существующую": если вы выбрали этот параметр на шаге 5, вы увидите схему выбранной таблицы.

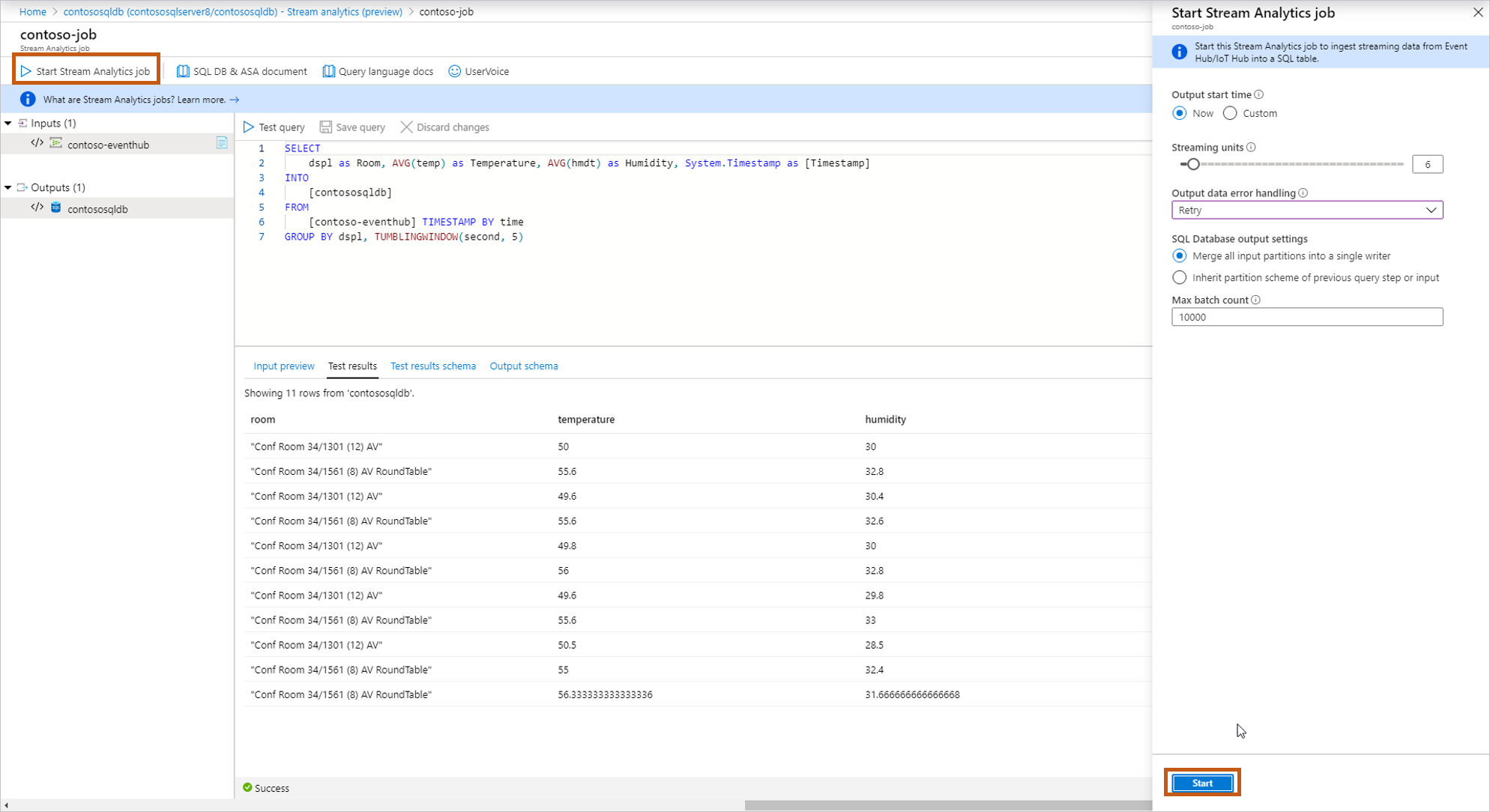

После завершения разработки и тестирования запроса выберите Save query (Сохранить запрос). Нажмите Start Stream Analytics job (Запустить задание Stream Analytics), чтобы начать прием преобразованных данных в таблицу SQL. После заполнения следующих полей запустите задание.

Output start time (Время начала вывода): определяет время первого вывода задания.

- Now (Сейчас): задание начнется сейчас и будет обрабатывать новые входящие данные.

- Custom (Настраиваемое): задание будет запущено, но будет обрабатывать данные с определенного момента времени (который может быть в прошлом или будущем). Дополнительные сведения см. в разделе Запуск задания Azure Stream Analytics.

Streaming units (Единицы потоковой передачи): использование Azure Stream Analytics тарифицируется на основе количества единиц потоковой передачи, необходимых для обработки данных в службе. Дополнительные сведения см. на странице цен на Azure Stream Analytics.

Обработка ошибок с выходными данными

- Retry (Повторить): когда происходит ошибка, Azure Stream Analytics бесконечно повторяет попытку записи события, пока запись не будет выполнена. Время ожидания для повторных попыток не задано. В конечном итоге обработку всех последующих событий блокирует событие, которое Azure Stream Analytics безуспешно пытается записать. Это политика обработки ошибок вывода по умолчанию.

- Drop (Удалить): Azure Stream Analytics будет удалять все выходные события, вызывающее ошибку преобразования данных. Восстановить удаленные события для повторной обработки позже невозможно. Для всех временных ошибок (например, сбоев сети) выполняется повторная попытка независимо от конфигурации политики обработки ошибок вывода.

SQL Database output settings (Параметры вывода базы данных SQL): это свойство позволяет наследовать схему разделов, используемую на предыдущем шаге запроса, для включения топологии полной параллельной обработки с несколькими модулями записи для таблицы. Дополнительные сведения см. в статье Вывод данных Azure Stream Analytics в базу данных SQL Azure.

Max batch count (максимальное число пакетов): рекомендованное максимальное число записей, отправляемых с каждой транзакцией массовой вставки.

Дополнительные сведения об обработке ошибок вывода см. в разделе политик ошибок вывода в Azure Stream Analytics.

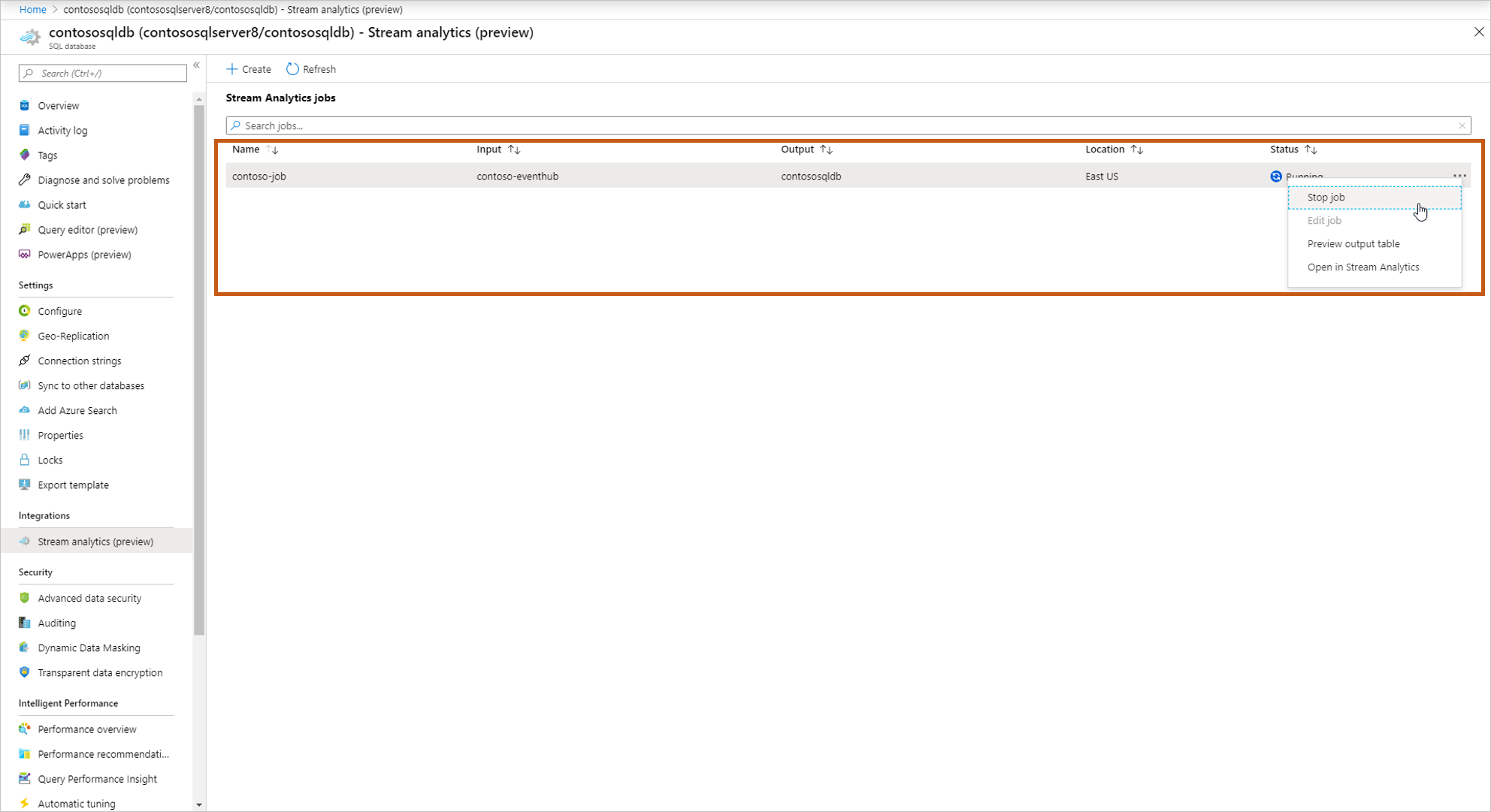

После запуска задания вы увидите в списке запущенное задание сможете выполнить следующие действия.

Start/stop the job (Запустить или остановить задание): если задание запущено, вы можете его остановить. Если задание остановлено, можно запустить его.

Edit job (Изменить задание): вы можете изменить запрос. Если вы хотите внести дополнительные изменения в задание, добавьте дополнительные входные и выходные данные, а затем откройте задание в Stream Analytics. Параметр "Изменить" отключен при выполнении задания.

Preview output table (Предварительный просмотр таблицы вывода): вы можете просмотреть таблицу в редакторе запросов SQL.

Open in Stream Analytics (Открыть в Stream Analytics): открывает задание в Stream Analytics для просмотра мониторинга, сведений об отладке задания.

Следующие шаги

Обратная связь

Ожидается в ближайшее время: в течение 2024 года мы постепенно откажемся от GitHub Issues как механизма обратной связи для контента и заменим его новой системой обратной связи. Дополнительные сведения см. в разделе https://aka.ms/ContentUserFeedback.

Отправить и просмотреть отзыв по