Руководство. Создание и использование службы Apache Kafka для разработки

Статья 06/23/2023

Участники: 5

Обратная связь

В этой статье

Приложения контейнеров Azure позволяют подключаться к службам разработки и рабочей среды, чтобы обеспечить широкий спектр функциональных возможностей приложений.

В этом руководстве описано, как создать и использовать службу Apache Kafka для разработки.

Команды Azure CLI и фрагменты шаблонов Bicep представлены в этом руководстве. При использовании Bicep можно добавить все фрагменты в один файл Bicep и развернуть шаблон одновременно .

Создание среды приложений-контейнеров для развертывания службы и приложения-контейнера

Создание службы Apache Kafka

Настройка приложения командной строки для использования службы Apache Kafka для разработки

Развертывание приложения kafka-ui для просмотра данных приложенияКомпиляция окончательного шаблона bicep для развертывания всех ресурсов с помощью согласованного и прогнозируемого развертывания шаблона

azd Использование шаблона для развертывания одной команды всех ресурсов

Необходимые компоненты

Примечание.

Для развертывания одной команды перейдите к последнему azdшагу шаблона.

Настройка

Определите переменные для общих значений.

RESOURCE_GROUP="kafka-dev"

LOCATION="northcentralus"

ENVIRONMENT="aca-env"

KAFKA_SVC="kafka01"

KAFKA_CLI_APP="kafka-cli-app"

KAFKA_UI_APP="kafka-ui-app"

Следующие переменные позволяют использовать ИНТЕРФЕЙС командной строки для развертывания шаблона Bicep.

RESOURCE_GROUP="kafka-dev"

LOCATION="northcentralus"

Для Bicep сначала создайте файл с именем kafka-dev.bicep, а затем добавьте параметры со следующими значениями по умолчанию.

targetScope = 'resourceGroup'

param location string = resourceGroup().location

param appEnvironmentName string = 'aca-env'

param kafkaSvcName string = 'kafka01'

param kafkaCliAppName string = 'kafka-cli-app'

param kafkaUiAppName string = 'kafka-ui'

При развертывании шаблона bicep на любом этапе можно использовать az deployment group create команду.

az deployment group create -g $RESOURCE_GROUP \

--query 'properties.outputs.*.value' \

--template-file kafka-dev.bicep

Определите исходные переменные.

AZURE_ENV_NAME="azd-kafka-dev"

LOCATION="northcentralus"

Используйте значения для инициализации минимального azd шаблона.

azd init \

--environment "$AZURE_ENV_NAME" \

--location "$LOCATION" \

--no-prompt

Примечание.

AZURE_ENV_NAME отличается от имени среды приложения-контейнера. В этом контексте AZURE_ENV_NAME используется azd для всех ресурсов в шаблоне. К этим ресурсам относятся ресурсы, не связанные с приложениями-контейнерами. Вы создаете другое имя среды "Приложения контейнеров".

Затем создайте infra/main.bicep и определите параметры для последующего использования.

param appEnvironmentName string = 'aca-env'

param kafkaSvcName string = 'kafka01'

param kafkaCliAppName string = 'kafka-cli-app'

param kafkaUiAppName string = 'kafka-ui'

Вход в Azure.

az login

Обновите интерфейс командной строки до последней версии.

az upgrade

Обновите Bicep до последней версии.

az bicep upgrade

Добавьте расширение th containerapp .

az extension add --name containerapp --upgrade

Зарегистрируйте необходимые пространства имен.

az provider register --namespace Microsoft.App

az provider register --namespace Microsoft.OperationalInsights

Создание среды приложений-контейнеров

Создать группу ресурсов.

az group create \

--name "$RESOURCE_GROUP" \

--location "$LOCATION"

az group create \

--name "$RESOURCE_GROUP" \

--location "$LOCATION"

Для управления группами azdресурсов в ней не требуется специальная настройка. Команда azd получает группу ресурсов из AZURE_ENV_NAME/--environment значения.

С помощью команды можно протестировать минимальный up шаблон.

azd up

При выполнении этой команды создается пустая группа ресурсов.

Создайте среду приложений-контейнеров.

az containerapp env create \

--name "$ENVIRONMENT" \

--resource-group "$RESOURCE_GROUP" \

--location "$LOCATION"

Добавьте в файл следующие значения kafka-dev.bicep .

resource appEnvironment 'Microsoft.App/managedEnvironments@2023-04-01-preview' = {

name: appEnvironmentName

location: location

properties: {

appLogsConfiguration: {

destination: 'azure-monitor'

}

}

}

Azure CLI автоматически создает рабочую область Log Analytics для каждой среды. Чтобы создать рабочую область с помощью шаблона Bicep, вы явно объявляете среду и связываете ее с ним в шаблоне. Этот шаг делает развертывание более стабильным, даже если по стоимости немного подробно.

Добавьте в среду следующие значения.

resource logAnalytics 'Microsoft.OperationalInsights/workspaces@2022-10-01' = {

name: '${appEnvironmentName}-log-analytics'

location: location

properties: {

sku: {

name: 'PerGB2018'

}

}

}

resource appEnvironment 'Microsoft.App/managedEnvironments@2023-04-01-preview' = {

name: appEnvironmentName

location: location

properties: {

appLogsConfiguration: {

destination: 'log-analytics'

logAnalyticsConfiguration: {

customerId: logAnalytics.properties.customerId

sharedKey: logAnalytics.listKeys().primarySharedKey

}

}

}

}

Шаблоны, используемые с azd помощью модулей bicep.

Создайте папку ./infra/core/host/container-apps-environment.bicep с именем./infra/core/host, а затем создайте модуль со следующим содержимым.

param name string

param location string = resourceGroup().location

param tags object = {}

resource logAnalytics 'Microsoft.OperationalInsights/workspaces@2022-10-01' = {

name: '${name}-log-analytics'

location: location

tags: tags

properties: {

sku: {

name: 'PerGB2018'

}

}

}

resource appEnvironment 'Microsoft.App/managedEnvironments@2023-04-01-preview' = {

name: name

location: location

tags: tags

properties: {

appLogsConfiguration: {

destination: 'log-analytics'

logAnalyticsConfiguration: {

customerId: logAnalytics.properties.customerId

sharedKey: logAnalytics.listKeys().primarySharedKey

}

}

}

}

output appEnvironmentId string = appEnvironment.id

./infra/main.bicep В файле загрузите модуль с помощью следующих значений.

module appEnvironment './core/host/container-apps-environment.bicep' = {

name: 'appEnvironment'

scope: rg

params: {

name: appEnvironmentName

location: location

tags: tags

}

}

Выполните команду azd up, чтобы развернуть шаблон.

Создание службы Apache Kafka

Создайте службу Apache Kafka.

ENVIRONMENT_ID=$(az containerapp env show \

--name "$ENVIRONMENT" \

--resource-group "$RESOURCE_GROUP" \

--output tsv \

--query id)

Добавьте следующие значения kafka-dev.bicepв .

resource kafka 'Microsoft.App/containerApps@2023-04-01-preview' = {

name: kafkaSvcName

location: location

properties: {

environmentId: appEnvironment.id

configuration: {

service: {

type: 'kafka'

}

}

}

}

output kafkaLogs string = 'az containerapp logs show -n ${kafka.name} -g ${resourceGroup().name} --follow --tail 30'

./infra/core/host/container-app-service.bicep Создайте файл модуля со следующим содержимым.

param name string

param location string = resourceGroup().location

param tags object = {}

param environmentId string

param serviceType string

resource service 'Microsoft.App/containerApps@2023-04-01-preview' = {

name: name

location: location

tags: tags

properties: {

environmentId: environmentId

configuration: {

service: {

type: serviceType

}

}

}

}

output serviceId string = service.id

Затем обновите файл модуля с помощью следующего ./infra/main.bicep объявления.

module kafka './core/host/container-app-service.bicep' = {

name: 'kafka'

scope: rg

params: {

name: kafkaSvcName

location: location

tags: tags

environmentId: appEnvironment.outputs.appEnvironmentId

serviceType: 'kafka'

}

}

Разверните шаблон .

az containerapp add-on kafka create \

--name "$KAFKA_SVC" \

--resource-group "$RESOURCE_GROUP" \

--environment "$ENVIRONMENT"

az deployment group create -g $RESOURCE_GROUP \

--query 'properties.outputs.*.value' \

--template-file kafka-dev.bicep

Совет

Выходные данные kafkaLogs выводит команду CLI, чтобы просмотреть журналы kafka после завершения развертывания. Чтобы просмотреть журналы инициализации новой службы Kafka, выполните команду.

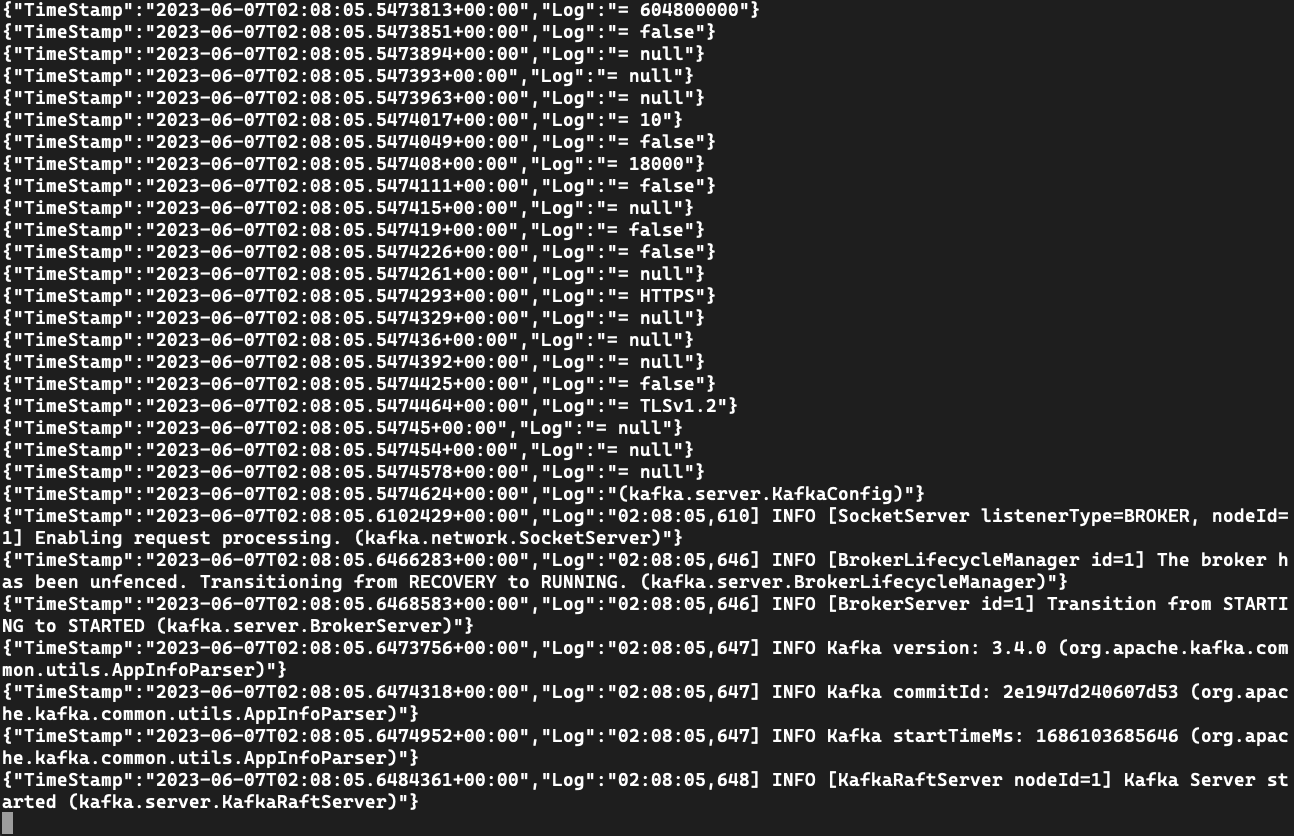

Просмотр выходных данных журнала из экземпляра Kafka

logs Используйте команду для просмотра сообщений журнала.

az containerapp logs show \

--name $KAFKA_SVC \

--resource-group $RESOURCE_GROUP \

--follow --tail 30

В предыдущем примере Bicep содержатся выходные данные для команды для просмотра журналов.

Например:

[

"az containerapp logs show -n kafka01 -g kafka-dev --follow --tail 30"

]

Если у вас нет команды, можно использовать имя службы для просмотра журналов с помощью интерфейса командной строки.

az containerapp logs show \

--name $KAFKA_SVC \

--resource-group $RESOURCE_GROUP \

--follow --tail 30

logs Используйте команду для просмотра сообщений журнала.

az containerapp logs show \

--name kafka01 \

--resource-group $RESOURCE_GROUP \

--follow --tail 30

Создание приложения для тестирования службы

При создании приложения вы настроите его для использования ./kafka-topics.sh./kafka-console-producer.shи kafka-console-consumer.sh подключитесь к экземпляру Kafka.

kafka-cli-app Создайте приложение, которое привязывается к службе Kafka.

az containerapp create \

--name "$KAFKA_CLI_APP" \

--image mcr.microsoft.com/k8se/services/kafka:3.4 \

--bind "$KAFKA_SVC" \

--environment "$ENVIRONMENT" \

--resource-group "$RESOURCE_GROUP" \

--min-replicas 1 \

--max-replicas 1 \

--command "/bin/sleep" "infinity"

Добавьте следующие значения kafka-dev.bicep.

resource kafkaCli 'Microsoft.App/containerApps@2023-04-01-preview' = {

name: kafkaCliAppName

location: location

properties: {

environmentId: appEnvironment.id

template: {

serviceBinds: [

{

serviceId: kafka.id

}

]

containers: [

{

name: 'kafka-cli'

image: 'mcr.microsoft.com/k8se/services/kafka:3.4'

command: [ '/bin/sleep', 'infinity' ]

}

]

scale: {

minReplicas: 1

maxReplicas: 1

}

}

}

}

output kafkaCliExec string = 'az containerapp exec -n ${kafkaCli.name} -g ${resourceGroup().name} --command /bin/bash'

Совет

Выходные данные kafkaCliExec выводит команду CLI, вы можете выполнить, чтобы убедиться, что приложение развернуто правильно.

Создайте модуль в разделе ./infra/core/host/container-app.bicep и добавьте следующие значения.

param name string

param location string = resourceGroup().location

param tags object = {}

param environmentId string

param serviceId string = ''

param containerName string

param containerImage string

param containerCommands array = []

param containerArgs array = []

param minReplicas int

param maxReplicas int

param targetPort int = 0

param externalIngress bool = false

resource app 'Microsoft.App/containerApps@2023-04-01-preview' = {

name: name

location: location

tags: tags

properties: {

environmentId: environmentId

configuration: {

ingress: targetPort > 0 ? {

targetPort: targetPort

external: externalIngress

} : null

}

template: {

serviceBinds: !empty(serviceId) ? [

{

serviceId: serviceId

}

] : null

containers: [

{

name: containerName

image: containerImage

command: !empty(containerCommands) ? containerCommands : null

args: !empty(containerArgs) ? containerArgs : null

}

]

scale: {

minReplicas: minReplicas

maxReplicas: maxReplicas

}

}

}

}

Теперь используйте модуль, ./infra/main.bicep добавив следующие значения.

module kafkaCli './core/host/container-app.bicep' = {

name: 'kafkaCli'

scope: rg

params: {

name: kafkaCliAppName

location: location

tags: tags

environmentId: appEnvironment.outputs.appEnvironmentId

serviceId: kafka.outputs.serviceId

containerImage: 'mcr.microsoft.com/k8se/services/kafka:3.4'

containerName: 'kafka-cli'

maxReplicas: 1

minReplicas: 1

containerCommands: [ '/bin/sleep', 'infinity' ]

}

}

Разверните шаблон с azd upпомощью .

azd up

Выполните команду CLI exec , чтобы подключиться к тестовом приложению.

az containerapp exec \

--name $KAFKA_CLI_APP \

--resource-group $RESOURCE_GROUP \

--command /bin/bash

В предыдущем примере Bicep содержатся выходные данные, показывающие, как запустить приложение.

Например:

[

"az containerapp logs show -n kafka01 -g kafka-dev --follow --tail 30",

"az containerapp exec -n kafka-cli-app -g kafka-dev --command /bin/bash"

]

Если у вас нет команды, можно использовать имя приложения для запуска приложения с помощью exec команды.

az containerapp exec \

--name $KAFKA_CLI_APP \

--resource-group $RESOURCE_GROUP \

--command /bin/bash

az containerapp exec \

--name kafka-cli-app \

--resource-group $RESOURCE_GROUP \

--command /bin/bash

При использовании --bind или serviceBinds в тестовом приложении сведения о подключении внедряются в среду приложения. После подключения к тестовом контейнеру можно проверить значения с помощью env команды.

env | grep "^KAFKA_"

KAFKA_SECURITYPROTOCOL=SASL_PLAINTEXT

KAFKA_BOOTSTRAPSERVER=kafka01:9092

KAFKA_HOME=/opt/kafka

KAFKA_PROPERTIES_SASL_JAAS_CONFIG=org.apache.kafka.common.security.plain.PlainLoginModule required username="kafka-user" password="7dw..." user_kafka-user="7dw..." ;

KAFKA_BOOTSTRAP_SERVERS=kafka01:9092

KAFKA_SASLUSERNAME=kafka-user

KAFKA_SASL_USER=kafka-user

KAFKA_VERSION=3.4.0

KAFKA_SECURITY_PROTOCOL=SASL_PLAINTEXT

KAFKA_SASL_PASSWORD=7dw...

KAFKA_SASLPASSWORD=7dw...

KAFKA_SASL_MECHANISM=PLAIN

KAFKA_SASLMECHANISM=PLAIN

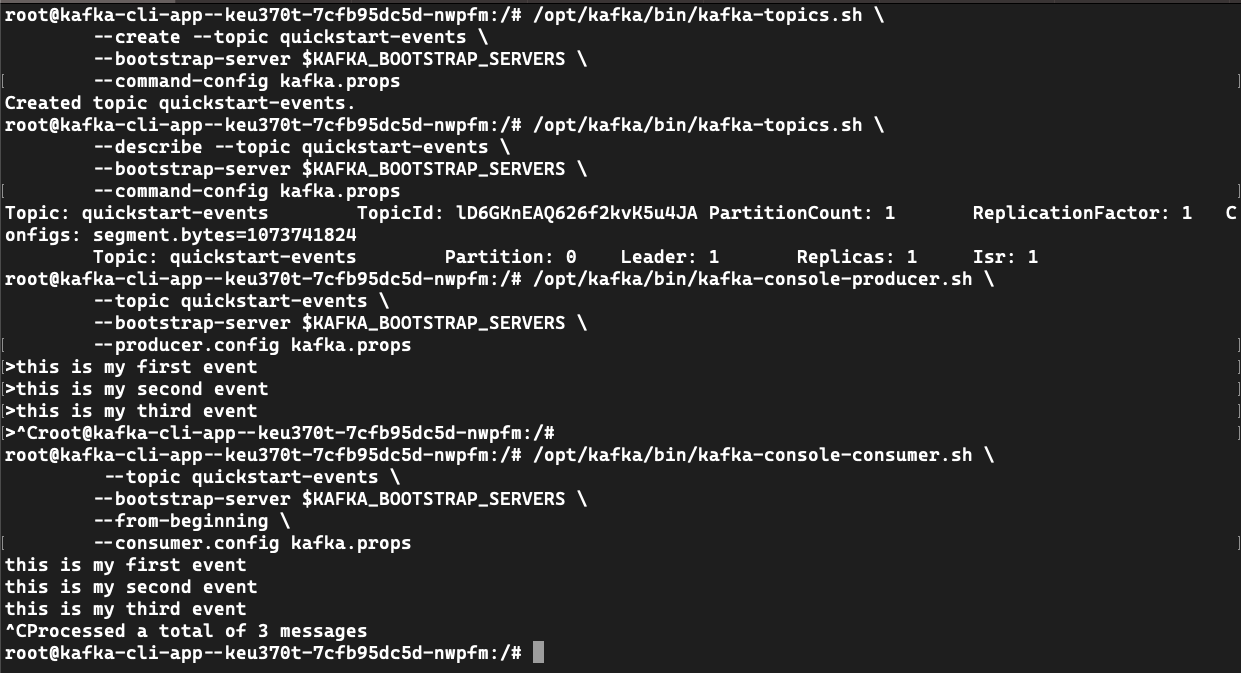

Используется kafka-topics.sh для создания раздела событий.

Создайте файл kafka.props .

echo "security.protocol=$KAFKA_SECURITY_PROTOCOL" >> kafka.props && \

echo "sasl.mechanism=$KAFKA_SASL_MECHANISM" >> kafka.props && \

echo "sasl.jaas.config=$KAFKA_PROPERTIES_SASL_JAAS_CONFIG" >> kafka.props

quickstart-events Создайте раздел события.

/opt/kafka/bin/kafka-topics.sh \

--create --topic quickstart-events \

--bootstrap-server $KAFKA_BOOTSTRAP_SERVERS \

--command-config kafka.props

# Created topic quickstart-events.

/opt/kafka/bin/kafka-topics.sh \

--describe --topic quickstart-events \

--bootstrap-server $KAFKA_BOOTSTRAP_SERVERS \

--command-config kafka.props

# Topic: quickstart-events TopicId: lCkTKmvZSgSUCHozhhvz1Q PartitionCount: 1 ReplicationFactor: 1 Configs: segment.bytes=1073741824

# Topic: quickstart-events Partition: 0 Leader: 1 Replicas: 1 Isr: 1

Используется kafka-console-producer.sh для записи событий в раздел.

/opt/kafka/bin/kafka-console-producer.sh \

--topic quickstart-events \

--bootstrap-server $KAFKA_BOOTSTRAP_SERVERS \

--producer.config kafka.props

> this is my first event

> this is my second event

> this is my third event

> CTRL-C

Примечание.

В командной строке вы записываете ./kafka-console-producer.sh события с >помощью . Напишите некоторые события, как показано ниже, а затем нажмите CTRL-C на выход.

Используется kafka-console-consumer.sh для чтения событий из раздела.

/opt/kafka/bin/kafka-console-consumer.sh \

--topic quickstart-events \

--bootstrap-server $KAFKA_BOOTSTRAP_SERVERS \

--from-beginning \

--consumer.config kafka.props

# this is my first event

# this is my second event

# this is my third event

Использование службы разработки с существующим приложением

Если у вас уже есть приложение, использующее Apache Kafka, можно изменить способ загрузки сведений о подключении.

Сначала создайте следующие переменные среды.

KAFKA_HOME=/opt/kafka

KAFKA_PROPERTIES_SASL_JAAS_CONFIG=org.apache.kafka.common.security.plain.PlainLoginModule required username="kafka-user" password="7dw..." user_kafka-user="7dw..." ;

KAFKA_BOOTSTRAP_SERVERS=kafka01:9092

KAFKA_SASL_USER=kafka-user

KAFKA_VERSION=3.4.0

KAFKA_SECURITY_PROTOCOL=SASL_PLAINTEXT

KAFKA_SASL_PASSWORD=7dw...

KAFKA_SASL_MECHANISM=PLAIN

С помощью интерфейса командной строки (или Bicep) можно обновить приложение, чтобы добавить --bind $KAFKA_SVC его для использования службы разработки.

Привязка к службе разработки

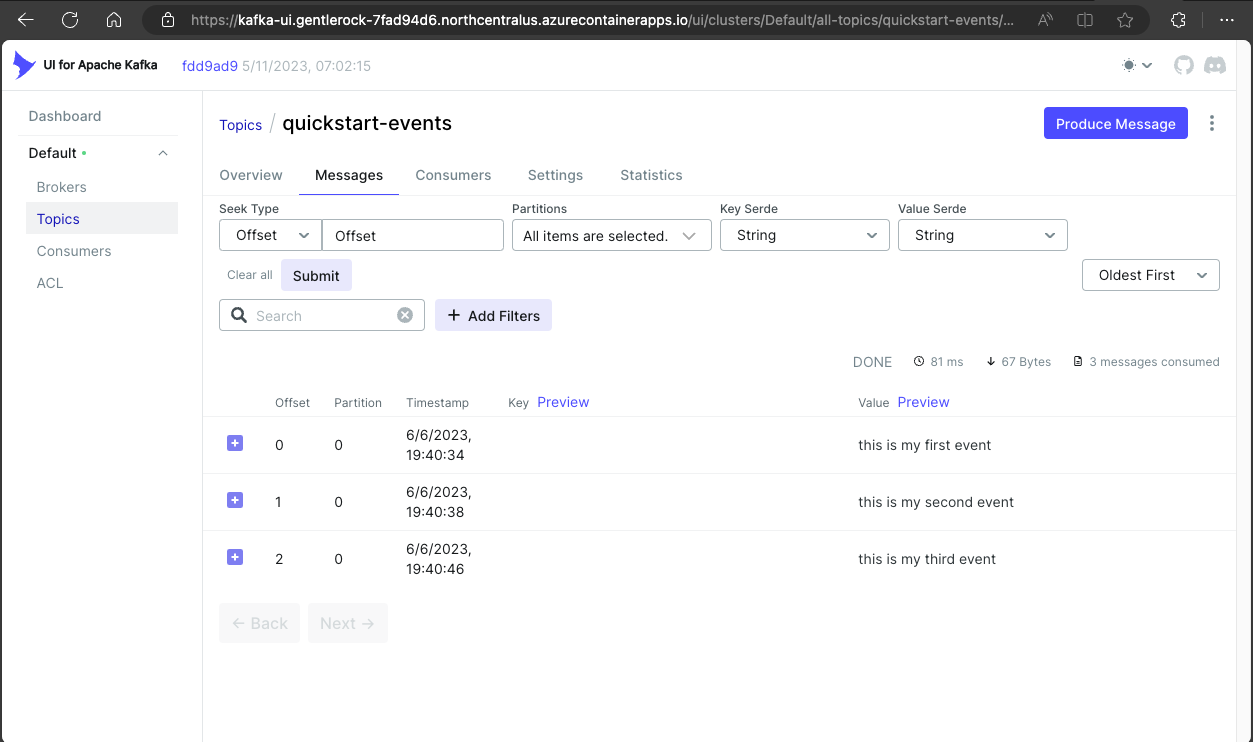

Разверните пользовательский интерфейс kafka для просмотра экземпляра Kafka и управления им.

См. пример Bicep или azd Bicep.

resource kafkaUi 'Microsoft.App/containerApps@2023-04-01-preview' = {

name: kafkaUiAppName

location: location

properties: {

environmentId: appEnvironment.id

configuration: {

ingress: {

external: true

targetPort: 8080

}

}

template: {

serviceBinds: [

{

serviceId: kafka.id

name: 'kafka'

}

]

containers: [

{

name: 'kafka-ui'

image: 'docker.io/provectuslabs/kafka-ui:latest'

command: [

'/bin/sh'

]

args: [

'-c'

'''export KAFKA_CLUSTERS_0_BOOTSTRAPSERVERS="$KAFKA_BOOTSTRAP_SERVERS" && \

export KAFKA_CLUSTERS_0_PROPERTIES_SASL_JAAS_CONFIG="$KAFKA_PROPERTIES_SASL_JAAS_CONFIG" && \

export KAFKA_CLUSTERS_0_PROPERTIES_SASL_MECHANISM="$KAFKA_SASL_MECHANISM" && \

export KAFKA_CLUSTERS_0_PROPERTIES_SECURITY_PROTOCOL="$KAFKA_SECURITY_PROTOCOL" && \

java $JAVA_OPTS -jar kafka-ui-api.jar'''

]

resources: {

cpu: json('1.0')

memory: '2.0Gi'

}

}

]

}

}

}

output kafkaUiUrl string = 'https://${kafkaUi.properties.configuration.ingress.fqdn}'

Команда Bicep возвращает URL-адрес. Скопируйте этот URL-адрес в браузер, чтобы посетить развернутый сайт.

Обновите ./infra/main.bicep следующие значения.

module kafkaUi './core/host/container-app.bicep' = {

name: 'kafka-ui'

scope: rg

params: {

name: kafkaUiAppName

location: location

tags: tags

environmentId: appEnvironment.outputs.appEnvironmentId

serviceId: kafka.outputs.serviceId

containerImage: 'docker.io/provectuslabs/kafka-ui:latest'

containerName: 'kafka-ui'

maxReplicas: 1

minReplicas: 1

containerCommands: [ '/bin/sh' ]

containerArgs: [

'-c'

'''export KAFKA_CLUSTERS_0_BOOTSTRAPSERVERS="$KAFKA_BOOTSTRAP_SERVERS" && \

export KAFKA_CLUSTERS_0_PROPERTIES_SASL_JAAS_CONFIG="$KAFKA_PROPERTIES_SASL_JAAS_CONFIG" && \

export KAFKA_CLUSTERS_0_PROPERTIES_SASL_MECHANISM="$KAFKA_SASL_MECHANISM" && \

export KAFKA_CLUSTERS_0_PROPERTIES_SECURITY_PROTOCOL="$KAFKA_SECURITY_PROTOCOL" && \

java $JAVA_OPTS -jar kafka-ui-api.jar'''

]

targetPort: 8080

externalIngress: true

}

}

Разверните шаблон с azd upпомощью .

azd up

Развертывание всех ресурсов

Используйте следующие примеры, чтобы одновременно развернуть все ресурсы.

Bicep

Следующий шаблон Bicep содержит все ресурсы в этом руководстве.

Файл можно создать kafka-dev.bicep с этим содержимым.

targetScope = 'resourceGroup'

param location string = resourceGroup().location

param appEnvironmentName string = 'aca-env'

param kafkaSvcName string = 'kafka01'

param kafkaCliAppName string = 'kafka-cli-app'

param kafkaUiAppName string = 'kafka-ui'

resource logAnalytics 'Microsoft.OperationalInsights/workspaces@2022-10-01' = {

name: '${appEnvironmentName}-log-analytics'

location: location

properties: {

sku: {

name: 'PerGB2018'

}

}

}

resource appEnvironment 'Microsoft.App/managedEnvironments@2023-04-01-preview' = {

name: appEnvironmentName

location: location

properties: {

appLogsConfiguration: {

destination: 'log-analytics'

logAnalyticsConfiguration: {

customerId: logAnalytics.properties.customerId

sharedKey: logAnalytics.listKeys().primarySharedKey

}

}

}

}

resource kafka 'Microsoft.App/containerApps@2023-04-01-preview' = {

name: kafkaSvcName

location: location

properties: {

environmentId: appEnvironment.id

configuration: {

service: {

type: 'kafka'

}

}

}

}

resource kafkaCli 'Microsoft.App/containerApps@2023-04-01-preview' = {

name: kafkaCliAppName

location: location

properties: {

environmentId: appEnvironment.id

template: {

serviceBinds: [

{

serviceId: kafka.id

}

]

containers: [

{

name: 'kafka-cli'

image: 'mcr.microsoft.com/k8se/services/kafka:3.4'

command: [ '/bin/sleep', 'infinity' ]

}

]

scale: {

minReplicas: 1

maxReplicas: 1

}

}

}

}

resource kafkaUi 'Microsoft.App/containerApps@2023-04-01-preview' = {

name: kafkaUiAppName

location: location

properties: {

environmentId: appEnvironment.id

configuration: {

ingress: {

external: true

targetPort: 8080

}

}

template: {

serviceBinds: [

{

serviceId: kafka.id

name: 'kafka'

}

]

containers: [

{

name: 'kafka-ui'

image: 'docker.io/provectuslabs/kafka-ui:latest'

command: [

'/bin/sh'

]

args: [

'-c'

'''export KAFKA_CLUSTERS_0_BOOTSTRAPSERVERS="$KAFKA_BOOTSTRAP_SERVERS" && \

export KAFKA_CLUSTERS_0_PROPERTIES_SASL_JAAS_CONFIG="$KAFKA_PROPERTIES_SASL_JAAS_CONFIG" && \

export KAFKA_CLUSTERS_0_PROPERTIES_SASL_MECHANISM="$KAFKA_SASL_MECHANISM" && \

export KAFKA_CLUSTERS_0_PROPERTIES_SECURITY_PROTOCOL="$KAFKA_SECURITY_PROTOCOL" && \

java $JAVA_OPTS -jar kafka-ui-api.jar'''

]

resources: {

cpu: json('1.0')

memory: '2.0Gi'

}

}

]

}

}

}

output kafkaUiUrl string = 'https://${kafkaUi.properties.configuration.ingress.fqdn}'

output kafkaCliExec string = 'az containerapp exec -n ${kafkaCli.name} -g ${resourceGroup().name} --command /bin/bash'

output kafkaLogs string = 'az containerapp logs show -n ${kafka.name} -g ${resourceGroup().name} --follow --tail 30'

Используйте Azure CLI для развертывания шаблона.

RESOURCE_GROUP="kafka-dev"

LOCATION="northcentralus"

az group create \

--name "$RESOURCE_GROUP" \

--location "$LOCATION"

az deployment group create -g $RESOURCE_GROUP \

--query 'properties.outputs.*.value' \

--template-file kafka-dev.bicep

Azure Developer CLI

Окончательный шаблон доступен на сайте GitHub.

Используется azd up для развертывания шаблона.

git clone https://github.com/Azure-Samples/aca-dev-service-kafka-azd

cd aca-dev-service-kafka-azd

azd up

Очистка ресурсов

После завершения выполните следующую команду, чтобы удалить группу ресурсов, содержащую ресурсы приложений контейнеров.

Внимание

Следующая команда удаляет указанную группу ресурсов и все ресурсы, содержащиеся в ней. Если в указанной группе ресурсов существуют другие ресурсы, кроме созданных для работы с этим учебником, они также будут удалены.

az group delete \

--resource-group $RESOURCE_GROUP