Потоки данных потоковой передачи (предварительная версия)

Организации хотят работать с данными, как это происходит, а не через несколько дней или недель. Видение Power BI просто: различия между пакетом, режимом реального времени и потоковой передачей должны исчезнуть. Пользователи должны иметь возможность работать со всеми данными сразу после его доступности.

Важно!

Потоки данных потоковой передачи удалены и больше не доступны. Azure Stream Analytics объединила функциональные возможности потоковых потоков данных. Дополнительные сведения об выходе потоковых потоковых данных см. в объявлении о выходе на пенсию.

Аналитики обычно нуждаются в технической помощи для работы с источниками данных потоковой передачи, подготовкой данных, сложными операциями на основе времени и визуализацией данных в режиме реального времени. ИТ-отделы часто полагаются на пользовательские системы, а также сочетание технологий от различных поставщиков для своевременного анализа данных. Без этой сложности они не могут предоставлять лицам, принимающим решения, информацию практически в режиме реального времени.

Потоки данных потоковой передачи позволяют авторам подключаться к, приему, перемешивать, модели и создавать отчеты на основе потоковой передачи в практически в реальном времени данных непосредственно в служба Power BI. Служба включает возможности перетаскивания без кода.

Вы можете смешивать и сопоставлять потоковые данные с пакетными данными, если требуется использовать пользовательский интерфейс, который включает представление схемы для простого преобразования данных. Окончательный элемент — это поток данных, который можно использовать в режиме реального времени для создания интерактивных отчетов практически в режиме реального времени. Все возможности визуализации данных в Power BI работают с потоковыми данными так же, как и с пакетными данными.

Пользователи могут выполнять такие операции подготовки данных, как соединения и фильтры. Они также могут выполнять агрегирование временных окон (например, переворачивающиеся, прыжки и сеансовые окна) для операций по группам.

Потоковая передача потоков данных в Power BI позволяет организациям:

- Принимать уверенные решения практически в режиме реального времени. Организации могут быть более гибкими и принимать значимые действия на основе самых актуальных аналитических сведений.

- Демократизация потоковых данных. Организации могут сделать данные более доступными и удобными для интерпретации с помощью решения без кода, и эта доступность сокращает ИТ-ресурсы.

- Ускорить анализ времени с помощью комплексного решения аналитики потоковой передачи с интегрированным хранилищем данных и бизнес-аналитикой.

Потоки данных потоковой передачи поддерживают directQuery и автоматическое обновление и обнаружение изменений страницы. Эта поддержка позволяет пользователям создавать отчеты, которые обновляются практически в реальном времени до каждой секунды с помощью любого визуального элемента, доступного в Power BI.

Requirements

Перед созданием первого потока потоковой передачи убедитесь, что выполнены все следующие требования:

Для создания и запуска потокового потока данных требуется рабочая область, которая является частью лицензииPremium для каждого пользователя (PPU).

Важно!

Если вы используете лицензию PPU и хотите, чтобы другие пользователи использовали отчеты, созданные с потоковыми потоками данных, которые обновляются в режиме реального времени, им также потребуется лицензия PPU. Затем они могут использовать отчеты с той же частотой обновления, которую вы настроили, если это обновление быстрее, чем каждые 30 минут.

Включите потоки данных для клиента. Дополнительные сведения см. в разделе "Включение потоков данных" в Power BI Premium.

Чтобы обеспечить работу потоковых потоковых потоков данных в емкости Premium, необходимо включить расширенный вычислительный модуль . Подсистема включена по умолчанию, но администраторы емкости Power BI могут отключить ее. В этом случае обратитесь к администратору, чтобы включить его.

Расширенный вычислительный модуль доступен только в классах Premium P или Embedded A3 и более крупных емкостях. Чтобы использовать потоки данных потоковой передачи, вам потребуется PPU, емкость premium P любого размера, внедренная A3 или более крупная емкость. Дополнительные сведения о номерах SKU уровня "Премиум" и их спецификациях см. в разделе "Емкость и номера SKU" в встроенной аналитике Power BI.

Чтобы создать отчеты, обновляемые в режиме реального времени, убедитесь, что администратор (емкость или Power BI для PPU) включил автоматическое обновление страницы. Кроме того, убедитесь, что администратор предоставил минимальный интервал обновления, соответствующий вашим потребностям. Дополнительные сведения см. в статье "Автоматическое обновление страницы" в Power BI.

Создание потокового потока данных

Поток потоковых данных, как его относительный поток данных, представляет собой коллекцию сущностей (таблиц), созданных и управляемых в рабочих областях в служба Power BI. Таблица — это набор полей, которые используются для хранения данных, как таблица в базе данных.

Таблицы потоковой передачи можно добавлять и изменять непосредственно из рабочей области, в которой был создан поток данных. Основное отличие от обычных потоков данных заключается в том, что вам не нужно беспокоиться об обновлениях или частоте. Из-за характера потоковых данных происходит непрерывный поток. Обновление является константой или бесконечной, если ее не остановить.

Примечание.

Для каждой рабочей области может быть только один тип потока данных. Если у вас уже есть обычный поток данных в рабочей области Premium, вы не сможете создать поток потоковых данных (и наоборот).

Чтобы создать поток данных потоковой передачи, выполните приведенные действия.

Откройте служба Power BI в браузере и выберите рабочую область с поддержкой Premium. (Потоки данных потоковой передачи, такие как обычные потоки данных, недоступны в Моя рабочая область.)

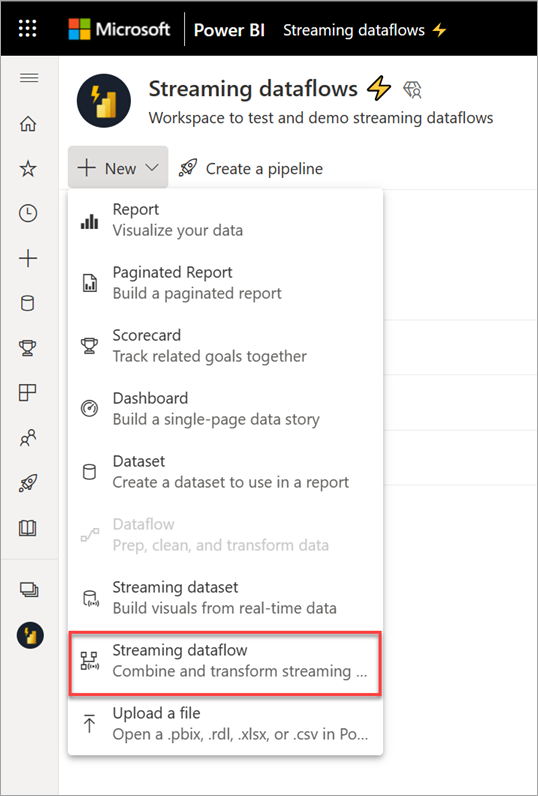

Выберите раскрывающееся меню "Создать" и выберите поток данных потоковой передачи.

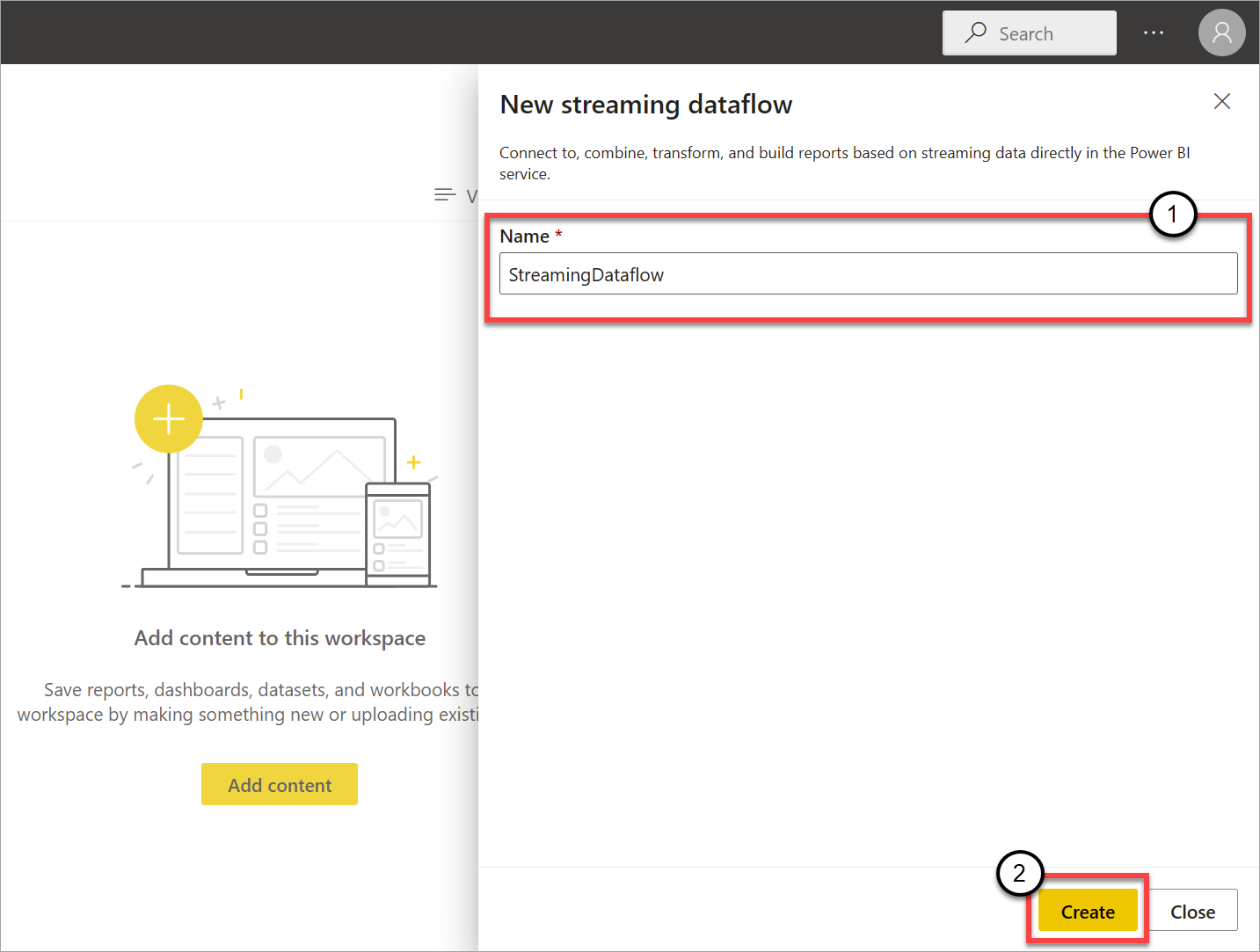

На открывающейся боковой панели необходимо указать поток данных потоковой передачи. Введите имя в поле "Имя " (1), а затем нажмите кнопку "Создать " (2).

Появится пустое представление схемы потоковых потоков данных.

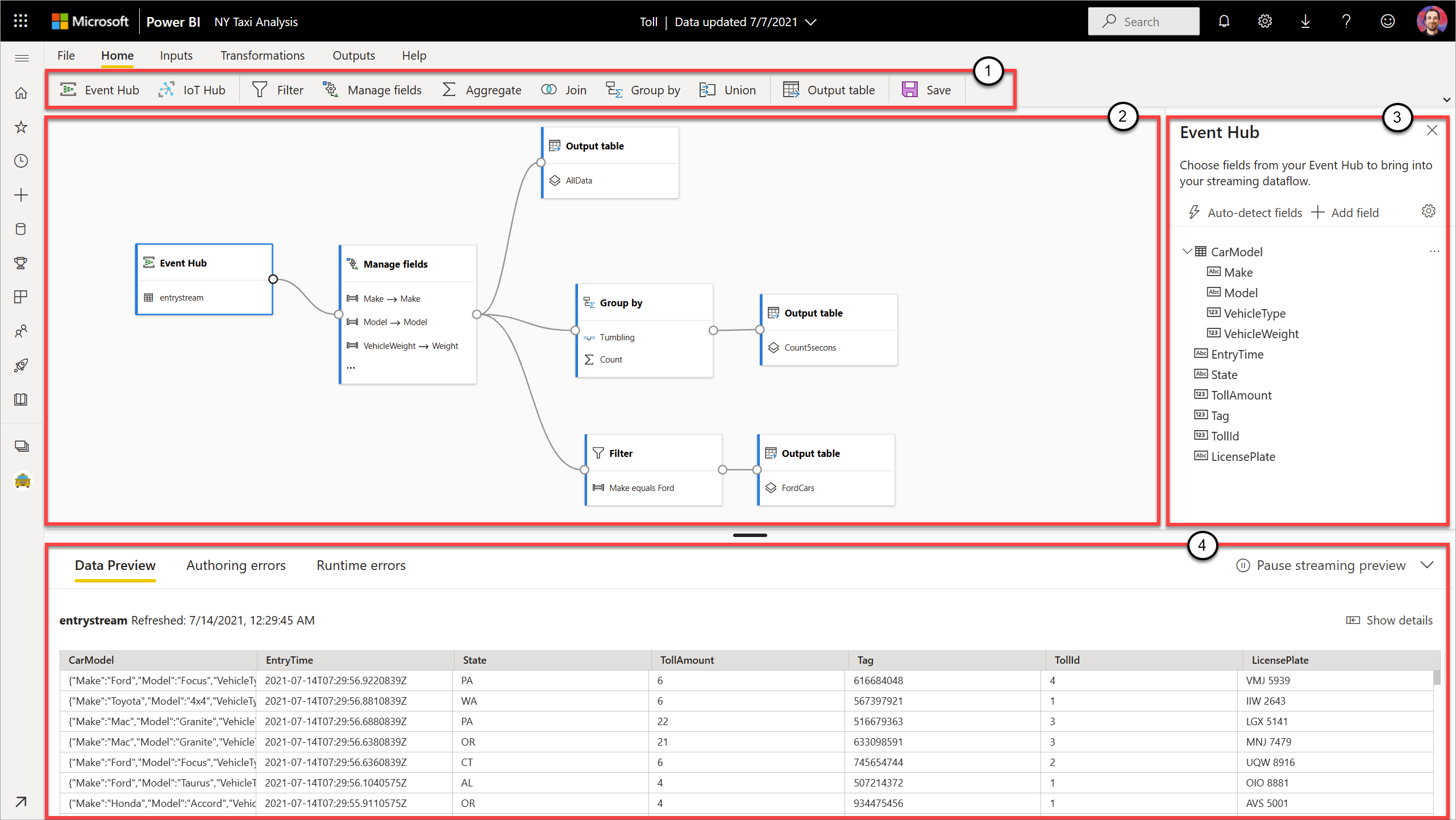

На следующем снимка экрана показан готовый поток данных. Он выделяет все разделы, доступные для разработки в пользовательском интерфейсе потокового потока данных.

Лента. На ленте разделы следуют порядку "классического" процесса аналитики: входные данные (также известные как источники данных), преобразования (операции потоковой передачи данных), выходные данные и кнопка, чтобы сохранить ход выполнения.

Представление схемы: это графическое представление потока данных, от входных данных до операций с выходными данными.

Боковая область: в зависимости от того, какой компонент вы выбираете в представлении диаграммы, вы можете изменить все входные, преобразования или выходные данные.

Вкладки для предварительного просмотра данных, ошибок разработки и ошибок среды выполнения. Для каждого карта показан предварительный просмотр данных показывает результаты этого шага (в режиме реального времени для входных данных и по запросу для преобразований и выходных данных).

В этом разделе также приводятся сведения об ошибках разработки или предупреждениях, которые могут возникнуть в потоках данных. При выборе каждой ошибки или предупреждения выбирается это преобразование. Кроме того, после запуска потока данных у вас есть доступ к ошибкам среды выполнения, таким как удаленные сообщения.

Вы всегда можете свести к минимуму этот раздел потоковых потоков данных, выбрав стрелку в правом верхнем углу.

Поток потоковых данных основан на трех основных компонентах: потоковых входных данных, преобразований и выходных данных. Вы можете иметь столько компонентов, сколько требуется, включая несколько входных данных, параллельные ветви с несколькими преобразованиями и несколькими выходными данными.

Добавление входных данных потоковой передачи

Чтобы добавить входные данные потоковой передачи, выберите значок на ленте и укажите сведения, необходимые на боковой панели, чтобы настроить его. По состоянию на июль 2021 г. предварительная версия потоковых потоков данных поддерживает Центры событий Azure и Центр Интернета вещей Azure в качестве входных данных.

Службы Центры событий Azure и Центр Интернета вещей Azure основаны на общей архитектуре для упрощения быстрого и масштабируемого приема и потребления событий. Центр Интернета вещей, в частности, предназначен для обмена данными в центре сообщений в обоих направлениях между приложением Интернета вещей и подключенными устройствами.

Центры событий Azure

Центры событий Azure — это платформа потоковой передачи больших данных и служба приема событий. Она может получать и обрабатывать миллионы событий в секунду. Данные, отправляемые в концентратор событий, можно преобразовать и сохранить с помощью любого поставщика аналитики в режиме реального времени или использовать пакетные адаптеры или адаптеры хранилища.

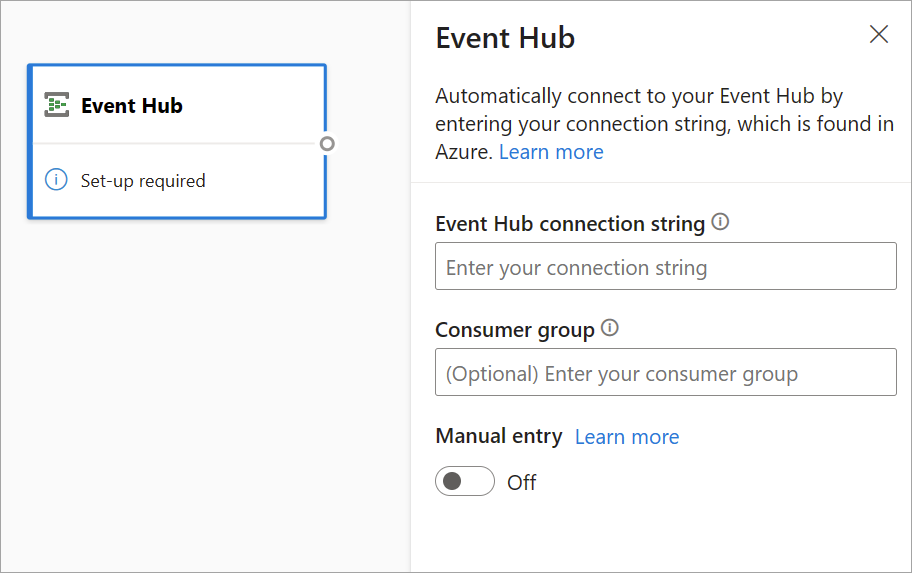

Чтобы настроить концентратор событий в качестве входных данных потоковой передачи, щелкните значок концентратора событий. В представлении схемы отображается карта, включая боковую панель для его конфигурации.

У вас есть возможность вставки строка подключения Центров событий. Потоки данных потоковой передачи заполняют все необходимые сведения, включая необязательную группу потребителей (которая по умолчанию $Default). Если вы хотите ввести все поля вручную, можно включить переключатель вручную, чтобы отобразить их. Дополнительные сведения см. в статье Получение строки подключения для Центров событий.

После настройки учетных данных Центров событий и выбора Подключение можно добавить поля вручную с помощью +Добавить поле, если вы знаете имена полей. Кроме того, вы можете автоматически обнаруживать поля и типы данных на основе образца входящих сообщений, выберите поля автоматического набора данных. При необходимости выбор значка шестеренки позволяет изменять учетные данные.

Когда потоки данных потоковой передачи обнаруживают поля, их можно увидеть в списке. В таблице предварительного просмотра данных также есть динамическая предварительная версия входящих сообщений в представлении схемы.

Вы всегда можете изменить имена полей или удалить или изменить тип данных, выбрав дополнительные параметры (...) рядом с каждым полем. Вы также можете развернуть, выбрать и изменить все вложенные поля из входящих сообщений, как показано на следующем рисунке.

Центр Интернета вещей Azure

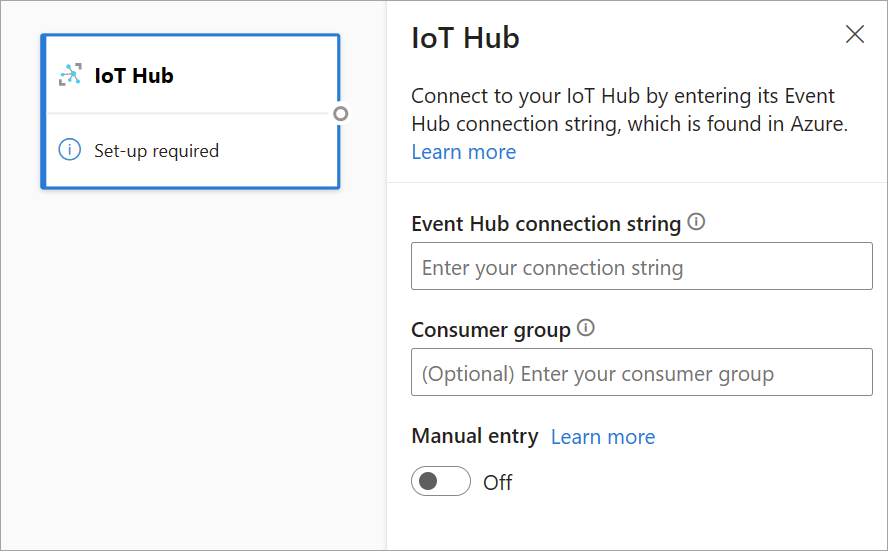

Центр Интернета вещей — это управляемая служба, размещенная в облаке. Он выступает в качестве центрального центра сообщений для обмена данными в обоих направлениях между приложением Интернета вещей и подключенными устройствами. Вы можете подключить миллионы устройств и их внутренние решения надежно и безопасно. Почти любое устройство может быть подключено к Центру Интернета вещей.

Центр Интернета вещей конфигурация похожа на конфигурацию Центров событий из-за их общей архитектуры. Но существуют некоторые различия, в том числе, где найти совместимые с Концентраторами событий строка подключения для встроенной конечной точки. Дополнительные сведения см. в статье "Чтение сообщений устройства в облако" из встроенной конечной точки.

После вставки строка подключения для встроенной конечной точки все функции для выбора, добавления, автоматического определения и редактирования полей, поступающих из Центр Интернета вещей, совпадают с значениями в Центрах событий. Вы также можете изменить учетные данные, выбрав значок шестеренки.

Совет

Если у вас есть доступ к Центрам событий или Центр Интернета вещей в портал Azure вашей организации, и вы хотите использовать его в качестве входных данных для потокового потока данных, вы можете найти строка подключения в следующих расположениях:

Для Центров событий:

- В разделе "Аналитика" выберите "Все центры событий служб>".

- Выберите "Сущности пространства имен>Центров событий" или "Центры событий", а затем выберите имя концентратора событий.

- В списке политик общего доступа выберите политику.

- Выберите "Копировать в буфер обмена" рядом с полем Подключение ion string-primary key.

Для Центр Интернета вещей:

- В разделе "Интернет вещей" выберите "Все службы> Центр Интернета вещей".

- Выберите центр Интернета вещей, к которому требуется подключиться, и выберите встроенные конечные точки.

- Выберите " Копировать в буфер обмена " рядом с конечной точкой, совместимой с Центрами событий.

При использовании потоковых данных из Центров событий или Центр Интернета вещей у вас есть доступ к следующим полям времени метаданных в потоке потоковых данных:

- EventProcessedUtcTime: дата и время обработки события.

- EventEnqueuedUtcTime: дата и время получения события.

Ни из этих полей не отображаются в предварительном просмотре входных данных. Необходимо добавить их вручную.

Хранилище BLOB-объектов

Хранилище BLOB-объектов Azure — это решение корпорации Майкрософт для хранения объектов в облаке. Хранилище BLOB-объектов оптимизировано для хранения огромных объемов неструктурированных данных. Неструктурированные данные — это данные, которые не соответствуют определенной модели данных или определению, например текстовых или двоичных данных.

Большие двоичные объекты Azure можно использовать в качестве потоковых или ссылочных входных данных. Большие двоичные объекты потоковой передачи проверка каждую секунду для обновлений. В отличие от потокового большого двоичного объекта, ссылка на большой двоичный объект загружается только в начале обновления. Это статические данные, которые не должны изменяться, и рекомендуемое ограничение для статических данных равно 50 МБ или меньше.

Power BI ожидает, что ссылки на большие двоичные объекты будут использоваться вместе с источниками потоковой передачи, например через JOIN. Таким образом, поток потоковых данных с ссылочным BLOB-объектом также должен иметь источник потоковой передачи.

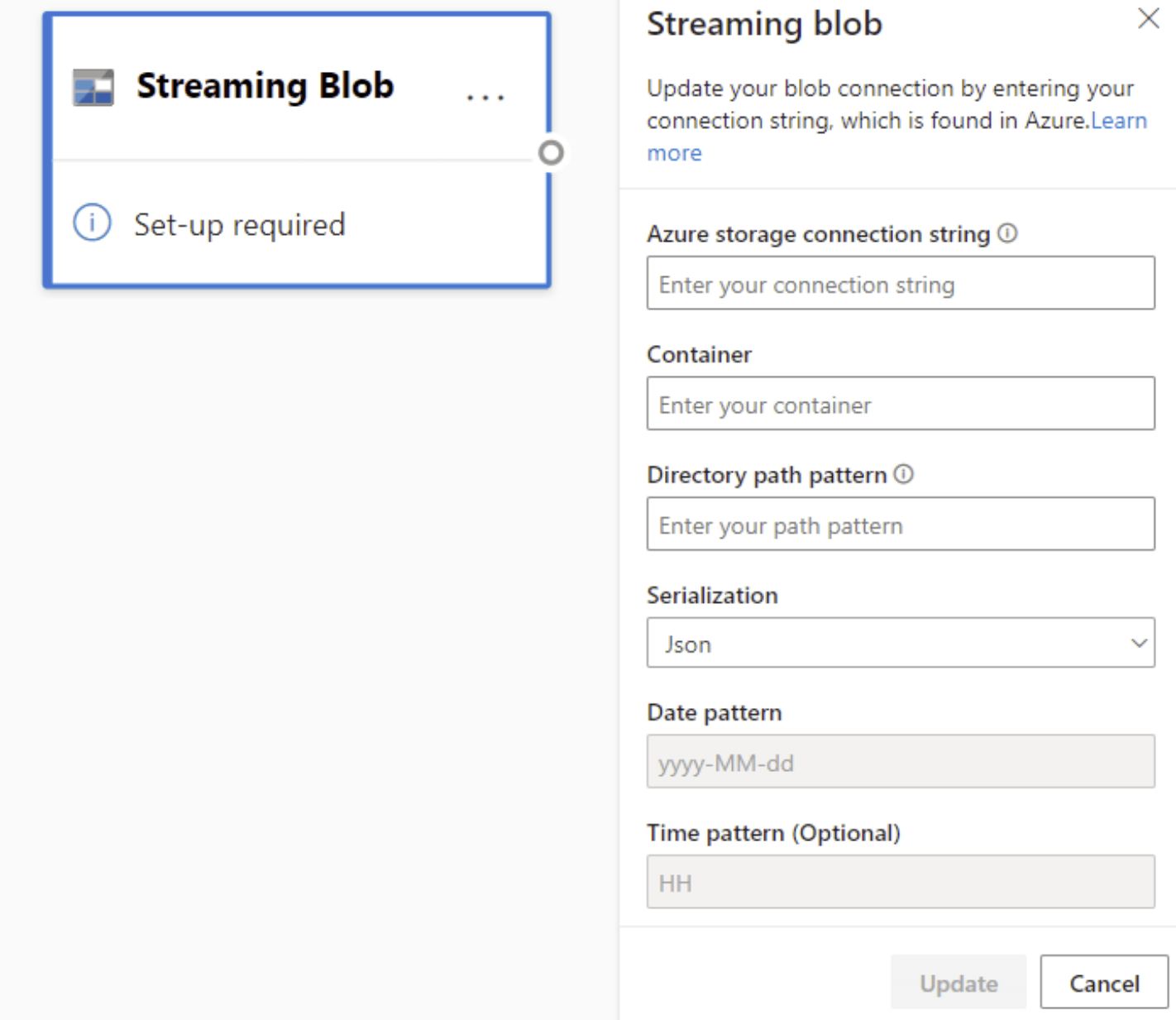

Конфигурация больших двоичных объектов Azure немного отличается от конфигурации Центры событий Azure узла. Чтобы найти строка подключения BLOB-объектов Azure, ознакомьтесь с разделом "Просмотр ключей доступа к учетной записи".

После ввода строка подключения БОЛЬШОго двоичного объекта необходимо указать имя контейнера. Кроме того, необходимо ввести шаблон пути в каталоге, чтобы получить доступ к файлам, которые необходимо задать в качестве источника для потока данных.

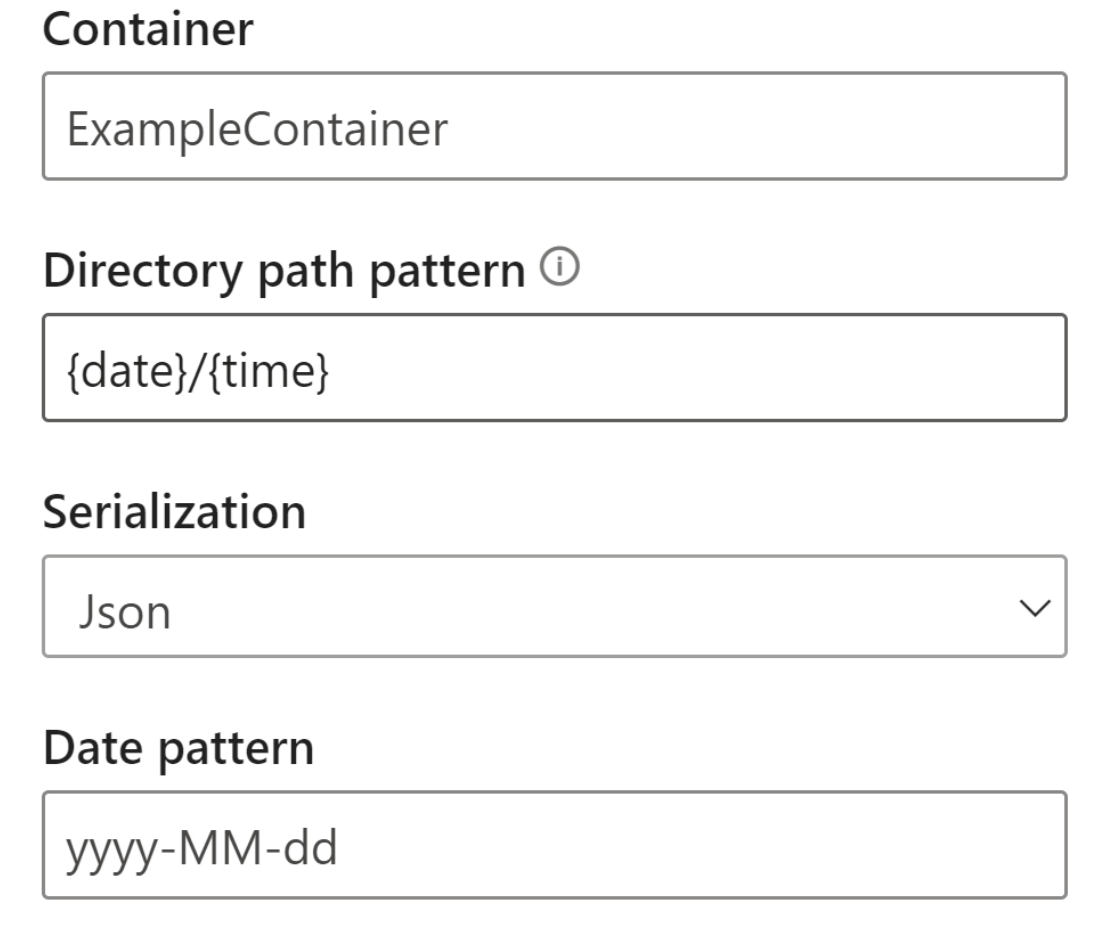

Для потоковой передачи больших двоичных объектов шаблон пути к каталогу должен представлять собой динамическое значение. Дата должна быть частью пути к файлу для большого двоичного объекта, на который ссылается {date}. Кроме того, звездочка (*) в шаблоне пути, например {date}/{time}/*.json, не поддерживается.

Например, если у вас есть большой двоичный объект ExampleContainer, в котором хранятся вложенные JSON-файлы, где первый уровень — дата создания, а второй — час создания (гггг-мм-дд/ч), то входные данные контейнера будут "ExampleContainer". Шаблон пути к каталогу будет "{date}/{time}", где можно изменить шаблон даты и времени.

После подключения большого двоичного объекта к конечной точке все функции для выбора, добавления, автоматического определения и редактирования полей, поступающих из BLOB-объектов Azure, совпадают с полями центров событий. Вы также можете изменить учетные данные, выбрав значок шестеренки.

Часто при работе с данными в режиме реального времени данные сжаты и идентификаторы используются для представления объекта. Возможный вариант использования больших двоичных объектов также может быть эталонным данным для источников потоковой передачи. Справочные данные позволяют присоединять статические данные к потоковой передаче данных для обогащения потоков для анализа. Краткий пример того, когда эта функция будет полезной, если бы вы устанавливали датчики в разных универмагах, чтобы оценить, сколько людей входят в магазин в определенное время. Обычно идентификатор датчика должен быть присоединен к статической таблице, чтобы указать, в каком магазине и в каком расположении датчика. Теперь с эталонными данными можно присоединить эти данные во время этапа приема, чтобы сделать его простым, чтобы увидеть, какое хранилище имеет самый высокий объем выходных данных пользователей.

Примечание.

Задание потоковых потоков данных извлекает данные из хранилища BLOB-объектов Azure или ADLS 2-го поколения, если файл BLOB-объектов доступен. В случае, если этот файл недоступен, применяется экспоненциально увеличивающаяся задержка с максимальным значением, равным 90 секундам.

Типы данных

Доступные типы данных для полей потоковых потоков данных:

- DateTime: поле даты и времени в формате ISO

- Float: Десятичное число

- Int: целочисленный номер

- Запись: вложенный объект с несколькими записями

- Строка: текст

Важно!

Типы данных, выбранные для потокового ввода, имеют важные последствия для потокового потока данных. Выберите тип данных до начала потока данных, чтобы избежать необходимости остановить его позже для редактирования.

Добавление преобразования потоковых данных

Преобразования потоковых данных по сути отличаются от преобразований пакетных данных. Почти все данные потоковой передачи имеют компонент времени, влияющий на все задачи подготовки данных.

Чтобы добавить преобразование потоковых данных в поток данных, выберите значок преобразования на ленте для этого преобразования. Соответствующие карта отображаются в представлении схемы. Выбрав его, вы увидите боковую область для этого преобразования, чтобы настроить его.

По состоянию на июль 2021 года потоки данных потоковой передачи поддерживают следующие преобразования потоковой передачи.

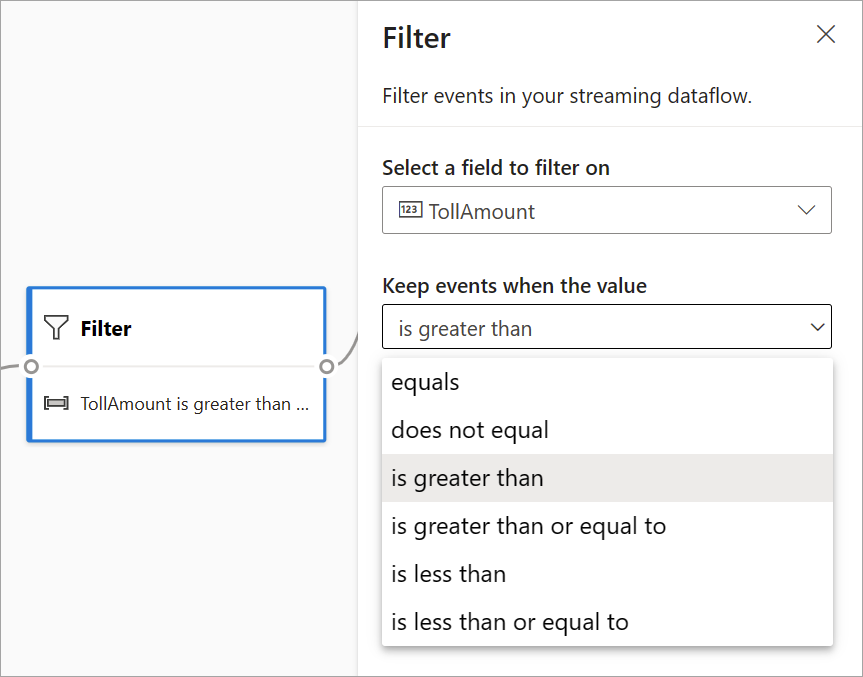

Фильтр

Используйте преобразование фильтра для фильтрации событий на основе значения поля во входных данных. В зависимости от типа данных (число или текст), преобразование сохраняет значения, соответствующие выбранному условию.

Примечание.

В каждой карта вы увидите сведения о том, что еще необходимо для подготовки преобразования. Например, при добавлении нового карта появится сообщение "Настройка требуется". Если соединитель узла отсутствует, вы увидите сообщение "Ошибка" или "Предупреждение".

Управление полями

Преобразование "Управление полями " позволяет добавлять, удалять или переименовать поля, поступающие из входного или другого преобразования. Параметры на боковой панели предоставляют возможность добавления нового, нажав кнопку "Добавить поле " или добавив все поля одновременно.

Совет

После настройки карта представление схемы дает представление о параметрах внутри самой карта. Например, в области "Управление полями" предыдущего изображения можно увидеть первые три поля , которыми управляются, и новые имена, назначенные им. Каждая карта имеет сведения, относящиеся к нему.

Агрегированное

Вы можете использовать преобразование "Агрегат" для вычисления агрегата (суммы, минимального, максимального или среднего) каждый раз, когда новое событие происходит за период времени. Эта операция также позволяет фильтровать или срезать агрегирование на основе других измерений в данных. В одном или нескольких агрегатах можно выполнить одно или несколько агрегатов.

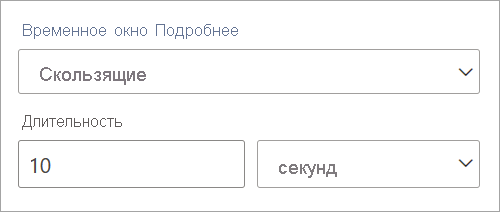

Чтобы добавить агрегирование, выберите значок преобразования. Затем подключите входные данные, выберите агрегирование, добавьте все измерения фильтра или среза и выберите период времени, когда вы хотите вычислить агрегирование. В этом примере вычисляется сумма стоимости по состоянию, в котором автомобиль находится за последние 10 секунд.

Чтобы добавить еще одну агрегацию в то же преобразование, выберите "Добавить агрегатную функцию". Помните, что фильтр или срез применяются ко всем агрегатам в преобразовании.

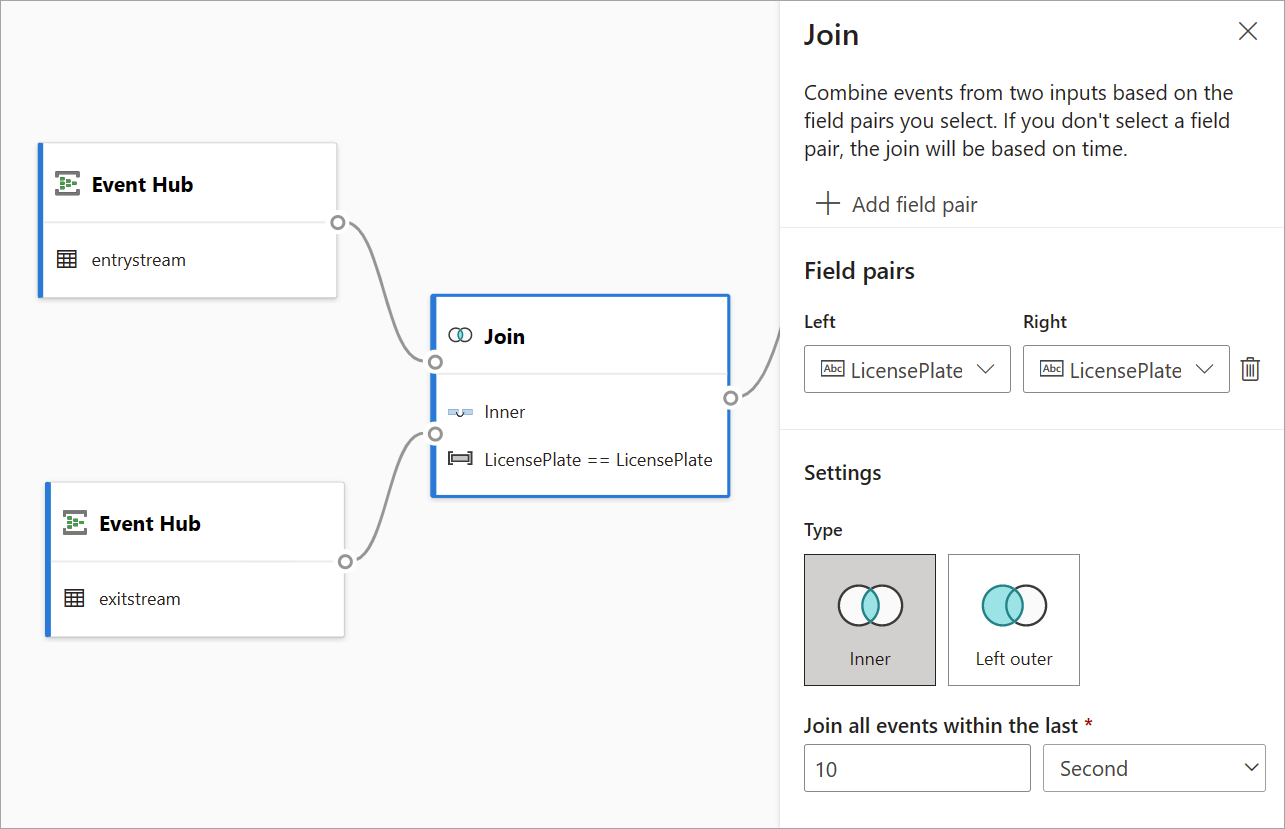

Присоединиться

Используйте преобразование Join для объединения событий из двух входных данных на основе пар полей, которые вы выбрали. Если вы не выбираете пару полей, соединение зависит от времени по умолчанию. По умолчанию это преобразование отличается от пакетной.

Как и при регулярных соединениях, у вас есть различные варианты логики соединения:

- Внутреннее соединение: включите только записи из обеих таблиц, в которых пара совпадает. В этом примере номер лицензии совпадает с обоими входными данными.

- Левое внешнее соединение: включите все записи из левой (первой) таблицы и только записи из второй, которые соответствуют паре полей. Если совпадения нет, поля из второго входного значения задаются пустыми.

Чтобы выбрать тип соединения, выберите значок предпочтительного типа на боковой панели.

Наконец, выберите в течение определенного периода времени вычисление соединения. В этом примере соединение смотрит на последние 10 секунд. Имейте в виду, что чем дольше период, тем меньше выходных данных— и чем больше ресурсов обработки, используемых для преобразования.

По умолчанию все поля из обеих таблиц включены. Префиксы слева (первый узел) и справа (второй узел) в выходных данных помогают различать источник.

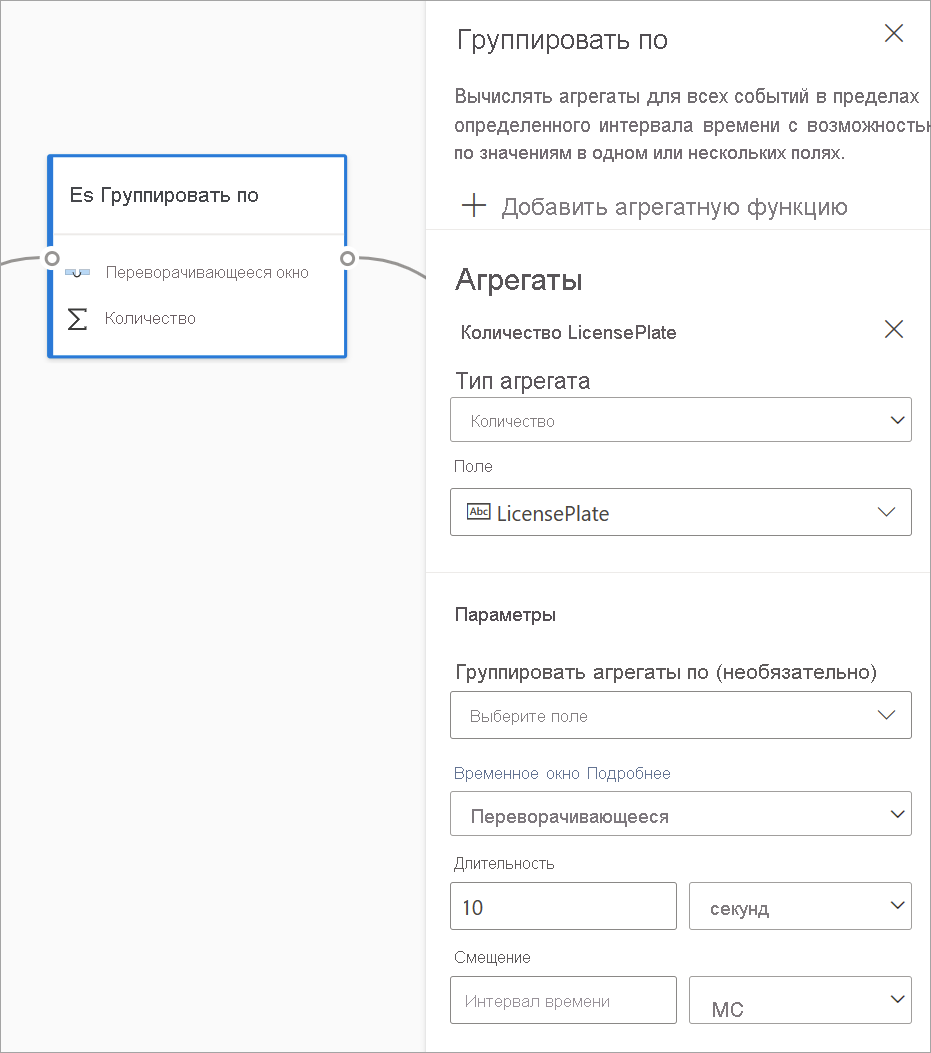

Группировать по

Используйте группу путем преобразования для вычисления агрегатов во всех событиях в течение определенного периода времени. Вы можете выполнять группирование по значениям в одном или нескольких полях. Это похоже на преобразование "Агрегат" , но предоставляет дополнительные возможности для агрегирования. Он также включает более сложные параметры периода времени. Кроме того, аналогично агрегату, можно добавить несколько агрегатов для каждого преобразования.

Агрегаты, доступные в этом преобразовании: среднее, число, максимальное, минимальное, процентиль (непрерывное и дискретное), стандартное отклонение, сумма и вариативность.

Чтобы настроить это преобразование, выполните указанные ниже действия.

- Выберите предпочтительную агрегирование.

- Выберите поле, для которого требуется агрегироваться.

- Выберите необязательное поле по группам, если вы хотите получить статистическое вычисление по другому измерению или категории (например, State).

- Выберите функцию для временных окон.

Чтобы добавить еще одну агрегацию в то же преобразование, выберите "Добавить агрегатную функцию". Помните, что группа по полю и функция окна применяются ко всем агрегатам в преобразовании.

Метка времени окончания периода времени предоставляется как часть выходных данных преобразования для ссылки.

В разделе ниже в этой статье описывается каждый тип периода времени, доступного для этого преобразования.

Объединение

Используйте преобразование Union для подключения двух или нескольких входных данных для добавления событий с общими полями (с одинаковым именем и типом данных) в одну таблицу. Поля, которые не соответствуют, удаляются и не включаются в выходные данные.

Настройка функций временных окон

Временные окна — это одна из самых сложных концепций потоковых данных. Эта концепция находится в основе потоковой аналитики.

С потоковыми потоками данных можно настроить окна времени при агрегирования данных в качестве параметра группы путем преобразования.

Примечание.

Помните, что все выходные результаты для операций с окном вычисляются в конце периода времени. Выходные данные окна будут одним событием, основанным на агрегатной функции. Это событие будет иметь метку времени конца окна, и все функции окна определяются фиксированной длиной.

Существует пять видов временных окон для выбора: переворачивающиеся, прыжки, скольжения, сеанс и моментальный снимок.

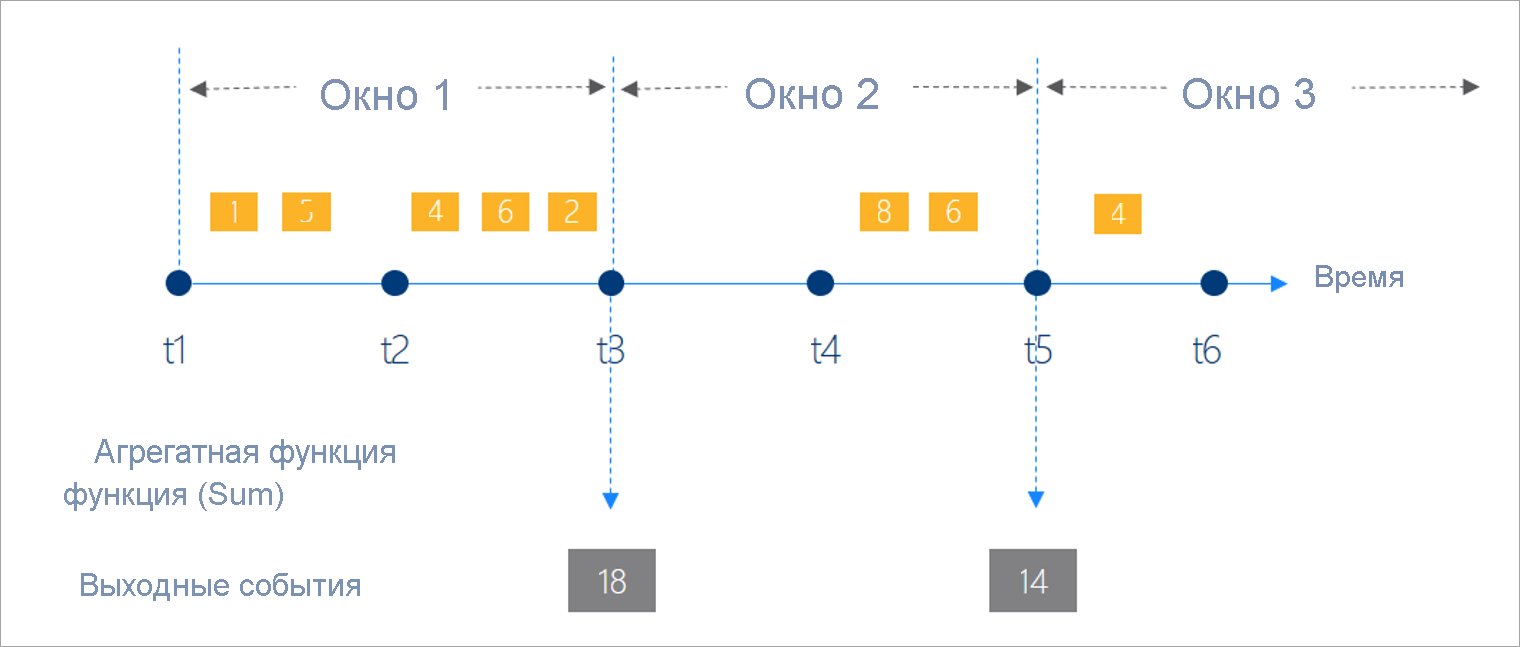

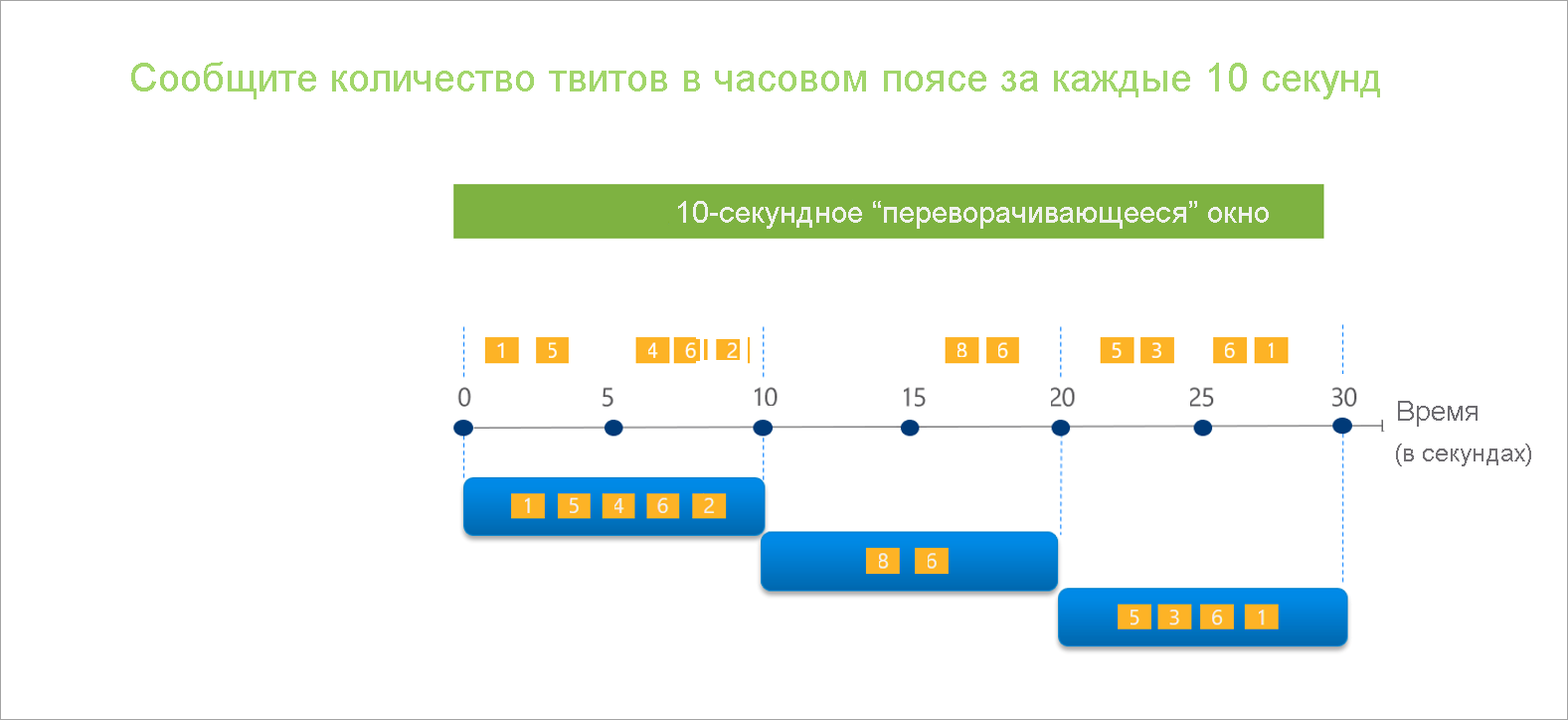

"Переворачивающееся" окно

Переворачивающееся — это наиболее распространенный тип периода времени. Ключевыми характеристиками переворачивающихся окон являются то, что они повторяются, имеют одинаковую длину времени и не перекрываются. Событие не может принадлежать нескольким переворачивающимся окнам.

При настройке переворачивающегося окна в потоковых потоках данных необходимо указать длительность окна (одинаково для всех окон в этом случае). Кроме того, можно указать необязательное смещение. По умолчанию переворачивающиеся окна включают конец окна и исключают начало. Этот параметр можно использовать для изменения этого поведения и включения событий в начало окна и исключения из них в конце.

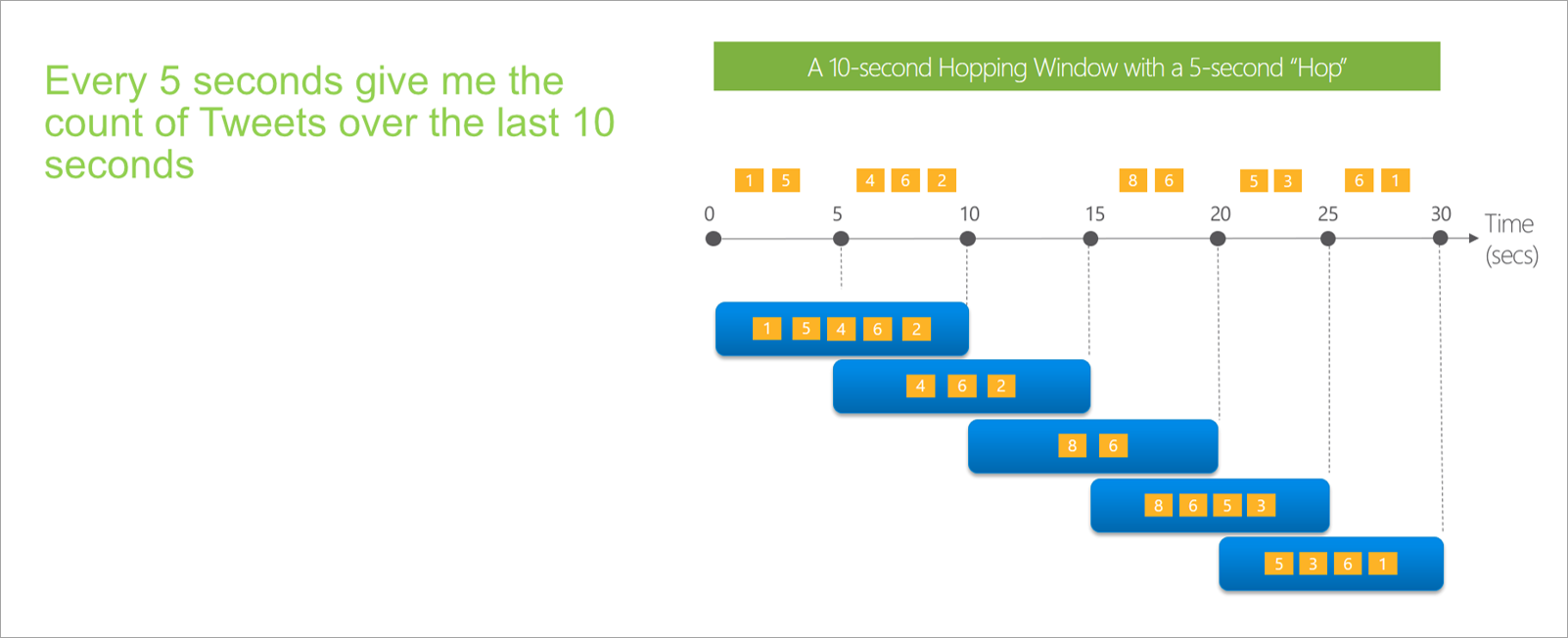

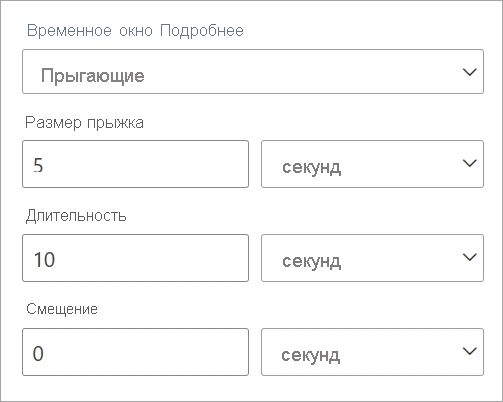

"Прыгающее" окно

Прыжки окна "прыжок" вперед в течение фиксированного периода. Их можно рассматривать как переворачивающиеся окна, которые могут перекрываться и быть генерируются чаще, чем размер окна. События могут принадлежать нескольким результирующий набор для окна прыжка. Чтобы сделать окно прыжка таким же, как и переворачивающееся окно, можно указать размер прыжка, который будет совпадать с размером окна.

При настройке окна прыжка в потоковых потоках данных необходимо указать длительность окна (так же, как и в переворачивающихся окнах). Кроме того, необходимо указать размер прыжка, который сообщает потоковым потокам данных, как часто вы хотите, чтобы агрегирование вычислялось в течение определенной длительности.

Параметр смещения также доступен в окнах прыжков по той же причине, что и в переворачивающихся окнах. Он определяет логику включения и исключения событий для начала и конца окна прыжков.

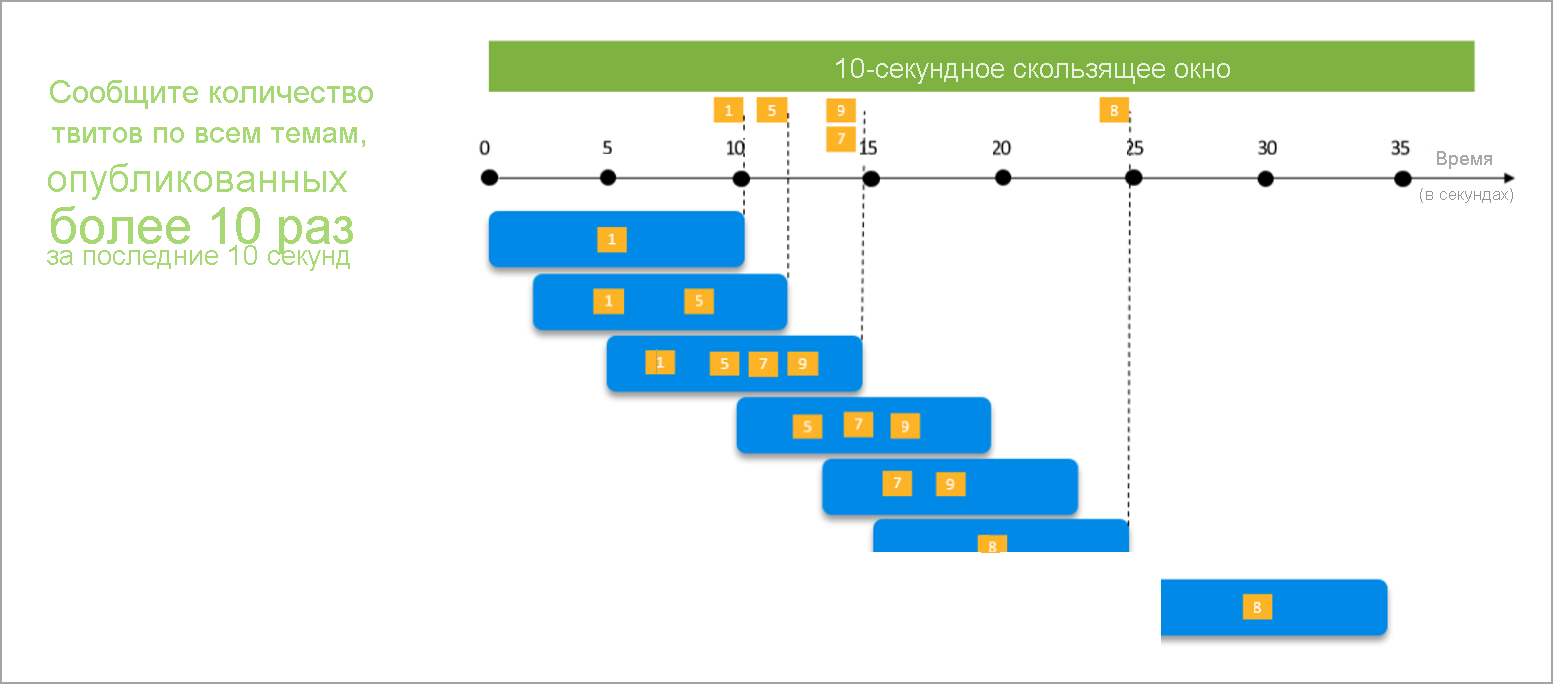

"Скользящее" окно

Скользящие окна, в отличие от переворачивающегося или прыжкового окна, вычисляют агрегирование только для точек во времени, когда содержимое окна фактически изменяется. При входе или выходе из окна вычисляется агрегирование. Таким образом, у каждого окна есть по меньшей мере одно событие. Подобно прыжкам окна, события могут принадлежать нескольким скользящим окнам.

Единственным параметром, который требуется для скользящего окна, является длительность, так как события сами определяются при запуске окна. Логика смещения не требуется.

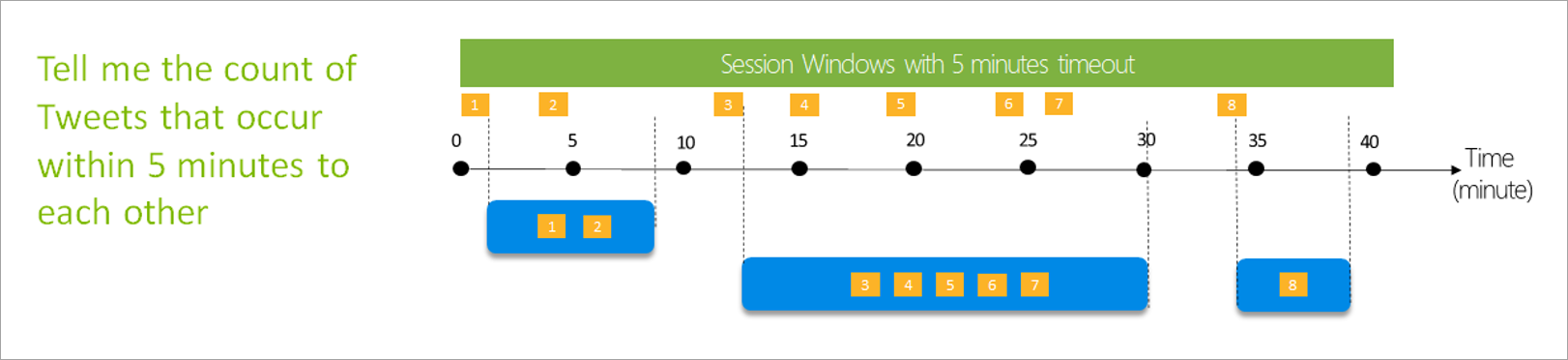

"Сеансовое" окно

Окна сеансов являются самым сложным типом. Они группируют события, поступающие в аналогичное время, отфильтровывая периоды времени, где нет данных. Для этого окна необходимо указать следующее:

- Время ожидания: как долго ждать, если нет новых данных.

- Максимальная длительность: самое длительное время, которое агрегирование вычисляет, если данные продолжают поступать.

Вы также можете определить секцию, если хотите.

Окно сеанса настраивается непосредственно на боковой панели для преобразования. Если вы предоставляете секцию, агрегирование будет группировать только события для одного и того же ключа.

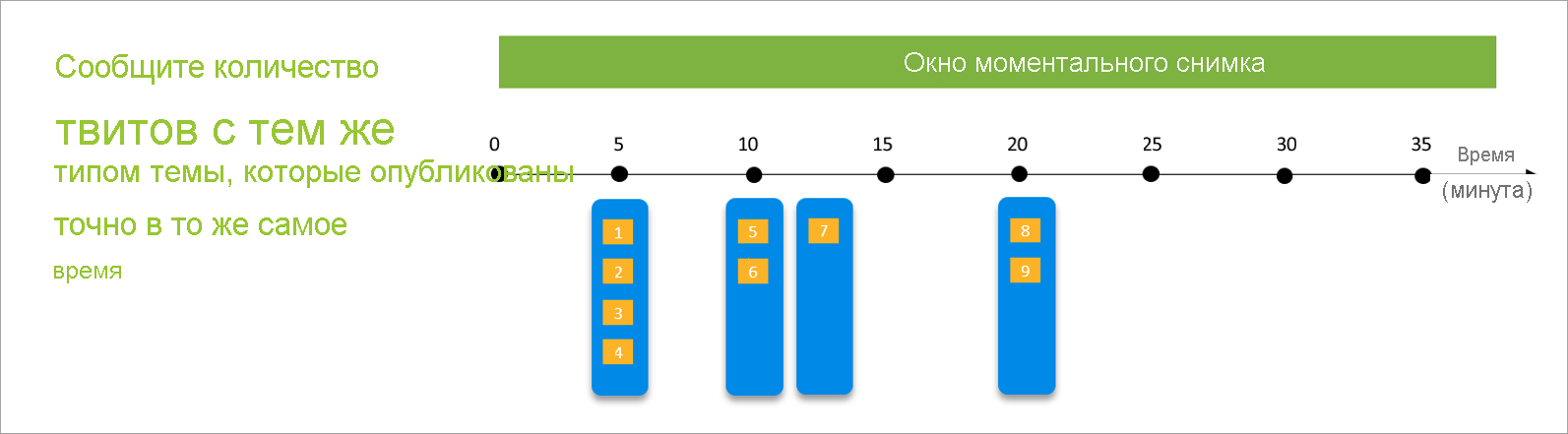

Окно моментального снимка

События группы моментальных снимков windows с одинаковым меткой времени. В отличие от других окон, моментальный снимок не требует никаких параметров, так как использует время из системы.

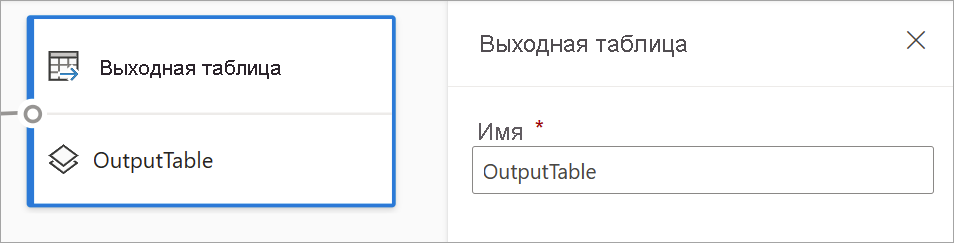

Определение выходных данных

После настройки входных и преобразований пришло время определить один или несколько выходных данных. По состоянию на июль 2021 года потоки данных потоковой передачи поддерживают таблицы Power BI в качестве единственного типа выходных данных.

Это таблица потока данных (то есть сущность), которую можно использовать для создания отчетов в Power BI Desktop. Необходимо присоединить узлы предыдущего шага к создаваемым выходным данным, чтобы сделать его работой. После этого назовите таблицу.

После подключения к потоку данных эта таблица будет доступна для создания визуальных элементов, обновляемых в режиме реального времени для отчетов.

Предварительный просмотр и ошибки данных

Потоки данных потоковой передачи предоставляют средства, помогающие создавать, устранять неполадки и оценивать производительность конвейера аналитики для потоковых данных.

Предварительная версия динамических данных для входных данных

При подключении к центру событий или Центру Интернета вещей и выборе карта в представлении схемы (вкладка "Предварительный просмотр данных") вы получите динамический просмотр данных, поступающих, если все следующие значения верны:

- Выполняется отправка данных.

- Входные данные настроены правильно.

- Добавлены поля.

Как показано на следующем снимке экрана, если вы хотите просмотреть или детализировать определенные сведения, можно приостановить предварительную версию (1). Или вы можете начать его снова, если вы закончите.

Кроме того, можно просмотреть сведения о конкретной записи (ячейке в таблице), выбрав ее, а затем выбрав "Показать сведения" или "Скрыть сведения" (2). Снимок экрана: подробное представление вложенного объекта в записи.

Статический предварительный просмотр для преобразований и выходных данных

После добавления и настройки любых шагов в представлении диаграммы можно проверить их поведение, нажав кнопку статических данных.

После этого потоки данных потоковой передачи оценивают все преобразования и выходные данные, настроенные правильно. Потоки данных потоковой передачи отображают результаты в предварительном просмотре статических данных, как показано на следующем рисунке.

Вы можете обновить предварительную версию, выбрав "Обновить статическую предварительную версию " (1). При этом потоки данных потоковой передачи принимают новые данные из входных данных и оценивают все преобразования и выходные данные снова с любыми обновлениями, которые вы могли выполнить. Также доступен параметр "Показать или скрыть сведения" (2).

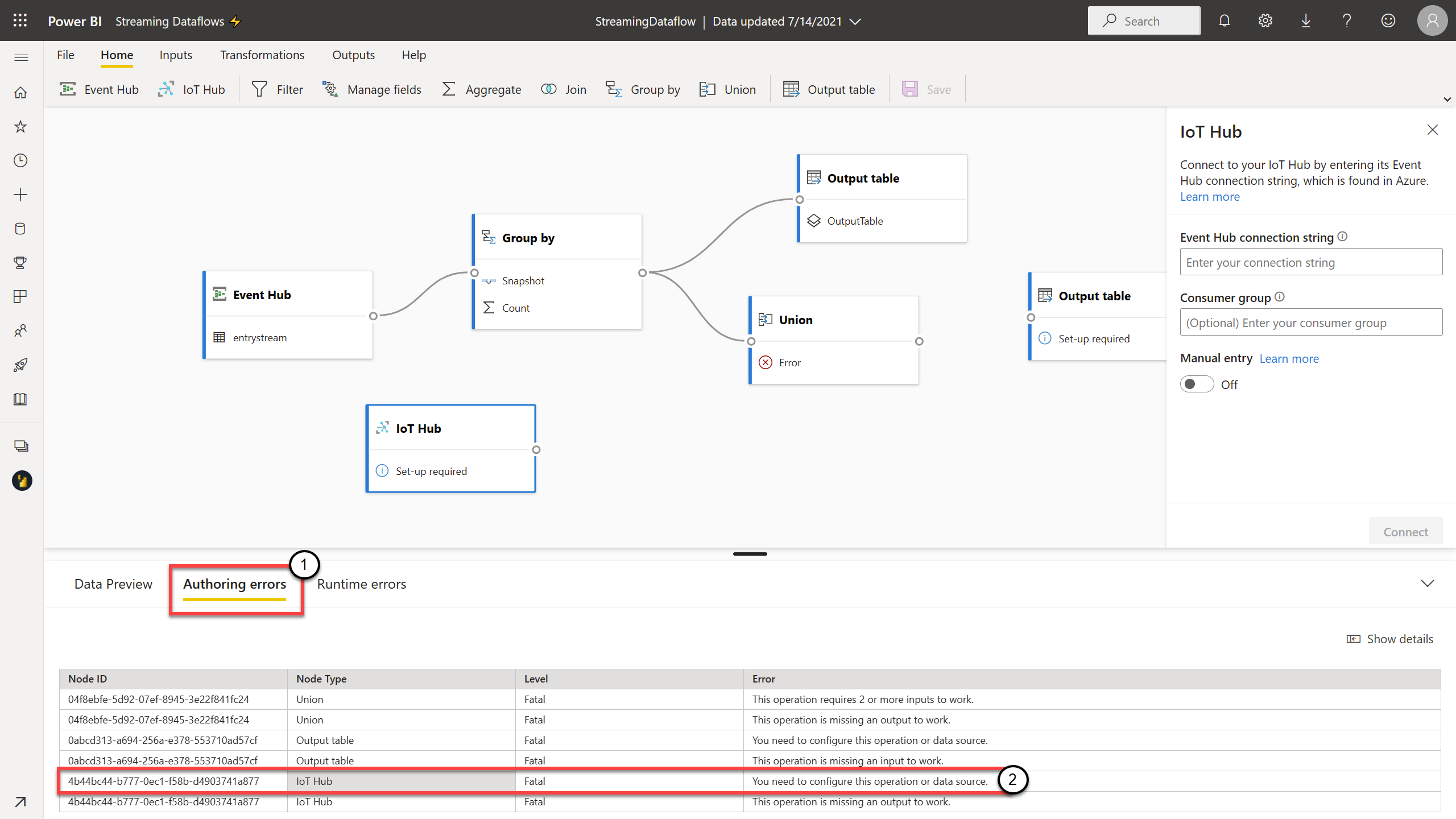

Ошибки разработки

Если у вас есть ошибки разработки или предупреждения, на вкладке "Создание ошибок " (1) перечислены их, как показано на следующем снимке экрана. Список содержит сведения об ошибке или предупреждении, тип карта (входные, преобразования или выходные данные), уровень ошибки и описание ошибки или предупреждения (2). При выборе любого из ошибок или предупреждений выбран соответствующий карта, и откроется боковая область конфигурации, чтобы внести необходимые изменения.

Ошибки среды выполнения

Последняя доступная вкладка в предварительной версии — ошибки среды выполнения (1), как показано на следующем снимке экрана. На этой вкладке перечислены все ошибки в процессе приема и анализа потокового потока данных после запуска. Например, вы можете получить ошибку среды выполнения, если сообщение было повреждено, и поток данных не мог его приема и выполнения определенных преобразований.

Так как потоки данных могут выполняться в течение длительного периода времени, эта вкладка предлагает возможность отфильтровать по временному интервалу и скачать список ошибок и обновить его при необходимости (2).

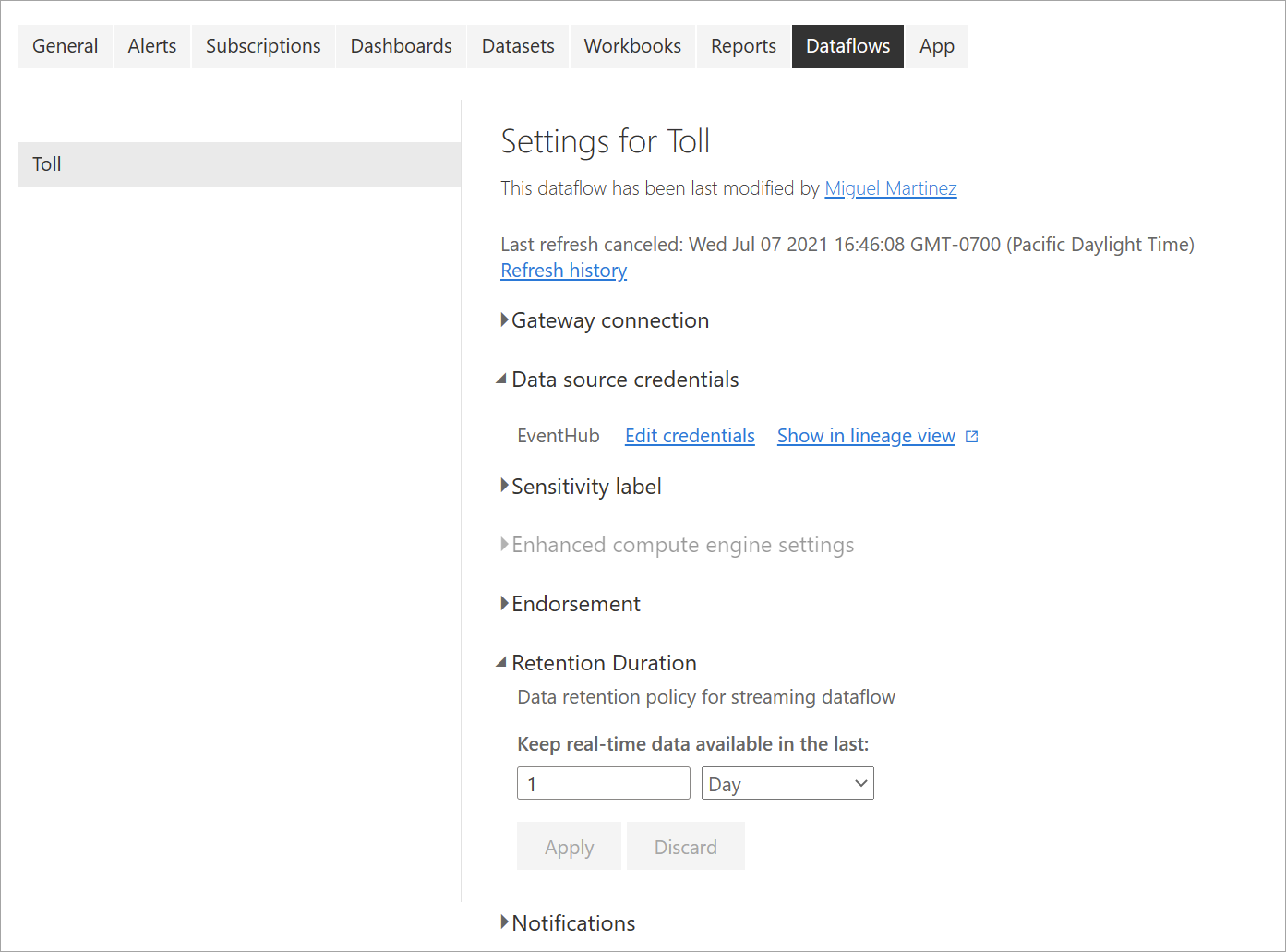

Изменение параметров потоковых потоков данных

Как и в случае с регулярными потоками данных, параметры потоковых потоков данных можно изменять в зависимости от потребностей владельцев и авторов. Следующие параметры уникальны для потоковых потоков данных. Для остальных параметров из-за общей инфраструктуры между двумя типами потоков данных можно предположить, что это то же самое.

Журнал обновления: так как потоки данных потоковой передачи выполняются непрерывно, журнал обновления отображает только сведения о том, когда поток данных запускается, когда он отменен или когда он завершается сбоем (с подробными сведениями и кодами ошибок, если применимо). Эта информация похожа на то, что отображается для регулярных потоков данных. Эти сведения можно использовать для устранения неполадок или предоставления поддержки Power BI с запрошенными сведениями.

Учетные данные источника данных: в этом параметре показаны входные данные, настроенные для конкретного потока потоковых данных.

Расширенные параметры подсистемы вычислений: потоки данных потоковой передачи требуют расширенного вычислительного модуля для предоставления визуальных элементов в режиме реального времени, поэтому этот параметр включен по умолчанию и не может быть изменен.

Длительность хранения. Этот параметр предназначен для потоковых потоков данных. Здесь можно определить время хранения данных в режиме реального времени для визуализации в отчетах. Исторические данные сохраняются по умолчанию в Хранилище BLOB-объектов Azure. Этот параметр зависит от стороны данных в режиме реального времени (горячее хранилище). Минимальное значение — 1 день или 24 часа.

Важно!

Объем горячих данных, хранящихся в течение этого срока хранения, напрямую влияет на производительность визуальных элементов реального времени при создании отчетов на основе этих данных. Чем больше хранения вы здесь, тем больше визуальных элементов в режиме реального времени в отчетах может повлиять на низкую производительность. Если необходимо выполнить исторический анализ, следует использовать холодное хранилище, предоставленное для потоковых потоков данных.

Запуск и изменение потокового потока данных

После сохранения и настройки потокового потока данных все готово для его запуска. Затем можно начать прием данных в Power BI с помощью логики потоковой аналитики, которую вы определили.

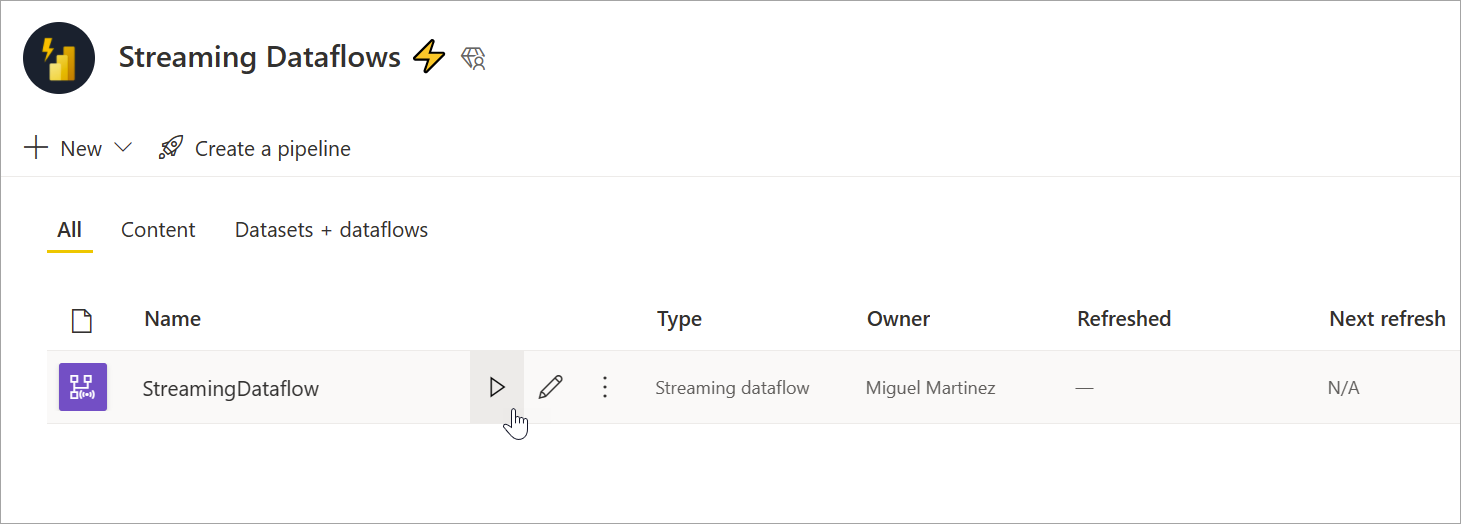

Запуск потокового потока данных

Чтобы запустить поток данных потоковой передачи, сначала сохраните поток данных и перейдите в рабочую область, в которой она создана. Наведите указатель мыши на поток потоковых данных и нажмите кнопку воспроизведения, которая отображается. Всплывающее сообщение сообщает о том, что поток потоковых данных запущен.

Примечание.

Для приема данных может потребоваться до пяти минут, и для просмотра данных, поступающих для создания отчетов и панелей мониторинга в Power BI Desktop.

Изменение потокового потока данных

Пока поток потоковых данных запущен, его нельзя изменить. Но вы можете перейти в поток потоковых данных, который находится в состоянии выполнения, и увидеть логику аналитики, на которую основан поток данных.

При переходе в поток потоковой передачи все параметры редактирования отключены, и отображается сообщение: "Поток данных не может быть изменен во время его выполнения. Остановите поток данных, если вы хотите продолжить". Предварительный просмотр данных также отключен.

Чтобы изменить поток потоковых данных, его необходимо остановить. Остановленный поток данных приводит к отсутствующим данным.

Единственный способ, доступный во время выполнения потокового потока данных, — вкладка ошибок среды выполнения, где можно отслеживать поведение потока данных для любых удаленных сообщений и аналогичных ситуаций.

Рассмотрите возможность хранения данных при редактировании потока данных

При редактировании потока данных необходимо учитывать другие аспекты. Как и любые изменения в схеме для регулярных потоков данных, при внесении изменений в выходную таблицу вы теряете данные, которые уже были отправлены и сохранены в Power BI. Интерфейс предоставляет четкие сведения о последствиях любого из этих изменений в потоке потоковых данных, а также выбор изменений, внесенных перед сохранением.

Этот интерфейс лучше показан с примером. На следующем снимне экрана показано сообщение, которое вы получаете при добавлении столбца в одну таблицу, измените имя второй таблицы и оставьте третью таблицу той же, что и раньше.

В этом примере данные, уже сохраненные в обеих таблицах с изменениями схемы и имени, удаляются при сохранении изменений. Для таблицы, которая осталась той же, вы получите возможность удалить старые данные и начать с нуля или сохранить ее для последующего анализа вместе с новыми данными, поступающими в систему.

Имейте в виду эти нюансы при редактировании потокового потока данных, особенно если вам нужны исторические данные, доступные позже для дальнейшего анализа.

Использование потокового потока данных

После запуска потокового потока данных можно приступить к созданию содержимого поверх потоковых данных. По сравнению с тем, что необходимо сделать для создания отчетов, обновляемых в режиме реального времени, нет структурных изменений. Существуют некоторые нюансы и обновления, которые следует учитывать, чтобы воспользоваться преимуществами этого нового типа подготовки данных для потоковой передачи данных.

Настройка хранилища данных

Как мы упоминание раньше, потоки данных потоковой передачи сохраняют данные в следующих двух расположениях. Использование этих источников зависит от типа анализа, который вы пытаетесь выполнить.

- Горячее хранилище (анализ в режиме реального времени): как данные входят в Power BI из потоковых потоков данных, данные хранятся в горячем расположении для доступа к визуальным элементам в режиме реального времени. Сколько данных сохраняется в этом хранилище, зависит от значения, определенного для длительности хранения в параметрах потокового потока данных. Значение по умолчанию (и минимальное) — 24 часа.

- Холодное хранилище (исторический анализ) — любой период времени, который не попадает в период, определенный для длительности хранения, сохраняется в холодном хранилище (BLOB-объектах) в Power BI для использования при необходимости.

Примечание.

Между этими двумя расположениями хранилища данных перекрывается. Если вам нужно использовать оба расположения в сочетании (например, изменение процента на день), может потребоваться дедупликация записей. Это зависит от вычислений аналитики времени, которые вы делаете, и политики хранения.

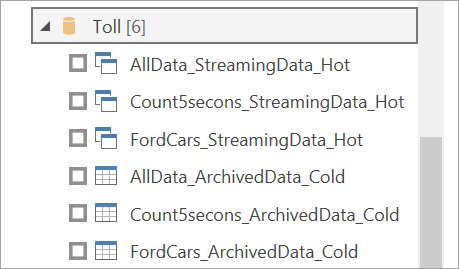

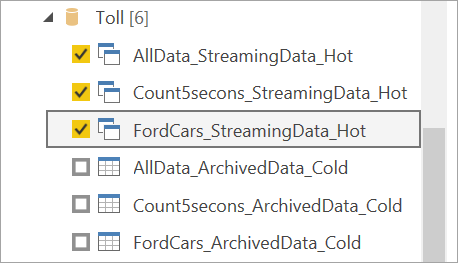

Подключение потоковой передачи потоков данных из Power BI Desktop

Power BI Desktop предлагает соединитель с именем "Потоки данных" для использования. В рамках этого соединителя потоковых потоков данных вы увидите две таблицы, соответствующие ранее описанному хранилищу данных.

Чтобы подключиться к данным для потоковых потоковых потоков данных, выполните приведенные далее действия.

Перейдите к разделу "Получить данные", выберите Power Platform и выберите соединитель потоков данных.

Войдите с помощью учетных данных Power BI.

Выберите рабочие области. Найдите тот, который содержит поток данных потоковой передачи, и выберите этот поток данных. (В этом примере вызывается поток потоковых данных.Toll.)

Обратите внимание, что все выходные таблицы отображаются дважды: один для потоковых данных (горячий) и один для архивированных данных (холодный). Вы можете отличить их по меткам, добавленным после имен таблиц и значков.

Подключение потоковой передачи данных. Архивный случай данных одинаков, доступен только в режиме импорта. Выберите таблицы, включающие метки Потоковая передача и горячая передача, а затем нажмите кнопку "Загрузить".

Когда вам будет предложено выбрать режим хранения, выберите DirectQuery , если ваша цель — создать визуальные элементы в режиме реального времени.

Теперь вы можете создавать визуальные элементы, меры и многое другое с помощью функций, доступных в Power BI Desktop.

Примечание.

Обычный соединитель потока данных Power BI по-прежнему доступен и будет работать с потоковыми потоками данных с двумя оговорками:

- Он позволяет подключаться только к горячему хранилищу.

- Предварительный просмотр данных в соединителе не работает с потоковыми потоками данных.

Включение автоматического обновления страницы для визуальных элементов в режиме реального времени

После того как отчет будет готов и вы добавили все содержимое, которое вы хотите предоставить, единственный шаг слева — убедиться, что визуальные элементы обновлены в режиме реального времени. Вы можете использовать функцию автоматического обновления страницы. Эта функция позволяет обновлять визуальные элементы из источника DirectQuery как раз в одну секунду.

Дополнительные сведения о функции см. в статье "Автоматическое обновление страницы" в Power BI. В этой статье содержатся сведения о том, как его использовать, как его настроить и как связаться с администратором, если у вас возникли проблемы. Ниже приведены основные сведения о настройке.

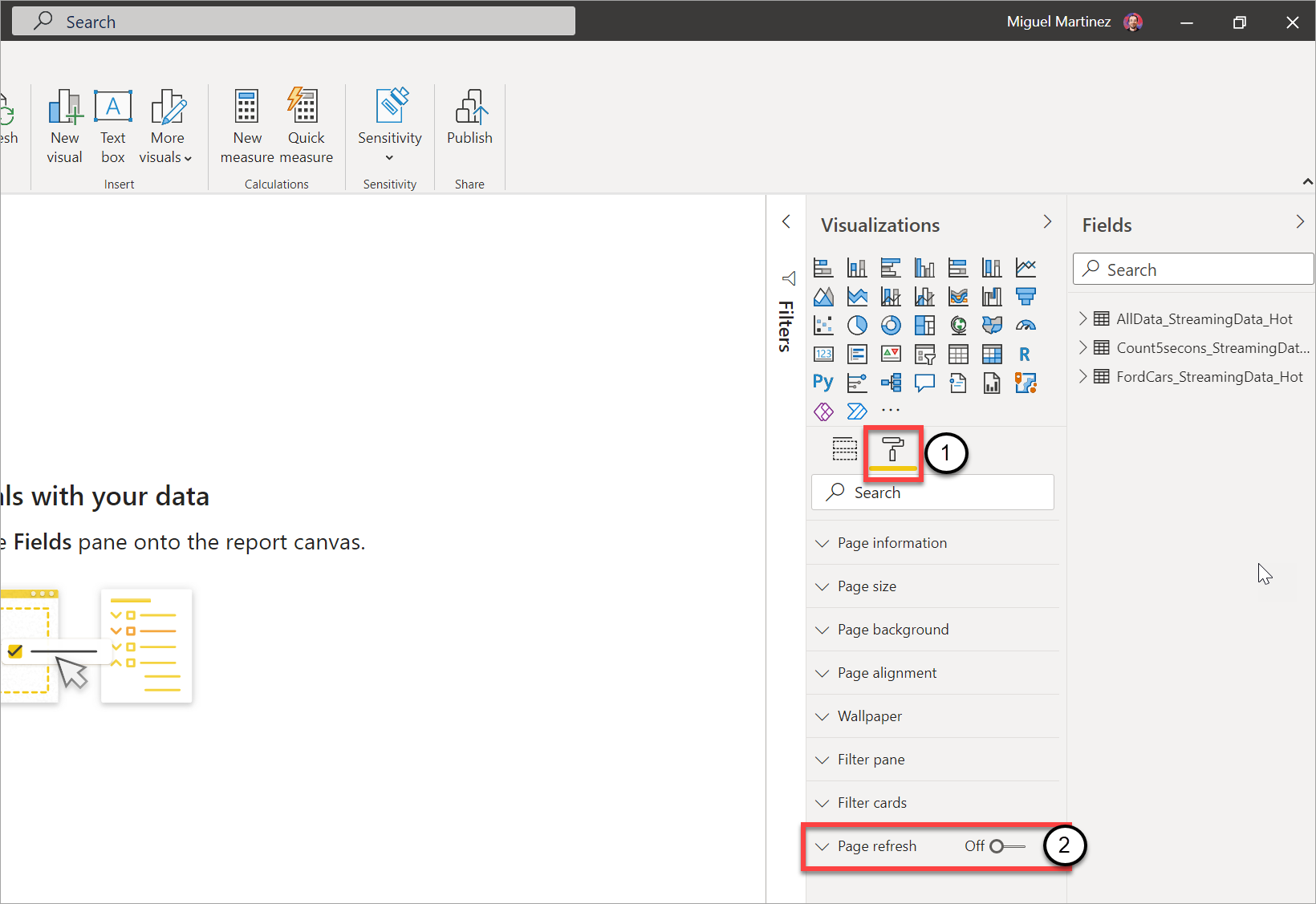

Перейдите на страницу отчета, в которой необходимо обновить визуальные элементы в режиме реального времени.

Снимите любой визуальный элемент на странице. Если это возможно, выберите фон страницы.

Перейдите в область форматирования (1) и включите обновление страницы (2).

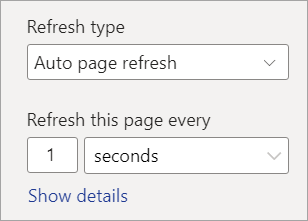

Настройте нужную частоту (до каждой секунды, если администратор разрешил ей).

Чтобы предоставить общий доступ к отчету в режиме реального времени, сначала опубликуйте его в служба Power BI. Затем можно настроить учетные данные потока данных для семантической модели и предоставить общий доступ.

Совет

Если отчет не обновляется так быстро, как это необходимо или в режиме реального времени, проверка документацию для автоматического обновления страницы. Следуйте часто задаваемым вопросам и инструкциям по устранению неполадок, чтобы выяснить, почему эта проблема может произойти.

Рекомендации и ограничения

Общие ограничения

- Подписка Power BI Premium (емкость или PPU) необходима для создания и запуска потоковых потоков данных.

- Для каждой рабочей области допускается только один тип потока данных.

- Связывание регулярных и потоковых потоков данных невозможно.

- Емкости меньше A3 не позволяют использовать потоки данных потоковой передачи.

- Если потоки данных или расширенный модуль вычислений не включены в клиенте, невозможно создать или запустить потоки данных потоковой передачи.

- Рабочие области, подключенные к учетной записи хранения, не поддерживаются.

- Каждый поток потоковых данных может предоставлять до 1 МБ в секунду пропускной способности.

Доступность

Предварительная версия потоковых потоков данных недоступна в следующих регионах:

- Центральная Индия

- Северная Германия

- Восточная Норвегия;

- Западная Норвегия

- Центральная часть ОАЭ

- Северная часть ЮАР

- Западная часть ЮАР

- Северная Швейцария

- Западная Швейцария

- Юго-Восточная Бразилия

Лицензирование

Число потоковых потоков данных, разрешенных для каждого клиента, зависит от используемой лицензии:

Для регулярных емкостей используйте следующую формулу, чтобы вычислить максимальное количество потоковых потоков данных, разрешенных в емкости:

Максимальное число потоковых потоковых данных на емкость = виртуальные ядра в емкости x 5

Например, P1 имеет 8 виртуальных ядер: 8 * 5 = 40 потоковых потоковых данных.

Для пользователей категории "Премиум" разрешен один поток потоковых данных для каждого пользователя. Если другой пользователь хочет использовать поток потоковых данных в рабочей области PPU, им также нужна лицензия PPU.

Создание потока данных

При разработке потоковых потоковых данных следует учитывать следующие аспекты:

- Владелец потоковых потоковых потоков данных может вносить изменения только в изменения, и они могут вносить изменения только в том случае, если поток данных не запущен.

- Потоки данных потоковой передачи недоступны в моей рабочей области.

Подключение из Power BI Desktop

Доступ к холодному хранилищу можно получить только с помощью соединителя потоков данных, доступного начиная с обновления Power BI Desktop за июль 2021 г. Предыдущий соединитель потока данных Power BI позволяет подключаться только к хранилищу потоковых данных (горячей). Предварительная версия данных соединителя не работает.

Связанный контент

В этой статье представлен обзор самостоятельной подготовки потоковых данных с помощью потоковых потоковых данных. В следующих статьях содержатся сведения о том, как протестировать эту возможность и как использовать другие функции потоковых данных в Power BI:

Обратная связь

Ожидается в ближайшее время: в течение 2024 года мы постепенно откажемся от GitHub Issues как механизма обратной связи для контента и заменим его новой системой обратной связи. Дополнительные сведения см. в разделе https://aka.ms/ContentUserFeedback.

Отправить и просмотреть отзыв по