Analysera webbplatsloggar med hjälp av Azure Data Lake Analytics

Lär dig hur du analyserar webbplatsloggar med hjälp av Data Lake Analytics, särskilt för att ta reda på vilka referenter som stötte på fel när de försökte besöka webbplatsen.

Viktigt

Azure Data Lake Analytics tillbaka den 29 februari 2024. Läs mer med det här meddelandet.

För dataanalys kan din organisation använda Azure Synapse Analytics eller Microsoft Fabric.

Förutsättningar

Visual Studio 2015 eller Visual Studio 2013.

Data Lake-verktyg för Visual Studio.

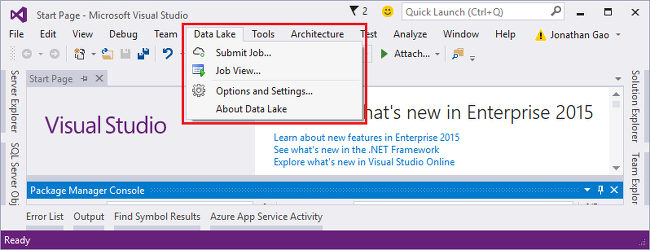

När Data Lake Tools för Visual Studio har installerats visas ett Data Lake-objekt på verktygsmenyn i Visual Studio:

Grundläggande kunskaper om Data Lake Analytics och Data Lake Tools för Visual Studio. Kom igång genom att läsa:

Ett Data Lake Analytics-konto. Se Skapa ett Azure Data Lake Analytics-konto.

Installera exempeldata. I Azure Portal öppnar du ditt Data Lake Analytics-konto och väljer Exempelskript på den vänstra menyn och väljer sedan Kopiera exempeldata.

Anslut till Azure

Innan du kan skapa och testa U-SQL-skript måste du först ansluta till Azure.

Så här ansluter du till Data Lake Analytics

- Öppna Visual Studio.

- Välj Data Lake-alternativ > och inställningar.

- Välj Logga in eller Ändra användare om någon har loggat in och följ instruktionerna.

- Välj OK för att stänga dialogrutan Alternativ och inställningar.

Bläddra bland dina Data Lake Analytics-konton

- Öppna Server Explorer från Visual Studio genom att trycka på CTRL+ALT+S.

- Gå till Server Explorer, expandera Azure och expandera sedan Data Lake Analytics. En lista över dina Data Lake Analytics-konton visas om det finns några. Du kan inte skapa Data Lake Analytics konton från studion. För att skapa ett konto, se Kom igång med Azure Data Lake Analytics med hjälp av Azure-portalen eller Kom igång med Azure Data Lake Analytics med hjälp av Azure PowerShell.

Utveckla U-SQL-program

Ett U-SQL-program är främst ett U-SQL-skript. Mer information om U-SQL finns i Kom igång med U-SQL.

Du kan lägga till användardefinierade operatorer i programmet. Mer information finns i Utveckla användardefinierade U-SQL-operatorer för Data Lake Analytics jobb.

Skapa och skicka ett Data Lake Analytics-jobb

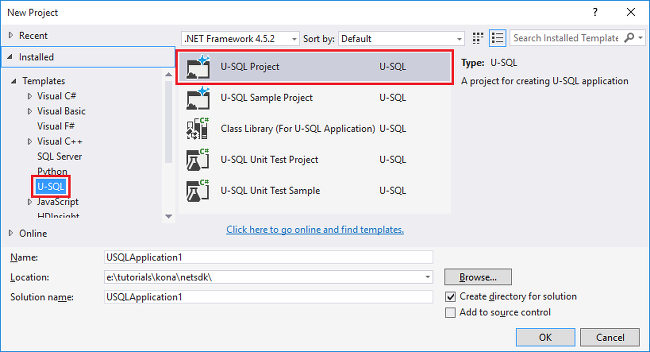

Välj Arkiv > Nytt > projekt.

Välj typen U-SQL-projekt.

Välj OK. Visual Studio skapar en lösning med en Script.usql-fil.

Ange följande skript i filen Script.usql:

// Create a database for easy reuse, so you don't need to read from a file very time. CREATE DATABASE IF NOT EXISTS SampleDBTutorials; // Create a Table valued function. TVF ensures that your jobs fetch data from he weblog file with the correct schema. DROP FUNCTION IF EXISTS SampleDBTutorials.dbo.WeblogsView; CREATE FUNCTION SampleDBTutorials.dbo.WeblogsView() RETURNS @result TABLE ( s_date DateTime, s_time string, s_sitename string, cs_method string, cs_uristem string, cs_uriquery string, s_port int, cs_username string, c_ip string, cs_useragent string, cs_cookie string, cs_referer string, cs_host string, sc_status int, sc_substatus int, sc_win32status int, sc_bytes int, cs_bytes int, s_timetaken int ) AS BEGIN @result = EXTRACT s_date DateTime, s_time string, s_sitename string, cs_method string, cs_uristem string, cs_uriquery string, s_port int, cs_username string, c_ip string, cs_useragent string, cs_cookie string, cs_referer string, cs_host string, sc_status int, sc_substatus int, sc_win32status int, sc_bytes int, cs_bytes int, s_timetaken int FROM @"/Samples/Data/WebLog.log" USING Extractors.Text(delimiter:' '); RETURN; END; // Create a table for storing referrers and status DROP TABLE IF EXISTS SampleDBTutorials.dbo.ReferrersPerDay; @weblog = SampleDBTutorials.dbo.WeblogsView(); CREATE TABLE SampleDBTutorials.dbo.ReferrersPerDay ( INDEX idx1 CLUSTERED(Year ASC) DISTRIBUTED BY HASH(Year) ) AS SELECT s_date.Year AS Year, s_date.Month AS Month, s_date.Day AS Day, cs_referer, sc_status, COUNT(DISTINCT c_ip) AS cnt FROM @weblog GROUP BY s_date, cs_referer, sc_status;Information om U-SQL finns i Kom igång med Data Lake Analytics U-SQL-språk.

Lägg till ett nytt U-SQL-skript i projektet och ange följande:

// Query the referrers that ran into errors @content = SELECT * FROM SampleDBTutorials.dbo.ReferrersPerDay WHERE sc_status >=400 AND sc_status < 500; OUTPUT @content TO @"/Samples/Outputs/UnsuccessfulResponses.log" USING Outputters.Tsv();Gå tillbaka till det första U-SQL-skriptet och ange ditt Analytics-konto bredvid knappen Skicka .

Från Solution Explorer högerklickar du på Script.usql och väljer sedan Skapa skript. Kontrollera resultaten i fönstret Utdata.

Välj Script.usqlfrån Solution Explorer och välj sedan Skicka skript.

Kontrollera att Analytics-kontot är det konto där du vill köra jobbet och välj sedan Skicka. Resultat för skicka och jobblänk är tillgängliga i resultatfönstret för Data Lake-verktyg för Visual Studio när överföringen är klar.

Vänta tills jobbet har slutförts. Om jobbet misslyckades saknar det troligtvis källfilen. Se avsnittet Krav i den här självstudien. Mer felsökningsinformation finns i Övervaka och felsöka Azure Data Lake Analytics-jobb.

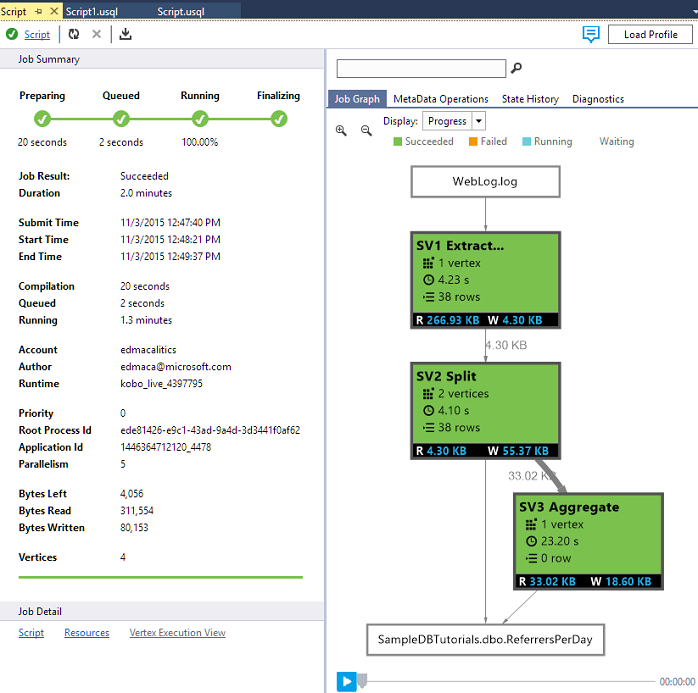

När jobbet har slutförts visas följande skärm:

Upprepa nu steg 7–10 för Script1.usql.

Visa jobbutdata

- Från Server Explorer expanderar du Azure, expanderar Data Lake Analytics, expanderar ditt Data Lake Analytics-konto, expanderar Lagringskonton, högerklickar på standardkontot Data Lake Storage och väljer sedan Utforskaren.

- Dubbelklicka på Exempel för att öppna mappen och dubbelklicka sedan på Utdata.

- Dubbelklicka på UnsuccessfulResponses.log.

- Du kan också dubbelklicka på utdatafilen i diagramvyn för jobbet för att navigera direkt till utdata.

Nästa steg

Om du vill komma igång med Data Lake Analytics med hjälp av olika verktyg, se: