Team Datavetenskap Process (TDSP) är en flexibel, iterativ datavetenskapsmetod som du kan använda för att leverera lösningar för förutsägelseanalys och AI-program effektivt. TDSP hjälper till att förbättra teamsamarbete och utbildning genom att föreslå hur teamroller fungerar bäst tillsammans. TDSP innehåller metodtips och strukturer från Microsoft och andra branschledare för att hjälpa ditt team att framgångsrikt implementera datavetenskapsinitiativ och fullt ut utnyttja fördelarna med ditt analysprogram.

Den här artikeln innehåller en översikt över TDSP och dess huvudkomponenter. Den innehåller vägledning om hur du implementerar TDSP med hjälp av Microsofts verktyg och infrastruktur. Du hittar mer detaljerade resurser i artikeln.

Viktiga komponenter i TDSP

TDSP har följande nyckelkomponenter:

- En livscykeldefinition för datavetenskap

- En standardiserad projektstruktur

- Infrastruktur och resurser som rekommenderas för datavetenskapsprojekt

- Verktyg och verktyg som rekommenderas för projektkörning

Livscykel för datavetenskap

TDSP tillhandahåller en livscykel som du kan använda för att strukturera utvecklingen av dina datavetenskapsprojekt. Livscykeln beskriver de fullständiga steg som lyckade projekt följer.

Du kan kombinera aktivitetsbaserad TDSP med andra datavetenskapslivscykler, till exempel branschöverskridande standardprocess för datautvinning (CRISP-DM), kunskapsidentifiering i databaser (KDD) eller en annan anpassad process. På hög nivå har dessa olika metoder mycket gemensamt.

Du bör använda den här livscykeln om du har ett datavetenskapsprojekt som ingår i ett intelligent program. Intelligenta program distribuerar maskininlärning eller AI-modeller för förutsägelseanalys. Du kan också använda den här processen för undersökande datavetenskapsprojekt och improviserade analysprojekt.

TDSP-livscykeln består av fem större steg som ditt team utför iterativt. Dessa steg omfattar:

Här är en visuell representation av TDSP-livscykeln:

Information om mål, uppgifter och dokumentationsartefakter för varje steg finns i Livscykeln för Team Datavetenskap Process.

Dessa uppgifter och artefakter är associerade med projektroller, till exempel:

- Lösningsarkitekt.

- Projektledare.

- Datatekniker.

- Dataexpert.

- Programutvecklare.

- Projektledare.

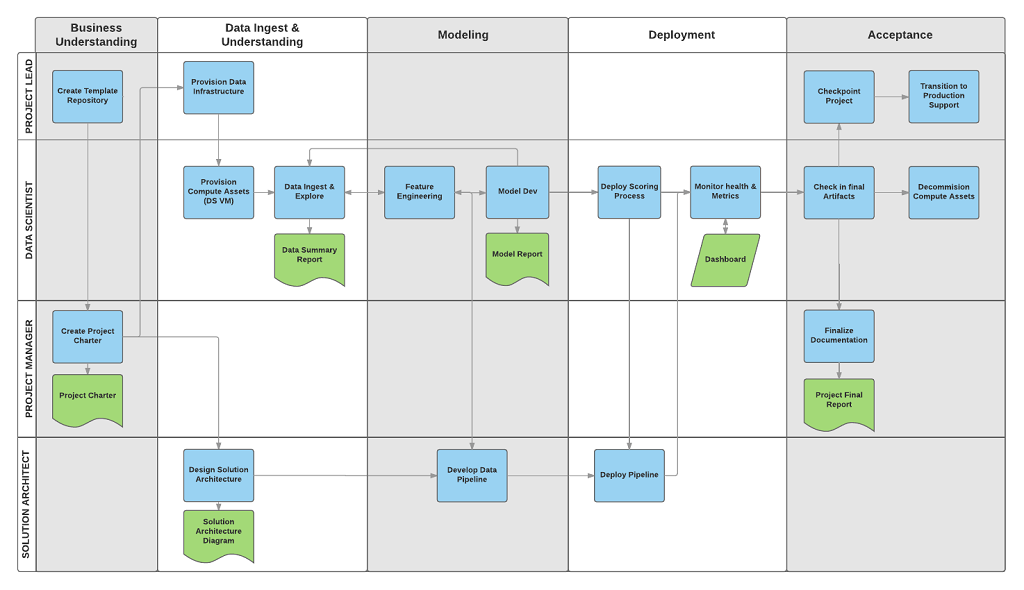

Följande diagram visar de uppgifter (i blått) och artefakter (i grönt) som är associerade med varje fas i livscykeln (på den vågräta axeln) för dessa roller (på den lodräta axeln).

Standardiserad projektstruktur

Ditt team kan använda Azure-infrastrukturen för att organisera dina datavetenskapstillgångar.

Azure Machine Learning stöder MLflow med öppen källkod. Vi rekommenderar att du använder MLflow för datavetenskap och AI-projekthantering. MLflow är utformat för att hantera hela livscykeln för maskininlärning. Den tränar och hanterar modeller på olika plattformar, så att du kan använda en konsekvent uppsättning verktyg oavsett var experimenten körs. Du kan använda MLflow lokalt på datorn, på ett fjärrberäkningsmål, på en virtuell dator eller på en Machine Learning-beräkningsinstans.

MLflow består av flera viktiga funktioner:

Spåra experiment: Med MLflow kan du hålla reda på experiment, inklusive parametrar, kodversioner, mått och utdatafiler. Den här funktionen hjälper dig att jämföra olika körningar och hantera experimenteringsprocessen effektivt.

Paketkod: Det erbjuder ett standardiserat format för att paketera maskininlärningskod, som innehåller beroenden och konfigurationer. Den här paketeringen gör det enklare att återskapa körningar och dela kod med andra.

Hantera modeller: MLflow tillhandahåller funktioner för hantering och versionshantering av modeller. Den stöder olika maskininlärningsramverk, så att du kan lagra, version och hantera modeller.

Hantera och distribuera modeller: MLflow integrerar funktioner för modellservering och distribution, så att du enkelt kan distribuera modeller i olika miljöer.

Registrera modeller: Du kan hantera livscykeln för en modell, inklusive versionshantering, fasövergångar och anteckningar. MLflow är användbart för att underhålla ett centraliserat modellarkiv i en samarbetsmiljö.

Använd ett API och användargränssnitt: I Azure paketeras MLflow i Machine Learning API version 2, så att du kan interagera med systemet programmatiskt. Du kan använda Azure-portalen för att interagera med ett användargränssnitt.

MLflow syftar till att förenkla och standardisera processen för maskininlärningsutveckling, från experimentering till distribution.

Machine Learning integreras med Git-lagringsplatser så att du kan använda Git-kompatibla tjänster: GitHub, GitLab, Bitbucket, Azure DevOps eller en annan Git-kompatibel tjänst. Förutom de tillgångar som redan spåras i Machine Learning kan ditt team utveckla sin egen taxonomi i sin Git-kompatibla tjänst för att lagra annan projektinformation, till exempel:

- Dokumentation

- Projekt, till exempel den slutliga projektrapporten

- Datarapport, till exempel dataordlistan eller datakvalitetsrapporter

- Modell, till exempel modellrapporter

- Koden

- Dataförberedelse

- Modellutveckling

- Operationalisering, inklusive säkerhet och efterlevnad

Infrastruktur och resurser

TDSP ger rekommendationer för hantering av delad analys och lagringsinfrastruktur, till exempel:

- Molnfilsystem för lagring av datamängder

- Databaser

- Stordatakluster, till exempel SQL eller Spark

- Maskininlärningstjänster

Du kan placera analys- och lagringsinfrastrukturen, där rådata och bearbetade datamängder lagras, i molnet eller lokalt. Den här infrastrukturen möjliggör reproducerbar analys. Det förhindrar också duplicering, vilket kan leda till inkonsekvenser och onödiga infrastrukturkostnader. Infrastrukturen har verktyg för att etablera delade resurser, spåra dem och tillåta varje gruppmedlem att ansluta till dessa resurser på ett säkert sätt. Det är också en bra idé att låta projektmedlemmar skapa en konsekvent beräkningsmiljö. Olika teammedlemmar kan sedan replikera och validera experiment.

Här är ett exempel på ett team som arbetar med flera projekt och delar olika infrastrukturkomponenter för molnanalys:

Verktyg och hjälpmedel

I de flesta organisationer är det svårt att introducera processer. Infrastrukturen innehåller verktyg för att implementera TDSP och livscykeln för att minska hindren för och öka konsekvensen i deras införande.

Med Machine Learning kan dataexperter använda verktyg med öppen källkod som en del av data science-pipelinen eller arbetsflödet. Inom Machine Learning främjar Microsoft ansvarsfulla AI-verktyg, vilket hjälper till att uppnå Microsofts ansvarsfulla AI-standard.

Peer-granskade citat

TDSP är en väletablerad metod som används i Microsoft-åtaganden och har därför dokumenterats och studerats i peer-granskad litteratur. Dessa citat ger en möjlighet att undersöka TDSP-funktioner och program. En lista över citat finns på livscykelöversiktssidan .