Introduktion till instinktiva interaktioner

Filosofin om enkla, instinktiva interaktioner är sammanvävd i hela plattformen för mixad verklighet (MR). Vi har vidtagit tre åtgärder för att säkerställa att programdesigners och utvecklare kan ge sina kunder enkla och intuitiva interaktioner.

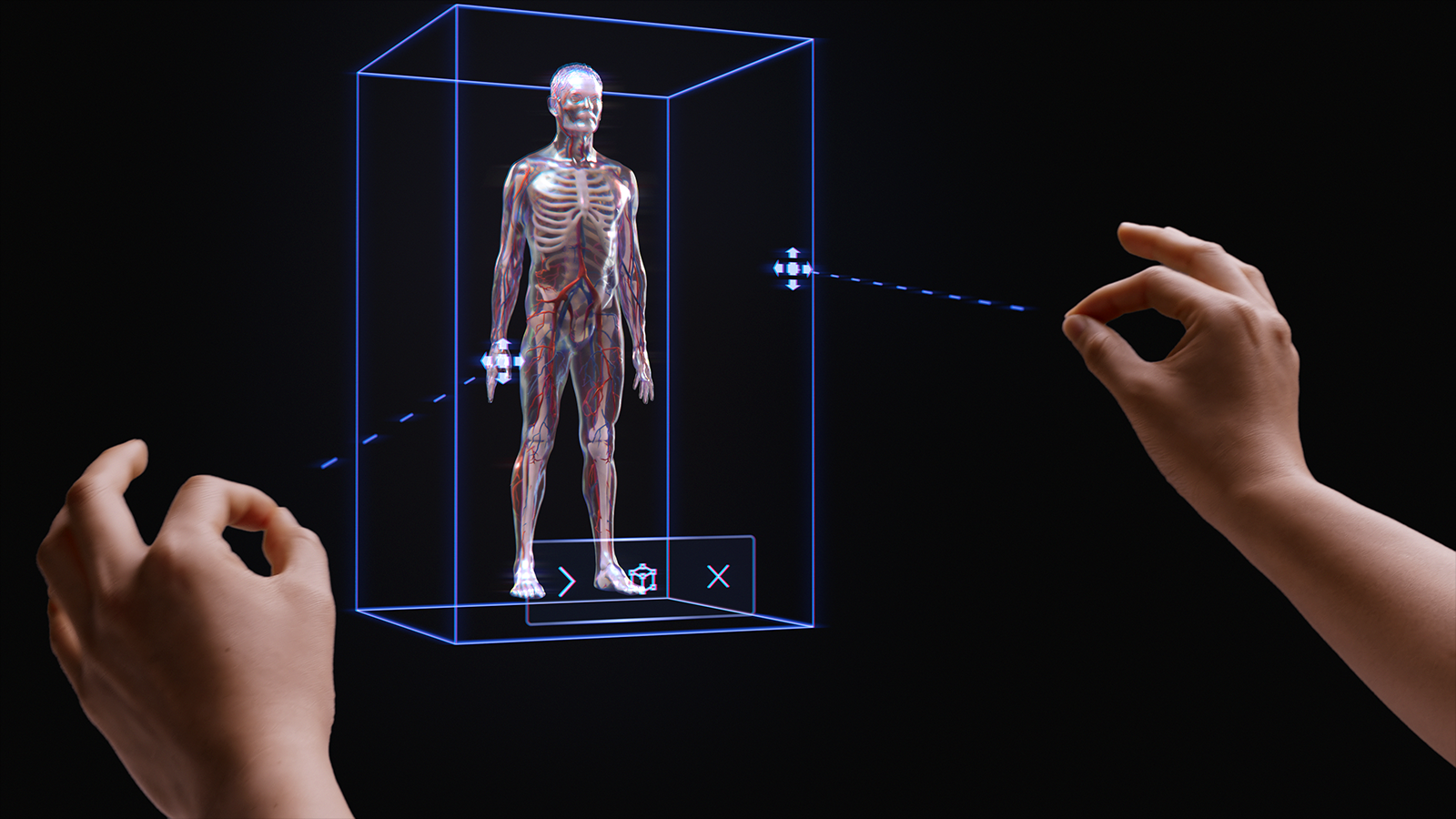

Först har vi sett till att våra sensorer och indatatekniker kombineras till multimodala interaktionsmodeller. Dessa interaktionsmodeller omfattar hand- och ögonspårning tillsammans med indata från naturligt språk. Baserat på vår forskning är design och utveckling inom ett multimodalt ramverk (och inte baserat på enskilda indata) nyckeln till att skapa instinktiva upplevelser.

För det andra inser vi att många utvecklare riktar in sig på flera HoloLens-enheter, till exempel HoloLens 2 och HoloLens (första generationen) eller HoloLens och VR. Därför har vi utformat våra interaktionsmodeller så att de fungerar på olika enheter, även om indatatekniken varierar på varje enhet. Till exempel använder långt interaktion på ett Windows Immersive-headset med en 6DoF-styrenhet och HoloLens 2 båda identiska råd och mönster. Detta gör det enkelt för programutveckling mellan enheter och ger en naturlig känsla för användarinteraktioner.

Även om vi inser att det finns tusentals effektiva, engagerande och magiska interaktioner som är möjliga i MR, har vi funnit att avsiktligt använda en enda interaktionsmodell i ett program är det bästa sättet att se till att användarna lyckas och har en bra upplevelse. Därför har vi inkluderat tre saker i den här interaktionsvägledningen:

- Specifik vägledning kring de tre primära interaktionsmodellerna och de komponenter och mönster som krävs för var och en.

- Kompletterande vägledning om andra fördelar som vår plattform ger.

- Allmän vägledning för att välja lämplig interaktionsmodell för ditt utvecklingsscenario.

Grundläggande demonstration av handspårning och instinktiva interaktioner

Kolla in vår videodemo för design av hologram – huvudspårning och ögonspårning nedan och gå sedan vidare till mer specifika ämnen:

Den här videon togs från appen "Designing Holograms" HoloLens 2. Ladda ned och njut av den fullständiga upplevelsen här.

Multimodala interaktionsmodeller

Baserat på vår forskning och feedback från kunder har vi upptäckt att tre primära interaktionsmodeller passar de flesta upplevelser med mixad verklighet. Interaktionsmodellen är på många sätt användarens mentala modell för att slutföra ett arbetsflöde. Var och en av dessa interaktionsmodeller är optimerad för en uppsättning kundbehov och är praktisk, kraftfull och användbar när den används korrekt.

Diagrammet nedan är en förenklad översikt. Detaljerad information för att använda varje interaktionsmodell länkas på sidorna nedan med bilder och kodexempel.

| Modell | Exempelscenarier | Anpassning | Maskinvara |

| Hand- och rörelsekontroller | Tredimensionella upplevelser, till exempel rumslayout och design, innehållsmanipulation eller simulering. | Perfekt för nya användare tillsammans med röst, ögonspårning och huvudriktning. Lätt att lära sig. Konsekvent UX för handspårning och 6DoF-kontroller. | HoloLens 2 Integrerande headset |

| Hands-free | Kontextuella upplevelser där en användares händer används, till exempel utbildning och underhåll på jobbet. | Viss utbildning krävs. Om händerna inte är tillgängliga kan enheten styras med röst och naturligt språk. | HoloLens 2 HoloLens (första generationen) Integrerande headset |

| Blick och genomför | Klicka dig igenom upplevelser, till exempel 3D-presentationer, demonstrationer. | Kräver utbildning på HMD:erna men inte på mobilen. Bäst för tillgängliga styrenheter. Bäst för HoloLens (1:a generationen). | HoloLens 2 HoloLens (första generationen) Integrerande headset Mobil AR |

För att undvika luckor i användarinteraktionen är det bäst att följa vägledningen för en enskild modell från början till slut.

I avsnitten nedan beskrivs stegen för att välja och implementera en av dessa interaktionsmodeller.

I slutet av den här sidan kommer du att förstå vår vägledning om:

- Välja en interaktionsmodell för kunden

- Implementera interaktionsmodellen

- Övergång mellan interaktionsmodeller

- Utforma nästa steg

Välj en interaktionsmodell för din kund

Vanligtvis har utvecklare och skapare tänkt igenom vilka typer av interaktioner som deras kunder kan ha. För att uppmuntra en kundfokuserad designmetod rekommenderar vi följande vägledning för att välja den interaktionsmodell som är optimerad för din kund.

Varför följa den här vägledningen?

- Vi testar våra interaktionsmodeller för objektiva och subjektiva kriterier, inklusive fysisk och kognitiv ansträngning, intuitivhet och inlärningsförmåga.

- Eftersom interaktionerna skiljer sig åt kan visuella/ljud-priser och objektbeteende skilja sig mellan interaktionsmodeller.

- Genom att kombinera delar av flera interaktionsmodeller ökar risken för konkurrerande priser, till exempel samtidiga handstrålar och en markör med huvud och blick. Detta kan överbelasta och förvirra användare.

Här är några exempel på hur råd och beteenden optimeras för varje interaktionsmodell. Vi ser ofta att nya användare har liknande frågor, till exempel "hur vet jag att systemet fungerar","hur vet jag vad jag kan göra" och "hur vet jag om det förstod vad jag just gjorde?"

| Modell | Hur gör jag för att vet att det fungerar? | Hur gör jag för att vet vad jag kan göra? | Hur gör jag för att vet vad jag just gjorde? |

| Hand- och rörelsekontroller | Jag ser ett handnät, en fingertoppsagens eller hand-/kontrollantstrålar. | Jag ser greppbara handtag, eller så visas en avgränsningsruta när min hand är nära ett objekt. | Jag hör hörbara toner och ser animationer på grab och release. |

| Huvud-blick och incheckning | Jag ser en markör i mitten av mitt visningsfält. | Markören ändrar tillstånd när den är över vissa objekt. | Jag ser/hör visuella och hörbara bekräftelser när jag vidtar åtgärder. |

| Handsfree (Huvud-blick och bo) | Jag ser en markör i mitten av mitt visningsfält. | Jag ser en förloppsindikator när jag bor på ett interaktionsbart objekt. | Jag ser/hör visuella och hörbara bekräftelser när jag vidtar åtgärder. |

| Handsfree (röstkommando) | Jag ser en lyssningsindikator och bildtexter som visar vad systemet hörde. | Jag får röstfrågor och tips. När jag säger: "Vad kan jag säga?" Jag ser feedback. | Jag ser/hör visuella och hörbara bekräftelser när jag ger ett kommando eller får tvetydighets-UX när det behövs. |

Nedan visas frågor om hur vi har hittat hjälpteam som väljer en interaktionsmodell:

F: Vill mina användare röra hologram och utföra holografiska precisionsmanipuleringar?

S: I så fall kan du kolla in interaktionsmodellen för händer och rörelsekontrollanter för precisionsmål och manipulering.F: Behöver mina användare hålla händerna fria för verkliga uppgifter?

S: Ta i så fall en titt på den handsfree-interaktionsmodellen, som ger en bra handsfree-upplevelse genom blick och röstbaserade interaktioner.F: Har mina användare tid att lära sig interaktioner för mitt MR-program eller behöver de interaktionerna med den lägsta möjliga inlärningskurvan?

S: För den lägsta inlärningskurvan och de mest intuitiva interaktionerna rekommenderar vi hands and motion controllers-modellen, så länge användarna kan använda händerna för interaktion.F: Använder mina användare rörelsekontrollanter för att peka och manipulera?

S: Hand- och rörelsestyrenhetsmodellen innehåller all vägledning för en bra upplevelse med rörelsekontrollanter.F: Använder mina användare en hjälpmedelskontrollant eller en vanlig Bluetooth-styrenhet, till exempel en klickare?

S: Vi rekommenderar modellen Med huvud och incheckning för alla icke-spårade kontrollanter. Den är utformad för att tillåta att en användare passerar en hel upplevelse med en enkel "mål- och incheckningsmekanism".F: Går mina användare bara igenom en upplevelse genom att "klicka igenom" (till exempel i en 3D-bildspelsliknande miljö), i stället för att navigera i täta layouter av UI-kontroller?

S: Om användarna inte behöver styra mycket användargränssnitt erbjuder Head-gaze and commit ett lärbart alternativ där användarna inte behöver oroa sig för att rikta sig.F: Använder mina användare både HoloLens (första generationen) och HoloLens 2/Windows Mixed Reality integrerande headset (VR)?

S: Eftersom head-gaze och commit är interaktionsmodellen för HoloLens (första generationen) rekommenderar vi att skapare som stöder HoloLens (första generationen) använder Huvud blick och genomför för alla funktioner eller lägen som användarna kommer att uppleva på ett HoloLens-headset (första generationen). Mer information om hur du skapar en bra upplevelse för flera HoloLens-generationer finns i nästa avsnitt om övergångsinteraktionsmodeller .F: Hur är det med användare som är mobila, täcker ett stort utrymme eller flyttar mellan utrymmen jämfört med användare som tenderar att arbeta i ett enda utrymme?

S: Vilken som helst av interaktionsmodellerna fungerar för dessa användare.

Anteckning

Mer vägledning som är specifik för appdesign kommer snart.

Övergångsinteraktionsmodeller

Det finns också användningsfall som kan kräva att fler än en interaktionsmodell används. Till exempel använder programmets skapandeflöde interaktionsmodellen "händer och rörelsekontrollanter", men du vill använda ett handsfree-läge för fälttekniker. Om din upplevelse kräver flera interaktionsmodeller kan användarna ha svårt att övergå från en modell till en annan, särskilt när de är nya för mixad verklighet.

Anteckning

Vi arbetar ständigt med mer vägledning som kommer att vara tillgänglig för utvecklare och designers och informerar dem om hur, när och varför för att använda flera MR-interaktionsmodeller.