Şirket içi Netezza sunucusundan Azure'a veri geçirmek için Azure Data Factory'yi kullanma

UYGULANANLAR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Bahşiş

Kuruluşlar için hepsi bir arada analiz çözümü olan Microsoft Fabric'te Data Factory'yi deneyin. Microsoft Fabric , veri taşımadan veri bilimine, gerçek zamanlı analize, iş zekasına ve raporlamaya kadar her şeyi kapsar. Yeni bir deneme sürümünü ücretsiz olarak başlatmayı öğrenin!

Azure Data Factory, verileri büyük ölçekte şirket içi Netezza sunucusundan Azure depolama hesabınıza veya Azure Synapse Analytics veritabanınıza geçirmek için yüksek performanslı, sağlam ve uygun maliyetli bir mekanizma sağlar.

Bu makalede veri mühendisleri ve geliştiriciler için aşağıdaki bilgiler sağlanır:

- Performans

- Dayanıklılığı kopyalama

- Ağ güvenliği

- Üst düzey çözüm mimarisi

- Uygulama için en iyi yöntemler

Performans

Azure Data Factory, çeşitli düzeylerde paralellik sağlayan sunucusuz bir mimari sunar. Geliştiriciyseniz bu, ortamınız için veri taşıma aktarım hızını en üst düzeye çıkarmak için hem ağ hem de veritabanı bant genişliğini tam olarak kullanmak üzere işlem hatları oluşturabileceğiniz anlamına gelir.

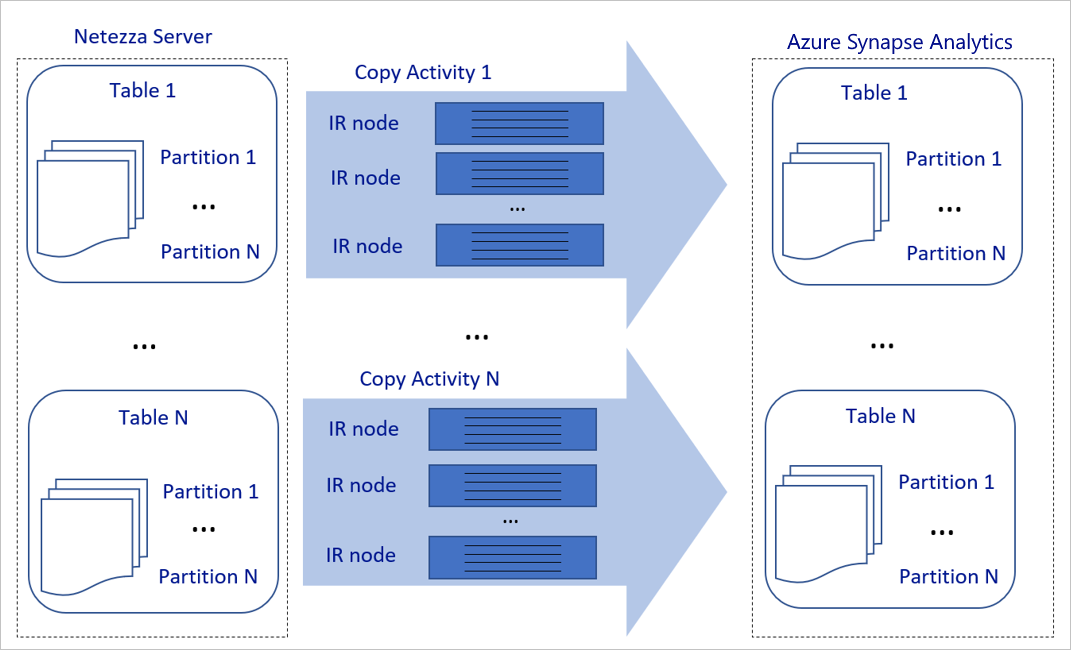

Yukarıdaki diyagram aşağıdaki gibi yorumlanabilir:

Tek bir kopyalama etkinliği ölçeklenebilir işlem kaynaklarından yararlanabilir. Azure Integration Runtime'ı kullandığınızda, her kopyalama etkinliği için sunucusuz bir şekilde en fazla 256 DIU belirtebilirsiniz. Şirket içinde barındırılan tümleştirme çalışma zamanı (şirket içinde barındırılan IR) ile makinenin ölçeğini el ile artırabilir veya ölçeği birden çok makineye genişletebilirsiniz (en fazla dört düğüm) ve tek bir kopyalama etkinliği, bölümü tüm düğümlere dağıtır.

Tek bir kopyalama etkinliği birden çok iş parçacığı kullanarak veri deposundan okur ve veri deposuna yazar.

Azure Data Factory denetim akışı birden çok kopyalama etkinliğini paralel olarak başlatabilir. Örneğin, bunları Her İçin döngüsü kullanarak başlatabilir.

Daha fazla bilgi için Kopyalama etkinliği performans ve ölçeklenebilirlik kılavuzuna bakın.

Dayanıklılık

Tek bir kopyalama etkinliği çalıştırması içinde Azure Data Factory'nin yerleşik bir yeniden deneme mekanizması vardır ve bu mekanizma, veri depolarındaki veya temel alınan ağdaki belirli bir geçici hata düzeyini işlemesini sağlar.

Azure Data Factory kopyalama etkinliğiyle, kaynak ve havuz veri depoları arasında veri kopyaladığınızda uyumsuz satırları işlemenin iki yolu vardır. Kopyalama etkinliğini durdurup başarısız olabilir veya uyumsuz veri satırlarını atlayarak verilerin geri kalanını kopyalamaya devam edebilirsiniz. Ayrıca, hatanın nedenini öğrenmek için Azure Blob depolama veya Azure Data Lake Store'da uyumsuz satırları günlüğe kaydedebilir, veri kaynağındaki verileri düzeltebilir ve kopyalama etkinliğini yeniden deneyebilirsiniz.

Ağ güvenliği

Varsayılan olarak Azure Data Factory, Köprü Metni Aktarım Protokolü Güvenli (HTTPS) üzerinden şifrelenmiş bir bağlantı kullanarak şirket içi Netezza sunucusundan azure depolama hesabına veya Azure Synapse Analytics veritabanına veri aktarır. HTTPS aktarım sırasında veri şifrelemesi sağlar ve gizlice dinleme ve ortadaki adam saldırılarını önler.

Alternatif olarak, verilerin genel İnternet üzerinden aktarılmasını istemiyorsanız, Azure Express Route aracılığıyla özel eşleme bağlantısı üzerinden veri aktararak daha yüksek güvenlik elde etmeye yardımcı olabilirsiniz.

Sonraki bölümde daha yüksek güvenlik elde etme konuları ele alınmaktadır.

Çözüm mimarisi

Bu bölümde verilerinizi geçirmenin iki yolu açıklanmıştır.

Verileri genel İnternet üzerinden geçirme

Yukarıdaki diyagram aşağıdaki gibi yorumlanabilir:

Bu mimaride, genel İnternet üzerinden HTTPS kullanarak verileri güvenli bir şekilde aktarırsınız.

Bu mimariyi elde etmek için Azure Data Factory tümleştirme çalışma zamanını (şirket içinde barındırılan) şirket güvenlik duvarının arkasındaki bir Windows makinesine yüklemeniz gerekir. Bu tümleştirme çalışma zamanının Netezza sunucusuna doğrudan erişebildiğinden emin olun. Verileri kopyalamak için ağınızın ve veri depolarınızın bant genişliğini tam olarak kullanmak için makinenizin ölçeğini el ile artırabilir veya ölçeği birden çok makineye genişletebilirsiniz.

Bu mimariyi kullanarak hem ilk anlık görüntü verilerini hem de delta verilerini geçirebilirsiniz.

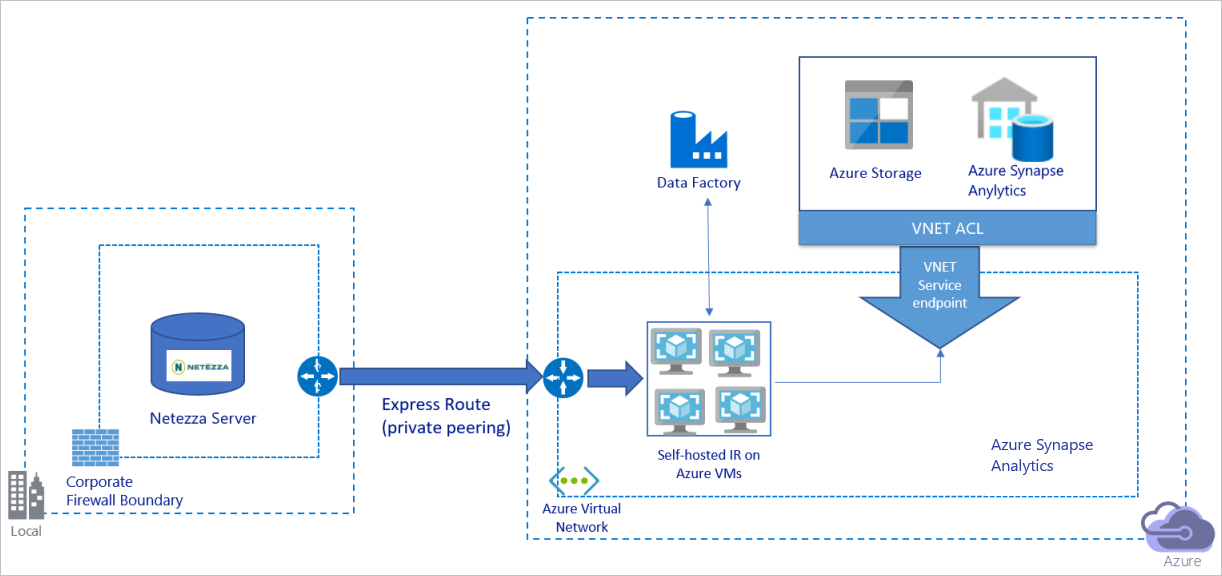

Verileri özel ağ üzerinden geçirme

Yukarıdaki diyagram aşağıdaki gibi yorumlanabilir:

Bu mimaride verileri Azure Express Route aracılığıyla özel eşleme bağlantısı üzerinden geçirirsiniz ve veriler hiçbir zaman genel İnternet üzerinden dolaşmaz.

Bu mimariyi elde etmek için Azure Data Factory tümleştirme çalışma zamanını (şirket içinde barındırılan) Azure sanal ağınızdaki bir Windows sanal makinesine (VM) yüklemeniz gerekir. Verileri kopyalamak için ağınızın ve veri depolarınızın bant genişliğini tam olarak kullanmak için VM'nizin ölçeğini el ile artırabilir veya ölçeği birden çok VM'ye genişletebilirsiniz.

Bu mimariyi kullanarak hem ilk anlık görüntü verilerini hem de delta verilerini geçirebilirsiniz.

En iyi yöntemleri uygulama

Kimlik doğrulama ve kimlik bilgilerini yönetme

Netezza'da kimlik doğrulaması yapmak için bağlantı dizesi aracılığıyla ODBC kimlik doğrulamasını kullanabilirsiniz.

Azure Blob depolamada kimlik doğrulaması yapmak için:

Azure kaynakları için yönetilen kimlikleri kullanmanızı kesinlikle öneririz. Microsoft Entra Id'de otomatik olarak yönetilen bir Azure Data Factory kimliğinin üzerine kurulan yönetilen kimlikler, Bağlı Hizmet tanımında kimlik bilgileri sağlamak zorunda kalmadan işlem hatlarını yapılandırmanıza olanak tanır.

Alternatif olarak hizmet sorumlusu, paylaşılan erişim imzası veya depolama hesabı anahtarı kullanarak Azure Blob depolamada kimlik doğrulaması yapabilirsiniz.

Azure Data Lake Storage 2. Nesil kimlik doğrulaması yapmak için:

Azure kaynakları için yönetilen kimlikleri kullanmanızı kesinlikle öneririz.

Hizmet sorumlusu veya depolama hesabı anahtarı da kullanabilirsiniz.

Azure Synapse Analytics'de kimlik doğrulaması yapmak için:

Azure kaynakları için yönetilen kimlikleri kullanmanızı kesinlikle öneririz.

Hizmet sorumlusu veya SQL kimlik doğrulaması da kullanabilirsiniz.

Azure kaynakları için yönetilen kimlikleri kullanmadığınızda, Azure Data Factory bağlı hizmetlerini değiştirmek zorunda kalmadan anahtarları merkezi olarak yönetmeyi ve döndürmeyi kolaylaştırmak için kimlik bilgilerini Azure Key Vault'ta depolamanızı kesinlikle öneririz. Bu aynı zamanda CI/CD için en iyi yöntemlerden biridir.

İlk anlık görüntü verilerini geçirme

Küçük tablolar için (yani hacmi 100 GB'ın altında olan veya iki saat içinde Azure'a geçirilebilen tablolar), her kopyalama işinin tablo başına veri yüklemesini sağlayabilirsiniz. Daha yüksek aktarım hızı için, aynı anda ayrı tablolar yüklemek için birden çok Azure Data Factory kopyalama işi çalıştırabilirsiniz.

Her kopyalama işinin içinde, paralel sorgular çalıştırmak ve bölümlere göre verileri kopyalamak için, aşağıdaki veri bölümü seçeneklerinden biriyle özellik ayarını kullanarak parallelCopies da bir paralellik düzeyine ulaşabilirsiniz:

Daha fazla verimlilik elde etmek için veri diliminden başlamanızı öneririz. Ayardaki değerin Netezza sunucusundaki

parallelCopiestablonuzdaki toplam veri dilimi bölümü sayısından az olduğundan emin olun.Her veri dilimi bölümünün hacmi hala büyükse (örneğin, 10 GB veya üzeri), dinamik aralık bölümüne geçmenizi öneririz. Bu seçenek, bölüm sayısını ve her bölümün hacmini bölüm sütununa, üst sınıra ve alt sınıra göre tanımlamak için daha fazla esneklik sağlar.

Daha büyük tablolar için (yani 100 GB veya daha büyük bir hacime sahip olan veya iki saat içinde Azure'a geçirilmeyecek tablolar) verileri özel sorguyla bölümlemenizi ve sonra her kopyalama işinin birer birer bir bölüm kopyalamasını sağlamanızı öneririz. Daha iyi aktarım hızı için birden çok Azure Data Factory kopyalama işini eşzamanlı olarak çalıştırabilirsiniz. Bir bölümü özel sorguyla yüklemenin her kopyalama işi hedefi için, veri dilimi veya dinamik aralık aracılığıyla paralelliği etkinleştirerek aktarım hızını artırabilirsiniz.

Ağ veya veri deposu geçici bir sorun nedeniyle herhangi bir kopyalama işi başarısız olursa, başarısız kopyalama işini yeniden çalıştırarak ilgili bölümü tablodan yeniden yükleyebilirsiniz. Diğer bölümleri yükleyen diğer kopyalama işleri etkilenmez.

Azure Synapse Analytics veritabanına veri yüklediğinizde, hazırlama olarak Azure Blob depolama ile kopyalama işi içinde PolyBase'i etkinleştirmenizi öneririz.

Delta verilerini geçirme

Tablonuzdaki yeni veya güncelleştirilmiş satırları tanımlamak için şemada bir zaman damgası sütunu veya artımlı anahtar kullanın. Ardından en son değeri bir dış tabloda yüksek filigran olarak depolayabilir ve verileri bir sonraki yükleyişinizde delta verilerini filtrelemek için kullanabilirsiniz.

Her tablo, yeni veya güncelleştirilmiş satırlarını tanımlamak için farklı bir filigran sütunu kullanabilir. Bir dış denetim tablosu oluşturmanızı öneririz. Tabloda, her satır Netezza sunucusunda belirli filigran sütun adı ve yüksek filigran değeri olan bir tabloyu temsil eder.

Şirket içinde barındırılan tümleştirme çalışma zamanını yapılandırma

Netezza sunucusundan Azure'a veri geçiriyorsanız, sunucunun şirket güvenlik duvarınızın arkasında veya sanal ağ ortamında olması fark etmeksizin, verileri taşımak için kullanılan altyapı olan bir Windows makinesine veya VM'ye şirket içinde barındırılan bir IR yüklemeniz gerekir. Şirket içinde barındırılan IR'yi yüklerken aşağıdaki yaklaşımı öneririz:

Her Windows makinesi veya VM için 32 vCPU ve 128 GB bellek yapılandırmasıyla başlayın. Veri geçişi sırasında IR makinesinin CPU ve bellek kullanımını izlemeye devam ederek daha iyi performans için makinenin ölçeğini artırmanız mı yoksa maliyetten tasarruf etmek için mi ölçeği azaltmanız gerektiğini görebilirsiniz.

Ayrıca, şirket içinde barındırılan tek bir IR ile en fazla dört düğüm ilişkilendirerek ölçeği genişletebilirsiniz. Şirket içinde barındırılan bir IR üzerinde çalışan tek bir kopyalama işi, verileri paralel olarak kopyalamak için tüm VM düğümlerini otomatik olarak uygular. Yüksek kullanılabilirlik için, veri geçişi sırasında tek bir hata noktasını önlemek için dört VM düğümüyle başlayın.

Bölümlerinizi sınırlama

En iyi uygulama olarak, her kopyalama etkinliği için uygun bölüm boyutunu belirleyebilmeniz için temsili bir örnek veri kümesiyle bir kavram kanıtı (POC) gerçekleştirin. Her bölümü iki saat içinde Azure'a yüklemenizi öneririz.

Tabloyu kopyalamak için, tek bir şirket içinde barındırılan IR makinesiyle tek bir kopyalama etkinliğiyle başlayın. Tablonuzdaki parallelCopies veri dilimi bölümlerinin sayısına göre ayarı aşamalı olarak artırın. Kopyalama işinin sonucunda elde edilecek aktarım hızına göre tablonun tamamının iki saat içinde Azure'a yüklenip yüklenemeyeceğini görün.

İki saat içinde Azure'a yüklenemediyse ve şirket içinde barındırılan IR düğümünün ve veri deposunun kapasitesi tam olarak kullanılmıyorsa, ağınızın sınırına veya veri depolarının bant genişliği sınırına ulaşana kadar eşzamanlı kopyalama etkinliklerinin sayısını kademeli olarak artırın.

Şirket içinde barındırılan IR makinesinde CPU ve bellek kullanımını izlemeye devam edin ve CPU ve belleğin tam olarak kullanıldığını gördüğünüzde makinenin ölçeğini artırmaya veya ölçeği birden çok makineye genişletmeye hazır olun.

Azure Data Factory kopyalama etkinliği tarafından bildirilen azaltma hatalarıyla karşılaştığınızda, Azure Data Factory'de eşzamanlılığı veya parallelCopies ayarı azaltın ya da ağ ve veri depolarının bant genişliği veya G/Ç işlemleri (IOPS) sınırlarını artırmayı göz önünde bulundurun.

Fiyatlandırmanızı tahmin edin

Şirket içi Netezza sunucusundan Azure Synapse Analytics veritabanına veri geçirmek için oluşturulan aşağıdaki işlem hattını göz önünde bulundurun:

Aşağıdaki deyimlerin doğru olduğunu varsayalım:

Toplam veri hacmi 50 terabayttır (TB).

İlk çözüm mimarisini kullanarak verileri geçiriyoruz (Netezza sunucusu şirket içinde, güvenlik duvarının arkasındadır).

50 TB birim 500 bölüme ayrılır ve her kopyalama etkinliği bir bölüm taşır.

Her kopyalama etkinliği, dört makinede şirket içinde barındırılan bir IR ile yapılandırılır ve saniyede 20 megabayt (MB/sn) aktarım hızına ulaşır. (Kopyalama etkinliğinde

parallelCopies4 olarak ayarlanır ve tablodan veri yüklenecek her iş parçacığı 5 MB/sn aktarım hızına ulaşır.)ForEach eşzamanlılığı 3 olarak ayarlanır ve toplam aktarım hızı 60 MB/sn'dir.

Geçişin tamamlanması toplamda 243 saat sürer.

Yukarıdaki varsayımlara göre tahmini fiyat şu şekildedir:

Dekont

Önceki tabloda gösterilen fiyatlandırma varsayımsaldır. Gerçek fiyatlandırmanız ortamınızdaki gerçek aktarım hızına bağlıdır. Windows makinesinin fiyatı (şirket içinde barındırılan IR yüklü) dahil değildir.

Ek başvurular

Daha fazla bilgi için aşağıdaki makalelere ve kılavuzlara bakın:

- Netezza bağlayıcısı

- ODBC bağlayıcısı

- Azure Blob depolama bağlayıcısı

- Azure Data Lake Storage 2. Nesil bağlayıcısı

- Azure Synapse Analytics bağlayıcısı

- Kopyalama etkinliği performans ayarlama kılavuzu

- Şirket içinde barındırılan tümleştirme çalışma zamanı oluşturma ve yapılandırma

- Şirket içinde barındırılan tümleştirme çalışma zamanı HA ve ölçeklenebilirlik

- Veri taşıma güvenliğiyle ilgili dikkat edilmesi gerekenler

- Kimlik bilgilerini Azure Key Vault'ta depolama

- Bir tablodan artımlı olarak veri kopyalama

- Birden çok tablodan artımlı olarak veri kopyalama

- Azure Data Factory fiyatlandırma sayfası