Veri işlem hattı için kaynak verileri keşfetme

Veri işlem hattı oluşturmanın yaygın bir ilk adımı, işlem hattının kaynak verilerini anlamaktır. Bu adımda, kaynak verileri ve yapıtları incelemek için bir not defterinde Databricks Yardımcı Programları ve PySpark komutlarını çalıştıracaksınız.

Keşif veri analizi hakkında daha fazla bilgi edinmek için bkz . Azure Databricks'te keşif veri analizi: Araçlar ve teknikler.

Video: Databricks not defterlerine giriş

Databricks not defterlerine giriş için şu videoyu izleyin:

Veri araştırma not defteri oluşturma

Kenar çubuğunda Yeni'ye tıklayın

ve menüden Not Defteri'ni seçin. Not defteri, değiştirebileceğiniz varsayılan bir adla açılır.

ve menüden Not Defteri'ni seçin. Not defteri, değiştirebileceğiniz varsayılan bir adla açılır.Not defteri için bir ad girin; örneğin,

Explore songs data. Varsayılan olarak:- Seçilen dil Python'dır .

- Not defteri, kullandığınız son kümeye eklenir. Bu durumda, 1. Adım: Küme oluşturma bölümünde oluşturduğunuz küme.

Veri kümesini içeren dizinin içeriğini görüntülemek için, not defterinin ilk hücresine aşağıdakileri girin, öğesine tıklayın

ve Hücreyi Çalıştır'ı seçin.

ve Hücreyi Çalıştır'ı seçin.%fs ls "/databricks-datasets/songs/data-001"yol Adı size modificationTime 1 dbfs:/databricks-datasets/songs/README.md BENİOKU.md 1719 1454620183000 2 dbfs:/databricks-datasets/songs/data-001/ data-001/ 0 1672791237846 3 dbfs:/databricks-datasets/songs/data-002/ data-002/ 0 1672791237846

Verileri keşfetme

README dosyasında veri kümesi hakkında veri şemasının açıklaması da dahil olmak üzere bilgiler bulunur. Şema bilgileri, verileri alırken sonraki adımda kullanılır. BENİOKU içeriğini görüntülemek için hücre eylemleri menüsüne tıklayın

, Altına Hücre Ekle'yi seçin, yeni hücreye aşağıdakileri girin, öğesine tıklayın

, Altına Hücre Ekle'yi seçin, yeni hücreye aşağıdakileri girin, öğesine tıklayın  ve Hücreyi Çalıştır'ı seçin.

ve Hücreyi Çalıştır'ı seçin.%fs head --maxBytes=10000 "/databricks-datasets/songs/README.md"Sample of Million Song Dataset =============================== ## Source This data is a small subset of the [Million Song Dataset](http://labrosa.ee.columbia.edu/millionsong/). The original data was contributed by The Echo Nest. Prepared by T. Bertin-Mahieux <tb2332 '@' columbia.edu> ## Attribute Information - artist_id:string - artist_latitude:double - artist_longitude:double - artist_location:string - artist_name:string - duration:double - end_of_fade_in:double - key:int - key_confidence:double - loudness:double - release:string - song_hotnes:double - song_id:string - start_of_fade_out:double - tempo:double - time_signature:double - time_signature_confidence:double - title:string - year:double - partial_sequence:int ...Bu örnekte kullanılan kayıtlar dizindedir

/databricks-datasets/songs/data-001/. Bu dizinin içeriğini görüntülemek için hücre eylemleri menüsüne tıklayın , Altına Hücre Ekle'yi seçin, yeni hücreye aşağıdakileri girin, öğesine tıklayın

, Altına Hücre Ekle'yi seçin, yeni hücreye aşağıdakileri girin, öğesine tıklayın  ve Hücreyi Çalıştır'ı seçin.

ve Hücreyi Çalıştır'ı seçin.%fs ls "/databricks-datasets/songs/data-001"yol Adı size modificationTime 1 dbfs:/databricks-datasets/songs/data-001/header.txt header.txt 377 1454633901000 2 dbfs:/databricks-datasets/songs/data-001/part-00000 bölüm 00000 52837 1454547464000 3 dbfs:/databricks-datasets/songs/data-001/part-00001 bölüm 00001 52469 1454547465000 BENİOKU ve dosya adları dosya biçimini belirtmediğinden, her kaydın içeriğini ve biçimini daha iyi anlamak için kayıtların bir örneğini görüntüleyebilirsiniz. Veri dosyalarından birinden ilk on kaydı okumak ve görüntülemek için hücre eylemleri menüsüne tıklayın

, Altına Hücre Ekle'yi seçin, yeni hücreye aşağıdakileri girin, öğesine tıklayın

, Altına Hücre Ekle'yi seçin, yeni hücreye aşağıdakileri girin, öğesine tıklayın ve Hücreyi Çalıştır'ı seçin.

ve Hücreyi Çalıştır'ı seçin.%fs head --maxBytes=10000 "/databricks-datasets/songs/data-001/part-00000"AR81V6H1187FB48872 nan nan Earl Sixteen 213.7073 0.0 11 0.419 -12.106 Soldier of Jah Army nan SOVNZSZ12AB018A9B8 208.289 125.882 1 0.0 Rastaman 2003 -- ARVVZQP11E2835DBCB nan nan Wavves 133.25016 0.0 0 0.282 0.596 Wavvves 0.471578247701 SOJTQHQ12A8C143C5F 128.116 89.519 1 0.0 I Want To See You (And Go To The Movies) 2009 -- ARFG9M11187FB3BBCB nan nan Nashua USA C-Side 247.32689 0.0 9 0.612 -4.896 Santa Festival Compilation 2008 vol.1 nan SOAJSQL12AB0180501 242.196 171.278 5 1.0 Loose on the Dancefloor 0 225261 ...Kayıtların bir örneğini görüntüleyerek veriler hakkında birkaç şey gözlemleyebilirsiniz. Bu gözlemleri daha sonra verileri işlerken kullanacaksınız:

- Kayıtlar üst bilgi içermiyor. Bunun yerine, üst bilgi aynı dizinde ayrı bir dosyada depolanır.

- Dosyalar sekmeyle ayrılmış değer (TSV) biçiminde görünüyor.

- Bazı alanlar eksik veya geçersiz.

- Kayıtlar üst bilgi içermiyor. Bunun yerine, üst bilgi aynı dizinde ayrı bir dosyada depolanır.

Verileri daha fazla araştırmak ve analiz etmek için bu gözlemleri kullanarak TSV biçimli şarkı verilerini PySpark DataFrame'e yükleyin. Bunu yapmak için hücre eylemleri menüsüne tıklayın

, Altına Hücre Ekle'yi seçin, yeni hücreye aşağıdaki kodu girin ve ardından Hücreyi Çalıştır'a tıklayın>

, Altına Hücre Ekle'yi seçin, yeni hücreye aşağıdaki kodu girin ve ardından Hücreyi Çalıştır'a tıklayın> .

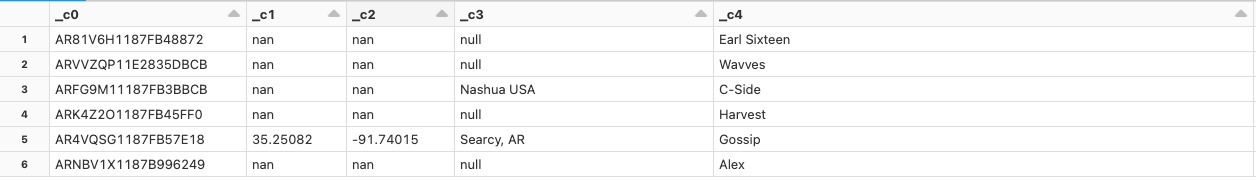

.df = spark.read.format('csv').option("sep", "\t").load('dbfs:/databricks-datasets/songs/data-001/part-00000') df.display()Veri dosyasında üst bilgi eksik olduğundan, sütun adları ,

_c1vb. olarak_c0görüntülenir. Her sütun, gerçek veri türünden bağımsız olarakstringyorumlanır. Sonraki adımda ham verilerin alımı, verileri yüklerken geçerli bir şemayı nasıl uygulayabileceğinize ilişkin bir örnek gösterir.

Geri Bildirim

Çok yakında: 2024 boyunca, içerik için geri bildirim mekanizması olarak GitHub Sorunları’nı kullanımdan kaldıracak ve yeni bir geri bildirim sistemiyle değiştireceğiz. Daha fazla bilgi için bkz. https://aka.ms/ContentUserFeedback.

Gönderin ve geri bildirimi görüntüleyin