Azure Databricks İş Akışlarına Giriş

Azure Databricks İş Akışları Databricks Veri Zekası Platformu'nda veri işleme, makine öğrenmesi ve analiz işlem hatlarını düzenler. İş akışları, Azure Databricks çalışma alanınızda etkileşimli olmayan kod çalıştırmaya yönelik Azure Databricks İşleri ve güvenilir ve sürdürülebilir ETL işlem hatları oluşturmak için Delta Live Tabloları dahil olmak üzere Databricks platformuyla tümleştirilmiş tam olarak yönetilen düzenleme hizmetlerine sahiptir.

Databricks platformuyla iş akışlarınızı düzenlemenin avantajları hakkında daha fazla bilgi edinmek için bkz . Databricks İş Akışları.

Örnek bir Azure Databricks iş akışı

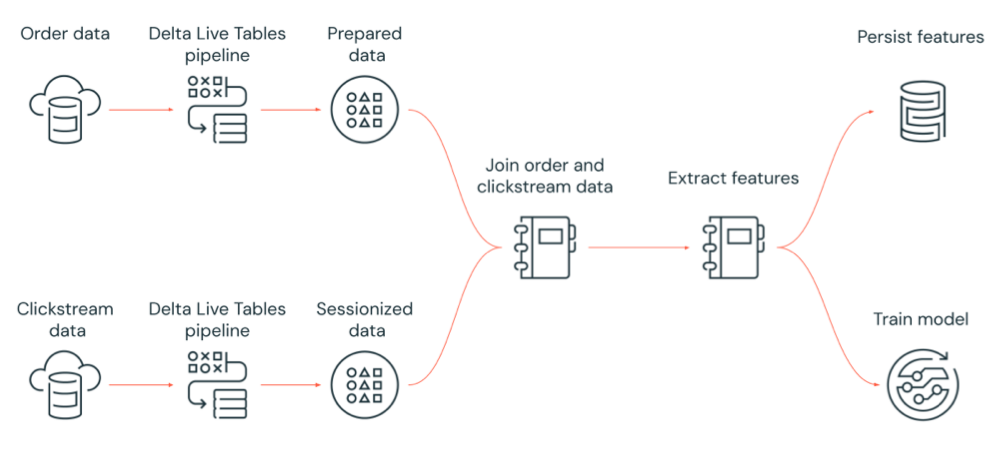

Aşağıdaki diyagramda Azure Databricks işi tarafından yönetilen bir iş akışı gösterilmektedir:

- Bulut depolamadan ham tıklama akışı verilerini alan, verileri temizleyen ve hazırlayan, verileri oturuma alan ve son oturuma alınan veri kümesini Delta Lake olarak kalıcı hale getiren bir Delta Live Tables işlem hattı çalıştırın.

- Bulut depolama alanından sipariş verilerini alan, verileri işlenmek üzere temizleyip dönüştüren ve son veri kümesini Delta Lake olarak kalıcı hale getiren bir Delta Live Tables işlem hattı çalıştırın.

- Analiz için yeni bir veri kümesi oluşturmak için sıralı ve oturumlu tıklama akışı verilerine katılın.

- Hazırlanan verilerden özellikleri ayıklayın.

- Özellikleri kalıcı hale getirmek ve makine öğrenmesi modelini eğitmek için görevleri paralel olarak gerçekleştirin.

Azure Databricks İşleri nedir?

Azure Databricks işi, veri işleme ve analiz uygulamalarınızı bir Azure Databricks çalışma alanında çalıştırmanın bir yoludur. İşiniz tek bir görevden oluşabilir veya karmaşık bağımlılıklara sahip büyük, çok görevli bir iş akışı olabilir. Azure Databricks tüm işleriniz için görev düzenleme, küme yönetimi, izleme ve hata raporlama süreçlerini yönetir. İşlerinizi hemen, düzenli aralıklarla kullanımı kolay bir zamanlama sistemi aracılığıyla, dış konuma yeni dosyalar geldiğinde çalıştırabilir veya işin bir örneğinin her zaman çalıştığından emin olmak için sürekli olarak çalıştırabilirsiniz. İşleri not defteri kullanıcı arabiriminde etkileşimli olarak da çalıştırabilirsiniz.

İşler kullanıcı arabirimini, Databricks CLI'yı kullanarak veya İşler API'sini çağırarak iş oluşturabilir ve çalıştırabilirsiniz. Kullanıcı arabirimini veya API’yi kullanarak başarısız veya iptal edilmiş bir işi onarabilir ve yeniden çalıştırabilirsiniz. kullanıcı arabirimi, CLI, API ve bildirimleri (örneğin, e-posta, web kancası hedefi veya Slack bildirimleri) kullanarak iş çalıştırma sonuçlarını izleyebilirsiniz.

Databricks CLI'yı kullanma hakkında bilgi edinmek için bkz . Databricks CLI nedir?. İşler API'sini kullanma hakkında bilgi edinmek için bkz. İşler API'sini.

Aşağıdaki bölümlerde Azure Databricks İşleri'nin önemli özellikleri ele alınıyor.

Önemli

- Çalışma alanı 1000 eşzamanlı görev çalıştırması ile sınırlıdır. Hemen başlatılamayan bir çalıştırma istediğinizde

429 Too Many Requestsyanıtı döndürülür. - Bir çalışma alanının bir saat içinde oluşturabileceği iş sayısı 10000 ile sınırlıdır ("çalıştırma göndermeyi içerir"). Bu sınır ayrıca REST API ve not defteri iş akışları tarafından oluşturulan işleri de etkiler.

İş görevleriyle veri işleme ve analiz uygulama

Görevleri kullanarak veri işleme ve analiz iş akışınızı uygularsınız. İş bir veya daha fazla görevden oluşur. Not defterleri, JARS, Delta Live Tables işlem hatlarını veya Python, Scala, Spark gönderme ve Java uygulamalarını çalıştıran iş görevleri oluşturabilirsiniz. İş görevleriniz analizler ve görselleştirmeler oluşturmak için Databricks SQL sorgularını, uyarılarını ve panolarını da düzenleyebilir veya dbt görevini kullanarak iş akışınızda dbt dönüşümlerini çalıştırabilirsiniz. Eski Spark Gönderme uygulamaları da desteklenir.

Ayrıca, farklı bir iş çalıştıran bir işe görev ekleyebilirsiniz. Bu özellik, büyük bir işlemi birden çok küçük işe bölmenize veya birden çok iş tarafından yeniden kullanılabilecek genelleştirilmiş modüller oluşturmanıza olanak tanır.

Görevler arasındaki bağımlılıkları belirterek görevlerin yürütme sırasını denetleyebilirsiniz. Görevleri sıralı veya paralel çalışacak şekilde yapılandırabilirsiniz.

İşleri etkileşimli, sürekli olarak veya iş tetikleyicilerini kullanarak çalıştırma

İşlerinizi İşler kullanıcı arabiriminden, API'den veya CLI'dan etkileşimli olarak çalıştırabilir veya sürekli bir iş çalıştırabilirsiniz. Amazon S3, Azure depolama veya Google Cloud storage gibi bir dış konuma yeni dosyalar geldiğinde işinizi düzenli aralıklarla çalıştırmak veya işinizi çalıştırmak için bir zamanlama oluşturabilirsiniz.

Bildirimlerle iş ilerleme durumunu izleme

bir iş veya görev başlatıldığında, tamamlandığında veya başarısız olduğunda bildirim alabilirsiniz. Bir veya daha fazla e-posta adresine veya sistem hedefine (örneğin, web kancası hedefleri veya Slack) bildirim gönderebilirsiniz. bkz. İş olayları için e-posta ve sistem bildirimleri ekleme.

Azure Databricks işlem kaynaklarıyla işlerinizi çalıştırma

Databricks kümeleri ve SQL ambarları, işleriniz için hesaplama kaynaklarını sağlar. İşlerinizi bir iş kümesi, çok amaçlı bir küme veya SQL ambarı ile çalıştırabilirsiniz:

- İş kümesi, işiniz veya tek tek iş görevleriniz için ayrılmış bir kümedir. İşiniz tüm görevler tarafından paylaşılan bir iş kümesi kullanabilir veya bir görevi oluştururken veya düzenlerken tek tek görevler için bir küme yapılandırabilirsiniz. İş veya görev başladığında ve iş veya görev sona erdiğinde bir iş kümesi oluşturulur.

- Çok amaçlı küme, el ile başlatılan ve sonlandırılan ve birden çok kullanıcı ve iş tarafından paylaşılabilen paylaşılan bir kümedir.

Databricks, kaynak kullanımını iyileştirmek için işleriniz için bir iş kümesi kullanmanızı önerir. Küme başlatmayı beklerken harcanan süreyi azaltmak için, çok amaçlı bir küme kullanmayı göz önünde bulundurun. Bkz . Azure Databricks işlem'i işlerinizle kullanma.

Sorgular, panolar veya uyarılar gibi Databricks SQL görevlerini çalıştırmak için sql ambarı kullanırsınız. Dbt göreviyle dbt dönüşümlerini çalıştırmak için bir SQL ambarı da kullanabilirsiniz.

Sonraki adımlar

Azure Databricks İşleri'ne başlamak için:

Hızlı başlangıç ile ilk Azure Databricks işinizi oluşturun.

Azure Databricks İşleri kullanıcı arabirimiyle iş akışları oluşturmayı ve çalıştırmayı öğrenin.

Sunucusuz iş akışlarıyla Azure Databricks işlem kaynaklarını yapılandırmak zorunda kalmadan bir işi çalıştırmayı öğrenin.

Azure Databricks İşleri kullanıcı arabiriminde iş çalıştırmalarını izleme hakkında bilgi edinin.

İşler için yapılandırma seçenekleri hakkında bilgi edinin.

Azure Databricks İşleri ile iş akışları oluşturma, yönetme ve sorun giderme hakkında daha fazla bilgi edinin:

- Azure Databricks işinde görev değerleriyle görevler arasında bilgi iletmeyi öğrenin.

- görev parametresi değişkenleriyle iş görevlerine iş çalıştırmaları hakkında bağlam geçirmeyi öğrenin.

- İş görevlerinizi, görevin bağımlılıklarının durumuna göre koşullu olarak çalışacak şekilde yapılandırmayı öğrenin.

- Başarısız işlerin sorunlarını gidermeyi ve düzeltmeyi öğrenin.

- İş çalıştırma bildirimleriyle işiniz başlatıldığında, tamamlandığında veya başarısız olduğunda bildirim alın.

- İşlerinizi özel bir zamanlamaya göre tetikleyin veya sürekli bir iş çalıştırın.

- Dosya varış tetikleyicileriyle yeni veriler geldiğinde Azure Databricks işinizi çalıştırmayı öğrenin.

- databricks işlem kaynaklarını kullanarak işlerinizi çalıştırmayı öğrenin.

- Azure Databricks işleri ile iş akışı oluşturmayı ve yönetmeyi desteklemek için İşler API'sine yönelik güncelleştirmeler hakkında bilgi edinin.

- Azure Databricks İşleri ile veri iş akışlarını uygulama hakkında daha fazla bilgi edinmek için nasıl yapılır kılavuzlarını ve öğreticileri kullanın.

Delta Live Tables nedir?

Not

Delta Live Tables, Premium planı gerektirir. Daha fazla bilgi için Databricks hesap ekibinize başvurun.

Delta Live Tables, ETL ve akış veri işlemeyi basitleştiren bir çerçevedir. Delta Live Tables, veri dönüşümlerinin bildirim temelli uygulanmasını destekleyen Otomatik Yükleyici, SQL ve Python arabirimleri için yerleşik destek ve Delta Lake'e dönüştürülmüş veri yazma desteği ile verilerin verimli bir şekilde alımını sağlar. Verileriniz üzerinde gerçekleştirilecek dönüştürmeleri tanımlarsınız ve Delta Live Tables görev düzenleme, küme yönetimi, izleme, veri kalitesi ve hata işlemeyi yönetir.

Başlamak için bkz . Delta Live Tables nedir?.

Azure Databricks İşleri ve Delta Live Tabloları

Azure Databricks İşleri ve Delta Live Tabloları, uçtan uca veri işleme ve analiz iş akışları oluşturmaya ve dağıtmaya yönelik kapsamlı bir çerçeve sağlar.

Verilerin tüm alımı ve dönüşümü için Delta Live Tablolarını kullanın. Tek bir görevden veya Delta Live Tables alımı ve dönüşümü dahil olmak üzere Databricks platformunda birden çok veri işleme ve analiz görevinden oluşan iş yüklerini yönetmek için Azure Databricks İşleri'ni kullanın.

İş akışı düzenleme sistemi olarak Azure Databricks İşleri şunları da destekler:

- İşleri tetiklenmiş bir şekilde çalıştırma, örneğin bir iş akışını zamanlamaya göre çalıştırma.

- SQL sorguları aracılığıyla veri analizi, not defterleri, betikler veya dış kitaplıklarla makine öğrenmesi ve veri analizi vb.

- Tek bir görevden oluşan bir işi çalıştırma, örneğin JAR içinde paketlenmiş bir Apache Spark işi çalıştırma.

Apache AirFlow ile iş akışı düzenleme

Databricks, veri iş akışlarınızı yönetmek ve zamanlamak için Azure Databricks İşleri'nin kullanılmasını önerse de Apache Airflow'u da kullanabilirsiniz. Airflow ile iş akışınızı bir Python dosyasında tanımlarsınız ve Airflow iş akışını zamanlamayı ve çalıştırmayı yönetir. Bkz. Apache Airflow ile Azure Databricks işlerini düzenleme.

Azure Data Factory ile iş akışı düzenleme

Azure Data Factory (ADF), otomatik veri işlem hatlarında veri depolama, taşıma ve işleme hizmetleri oluşturmanıza olanak tanıyan bir bulut veri tümleştirme hizmetidir. ADF'yi kullanarak bir Azure Databricks işini ADF işlem hattının bir parçası olarak düzenleyebilirsiniz.

ADF'den Azure Databricks'e kimlik doğrulaması da dahil olmak üzere ADF Web etkinliğini kullanarak iş çalıştırmayı öğrenmek için bkz . Azure Data Factory'den Azure Databricks işleri düzenlemesinden yararlanma.

ADF ayrıca Databricks not defterlerini, Python betiklerini veya ADF işlem hattındaki JAR'lerde paketlenmiş kodu çalıştırmak için yerleşik destek sağlar.

Databricks not defterini bir ADF işlem hattında çalıştırmayı öğrenmek için bkz . Azure Data Factory'de Databricks not defteri etkinliğiyle Databricks not defteri çalıştırma ve ardından Databricks not defteri çalıştırarak verileri dönüştürme.

ADF işlem hattında Python betiğini çalıştırmayı öğrenmek için bkz . Azure Databricks'te Python etkinliği çalıştırarak verileri dönüştürme.

ADF işlem hattında JAR içinde paketlenmiş kodu çalıştırmayı öğrenmek için bkz . Azure Databricks'te JAR etkinliği çalıştırarak verileri dönüştürme.

Geri Bildirim

Çok yakında: 2024 boyunca, içerik için geri bildirim mekanizması olarak GitHub Sorunları’nı kullanımdan kaldıracak ve yeni bir geri bildirim sistemiyle değiştireceğiz. Daha fazla bilgi için bkz. https://aka.ms/ContentUserFeedback.

Gönderin ve geri bildirimi görüntüleyin