設定個人化工具學習迴圈

重要

從 2023 年 9 月 20 日起,您將無法建立新的個人化工具資源。 個人化工具服務將于 2026 年 10 月 1 日淘汰。

服務設定包括服務如何處理獎勵、服務探索的頻率、重新定型模型的頻率,以及儲存多少資料。

在 [組態 ] 頁面上,在該個人化工具資源的Azure 入口網站中設定學習迴圈 。

規劃設定變更

由於某些組態變更 會重設您的模型 ,因此您應該規劃設定變更。

如果您打算使用 學徒模式 ,請務必先檢閱個人化工具設定,再切換至學徒模式。

包含重設模型的設定

下列動作會使用過去 2 天可用的資料來觸發模型的重新定型。

- 獎勵

- 探索

若要 清除 所有資料,請使用 [模型和學習設定 ] 頁面。

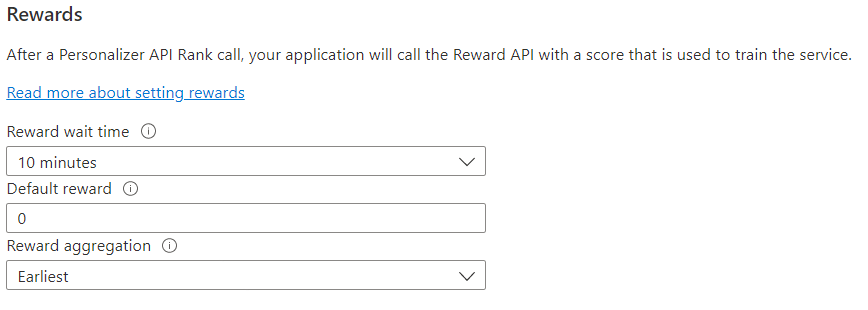

設定意見反應迴圈的獎勵

為學習迴圈使用獎勵設定服務。 下列值的變更將會重設目前的個人化工具模型,並使用過去 2 天的資料重新定型。

| 值 | 目的 |

|---|---|

| 奬勵等待時間 | 設定個人化工具從排名呼叫開始的時間長度,從排名呼叫開始收集獎勵值的時間長度。 系統會詢問下列問題來設定此值:「個人化工具應該等候報酬呼叫多久?」在此時段過後才抵達的報酬會記錄下來,但不會用於學習。 |

| 預設奬勵 | 如果在與排名通話相關聯的獎勵等候時間時段期間,個人化工具未收到任何獎勵通話,個人化工具將會指派預設獎勵。 根據預設,在大部分情況下,預設獎勵為零 (0)。 |

| 奬勵彙總 | 如果收到相同排名 API 呼叫的多個獎勵,則會使用這個匯總方法: sum 或 最早 。 「最早」會挑選最早收到的分數,並捨棄其餘分數。 如果您想要在可能重複的呼叫之間取得唯一的獎勵,這會很有用。 |

變更這些值之後,請務必選取 [ 儲存 ]。

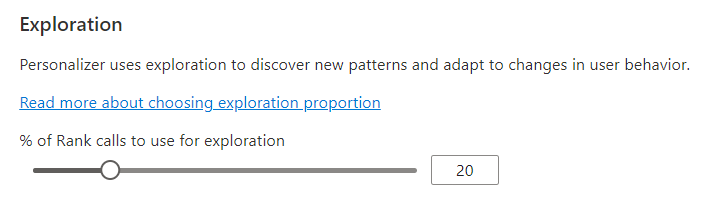

設定探索以允許學習迴圈進行調整

個人化能夠探索新的模式,並透過探索替代專案,而不是使用定型模型的預測,來探索新的模式並適應使用者行為變更。 探 勘 值會決定使用探索接聽排名呼叫的百分比。

此值的變更將會重設目前的個人化工具模型,並使用過去 2 天的資料重新定型。

變更此值之後,請務必選取 [ 儲存 ]。

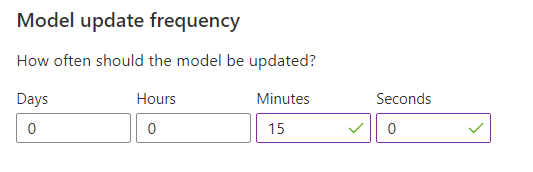

設定模型定型的模型更新頻率

模型 更新頻率 會設定模型定型的頻率。

| 頻率設定 | 目的 |

|---|---|

| 1 分鐘 | 使用個人化工具對應用程式的程式碼進行偵錯、執行示範或以互動方式測試機器學習層面時 ,一分鐘的更新頻率很有用。 |

| 15 分鐘 | 高模型更新頻率適用于您想要 密切追蹤使用者行為變更 的情況。 範例包括即時新聞、病毒內容或即時產品投標上執行的網站。 您可以在這些案例中使用 15 分鐘的頻率。 |

| 1 小時 | 在大部分的使用案例中,更新頻率較低是有效的。 |

變更此值之後,請務必選取 [ 儲存 ]。

資料保留

資料保留期間 會設定個人化工具保留資料記錄的天數。 過去的資料記錄需要執行 離線評估 ,用來測量個人化工具的有效性,並將學習原則優化。

變更此值之後,請務必選取 [ 儲存 ]。