Získání z toku dat 1. generace do generace 2

Tok dat Gen2 je nová generace toků dat. Nová generace toků dat se nachází společně s tokem dat Power BI (Gen1) a přináší nové funkce a vylepšené prostředí. Následující část obsahuje porovnání mezi Tokem Dat Gen1 a Dataflow Gen2.

Přehled funkcí

| Funkce | Tok dat Gen2 | Tok dat Gen1 |

|---|---|---|

| Vytváření toků dat pomocí Power Query | ✓ | ✓ |

| Kratší tok vytváření | ✓ | |

| Automatické ukládání a publikování na pozadí | ✓ | |

| Cíle dat | ✓ | |

| Vylepšená historie monitorování a aktualizace | ✓ | |

| Integrace s datovými kanály | ✓ | |

| Vysokokapacitní výpočetní prostředky | ✓ | |

| Získání dat přes konektor Toky dat | ✓ | ✓ |

| Direct Query prostřednictvím konektoru Toky dat | ✓ | |

| Přírůstková aktualizace | ✓ | |

| podpora Přehledy AI | ✓ |

Kratší prostředí pro vytváření obsahu

Práce s Tokem Dat Gen2 se podobá příchodu domů. Zachovali jsme úplné prostředí Power Query, na které jste zvyklí v tocích dat Power BI. Když zadáte prostředí, provedete podrobné pokyny k získání dat do toku dat. Zkracujeme také prostředí pro vytváření obsahu, abychom snížili počet kroků potřebných k vytvoření toků dat a přidali několik nových funkcí, aby bylo prostředí ještě lepší.

Nové prostředí pro ukládání toku dat

S tokem dat Gen2 jsme změnili způsob, jakým funguje ukládání toku dat. Všechny změny toku dat se automaticky ukládají do cloudu. Proto můžete prostředí pro vytváření kdykoli ukončit a pokračovat tam, kde jste skončili později. Po vytvoření toku dat publikujete změny a tyto změny se použijí při aktualizaci toku dat. Kromě toho publikování toku dat uloží vaše změny a spustí ověření, která se musí provést na pozadí. Tato funkce umožňuje uložit tok dat, aniž byste museli čekat na dokončení ověření.

Další informace o novém prostředí pro ukládání najdete v části Uložení konceptu toku dat.

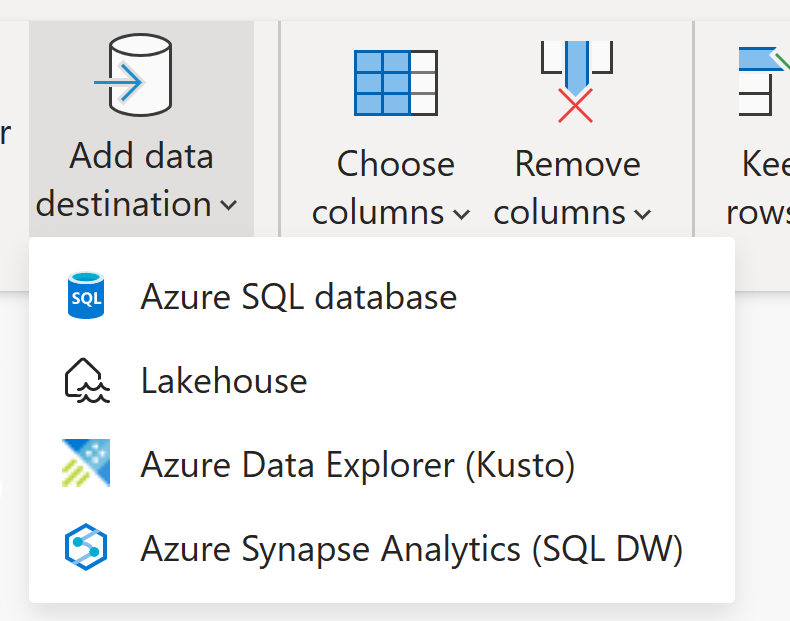

Cíle dat

Podobně jako dataflow Gen1 vám tok dat Gen2 umožňuje transformovat data do interního a přípravného úložiště toku dat, ke které se dá přistupovat pomocí konektoru toku dat. Tok dat Gen2 také umožňuje zadat cíl dat pro vaše data. Pomocí této funkce teď můžete oddělit logiku ETL a cílové úložiště. Tato funkce vám přináší mnoho výhod. Teď můžete například pomocí toku dat načíst data do jezera a pak pomocí poznámkového bloku data analyzovat. Nebo můžete použít tok dat k načtení dat do databáze Azure SQL a následnému načtení dat do datového skladu pomocí datového kanálu.

V Dataflow Gen2 jsme přidali podporu pro následující cíle a připravujeme mnoho dalších:

- Fabric Lakehouse

- Azure Data Explorer (Kusto)

- Azure Synapse Analytics (SQL DW)

- Azure SQL Database

Poznámka:

Pokud chcete načíst data do služby Fabric Warehouse, můžete pomocí konektoru Azure Synapse Analytics (SQL DW) načíst sql připojovací řetězec. Další informace: Připojení ivity pro datové sklady v Microsoft Fabric

Nová historie aktualizací a monitorování

S Tokem dat Gen2 představujeme nový způsob, jak monitorovat aktualizace toku dat. Integrujeme podporu centra monitorování a poskytujeme prostředí historie aktualizací hlavním upgradem.

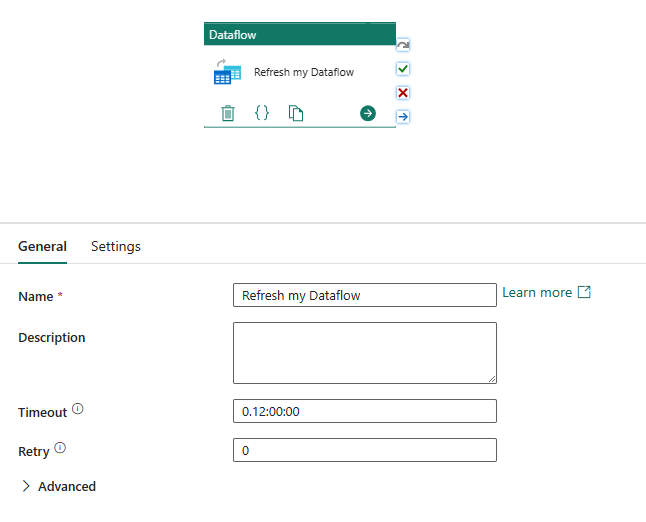

Integrace s datovými kanály

Datové kanály umožňují seskupit aktivity, které společně provádějí úlohu. Aktivita je jednotka práce, kterou lze spustit. Aktivita může například kopírovat data z jednoho umístění do jiného, spustit dotaz SQL, spustit uloženou proceduru nebo spustit poznámkový blok Pythonu.

Kanál může obsahovat jednu nebo více aktivit, které jsou propojené závislostmi. Kanál můžete například použít k ingestování a čištění dat z objektu blob Azure a následnému spuštění toku dat Gen2 k analýze dat protokolu. Kanál můžete také použít ke kopírování dat z objektu blob Azure do databáze Azure SQL a následnému spuštění uložené procedury v databázi.

Uložit jako koncept

S Tokem dat Gen2 představujeme bezplatné prostředí pro obavy tím, že odebereme potřebu publikování, aby se změny uložily. Při uložení jako funkce konceptu ukládáme koncept vaší verze toku dat při každé změně. Ztratili jste připojení k internetu? Zavřeli jste omylem prohlížeč? Žádné obavy; Dostali jsme tvůj záda. Jakmile se vrátíte do toku dat, vaše nedávné změny tam zůstanou a můžete pokračovat tam, kde jste skončili. Jedná se o bezproblémové prostředí, které nevyžaduje žádné vstupy od vás. To vám umožní pracovat na toku dat, aniž byste se museli starat o ztrátu změn nebo opravit všechny chyby dotazu, než změny uložíte. Další informace o této funkci najdete v části Uložení konceptu toku dat.

Vysokokapacitní výpočetní prostředky

Podobně jako Dataflow Gen1 nabízí Dataflow Gen2 také vylepšený výpočetní modul pro zlepšení výkonu obou transformací odkazovaných dotazů a získání datových scénářů. K tomu tok Dataflow Gen2 vytvoří ve vašem pracovním prostoru položky Lakehouse i Warehouse a použije je k ukládání dat a přístupu k nim, aby se zlepšil výkon všech toků dat.

Licencování toku dat Gen1 vs Gen2

Tok dat Gen2 je nová generace toků dat, která se nachází vedle toku dat Power BI (Gen1) a přináší nové funkce a vylepšené prostředí. Vyžaduje kapacitu Fabric nebo zkušební kapacitu Fabric. Pokud chcete lépe pochopit, jak funguje licencování pro toky dat, přečtěte si následující článek: Koncepty a licence Microsoft Fabric

Vyzkoušení toku dat Gen2 opětovným použitím dotazů z toku dat Gen1

Pravděpodobně máte mnoho dotazů Gen1 toku dat a zajímá vás, jak je můžete vyzkoušet v Toku dat Gen2. Máme pro vás několik možností, jak znovu vytvořit toky dat Gen1 jako tok dat Gen2.

Export dotazů Toku dat Gen1 a jejich import do Dataflow Gen2

Teď můžete exportovat dotazy v prostředích pro vytváření Toku dat Gen1 i Gen2 a uložit je do souboru PQT, který pak můžete importovat do Toku dat Gen2. Další informace najdete v tématu Použití funkce šablony exportu.

Kopírování a vkládání v Power Query

Pokud máte tok dat v Power BI nebo Power Apps, můžete zkopírovat dotazy a vložit je do editoru toku dat Gen2. Tato funkce umožňuje migrovat tok dat do Gen2 bez nutnosti přepisovat dotazy. Další informace najdete v tématu Kopírování a vkládání existujících dotazů Dataflow Gen1.

Související obsah

Váš názor

Připravujeme: V průběhu roku 2024 budeme postupně vyřazovat problémy z GitHub coby mechanismus zpětné vazby pro obsah a nahrazovat ho novým systémem zpětné vazby. Další informace naleznete v tématu: https://aka.ms/ContentUserFeedback.

Odeslat a zobrazit názory pro