Analysieren Ihrer Lernschleife mit einer Offlineauswertung

Wichtig

Ab dem 20. September 2023 können Sie keine neuen Personalisierungsressourcen mehr erstellen. Der Personalisierungsdienst wird am 1. Oktober 2026 eingestellt.

Hier erfahren Sie, wie Sie eine Offlineauswertung erstellen und die Ergebnisse interpretieren.

Mit Offlineauswertungen können Sie die Effektivität der Personalisierung im Vergleich zum Standardverhalten Ihrer Anwendung über einen Zeitraum mit protokollierten (historischen) Daten messen und bewerten, wie gut andere Modellkonfigurationseinstellungen für Ihr Modell funktionieren.

Wenn Sie eine Offlineauswertung erstellen, führt die Option Ermittlung zur Optimierung Offlineauswertungen für eine Vielzahl von Lernrichtlinienwerten durch, um eine Lernrichtlinie zu finden, die die Leistung Ihres Modells verbessern kann. Sie können auch zusätzliche Richtlinien bereitstellen, die in der Offlineauswertung ausgewertet werden sollen.

Weitere Informationen finden Sie unter Offlineauswertung.

Voraussetzungen

- Eine konfigurierte Personalisierungsressource

- Die Personalisierungsressource muss über eine repräsentative Menge an protokollierten Daten verfügen. Für aussagekräftige Auswertungsergebnisse werden mindestens 50.000 Ereignisse in den Protokollen empfohlen. Vielleicht verfügen Sie auch über zuvor exportierte Lernrichtliniendateien, die Sie in dieser Auswertung testen und vergleichen möchten. Dies ist allerdings optional.

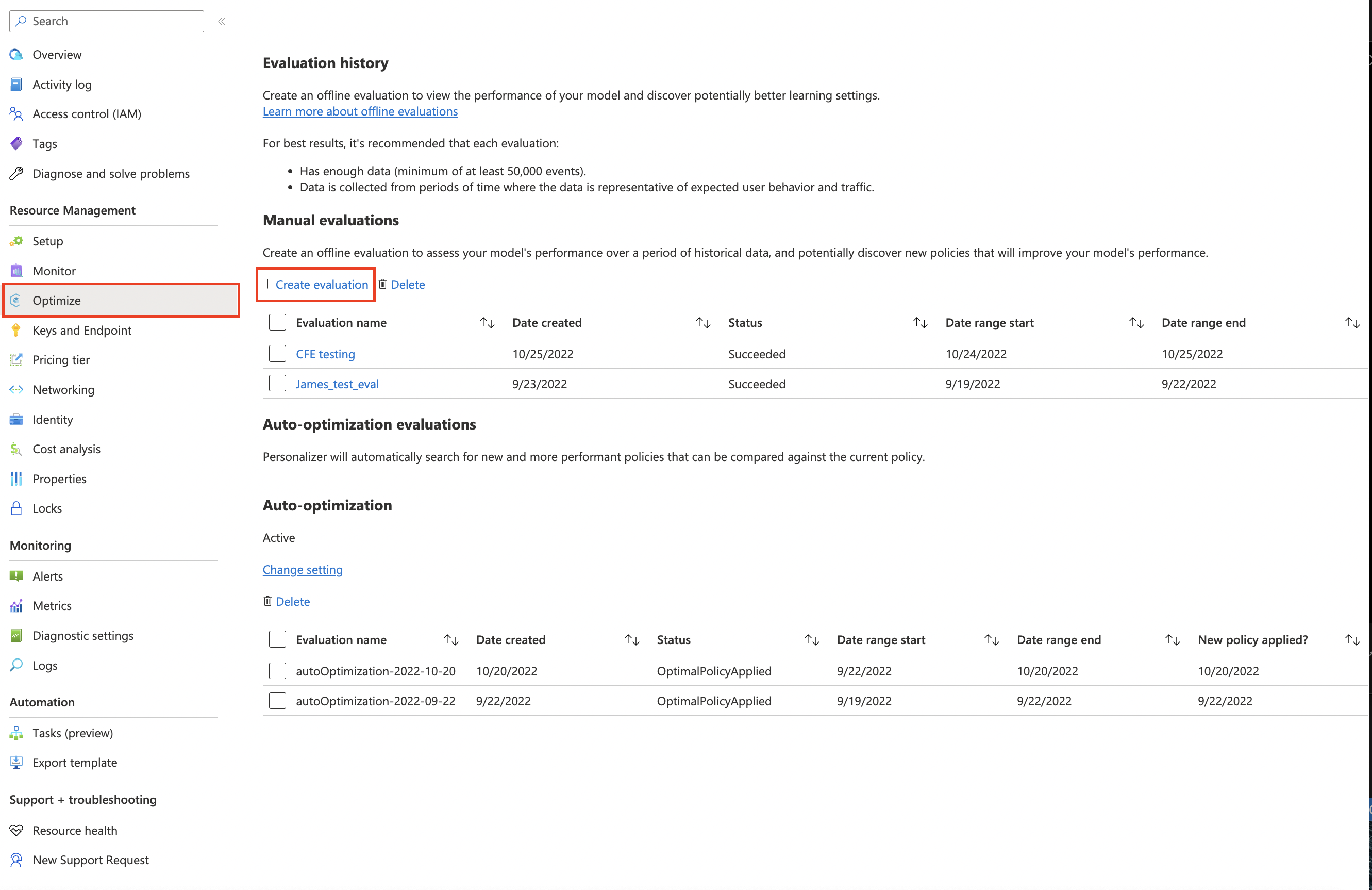

Durchführen einer Offlinebewertung

Suchen Sie Ihre Personalisierungsressource im Azure-Portal.

Navigieren Sie im Azure-Portal zum Abschnitt Bewertungen, und wählen Sie Bewertung erstellen aus.

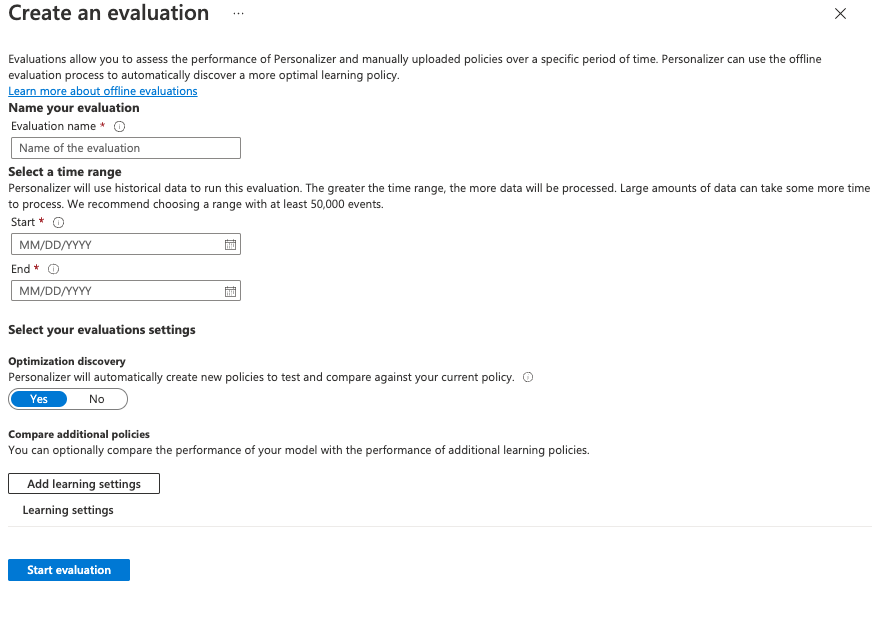

Füllen Sie die Optionen im Fenster Bewertung erstellen aus:

- Einen Auswertungsnamen.

- Start- und Enddatum: Hierbei handelt es sich um Datumsangaben, die den Bereich der zur Auswertung zu verwendenden Daten angeben. Diese Daten müssen gemäß dem Wert Datenaufbewahrung in den Protokollen vorliegen.

- Legen Sie Ermittlung zur Optimierung auf Ja fest, wenn die Personalisierung versuchen soll, bessere Lernrichtlinien zu finden.

- Lerneinstellungen hinzufügen: Laden Sie eine Lernrichtliniendatei hoch, wenn Sie eine benutzerdefinierte oder zuvor exportierte Richtlinie auswerten möchten.

Wählen Sie Auswertung starten aus, um die Auswertung zu starten.

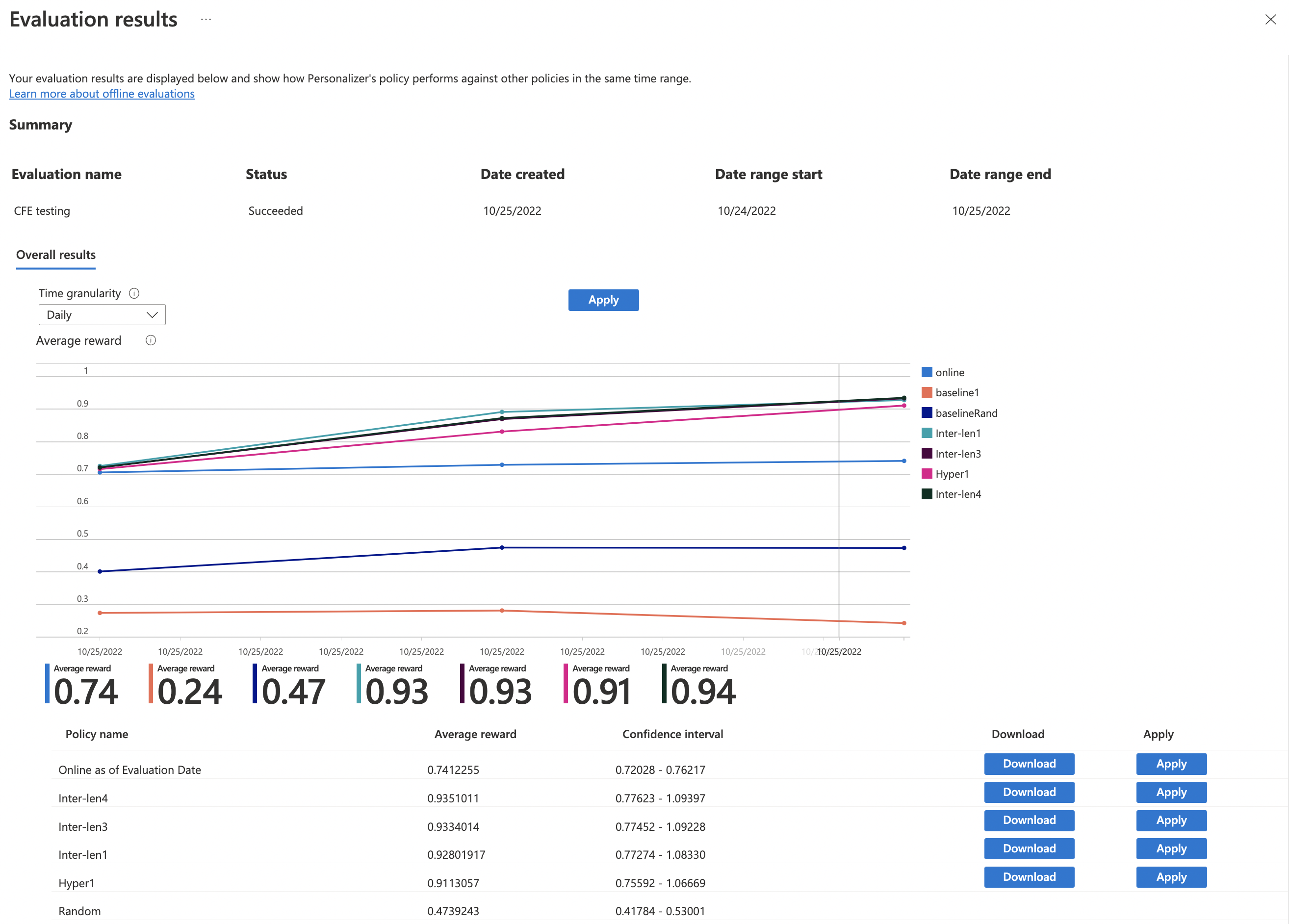

Überprüfen der Auswertungsergebnisse

Auswertungen können je nach der Menge zu verarbeitender Daten, der Anzahl der zu vergleichenden Lernrichtlinien und abhängig davon, ob eine Optimierung angefordert wurde, sehr lange dauern.

Nach Abschluss können Sie die Auswertung aus der Auswertungsliste auswählen und dann die Option zum Vergleichen der Bewertung Ihrer Anwendung mit anderen potenziellen Lerneinstellungen aktivieren. Aktivieren Sie dieses Feature, wenn Sie sehen möchten, wie Ihre aktuelle Lernrichtlinie im Vergleich zu einer neuen Richtlinie abschneidet.

Überprüfen Sie als Nächstes die Leistung der Lernrichtlinien.

Ihnen werden im Diagramm verschiedene Lernrichtlinien angezeigt – zusammen mit der geschätzten durchschnittlichen Relevanz, Konfidenzintervallen und Optionen zum Herunterladen oder Anwenden einer bestimmten Richtlinie.

- „Online“: Aktuelle Richtlinie der Personalisierung

- „Baseline1“: Die Baselinerichtlinie Ihrer Anwendung

- „BaselineRand“: Eine Richtlinie zum Ausführen willkürlicher Aktionen

- „Inter-len#“ oder „Hyper#“: Richtlinien, die von der Ermittlung zur Optimierung erstellt wurden

Wählen Sie Übernehmen aus, um die Richtlinie anzuwenden, die das Modell am besten für Ihre Daten optimiert.

Nächste Schritte

- Weitere Informationen zur Funktionsweise von Offlineauswertungen.