Übersicht über Eye Tracking-Beispiele — MRTK2

In diesem Thema wird beschrieben, wie Sie schnell mit eye tracking in MRTK beginnen können, indem Sie auf MRTK-Augenverfolgungsbeispielen (Assets/MRTK/Examples/Demos/EyeTracking) aufbauen. Mit diesen Beispielen können Sie eine unserer neuen magischen Eingabefunktionen erleben: Augenverfolgung! Die Demo umfasst verschiedene Anwendungsfälle, von impliziten, augenbasierten Aktivierungen bis hin zur nahtlosen Kombination von Informationen über das, was Sie sehen, mit Sprach- und Handeingaben . Auf diese Weise können Benutzer holografische Inhalte schnell und mühelos auswählen und in ihrer Ansicht verschieben, indem sie einfach auf ein Ziel schauen und "Auswählen" sagen oder eine Handbewegung ausführen. Die Demos enthalten auch ein Beispiel für das Scrollen, Schwenken und Zoomen von Text und Bildern auf einer Schieferschie. Schließlich wird ein Beispiel für die Aufzeichnung und Visualisierung der visuellen Aufmerksamkeit des Benutzers auf einem 2D-Schiefer bereitgestellt. Im folgenden Abschnitt finden Sie weitere Details zu den verschiedenen Beispielen im MRTK-Beispielpaket für Augenverfolgung (Assets/MRTK/Examples/Demos/EyeTracking):

![]()

Im folgenden Abschnitt erhalten Sie eine kurze Übersicht darüber, worum es in den einzelnen Eye Tracking-Demoszenen geht. Die MRTK Eye Tracking-Demoszenen werden additiv geladen, was im Folgenden erläutert wird, wie sie eingerichtet werden.

Übersicht über die Eye Tracking-Demobeispiele

Von Augen unterstützte Zielauswahl

In diesem Tutorial wird erläutert, wie einfach der Zugriff auf Augenblickdaten zur Auswahl von Zielen ist. Es enthält ein Beispiel für subtiles, aber leistungsstarkes Feedback, um dem Benutzer das Vertrauen zu geben, dass ein Ziel fokussiert ist, ohne überfordernd zu sein. Darüber hinaus gibt es ein einfaches Beispiel für intelligente Benachrichtigungen, die nach dem Lesen automatisch verschwinden.

Zusammenfassung: Schnelle und mühelose Zielauswahl mit einer Kombination aus Augen,Stimme und Handeingabe.

Von Augen unterstützte Navigation

Stellen Sie sich vor, Sie lesen einige Informationen auf einem fernen Display oder Ihrem E-Reader, und wenn Sie das Ende des angezeigten Texts erreichen, scrollt der Text automatisch nach oben, um mehr Inhalt anzuzeigen. Oder wie wäre es mit einem magischen Zoom direkt auf das, was Sie betrachtet haben? Dies sind einige der Beispiele, die in diesem Tutorial zur augengestützten Navigation vorgestellt werden. Darüber hinaus gibt es ein Beispiel für die freihändige Drehung von 3D-Hologrammen, indem sie basierend auf Ihrem aktuellen Fokus automatisch rotieren.

Zusammenfassung: Scrollen, Schwenken, Zoomen, 3D-Drehung mit einer Kombination aus Augen, Stimme und Handeingabe.

Augengestützte Positionierung

Dieses Tutorial zeigt ein Eingabeszenario namens Put-That-There , das auf die Forschung des MIT Media Lab in den frühen 1980er Jahren mit Augen-, Hand- und Spracheingabe zurückgeht. Die Idee ist einfach: Profitieren Sie von Ihren Augen für eine schnelle Zielauswahl und -positionierung. Schauen Sie sich einfach ein Hologramm an und sagen Sie "put this", schauen Sie hinüber, wo Sie es platzieren möchten, und sagen Sie "da!". Um Ihr Hologramm präziser zu positionieren, können Sie zusätzliche Eingaben von Händen, Stimme oder Controllern verwenden.

Zusammenfassung: Positionieren von Hologrammen mithilfe von Augen-, Sprach- und Handeingaben (Drag-and-Drop). Augengestützte Schieberegler mit Augen + Händen.

Visualisierung visueller Aufmerksamkeit

Daten, die auf dem Blick der Benutzer basieren, sind ein immens leistungsfähiges Tool, um die Benutzerfreundlichkeit eines Designs zu bewerten und Probleme in effizienten Arbeitsströmen zu identifizieren. In diesem Tutorial werden verschiedene Eye-Tracking-Visualisierungen erläutert und erläutert, wie sie unterschiedlichen Anforderungen entsprechen. Wir bieten grundlegende Beispiele für die Protokollierung und das Laden von Eye Tracking-Daten und Beispiele für deren Visualisierung.

Zusammenfassung: Zweidimensionale Aufmerksamkeitskarte (Heatmaps) auf Slaten. Aufzeichnen & Wiedergeben von Eye Tracking-Daten.

Einrichten der MRTK-Augenverfolgungsbeispiele

Voraussetzungen

Beachten Sie, dass für die Verwendung der Eye Tracking-Beispiele auf dem Gerät ein HoloLens 2 und ein Beispiel-App-Paket erforderlich ist, das mit der Funktion "Gaze Input" im AppXManifest des Pakets erstellt wird.

Führen Sie diese Schritte vor dem Erstellen der App in Visual Studio aus, um diese Eye Tracking-Beispiele auf dem Gerät zu verwenden.

1. Laden Sie EyeTrackingDemo-00-RootScene.unity

EyeTrackingDemo-00-RootScene ist die Basisszene (Stamm), in der alle kernigen MRTK-Komponenten enthalten sind. Dies ist die Szene, die Sie zuerst laden müssen und von der aus Sie die Eye Tracking-Demos ausführen. Es verfügt über ein grafisches Szenenmenü, mit dem Sie einfach zwischen den verschiedenen Eye Tracking-Beispielen wechseln können, die additiv geladen werden.

![]()

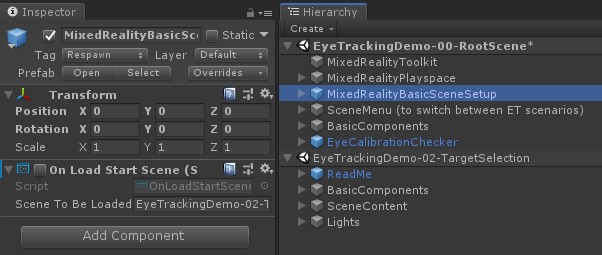

Die Stammszene enthält einige Kernkomponenten, die in den additiv geladenen Szenen beibehalten werden, z. B. die MRTK-konfigurierten Profile und die Szenenkamera. MixedRealityBasicSceneSetup (siehe Screenshot unten) enthält ein Skript, mit dem die Szene, auf die verwiesen wird, beim Start automatisch geladen wird. Standardmäßig ist dies EyeTrackingDemo-02-TargetSelection.

![]()

2. Hinzufügen von Szenen zum Buildmenü

Um additive Szenen während der Laufzeit zu laden, müssen Sie diese Szenen zuerst ihren Buildeinstellungen –> Szenen im Menü Build hinzufügen. Es ist wichtig, dass die Stammszene als erste Szene in der Liste angezeigt wird:

![]()

3. Wiedergeben der Eye Tracking-Beispiele im Unity-Editor

Nachdem Sie die EyeTracking-Szenen zu den Buildeinstellungen hinzugefügt und eyeTrackingDemo-00-RootScene geladen haben, können Sie noch eine letzte Sache überprüfen: Ist das Skript "OnLoadStartScene" , das an das MixedRealityBasicScene-GameObject angefügt ist, aktiviert? Dies ist, um die Stammszene darüber zu informieren, welche Demoszene zuerst geladen werden soll.

![]()

Lassen Sie uns rollen! Klicken Sie auf "Play"! Es sollten mehrere Edelsteine und das Szenenmenü oben angezeigt werden.

![]()

Sie sollten auch einen kleinen halbtransparenten Kreis in der Mitte Ihrer Spielansicht bemerken. Dies fungiert als Indikator (Cursor) Ihres simulierten Blicks: Drücken Sie einfach die rechte Maustaste nach unten und bewegen Sie die Maus, um ihre Position zu ändern. Wenn der Cursor auf die Edelsteine zeigt, werden Sie feststellen, dass er in die Mitte des aktuell angezeigten Gems einrastet. Dies ist eine hervorragende Möglichkeit, zu testen, ob Ereignisse beim "Betrachten" eines Ziels wie erwartet ausgelöst werden. Beachten Sie, dass der simulierte Blick per Maussteuerung eine eher schlechte Ergänzung zu unseren schnellen und unbeabsichtigten Augenbewegungen ist. Es eignet sich jedoch hervorragend, um die grundlegende Funktionalität zu testen, bevor Sie den Entwurf durchlaufen, indem Sie sie auf dem HoloLens 2 Gerät bereitstellen. Zurück zu unserer Eyetracking-Beispielszene: Der Edelstein dreht sich so lange, wie es betrachtet wird und kann durch "Betrachten" zerstört werden und ...

- Drücken der EINGABETASTE (was simuliert, dass "Select" angegeben wird)

- " Auswählen" in Ihr Mikrofon sagen

- Klicken Sie beim Drücken von Leertaste , um die simulierte Handeingabe anzuzeigen, auf die linke Maustaste, um eine simulierte Pinch auszuführen.

Wie Sie diese Interaktionen erreichen können, erfahren Sie in unserem Tutorial zur Von Augen unterstützten Zielauswahl .

Wenn Sie den Cursor auf die obere Menüleiste in der Szene bewegen, werden Sie feststellen, dass das aktuell mit mauserte Element subtil hervorgehoben wird. Sie können das aktuell hervorgehobene Element auswählen, indem Sie eine der oben beschriebenen Commitmethoden verwenden (z. B. die EINGABETASTE drücken). Auf diese Weise können Sie zwischen den verschiedenen Eye Tracking-Beispielszenen wechseln.

4. Testen bestimmter Unterszenen

Wenn Sie an einem bestimmten Szenario arbeiten, sollten Sie das Szenenmenü möglicherweise nicht jedes Mal durchgehen. Stattdessen können Sie direkt mit der Szene beginnen, an der Sie gerade arbeiten, wenn Sie die Schaltfläche Wiedergabe drücken. Kein Problem. Hier sehen Sie, was Sie tun können:

Laden der Stammszene

Deaktivieren Sie in der Stammszene das Skript "OnLoadStartScene" .

Ziehen Sie eine der unten beschriebenen Testszenen für eye tracking (oder eine andere Szene) in ihre Hierarchieansicht , wie im screenshot unten gezeigt.

Drücken Sie die Wiedergabe.

Beachten Sie, dass das Laden der Unterszene wie dieser nicht persistent ist: Dies bedeutet, dass, wenn Sie Ihre App auf dem HoloLens 2 Gerät bereitstellen, nur die Stammszene geladen wird (vorausgesetzt, sie wird oben in Den Buildeinstellungen angezeigt). Außerdem werden die Unterszenen nicht automatisch geladen, wenn Sie Ihr Projekt für andere Freigeben.

Nachdem Sie nun wissen, wie Sie die MRTK-Beispielszenen für die Augenverfolgung zum Funktionieren bringen können, gehen wir mit der Tieferlegung der Auswahl von Hologrammen mit Den Augen fort: Augengestützte Zielauswahl.