Déployer un modèle vocal personnalisé

Dans cet article, vous apprenez à déployer un point de terminaison pour un modèle vocal personnalisé. À l’exception de la transcription par lots, vous devez déployer un point de terminaison personnalisé pour utiliser un modèle vocal personnalisé.

Conseil

Un point de terminaison de déploiement hébergé n’est pas nécessaire pour utiliser la reconnaissance vocale personnalisée avec l’API de transcription par lots. Vous pouvez conserver des ressources si le modèle vocal personnalisé est utilisé uniquement pour la transcription par lots. Pour plus d’informations, consultez les tarifs du service Speech.

Vous pouvez déployer un point de terminaison pour un modèle de base ou personnalisé, puis mettre à jour le point de terminaison ultérieurement afin d’utiliser un modèle mieux entraîné.

Notes

Les points de terminaison utilisés par les ressources Speech F0 sont supprimés après sept jours.

Ajouter un point de terminaison de déploiement

Pour créer un point de terminaison personnalisé, procédez comme suit.

Connectez-vous à Speech Studio.

Sélectionnez Custom Speech> Nom de votre projet >Déployer des modèles.

S’il s’agit de votre premier point de terminaison, notez que la table ne contient aucun point de terminaison. Une fois que vous avez créé un point de terminaison, vous utilisez cette page pour effectuer le suivi de chaque point de terminaison déployé.

Sélectionnez Déployer le modèle pour démarrer l’Assistant Nouveau point de terminaison.

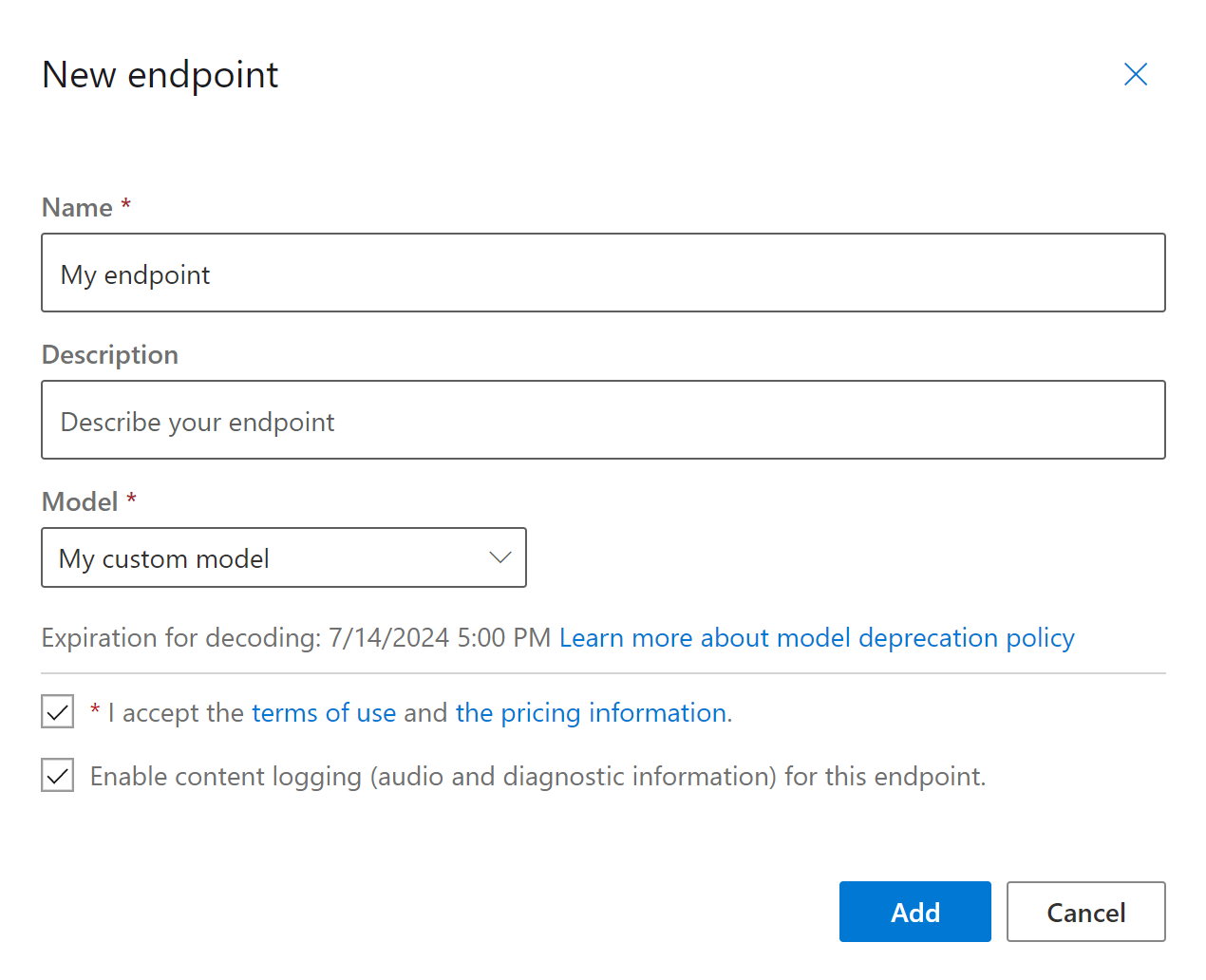

Sur la page Nouveau point de terminaison, entrez un nom et une description pour votre point de terminaison personnalisé.

Sélectionnez le modèle personnalisé que vous souhaitez associer au point de terminaison.

Si vous le souhaitez, vous pouvez cocher la case pour activer la journalisation audio et de diagnostic du trafic du point de terminaison.

Sélectionnez Ajouter pour enregistrer et déployer le point de terminaison.

Sur la page principale des modèles de déploiement, les détails sur le nouveau point de terminaison sont affichés dans un tableau, tel que le nom, la description, l’état et la date d’expiration. L’instanciation d’un nouveau point de terminaison avec vos modèles personnalisés peut prendre jusqu’à 30 minutes. Lorsque l’état du déploiement est Réussi, le point de terminaison est prêt à être utilisé.

Important

Prenez note de la date d’expiration du modèle. Il s’agit de la dernière date à laquelle vous pouvez utiliser votre modèle personnalisé pour la reconnaissance vocale. Pour plus d’informations, consultez Cycle de vie des modèles et des points de terminaison.

Sélectionnez ce lien de point de terminaison pour afficher ses informations spécifiques, telles que sa clé, son URL et un exemple de code.

Pour créer un point de terminaison et déployer un modèle, utilisez la commande spx csr endpoint create. Construisez les paramètres de la requête conformément aux instructions suivantes :

- Définissez le paramètre

projectsur l’ID d’un projet existant. Cela est recommandé afin de pouvoir également afficher et de gérer le point de terminaison dans Speech Studio. Vous pouvez exécuter la commandespx csr project listpour obtenir les projets disponibles. - Définissez le paramètre requis

modelsur l’ID du modèle que vous souhaitez déployer sur le point de terminaison. - Définissez le paramètre requis

language. Les paramètres régionaux du point de terminaison doivent correspondre à ceux du modèle. Vous ne pourrez plus changer de paramètres régionaux. Le paramètrelanguageCLI Speech correspond à la propriétélocaledans la requête et la réponse JSON. - Définissez le paramètre requis

name. C’est le nom qui est affiché dans Speech Studio. Le paramètrenameCLI Speech correspond à la propriétédisplayNamedans la requête et la réponse JSON. - Si vous le souhaitez, vous pouvez définir le paramètre

logging. Définissez-le surenabledpour activer la journalisation audio et de diagnostic du trafic du point de terminaison. Par défaut, il s’agit defalse.

Voici un exemple de commande l’interface CLI Speech pour créer un point de terminaison et déployer un modèle :

spx csr endpoint create --api-version v3.1 --project YourProjectId --model YourModelId --name "My Endpoint" --description "My Endpoint Description" --language "en-US"

Vous devriez recevoir un corps de réponse au format suivant :

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/ae8d1643-53e4-4554-be4c-221dcfb471c5"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/d40f2eb8-1abf-4f72-9008-a5ae8add82a4"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T15:27:51Z",

"status": "NotStarted",

"createdDateTime": "2022-05-19T15:27:51Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

La propriété self de niveau supérieur dans le corps de la réponse est l’URI du point de terminaison. Utilisez cet URI pour obtenir des détails sur le projet, le modèle et les journaux du point de terminaison. Vous utilisez également cet URI pour mettre à jour le point de terminaison.

Pour obtenir l’aide de l’interface CLI Speech avec des points de terminaison, exécutez la commande suivante :

spx help csr endpoint

Pour créer un point de terminaison et déployer un modèle, utilisez l’opération Endpoints_Create de l’API REST de reconnaissance vocale. Construisez le corps de la requête conformément aux instructions suivantes :

- Définissez la propriété

projectsur l’URI d’un projet existant. Cela est recommandé afin de pouvoir également afficher et de gérer le point de terminaison dans Speech Studio. Vous pouvez effectuer une requête Projects_List pour obtenir les projets disponibles. - Définissez la propriété requise

modelsur l’URI du modèle que vous souhaitez déployer sur le point de terminaison. - Définissez la propriété requise

locale. Les paramètres régionaux du point de terminaison doivent correspondre à ceux du modèle. Vous ne pourrez plus changer de paramètres régionaux. - Définissez la propriété requise

displayName. C’est le nom qui est affiché dans Speech Studio. - Si vous le souhaitez, vous pouvez définir la propriété

loggingEnableddansproperties. Définissez-la surtruepour activer la journalisation audio et de diagnostic du trafic du point de terminaison. Par défaut, il s’agit defalse.

Effectuez une requête HTTP POST à l’aide de l’URI, comme illustré dans l’exemple Endpoints_Create suivant. Remplacez YourSubscriptionKey par votre clé de ressource Speech, remplacez YourServiceRegion par votre région de ressource Speech et définissez les propriétés du corps de la requête comme décrit précédemment.

curl -v -X POST -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/d40f2eb8-1abf-4f72-9008-a5ae8add82a4"

},

"properties": {

"loggingEnabled": true

},

"displayName": "My Endpoint",

"description": "My Endpoint Description",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/ae8d1643-53e4-4554-be4c-221dcfb471c5"

},

"locale": "en-US",

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints"

Vous devriez recevoir un corps de réponse au format suivant :

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/ae8d1643-53e4-4554-be4c-221dcfb471c5"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/d40f2eb8-1abf-4f72-9008-a5ae8add82a4"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T15:27:51Z",

"status": "NotStarted",

"createdDateTime": "2022-05-19T15:27:51Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

La propriété self de niveau supérieur dans le corps de la réponse est l’URI du point de terminaison. Utilisez cet URI pour obtenir des détails sur le projet, le modèle et les journaux du point de terminaison. Vous utilisez également cet URI pour mettre à jour ou supprimer le point de terminaison.

Modifier le modèle et redéployer le point de terminaison

Un point de terminaison peut être mis à jour pour utiliser un autre modèle créé par la même ressource Speech. Comme mentionné précédemment, vous devez mettre à jour le modèle du point de terminaison avant l’expiration du modèle.

Pour utiliser un nouveau modèle et redéployer le point de terminaison personnalisé :

- Connectez-vous à Speech Studio.

- Sélectionnez Custom Speech> Nom de votre projet >Déployer des modèles.

- Sélectionnez le lien vers un point de terminaison par nom, puis sélectionnez Modifier le modèle.

- Sélectionnez le nouveau modèle que vous souhaitez que le point de terminaison utilise.

- Sélectionnez Terminé pour enregistrer et redéployer le point de terminaison.

Pour redéployer le point de terminaison personnalisé avec un nouveau modèle, utilisez la commande spx csr model update. Construisez les paramètres de la requête conformément aux instructions suivantes :

- Définissez le paramètre requis

endpointsur l’ID du point de terminaison que vous souhaitez déployer. - Définissez le paramètre requis

modelsur l’ID du modèle que vous souhaitez déployer sur le point de terminaison.

Voici un exemple de commande de l’interface CLI Speech qui redéploie le point de terminaison personnalisé avec un nouveau modèle :

spx csr endpoint update --api-version v3.1 --endpoint YourEndpointId --model YourModelId

Vous devriez recevoir un corps de réponse au format suivant :

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/1e47c19d-12ca-4ba5-b177-9e04bd72cf98"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/639d5280-8995-40cc-9329-051fd0fddd46"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T23:01:34Z",

"status": "NotStarted",

"createdDateTime": "2022-05-19T15:41:27Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Updated Endpoint Description"

}

Pour obtenir l’aide de l’interface CLI Speech avec des points de terminaison, exécutez la commande suivante :

spx help csr endpoint

Pour redéployer le point de terminaison personnalisé avec un nouveau modèle, utilisez l’opération Endpoints_Update de l’API REST de reconnaissance vocale. Construisez le corps de la requête conformément aux instructions suivantes :

- Définissez la propriété

modelsur l’URI du modèle que vous souhaitez déployer sur le point de terminaison.

Effectuez une requête HTTP PATCH à l’aide de l’URI, comme illustré dans l’exemple suivant. Remplacez YourSubscriptionKey par votre clé de ressource Speech, YourServiceRegion par votre clé de ressource Speech, YourEndpointId par votre ID de point de terminaison, et définissez les propriétés du corps de la demande comme décrit précédemment.

curl -v -X PATCH -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/1e47c19d-12ca-4ba5-b177-9e04bd72cf98"

}

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/YourEndpointId"

Vous devriez recevoir un corps de réponse au format suivant :

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/1e47c19d-12ca-4ba5-b177-9e04bd72cf98"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/639d5280-8995-40cc-9329-051fd0fddd46"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T23:01:34Z",

"status": "NotStarted",

"createdDateTime": "2022-05-19T15:41:27Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Updated Endpoint Description"

}

Le redéploiement prend plusieurs minutes. En attendant, votre point de terminaison utilise le modèle précédent sans interruption du service.

Afficher les données de journalisation

Les données de journalisation sont disponibles pour l’exportation si vous l’avez configurée lors de la création du point de terminaison.

Pour télécharger les journaux d’activité de point de terminaison :

- Connectez-vous à Speech Studio.

- Sélectionnez Custom Speech> Nom de votre projet >Déployer des modèles.

- Sélectionnez le lien par nom de point de terminaison.

- Sous Journalisation du contenu, sélectionnez Télécharger le journal.

Pour obtenir les journaux d’un point de terminaison, utilisez la commande spx csr endpoint list. Construisez les paramètres de la requête conformément aux instructions suivantes :

- Définissez le paramètre requis

endpointsur l’ID du point de terminaison dont vous souhaitez obtenir les journaux.

Voici un exemple de commande CLI Speech qui obtient les journaux d’un point de terminaison :

spx csr endpoint list --api-version v3.1 --endpoint YourEndpointId

Les emplacements de chaque fichier journal et d’autres détails sont retournés dans le corps de la réponse.

Pour obtenir des journaux d’un point de terminaison, commencez par utiliser l’opération Endpoints_Get de l’API REST de reconnaissance vocale.

Effectuez une requête HTTP GET à l’aide de l’URI, comme illustré dans l’exemple suivant. Remplacez YourEndpointId par votre ID de point de terminaison, remplacez YourSubscriptionKey par votre clé de ressource Speech et remplacez YourServiceRegion par votre région de ressource Speech.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/YourEndpointId" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Vous devriez recevoir un corps de réponse au format suivant :

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/1e47c19d-12ca-4ba5-b177-9e04bd72cf98"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/98375aaa-40c2-42c4-b65c-f76734fc7790/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=98375aaa-40c2-42c4-b65c-f76734fc7790"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/2f78cdb7-58ac-4bd9-9bc6-170e31483b26"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2022-05-19T23:41:05Z",

"status": "Succeeded",

"createdDateTime": "2022-05-19T23:41:05Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Updated Endpoint Description"

}

Effectuez une requête HTTP GET à l’aide de l’URI « logs » du corps de la réponse précédente. Remplacez YourEndpointId par votre ID de point de terminaison, remplacez YourSubscriptionKey par votre clé de ressource Speech et remplacez YourServiceRegion par votre région de ressource Speech.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/endpoints/YourEndpointId/files/logs" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Les emplacements de chaque fichier journal et d’autres détails sont retournés dans le corps de la réponse.

Les données de journalisation sont disponibles sur le stockage Microsoft pendant 30 jours, puis supprimées. Si votre compte de stockage est lié à l’abonnement Azure AI services, les données de journalisation ne sont pas automatiquement supprimées.