Démarrage rapide : Créer un pool Apache Spark serverless avec le portail Azure

Azure Synapse Analytics propose différents moteurs d’analytique pour vous aider à ingérer, transformer, modéliser, analyser et distribuer vos données. Un pool Apache Spark fournit des fonctionnalités de calcul Big Data open source. Après avoir créé un pool Apache Spark dans votre espace de travail Synapse, les données peuvent être chargées, modélisées, traitées et distribuées pour des informations analytiques plus rapides.

Dans ce guide de démarrage rapide, vous allez apprendre à utiliser le portail Azure pour créer un pool Apache Spark dans un espace de travail Synapse.

Important

La facturation des instances Spark est calculée au prorata des minutes écoulées, que vous les utilisiez ou non. Veillez à arrêter votre instance Spark une fois que vous avez fini de l’utiliser, ou définissez un délai d’expiration court. Pour plus d’informations, consultez la section Nettoyer les ressources de cet article.

Si vous n’avez pas d’abonnement Azure, créez un compte gratuit avant de commencer.

Prérequis

- Vous aurez besoin d’un abonnement Azure. Si besoin, Créez un compte Azure gratuit

- Vous utiliserez l'espace de travail Synapse.

Connectez-vous au portail Azure

Connectez-vous au portail Azure

Accéder à l’espace de travail Synapse

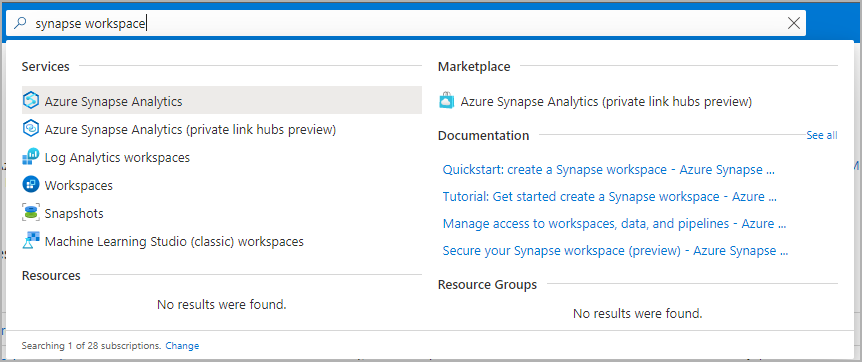

Accédez à l’espace de travail Synapse dans lequel vous allez créer le pool Apache Spark en saisissant le nom du service (ou directement le nom de la ressource) dans la barre de recherche.

Dans la liste des espaces de travail, saisissez le nom (ou une partie du nom) de l’espace de travail à ouvrir. Pour cet exemple, nous utilisons un espace de travail nommé contosoanalytics.

Créer un pool Apache Spark

Important

Azure Synapse Runtime pour Apache Spark 2.4 est obsolète et n'est officiellement plus pris en charge depuis septembre 2023. Étant donné que Spark 3.1 et Spark 3.2 sont également annoncés comme fin de support, nous recommandons aux clients de migrer vers Spark 3.3.

Dans l’espace de travail Synapse où vous souhaitez créer le pool Apache Spark, sélectionnez Nouveau pool Apache Spark.

Sous l’onglet Général, entrez les informations suivantes :

Paramètre Valeur suggérée Description Nom du pool Apache Spark Un nom de pool valide, comme contososparkIl s’agit du nom du pool Apache Spark. Taille du nœud Petite (4 processeurs virtuels/32 Go) Définissez ce paramètre sur la plus petite taille pour réduire les coûts de ce guide de démarrage rapide. Autoscale Désactivé Ce démarrage rapide ne nécessite pas de mise à l’échelle automatique Nombre de nœuds 5 Utilisez une petite taille pour limiter les coûts de ce démarrage rapide Important

Il existe des limitations spécifiques concernant les noms que les pools Apache Spark peuvent utiliser. Les noms doivent contenir uniquement des lettres ou des chiffres, ne doivent pas comporter plus de 15 caractères, doivent commencer par une lettre, ne pas contenir de mots réservés et être uniques dans l’espace de travail.

Sélectionnez Suivant : Paramètres supplémentaires et passez en revue les paramètres par défaut. Ne modifiez aucun paramètre par défaut.

Sélectionnez Suivant : étiquettes. Envisagez d'utiliser les balises Azure. Par exemple, la balise « Owner » ou « CreatedBy » pour identifier qui a créé la ressource, et la balise « Environnement » pour identifier si cette ressource est en Production, Développement, etc. Pour plus d’informations, consultez Développer une stratégie de nommage et de catégorisation des ressources Azure.

Sélectionnez Revoir + créer.

Vérifiez que les informations reflètent bien ce que vous avez entré, puis sélectionnez Créer.

À ce stade, le flux de provisionnement des ressources démarre et vous avertit quand l’opération est terminée.

Une fois le provisionnement terminé, une nouvelle entrée apparaît pour le pool Apache Spark créé quand vous revenez à l’espace de travail.

À ce stade, aucune ressource n’est en cours d’exécution, rien n’est facturé pour Spark ; vous avez créé les métadonnées sur les instances Spark que vous souhaitez créer.

Nettoyer les ressources

Les étapes suivantes suppriment le pool Apache Spark de l'espace de travail.

Avertissement

La suppression d’un pool Apache Spark supprime le moteur d’analytique de l’espace de travail. Il n’est plus possible de se connecter au pool, et l’ensemble des requêtes, pipelines et notebooks qui utilisent ce pool Apache Spark ne fonctionnent plus.

Si vous souhaitez supprimer le pool Apache Spark, procédez comme suit :

- Accédez au volet Pools Apache Spark dans l’espace de travail.

- Sélectionnez le pool Apache Spark à supprimer (dans ce cas, contosospark).

- Sélectionnez Supprimer.

- Confirmez la suppression et sélectionnez le bouton Supprimer.

- Une fois le processus terminé, le pool Apache Spark ne figure plus dans la liste des ressources de l’espace de travail.

Contenu connexe

Commentaires

Bientôt disponible : Tout au long de 2024, nous allons supprimer progressivement GitHub Issues comme mécanisme de commentaires pour le contenu et le remplacer par un nouveau système de commentaires. Pour plus d’informations, consultez https://aka.ms/ContentUserFeedback.

Envoyer et afficher des commentaires pour