Eye-tracking sur HoloLens 2

HoloLens 2 permet un nouveau niveau de compréhension du contexte et de l’homme dans l’expérience holographique en offrant aux développeurs la possibilité d’utiliser des informations sur ce que l’utilisateur regarde. Cette page explique comment les développeurs peuvent tirer parti du suivi oculaire pour divers cas d’usage et ce qu’il faut rechercher lors de la conception d’interactions utilisateur basées sur le regard.

L’API Eye Tracking a été conçue en tenant compte de la confidentialité d’un utilisateur ; elle évite la transmission de toute information identifiable, en particulier toute biométrie. Pour les applications compatibles avec le suivi oculaire, l’utilisateur doit accorder à l’application l’autorisation d’utiliser les informations de suivi oculaire.

Prise en charge des appareils

| Fonctionnalité | HoloLens (1ère génération) | HoloLens 2 | Casques immersifs |

| Regard de l’œil | ❌ | ✔️ | ❌ |

Démonstration des concepts d’élaboration du suivi de la tête et du suivi oculaire

Si vous souhaitez voir les concepts d’élaboration du suivi de la tête et du suivi oculaire en action, consultez notre démonstration vidéo Conception d’hologrammes - Suivi de la tête et suivi oculaire ci-dessous. Une fois que vous avez terminé, poursuivez pour obtenir une présentation plus détaillée relative à des rubriques spécifiques.

Cette vidéo a été extraite de l’application HoloLens 2 « Designing Holograms ». Téléchargez et profitez de l’expérience complète ici.

Étalonnage

Pour que le suivi oculaire fonctionne avec précision, chaque utilisateur doit passer par un étalonnage d’utilisateur de suivi oculaire pour lequel l’utilisateur doit examiner un ensemble de cibles holographiques. Cela permet à l’appareil d’ajuster le système, ce qui entraîne une expérience d’affichage plus confortable et de meilleure qualité pour l’utilisateur, tout en garantissant un suivi visuel précis en même temps.

Le suivi oculaire doit fonctionner pour la plupart des utilisateurs, mais il existe de rares cas dans lesquels un utilisateur ne peut pas étalonner correctement. L’étalonnage peut échouer pour différentes raisons, notamment :

- L’utilisateur a précédemment exclu le processus d’étalonnage.

- L’utilisateur a été distrait et n’a pas suivi les objectifs d’étalonnage.

- L’utilisateur a certains types de lentilles de contact et de lunettes que le système ne prend pas encore en charge.

- L’utilisateur a certaines physiologies oculaires ou des conditions oculaires ou a eu une chirurgie oculaire, que le système ne prend pas encore en charge.

- Des facteurs externes empêchant un suivi oculaire fiable tels que les taches sur la visière HoloLens ou les lunettes, la lumière du soleil directe intense, et les occlusions dues aux cheveux devant les yeux.

Les développeurs doivent veiller à fournir une prise en charge adéquate aux utilisateurs pour lesquels les données de suivi oculaire peuvent ne pas être disponibles (qui ne sont pas en mesure de s’étalonner correctement). Nous avons fourni des recommandations pour les solutions de secours dans la section en bas de cette page.

Pour en savoir plus sur l’étalonnage et sur la façon de garantir une expérience fluide, consultez notre page d’étalonnage des utilisateurs de suivi oculaire .

Données de suivi oculaire disponibles

Le suivi oculaire sur HoloLens 2 permet aux développeurs de concevoir des scénarios d’entrée et d’interaction naturels et intuitifs. L’API Suivi oculaire fournit des informations sur ce que l’utilisateur regarde sous la forme d’un seul rayon de regard (origine et direction du regard) à environ 30 FPS (30 Hz). Pour que l’eye-tracking fonctionne avec précision, chaque utilisateur doit effectuer un étalonnage. Pour plus d’informations sur l’accès aux données de suivi oculaire, reportez-vous à nos guides de développement pour l’utilisation du regard dans DirectX et du regard dans Unity.

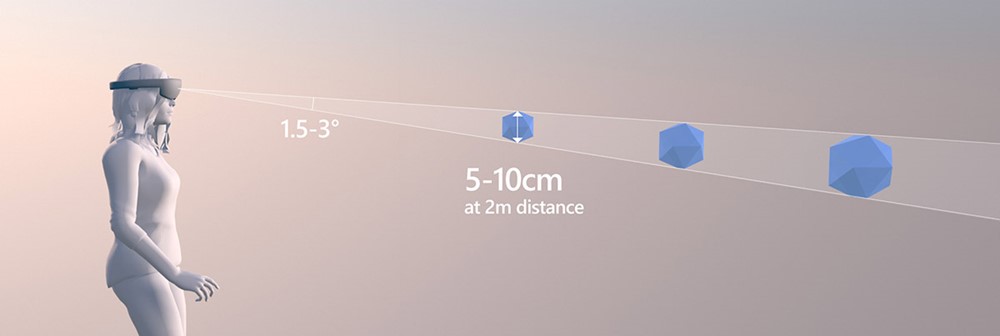

Le regard prédit est à environ 1,5 degré d’angle visuel autour de la cible réelle (voir l’illustration ci-dessous). De légères imprécisions sont attendues. Les développeurs doivent donc prévoir une certaine marge autour de cette valeur de limite inférieure (par exemple, 2.0-3.0 degrés peut entraîner une expérience beaucoup plus confortable). Nous aborderons plus en détail la sélection de petites cibles ci-dessous.

Taille optimale de la cible à une distance de 2 mètres

Données de suivi oculaire étendu

Les API de suivi oculaire étendues permettent aux développeurs de débloquer un nouveau niveau de scénarios innovants tels que l’évaluation de l’intégrité, la surveillance et la thérapie en fournissant des informations plus précises sur le regard de l’utilisateur.

Les API de suivi oculaire étendues permettent d’accéder à des valeurs de suivi oculaire existantes et à de nouvelles fonctionnalités telles que des vecteurs de regard individuels (gauche et droite), des fréquences d’images prises en charge et la possibilité de définir la fréquence d’images de suivi oculaire sur 30, 60 ou 90 ips. Pour utiliser l’API Suivi oculaire étendu, reportez-vous à nos guides de développement pour l’utilisation des API de suivi oculaire étendu pour native ou Unity.

Cas d'utilisation

L’eye-tracking permet aux applications de savoir où l’utilisateur regarde en temps réel. Les cas d’usage suivants décrivent certaines interactions possibles avec le suivi oculaire sur HoloLens 2 en réalité mixte. Ces cas d’usage ne font pas encore partie de l’expérience Holographic Shell (l’interface que vous voyez lorsque vous démarrez votre HoloLens 2). Vous pouvez essayer certains d’entre eux dans le kit de ressources Mixed Reality. Le kit de ressources fournit plusieurs exemples intéressants et puissants d’utilisation du suivi oculaire, tels que des sélections de cibles prises en charge par les yeux rapides et sans effort et le défilement automatique du texte en fonction de ce que l’utilisateur regarde.

Intention de l'utilisateur

Les informations sur où et ce qu’un utilisateur regarde fournissent un contexte puissant pour d’autres entrées, telles que la voix, les mains et les contrôleurs. Cela peut être utile pour diverses tâches. Par exemple, l’utilisateur peut cibler rapidement et sans effort sur toute la scène en regardant un hologramme et en disant « sélectionner » (voir aussi regarder et valider) ou « mettre ceci... », puis regarder à l’endroit où il souhaite placer l’hologramme et dire « ... là- bas. Vous trouverez des exemples à ce sujet dans Mixed Reality Toolkit - Sélection d’une cible à l’aide du regard et Mixed Reality Toolkit - Positionnement d’une cible à l’aide du regard.

En outre, un exemple d’intention utilisateur peut inclure l’utilisation d’informations sur ce que les utilisateurs regardent pour améliorer l’engagement avec des agents virtuels incorporés et des hologrammes interactifs. Par exemple, les agents virtuels peuvent adapter les options disponibles et leur comportement en fonction du contenu actuellement affiché.

Actions implicites

La catégorie des actions implicites est étroitement liée à l’intention de l’utilisateur. L’idée est que les hologrammes ou les éléments d’interface utilisateur réagissent d’une manière instinctive qui peut même ne pas avoir l’impression que l’utilisateur interagit avec le système, mais plutôt que le système et l’utilisateur sont synchronisés. Par exemple, le défilement automatique basé sur les yeux permet à l’utilisateur de lire un texte long qui commence automatiquement à défiler une fois que l’utilisateur accède au bas de la zone de texte. Cela maintient l’utilisateur dans le flux de lecture sans lever le doigt. Un aspect clé de cela est que la vitesse de défilement s’adapte à la vitesse de lecture de l’utilisateur.

Un autre exemple est le zoom et le panoramique pris en charge par les yeux, où l’utilisateur peut avoir l’impression de plonger exactement vers ce sur quoi il se concentre.

Le déclenchement et le contrôle de la vitesse de zoom peuvent être contrôlés par la voix ou la main, ce qui est important pour fournir à l’utilisateur le sentiment de contrôle tout en évitant d’être submergé. Nous aborderons ces considérations de conception plus en détail ci-dessous. Une fois le zoom avant, l’utilisateur peut suivre en douceur, par exemple, le cours d’une rue pour explorer son quartier à l’aide de son regard. Vous trouverez des démonstrations de ces types d’interaction dans l’exemple Mixed Reality Toolkit - Navigation à l’aide du regard.

D’autres cas d’usage pour les actions implicites peuvent inclure :

- Notifications intelligentes : Êtes-vous déjà ennuyé par des notifications qui apparaissent en plein milieu de votre vue ? Vous pouvez améliorer cette expérience en compensant les notifications d’où l’utilisateur observe actuellement. Cela limite les distractions et les ignore automatiquement une fois que l’utilisateur a terminé la lecture.

- Hologrammes attentifs : Il s’agit d’hologrammes qui réagissent de manière subtile lorsqu’ils sont regardés. Cela peut aller d’éléments d’interface utilisateur légèrement brillants à une fleur qui fleurit lentement à un chien virtuel qui commence à regarder en arrière l’utilisateur et à agiter sa queue. Cette interaction peut fournir un sentiment intéressant de connectivité et de satisfaction dans votre application.

Suivi de l’attention

Les informations sur où et ce que les utilisateurs regardent peuvent être un outil extrêmement puissant. Il peut aider à évaluer la facilité d’utilisation des conceptions et à identifier les problèmes dans les flux de travail pour les rendre plus efficaces. La visualisation et l’analytique du suivi oculaire sont une pratique courante dans différents domaines d’application. Avec HoloLens 2, nous apportons une nouvelle dimension à cette compréhension : les hologrammes 3D peuvent être placés dans des contextes réels et évalués en conséquence.

Le kit de ressources Mixed Reality fournit des exemples de base pour la journalisation et le chargement des données de suivi oculaire et la façon de les visualiser.

Microsoft s’engage à faciliter l’innovation tout en veillant à ce que les utilisateurs disposent d’une expérience informée et transparente de la façon dont leurs informations de suivi oculaire sont utilisées. Nous continuerons à travailler avec nos développeurs et nos équipes d’expérience utilisateur pour fournir des conseils à des tiers afin de garantir que les expériences sont centrées sur l’utilisateur.

Autres applications possibles dans ce domaine :

- Visualisation à distance des yeux : Visualisez ce que les collaborateurs à distance regardent. Cela peut fournir des commentaires immédiats et faciliter le traitement des informations plus précises.

- Études de recherche sur les utilisateurs : Le suivi de l’attention peut fournir des informations sur la façon dont les utilisateurs perçoivent et interagissent avec l’environnement naturel sans interférer. Cela peut aider les développeurs à concevoir des interactions homme-ordinateur plus instinctives. Le suivi oculaire peut fournir des informations qui ne sont pas directement articulées par les participants à l’étude et qui peuvent être facilement manquées par le chercheur.

- Formation et surveillance des performances : Pratiquez et optimisez l’exécution des tâches en identifiant plus efficacement les goulots d’étranglement dans le flux d’exécution. Le suivi oculaire peut fournir des informations naturelles, en temps réel et objectives pour aider à améliorer la formation, la productivité et la sécurité sur le lieu de travail.

- Évaluations de conception, marketing et recherche sur les consommateurs : Le suivi oculaire permet aux entreprises commerciales d’effectuer des études de marketing et de consommation dans des environnements réels ou d’analyser ce qui capte l’attention d’un utilisateur pour améliorer la conception du produit ou de l’espace.

Autres cas d’usage

- Jeu: Avez-vous déjà voulu avoir des superpouvoirs ? Voilà votre chance !

Vous pouvez léviter les hologrammes en les fixant.

Tirez des faisceaux laser de vos yeux - essayez-le dans RoboRaid pour HoloLens 2.

Transformer les ennemis en pierre ou les congeler.

Utilisez votre vision à rayons X pour explorer des bâtiments.

La seule limite, c’est votre imagination ! Attention toutefois à ne pas surcharger l’utilisateur. Pour plus d’informations, consultez nos instructions de conception d’entrée basées sur les yeux.

Avatars expressifs : Le suivi oculaire aide dans les avatars 3D plus expressifs en utilisant des données de suivi oculaire en direct pour animer les yeux de l’avatar et les faire suivre ce que l’utilisateur regarde.

Entrée de texte : Le suivi oculaire peut être utilisé comme alternative pour la saisie de texte à faible effort, en particulier lorsque la parole ou les mains ne sont pas pratiques à utiliser.

Utilisation du regard pour l’interaction

Créer une interaction qui tire parti du ciblage rapide des yeux peut être difficile. Étant donné que les yeux peuvent se déplacer rapidement, si vous ne faites pas attention à l’utilisation de l’entrée de regard, les utilisateurs peuvent trouver l’expérience écrasante ou distrayante. Mais cela en vaut la peine, car le suivi oculaire vous permet de créer des expériences vraiment magiques qui enthousiasmeront vos utilisateurs! Pour vous aider, consultez notre vue d’ensemble des principaux avantages, défis et recommandations de conception pour l’interaction.

Solutions de secours lorsque le suivi oculaire n’est pas disponible

Dans de rares cas, les données de suivi oculaire peuvent ne pas être disponibles. Cela peut se produire pour plusieurs raisons : les plus courantes sont répertoriées ci-dessous :

- Le système n’a pas pu étalonner l’utilisateur.

- L’utilisateur a ignoré l’étalonnage.

- L’utilisateur est étalonné, mais a décidé de ne pas autoriser votre application à utiliser ses données de suivi oculaire.

- L’utilisateur a des lunettes uniques ou une condition oculaire que le système ne prend pas encore en charge.

- Des facteurs externes inhibant un suivi oculaire fiable comme les taches sur la visière HoloLens ou les lunettes, la lumière du soleil directe intense, et les occlusions en raison des cheveux devant les yeux.

Les développeurs doivent s’assurer qu’il existe une prise en charge de secours appropriée pour ces utilisateurs. Dans la page Suivi oculaire dans DirectX , nous expliquons les API nécessaires pour détecter si des données de suivi oculaire sont disponibles.

Certains utilisateurs peuvent décider qu’une plus grande confidentialité est plus importante pour eux que l’expérience améliorée que le suivi oculaire peut fournir, de sorte qu’ils révoquent intentionnellement l’accès à leurs données de suivi oculaire. Toutefois, dans certains cas, cette révocation peut être involontaire. Si votre application utilise le suivi oculaire, et qu’il s’agit d’une partie importante de l’expérience, nous vous recommandons de le communiquer clairement à l’utilisateur. Expliquer à l’utilisateur comment le suivi oculaire déverrouille tout le potentiel de votre application peut l’aider à mieux comprendre ce qu’il abandonne. Si le suivi oculaire est activé, mais ne fonctionne pas, aidez l’utilisateur à identifier et à résoudre le problème à l’aide de la liste de contrôle ci-dessus comme guide. Par exemple, si vous pouvez détecter que le système prend en charge le suivi oculaire et que l’utilisateur est étalonné et a donné son autorisation, mais qu’aucune donnée de suivi oculaire n’est reçue, cela peut indiquer des problèmes tels que des taches ou des yeux obstrués.

Il existe de rares cas où le suivi oculaire ne fonctionne pas pour quelqu’un et il n’y a pas de raison évidente. Soyez respectueux de cela en permettant à l’utilisateur d’ignorer ou de désactiver les rappels pour activer le suivi oculaire dans votre application.

Revenir en arrière pour les applications qui utilisent l’œil-regard comme pointeur d’entrée principal

Si votre application utilise l’œil-regard comme entrée de pointeur pour sélectionner rapidement des hologrammes dans la scène, alors que les données de suivi oculaire ne sont pas disponibles, nous vous recommandons de revenir au regard visuel et d’afficher le curseur de regard frontal. Nous vous recommandons d’utiliser un délai d’attente (par exemple, 500 à 1500 ms) pour déterminer s’il faut basculer ou non. Cette action empêche les curseurs d’apparaître chaque fois que le système peut perdre brièvement le suivi en raison de mouvements rapides des yeux ou de clins d’œil et de clignotements. Si vous êtes développeur Unity, le secours automatique à l’observation frontale est déjà géré dans le kit de ressources Mixed Reality. Si vous êtes développeur DirectX, vous devez gérer ce commutateur vous-même.

Revenir en arrière pour d’autres applications spécifiques au suivi oculaire

Votre application peut utiliser le regard d’une manière unique et adaptée spécifiquement aux yeux, par exemple, en animant les yeux d’un avatar ou des cartes thermiques d’attention basées sur les yeux qui s’appuient sur des informations précises sur l’attention visuelle. Dans ce type de cas, il n’y a pas de secours clair. Si le suivi oculaire n’est pas disponible, ces fonctionnalités doivent peut-être être désactivées. Là encore, nous vous recommandons de le communiquer clairement à l’utilisateur, qui peut ne pas savoir que la fonctionnalité ne fonctionne pas.

Nous espérons que cette page vous a fourni une bonne vue d’ensemble pour commencer à comprendre le rôle du suivi oculaire et de l’entrée de regard pour le HoloLens 2. Pour commencer à développer, consultez nos informations sur le rôle du regard-regard pour interagir avec les hologrammes, le regard-regard dans Unity et le regard dans DirectX.