Comment fonctionne le gestionnaire du flux de travail Azure Data Factory ?

S’APPLIQUE À : Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

Remarque

Le gestionnaire du flux de travail est basé sur Apache Airflow.

Remarque

Le gestionnaire du flux de travail pour Azure Data Factory s’appuie sur l’application open source Apache Airflow. Vous trouverez de la documentation et d’autres tutoriels sur Airflow dans les pages Documentation ou Communauté d’Apache Airflow.

Le gestionnaire du flux de travail dans Azure Data Factory utilise des graphes orientés acycliques (DAG) basés sur Python pour exécuter vos flux de travail d’orchestration. Pour utiliser cette fonctionnalité, vous devez fournir vos graphes DAG et vos plug-ins dans le Stockage Blob Azure. Vous pouvez lancer l’interface utilisateur Airflow à partir d’ADF en utilisant une interface de ligne de commande (CLI) ou un SDK pour gérer vos graphes DAG.

Créer un environnement de gestionnaire du flux de travail

Les étapes suivantes installent et configurent votre environnement de gestionnaire du flux de travail.

Prérequis

Abonnement Azure : Si vous n’avez pas d’abonnement Azure, créez un compte gratuit avant de commencer. Créez ou sélectionnez une fabrique de données existante dans la région où la préversion du gestionnaire du flux de travail est prise en charge.

Étapes pour créer l’environnement

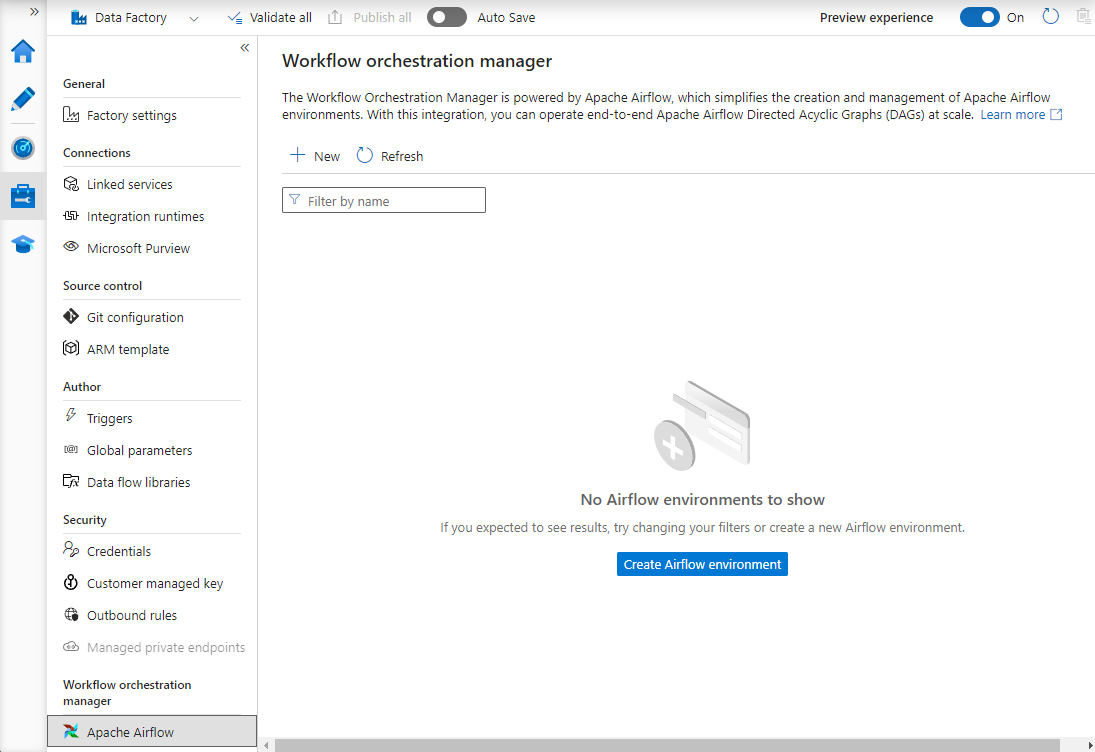

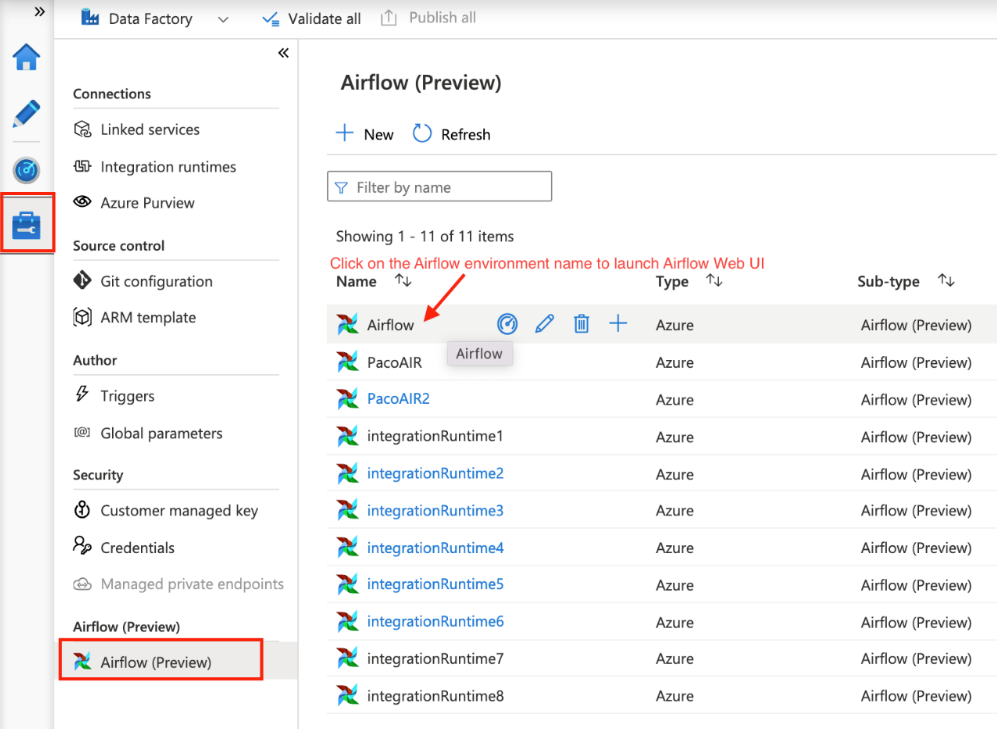

Créez un environnement de gestionnaire du flux de travail. Accédez à Gérer le hub ->Airflow (préversion) ->+Nouveau pour créer un environnement Airflow.

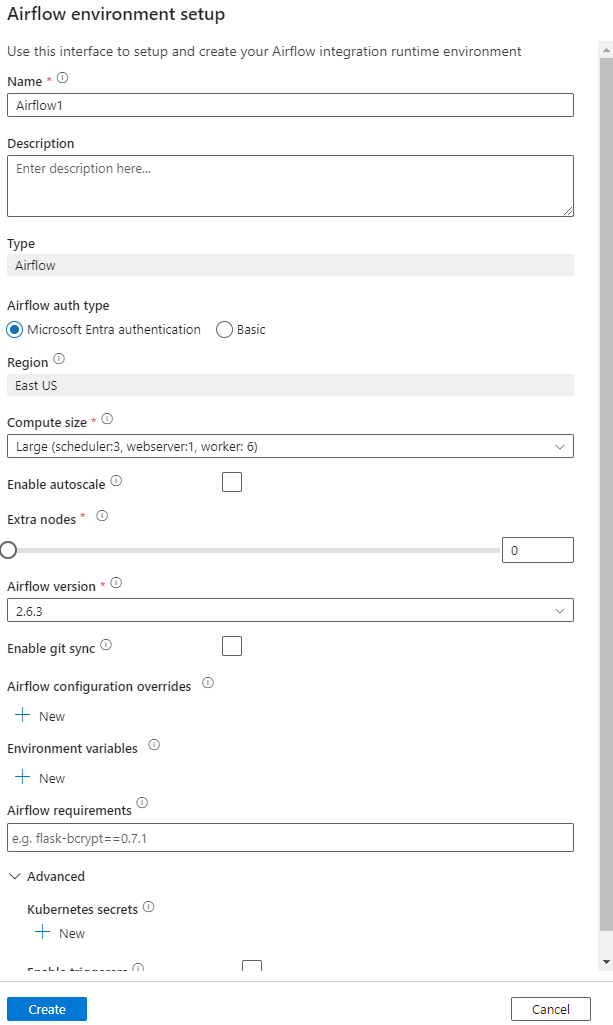

Spécifiez les informations détaillées (configuration d’Airflow)

Important

Si vous utilisez l’authentification De base, mémorisez le nom d’utilisateur et le mot de passe spécifiés dans cet écran. Vous devrez vous connecter ultérieurement dans l’interface utilisateur du gestionnaire du flux de travail. L’option par défaut est Microsoft Entra ID et elle ne nécessite pas la création d’un nom d’utilisateur/mot de passe pour votre environnement Airflow, mais elle utilise à la place les informations d’identification de l’utilisateur connecté à Azure Data Factory pour se connecter aux/superviser les DAG.

Variables d’environnement : un magasin de clés-valeurs simples dans Airflow pour stocker et récupérer du contenu arbitraire ou des paramètres.

Exigences : peut être utilisé pour préinstaller des bibliothèques Python. Vous pouvez également les mettre à jour ultérieurement.

Importer des DAG

Les étapes suivantes décrivent comment importer des DAG dans la gestionnaire du flux de travail.

Prérequis

Vous devez charger un exemple de DAG sur un compte de stockage accessible (doit se trouver dans le dossier dags).

Notes

Stockage Blob derrière un réseau virtuel n’est pas pris en charge avec la préversion.

Configuration de KeyVault dans storageLinkedServices non prise en charge pour importer des dags.

Exemple de DAG Apache Airflow v2.x. Exemple de DAG Apache Airflow v1.10.

Étapes de l’importation

Copiez-collez le contenu (v2.x ou v1.10, selon l’environnement Airflow que vous avez configuré) dans un nouveau fichier appelé tutorial.py.

Chargez le fichier tutorial.py dans un stockage d’objets blob. (Comment charger un fichier dans un objet blob)

Notes

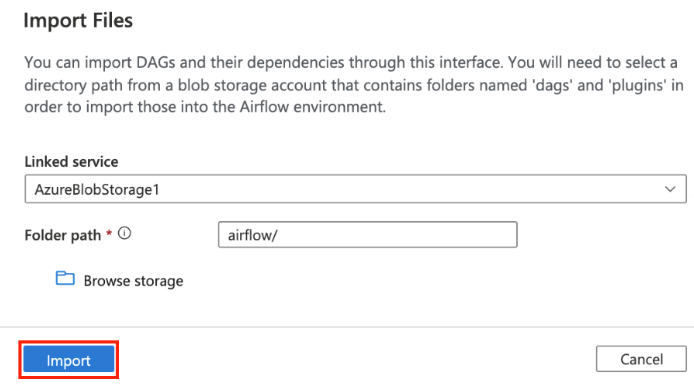

Vous devez sélectionner un chemin de répertoire à partir d’un compte de stockage d’objets blob qui contient des dossiers nommés dags et plugins pour les importer dans l’environnement Airflow. Les plug-ins ne sont pas obligatoires. Vous pouvez aussi avoir un conteneur nommé dags et y charger tous les fichiers Airflow.

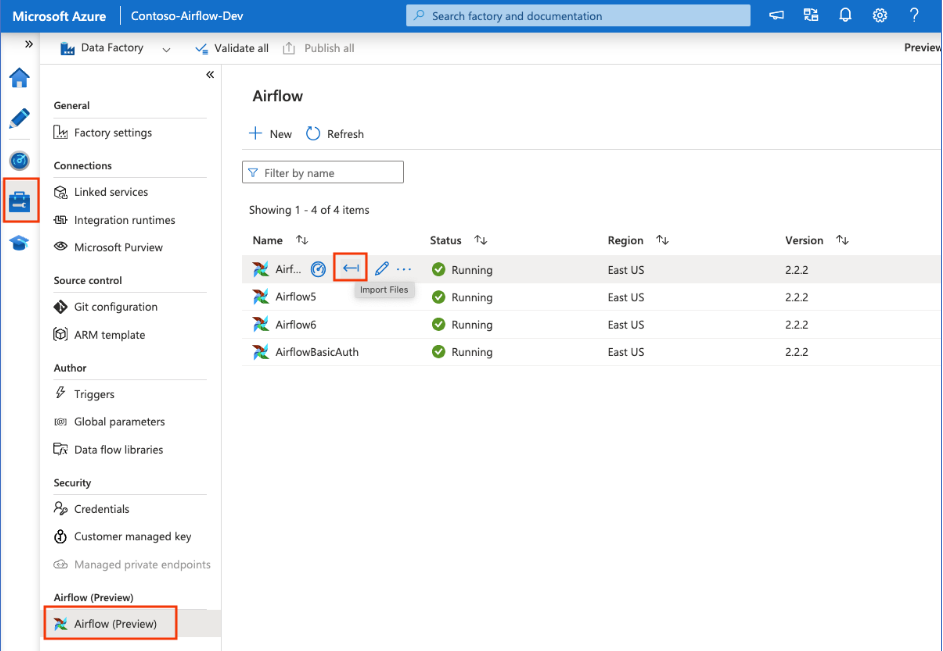

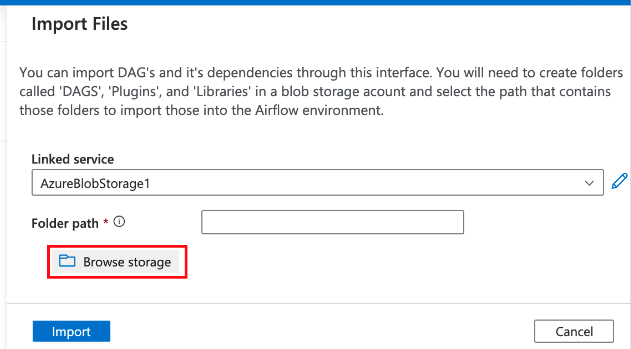

Sélectionnez Airflow (préversion) sous Gérer le hub. Pointez ensuite sur l’environnement Airflow créé précédemment, puis sélectionnez Importer des fichiers pour importer tous les DAG et les dépendances dans l’environnement Airflow.

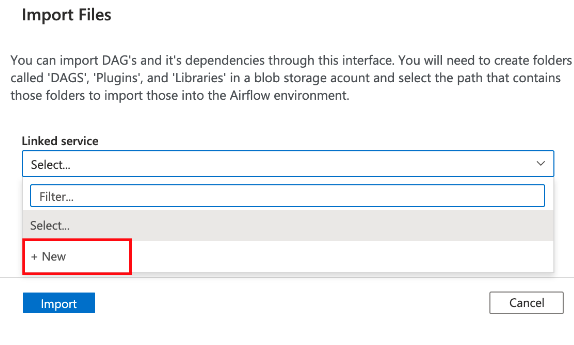

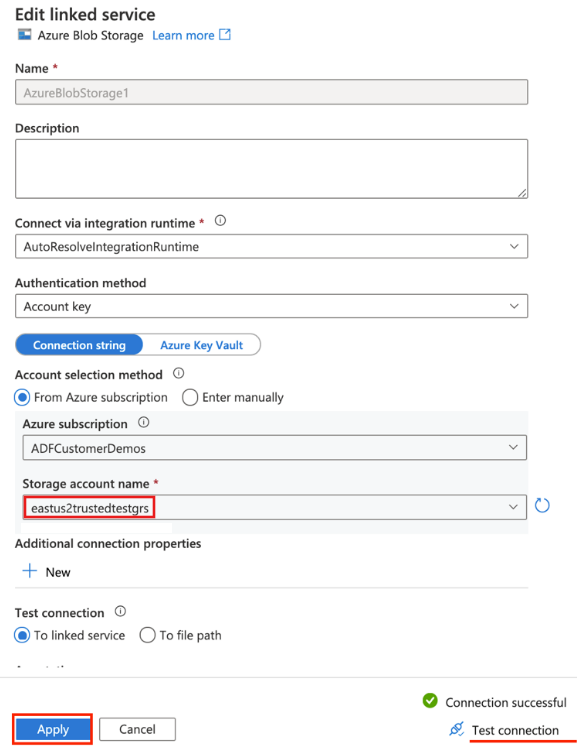

Créez un service lié au compte de stockage accessible mentionné dans le prérequis (ou utilisez un service existant si vous disposez déjà de vos propres DAG).

Utilisez le compte de stockage où vous avez chargé le DAG (consultez le prérequis). Testez la connexion, puis sélectionnez Créer.

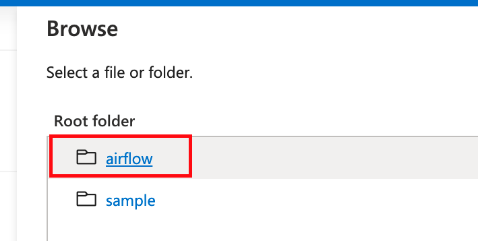

Parcourez et sélectionnez airflow si vous utilisez l’exemple d’URL SAS ou sélectionnez le dossier qui contient le dossier dags avec des fichiers DAG.

Notes

Vous pouvez importer des DAG et leurs dépendances via cette interface. Vous devez sélectionner un chemin de répertoire à partir d’un compte de stockage d’objets blob qui contient des dossiers nommés dags et plugins pour les importer dans l’environnement Airflow. Les plug-ins ne sont pas obligatoires.

Notes

L’importation de DAG peut prendre quelques minutes avec la préversion. Le centre de notification (icône de cloche dans l’interface utilisateur ADF) peut être utilisé pour suivre les mises à jour de l’état de l’importation.

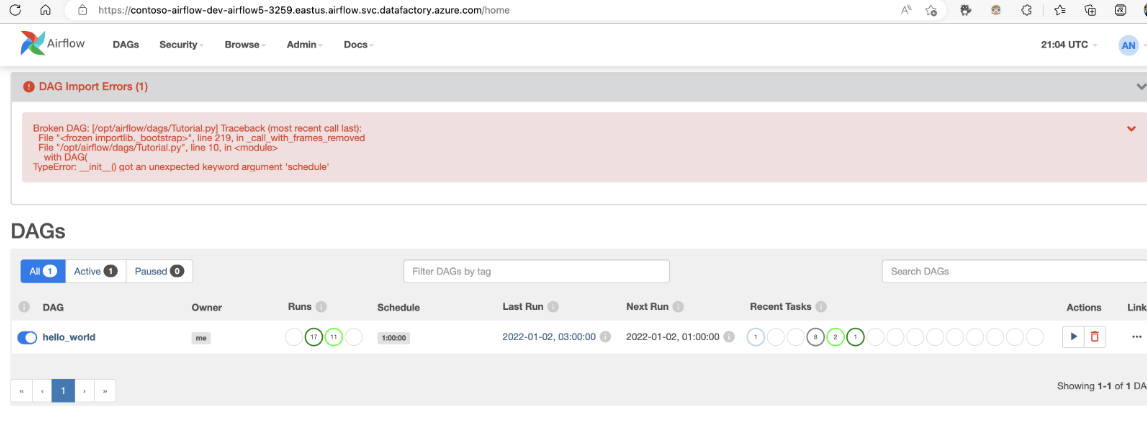

Résolution des problèmes liés à l’importation de DAG

Problème : L’importation de DAG prend plus de 5 minutes. Résolution : réduisez la taille des DAG importés avec une même importation. Une façon de le faire est de créer plusieurs dossiers DAG avec moins de DAG sur plusieurs conteneurs.

Problème : Les DAG importés ne s’affichent pas quand vous vous connectez à l’interface utilisateur Airflow. Résolution : Connectez-vous à l’interface utilisateur Airflow et vérifiez s’il existe des erreurs d’analyse des DAG. Ceci peut se produire si les fichiers DAG contiennent du code incompatible. Vous trouverez les numéros de ligne exacts et les fichiers qui avoir le problème via l’interface utilisateur Airflow.

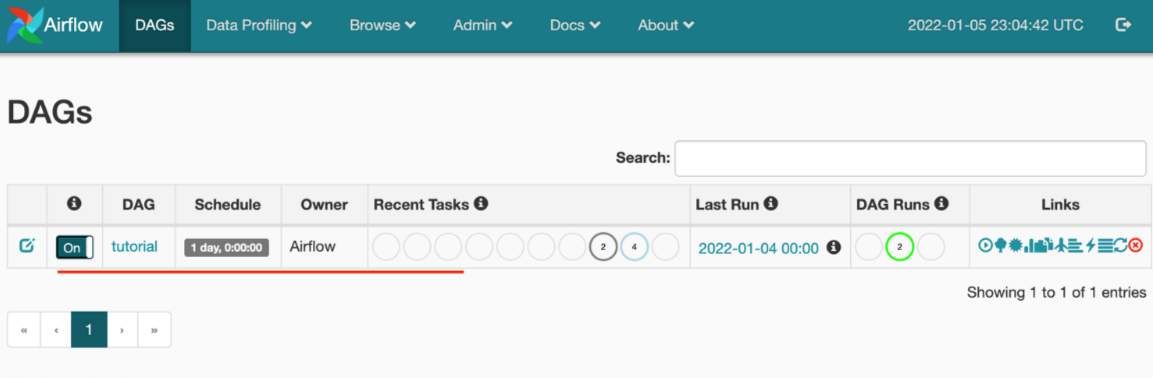

Superviser les exécutions de DAG

Pour superviser les DAG Airflow, connectez-vous à l’interface utilisateur Airflow avec le nom d’utilisateur et le mot de passe créés précédemment.

Sélectionnez l’environnement Airflow créé.

Connectez-vous en utilisant le nom d’utilisateur et le mot de passe fournis lors de la création du runtime d’intégration Airflow. (Vous pouvez si nécessaire réinitialiser le nom d’utilisateur ou le mot de passe en modifiant le runtime d’intégration Airflow)

Supprimer des DAG de l’environnement Airflow

Si vous utilisez Airflow version 1.x, pour supprimer les DAG déployés sur un environnement Airflow (IR), vous devez supprimer les DAG à deux endroits différents.

- Supprimer le DAG de l’interface utilisateur Airflow

- Supprimer le DAG dans l’interface utilisateur ADF

Notes

Ceci est l’expérience actuelle pendant la préversion publique, et nous allons améliorer cette expérience.